Neuroboids Optimierungsalgorithmus 2 (NOA2)

Der neue proprietäre Optimierungsalgorithmus NOA2 (Neuroboids Optimization Algorithm 2) kombiniert die Prinzipien der Schwarmintelligenz mit neuronaler Steuerung. NOA2 kombiniert die Mechanik eines Neuroboidenschwarms mit einem adaptiven neuronalen System, das es den Agenten ermöglicht, ihr Verhalten selbst zu korrigieren, während sie nach dem Optimum suchen. Der Algorithmus wird derzeit aktiv weiterentwickelt und zeigt sein Potenzial für die Lösung komplexer Optimierungsprobleme.

Algorithmische Handelsstrategien: KI und ihr Weg zu den goldenen Zinnen

In diesem Artikel wird ein Ansatz zur Erstellung von Handelsstrategien für Gold mithilfe von maschinellem Lernen vorgestellt. Betrachtet man den vorgeschlagenen Ansatz zur Analyse und Prognose von Zeitreihen aus verschiedenen Blickwinkeln, so lassen sich seine Vor- und Nachteile im Vergleich zu anderen Methoden zur Erstellung von Handelssystemen, die ausschließlich auf der Analyse und Prognose von Finanzzeitreihen beruhen, feststellen.

Quantitative Analyse von Trends: Sammeln von Statistiken in Python

Was ist eine quantitative Trendanalyse auf dem Devisenmarkt? Wir sammeln Statistiken über Trends, deren Ausmaß und Verteilung über das Währungspaar EURUSD. Wie Sie mit Hilfe der quantitativen Trendanalyse einen profitablen Trading Expert Advisor erstellen können.

Analyse überkaufter und überverkaufter Trends mit Ansätzen der Chaostheorie

Wir bestimmen den überkauften und überverkauften Zustand des Marktes nach der Chaostheorie: Wir integrieren die Prinzipien der Chaostheorie, der fraktalen Geometrie und der neuronalen Netze, um Finanzmärkte zu prognostizieren. Die Studie demonstriert die Verwendung des Lyapunov-Exponenten als Maß für die Zufälligkeit des Marktes und die dynamische Anpassung der Handelssignale. Die Methodik umfasst einen Algorithmus zur Erzeugung von fraktalem Rauschen, hyperbolische Tangentenaktivierung und Momentoptimierung.

Neuronale Netze im Handel: Hybride Graphsequenzmodelle (letzter Teil)

Wir erforschen weiterhin hybride Graphsequenzmodelle (GSM++), die die Vorteile verschiedener Architekturen vereinen und eine hohe Analysegenauigkeit sowie eine effiziente Verteilung der Rechenressourcen bieten. Diese Modelle erkennen verborgene Muster, verringern die Auswirkungen von Marktstörungen und verbessern die Prognosequalität.

Erforschung des maschinellen Lernens im unidirektionalen Trendhandel am Beispiel von Gold

In diesem Artikel wird ein Ansatz erörtert, der darauf abzielt, nur in der gewählten Richtung (Kauf oder Verkauf) zu handeln. Zu diesem Zweck werden die Technik der kausalen Inferenz und des maschinellen Lernens eingesetzt.

Integration von Computer Vision in den Handel in MQL5 (Teil 1): Erstellen von Grundfunktionen

Das EURUSD-Prognosesystem mit Hilfe von Computer Vision und Deep Learning. Erfahren Sie, wie Faltungsneuronale Netze komplexe Kursmuster auf dem Devisenmarkt erkennen und Wechselkursbewegungen mit einer Genauigkeit von bis zu 54 % vorhersagen können. Der Artikel beschreibt die Methodik zur Entwicklung eines Algorithmus, der Technologien der künstlichen Intelligenz für die visuelle Analyse von Charts anstelle von traditionellen technischen Indikatoren verwendet. Der Autor demonstriert den Prozess der Umwandlung von Preisdaten in „Bilder“, ihre Verarbeitung durch ein neuronales Netz und die einzigartige Möglichkeit, anhand von Aktivierungskarten und Aufmerksamkeits-Heatmaps einen Blick in das „Bewusstsein“ der KI zu werfen. Praktischer Python-Code, der die MetaTrader 5-Bibliothek nutzt, ermöglicht es den Lesern, das System zu reproduzieren und für den eigenen Handel anzuwenden.

Erstellung einer Strategie der Rückkehr zum Mittelwert auf der Grundlage von maschinellem Lernen

In diesem Artikel wird ein weiterer, origineller Ansatz für die Entwicklung von Handelssystemen auf der Grundlage von maschinellem Lernen vorgeschlagen, bei dem Clustering und Trade Labeling für die Strategien der Rückkehr zum Mittelwert eingesetzt werden.

Swap-Arbitrage am Devisenmarkt: Aufbau eines synthetischen Portfolios und Generierung eines konsistenten Swapflusses

Möchten Sie wissen, wie Sie von den unterschiedlichen Zinssätzen profitieren können? Dieser Artikel befasst sich mit der Frage, wie man Swap-Arbitrage auf dem Forex-Markt nutzen kann, um jede Nacht einen stabilen Gewinn zu erzielen und ein Portfolio aufzubauen, das gegen Marktschwankungen resistent ist.

Neuronale Netze im Handel: Hybride Graphsequenzmodelle (GSM++)

Hybride Graphsequenzmodelle (GSM++) kombinieren die Vorteile verschiedener Architekturen, um eine realitätsnahe Datenanalyse und optimierte Rechenkosten zu ermöglichen. Diese Modelle passen sich effektiv an dynamische Marktdaten an und verbessern die Darstellung und Verarbeitung von Finanzinformationen.

Neuroboids Optimierungsalgorithmus (NOA)

Eine neue bioinspirierte Metaheuristik zur Optimierung, NOA (Neuroboids Optimization Algorithm), kombiniert die Prinzipien der kollektiven Intelligenz und der neuronalen Netze. Im Gegensatz zu herkömmlichen Methoden verwendet der Algorithmus eine Population von selbstlernenden „Neuroboiden“, von denen jeder sein eigenes neuronales Netz hat, das seine Suchstrategie in Echtzeit anpasst. Der Artikel zeigt die Architektur des Algorithmus, die Mechanismen des Selbstlernens der Agenten und die Aussichten für die Anwendung dieses hybriden Ansatzes auf komplexe Optimierungsprobleme.

Forex Arbitrage-Handel: Analyse der Bewegungen synthetischer Währungen und ihrer mittleren Umkehrung

In diesem Artikel werden wir die Bewegungen synthetischer Währungen mit Hilfe von Python und MQL5 untersuchen und herausfinden, wie praktikabel Forex-Arbitrage heute ist. Wir werden uns auch mit fertigem Python-Code für die Analyse synthetischer Währungen befassen und mehr Details darüber mitteilen, was synthetische Währungen im Devisenhandel sind.

Entwicklung von Trendhandelsstrategien mit maschinellem Lernen

In dieser Studie wird eine neuartige Methodik für die Entwicklung von Trendfolgestrategien vorgestellt. In diesem Abschnitt wird der Prozess der Annotation von Trainingsdaten und deren Verwendung zum Training von Klassifikatoren beschrieben. Dieser Prozess führt zu voll funktionsfähigen Handelssystemen, die für den MetaTrader 5 entwickelt wurden.

Aufbau eines Remote-Forex-Risikomanagementsystems in Python

Wir entwickeln einen professionellen Remote-Risikomanager für Forex in Python, der Schritt für Schritt auf dem Server installiert wird. Im Laufe des Artikels werden wir verstehen, wie man die Forex-Risiken programmatisch verwalten kann und wie man eine Forex-Einlage nicht mehr verschwenden kann.

Der Algorithmus Central Force Optimization (CFO)

Der Artikel stellt den von den Gesetzen der Schwerkraft inspirierten Algorithmus Central Force Optimization (CFO) vor. Es wird untersucht, wie die Prinzipien der physikalischen Schwerkraft Optimierungsprobleme lösen können, bei denen „schwerere“ Lösungen weniger erfolgreiche Gegenstücke anziehen.

Neuronale Netze im Handel: Zweidimensionale Verbindungsraummodelle (letzter Teil)

Wir erforschen weiterhin den innovativen Chimera-Rahmen – ein zweidimensionales Zustandsraummodell, das neuronale Netzwerktechnologien zur Analyse mehrdimensionaler Zeitreihen nutzt. Diese Methode bietet eine hohe Vorhersagegenauigkeit bei geringen Rechenkosten.

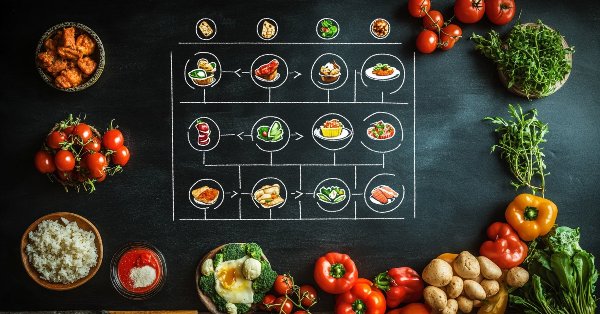

Algorithmus der erfolgreichen Gastronomen (SRA)

Der Successful Restaurateur Algorithm (SRA) ist eine innovative Optimierungsmethode, die sich an den Prinzipien des Restaurantbetriebs orientiert. Im Gegensatz zu traditionellen Ansätzen werden bei der SRA schwache Lösungen nicht verworfen, sondern durch die Kombination mit Elementen erfolgreicher Lösungen verbessert. Der Algorithmus zeigt konkurrenzfähige Ergebnisse und bietet eine neue Perspektive für das Gleichgewicht zwischen Erkunden und Nutzen bei Optimierungsproblemen.

Billard-Optimierungsalgorithmus (BOA)

Die BOA-Methode ist vom klassischen Billardspiel inspiriert und simuliert die Suche nach optimalen Lösungen als ein Spiel, bei dem die Kugeln versuchen, in die Taschen zu fallen, die die besten Ergebnisse darstellen. In diesem Artikel werden wir die Grundlagen von BOA, sein mathematisches Modell und seine Effizienz bei der Lösung verschiedener Optimierungsprobleme betrachten.

Neuronale Netze im Handel: Zweidimensionale Verbindungsraummodelle (Chimera)

In diesem Artikel wird das innovative Chimera-System vorgestellt: ein zweidimensionales Zustandsraummodell, das neuronale Netze zur Analyse multivariater Zeitreihen verwendet. Diese Methode bietet eine hohe Genauigkeit bei geringen Rechenkosten und übertrifft damit traditionelle Ansätze und Transformer-Architekturen.

Analyse aller Preisbewegungsoptionen auf dem IBM-Quantencomputer

Wir werden einen Quantencomputer von IBM einsetzen, um alle Möglichkeiten der Preisentwicklung zu ermitteln. Klingt nach Science Fiction? Willkommen in der Welt des Quantencomputers für den Handel!

Fibonacci am Devisenmarkt (Teil I): Prüfung des Verhältnisses zwischen Preis und Zeit

Wie beobachtet der Markt Fibonacci-basierte Beziehungen? Diese Folge, bei der jede nachfolgende Zahl gleich der Summe der beiden vorhergehenden ist (1, 1, 2, 3, 5, 8, 13, 21...), beschreibt nicht nur das Wachstum der Kaninchenpopulation. Wir werden die pythagoreische Hypothese betrachten, dass alles in der Welt bestimmten Zahlenbeziehungen unterliegt...

Neuronale Netze im Handel: Multi-Task-Lernen auf der Grundlage des ResNeXt-Modells (letzter Teil)

Wir erforschen weiterhin ein auf ResNeXt basierendes Multitasking-Lernsystem, das sich durch Modularität, hohe Recheneffizienz und die Fähigkeit, stabile Muster in Daten zu erkennen, auszeichnet. Die Verwendung eines einzigen Encoders und spezieller „Köpfe“ verringert das Risiko einer Überanpassung des Modells und verbessert die Qualität der Prognosen.

Blood inheritance optimization (BIO)

Ich stelle Ihnen meinen neuen Algorithmus zur Populationsoptimierung vor – Blood Inheritance Optimization (BIO), inspiriert durch das menschliche Blutgruppenvererbungssystem. Bei diesem Algorithmus hat jede Lösung ihre eigene „Blutgruppe“, die bestimmt, wie sie sich weiterentwickelt. Wie in der Natur, wo die Blutgruppe eines Kindes nach bestimmten Regeln vererbt wird, erhalten neue Lösungen in BIO ihre Eigenschaften durch ein System von Vererbung und Mutationen.

Kreis-Such-Algorithmus (CSA)

Der Artikel stellt einen neuen metaheuristischen Optimierungs-Kreis-Such-Algorithmus (CSA) vor, der auf den geometrischen Eigenschaften eines Kreises basiert. Der Algorithmus nutzt das Prinzip der Bewegung von Punkten entlang von Tangenten, um die optimale Lösung zu finden, und kombiniert die Phasen der globalen Erkundung und der lokalen Ausbeutung.

Chaos Game Optimization (CGO)

Der Artikel stellt einen neuen metaheuristischen Algorithmus, Chaos Game Optimization (CGO), vor, der eine einzigartige Fähigkeit zur Aufrechterhaltung einer hohen Effizienz bei hochdimensionalen Problemen aufweist. Im Gegensatz zu den meisten Optimierungsalgorithmen verliert CGO nicht nur nicht an Leistung, sondern steigert sie manchmal sogar, wenn ein Problem skaliert wird, was sein Hauptmerkmal ist.

Biologisches Neuron zur Vorhersage von Finanzzeitreihen

Wir werden ein biologisch korrektes System von Neuronen für die Vorhersage von Zeitreihen aufbauen. Die Einführung einer plasmaähnlichen Umgebung in die Architektur des neuronalen Netzes schafft eine Art „kollektive Intelligenz“, bei der jedes Neuron den Betrieb des Systems nicht nur durch direkte Verbindungen, sondern auch durch weitreichende elektromagnetische Wechselwirkungen beeinflusst. Mal sehen, wie sich das neuronale Gehirnmodellierungssystem auf dem Markt schlagen wird.

Royal-Flush-Optimierung (RFO)

Der ursprüngliche Royal Flush Optimierung-Algorithmus bietet einen neuen Ansatz zur Lösung von Optimierungsproblemen, indem er die klassische binäre Kodierung genetischer Algorithmen durch einen sektorbasierten Ansatz ersetzt, der von den Prinzipien des Pokerspiels inspiriert ist. RFO zeigt, wie die Vereinfachung von Grundprinzipien zu einer effizienten und praktischen Optimierungsmethode führen kann. Der Artikel enthält eine detaillierte Analyse des Algorithmus und der Testergebnisse.

Neuronale Netze im Handel: Hierarchical Dual-Tower Transforme (letzter Teil)

Wir setzen die Entwicklung des Modells von „Hidformer Hierarchical Dual-Tower Transformer“ fort, das für die Analyse und Vorhersage komplexer multivariater Zeitreihen entwickelt wurde. In diesem Artikel werden wir die Arbeit, die wir zuvor begonnen haben, zu einem logischen Abschluss bringen - wir werden das Modell an realen historischen Daten testen.

Neuronale Netze im Handel: Hierarchischer Dual-Tower-Transformer (Hidformer)

Wir laden Sie ein, sich mit dem Hierarchical Double-Tower Transformer (Hidformer) vertraut zu machen, der für Zeitreihenprognosen und Datenanalysen entwickelt wurde. Die Autoren des Rahmenwerks schlugen mehrere Verbesserungen an der Transformer-Architektur vor, die zu einer höheren Vorhersagegenauigkeit und einem geringeren Verbrauch an Rechenressourcen führten.

Neuronale Netze im Handel: Speichererweitertes kontextbezogenes Lernen für Kryptowährungsmärkte (letzter Teil)

Das MacroHFT-Framework für den Hochfrequenzhandel mit Kryptowährungen nutzt kontextbezogenes Verstärkungslernen und Speicher, um sich an dynamische Marktbedingungen anzupassen. Am Ende dieses Artikels werden wir die implementierten Ansätze an realen historischen Daten testen, um ihre Wirksamkeit zu bewerten.

Neuronale Netze im Handel: Multi-Task-Lernen auf der Grundlage des ResNeXt-Modells

Ein auf ResNeXt basierendes Multi-Task-Learning-System optimiert die Analyse von Finanzdaten unter Berücksichtigung ihrer hohen Dimensionalität, Nichtlinearität und Zeitabhängigkeit. Die Verwendung von Gruppenfaltung und spezialisierten Köpfen ermöglicht es dem Modell, effektiv Schlüsselmerkmale aus den Eingabedaten zu extrahieren.

Neuronale Netze im Handel: Speichererweitertes kontextbezogenes Lernen (MacroHFT) für Kryptowährungsmärkte

Ich lade Sie ein, das MacroHFT-Framework zu erkunden, das kontextbewusstes Verstärkungslernen und eine Speicherverwendung anwendet, um Hochfrequenzhandelsentscheidungen für Kryptowährungen mithilfe von makroökonomischen Daten und adaptiven Agenten zu verbessern.

Dialektische Suche (DA)

Der Artikel stellt den dialektischen Algorithmus (DA) vor, eine neue globale Optimierungsmethode, die vom philosophischen Konzept der Dialektik inspiriert ist. Der Algorithmus macht sich eine einzigartige Aufteilung der Bevölkerung in spekulative und praktische Denker (thinker) zunutze. Tests zeigen eine beeindruckende Leistung von bis zu 98 % bei niedrigdimensionalen Problemen und eine Gesamteffizienz von 57,95 %. Der Artikel erläutert diese Metriken und präsentiert eine detaillierte Beschreibung des Algorithmus sowie die Ergebnisse von Experimenten mit verschiedenen Arten von Funktionen.

Neuronale Netze im Handel: Ein Multi-Agenten-System mit konzeptioneller Verstärkung (letzter Teil)

Wir setzen weiterhin die von den Autoren des FinCon-Rahmens vorgeschlagenen Ansätze um. FinCon ist ein Multi-Agenten-System, das auf Large Language Models (LLMs) basiert. Heute werden wir die erforderlichen Module implementieren und umfassende Tests des Modells mit realen historischen Daten durchführen.

Marktsimulation (Teil 06): Übertragen von Informationen von MetaTrader 5 nach Excel

Viele Menschen, insbesondere Nicht-Programmierer, finden es sehr schwierig, Informationen zwischen MetaTrader 5 und anderen Programmen zu übertragen. Ein solches Programm ist Excel. Viele verwenden Excel, um ihre Risikokontrolle zu verwalten und aufrechtzuerhalten. Es ist ein ausgezeichnetes Programm und leicht zu erlernen, auch für diejenigen, die keine VBA-Programmierer sind. Im Folgenden werden wir uns ansehen, wie man eine Verbindung zwischen MetaTrader 5 und Excel herstellt (eine sehr einfache Methode).

Neuronale Netze im Handel: Ein Multi-Agenten-System mit konzeptioneller Verstärkung (FinCon)

Wir laden Sie ein, den FinCon-Rahmen zu erkunden, der ein auf einem Large Language Model (LLM) basierendes Multi-Agenten-System ist. Der Rahmen nutzt konzeptionelle verbale Verstärkung, um die Entscheidungsfindung und das Risikomanagement zu verbessern und eine effektive Leistung bei einer Vielzahl von Finanzaufgaben zu ermöglichen.

Neuronale Netze im Handel: Ein multimodaler, werkzeuggestützter Agent für Finanzmärkte (letzter Teil)

Wir entwickeln weiterhin die Algorithmen für FinAgent, einen multimodalen Finanzhandelsagenten, der multimodale Marktdynamikdaten und historische Handelsmuster analysiert.

Neuronale Netze im Handel: Ein multimodaler, werkzeuggestützter Agent für Finanzmärkte (FinAgent)

Wir laden Sie ein, FinAgent kennenzulernen, ein multimodales Finanzhandelsagenten-Framework zur Analyse verschiedener Datentypen, die die Marktdynamik und historische Handelsmuster widerspiegeln.

Erstellung eines Indikators für die Volatilitätsprognose mit Python

In diesem Artikel prognostizieren wir die zukünftige extreme Volatilität anhand einer binären Klassifizierung. Außerdem werden wir mit Hilfe von maschinellem Lernen einen Indikator für extreme Volatilität entwickeln.

Neuronale Netze im Handel: Ein Agent mit geschichtetem Gedächtnis (letzter Teil)

Wir setzen unsere Arbeit an der Entwicklung des Systems von FinMem fort, das mehrschichtige Speicheransätze verwendet, die menschliche kognitive Prozesse nachahmen. Dadurch kann das Modell nicht nur komplexe Finanzdaten effektiv verarbeiten, sondern sich auch an neue Signale anpassen, was die Genauigkeit und Effektivität von Anlageentscheidungen auf sich dynamisch verändernden Märkten erheblich verbessert.