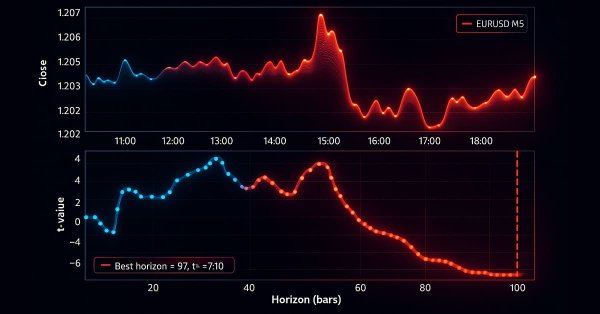

MetaTrader 5 Machine Learning Blueprint (Teil 3): Methoden der Kennzeichnung von Trend-Scanning

Wir haben eine Pipline für eine robuste Eigenschaftsentwicklung entwickelt, die geeignete tick-basierte Balken verwendet, um Datenverluste zu vermeiden, und das kritische Problem der Kennzeichnung der meta-gekennzeichneten Signale des Triple-Barrier gelöst. Dieser Teil behandelt die fortgeschrittene Technik der Kennzeichnung, dem Trend-Scanning, für adaptive Horizonte. Nach der Erläuterung der Theorie wird anhand eines Beispiels gezeigt, wie Kennzeichnungen des Trend-Scanning mit Meta-Kennzeichen verwendet werden können, um die klassische Kreuzungsstrategie mit gleitendem Durchschnitt zu verbessern.

Selbstoptimierende Expert Advisors in MQL5 (Teil 16): Überwachte lineare Systemidentifikation

Die lineare Systemidentifikation kann mit dem Lernen gekoppelt werden, um den Fehler in einem überwachten Lernalgorithmus zu korrigieren. So können wir Anwendungen entwickeln, die von statistischen Modellierungstechniken abhängen, ohne zwangsläufig die Anfälligkeit der restriktiven Annahmen des Modells zu übernehmen. Klassische überwachte Lernalgorithmen haben viele Bedürfnisse, die durch die Kombination dieser Modelle mit einem Feedback-Controller ergänzt werden können, der das Modell korrigieren kann, um mit den aktuellen Marktbedingungen Schritt zu halten.

Die Grenzen des maschinellen Lernens überwinden (Teil 6): Effektive Speichervalidierung

In dieser Diskussion stellen wir den klassischen Ansatz der Zeitreihen-Kreuzvalidierung modernen Alternativen gegenüber, die seine Grundannahmen in Frage stellen. Wir zeigen die wichtigsten blinden Flecken der traditionellen Methode auf – insbesondere ihr Versagen, die sich verändernden Marktbedingungen zu berücksichtigen. Um diese Lücken zu schließen, führen wir die Effective Memory Cross-Validation (EMCV) ein, einen domänenspezifischen Ansatz, der die lange gehegte Annahme in Frage stellt, dass mehr historische Daten immer die Leistung verbessern.

Klassische Strategien neu interpretiert (Teil 16): Doppelte Ausbrüche aus den Bollinger Bänder

Dieser Artikel führt den Leser durch eine neu gestaltete Version der klassischen Bollinger Band Ausbruchsstrategie. Sie zeigt wesentliche Schwachstellen des ursprünglichen Ansatzes auf, wie z. B. seine bekannte Anfälligkeit für falsche Ausbrüche. In diesem Artikel soll eine mögliche Lösung vorgestellt werden: die Handelsstrategie der doppelten Bollinger Bänder. Dieser relativ weniger bekannte Ansatz ergänzt die Schwächen der klassischen Version und bietet eine dynamischere Perspektive auf die Finanzmärkte. Sie hilft uns, die alten Beschränkungen zu überwinden, die durch die ursprünglichen Regeln festgelegt wurden, und bietet den Händlern einen stärkeren und anpassungsfähigeren Rahmen.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 85): Verwendung von Mustern des Stochastik-Oszillators und der FrAMA mit Beta-VAE-Inferenzlernen

Dieser Beitrag schließt an Teil 84 an, in dem wir die Kombination von Stochastik und Fractal Adaptive Moving Average vorgestellt haben. Wir verlagern nun den Schwerpunkt auf das Inferenzlernen, um zu sehen, ob die im letzten Artikel unterlegenen Muster eine Trendwende erfahren könnten. Der Stochastik und der FrAMA sind eine sich ergänzende Paarung von Momentum und Trend. Für unser Inferenzlernen greifen wir auf den Beta-Algorithmus eines Variational Auto Encoders zurück. Außerdem implementieren wir, wie immer, eine nutzerdefinierte Signalklasse, die für die Integration mit dem MQL5-Assistenten entwickelt wurde.

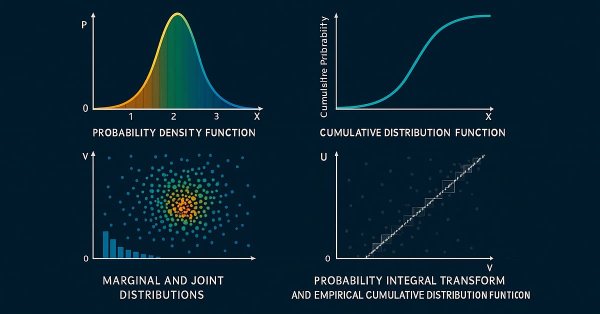

Bivariate Copulae in MQL5 (Teil 1): Implementierung von Gauß- und Studentische t-Copulae für die Modellierung von Abhängigkeiten

Dies ist der erste Teil einer Artikelserie, in der die Implementierung von bivariaten Copulae in MQL5 vorgestellt wird. Dieser Artikel enthält Code zur Implementierung der Gauß‘schen und Studentischen t-Copulae. Außerdem werden die Grundlagen der statistischen Copulae und verwandte Themen behandelt. Der Code basiert auf dem Python-Paket Arbitragelab von Hudson und Thames.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 82): Verwendung von TRIX- und WPR-Mustern mit DQN-Verstärkungslernen

Im letzten Artikel haben wir die Paarung von Ichimoku und ADX im Rahmen des Inferenzlernens untersucht. In diesem Beitrag greifen wir das Verstärkungslernen in Verbindung mit einem Indikatorpaar auf, das wir zuletzt in „Teil 68“ betrachtet haben. Der TRIX und Williams Percent Range. Unser Algorithmus für diese Überprüfung wird die Quantilregression DQN sein. Wie üblich stellen wir dies als nutzerdefinierte Signalklasse vor, die für die Implementierung mit dem MQL5-Assistenten entwickelt wurde.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 81): Verwendung von Ichimoku-Mustern und des ADX-Wilder mit Beta-VAE-Inferenzlernen

Dieser Beitrag schließt an Teil 80 an, in dem wir die Paarung von Ichimoku und ADX im Rahmen eines Reinforcement Learning untersucht haben. Wir wenden uns nun dem Inferenzlernen zu. Ichimoku und ADX ergänzen sich, wie bereits erwähnt, jedoch werden wir die Schlussfolgerungen des letzten Artikels in Bezug auf die Verwendung von Pipelines wieder aufgreifen. Für unser Inferenzlernen verwenden wir den Beta-Algorithmus eines Variational Auto Encoders. Wir bleiben auch bei der Implementierung einer nutzerdefinierten Signalklasse für die Integration mit dem MQL5-Assistenten.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 80): Verwendung von Ichimoku-Muster und des ADX-Wilder mit TD3 Reinforcement Learning

Dieser Artikel schließt an Teil 74 an, in dem wir die Paarung von Ichimoku und ADX im Rahmen des überwachten Lernens untersuchten, und verlagert den Schwerpunkt auf das Bestärkende Lernen. Ichimoku und ADX bilden eine komplementäre Kombination von Unterstützungs-/Widerstandskartierung und Trendstärkemessung. In dieser Folge wird gezeigt, wie der Twin Delayed Deep Deterministic Policy Gradient (TD3) Algorithmus mit diesem Indikatorensatz verwendet werden kann. Wie bei früheren Teilen der Serie erfolgt die Implementierung in einer nutzerdefinierten Signalklasse, die für die Integration mit dem MQL5-Assistenten entwickelt wurde, was eine problemlose Zusammenstellung von Expert Advisors ermöglicht.

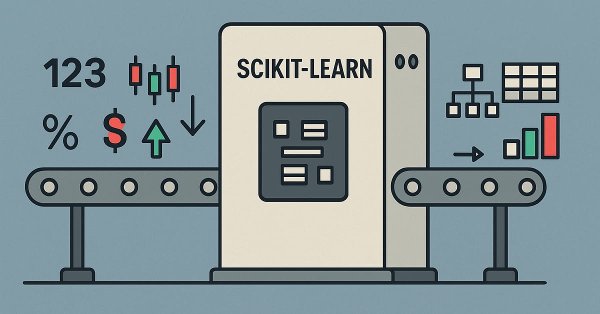

Pipelines in MQL5

In diesem Beitrag befassen wir uns mit einem wichtigen Schritt der Datenaufbereitung für das maschinelle Lernen, der zunehmend an Bedeutung gewinnt. Pipelines für die Datenvorverarbeitung. Dabei handelt es sich im Wesentlichen um eine rationalisierte Abfolge von Datenumwandlungsschritten, mit denen Rohdaten aufbereitet werden, bevor sie in ein Modell eingespeist werden. So uninteressant dies für den Laien auch erscheinen mag, diese „Datenstandardisierung“ spart nicht nur Trainingszeit und Ausführungskosten, sondern trägt auch zu einer besseren Generalisierung bei. In diesem Artikel konzentrieren wir uns auf einige SCIKIT-LEARN Vorverarbeitungsfunktionen, und während wir den MQL5-Assistenten nicht ausnutzen, werden wir in späteren Artikeln darauf zurückkommen.

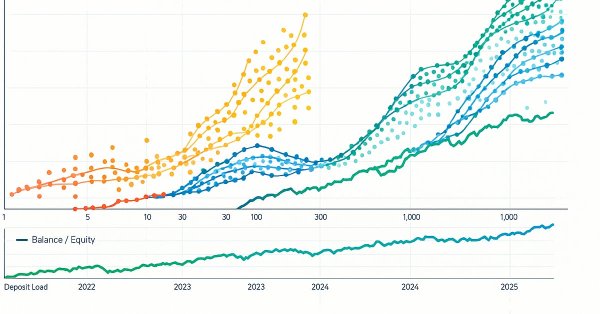

Die Grenzen des maschinellen Lernens überwinden (Teil 4): Überwindung des irreduziblen Fehlers durch mehrere Prognosehorizonte

Maschinelles Lernen wird oft durch die Brille der Statistik oder der linearen Algebra betrachtet, aber dieser Artikel betont eine geometrische Perspektive der Modellvorhersagen. Sie zeigt, dass sich die Modelle dem Ziel nicht wirklich annähern, sondern es auf ein neues Koordinatensystem abbilden, was zu einer inhärenten Fehlausrichtung führt, die irreduzible Fehler zur Folge hat. In dem Artikel wird vorgeschlagen, dass mehrstufige Vorhersagen, bei denen die Prognosen des Modells über verschiedene Zeithorizonte hinweg verglichen werden, einen effektiveren Ansatz darstellen als direkte Vergleiche mit dem Ziel. Durch die Anwendung dieser Methode auf ein Handelsmodell zeigt der Artikel erhebliche Verbesserungen der Rentabilität und Genauigkeit, ohne das zugrunde liegende Modell zu verändern.

Dynamic Mode Decomposition angewandt auf univariate Zeitreihen in MQL5

Die Dynamic Mode Decomposition (DMD) ist eine Technik, die in der Regel auf hochdimensionale Datensätze angewendet wird. In diesem Artikel demonstrieren wir die Anwendung der DMD auf univariate Zeitreihen und zeigen, dass sie in der Lage ist, sowohl eine Reihe zu charakterisieren als auch Prognosen zu erstellen. Dabei werden wir die in MQL5 eingebaute Implementierung der Dynamic Mode Decomposition untersuchen und dabei besonderes Augenmerk auf die neue Matrixmethode DynamicModeDecomposition() legen.

Die Grenzen des maschinellen Lernens überwinden (Teil 3): Eine neue Perspektive auf irreduzible Fehler

Dieser Artikel wirft einen neuen Blick auf eine verborgene, geometrische Fehlerquelle, die im Stillen jede Vorhersage Ihrer Modelle beeinflusst. Indem wir die Messung und Anwendung von Prognosen des maschinellen Lernens im Handel überdenken, zeigen wir, wie diese übersehene Perspektive schärfere Entscheidungen, höhere Renditen und einen intelligenteren Umgang mit Modellen, die wir bereits zu verstehen glaubten, ermöglichen kann.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 79): Verwendung von Gator-Oszillator und Akkumulations-/Distributions-Oszillator mit überwachtem Lernen

Im letzten Beitrag haben wir die Paarung von Gator-Oszillator und Akkumulations-/Distributions-Oszillator in ihrer typischen Einstellung der von ihnen erzeugten Rohsignale betrachtet. Diese beiden Indikatoren sind als Trend- bzw. Volumenindikatoren zu verstehen. Im Anschluss an diesen Teil untersuchen wir die Auswirkungen, die das überwachte Lernen auf die Verbesserung einiger der von uns untersuchten Merkmalsmuster haben kann. Unser überwachter Lernansatz ist ein CNN, der mit Kernelregression und Skalarproduktähnlichkeit arbeitet, um seine Kernel und Kanäle zu dimensionieren. Wie immer tun wir dies in einer nutzerdefinierten Signalklassendatei, die mit dem MQL5-Assistenten arbeitet, um einen Expert Advisor zusammenzustellen.

MetaTrader 5 Machine Learning Blueprint (Teil 2): Kennzeichnung von Finanzdaten für maschinelles Lernen

In diesem zweiten Teil der MetaTrader 5 Machine Learning Blueprint-Serie erfahren Sie, warum einfache Bezeichnungen Ihre Modelle in die Irre führen können und wie Sie fortgeschrittene Techniken wie die Triple-Barrier- und Trend-Scanning-Methode anwenden, um robuste, risikobewusste Ziele zu definieren. Dieser praktische Leitfaden ist vollgepackt mit praktischen Python-Beispielen, die diese rechenintensiven Techniken optimieren, und zeigt Ihnen, wie Sie verrauschte Marktdaten in zuverlässige Kennzeichnungen umwandeln können, die die realen Handelsbedingungen widerspiegeln.

Selbstoptimierende Expert Advisors in MQL5 (Teil 12): Aufbau von linearen Klassifikatoren durch Matrixfaktorisierung

Dieser Artikel befasst sich mit der leistungsfähigen Rolle der Matrixfaktorisierung im algorithmischen Handel, insbesondere in MQL5-Anwendungen. Von Regressionsmodellen bis hin zu Multi-Target-Klassifikatoren gehen wir durch praktische Beispiele, die zeigen, wie einfach diese Techniken mit Hilfe von integrierten MQL5-Funktionen integriert werden können. Ganz gleich, ob Sie die Kursrichtung vorhersagen oder das Verhalten von Indikatoren modellieren wollen, dieser Leitfaden schafft eine solide Grundlage für den Aufbau intelligenter Handelssysteme mit Hilfe von Matrixmethoden.

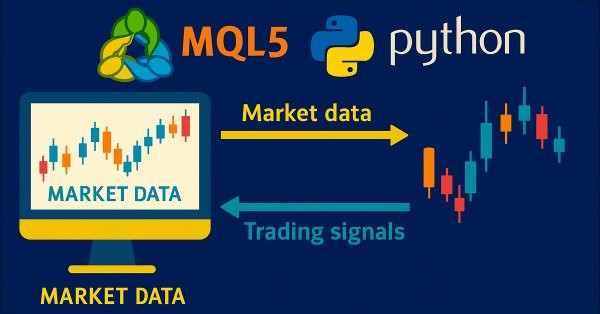

Entwicklung des Price Action Analysis Toolkit (Teil 36): Direkter Python-Zugang zu MetaTrader 5 Market Streams freischalten

Schöpfen Sie das volle Potenzial Ihres MetaTrader 5 Terminals aus, indem Sie das datenwissenschaftliche Ökosystem von Python und die offizielle MetaTrader 5 Client-Bibliothek nutzen. Dieser Artikel zeigt, wie man Live-Tick- und Minutenbalken-Daten direkt in den Parquet-Speicher authentifiziert und streamt, mit Ta und Prophet ein ausgefeiltes Feature-Engineering durchführt und ein zeitabhängiges Gradient-Boosting-Modell trainiert. Anschließend setzen wir einen leichtgewichtigen Flask-Dienst ein, um Handelssignale in Echtzeit zu liefern. Egal, ob Sie ein hybrides Quant-Framework aufbauen oder Ihren EA mit maschinellem Lernen erweitern, Sie erhalten eine robuste Ende-zu-Ende-Pipeline für den datengesteuerten algorithmischen Handel an die Hand.

Implementierung von praktischen Modulen aus anderen Sprachen in MQL5 (Teil 03): Zeitplan-Modul von Python, das OnTimer-Ereignis auf Steroiden

Das Schedule-Modul in Python bietet eine einfache Möglichkeit, wiederkehrende Aufgaben zu planen. Während MQL5 kein eingebautes Äquivalent hat, werden wir in diesem Artikel eine ähnliche Bibliothek implementieren, um die Einrichtung von zeitgesteuerten Ereignissen in MetaTrader 5 zu erleichtern.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 76): Verwendung von Mustern des Awesome Oszillators und der Envelope-Kanäle mit überwachtem Lernen

Wir knüpfen an unseren letzten Artikel an, in dem wir das Indikatorpaar des Awesome Oszillators und die Envelope-Kanäle vorstellten, indem wir uns ansehen, wie dieses Paar durch überwachtes Lernen verbessert werden kann. Der Awesome Oszillator und die Envelope-Kanäle sind eine Mischung aus Trendspotting und Unterstützung/Widerstand, die sich gegenseitig ergänzen. Unser überwachter Lernansatz ist ein CNN, der das Punktprodukt-Kernel mit Cross-Time-Attention einsetzt, um seine Kernel und Kanäle zu dimensionieren. Wie üblich erfolgt dies in einer nutzerdefinierten Signalklassendatei, die mit dem MQL5-Assistenten zur Zusammenstellung eines Expert Advisors arbeitet.

Entwicklung des Price Action Analysis Toolkit (Teil 35): Training und Einsatz von Vorhersagemodellen

Historische Daten sind alles andere als „Müll“ – sie sind die Grundlage für jede solide Marktanalyse. In diesem Artikel führen wir Sie Schritt für Schritt von der Erfassung der Historie über die Verwendung zur Erstellung eines Prognosemodells bis hin zum Einsatz dieses Modells für Live-Preisprognosen. Lesen Sie weiter, um zu erfahren, wie!

Entwicklung des Price Action Analysis Toolkit (Teil 34): Umwandlung von Marktrohdaten in Prognosemodellen mithilfe einer fortschrittlichen Pipeline der Datenerfassung

Haben Sie schon einmal einen plötzlichen Marktanstieg verpasst oder wurden Sie von einem solchen überrascht? Der beste Weg, aktuelle Ereignisse zu antizipieren, besteht darin, aus historischen Mustern zu lernen. Mit dem Ziel, ein ML-Modell zu trainieren, zeigt Ihnen dieser Artikel zunächst, wie Sie ein Skript in MetaTrader 5 erstellen, das historische Daten aufnimmt und sie zur Speicherung an Python sendet. Lesen Sie weiter, um die einzelnen Schritte in Aktion zu sehen.

Datenwissenschaft und ML (Teil 46): Aktienmarktprognosen mit N-BEATS in Python

N-BEATS ist ein revolutionäres Deep-Learning-Modell, das für die Prognose von Zeitreihen entwickelt wurde. Es wurde veröffentlicht, um die klassischen Modelle für Zeitreihenprognosen wie ARIMA, PROPHET, VAR usw. zu übertreffen. In diesem Artikel werden wir dieses Modell erörtern und es für die Vorhersage des Aktienmarktes verwenden.

Time Evolution Travel Algorithm (TETA)

Dies ist mein eigener Algorithmus. Der Artikel stellt den Time Evolution Travel Algorithm (TETA) vor, der vom Konzept der Paralleluniversen und Zeitströme inspiriert ist. Der Grundgedanke des Algorithmus ist, dass wir, obwohl Zeitreisen im herkömmlichen Sinne unmöglich sind, eine Abfolge von Ereignissen wählen können, die zu unterschiedlichen Realitäten führen.

Analyse des Binärcodes der Börsenkurse (Teil II): Umwandlung in BIP39 und Schreiben des GPT-Modells

Fortsetzung der Versuche, die Preisbewegungen zu entschlüsseln... Wie steht es mit der linguistischen Analyse des „Marktwörterbuchs“, das wir durch die Umwandlung des binären Preiscodes in BIP39 erhalten? In diesem Artikel befassen wir uns mit einem innovativen Ansatz für die Analyse von Börsendaten und untersuchen, wie moderne Techniken der natürlichen Sprachverarbeitung auf die Marktsprache angewendet werden können.

Algorithmus für zyklische Parthenogenese (CPA)

Der Artikel befasst sich mit einem neuen Populationsoptimierungsalgorithmus – dem Cyclic Parthenogenesis Algorithm (CPA), der von der einzigartigen Fortpflanzungsstrategie von Blattläusen inspiriert ist. Der Algorithmus kombiniert zwei Fortpflanzungsmechanismen – Parthenogenese und sexuelle Fortpflanzung – und nutzt auch die koloniale Struktur der Population mit der Möglichkeit der Migration zwischen Kolonien. Die wichtigsten Merkmale des Algorithmus sind der adaptive Wechsel zwischen verschiedenen Fortpflanzungsstrategien und ein System des Informationsaustauschs zwischen den Kolonien durch den Flugmechanismus.

Evolutionärer Handelsalgorithmus mit Verstärkungslernen und Auslöschung von schwachen Individuen (ETARE)

In diesem Artikel stelle ich einen innovativen Handelsalgorithmus vor, der evolutionäre Algorithmen mit Deep Reinforcement Learning für den Devisenhandel kombiniert. Der Algorithmus nutzt den Mechanismus der Auslöschung ineffizienter Individuen zur Optimierung der Handelsstrategie.

Neuronale Netze im Handel: Ein Agent mit geschichtetem Speicher

Mehrschichtige Speicher, die die kognitiven Prozesse des Menschen nachahmen, ermöglichen die Verarbeitung komplexer Finanzdaten und die Anpassung an neue Signale, wodurch die Wirksamkeit von Anlageentscheidungen auf dynamischen Märkten verbessert wird.

Funktionen zur Aktivierung von Neuronen während des Trainings: Der Schlüssel zur schnellen Konvergenz?

In diesem Artikel wird die Interaktion verschiedener Aktivierungsfunktionen mit Optimierungsalgorithmen im Rahmen des Trainings neuronaler Netze untersucht. Besonderes Augenmerk wird auf den Vergleich zwischen dem klassischen ADAM und seiner Populationsversion gelegt, wenn mit einer breiten Palette von Aktivierungsfunktionen gearbeitet wird, einschließlich der oszillierenden ACON- und Snake-Funktionen. Durch die Verwendung einer minimalistischen MLP-Architektur (1-1-1) und eines einzigen Trainingsbeispiels wird der Einfluss der Aktivierungsfunktionen auf die Optimierung von anderen Faktoren getrennt. Der Artikel schlägt einen Ansatz zur Verwaltung von Netzwerkgewichten durch die Grenzen von Aktivierungsfunktionen und einen Gewichtsreflexionsmechanismus vor, der es ermöglicht, Probleme mit Sättigung und Stagnation beim Training zu vermeiden.

Diskretisierungsmethoden für Preisbewegungen in Python

Wir werden uns die Preisdiskretisierungsmethoden mit Python und MQL5 ansehen. In diesem Artikel werde ich meine praktischen Erfahrungen mit der Entwicklung einer Python-Bibliothek teilen, die eine breite Palette von Ansätzen zur Balkenbildung implementiert – von klassischen Volumen- und Range Bars bis hin zu exotischeren Methoden wie Renko und Kagi. Wir werden Drei-Linien-Durchbruchskerzen und Range-Bars betrachten, ihre Statistiken analysieren und versuchen zu definieren, wie die Preise sonst noch diskret dargestellt werden können.

Big Bang – Big Crunch (BBBC) Algorithmus

Der Artikel stellt die Methode Big Bang – Big Crunch vor, die aus zwei Schlüsselphasen besteht: zyklische Erzeugung von Zufallspunkten und deren Komprimierung zur optimalen Lösung. Dieser Ansatz kombiniert Erkundung und Verfeinerung und ermöglicht es uns, schrittweise bessere Lösungen zu finden und neue Optimierungsmöglichkeiten zu erschließen.

Neuronale Netze im Handel: Modelle mit Wavelet-Transformation und Multitasking-Aufmerksamkeit (letzter Teil)

Im vorangegangenen Artikel haben wir die theoretischen Grundlagen erforscht und mit der Umsetzung der Ansätze des Systems Multitask-Stockformer begonnen, das die Wavelet-Transformation und das Self-Attention-Multitask-Modell kombiniert. Wir fahren fort, die Algorithmen dieses Rahmens zu implementieren und ihre Effektivität anhand realer historischer Daten zu bewerten.

Neuro-symbolische Systeme im algorithmischen Handel: Kombination von symbolischen Regeln und neuronalen Netzen

Der Artikel beschreibt die Erfahrungen bei der Entwicklung eines hybriden Handelssystems, das die klassische technische Analyse mit neuronalen Netzen kombiniert. Der Autor liefert eine detaillierte Analyse der Systemarchitektur, von der grundlegenden Musteranalyse und der Struktur des neuronalen Netzes bis hin zu den Mechanismen, die den Handelsentscheidungen zugrunde liegen, und stellt echten Code und praktische Beobachtungen vor.

Neuronale Netze im Handel: Modelle mit Wavelet-Transformation und Multitasking-Aufmerksamkeit

Wir laden Sie ein, einen Rahmen zu erkunden, der Wavelet-Transformationen und ein Multitasking-Selbstaufmerksamkeitsmodell kombiniert, um die Reaktionsfähigkeit und Genauigkeit von Prognosen unter volatilen Marktbedingungen zu verbessern. Die Wavelet-Transformation ermöglicht die Zerlegung der Renditen von Vermögenswerten in hohe und niedrige Frequenzen, wodurch langfristige Markttrends und kurzfristige Schwankungen sorgfältig erfasst werden.

Black Hole Algorithmus (BHA)

Der Black Hole Algorithm (BHA) nutzt die Prinzipien der Schwerkraft von Schwarzen Löchern, um Lösungen zu optimieren. In diesem Artikel werden wir uns ansehen, wie BHA die besten Lösungen findet und dabei lokale Extreme vermeidet, und warum dieser Algorithmus zu einem leistungsstarken Werkzeug für die Lösung komplexer Probleme geworden ist. Erfahren Sie, wie einfache Ideen zu beeindruckenden Ergebnissen in der Welt der Optimierung führen können.

Quantencomputing und Handel: Ein neuer Ansatz für Preisprognosen

Der Artikel beschreibt einen innovativen Ansatz zur Vorhersage von Kursbewegungen auf den Finanzmärkten mit Hilfe von Quantencomputern. Das Hauptaugenmerk liegt auf der Anwendung des Algorithmus Quantum Phase Estimation (QPE), um Prototypen von Preismustern zu finden, die es Händlern ermöglichen, die Analyse von Marktdaten erheblich zu beschleunigen.

Neuronale Netze im Handel: Ein hybrider Handelsrahmen mit prädiktiver Kodierung (letzter Teil)

Wir setzen unsere Untersuchung des hybriden Handelssystems StockFormer fort, das prädiktive Kodierungs- und Verstärkungslernalgorithmen für die Analyse von Finanzzeitreihen kombiniert. Das System basiert auf drei Transformer-Zweigen mit einem diversifizierten Mehrkopf-Aufmerksamkeitsmechanismus (DMH-Attn), der die Erfassung komplexer Muster und Abhängigkeiten zwischen Assets ermöglicht. Zuvor haben wir uns mit den theoretischen Aspekten des Frameworks vertraut gemacht und die DMH-Attn-Mechanismus implementiert. Heute werden wir über die Modellarchitektur und das Training sprechen.

Artificial Tribe Algorithm (ATA)

In diesem Artikel werden die wichtigsten Komponenten und Innovationen des ATA-Optimierungsalgorithmus ausführlich besprochen. Dabei handelt es sich um eine evolutionäre Methode mit einem einzigartigen dualen Verhaltenssystem, das sich je nach Situation anpasst. ATA kombiniert individuelles und soziales Lernen und nutzt Crossover für Erkundungen und Migration, um Lösungen zu finden, wenn sie in lokalen Optima stecken.

Analyse des Binärcodes der Börsenkurse (Teil I): Ein neuer Blick auf die technische Analyse

In diesem Artikel wird ein innovativer Ansatz für die technische Analyse vorgestellt, der auf der Umwandlung von Kursbewegungen in Binärcodes beruht. Der Autor zeigt, wie verschiedene Aspekte des Marktverhaltens – von einfachen Preisbewegungen bis hin zu komplexen Mustern – in einer Folge von Nullen und Einsen kodiert werden können.

Neuronale Netze im Handel: Ein hybrider Handelsrahmen mit prädiktiver Kodierung (StockFormer)

In diesem Artikel wird das hybride Handelssystem StockFormer vorgestellt, das die Algorithmen von Predictive Coding und dem Reinforcement Learning (RL) kombiniert. Das Framework verwendet 3 Transformer-Zweige mit einem integrierten Diversified Multi-Head Attention (DMH-Attn)-Mechanismus, der das ursprüngliche Aufmerksamkeitsmodul mit einem mehrköpfigen Block des Vorwärtsdurchlaufs verbessert und es ermöglicht, diverse Zeitreihenmuster über verschiedene Teilräume hinweg zu erfassen.

Trendstärke- und Richtungsindikator auf 3D-Balken

Wir werden einen neuen Ansatz zur Markttrendanalyse betrachten, der auf einer dreidimensionalen Visualisierung und Tensoranalyse der Marktmikrostruktur basiert.