Ensemble-Methoden zur Verbesserung von Klassifizierungsaufgaben in MQL5

Einführung

In einem früheren Artikel haben wir Methoden zur Modellkombination für numerische Vorhersagen untersucht. Dieser Artikel erweitert diese Untersuchung, indem er sich auf Ensemble-Techniken konzentriert, die speziell auf Klassifizierungsaufgaben zugeschnitten sind. Nebenbei untersuchen wir auch Strategien für den Einsatz von Komponentenklassifikatoren, die Klassenränge auf einer Ordinalskala erzeugen. Auch wenn numerische Kombinationstechniken manchmal auf Klassifizierungsaufgaben angewendet werden können, bei denen Modelle auf numerische Ergebnisse angewiesen sind, verfolgen viele Klassifizierer einen starreren Ansatz und treffen nur diskrete Klassenentscheidungen. Darüber hinaus weisen numerisch basierte Klassifikatoren häufig eine Instabilität bei der Vorhersage auf, was den Bedarf an speziellen Kombinationsmethoden unterstreicht.

Die in diesem Artikel besprochenen Klassifizierungsensembles arbeiten unter bestimmten Annahmen bezüglich ihrer Komponentenmodelle. Erstens wird davon ausgegangen, dass diese Modelle der Daten mit sich gegenseitig ausschließenden und erschöpfenden Klassenzielen trainiert werden, wodurch sichergestellt wird, dass jede Instanz zu genau einer Klasse gehört. Wenn eine „keine der oben genannten Optionen“ erforderlich ist, sollte sie entweder als separate Klasse behandelt oder mit Hilfe einer numerischen Kombinationsmethode mit einer definierten Zugehörigkeitsschwelle verwaltet werden. Außerdem wird von Komponentenmodellen erwartet, dass sie bei einem Eingabevektor von Prädiktoren N Ausgaben erzeugen, wobei N die Anzahl der Klassen darstellt. Diese Ausgaben können Wahrscheinlichkeiten oder Konfidenzwerte sein, die die Wahrscheinlichkeit der Zugehörigkeit zu den einzelnen Klassen angeben. Es könnte sich auch um binäre Entscheidungen handeln, bei denen eine Ausgabe 1,0 (wahr) und die anderen 0,0 (falsch) sind, oder die Modellausgaben könnten ganzzahlige Rangfolgen von 1 bis N sein, die die relative Wahrscheinlichkeit der Klassenzugehörigkeit widerspiegeln.

Einige der von uns untersuchten Ensemble-Methoden profitieren in hohem Maße von Komponentenklassifikatoren, die eine Rangfolge der Ergebnisse erstellen. Modelle, die in der Lage sind, die Wahrscheinlichkeit der Klassenzugehörigkeit genau abzuschätzen, sind in der Regel sehr wertvoll, aber es birgt erhebliche Risiken, die Ergebnisse als Wahrscheinlichkeiten zu behandeln, wenn sie es nicht sind. Bei einem Zweifel darüber, was die Modellergebnisse darstellen, kann es von Vorteil sein, sie in Ränge zu konvertieren. Der Nutzen von Ranginformationen steigt mit der Anzahl der Klassen. Bei der binären Klassifizierung bieten Ränge keinen zusätzlichen Einblick, und ihr Wert für Drei-Klassen-Probleme bleibt bescheiden. In Szenarien, die zahlreiche Klassen umfassen, ist die Möglichkeit, die Auswahl der Zweitplatzierten eines Modells zu interpretieren, jedoch von großem Nutzen, insbesondere wenn einzelne Vorhersagen mit Unsicherheit behaftet sind. So könnten beispielsweise Support-Vector-Maschinen (SVMs) so verbessert werden, dass sie nicht nur binäre Klassifizierungen, sondern auch Entscheidungsabstände für jede Klasse erzeugen und so einen besseren Einblick in die Zuverlässigkeit der Vorhersage bieten.

Ränge stellen auch eine zentrale Herausforderung bei Ensemble-Methoden dar: die Normalisierung der Ergebnisse verschiedener Klassifikationsmodelle. Betrachten wir zwei Modelle zur Analyse von Marktbewegungen: Das eine ist auf kurzfristige Preisschwankungen auf hochliquiden Märkten spezialisiert, während das andere auf langfristige Trends über Wochen oder Monate ausgerichtet ist. Der breitere Fokus des zweiten Modells könnte die kurzfristigen Vorhersagen verfälschen. Die Konvertierung von Klassenentscheidungen in Ränge entschärft dieses Problem und stellt sicher, dass wertvolle kurzfristige Erkenntnisse nicht von breiteren Trendsignalen überschattet werden. Dieser Ansatz führt zu ausgewogeneren und effektiveren Ensemble-Vorhersagen.

Alternative Ziele für die Kombination von Klassifikatoren

Das Hauptziel der Anwendung von Ensemble-Klassifikatoren ist in der Regel die Verbesserung der Klassifizierungsgenauigkeit. Dies muss nicht immer der Fall sein, denn bei manchen Klassifizierungsaufgaben kann es auch von Vorteil sein, über dieses spezifische Ziel hinauszuschauen. Neben der grundlegenden Klassifizierungsgenauigkeit können auch anspruchsvollere Erfolgsmessungen durchgeführt werden, um Szenarien zu berücksichtigen, in denen die ursprüngliche Entscheidung falsch sein könnte. In Anbetracht dessen kann die Klassifizierung durch zwei unterschiedliche, aber komplementäre Ziele angegangen werden, von denen jedes als Leistungsmaßstab für Klassenkombinationsstrategien dienen kann:

- Reduzierung des Klassen: Dieser Ansatz zielt darauf ab, die kleinste Teilmenge der ursprünglichen Klassen zu ermitteln, die mit hoher Wahrscheinlichkeit die wahre Klasse enthält. Hier ist die interne Rangfolge innerhalb der Teilmenge zweitrangig, um sicherzustellen, dass die Teilmenge sowohl kompakt ist als auch wahrscheinlich die richtige Klassifizierung enthält.

- Klassenrangfolge: Diese Methode konzentriert sich darauf, die Wahrscheinlichkeit der Klassenzugehörigkeit in eine Rangfolge zu bringen, um die wahre Klasse so nah wie möglich an der Spitze zu positionieren. Anstatt feste Rangschwellen zu verwenden, wird die Leistung durch Messung des durchschnittlichen Abstands zwischen der wahren Klasse und der bestplatzierten Position bewertet.

Bei bestimmten Anwendungen kann die Betonung eines dieser Schemata gegenüber dem anderen erhebliche Vorteile bringen. Selbst wenn eine solche Präferenz nicht ausdrücklich vorgeschrieben ist. Die Auswahl des relevantesten Ziels und die Implementierung des entsprechenden Fehlermaßes führt oft zu zuverlässigeren Leistungskennzahlen als die alleinige Verwendung der Klassifizierungsgenauigkeit. Außerdem müssen sich diese beiden Ziele nicht gegenseitig ausschließen. Ein hybrider Ansatz kann besonders effektiv sein: Zunächst wird eine Kombinationsmethode angewandt, die sich auf die Reduzierung der Klassenmenge konzentriert, um eine kleine, sehr wahrscheinliche Teilmenge von Klassen zu ermitteln. Dann wird eine sekundäre Methode verwendet, um die Klassen innerhalb dieser verfeinerten Teilmenge einzustufen. Die höchstrangige Klasse aus diesem zweistufigen Prozess wird zur endgültigen Entscheidung, wobei sowohl die Effizienz der Mengenreduzierung als auch die Präzision der geordneten Rangfolge zum Tragen kommen. Diese Zwei-Ziel-Strategie könnte einen robusteren Klassifizierungsrahmen bieten als herkömmliche Ein-Klassen-Vorhersagemethoden, insbesondere in komplexen Szenarien, in denen die Klassifizierungssicherheit stark schwankt. In diesem Sinne beginnen wir mit der Erforschung von Ensemble-Klassifikatoren.

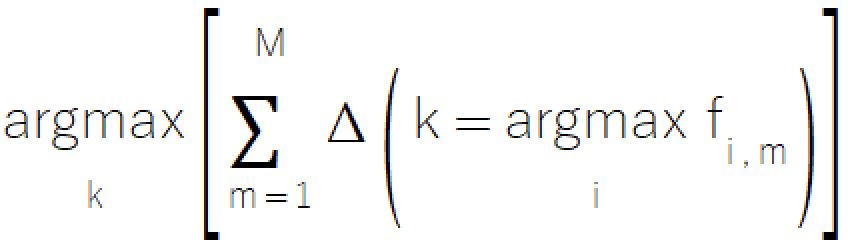

Ensembles auf der Grundlage der Mehrheitsregel

Die Mehrheitsregel ist ein einfacher und intuitiver Ansatz für die Ensemble-Klassifizierung, der vom bekannten Konzept der Abstimmung abgeleitet ist. Bei dieser Methode wird die Klasse ausgewählt, die die meisten Stimmen der Komponentenmodelle erhält. Diese unkomplizierte Methode ist besonders wertvoll in Szenarien, in denen Modelle nur eine diskrete Klassenauswahl bieten können, was sie zu einer hervorragenden Wahl für Systeme mit begrenzter Modellausgereiftheit macht. Die formale mathematische Darstellung der Mehrheitsregel ist in der folgenden Gleichung dargestellt.

Die Implementierung der Mehrheitsregel befindet sich in der Datei ensemble.mqh, wo die Klasse CMajority ihre Kernfunktionalität über die Methode classify() verwaltet.

//+------------------------------------------------------------------+ //| Compute the winner via simple majority | //+------------------------------------------------------------------+ class CMajority { private: ulong m_outputs; ulong m_inputs; vector m_output; matrix m_out; public: CMajority(void); ~CMajority(void); ulong classify(vector &inputs, IClassify* &models[]); };

Diese Methode nimmt als Eingabe einen Vektor von Prädiktoren und ein Array von Komponentenmodellen, die als IClassify-Zeiger bereitgestellt werden. Die Schnittstelle IClassify standardisiert die Modellmanipulation in ähnlicher Weise wie die im vorherigen Artikel beschriebene Schnittstelle IModel.

//+------------------------------------------------------------------+ //| IClassify interface defining methods for manipulation of | //|classification algorithms | //+------------------------------------------------------------------+ interface IClassify { //train a model bool train(matrix &predictors,matrix&targets); //make a prediction with a trained model vector classify(vector &predictors); //get number of inputs for a model ulong getNumInputs(void); //get number of class outputs for a model ulong getNumOutputs(void); };

Die Funktion classify() gibt eine ganze Zahl zurück, die für die ausgewählte Klasse steht und von null bis eins weniger als die Gesamtzahl der möglichen Klassen reicht. Die zurückgegebene Klasse entspricht derjenigen, die von den Komponentenmodellen die meisten „Stimmen“ erhalten hat. Die Umsetzung der Mehrheitsregel mag auf den ersten Blick einfach erscheinen, aber es gibt ein großes Problem bei ihrer praktischen Anwendung. Was passiert, wenn zwei oder mehr Klassen die gleiche Anzahl von Stimmen erhalten? In demokratischen Systemen führt eine solche Situation zu einer weiteren Abstimmungsrunde, aber das wird in diesem Zusammenhang nicht funktionieren. Um Gleichstände gerecht aufzulösen, führt die Methode während des Vergleichsprozesses kleine zufällige Störungen in die Stimmenzahl jeder Klasse ein. Durch diese Technik wird sichergestellt, dass gleichwertige Klassen die gleiche Auswahlwahrscheinlichkeit erhalten, wodurch die Integrität der Methode gewahrt und Verzerrungen vermieden werden.

//+------------------------------------------------------------------+ //| ensemble classification | //+------------------------------------------------------------------+ ulong CMajority::classify(vector &inputs,IClassify *&models[]) { double best, sum, temp; ulong ibest; best =0; ibest = 0; CHighQualityRandStateShell state; CHighQualityRand::HQRndRandomize(state.GetInnerObj()); m_output = vector::Zeros(models[0].getNumOutputs()); for(uint i = 0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); m_output[classification.ArgMax()] += 1.0; } sum = 0.0; for(ulong i=0 ; i<m_output.Size() ; i++) { temp = m_output[i] + 0.999 * CAlglib::HQRndUniformR(state); if((i == 0) || (temp > best)) { best = temp ; ibest = i ; } sum += m_output[i] ; } if(sum>0.0) m_output/=sum; return ibest; }

Trotz ihrer Nützlichkeit weist die Mehrheitsregel mehrere Einschränkungen auf, die es zu beachten gilt:

- Bei dieser Methode wird nur die erste Wahl jedes Modells berücksichtigt, sodass wertvolle Informationen, die in den unteren Rängen enthalten sind, möglicherweise nicht berücksichtigt werden. Die Verwendung eines einfachen arithmetischen Mittels der Klassenergebnisse mag zwar als Lösung erscheinen, doch kann dieser Ansatz zusätzliche Komplikationen im Zusammenhang mit Rauschen und Skalierung mit sich bringen.

- In Szenarien mit mehreren Klassen erfasst der einfache Abstimmungsmechanismus möglicherweise nicht die subtilen Beziehungen zwischen verschiedenen Klassenoptionen.

- Bei diesem Ansatz werden alle Komponentenmodelle gleich behandelt, unabhängig von ihren individuellen Leistungsmerkmalen oder ihrer Zuverlässigkeit in unterschiedlichen Kontexten.

Die nächste Methode, die wir erörtern werden, ist ein anderes, auf einer Abstimmung basierendes System, das versucht, einige der Nachteile der Mehrheitsregel zu überwinden, indem es ein wenig ausgefeilter ist.

Die Borda-Wahl

Die Borda-Wahl berechnet eine Punktzahl für jede Klasse, indem sie über alle Modelle hinweg die Anzahl der Klassen aggregiert, die in der Bewertung des jeweiligen Modells unter der Klasse rangieren. Mit dieser Methode wird ein optimales Gleichgewicht zwischen der Nutzung und der Abschwächung des Einflusses nachrangiger Wahlmöglichkeiten erreicht, was eine raffiniertere Alternative zu einfacheren Wahlmechanismen darstellt. In einem System mit „m“ Modellen und „k“ Klassen ist die Bewertungsspanne klar definiert: Eine Klasse, die in allen Modellen durchweg an letzter Stelle steht, erhält eine Borda-Zahl von Null, während eine Klasse, die in allen Modellen an erster Stelle steht, eine maximale Punktzahl von m(k-1) erreicht.

Diese Methode stellt einen bedeutenden Fortschritt gegenüber einfacheren Abstimmungsmethoden dar, denn sie bietet die Möglichkeit, das gesamte Spektrum der Modellvorhersagen zu erfassen und zu nutzen, ohne dabei die Effizienz der Berechnungen zu beeinträchtigen. Obwohl die Methode effektiv mit Gleichheiten innerhalb der einzelnen Modellrankings umgeht, müssen Gleichheiten in den endgültigen Borda-Zahlen zwischen den Modellen sorgfältig berücksichtigt werden. Für binäre Klassifizierungsaufgaben ist die Borda-Wahl funktional äquivalent zur Mehrheitsregel. Seine eindeutigen Vorteile kommen daher vor allem in Szenarien mit drei oder mehr Klassen zum Tragen. Die Effizienz der Methode beruht auf ihrem sortierungsbasierten Ansatz, der eine rationelle Verarbeitung der Klassenausgaben ermöglicht und gleichzeitig genaue Indexzuordnungen gewährleistet.

Die Umsetzung der Borda-Wahl weist strukturelle Ähnlichkeiten mit der Methodik der Mehrheitsregel auf, bietet jedoch zusätzliche Effizienzgewinne bei der Berechnung. Der Prozess wird durch die Klasse CBorda innerhalb von ensemble.mqh verwaltet und funktioniert ohne eine vorherige Trainingsphase.

//+------------------------------------------------------------------+ //| Compute the winner via Borda count | //+------------------------------------------------------------------+ class CBorda { private: ulong m_outputs; ulong m_inputs; vector m_output; matrix m_out; long m_indices[]; public: CBorda(void); ~CBorda(void); ulong classify(vector& inputs, IClassify* &models[]); };

Das Klassifizierungsverfahren beginnt mit der Initialisierung des Ausgabevektors, der die kumulativen Borda-Zahlen speichern soll. Anschließend erfolgt die Bewertung aller Komponentenmodelle anhand des Eingangsvektors. Ein Array von Indizes wird erstellt, um die Klassenbeziehungen zu verfolgen. Die Klassifizierungsergebnisse der einzelnen Modelle werden in aufsteigender Reihenfolge sortiert. Und schließlich werden die Borda-Zahlen auf der Grundlage der sortierten Ranglisten systematisch kumuliert.

//+------------------------------------------------------------------+ //| ensemble classification | //+------------------------------------------------------------------+ ulong CBorda::classify(vector &inputs,IClassify *&models[]) { double best=0, sum, temp; ulong ibest=0; CHighQualityRandStateShell state; CHighQualityRand::HQRndRandomize(state.GetInnerObj()); if(m_indices.Size()) ArrayFree(m_indices); m_output = vector::Zeros(models[0].getNumOutputs()); if(ArrayResize(m_indices, int(m_output.Size()))<0) { Print(__FUNCTION__, " ", __LINE__, " array resize error ", GetLastError()); return ULONG_MAX; } for(uint i = 0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); for(long j = 0; j<long(classification.Size()); j++) m_indices[j] = j; if(!classification.Size()) { Print(__FUNCTION__," ", __LINE__," empty vector "); return ULONG_MAX; } qsortdsi(0,classification.Size()-1,classification,m_indices); for(ulong k =0; k<classification.Size(); k++) m_output[m_indices[k]] += double(k); } sum = 0.0; for(ulong i=0 ; i<m_output.Size() ; i++) { temp = m_output[i] + 0.999 * CAlglib::HQRndUniformR(state); if((i == 0) || (temp > best)) { best = temp ; ibest = i ; } sum += m_output[i] ; } if(sum>0.0) m_output/=sum; return ibest; }

In den folgenden Abschnitten betrachten wir Ensembles, die die meisten, wenn nicht sogar alle Informationen, die von den Komponentenmodellen generiert werden, in die endgültige Klassenentscheidung einbeziehen.

Mittelwertbildung für die Ausgaben des Komponentenmodells

Wenn die Komponentenmodelle Ergebnisse mit aussagekräftigen und vergleichbaren relativen Werten zwischen den Modellen erzeugen, verbessert die Einbeziehung dieser numerischen Messungen die Ensembleleistung erheblich. Während die Methoden der Mehrheitsregel und der Borda-Wahl wesentliche Teile der verfügbaren Informationen unberücksichtigt lassen, bietet die Durchschnittsbildung der Komponentenausgaben einen umfassenderen Ansatz für die Datennutzung. Die Methode berechnet den mittleren Output für jede Klasse über alle Komponentenmodelle hinweg. Da die Anzahl der Modelle konstant bleibt, ist dieser Ansatz mathematisch gleichbedeutend mit der Addition der Ergebnisse. Bei dieser Technik wird jedes Klassifizierungsmodell als numerischer Prädiktor behandelt und durch einfache Mittelungsmethoden kombiniert. Die endgültige Klassifizierungsentscheidung wird durch die Identifizierung der Klasse mit der höchsten aggregierten Leistung getroffen.

Ein wesentlicher Unterschied besteht zwischen der Mittelwertbildung bei numerischen Vorhersageaufgaben und bei Klassifizierungsaufgaben. Bei numerischen Vorhersagen haben die Komponentenmodelle in der Regel ein gemeinsames Trainingsziel, das die Konsistenz der Ergebnisse gewährleistet. Bei Klassifizierungsaufgaben, bei denen nur die Rangfolge der Ergebnisse für die einzelnen Modelle von Bedeutung ist, können jedoch unbeabsichtigt unvergleichbare Ergebnisse entstehen. Manchmal kann diese Inkohärenz dazu führen, dass die Kombination eher zu einem impliziten gewichteten Durchschnitt als zu einem echten arithmetischen Mittel wird. Andererseits können einzelne Modelle einen unverhältnismäßig großen Einfluss auf die Endsumme haben, was die Wirksamkeit des Ensembles beeinträchtigt. Um die Integrität des Metamodells aufrechtzuerhalten, ist es daher von entscheidender Bedeutung, die Kohärenz der Ergebnisse aller Komponentenmodelle zu überprüfen.

Unter der Annahme, dass die Ergebnisse der Komponentenmodelle tatsächlich Wahrscheinlichkeiten sind, wurden alternative Kombinationsmethoden entwickelt, die konzeptionell der Mittelwertbildung ähneln. Eine davon ist die Produktregel. Damit wird die Addition durch die Multiplikation der Modellausgaben ersetzt. Das Problem ist, dass dieser Ansatz extrem empfindlich auf selbst kleine Verletzungen der Wahrscheinlichkeitsannahmen reagiert. Die signifikante Unterschätzung der Klassenwahrscheinlichkeit durch ein einzelnes Modell kann diese Klasse irreversibel benachteiligen, da die Multiplikation mit Werten nahe Null zu vernachlässigbaren Ergebnissen führt, unabhängig von anderen Faktoren. Diese erhöhte Empfindlichkeit macht die Produktregel trotz ihrer theoretischen Eleganz für die meisten Anwendungen unpraktisch. Sie dient in erster Linie als warnendes Beispiel dafür, dass sich mathematisch fundierte Ansätze in der praktischen Umsetzung als problematisch erweisen können.

Die Implementierung der Durchschnittsregel befindet sich in der Klasse CAvgClass, die strukturell den Rahmen der Klasse CMajority widerspiegelt.

//+------------------------------------------------------------------+ //| full resolution' version of majority rule. | //+------------------------------------------------------------------+ class CAvgClass { private: ulong m_outputs; ulong m_inputs; vector m_output; public: CAvgClass(void); ~CAvgClass(void); ulong classify(vector &inputs, IClassify* &models[]); };

Während der Klassifizierung sammelt die Methode classify() Vorhersagen von allen Komponentenmodellen und kumuliert ihre jeweiligen Ergebnisse. Die Abschlussklasse wird auf der Grundlage der höchsten kumulativen Punktzahl ermittelt.

//+------------------------------------------------------------------+ //| make classification with consensus model | //+------------------------------------------------------------------+ ulong CAvgClass::classify(vector &inputs, IClassify* &models[]) { m_output=vector::Zeros(models[0].getNumOutputs()); vector model_classification; for(uint i =0 ; i<models.Size(); i++) { model_classification = models[i].classify(inputs); m_output+=model_classification; } double sum = m_output.Sum(); ulong min = m_output.ArgMax(); m_output/=sum; return min; }

Der Median

Die Aggregation von Mittelwerten hat den Vorteil, dass die Daten umfassend genutzt werden können, allerdings um den Preis der Empfindlichkeit gegenüber Ausreißern, was die Leistung des Ensembles beeinträchtigen kann. Der Median stellt eine robuste Alternative dar, die trotz einer geringfügigen Verringerung der Informationsausnutzung zuverlässige Messungen der zentralen Tendenz liefert und gleichzeitig resistent gegen Extremwerte ist. Die Median-Ensemble-Methode, die durch die CMedian-Klasse in ensemble.mqh implementiert wird, bietet einen einfachen, aber effektiven Ansatz zur Ensemble-Klassifikation. Diese Implementierung geht auf die Herausforderungen der Verwaltung von Ausreißerprognosen und der Beibehaltung einer sinnvollen relativen Ordnung zwischen den Klassen ein. Ausreißer werden behandelt, indem eine rangbasierte Transformation durchgeführt wird. Die Ergebnisse jedes Komponentenmodells werden unabhängig voneinander eingestuft, und dann wird der Mittelwert dieser Einstufungen für jede Klasse berechnet. Mit diesem Ansatz wird der Einfluss extremer Vorhersagen wirksam reduziert, während die wesentliche hierarchische Beziehung zwischen den Klassenvorhersagen erhalten bleibt.

Der Median-Ansatz erhöht die Stabilität bei gelegentlich auftretenden extremen Vorhersagen. Es bleibt auch bei asymmetrischen oder schiefen Vorhersageverteilungen effektiv und stellt einen ausgewogenen Kompromiss zwischen der Nutzung vollständiger Informationen und dem robusten Umgang mit Ausreißern dar. Bei der Anwendung der Medianregel sollten Praktiker ihre spezifischen Anwendungsfallanforderungen bewerten. In Szenarien, in denen gelegentlich extreme Vorhersagen zu erwarten sind oder in denen die Stabilität der Vorhersagen von größter Bedeutung ist, bietet die Medianmethode oft ein optimales Gleichgewicht zwischen Zuverlässigkeit und Leistung.

//+------------------------------------------------------------------+ //| median of predications | //+------------------------------------------------------------------+ class CMedian { private: ulong m_outputs; ulong m_inputs; vector m_output; matrix m_out; public: CMedian(void); ~CMedian(void); ulong classify(vector &inputs, IClassify* &models[]); }; //+------------------------------------------------------------------+ //| constructor | //+------------------------------------------------------------------+ CMedian::CMedian(void) { } //+------------------------------------------------------------------+ //| destructor | //+------------------------------------------------------------------+ CMedian::~CMedian(void) { } //+------------------------------------------------------------------+ //| consensus classification | //+------------------------------------------------------------------+ ulong CMedian::classify(vector &inputs,IClassify *&models[]) { m_out = matrix::Zeros(models[0].getNumOutputs(),models.Size()); vector model_classification; for(uint i = 0; i<models.Size(); i++) { model_classification = models[i].classify(inputs); if(!m_out.Col(model_classification,i)) { Print(__FUNCTION__, " ", __LINE__, " failed row insertion ", GetLastError()); return ULONG_MAX; } } m_output = vector::Zeros(models[0].getNumOutputs()); for(ulong i = 0; i<m_output.Size(); i++) { vector row = m_out.Row(i); if(!row.Size()) { Print(__FUNCTION__," ", __LINE__," empty vector "); return ULONG_MAX; } qsortd(0,row.Size()-1,row); m_output[i] = row.Median(); } double sum = m_output.Sum(); ulong mx = m_output.ArgMax(); if(sum>0.0) m_output/=sum; return mx; }

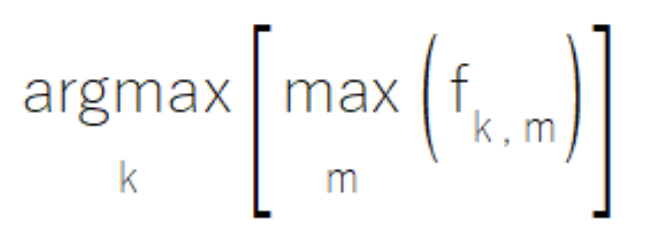

MaxMax und MaxMin Ensemble-Klassifikatoren

Innerhalb eines Ensembles von Komponentenmodellen kann es vorkommen, dass einzelne Modelle so konzipiert wurden, dass sie über Fachwissen in bestimmten Untergruppen der Klassenmenge verfügen. Wenn sie in ihren spezialisierten Bereichen arbeiten, erzeugen diese Modelle Ergebnisse mit hoher Zuverlässigkeit, während sie für Klassen außerhalb ihres Fachgebiets weniger aussagekräftige, moderate Werte produzieren. Die MaxMax-Regel geht auf dieses Szenario ein, indem sie jede Klasse auf der Grundlage ihres maximalen Outputs über alle Modelle hinweg bewertet. Bei diesem Ansatz werden Vorhersagen mit hoher Zuverlässigkeit bevorzugt, während potenziell weniger informative, moderate Ergebnisse unberücksichtigt bleiben. Praktiker sollten jedoch beachten, dass sich diese Methode für Szenarien, in denen Sekundärausgänge einen erheblichen analytischen Wert haben, als ungeeignet erweist.

Die Implementierung der MaxMax-Regel befindet sich in der Klasse CMaxmax in ensemble.mqh, die einen strukturierten Rahmen für die Nutzung von Modellspezialisierungsmustern bietet.

//+------------------------------------------------------------------+ //|Compute the maximum of the predictions | //+------------------------------------------------------------------+ class CMaxMax { private: ulong m_outputs; ulong m_inputs; vector m_output; matrix m_out; public: CMaxMax(void); ~CMaxMax(void); ulong classify(vector &inputs, IClassify* &models[]); }; //+------------------------------------------------------------------+ //| constructor | //+------------------------------------------------------------------+ CMaxMax::CMaxMax(void) { } //+------------------------------------------------------------------+ //| destructor | //+------------------------------------------------------------------+ CMaxMax::~CMaxMax(void) { } //+------------------------------------------------------------------+ //| ensemble classification | //+------------------------------------------------------------------+ ulong CMaxMax::classify(vector &inputs,IClassify *&models[]) { double sum; ulong ibest; m_output = vector::Zeros(models[0].getNumOutputs()); for(uint i = 0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); for(ulong j = 0; j<classification.Size(); j++) { if(classification[j] > m_output[j]) m_output[j] = classification[j]; } } ibest = m_output.ArgMax(); sum = m_output.Sum(); if(sum>0.0) m_output/=sum; return ibest; }

Umgekehrt zeichnen sich einige Ensemblesysteme durch Modelle aus, die bestimmte Klassen eher ausschließen als sie zu identifizieren. In diesen Fällen, wenn eine Instanz zu einer bestimmten Klasse gehört, erzeugt mindestens ein Modell im Ensemble eine deutlich niedrige Ausgabe für jede falsche Klasse, wodurch sie effektiv aus der Betrachtung ausgeschlossen werden.

Die MaxMin-Regel macht sich diese Eigenschaft zunutze, indem sie die Klassenzugehörigkeit auf der Grundlage des minimalen Outputs aller Modelle für jede Klasse bewertet.

Dieser Ansatz, der in der Klasse CMaxmin in ensemble.mqh implementiert ist, bietet einen Mechanismus zur Nutzung der ausschließenden Stärken bestimmter Modelle.

//+------------------------------------------------------------------+ //| Compute the minimum of the predictions | //+------------------------------------------------------------------+ class CMaxMin { private: ulong m_outputs; ulong m_inputs; vector m_output; matrix m_out; public: CMaxMin(void); ~CMaxMin(void); ulong classify(vector &inputs, IClassify* &models[]); }; //+------------------------------------------------------------------+ //| constructor | //+------------------------------------------------------------------+ CMaxMin::CMaxMin(void) { } //+------------------------------------------------------------------+ //| destructor | //+------------------------------------------------------------------+ CMaxMin::~CMaxMin(void) { } //+------------------------------------------------------------------+ //| ensemble classification | //+------------------------------------------------------------------+ ulong CMaxMin::classify(vector &inputs,IClassify *&models[]) { double sum; ulong ibest; for(uint i = 0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); if(i == 0) m_output = classification; else { for(ulong j = 0; j<classification.Size(); j++) if(classification[j] < m_output[j]) m_output[j] = classification[j]; } } ibest = m_output.ArgMax(); sum = m_output.Sum(); if(sum>0.0) m_output/=sum; return ibest; }

Bei der Umsetzung des MaxMax- oder MaxMin-Ansatzes sollten die Praktiker die Eigenschaften ihres Modellensembles sorgfältig bewerten. Für den MaxMax-Ansatz ist es wichtig zu bestätigen, dass die Modelle klare Spezialisierungsmuster aufweisen. Es ist besonders wichtig sicherzustellen, dass mäßige Ergebnisse eher Rauschen als wertvolle sekundäre Informationen darstellen, und schließlich, dass das Ensemble eine umfassende Abdeckung aller relevanten Klassen bietet. Bei der Anwendung des MaxMin-Ansatzes sollten Praktiker sicherstellen, dass das Ensemble insgesamt alle potenziellen Fehlklassifizierungsszenarien abdeckt und auf Lücken in der Ausschlussabdeckung achten.

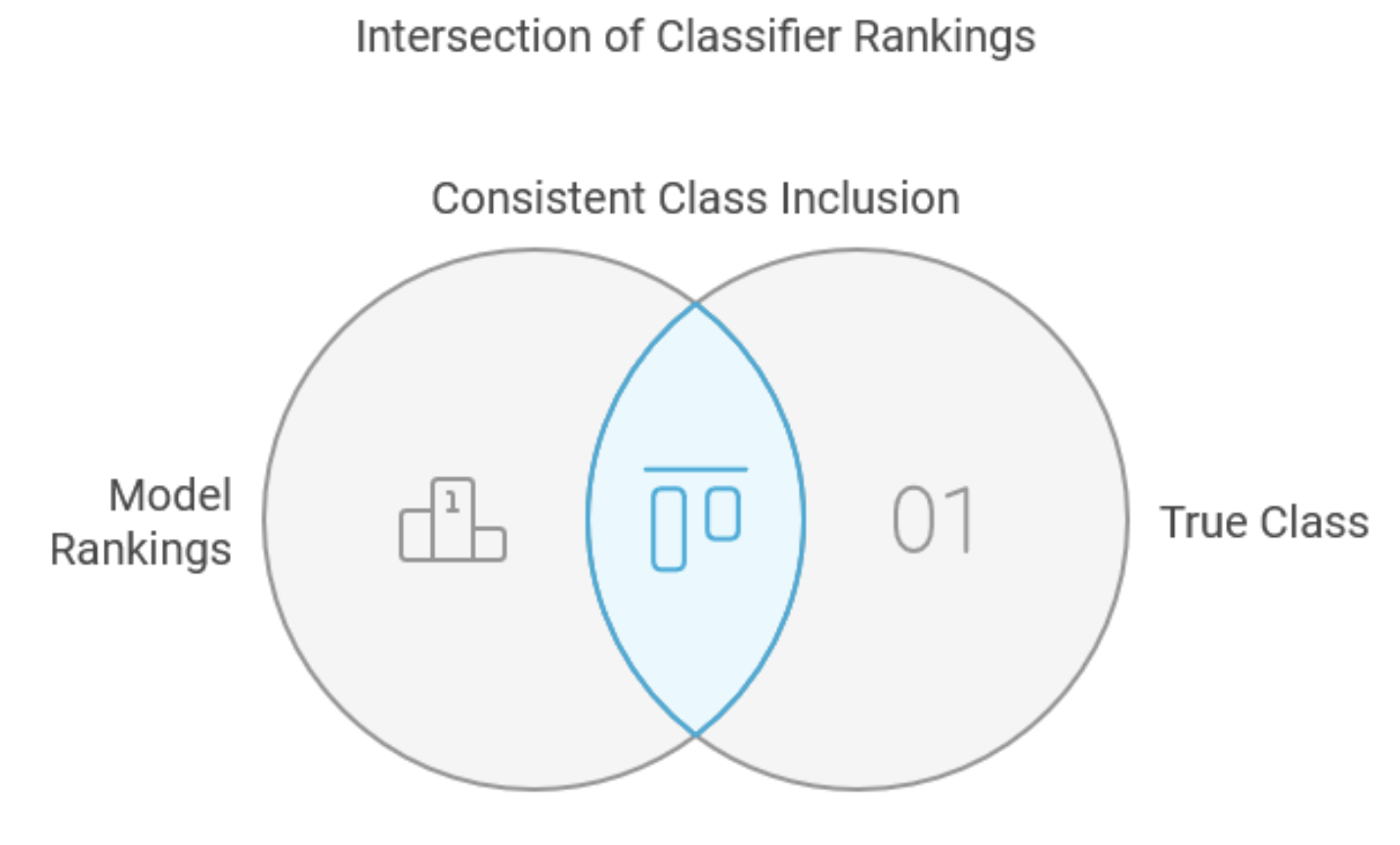

Die Schnittpunktmethode

Die Schnittmengenmethode ist ein spezieller Ansatz für die Kombination von Klassifikatoren, der in erster Linie für die Reduzierung von Klassenmengen und nicht für die allgemeine Klassifizierung konzipiert ist. Zugegeben, ihre direkte Anwendung mag begrenzt sein, aber sie ist in diesem Text enthalten, um als grundlegender Vorläufer für robustere Methoden, insbesondere die Vereinigungsmethode, zu dienen. Bei diesem Ansatz müssen die Komponentenmodelle für jeden Eingabefall eine vollständige Klasseneinstufung erstellen, und zwar von der höchsten zur niedrigsten Wahrscheinlichkeit. Viele Klassifikatoren können diese Anforderung erfüllen, und der Prozess der Einstufung reellwertiger Ausgaben verbessert oft die Leistung, indem Rauschen effektiv gefiltert wird, während wertvolle Informationen erhalten bleiben. In der Trainingsphase der Methode wird die Mindestanzahl der bestplatzierten Ergebnisse festgelegt, die jedes Komponentenmodell beibehalten muss, um eine konsistente Einbeziehung der wahren Klasse in die Trainingsmenge zu gewährleisten. Bei neuen Fällen besteht die kombinierte Entscheidung aus einer minimalen Teilmenge, die die wahre Klasse enthält und durch Überschneidung der minimalen Teilmengen aus allen Komponentenmodellen bestimmt wird.

Betrachten wir ein praktisches Beispiel mit mehreren Klassen und vier Modellen. Die Untersuchung der fünf Stichproben im Trainingssatz zeigt unterschiedliche Rangmuster für die wahre Klasse in den verschiedenen Modellen.

| Muster | Modell 1 | Modell 2 | Modell 3 | Modell 4 |

|---|---|---|---|---|

| 1 | 3 | 21 | 4 | 5 |

| 2 | 8 | 4 | 8 | 9 |

| 3 | 1 | 17 | 12 | 3 |

| 4 | 7 | 16 | 2 | 8 |

| 5 | 7 | 8 | 6 | 1 |

| Max | 8 | 21 | 12 | 9 |

Die Tabelle zeigt, dass die wahre Klasse der zweiten Stichprobe beim ersten Modell an achter Stelle, beim zweiten Modell an vierter Stelle und beim vierten Modell an neunter Stelle liegt. Die letzte Zeile der Tabelle zeigt spaltenweise die höchsten Ränge, nämlich 8, 21, 12 bzw. 9. Bei der Bewertung unbekannter Fälle wählt das Ensemble die bestplatzierten Klassen jedes Modells anhand dieser Schwellenwerte aus und schneidet sie, sodass eine endgültige Teilmenge von Klassen entsteht, die allen Gruppen gemeinsam ist.

Die Klasse CIntersection verwaltet die Implementierung der Schnittmethode und verfügt mit der Funktion fit() über ein eigenes Trainingsverfahren. Diese Funktion analysiert Trainingsdaten, um Worst-Case-Rankings für jedes Modell zu bestimmen und die Mindestanzahl an Klassen mit Top-Rankings zu ermitteln, die erforderlich sind, um konsistent korrekte Klassifizierungen zu erhalten.

//+------------------------------------------------------------------+ //| Use intersection rule to compute minimal class set | //+------------------------------------------------------------------+ class CIntersection { private: ulong m_nout; long m_indices[]; vector m_ranks; vector m_output; public: CIntersection(void); ~CIntersection(void); ulong classify(vector &inputs, IClassify* &models[]); bool fit(matrix &inputs, matrix &targets, IClassify* &models[]); vector proba(void) { return m_output;} };

Durch den Aufruf der Methode classify() der Klasse CIntersection werden alle Komponentenmodelle nacheinander anhand der Eingabedaten ausgewertet. Für jedes Modell wird der Ausgangsvektor sortiert, und die Indizes des sortierten Vektors werden verwendet, um die Schnittmenge der Klassen zu berechnen, die zur höchstbewerteten Teilmenge für jedes Modell gehören.

//+------------------------------------------------------------------+ //| fit an ensemble model | //+------------------------------------------------------------------+ bool CIntersection::fit(matrix &inputs,matrix &targets,IClassify *&models[]) { m_nout = targets.Cols(); m_output = vector::Ones(m_nout); m_ranks = vector::Zeros(models.Size()); double best = 0.0; ulong nbad; if(ArrayResize(m_indices,int(m_nout))<0) { Print(__FUNCTION__, " ", __LINE__, " array resize error ", GetLastError()); return false; } ulong k; for(ulong i = 0; i<inputs.Rows(); i++) { vector trow = targets.Row(i); vector inrow = inputs.Row(i); k = trow.ArgMax(); best = trow[k]; for(uint j = 0; j<models.Size(); j++) { vector classification = models[j].classify(inrow); best = classification[k]; nbad = 1; for(ulong ii = 0; ii<m_nout; ii++) { if(ii == k) continue; if(classification[ii] >= best) ++nbad; } if(nbad > ulong(m_ranks[j])) m_ranks[j] = double(nbad); } } return true; } //+------------------------------------------------------------------+ //| ensemble classification | //+------------------------------------------------------------------+ ulong CIntersection::classify(vector &inputs,IClassify *&models[]) { for(long j =0; j<long(m_nout); j++) m_indices[j] = j; for(uint i =0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); ArraySort(m_indices); qsortdsi(0,classification.Size()-1,classification,m_indices); for(ulong j = 0; j<m_nout-ulong(m_ranks[i]); j++) { m_output[m_indices[j]] = 0.0; } } ulong n=0; double cut = 0.5; for(ulong i = 0; i<m_nout; i++) { if(m_output[i] > cut) ++n; } return n; }

Trotz ihrer theoretischen Eleganz weist die Schnittpunktmethode einige erhebliche Einschränkungen auf. Es garantiert zwar die Einbeziehung echter Klassen aus der Trainingsmenge, doch wird dieser Vorteil durch die damit verbundenen Einschränkungen geschmälert. Die Methode kann auch leere Klassenuntergruppen für Fälle außerhalb des Trainingssatzes erzeugen, insbesondere wenn die bestplatzierten Untergruppen keine gemeinsamen Elemente für alle Modelle aufweisen. Am kritischsten ist, dass die Methode, die sich auf die schlechteste Leistung stützt, oft zu große Klassenuntergruppen ergibt, was sowohl die Effektivität als auch die Effizienz der Methode mindert.

Die Schnittpunktmethode kann in bestimmten Kontexten nützlich sein, in denen alle Komponentenmodelle über den gesamten Klassensatz hinweg konsistent funktionieren. Seine Empfindlichkeit gegenüber schlechter Modellleistung in nicht spezialisierten Bereichen schränkt jedoch häufig seinen praktischen Nutzen ein, insbesondere bei Anwendungen, die auf spezialisierte Modelle für verschiedene Klassenuntergruppen angewiesen sind. Letztendlich liegt der primäre Wert dieser Methode in ihrem konzeptionellen Beitrag zu robusteren Ansätzen wie der Union-Methode und nicht in ihrer direkten Anwendung bei den meisten Klassifizierungsaufgaben.

Die Vereinigungsregel

Die Vereinigungsregel stellt eine strategische Verbesserung der Schnittmengenmethode dar, die deren primäre Einschränkung, nämlich die übermäßige Abhängigkeit von Worst-Case-Leistungen, behebt. Diese Modifikation erweist sich als besonders wertvoll, wenn spezialisierte Modelle mit unterschiedlichen Fachgebieten kombiniert werden, um den Schwerpunkt von Worst-Case- auf Best-Case-Leistungsszenarien zu verlagern. Der anfängliche Prozess spiegelt den Ansatz der Überschneidungsmethode wider: die Analyse von Trainingsfällen, um die wahren Klassenrankings der Komponentenmodelle zu bestimmen. Die Vereinigungsregel weicht jedoch davon ab, indem sie für jeden Fall das Modell mit der besten Leistung ermittelt und verfolgt, anstatt die schlechteste Leistung zu überwachen. Die Methode wertet dann die ungünstigste dieser Best-Case-Leistungen über den gesamten Trainingsdatensatz aus. Für die Klassifizierung unbekannter Fälle erstellt das System eine kombinierte Klassenuntermenge, indem es die optimalen Untermengen der einzelnen Komponentenmodelle zusammenführt. Betrachten Sie unser vorheriges Beispiel eines Datensatzes, der nun um Spalten zur Leistungsverfolgung mit dem Präfix „Perf“ erweitert wurde.

| Muster | Modell 1 | Modell 2 | Modell 3 | Modell 4 | Perf_Modell 1 | Perf_Modell 2 | Perf_Modell 3 | Perf_Modell 4 |

|---|---|---|---|---|---|---|---|---|

| 1 | 3 | 21 | 4 | 5 | 3 | 0 | 0 | 0 |

| 2 | 8 | 4 | 8 | 9 | 0 | 4 | 0 | 0 |

| 3 | 1 | 17 | 12 | 3 | 1 | 0 | 0 | 0 |

| 4 | 7 | 16 | 2 | 8 | 0 | 0 | 2 | 0 |

| 5 | 7 | 8 | 6 | 1 | 0 | 0 | 0 | 1 |

| Max | 3 | 4 | 2 | 1 |

In den zusätzlichen Spalten sind die Fälle aufgeführt, in denen jedes Modell eine überdurchschnittliche Leistung zeigt, wobei die unterste Zeile die Maximalwerte dieser Best-Case-Szenarien angibt.

Die Vereinigungsregel bietet mehrere deutliche Vorteile gegenüber der Schnittpunktmethode. Dadurch wird die Möglichkeit leerer Teilmengen ausgeschlossen, da mindestens ein Modell in jedem Fall optimal funktioniert. Die Methode verwaltet auch wirksam die Fachmodelle, indem sie schlechte Leistungen außerhalb ihres Fachgebiets während der Ausbildung außer Acht lässt, sodass die entsprechenden Fachleute die Kontrolle übernehmen können. Schließlich bietet es einen natürlichen Mechanismus zur Identifizierung und zum potenziellen Ausschluss von Modellen, die durchgängig unterdurchschnittlich abschneiden, was durch Spalten mit Nullen in der Tracking-Matrix angezeigt wird.

Die Implementierung der Union-Methode weist erhebliche strukturelle Ähnlichkeiten mit der Überschneidungsmethode auf, wobei der m_ranks-Container zur Überwachung der Maximalwerte der Performance-Tracking-Spalten verwendet wird.

//+------------------------------------------------------------------+ //| Use union rule to compute minimal class set | //+------------------------------------------------------------------+ class CUnion { private: ulong m_nout; long m_indices[]; vector m_ranks; vector m_output; public: CUnion(void); ~CUnion(void); ulong classify(vector &inputs, IClassify* &models[]); bool fit(matrix &inputs, matrix &targets, IClassify* &models[]); vector proba(void) { return m_output;} };

Wichtige Unterschiede ergeben sich jedoch bei der Behandlung von Klassenrangfolgen und der Initialisierung von Flaggen. Während des Trainings verfolgt das System die minimalen Ränge der Modelle für jeden Fall und aktualisiert bei Bedarf die Maximalwerte in m_ranks.

//+------------------------------------------------------------------+ //| fit an ensemble model | //+------------------------------------------------------------------+ bool CUnion::fit(matrix &inputs,matrix &targets,IClassify *&models[]) { m_nout = targets.Cols(); m_output = vector::Zeros(m_nout); m_ranks = vector::Zeros(models.Size()); double best = 0.0; ulong nbad; if(ArrayResize(m_indices,int(m_nout))<0) { Print(__FUNCTION__, " ", __LINE__, " array resize error ", GetLastError()); return false; } ulong k, ibestrank=0, bestrank=0; for(ulong i = 0; i<inputs.Rows(); i++) { vector trow = targets.Row(i); vector inrow = inputs.Row(i); k = trow.ArgMax(); for(uint j = 0; j<models.Size(); j++) { vector classification = models[j].classify(inrow); best = classification[k]; nbad = 1; for(ulong ii = 0; ii<m_nout; ii++) { if(ii == k) continue; if(classification[ii] >= best) ++nbad; } if(j == 0 || nbad < bestrank) { bestrank = nbad; ibestrank = j; } } if(bestrank > ulong(m_ranks[ibestrank])) m_ranks[ibestrank] = double(bestrank); } return true; }

Die Klassifizierungsphase umfasst schrittweise Klassen, die bestimmte Leistungskriterien erfüllen.

//+------------------------------------------------------------------+ //| ensemble classification | //+------------------------------------------------------------------+ ulong CUnion::classify(vector &inputs,IClassify *&models[]) { for(long j =0; j<long(m_nout); j++) m_indices[j] = j; for(uint i =0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); ArraySort(m_indices); qsortdsi(0,classification.Size()-1,classification,m_indices); for(ulong j =(m_nout-ulong(m_ranks[i])); j<m_nout; j++) { m_output[m_indices[j]] = 1.0; } } ulong n=0; double cut = 0.5; for(ulong i = 0; i<m_nout; i++) { if(m_output[i] > cut) ++n; } return n; }

Trotz der Fähigkeit der Vereinigungsregel, viele Einschränkungen der Überschneidungsmethode wirksam zu beseitigen, bleibt sie anfällig für Ausreißer, bei denen alle Komponentenmodelle schlechte Ergebnisse erzielen. Dieses Szenario stellt zwar eine Herausforderung dar, sollte aber bei gut konzipierten Anwendungen selten vorkommen und kann oft durch eine angemessene Systemgestaltung und Modellauswahl gemildert werden. Die Effektivität der Methode zeigt sich besonders in Umgebungen mit spezialisierten Modellen, in denen jede Komponente in bestimmten Bereichen hervorragende Leistungen erbringt, während sie in anderen möglicherweise schlecht abschneidet. Diese Eigenschaft macht sie besonders wertvoll für komplexe Klassifizierungsaufgaben, die verschiedene Fachkenntnisse erfordern.

Klassifikator-Kombinationen auf der Grundlage der logistischen Regression

Von allen bisher diskutierten Ensemble-Klassifikatoren dient die Methode der Borda-Wahl als universell wirksame Lösung für die Kombination von Klassifikatoren mit ähnlicher Leistung, da sie eine einheitliche Vorhersagekraft für alle Modelle voraussetzt. Wenn die Leistung zwischen den einzelnen Modellen erheblich schwankt, kann eine unterschiedliche Gewichtung auf der Grundlage der individuellen Modellleistung wünschenswert sein. Die logistische Regression bietet einen ausgefeilten Rahmen für diesen gewichteten Kombinationsansatz.

Die Implementierung der logistischen Regression für die Kombination von Klassifikatoren baut auf den Prinzipien der gewöhnlichen linearen Regression auf, geht aber auf die besonderen Herausforderungen der Klassifizierung ein. Anstatt kontinuierliche Werte direkt vorherzusagen, berechnet die logistische Regression die Wahrscheinlichkeit der Klassenzugehörigkeit und bietet damit einen verfeinerten Ansatz für Klassifizierungsaufgaben. Der Prozess beginnt mit der Umwandlung der ursprünglichen Trainingsdaten in ein regressionsfähiges Format. Betrachten Sie ein System mit drei Klassen und vier Modellen, das die folgenden Ergebnisse erzeugt.

| Modell 1 | Modell 2 | Modell 3 | Modell 4 | |

|---|---|---|---|---|

| 1 | 0.7 | 0.1 | 0.8 | 0.4 |

| 2 | 0.8 | 0.3 | 0.9 | 0.3 |

| 3 | 0.2 | 0.2 | 0.7 | 0.2 |

Diese Daten erzeugen drei neue Regressionstrainingsfälle für jeden ursprünglichen Fall, wobei die Zielvariable auf 1,0 für die richtige Klasse und 0,0 für falsche Klassen gesetzt wird. Die Prädiktoren verwenden proportionale Rangfolgen anstelle von Rohdaten, was die numerische Stabilität verbessert.

Die Klasse CLogitReg in ensemble.mqh verwaltet die Implementierung eines gewichteten Kombinationsansatzes für Klassifikator-Ensembles.

//+------------------------------------------------------------------+ //| Use logistic regression to find best class | //| This uses one common weight vector for all classes. | //+------------------------------------------------------------------+ class ClogitReg { private: ulong m_nout; long m_indices[]; matrix m_ranks; vector m_output; vector m_targs; matrix m_input; logistic::Clogit *m_logit; public: ClogitReg(void); ~ClogitReg(void); ulong classify(vector &inputs, IClassify* &models[]); bool fit(matrix &inputs, matrix &targets, IClassify* &models[]); vector proba(void) { return m_output;} };

Die Methode fit() konstruiert die Regressions-Trainingsmenge durch systematische Verarbeitung einzelner Fälle. Zunächst wird die wahre Klassenzugehörigkeit jeder Trainingsstichprobe bestimmt. Anschließend werden die Ergebnisse der Bewertung der einzelnen Komponentenmodelle in der Matrix m_ranks zusammengefasst. Diese Matrix wird verarbeitet, um die abhängigen und unabhängigen Variablen für das Regressionsproblem zu erzeugen, das anschließend mit dem Objekt m_logit gelöst wird.

//+------------------------------------------------------------------+ //| fit an ensemble model | //+------------------------------------------------------------------+ bool ClogitReg::fit(matrix &inputs,matrix &targets,IClassify *&models[]) { m_nout = targets.Cols(); m_input = matrix::Zeros(inputs.Rows(),models.Size()); m_targs = vector::Zeros(inputs.Rows()); m_output = vector::Zeros(m_nout); m_ranks = matrix::Zeros(models.Size(),m_nout); double best = 0.0; ulong nbelow; if(ArrayResize(m_indices,int(m_nout))<0) { Print(__FUNCTION__, " ", __LINE__, " array resize error ", GetLastError()); return false; } ulong k; if(CheckPointer(m_logit) == POINTER_DYNAMIC) delete m_logit; m_logit = new logistic::Clogit(); for(ulong i = 0; i<inputs.Rows(); i++) { vector trow = targets.Row(i); vector inrow = inputs.Row(i); k = trow.ArgMax(); best = trow[k]; for(uint j = 0; j<models.Size(); j++) { vector classification = models[j].classify(inrow); if(!m_ranks.Row(classification,j)) { Print(__FUNCTION__, " ", __LINE__, " failed row insertion ", GetLastError()); return false; } } for(ulong j = 0; j<m_nout; j++) { for(uint jj =0; jj<models.Size(); jj++) { nbelow = 0; best = m_ranks[jj][j]; for(ulong ii =0; ii<m_nout; ii++) { if(m_ranks[jj][ii]<best) ++nbelow; } m_input[i][jj] = double(nbelow)/double(m_nout); } m_targs[i] = (j == k)? 1.0:0.0; } } return m_logit.fit(m_input,m_targs); }

Diese Implementierung stellt einen ausgeklügelten Ansatz für die Kombination von Klassifikatoren dar und ist besonders wertvoll in Szenarien, in denen die Komponentenmodelle bei verschiedenen Klassifizierungsaufgaben unterschiedlich effektiv sind.

Das gewichtete Klassifizierungsverfahren baut auf der Borda-Wahl auf, indem modellspezifische Gewichte integriert werden. Der Algorithmus beginnt mit der Initialisierung von Akkumulationsvektoren und der Verarbeitung unbekannter Fälle durch jedes Komponentenmodell. Die vom Objekt m_logit berechneten optimalen Gewichte werden angewendet, um die Beiträge der einzelnen Klassifikatoren anzupassen. Die endgültige Klasse wird durch den Index bestimmt, der dem größten Wert in m_output entspricht.

//+------------------------------------------------------------------+ //| classify with ensemble model | //+------------------------------------------------------------------+ ulong ClogitReg::classify(vector &inputs,IClassify *&models[]) { double temp; for(uint i =0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); for(long j =0; j<long(classification.Size()); j++) m_indices[j] = j; if(!classification.Size()) { Print(__FUNCTION__," ", __LINE__," empty vector "); return ULONG_MAX; } qsortdsi(0,classification.Size()-1,classification,m_indices); temp = m_logit.coeffAt(i); for(ulong j = 0 ; j<m_nout; j++) { m_output[m_indices[j]] += j * temp; } } double sum = m_output.Sum(); ulong ibest = m_output.ArgMax(); double best = m_output[ibest]; if(sum>0.0) m_output/=sum; return ibest; }

Bei der Implementierung wird der Schwerpunkt auf universelle Gewichte gelegt, da diese stabiler sind und das Risiko einer Überanpassung geringer ist. Klassenspezifische Gewichte bleiben jedoch eine praktikable Option für Anwendungen mit umfangreichen Trainingsdaten. Eine Methode, bei der klassenspezifische Gewichte verwendet werden, wird in einem der folgenden Abschnitte erörtert. Im Moment lenken wir unsere Aufmerksamkeit darauf, wie die optimalen Gewichte abgeleitet werden, insbesondere das logistische Regressionsmodell.

Das Kernstück der logistischen Regression ist die unten dargestellte logistische oder Logit-Transformation.

Diese Funktion bildet einen unbegrenzten Bereich auf das Intervall [0, 1] ab. Wenn x in der obigen Gleichung extrem negativ ist, geht das Ergebnis gegen Null. Umgekehrt nähert sich der Wert der Funktion der Einheit, wenn x größer wird. Wenn x=0 ist, gibt die Funktion einen Wert zurück, der genau in der Mitte zwischen den beiden Extremen liegt. Wenn x die vorhergesagte Variable im Regressionsmodell darstellt, bedeutet dies, dass, wenn x gleich Null ist, eine 50%ige Chance besteht, dass eine Probe zu einer bestimmten Klasse gehört. Wenn der Wert von x von 0 ansteigt, erhöht sich der Prozentsatz der Wahrscheinlichkeit entsprechend. Andererseits nimmt der Prozentsatz ab, wenn der Wert von x von 0 abnimmt.

Eine andere Art, die Wahrscheinlichkeit zu beschreiben, sind Quoten. Dies wird offiziell als Chancenverhältnis bezeichnet, d. h. die Wahrscheinlichkeit, dass ein Ereignis eintritt, geteilt durch die Wahrscheinlichkeit, dass es nicht eintritt. Drückt man e^x in der Logit-Transformation in Bezug auf f(x) aus, so ergibt sich folgende Gleichung.

Entfernt man die Exponenten in dieser Gleichung, indem man die Logarithmen auf beide Seiten anwendet, und lässt x die vorhergesagte Variable des Regressionsproblems sein, erhält man die unten dargestellte Gleichung.

Dieser Ausdruck, der im Zusammenhang mit Klassifizierer-Ensembles verwendet wird, besagt, dass eine lineare Kombination von Prädiktoren aus Komponenten-Klassifizierern für jede Probe in der Trainingsmenge den Logarithmus der Wahrscheinlichkeit für die entsprechende Klassenbezeichnung liefert. Die optimalen Gewichte w können mit Hilfe einer Maximum-Likelihood-Schätzung oder durch Minimierung einer Zielfunktion ermittelt werden. Einzelheiten dazu würden den Rahmen dieses Artikels sprengen.

Eine umfassende Implementierung der logistischen Regression in MQL5 war zunächst schwer zu finden. Die MQL5-Portierung der Alglib-Bibliothek verfügt über spezielle Werkzeuge für die logistische Regression, aber dieser Autor hat sie nie erfolgreich kompilieren können. Auch in den Demoprogrammen, in denen die Alglib-Werkzeuge vorgestellt werden, gibt es keine Beispiele für ihre Verwendung. Leider war die Alglib-Bibliothek bei der Implementierung der in der Datei logistic.mqh definierten Klasse Clogit nützlich. Die Datei enthält die Definition der Klasse CFg, die die Schnittstelle CNDimensional_Grad implementiert.

//+------------------------------------------------------------------+ //| function and gradient calculation object | //+------------------------------------------------------------------+ class CFg:public CNDimensional_Grad { private: matrix m_preds; vector m_targs; ulong m_nclasses,m_samples,m_features; double loss_gradient(matrix &coef,double &gradients[]); void weight_intercept_raw(matrix &coef,matrix &x, matrix &wghts,vector &intcept,matrix &rpreds); void weight_intercept(matrix &coef,matrix &wghts,vector &intcept); double l2_penalty(matrix &wghts,double strenth); void sum_exp_minus_max(ulong index,matrix &rp,vector &pr); void closs_grad_halfbinmial(double y_true,double raw, double &inout_1,double &intout_2); public: //--- constructor, destructor CFg(matrix &predictors,vector &targets, ulong num_classes) { m_preds = predictors; vector classes = np::unique(targets); np::sort(classes); vector checkclasses = np::arange(classes.Size()); if(checkclasses.Compare(classes,1.e-1)) { double classv[]; np::vecAsArray(classes,classv); m_targs = targets; for(ulong i = 0; i<targets.Size(); i++) m_targs[i] = double(ArrayBsearch(classv,m_targs[i])); } else m_targs = targets; m_nclasses = num_classes; m_features = m_preds.Cols(); m_samples = m_preds.Rows(); } ~CFg(void) {} virtual void Grad(double &x[],double &func,double &grad[],CObject &obj); virtual void Grad(CRowDouble &x,double &func,CRowDouble &grad,CObject &obj); }; //+------------------------------------------------------------------+ //| this function is not used | //+------------------------------------------------------------------+ void CFg::Grad(double &x[],double &func,double &grad[],CObject &obj) { matrix coefficients; arrayToMatrix(x,coefficients,m_nclasses>2?m_nclasses:m_nclasses-1,m_features+1); func=loss_gradient(coefficients,grad); return; } //+------------------------------------------------------------------+ //| get function value and gradients | //+------------------------------------------------------------------+ void CFg::Grad(CRowDouble &x,double &func,CRowDouble &grad,CObject &obj) { double xarray[],garray[]; x.ToArray(xarray); Grad(xarray,func,garray,obj); grad = garray; return; } //+------------------------------------------------------------------+ //| loss gradient | //+------------------------------------------------------------------+ double CFg::loss_gradient(matrix &coef,double &gradients[]) { matrix weights; vector intercept; vector losses; matrix gradpointwise; matrix rawpredictions; matrix gradient; double loss; double l2reg; //calculate weights intercept and raw predictions weight_intercept_raw(coef,m_preds,weights,intercept,rawpredictions); gradpointwise = matrix::Zeros(m_samples,rawpredictions.Cols()); losses = vector::Zeros(m_samples); double sw_sum = double(m_samples); //loss gradient calculations if(m_nclasses>2) { double max_value, sum_exps; vector p(rawpredictions.Cols()+2); //--- for(ulong i = 0; i< m_samples; i++) { sum_exp_minus_max(i,rawpredictions,p); max_value = p[rawpredictions.Cols()]; sum_exps = p[rawpredictions.Cols()+1]; losses[i] = log(sum_exps) + max_value; //--- for(ulong k = 0; k<rawpredictions.Cols(); k++) { if(ulong(m_targs[i]) == k) losses[i] -= rawpredictions[i][k]; p[k]/=sum_exps; gradpointwise[i][k] = p[k] - double(int(ulong(m_targs[i])==k)); } } } else { for(ulong i = 0; i<m_samples; i++) { closs_grad_halfbinmial(m_targs[i],rawpredictions[i][0],losses[i],gradpointwise[i][0]); } } //--- loss = losses.Sum()/sw_sum; l2reg = 1.0 / (1.0 * sw_sum); loss += l2_penalty(weights,l2reg); gradpointwise/=sw_sum; //--- if(m_nclasses>2) { gradient = gradpointwise.Transpose().MatMul(m_preds) + l2reg*weights; gradient.Resize(gradient.Rows(),gradient.Cols()+1); vector gpsum = gradpointwise.Sum(0); gradient.Col(gpsum,m_features); } else { gradient = m_preds.Transpose().MatMul(gradpointwise) + l2reg*weights.Transpose(); gradient.Resize(gradient.Rows()+1,gradient.Cols()); vector gpsum = gradpointwise.Sum(0); gradient.Row(gpsum,m_features); } //--- matrixToArray(gradient,gradients); //--- return loss; } //+------------------------------------------------------------------+ //| weight intercept raw preds | //+------------------------------------------------------------------+ void CFg::weight_intercept_raw(matrix &coef,matrix &x,matrix &wghts,vector &intcept,matrix &rpreds) { weight_intercept(coef,wghts,intcept); matrix intceptmat = np::vectorAsRowMatrix(intcept,x.Rows()); rpreds = (x.MatMul(wghts.Transpose()))+intceptmat; } //+------------------------------------------------------------------+ //| weight intercept | //+------------------------------------------------------------------+ void CFg::weight_intercept(matrix &coef,matrix &wghts,vector &intcept) { intcept = coef.Col(m_features); wghts = np::sliceMatrixCols(coef,0,m_features); } //+------------------------------------------------------------------+ //| sum exp minus max | //+------------------------------------------------------------------+ void CFg::sum_exp_minus_max(ulong index,matrix &rp,vector &pr) { double mv = rp[index][0]; double s_exps = 0.0; for(ulong k = 1; k<rp.Cols(); k++) { if(mv<rp[index][k]) mv=rp[index][k]; } for(ulong k = 0; k<rp.Cols(); k++) { pr[k] = exp(rp[index][k] - mv); s_exps += pr[k]; } pr[rp.Cols()] = mv; pr[rp.Cols()+1] = s_exps; } //+------------------------------------------------------------------+ //| l2 penalty | //+------------------------------------------------------------------+ double CFg::l2_penalty(matrix &wghts,double strenth) { double norm2_v; if(wghts.Rows()==1) { matrix nmat = (wghts).MatMul(wghts.Transpose()); norm2_v = nmat[0][0]; } else norm2_v = wghts.Norm(MATRIX_NORM_FROBENIUS); return 0.5*strenth*norm2_v; } //+------------------------------------------------------------------+ //| closs_grad_half_binomial | //+------------------------------------------------------------------+ void CFg::closs_grad_halfbinmial(double y_true,double raw, double &inout_1,double &inout_2) { if(raw <= -37.0) { inout_2 = exp(raw); inout_1 = inout_2 - y_true * raw; inout_2 -= y_true; } else if(raw <= -2.0) { inout_2 = exp(raw); inout_1 = log1p(inout_2) - y_true * raw; inout_2 = ((1.0 - y_true) * inout_2 - y_true) / (1.0 + inout_2); } else if(raw <= 18.0) { inout_2 = exp(-raw); // log1p(exp(x)) = log(1 + exp(x)) = x + log1p(exp(-x)) inout_1 = log1p(inout_2) + (1.0 - y_true) * raw; inout_2 = ((1.0 - y_true) - y_true * inout_2) / (1.0 + inout_2); } else { inout_2 = exp(-raw); inout_1 = inout_2 + (1.0 - y_true) * raw; inout_2 = ((1.0 - y_true) - y_true * inout_2) / (1.0 + inout_2); } }

Dies ist für das Verfahren zur Minimierung der LBFGS-Funktion erforderlich. Clogit verfügt über die bekannten Methoden für Training und Inferenz.

//+------------------------------------------------------------------+ //| logistic regression implementation | //+------------------------------------------------------------------+ class Clogit { public: Clogit(void); ~Clogit(void); bool fit(matrix &predictors, vector &targets); double predict(vector &preds); vector proba(vector &preds); matrix probas(matrix &preds); double coeffAt(ulong index); private: ulong m_nsamples; ulong m_nfeatures; bool m_trained; matrix m_train_preds; vector m_train_targs; matrix m_coefs; vector m_bias; vector m_classes; double m_xin[]; CFg *m_gradfunc; CObject m_dummy; vector predictProba(double &in); }; //+------------------------------------------------------------------+ //| constructor | //+------------------------------------------------------------------+ Clogit::Clogit(void) { } //+------------------------------------------------------------------+ //| destructor | //+------------------------------------------------------------------+ Clogit::~Clogit(void) { if(CheckPointer(m_gradfunc) == POINTER_DYNAMIC) delete m_gradfunc; } //+------------------------------------------------------------------+ //| fit a model to a dataset | //+------------------------------------------------------------------+ bool Clogit::fit(matrix &predictors, vector &targets) { m_trained = false; m_classes = np::unique(targets); np::sort(m_classes); if(predictors.Rows()!=targets.Size() || m_classes.Size()<2) { Print(__FUNCTION__," ",__LINE__," invalid inputs "); return m_trained; } m_train_preds = predictors; m_train_targs = targets; m_nfeatures = m_train_preds.Cols(); m_nsamples = m_train_preds.Rows(); m_coefs = matrix::Zeros(m_classes.Size()>2?m_classes.Size():m_classes.Size()-1,m_nfeatures+1); matrixToArray(m_coefs,m_xin); m_gradfunc = new CFg(m_train_preds,m_train_targs,m_classes.Size()); //--- CMinLBFGSStateShell state; CMinLBFGSReportShell rep; CNDimensional_Rep frep; //--- CAlglib::MinLBFGSCreate(m_xin.Size(),m_xin.Size()>=5?5:m_xin.Size(),m_xin,state); //--- CAlglib::MinLBFGSOptimize(state,m_gradfunc,frep,true,m_dummy); //--- CAlglib::MinLBFGSResults(state,m_xin,rep); //--- if(rep.GetTerminationType()>0) { m_trained = true; arrayToMatrix(m_xin,m_coefs,m_classes.Size()>2?m_classes.Size():m_classes.Size()-1,m_nfeatures+1); m_bias = m_coefs.Col(m_nfeatures); m_coefs = np::sliceMatrixCols(m_coefs,0,m_nfeatures); } else Print(__FUNCTION__," ", __LINE__, " failed to train the model ", rep.GetTerminationType()); delete m_gradfunc; return m_trained; } //+------------------------------------------------------------------+ //| get probability for single sample | //+------------------------------------------------------------------+ vector Clogit::proba(vector &preds) { vector predicted; if(!m_trained) { Print(__FUNCTION__," ", __LINE__," no trained model available "); predicted.Fill(EMPTY_VALUE); return predicted; } predicted = ((preds.MatMul(m_coefs.Transpose()))); predicted += m_bias; if(predicted.Size()>1) { if(!predicted.Activation(predicted,AF_SOFTMAX)) { Print(__FUNCTION__," ", __LINE__," errror ", GetLastError()); predicted.Fill(EMPTY_VALUE); return predicted; } } else { predicted = predictProba(predicted[0]); } return predicted; } //+------------------------------------------------------------------+ //| get probability for binary classification | //+------------------------------------------------------------------+ vector Clogit::predictProba(double &in) { vector out(2); double n = 1.0/(1.0+exp(-1.0*in)); out[0] = 1.0 - n; out[1] = n; return out; } //+------------------------------------------------------------------+ //| get probabilities for multiple samples | //+------------------------------------------------------------------+ matrix Clogit::probas(matrix &preds) { matrix output(preds.Rows(),m_classes.Size()); vector rowin,rowout; for(ulong i = 0; i<preds.Rows(); i++) { rowin = preds.Row(i); rowout = proba(rowin); if(rowout.Max() == EMPTY_VALUE || !output.Row(rowout,i)) { Print(__LINE__," probas error ", GetLastError()); output.Fill(EMPTY_VALUE); break; } } return output; } //+------------------------------------------------------------------+ //| get probability for single sample | //+------------------------------------------------------------------+ double Clogit::predict(vector &preds) { vector prob = proba(preds); if(prob.Max() == EMPTY_VALUE) { Print(__LINE__," predict error "); return EMPTY_VALUE; } return m_classes[prob.ArgMax()]; } //+------------------------------------------------------------------+ //| get model coefficient at specific index | //+------------------------------------------------------------------+ double Clogit::coeffAt(ulong index) { if(index<(m_coefs.Rows())) { return (m_coefs.Row(index)).Sum(); } else { return 0.0; } } } //+------------------------------------------------------------------+

Ensemble-Kombinationen auf der Grundlage logistischer Regression mit klassenspezifischen Gewichten

Der im vorigen Abschnitt beschriebene Ansatz mit einem einzigen Gewichtssatz bietet Stabilität und Effektivität, ist aber insofern begrenzt, als er die Spezialisierung des Modells nicht in vollem Umfang ausnutzen kann. Wenn einzelne Modelle für bestimmte Klassen eine überlegene Leistung zeigen, sei es durch Design oder natürliche Entwicklung, kann die Implementierung separater Gewichtungssätze für jede Klasse diese speziellen Fähigkeiten effektiver nutzen. Der Übergang zu klassenspezifischen Gewichtssätzen führt zu einer erheblichen Komplexität des Optimierungsprozesses. Anstatt einen einzigen Satz von Gewichten zu optimieren, muss das Ensemble K Sätze (einen pro Klasse) verwalten, die jeweils M Parameter enthalten, was insgesamt K*M Parameter ergibt. Diese Erweiterung der Parameter erfordert eine sorgfältige Abwägung der Datenanforderungen und der Implementierungsrisiken.

Eine robuste Anwendung separater Gewichtungssätze erfordert umfangreiche Trainingsdaten, um die statistische Gültigkeit zu erhalten. Als allgemeine Richtlinie gilt, dass jede Klasse mindestens zehnmal so viele Trainingsfälle haben sollte wie es Modelle gibt. Selbst bei ausreichender Datenlage sollte dieser Ansatz nur mit Vorsicht und nur dann angewandt werden, wenn eindeutige Hinweise auf eine signifikante Modellspezialisierung über die Klassen hinweg vorliegen.

Die Klasse CLogitRegSep verwaltet die Implementierung separater Gewichtungssätze und unterscheidet sich von CLogitReg durch die Zuweisung einzelner Clogit-Objekte für jede Klasse. Der Trainingsprozess verteilt die Regressionsfälle auf klassenspezifische Trainingssätze, anstatt sie in einem einzigen Satz zu konsolidieren.

//+------------------------------------------------------------------+ //| Use logistic regression to find best class. | //| This uses separate weight vectors for each class. | //+------------------------------------------------------------------+ class ClogitRegSep { private: ulong m_nout; long m_indices[]; matrix m_ranks; vector m_output; vector m_targs[]; matrix m_input[]; logistic::Clogit *m_logit[]; public: ClogitRegSep(void); ~ClogitRegSep(void); ulong classify(vector &inputs, IClassify* &models[]); bool fit(matrix &inputs, matrix &targets, IClassify* &models[]); vector proba(void) { return m_output;} };

Die Klassifizierung unbekannter Fälle erfolgt nach einem ähnlichen Verfahren wie beim einfach gewichteten Ansatz, mit einem entscheidenden Unterschied: Bei der Berechnung der Borda-Zahl werden klassenspezifische Gewichte angewendet. Diese Spezialisierung ermöglicht es dem System, klassenspezifische Modellkenntnisse effektiver zu nutzen.

//+------------------------------------------------------------------+ //| classify with ensemble model | //+------------------------------------------------------------------+ ulong ClogitRegSep::classify(vector &inputs,IClassify *&models[]) { double temp; for(uint i =0; i<models.Size(); i++) { vector classification = models[i].classify(inputs); for(long j =0; j<long(classification.Size()); j++) m_indices[j] = j; if(!classification.Size()) { Print(__FUNCTION__," ", __LINE__," empty vector "); return ULONG_MAX; } qsortdsi(0,classification.Size()-1,classification,m_indices); for(ulong j = 0 ; j<m_nout; j++) { temp = m_logit[j].coeffAt(i); m_output[m_indices[j]] += j * temp; } } double sum = m_output.Sum(); ulong ibest = m_output.ArgMax(); double best = m_output[ibest]; if(sum>0.0) m_output/=sum; return ibest; }

Die Einführung getrennter Gewichtungssätze erfordert strenge Validierungsverfahren. Praktiker sollten die Gewichtsverteilungen auf unerklärliche Extremwerte überwachen und sicherstellen, dass die Gewichtsunterschiede mit den bekannten Modellmerkmalen übereinstimmen. Es müssen Sicherheitsvorkehrungen getroffen werden, um Instabilitäten bei Regressionsprozessen zu verhindern. All dies kann durch umfassende Prüfprotokolle wirksam umgesetzt werden.

Die erfolgreiche Implementierung klassenspezifischer Gewichtungssätze hängt von der sorgfältigen Beachtung mehrerer kritischer Faktoren ab: Sicherstellung ausreichender Trainingsdaten für jede Klasse, Überprüfung, ob Spezialisierungsmuster separate Gewichtungen rechtfertigen, Überwachung der Gewichtungsstabilität und Bestätigung der verbesserten Klassifizierungsgenauigkeit im Vergleich zu Ansätzen mit nur einem Gewicht. Diese fortschrittliche Implementierung der logistischen Regression bietet zwar verbesserte Klassifizierungsmöglichkeiten, erfordert jedoch ein sorgfältiges Management, um die erhöhte Komplexität und die potenziellen Risiken zu bewältigen.

Ensembles, die lokale Genauigkeit nutzen

Um die Stärken der einzelnen Modelle weiter zu nutzen, können wir ihre lokale Genauigkeit innerhalb des Vorhersageraums berücksichtigen. Manchmal zeigen Komponentenklassifikatoren in bestimmten Regionen des Prädiktorenraums eine bessere Leistung. Diese Spezialisierung zeigt sich, wenn Modelle unter bestimmten Bedingungen der Prädiktorvariablen besonders gut abschneiden - ein Modell kann beispielsweise bei niedrigen Variablenwerten optimal abschneiden, während ein anderes bei höheren Werten besonders gut abschneidet. Solche Spezialisierungsmuster, ob absichtlich entworfen oder natürlich entstanden, können die Klassifizierungsgenauigkeit erheblich verbessern, wenn sie richtig eingesetzt werden.

Die Umsetzung erfolgt nach einem einfachen, aber effektiven Konzept. Bei der Bewertung eines unbekannten Falles sammelt das System Klassifizierungen von allen Komponentenmodellen und wählt das Modell aus, das für diesen speziellen Fall als am zuverlässigsten erachtet wird. Das Ensemble bewertet die Zuverlässigkeit eines Modells, indem es eine Methode anwendet, die in dem von Woods, Kegelmeyer und Bowyer verfassten „Combination of multiple classifiers using local accuracy estimates“ (Kombination mehrerer Klassifikatoren unter Verwendung lokaler Genauigkeitsschätzungen) vorgeschlagen wurde. Dieser Ansatz erfolgt in mehreren festgelegten Schritten:

- Berechnen der euklidischen Abstände zwischen dem unbekannten Fall und allen Trainingsfällen.

- Identifizieren einer vordefinierten Anzahl der nächstgelegenen Trainingsfälle für eine vergleichende Analyse.

- Bewerten der Leistung jedes Modells speziell für diese nahe gelegenen Fälle und der Konzentration auf die Fälle, in denen das Modell die gleiche Klassifizierung wie für den unbekannten Fall vornimmt.

- Berechnung eines Leistungskriteriums, das auf dem Anteil der korrekten Klassifizierungen unter den Fällen basiert, in denen das Modell die gleiche Klasse für den unbekannten Fall und seine Nachbarn vorausgesagt hat.

Betrachten wir ein Szenario, in dem zehn nächste Nachbarn analysiert werden. Nach der Identifizierung dieser Nachbarn durch Berechnung des euklidischen Abstands legt das Ensemble einen unbekannten Fall einem Modell vor, das ihn der Klasse 3 zuordnet. Das System bewertet dann die Leistung dieses Modells anhand der zehn nächstgelegenen Trainingsfälle. Wenn das Modell sechs dieser Fälle als Klasse 3 klassifiziert, wobei vier dieser Klassifizierungen richtig sind, erreicht das Modell ein Leistungskriterium von 0,67 (4/6). Dieser Bewertungsprozess wird für alle Komponentenmodelle fortgesetzt, wobei das Modell mit der höchsten Punktzahl letztendlich die endgültige Klassifizierung bestimmt. Dieser Ansatz stellt sicher, dass die Klassifizierungsentscheidungen das zuverlässigste Modell für jeden spezifischen Fallkontext nutzen.

Um Unstimmigkeiten zu vermeiden, wählen wir das Modell mit der höchsten Sicherheit aus, die sich aus dem Verhältnis zwischen seinem maximalen Output und der Summe aller Outputs ergibt. Es ist notwendig, die Größe dieser lokalen Teilmenge zu bestimmen, da kleinere Teilmengen empfindlicher auf lokale Abweichungen reagieren, während größere Teilmengen robuster sind, aber den „lokalen“ Charakter der Bewertung verringern können. Eine Kreuzvalidierung kann dabei helfen, die optimale Größe der Teilmenge zu bestimmen, wobei aus Gründen der Effizienz im Falle von Gleichständen in der Regel kleinere Teilmengen bevorzugt werden. Durch die Anwendung dieses Ansatzes nutzt das Ensemble effektiv domänenspezifisches Modell-Know-how, ohne dabei die Effizienz der Berechnung zu beeinträchtigen. Die Methode ermöglicht es dem Ensemble, sich dynamisch an unterschiedliche Regionen des Prädiktorenraums anzupassen, und das Zuverlässigkeitsmaß kann genutzt werden, um eine transparente Metrik für die Modellauswahl bereitzustellen.

Die Klasse ClocalAcc in ensemble.mqh dient der Bestimmung der wahrscheinlichsten Klasse aus einem Ensemble von Klassifikatoren auf der Grundlage der lokalen Genauigkeit.

//+------------------------------------------------------------------+ //| Use local accuracy to choose the best model | //+------------------------------------------------------------------+ class ClocalAcc { private: ulong m_knn; ulong m_nout; long m_indices[]; matrix m_ranks; vector m_output; vector m_targs; matrix m_input; vector m_dist; matrix m_trnx; matrix m_trncls; vector m_trntrue; ulong m_classprep; bool m_crossvalidate; public: ClocalAcc(void); ~ClocalAcc(void); ulong classify(vector &inputs, IClassify* &models[]); bool fit(matrix &inputs, matrix &targets, IClassify* &models[], bool crossvalidate = false); vector proba(void) { return m_output;} };

Die Methode fit() trainiert das ClocalAcc-Objekt. Es nimmt die Eingabedaten (inputs), Zielwerte (targets), ein Array von Klassifikatormodellen (models) und ein optionales Flag für die Kreuzvalidierung (crossvalidate). Während des Trainings berechnet fit() den Abstand zwischen jedem eingegebenen Datenpunkt und allen anderen Datenpunkten. Anschließend werden die k nächsten Nachbarn für jeden Punkt bestimmt, wobei k durch Kreuzvalidierung ermittelt wird, wenn „crossvalidate“ auf true gesetzt ist. Für jeden Nachbarn bewertet die Methode die Leistung jedes Klassifizierers im Ensemble.

//+------------------------------------------------------------------+ //| fit an ensemble model | //+------------------------------------------------------------------+ bool ClocalAcc::fit(matrix &inputs,matrix &targets,IClassify *&models[], bool crossvalidate = false) { m_crossvalidate = crossvalidate; m_nout = targets.Cols(); m_input = matrix::Zeros(inputs.Rows(),models.Size()); m_targs = vector::Zeros(inputs.Rows()); m_output = vector::Zeros(m_nout); m_ranks = matrix::Zeros(models.Size(),m_nout); m_dist = vector::Zeros(inputs.Rows()); m_trnx = matrix::Zeros(inputs.Rows(),inputs.Cols()); m_trncls = matrix::Zeros(inputs.Rows(),models.Size()); m_trntrue = vector::Zeros(inputs.Rows()); double best = 0.0; if(ArrayResize(m_indices,int(inputs.Rows()))<0) { Print(__FUNCTION__, " ", __LINE__, " array resize error ", GetLastError()); return false; } ulong k, knn_min,knn_max,knn_best=0,true_class, ibest=0; for(ulong i = 0; i<inputs.Rows(); i++) { np::matrixCopyRows(m_trnx,inputs,i,i+1,1); vector trow = targets.Row(i); vector inrow = inputs.Row(i); k = trow.ArgMax(); best = trow[k]; m_trntrue[i] = double(k); for(uint j=0; j<models.Size(); j++) { vector classification = models[j].classify(inrow); ibest = classification.ArgMax(); best = classification[ibest]; m_trncls[i][j] = double(ibest); } } m_classprep = 1; if(!m_crossvalidate) { m_knn=3; return true; } else { ulong ncases = inputs.Rows(); if(inputs.Rows()<20) { m_knn=3; return true; } knn_min = 3; knn_max = 10; vector testcase(inputs.Cols()) ; vector clswork(m_nout) ; vector knn_counts(knn_max - knn_min + 1) ; for(ulong i = knn_min; i<=knn_max; i++) knn_counts[i-knn_min] = 0; --ncases; for(ulong i = 0; i<=ncases; i++) { testcase = m_trnx.Row(i); true_class = ulong(m_trntrue[i]); if(i<ncases) { if(!m_trnx.SwapRows(ncases,i)) { Print(__FUNCTION__, " ", __LINE__, " failed row swap ", GetLastError()); return false; } m_trntrue[i] = m_trntrue[ncases]; double temp; for(uint j = 0; j<models.Size(); j++) { temp = m_trncls[i][j]; m_trncls[i][j] = m_trncls[ncases][j]; m_trncls[ncases][j] = temp; } } m_classprep = 1; for(ulong knn = knn_min; knn<knn_max; knn++) { ulong iclass = classify(testcase,models); if(iclass == true_class) { ++knn_counts[knn-knn_min]; } m_classprep=0; } if(i<ncases) { if(!m_trnx.SwapRows(i,ncases) || !m_trnx.Row(testcase,i)) { Print(__FUNCTION__, " ", __LINE__, " error ", GetLastError()); return false; } m_trntrue[ncases] = m_trntrue[i]; m_trntrue[i] = double(true_class); double temp; for(uint j = 0; j<models.Size(); j++) { temp = m_trncls[i][j]; m_trncls[i][j] = m_trncls[ncases][j]; m_trncls[ncases][j] = temp; } } } ++ncases; for(ulong knn = knn_min; knn<=knn_max; knn++) { if((knn==knn_min) || (ulong(knn_counts[knn-knn_min])>ibest)) { ibest = ulong(knn_counts[knn-knn_min]); knn_best = knn; } } m_knn = knn_best; m_classprep = 1; } return true; }

Die Methode classify() sagt die Klassenbezeichnung für einen gegebenen Eingabevektor voraus. Es berechnet die Abstände zwischen dem Eingabevektor und allen Trainingsdatenpunkten und identifiziert die k nächsten Nachbarn. Für jeden Klassifikator im Ensemble wird die Genauigkeit des Klassifikators bei diesen Nachbarn ermittelt. Der Klassifikator mit der höchsten Genauigkeit bei den nächsten Nachbarn wird ausgewählt, und seine vorhergesagte Klassenbezeichnung wird zurückgegeben.

//+------------------------------------------------------------------+ //| classify with an ensemble model | //+------------------------------------------------------------------+ ulong ClocalAcc::classify(vector &inputs,IClassify *&models[]) { double dist=0, diff=0, best=0, crit=0, bestcrit=0, conf=0, bestconf=0, sum ; ulong k, ibest, numer, denom, bestmodel=0, bestchoice=0 ; if(m_classprep) { for(ulong i = 0; i<m_input.Rows(); i++) { m_indices[i] = long(i); dist = 0.0; for(ulong j = 0; j<m_trnx.Cols(); j++) { diff = inputs[j] - m_trnx[i][j]; dist+= diff*diff; } m_dist[i] = dist; } if(!m_dist.Size()) { Print(__FUNCTION__," ", __LINE__," empty vector "); return ULONG_MAX; } qsortdsi(0, m_dist.Size()-1, m_dist,m_indices); } for(uint i = 0; i<models.Size(); i++) { vector vec = models[i].classify(inputs); sum = vec.Sum(); ibest = vec.ArgMax(); best = vec[ibest]; conf = best/sum; denom = numer = 0; for(ulong ii = 0; ii<m_knn; ii++) { k = m_indices[ii]; if(ulong(m_trncls[k][i]) == ibest) { ++denom; if(ibest == ulong(m_trntrue[k])) ++numer; } } if(denom > 0) crit = double(numer)/double(denom); else crit = 0.0; if((i == 0) || (crit > bestcrit)) { bestcrit = crit; bestmodel = ulong(i); bestchoice = ibest; bestconf = conf; m_output = vec; } else if(fabs(crit-bestcrit)<1.e-10) { if(conf > bestconf) { bestcrit= crit; bestmodel = ulong(i); bestchoice = ibest; bestconf = conf; m_output = vec; } } } sum = m_output.Sum(); if(sum>0) m_output/=sum; return bestchoice; }

Ensembles kombiniert mit dem Fuzzy-Integral

Die unscharfe Logik ist ein mathematischer Rahmen, der sich mit Wahrheitsgraden und nicht mit absolut wahren oder falschen Werten befasst. Im Zusammenhang mit der Kombination von Klassifikatoren kann Fuzzy-Logik verwendet werden, um die Ergebnisse mehrerer Modelle zu integrieren, wobei die Zuverlässigkeit der einzelnen Modelle berücksichtigt wird. Beim Fuzzy-Integral, das ursprünglich von Sugeno (1977) vorgeschlagen wurde, handelt es sich um ein Unschärfemaß, das Teilmengen eines Universums Werte zuweist. Dieses Maß erfüllt bestimmte Eigenschaften, darunter Randbedingungen, Monotonie und Kontinuität. Sugeno erweiterte dieses Konzept um das Fuzzy-Maß λ, das einen zusätzlichen Faktor für die Kombination der Maße disjunkter Mengen enthält.

Das Fuzzy-Integral selbst wird mit einer speziellen Formel berechnet, die die Zugehörigkeitsfunktion und das Fuzzy-Maß beinhaltet. Während eine Brute-Force-Berechnung möglich ist, gibt es für endliche Mengen eine effizientere Methode, die eine rekursive Berechnung beinhaltet. Der Wert von λ wird bestimmt, indem sichergestellt wird, dass das endgültige Maß gleich eins ist. Im Zusammenhang mit der Kombination von Klassifikatoren kann das Fuzzy-Integral angewandt werden, indem jeder Klassifikator als ein Element des Universums behandelt wird, wobei seine Zuverlässigkeit als Mitgliedswert gilt. Das Fuzzy-Integral wird dann für jede Klasse berechnet, und die Klasse mit dem höchsten Integral wird ausgewählt. Bei dieser Methode werden die Ergebnisse mehrerer Klassifikatoren unter Berücksichtigung ihrer individuellen Zuverlässigkeit effektiv kombiniert.

Die Klasse CFuzzyInt implementiert die Fuzzy-Integral-Methode zur Kombination von Klassifikatoren.

//+------------------------------------------------------------------+ //| Use fuzzy integral to combine decisions | //+------------------------------------------------------------------+ class CFuzzyInt { private: ulong m_nout; vector m_output; long m_indices[]; matrix m_sort; vector m_g; double m_lambda; double recurse(double x); public: CFuzzyInt(void); ~CFuzzyInt(void); bool fit(matrix &predictors, matrix &targets, IClassify* &models[]); ulong classify(vector &inputs, IClassify* &models[]); vector proba(void) { return m_output;} };