Neuronale Netze im Handel: Der Contrastive Muster-Transformer (letzter Teil)

Im letzten Artikel dieser Reihe haben wir uns mit dem Atom-Motif Contrastive Transformer (AMCT) beschäftigt, der kontrastives Lernen zur Entdeckung von Schlüsselmustern auf allen Ebenen einsetzt, von grundlegenden Elementen bis hin zu komplexen Strukturen. In diesem Artikel setzen wir die Implementierung von AMCT-Ansätzen mit MQL5 fort.

Optimierungsmethoden der ALGLIB-Bibliothek (Teil I)

In diesem Artikel werden wir uns mit den Optimierungsmethoden der ALGLIB-Bibliothek für MQL5 vertraut machen. Der Artikel enthält einfache und anschauliche Beispiele für die Verwendung von ALGLIB zur Lösung von Optimierungsproblemen, die das Erlernen der Methoden so einfach wie möglich machen. Wir werden uns die Verbindung von Algorithmen wie BLEIC, L-BFGS und NS im Detail ansehen und sie zur Lösung eines einfachen Testproblems verwenden.

Neuronale Netze im Handel: Der Contrastive Muster-Transformer

Der Contrastive Transformer wurde entwickelt, um Märkte sowohl auf der Ebene einzelner Kerzen als auch auf der Basis ganzer Muster zu analysieren. Dies trägt dazu bei, die Qualität der Modellierung von Markttrends zu verbessern. Darüber hinaus fördert der Einsatz des kontrastiven Lernens zum Abgleich der Darstellungen von Kerzen und Mustern die Selbstregulierung und verbessert die Genauigkeit der Prognosen.

Neuronale Netze im Handel: Transformer mit relativer Kodierung

Selbstüberwachtes Lernen kann ein effektives Mittel sein, um große Mengen ungekennzeichneter Daten zu analysieren. Die Effizienz wird durch die Anpassung der Modelle an die spezifischen Merkmale der Finanzmärkte gewährleistet, was zur Verbesserung der Wirksamkeit der traditionellen Methoden beiträgt. In diesem Artikel wird ein alternativer Aufmerksamkeitsmechanismus vorgestellt, der die relativen Abhängigkeiten und Beziehungen zwischen den Eingaben berücksichtigt.

Neuronale Netze im Handel: Marktanalyse mit Hilfe eines Muster-Transformers

Wenn wir Modelle zur Analyse der Marktsituation verwenden, konzentrieren wir uns hauptsächlich auf Kerzen. Es ist doch seit langem bekannt, dass Kerzen-Muster bei der Vorhersage künftiger Kursbewegungen helfen können. In diesem Artikel werden wir uns mit einer Methode vertraut machen, die es uns ermöglicht, diese beiden Ansätze zu integrieren.

Neuronale Netze im Handel: Kontrollierte Segmentierung

In diesem Artikel wird eine Methode zur Analyse komplexer multimodaler Interaktionen und zum Verstehen von Merkmalen erörtert.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 60): Inferenzlernen (Wasserstein-VAE) mit gleitendem Durchschnitt und stochastischen Oszillatormustern

Wir schließen unsere Betrachtung der komplementären Paarung von MA und stochastischem Oszillator ab, indem wir untersuchen, welche Rolle das Inferenzlernen in einer Situation nach überwachtem Lernen und Verstärkungslernen spielen kann. Es gibt natürlich eine Vielzahl von Möglichkeiten, wie man in diesem Fall das Inferenzlernen angehen kann, unser Ansatz ist jedoch die Verwendung von Variationsautokodierern. Wir untersuchen dies in Python, bevor wir unser trainiertes Modell mit ONNX exportieren, um es in einem von einem Assistenten zusammengestellten Expert Advisor in MetaTrader zu verwenden.

Datenwissenschaft und ML (Teil 37): Mit Kerzenmustern und AI den Markt schlagen

Kerzenmuster helfen Händlern, die Marktpsychologie zu verstehen und Trends auf den Finanzmärkten zu erkennen. Sie ermöglichen fundiertere Handelsentscheidungen, die zu besseren Ergebnissen führen können. In diesem Artikel werden wir untersuchen, wie man Kerzenmuster mit KI-Modellen nutzen kann, um eine optimale Handelsperformance zu erzielen.

Datenwissenschaft und ML (Teil 36): Der Umgang mit verzerrten Finanzmärkten

Die Finanzmärkte sind nicht vollkommen ausgeglichen. Einige Märkte steigen, andere fallen, und wieder andere zeigen ein gewisses Schwankungsverhalten, das auf Unsicherheit in beide Richtungen hindeutet. Diese unausgewogenen Informationen können beim Trainieren von Machine-Learning-Modellen irreführend sein, da sich die Märkte häufig ändern. In diesem Artikel werden wir verschiedene Möglichkeiten erörtern, dieses Problem zu lösen.

Integration des AI-Modells in eine bereits bestehende MQL5-Handelsstrategie

Dieses Thema konzentriert sich auf die Einbindung eines trainierten KI-Modells (z. B. eines Verstärkungslernmodells wie LSTM oder eines auf maschinellem Lernen basierenden Prognosemodells) in eine bestehende MQL5-Handelsstrategie.

Klassische Strategien neu interpretieren (Teil 14): Hochwahrscheinliche Setups

Hochwahrscheinliche Setups sind in unserer Trading-Community gut bekannt, aber leider sind sie nicht gut definiert. In diesem Artikel wollen wir einen empirischen und algorithmischen Weg finden, um genau zu definieren, was ein Hochwahrscheinlichkeits-Setup ist, und um diese zu identifizieren und auszunutzen. Durch die Verwendung von Gradient Boosting Trees haben wir gezeigt, wie der Leser die Leistung einer beliebigen Handelsstrategie verbessern und unserem Computer die genaue Aufgabe auf sinnvollere und explizitere Weise mitteilen kann.

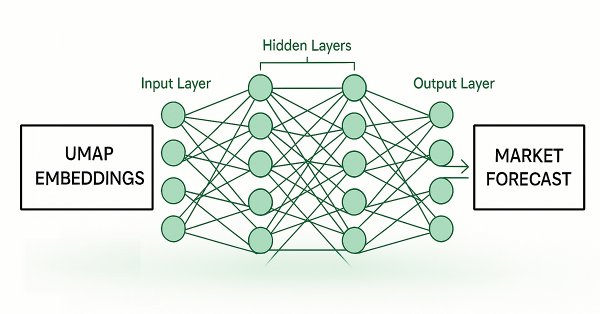

Feature Engineering mit Python und MQL5 (Teil IV): Erkennung von Kerzenmustern mit der UMAP-Regression

Techniken zur Dimensionenreduktion werden häufig eingesetzt, um die Leistung von Modellen des maschinellen Lernens zu verbessern. Wir wollen nun eine relativ neue Technik erörtern, die als Uniform Manifold Approximation and Projection (UMAP) bekannt ist. Diese neue Technik wurde entwickelt, um die Einschränkungen herkömmlicher Methoden zu überwinden, die Artefakte und Verzerrungen in den Daten verursachen. UMAP ist eine leistungsstarke Technik zur Dimensionenreduzierung und hilft uns, ähnliche Kerzen auf eine neuartige und effektive Weise zu gruppieren, die unsere Fehlerquoten bei Daten, die nicht in der Stichprobe enthalten sind, reduziert und unsere Handelsleistung verbessert.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 59): Verstärkungslernen (DDPG) mit gleitendem Durchschnitt und stochastischen Oszillatormustern

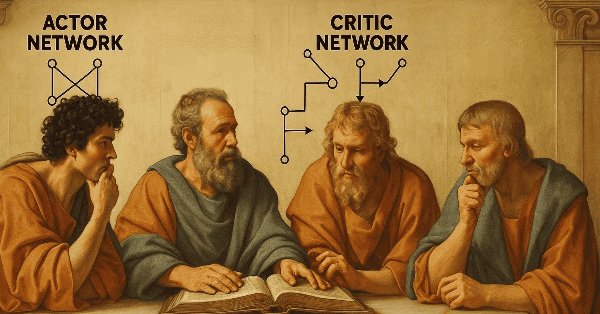

Wir setzen unseren letzten Artikel über DDPG mit MA und stochastischen Indikatoren fort, indem wir andere Schlüsselklassen des Reinforcement Learning untersuchen, die für die Implementierung von DDPG entscheidend sind. Obwohl wir hauptsächlich in Python kodieren, wird das Endprodukt, ein trainiertes Netzwerk, als ONNX nach MQL5 exportiert, wo wir es als Ressource in einen von einem Assistenten zusammengestellten Expert Advisor integrieren.

MQL5-Assistent-Techniken, die Sie kennen sollten (Teil 58): Reinforcement Learning (DDPG) mit gleitendem Durchschnitt und stochastischen Oszillatormustern

Der gleitende Durchschnitt und der Stochastik-Oszillator sind sehr gebräuchliche Indikatoren, deren kollektive Muster wir im vorangegangenen Artikel mittels eines überwachten Lernnetzwerks untersucht haben, um zu sehen, welche „Muster haften bleiben“ würden. Wir gehen mit unseren Analysen aus diesem Artikel noch einen Schritt weiter, indem wir die Auswirkungen des Reinforcement Learnings auf die Leistung untersuchen, wenn es mit diesem trainierten Netz eingesetzt wird. Die Leser sollten beachten, dass sich unsere Tests auf ein sehr begrenztes Zeitfenster beziehen. Nichtsdestotrotz nutzen wir weiterhin die minimalen Programmieranforderungen, die der MQL5-Assistent bietet, um dies zu zeigen.

Erforschung fortgeschrittener maschineller Lerntechniken bei der Darvas Box Breakout Strategie

Die von Nicolas Darvas entwickelte Darvas-Box-Breakout-Strategie ist ein technischer Handelsansatz, der potenzielle Kaufsignale erkennt, wenn der Kurs einer Aktie über einen festgelegten Bereich der „Box“ ansteigt, was auf eine starke Aufwärtsdynamik hindeutet. In diesem Artikel werden wir dieses Strategiekonzept als Beispiel anwenden, um drei fortgeschrittene Techniken des maschinellen Lernens zu untersuchen. Dazu gehören die Verwendung eines maschinellen Lernmodells zur Generierung von Signalen anstelle von Handelsfiltern, die Verwendung von kontinuierlichen Signalen anstelle von diskreten Signalen und die Verwendung von Modellen, die auf verschiedenen Zeitrahmen trainiert wurden, um Handelsgeschäfte zu bestätigen.

MQL5-Assistent-Techniken, die Sie kennen sollten (Teil 57): Überwachtes Lernen mit gleitendem Durchschnitt und dem stochastischen Oszillator

Der gleitende Durchschnitt und der Stochastik-Oszillator sind sehr gängige Indikatoren, die von manchen Händlern aufgrund ihres verzögerten Charakters nicht oft verwendet werden. In einer dreiteiligen Miniserie, die sich mit den drei wichtigsten Formen des maschinellen Lernens befasst, gehen wir der Frage nach, ob die Voreingenommenheit gegenüber diesen Indikatoren gerechtfertigt ist, oder ob sie vielleicht einen Vorteil haben. Wir führen unsere Untersuchung mit Hilfe eines Assistenten durch, der Expert Advisors zusammenstellt.

Datenwissenschaft und ML (Teil 35): NumPy in MQL5 - Die Kunst, komplexe Algorithmen mit weniger Code zu erstellen

Die NumPy-Bibliothek treibt fast alle Algorithmen des maschinellen Lernens in der Programmiersprache Python an. In diesem Artikel werden wir ein ähnliches Modul implementieren, das eine Sammlung des gesamten komplexen Codes enthält, um uns bei der Erstellung anspruchsvoller Modelle und Algorithmen jeglicher Art zu unterstützen.

Resampling-Techniken für die Bewertung von Vorhersagen und Klassifizierungen in MQL5

In diesem Artikel werden wir Methoden zur Bewertung der Modellqualität erforschen und implementieren, die einen einzigen Datensatz sowohl als Trainings- als auch als Validierungssatz verwenden.

Eine Einführung in die Kurven von Receiver Operating Characteristic

ROC-Kurven sind grafische Darstellungen, die zur Bewertung der Leistung von Klassifikatoren verwendet werden. Obwohl ROC-Diagramme relativ einfach zu handhaben sind, gibt es bei ihrer Verwendung in der Praxis häufig Missverständnisse und Fallstricke. Dieser Artikel bietet eine Einführung in ROC-Diagramme als Hilfsmittel für Praktiker, die die Leistungsbewertung von Klassifikatoren verstehen wollen.

Datenwissenschaft und ML (Teil 34): Zeitreihenzerlegung, den Aktienmarkt auf den Kern herunterbrechen.

In einer Welt, die von verrauschten und unvorhersehbaren Daten überschwemmt wird, kann es schwierig sein, aussagekräftige Muster zu erkennen. In diesem Artikel befassen wir uns mit der saisonalen Dekomposition, einer leistungsstarken Analysetechnik, die dabei hilft, Daten in ihre Hauptkomponenten zu zerlegen: Trend, saisonale Muster und Rauschen. Wenn wir die Daten auf diese Weise aufschlüsseln, können wir verborgene Erkenntnisse aufdecken und mit klareren, besser interpretierbaren Informationen arbeiten.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 55): SAC mit priorisierter Erfahrungswiederholung

Replay-Puffer sind beim Reinforcement Learning besonders wichtig bei Off-Policy-Algorithmen wie DQN oder SAC. Damit wird das Sampling-Verfahren dieses Speicherpuffers in den Mittelpunkt gerückt. Während bei den Standardoptionen von SAC beispielsweise eine zufällige Auswahl aus diesem Puffer verwendet wird, wird bei den priorisierten Erfahrungswiederholungspuffern eine Feinabstimmung vorgenommen, indem eine Auswahl aus dem Puffer auf der Grundlage eines TD-Scores erfolgt. Wir gehen auf die Bedeutung des Reinforcement Learning ein und untersuchen wie immer nur diese Hypothese (nicht die Kreuzvalidierung) in einem von einem Assistenten zusammengestellten Expert Advisor.

Erstellen von selbstoptimierenden Expert Advisor in MQL5 (Teil 6): Stop-Out-Prävention

Schließen Sie sich unserer heutigen Diskussion an, wenn wir nach einem algorithmischen Verfahren suchen, mit dem wir die Gesamtzahl der Ausstiege aus Gewinngeschäften minimieren können. Das Problem, mit dem wir konfrontiert waren, ist sehr schwierig, und die meisten Lösungen, die in den Diskussionen in der Gemeinschaft genannt wurden, haben keine festen Regeln. Unser algorithmischer Ansatz zur Lösung des Problems erhöhte die Rentabilität unserer Handelsgeschäft und reduzierte den durchschnittlichen Verlust pro Handelsgeschäft. Es müssen jedoch noch weitere Fortschritte gemacht werden, um alle Handelsgeschäfte, die ausgestoppt werden, vollständig herauszufiltern, aber unsere Lösung ist ein guter erster Schritt, den jeder ausprobieren kann.

Datenwissenschaft und ML (Teil 33): Pandas Dataframe in MQL5, Vereinfachung der Datensammlung für ML-Nutzung

Bei der Arbeit mit maschinellen Lernmodellen ist es wichtig, die Konsistenz der für Training, Validierung und Tests verwendeten Daten sicherzustellen. In diesem Artikel werden wir unsere eigene Version der Pandas-Bibliothek in MQL5 erstellen, um einen einheitlichen Ansatz für den Umgang mit maschinellen Lerndaten zu gewährleisten und sicherzustellen, dass innerhalb und außerhalb von MQL5, wo der Großteil des Trainings stattfindet, dieselben Daten verwendet werden.

MQL5-Assistenten-Techniken, die Sie kennen sollten (Teil 54): Verstärkungslernen mit hybriden SAC und Tensoren

Soft Actor Critic ist ein Reinforcement Learning-Algorithmus, den wir bereits in einem früheren Artikel vorgestellt haben, in dem wir auch Python und ONNX als effiziente Ansätze für das Training von Netzwerken vorgestellt haben. Wir überarbeiten den Algorithmus mit dem Ziel, Tensoren, Berechnungsgraphen, die häufig in Python verwendet werden, zu nutzen.

Trendvorhersage mit LSTM für Trendfolgestrategien

Long Short-Term Memory (LSTM) ist eine Art rekurrentes neuronales Netz (RNN), das für die Modellierung sequenzieller Daten entwickelt wurde, indem es langfristige Abhängigkeiten effektiv erfasst und das Problem des verschwindenden Gradienten löst. In diesem Artikel werden wir untersuchen, wie LSTM zur Vorhersage zukünftiger Trends eingesetzt werden kann, um die Leistung von Trendfolgestrategien zu verbessern. Der Artikel behandelt die Einführung von Schlüsselkonzepten und die Motivation hinter der Entwicklung, das Abrufen von Daten aus dem MetaTrader 5, die Verwendung dieser Daten zum Trainieren des Modells in Python, die Integration des maschinellen Lernmodells in MQL5 und die Reflexion der Ergebnisse und zukünftigen Bestrebungen auf der Grundlage von statistischem Backtesting.

Generative Adversarial Networks (GANs) für synthetische Daten in der Finanzmodellierung (Teil 2): Erstellen eines synthetischen Symbols für Tests

In diesem Artikel erstellen wir ein synthetisches Symbol mit Hilfe eines Generative Adversarial Network (GAN), das realistische Finanzdaten generiert, die das Verhalten tatsächlicher Marktinstrumente, wie z. B. EURUSD, nachahmen. Das GAN-Modell lernt Muster und Volatilität aus historischen Marktdaten und erstellt synthetische Preisdaten mit ähnlichen Merkmalen.

Gating-Mechanismen beim Ensemblelernen

In diesem Artikel setzen wir unsere Untersuchung von Ensemblemodellen fort, indem wir das Konzept der Gates erörtern, insbesondere wie sie bei der Kombination von Modellergebnissen nützlich sein können, um entweder die Vorhersagegenauigkeit oder die Modellgeneralisierung zu verbessern.

Integrieren Sie Ihr eigenes LLM in einen EA (Teil 5): Handelsstrategie mit LLMs(IV) entwickeln und testen - Test der Handelsstrategie

Angesichts der rasanten Entwicklung der künstlichen Intelligenz sind Sprachmodelle (language models, LLMs) heute ein wichtiger Bestandteil der künstlichen Intelligenz, sodass wir darüber nachdenken sollten, wie wir leistungsstarke LLMs in unseren algorithmischen Handel integrieren können. Für die meisten Menschen ist es schwierig, diese leistungsstarken Modelle auf ihre Bedürfnisse abzustimmen, sie lokal einzusetzen und sie dann auf den algorithmischen Handel anzuwenden. In dieser Artikelserie werden wir Schritt für Schritt vorgehen, um dieses Ziel zu erreichen.

Hidden Markov Modelle für trendfolgende Volatilitätsprognosen

Hidden Markov Modelle (HMM) sind leistungsstarke statistische Instrumente, die durch die Analyse beobachtbarer Kursbewegungen die zugrunde liegenden Marktzustände identifizieren. Im Handel verbessern HMM die Volatilitätsprognose und liefern Informationen für Trendfolgestrategien, indem sie Marktverschiebungen modellieren und antizipieren. In diesem Artikel stellen wir das vollständige Verfahren zur Entwicklung einer Trendfolgestrategie vor, die HMM zur Prognose der Volatilität als Filter einsetzt.

Algorithmus für eine auf künstlichen Ökosystemen basierende Optimierung (AEO)

Der Artikel befasst sich mit einem metaheuristischen AEO-Algorithmus (Artificial Ecosystem-based Optimization), der Interaktionen zwischen Ökosystemkomponenten simuliert, indem er eine anfängliche Lösungspopulation erstellt und adaptive Aktualisierungsstrategien anwendet, und beschreibt im Detail die Phasen des AEO-Betriebs, einschließlich der Verbrauchs- und Zersetzungsphasen, sowie verschiedene Agentenverhaltensstrategien. Der Artikel stellt die Merkmale und Vorteile dieses Algorithmus vor.

Neuronale Netze im Handel: Kontrollierte Segmentierung (letzter Teil)

Wir setzen die im vorigen Artikel begonnene Arbeit am Aufbau des RefMask3D-Frameworks mit MQL5 fort. Dieser Rahmen wurde entwickelt, um multimodale Interaktion und Merkmalsanalyse in einer Punktwolke umfassend zu untersuchen, gefolgt von der Identifizierung des Zielobjekts auf der Grundlage einer in natürlicher Sprache gegebenen Beschreibung.

Neuronale Netze im Handel: Verallgemeinerte 3D-Segmentierung von referenzierten Ausdrücken

Bei der Analyse der Marktsituation unterteilen wir den Markt in einzelne Segmente und ermitteln die wichtigsten Trends. Herkömmliche Analysemethoden konzentrieren sich jedoch oft auf einen Aspekt und schränken so die richtige Wahrnehmung ein. In diesem Artikel lernen wir eine Methode kennen, die die Auswahl mehrerer Objekte ermöglicht, um ein umfassenderes und vielschichtigeres Verständnis der Situation zu gewährleisten.

Vorhersage von Wechselkursen mit klassischen Methoden des maschinellen Lernens: Logit- und Probit-Modelle

In diesem Artikel wird der Versuch unternommen, einen Handels-EA zur Vorhersage von Wechselkursen zu erstellen. Der Algorithmus basiert auf klassischen Klassifikationsmodellen - logistische und Probit-Regression. Das Kriterium des Wahrscheinlichkeitsquotienten wird als Filter für Handelssignale verwendet.

Neuronale Netze im Handel: Maskenfreier Ansatz zur Vorhersage von Preisentwicklungen

In diesem Artikel wird die Methode MAFT (Mask-Attention-Free Transformer) und ihre Anwendung im Bereich des Handels diskutiert. Im Gegensatz zu herkömmlichen Transformer, die bei der Verarbeitung von Sequenzen eine Datenmaskierung erfordern, optimiert MAFT den Aufmerksamkeitsprozess, indem es die Maskierung überflüssig macht und so die Rechenleistung erheblich verbessert.

Wirtschaftsprognosen: Erkunden des Potenzials von Python

Wie kann man die Wirtschaftsdaten der Weltbank für Prognosen nutzen? Was passiert, wenn man KI-Modelle und Wirtschaft kombiniert?

Neuronale Netze im Handel: Superpoint Transformer (SPFormer)

In diesem Artikel stellen wir eine Methode zur Segmentierung von 3D-Objekten vor, die auf dem Superpoint Transformer (SPFormer) basiert und bei der die Notwendigkeit einer zwischengeschalteten Datenaggregation entfällt. Dadurch wird der Segmentierungsprozess beschleunigt und die Leistung des Modells verbessert.

African Buffalo Optimierung (ABO)

Der Artikel stellt den Algorithmus der Afrikanische Büffel-Optimierung (ABO) vor, einen metaheuristischen Ansatz, der 2015 auf der Grundlage des einzigartigen Verhaltens dieser Tiere entwickelt wurde. Der Artikel beschreibt im Detail die Phasen der Implementierung des Algorithmus und seine Effizienz bei der Lösung komplexer Probleme, was ihn zu einem wertvollen Werkzeug im Bereich der Optimierung macht.

Neuronale Netze im Handel: Erforschen lokaler Datenstrukturen

Die effektive Identifizierung und Erhaltung der lokalen Struktur von Marktdaten unter verrauschten Bedingungen ist eine wichtige Aufgabe im Handel. Die Verwendung des Mechanismus der Selbstaufmerksamkeit hat vielversprechende Ergebnisse bei der Verarbeitung solcher Daten gezeigt; der klassische Ansatz berücksichtigt jedoch nicht die lokalen Merkmale der zugrunde liegenden Struktur. In diesem Artikel stelle ich einen Algorithmus vor, der diese strukturellen Abhängigkeiten berücksichtigen kann.

Artificial Showering Algorithm (ASHA)

Der Artikel stellt den Künstlichen Duschalgorithmus (ASHA) vor, eine neue metaheuristische Methode, die für die Lösung allgemeiner Optimierungsprobleme entwickelt wurde. Auf der Grundlage der Simulation von Wasserfluss- und Akkumulationsprozessen konstruiert dieser Algorithmus das Konzept eines idealen Feldes, in dem jede Einheit der Ressource (Wasser) aufgerufen ist, eine optimale Lösung zu finden. Wir werden herausfinden, wie ASHA Fließ- und Akkumulationsprinzipien anpasst, um Ressourcen in einem Suchraum effizient zuzuweisen, und seine Implementierung und Testergebnisse sehen.

Hochfrequenz-Arbitrage-Handelssystem in Python mit MetaTrader 5

In diesem Artikel werden wir ein Arbitrationssystem erstellen, das in den Augen der Broker legal bleibt, Tausende von synthetischen Preisen auf dem Forex-Markt erstellt, sie analysiert und erfolgreich mit Gewinn handelt.