Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

Я не обсуждаю тему ветки. Я к этому отношусь ровно, совсем никак. Я только против дополнительной темы. Темы которую вы лично читать уже завтра вообще не будете. А если и здесь будете убеждать противников ИИ и МО в частности, то почему-бы не обсуждать всё это в основной теме? И если вы не можете этими идеями убедить тех кто отрицает саму тему, то грош цена вашим новым идеям.

На этом я вас покидаю, пока не назвали меня сумасшедшим. Пусть будет у вас две банки. Одна для одних пауков, другая для других…

я бы заметил, что срач возникает как раз в тех случаях, когда в специальной профильной ветке появляются персонажи, которые против темы ветки

Тут не в том дело, что кто-то был против ветки или против МО вообще.

Тут дело в разной квалификации пользователей, которые хотят что-то обсуждать.

------------------

Пример.

В ключевую ветку как-то зашел пользователь, и спросил про summary (краткий обзор): "а можно подвести краткий итог" и так далее. Пользователь уже делал посты в той ветке, нареканий не было.

Так этого пользователя почти растерзали ... за что? За недостаточную квалификацию в МО (говорили, что это флуд, а тот просто спросил).

Кто решает о том - какая квалификация и кто может постить в ключевой ветке по МО?

Максим решает.

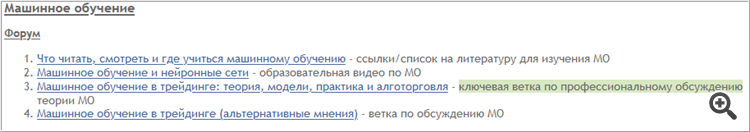

Поэтому в этой ветке (по альтернативным теориям и мнениям) я сделал summary, но общее (пост #1), и обозначил ключевую ветку как

ветка по дискуссиям профессионалов:

Теперь, если кто-то зайдет в ключевую ветку, а у него будет недостаточная квалификация для обсуждения среди профессионалов -

можно просто пост переместить сюда. Таким образом - новички не буду уходить с форума совсем, а останутся, и у них даже будет возможность чего-то спросить по теме МО.

-----------------------

Кстати, summary (ветки и посты как обзоры по теме) очень популярны на англоязычном форуме

(они бывают как ветками, так и просто постами).

Например -

В англоязычном форуме:

Здесь на форуме:

--------------------

Например, в одной моей ветке 237 листов, а новички не буду читать столько листов, даже если там индикаторы исходниками и советники с тестами и настройками. Я сделал summary ветки #613

А 3 тысячи листов точно читать не будут (многие новенькие и один лист то ....).

--------------------

Поэтому рекомендую делать summary постами или ветками (лучше постами).

Так как эти summary популярны, и любому новичку (который что-то спросил, как бы прервав дискуссию) - можно просто дать ссылку на summary.

То есть, на вопрос "а что вы тут обсуждаете на 3 тыс листов?" (были такие вопросы, и воспринимались как флуд) - может быть ответ:

"обсуждем это - см пост #1".

Теперь, если кто-то зайдет в ключевую ветку, а у него будет недостаточная квалификация для обсуждения среди профессионалов -

можно просто пост переместить сюда. Таким образом - новички не буду уходить с форума совсем, а останутся, и у них даже будет возможность чего-то спросить по теме МО.

Извините, что сразу не смог покинуть эту тему…

Сергей, а какой смысл переносить вопросы в другую тему, если профессионалы в МО сюда заходить не будут? Эти вопросы так и останутся без ответа и разъяснений.

Извините, что сразу не смог покинуть эту тему…

Сергей, а какой смысл переносить вопросы в другую тему, если профессионалы в МО сюда заходить не будут? Эти вопросы так и останутся без ответа и разъяснений.

Машинное обучение

Форум

Статьи

CodeBase

Documentation

вот список про машинное обучение:

https://cran.r-project.org/web/views/MachineLearning.html

Копипаст:

Several add-on packages implement ideas and methods developed at the borderline between computer science and statistics - this field of research is usually referred to as machine learning. The packages can be roughly structured into the following topics:

Neural Networks and Deep Learning : Single-hidden-layer neural network are implemented in package nnet (shipped with base R). Package RSNNS offers an interface to the Stuttgart Neural Network Simulator (SNNS). Packages implementing deep learning flavours of neural networks include deepnet (feed-forward neural network, restricted Boltzmann machine, deep belief network, stacked autoencoders), RcppDL (denoising autoencoder, stacked denoising autoencoder, restricted Boltzmann machine, deep belief network) and h2o (feed-forward neural network, deep autoencoders). An interface to tensorflow is available in tensorflow. The torch package implements an interface to the libtorch library. Prediction uncertainty can be quantified by the ENNreg evidential regression neural network model implemented in evreg.

Recursive Partitioning : Tree-structured models for regression, classification and survival analysis, following the ideas in the CART book, are implemented in rpart (shipped with base R) and tree. Package rpart is recommended for computing CART-like trees. A rich toolbox of partitioning algorithms is available in Weka, package RWeka provides an interface to this implementation, including the J4.8-variant of C4.5 and M5. The Cubist package fits rule-based models (similar to trees) with linear regression models in the terminal leaves, instance-based corrections and boosting. The C50 package can fit C5.0 classification trees, rule-based models, and boosted versions of these. pre can fit rule-based models for a wider range of response variable types.

Two recursive partitioning algorithms with unbiased variable selection and statistical stopping criterion are implemented in package party and partykit. Function ctree() is based on non-parametric conditional inference procedures for testing independence between response and each input variable whereas mob() can be used to partition parametric models. Extensible tools for visualizing binary trees and node distributions of the response are available in package party and partykit as well. Partitioning of mixed-effects models (GLMMs) can be performed with package glmertree; partitioning of structural equation models (SEMs) can be performed with package semtree. Graphical tools for the visualization of trees are available in package maptree.

Partitioning of mixture models is performed by RPMM.

Computational infrastructure for representing trees and unified methods for prediction and visualization is implemented in partykit. This infrastructure is used by package evtree to implement evolutionary learning of globally optimal trees. Survival trees are available in various packages.

Trees for subgroup identification with respect to heterogenuous treatment effects are available in packages partykit, model4you, dipm, quint, pkg("SIDES") , pkg("psica") , and pkg("MrSGUIDE") (and probably many more).

Random Forests : The reference implementation of the random forest algorithm for regression and classification is available in package randomForest. Package ipred has bagging for regression, classification and survival analysis as well as bundling, a combination of multiple models via ensemble learning. In addition, a random forest variant for response variables measured at arbitrary scales based on conditional inference trees is implemented in package party. randomForestSRC implements a unified treatment of Breiman’s random forests for survival, regression and classification problems. Quantile regression forests quantregForest allow to regress quantiles of a numeric response on exploratory variables via a random forest approach. For binary data, The varSelRF and Boruta packages focus on variable selection by means for random forest algorithms. In addition, packages ranger and Rborist offer R interfaces to fast C++ implementations of random forests. Reinforcement Learning Trees, featuring splits in variables which will be important down the tree, are implemented in package RLT. wsrf implements an alternative variable weighting method for variable subspace selection in place of the traditional random variable sampling. Package RGF is an interface to a Python implementation of a procedure called regularized greedy forests. Random forests for parametric models, including forests for the estimation of predictive distributions, are available in packages trtf (predictive transformation forests, possibly under censoring and trunction) and grf (an implementation of generalised random forests).

Regularized and Shrinkage Methods : Regression models with some constraint on the parameter estimates can be fitted with the lars package. Lasso with simultaneous updates for groups of parameters (groupwise lasso) is available in package grplasso; the grpreg package implements a number of other group penalization models, such as group MCP and group SCAD. The L1 regularization path for generalized linear models and Cox models can be obtained from functions available in package glmpath, the entire lasso or elastic-net regularization path (also in elasticnet) for linear regression, logistic and multinomial regression models can be obtained from package glmnet. The penalized package provides an alternative implementation of lasso (L1) and ridge (L2) penalized regression models (both GLM and Cox models). Package RXshrink can be used to identify and display TRACEs for a specified shrinkage path and to determine the appropriate extent of shrinkage. Semiparametric additive hazards models under lasso penalties are offered by package ahaz. Fisher’s LDA projection with an optional LASSO penalty to produce sparse solutions is implemented in package penalizedLDA. The shrunken centroids classifier and utilities for gene expression analyses are implemented in package pamr. An implementation of multivariate adaptive regression splines is available in package earth. Various forms of penalized discriminant analysis are implemented in packages hda and sda. Package LiblineaR offers an interface to the LIBLINEAR library. The ncvreg package fits linear and logistic regression models under the the SCAD and MCP regression penalties using a coordinate descent algorithm. The same penalties are also implemented in the picasso package. The Lasso under non-Gaussian and heteroscedastic errors is estimated by hdm, inference on low-dimensional components of Lasso regression and of estimated treatment effects in a high-dimensional setting are also contained. Package SIS implements sure independence screening in generalised linear and Cox models. Elastic nets for correlated outcomes are available from package joinet. Robust penalized generalized linear models and robust support vector machines are fitted by package mpath using composite optimization by conjugation operator. The islasso package provides an implementation of lasso based on the induced smoothing idea which allows to obtain reliable p-values for all model parameters. Best-subset selection for linear, logistic, Cox and other regression models, based on a fast polynomial time algorithm, is available from package abess.

Boosting and Gradient Descent : Various forms of gradient boosting are implemented in package gbm (tree-based functional gradient descent boosting). Package lightgbm and xgboost implement tree-based boosting using efficient trees as base learners for several and also user-defined objective functions. The Hinge-loss is optimized by the boosting implementation in package bst. An extensible boosting framework for generalized linear, additive and nonparametric models is available in package mboost. Likelihood-based boosting for mixed models is implemented in GMMBoost. GAMLSS models can be fitted using boosting by gamboostLSS. adabag implements the classical AdaBoost algorithm with added functionality, such as variable importances.

Support Vector Machines and Kernel Methods : The function svm() from e1071 offers an interface to the LIBSVM library and package kernlab implements a flexible framework for kernel learning (including SVMs, RVMs and other kernel learning algorithms). An interface to the SVMlight implementation (only for one-against-all classification) is provided in package klaR.

Bayesian Methods : Bayesian Additive Regression Trees (BART), where the final model is defined in terms of the sum over many weak learners (not unlike ensemble methods), are implemented in packages BayesTree, BART, and bartMachine. Bayesian nonstationary, semiparametric nonlinear regression and design by treed Gaussian processes including Bayesian CART and treed linear models are made available by package tgp. Bayesian structure learning in undirected graphical models for multivariate continuous, discrete, and mixed data is implemented in package BDgraph; corresponding methods relying on spike-and-slab priors are available from package ssgraph. Naive Bayes classifiers are available in naivebayes.

Optimization using Genetic Algorithms : Package rgenoud offers optimization routines based on genetic algorithms. The package Rmalschains implements memetic algorithms with local search chains, which are a special type of evolutionary algorithms, combining a steady state genetic algorithm with local search for real-valued parameter optimization.

Association Rules : Package arules provides both data structures for efficient handling of sparse binary data as well as interfaces to implementations of Apriori and Eclat for mining frequent itemsets, maximal frequent itemsets, closed frequent itemsets and association rules. Package opusminer provides an interface to the OPUS Miner algorithm (implemented in C++) for finding the key associations in transaction data efficiently, in the form of self-sufficient itemsets, using either leverage or lift.

Fuzzy Rule-based Systems : Package frbs implements a host of standard methods for learning fuzzy rule-based systems from data for regression and classification. Package RoughSets provides comprehensive implementations of the rough set theory (RST) and the fuzzy rough set theory (FRST) in a single package.

Model selection and validation : Package e1071 has function tune() for hyper parameter tuning and function errorest() (ipred) can be used for error rate estimation. The cost parameter C for support vector machines can be chosen utilizing the functionality of package svmpath. Data splitting for crossvalidation and other resampling schemes is available in the splitTools package. Package nestedcv provides nested cross-validation for glmnet and caret models. Functions for ROC analysis and other visualisation techniques for comparing candidate classifiers are available from package ROCR. Packages hdi and stabs implement stability selection for a range of models, hdi also offers other inference procedures in high-dimensional models.

Causal Machine Learning : The package DoubleML is an object-oriented implementation of the double machine learning framework in a variety of causal models. Building upon the mlr3 ecosystem, estimation of causal effects can be based on an extensive collection of machine learning methods.

Other procedures : Evidential classifiers quantify the uncertainty about the class of a test pattern using a Dempster-Shafer mass function in package evclass. The OneR (One Rule) package offers a classification algorithm with enhancements for sophisticated handling of missing values and numeric data together with extensive diagnostic functions.

Meta packages : Package tidymodels provides miscellaneous functions for building predictive models, including parameter tuning and variable importance measures. In a similar spirit, package mlr3 offers high-level interfaces to various statistical and machine learning packages. Package SuperLearner implements a similar toolbox. The h2o package implements a general purpose machine learning platform that has scalable implementations of many popular algorithms such as random forest, GBM, GLM (with elastic net regularization), and deep learning (feedforward multilayer networks), among others. An interface to the mlpack C++ library is available from package mlpack. CORElearn implements a rather broad class of machine learning algorithms, such as nearest neighbors, trees, random forests, and several feature selection methods. Similar, package rminer interfaces several learning algorithms implemented in other packages and computes several performance measures.

Visualisation (initially contributed by Brandon Greenwell) The stats::termplot() function package can be used to plot the terms in a model whose predict method supports type="terms" . The effects package provides graphical and tabular effect displays for models with a linear predictor (e.g., linear and generalized linear models). Friedman’s partial dependence plots (PDPs), that are low dimensional graphical renderings of the prediction function, are implemented in a few packages. gbm, randomForest and randomForestSRC provide their own functions for displaying PDPs, but are limited to the models fit with those packages (the function partialPlot from randomForest is more limited since it only allows for one predictor at a time). Packages pdp, plotmo, and ICEbox are more general and allow for the creation of PDPs for a wide variety of machine learning models (e.g., random forests, support vector machines, etc.); both pdp and plotmo support multivariate displays (plotmo is limited to two predictors while pdp uses trellis graphics to display PDPs involving three predictors). By default, plotmo fixes the background variables at their medians (or first level for factors) which is faster than constructing PDPs but incorporates less information. ICEbox focuses on constructing individual conditional expectation (ICE) curves, a refinement over Friedman’s PDPs. ICE curves, as well as centered ICE curves can also be constructed with the partial() function from the pdp package.

XAI : Most packages and functions from the last section “Visualization” belong to the field of explainable artificial intelligence (XAI). The meta packages DALEX and iml offer different methods to interpret any model, including partial dependence, accumulated local effects, and permutation importance. Accumulated local effects plots are also directly available in ALEPlot. SHAP (from SHapley Additive exPlanations) is one of the most frequently used techniques to interpret ML models. It decomposes - in a fair way - predictions into additive contributions of the predictors. For tree-based models, the very fast TreeSHAP algorithm exists. It is shipped directly with h2o, xgboost, and lightgbm. Model-agnostic implementations of SHAP are available in additional packages: fastshap mainly uses Monte-Carlo sampling to approximate SHAP values, while shapr and kernelshap provide implementations of KernelSHAP. SHAP values of any of these packages can be plotted by the package shapviz. A port to Python’s “shap” package is provided in shapper. Alternative decompositions of predictions are implemented in lime and iBreakDown.

CRAN packages

Машинное обучение

Форум

Статьи

CodeBase

Documentation

"Машинное обучение" - это СИСТЕМА методов и соответствующих инструментов, которые применяются на следующих этапах:

В R можно назвать две оболочки, демонстрирующие системный подход, включающие перечисленные этапы) к машинному обучению,

Извините, что сразу не смог покинуть эту тему…

Сергей, а какой смысл переносить вопросы в другую тему, если профессионалы в МО сюда заходить не будут? Эти вопросы так и останутся без ответа и разъяснений.

Но там то они не могут задавать вопросы.

Все равно кто-то знающий сюда зайдет. И как я вижу - уже тут такие есть.

-------------------

Тем более, что новички то уже не те, которые были несколько лет назад.

Например, сейчас новенькие (недавно зарегистрировавшись на форуме) сразу постят, что у них высокое IQ, и поэтому надо слушать их, а не знающих пользователей (и это не единичный пример, и от страны не зависит).

Вот недавно (англоязычный форум) - один пишет, что чтобы остановить советник на MQL5 VPS - надо зайти удаленным рабочим столом на этот MQL5 VPS и просто отключить автотрейдинг у того Метатрейдера в клауде. А то, что там нет рабочего стола у MQL5 VPS -

он не знает и знать не желает (потому что у него высокое IQ). И его не забанить (он новичек), и если пост перенести - он может его не найти ...

просто как выход - создавать из его поста отдельную ветку ... c его цитатой про IQ

:)

-------------------

Если короче - то новички уже не "тихие, скромные, пугливые", на всё согласные.

Уже массами пошел другой народ. И тут так просто их не научить даже простым вещам.

-------------------

А они/новенькие нужны. Ведь кто подписывается на сигналы и покупает продукты в Маркете?

Профессионалы сами друг у друга? Много новичков покупают. А если проблемы у них с этим

(а много у них с этим проблем, так как они не читают ничего) - они идут на форум в любую ветку и делают пост.

Завсегдатаи какой-то ветки воспринимают это как флуд, а модераторы ждут кто нажмет на линк "Нарушение", и/или просто перемещают их пост в другую ветку.

Но иногда не успевают переместить, так как профессиональные пользователи отвечают новичкам прямо в той ветке, и "обрабатывают" их (новичков) как ВИП персон ... а те (новички) - потом подписываются на сигналы и покупают в Маркете.

-------------------

Потому что есть правило, что чтобы снизить риски - лучше подписываться на сигнал или покупать в Маркете у тех, кого знаешь лично или кто очень активен на форуме и помогает новичкам. Англоязычные пользователи это знают.

Например, кто-то на англоязычном форуме сделал пост, спросил что-то обычное, я подготовил ответ (со ссылками), и когда запостил, то увидел, что впереди/выше меня на странице - уже три поста. То есть - три человека помогли (или старались помочь) и сделали это быстрее.

Просто потому, что новенький что-то спросил. Свой пост тогда удаляю (так как там уже три поста выше меня).

-------------------

Кстати, эта ветка (которую тут назвали "альтернативная") - это вообще обычный прием (этот прием известен еще с прошлого века).

Так делают чтобы разделить оппонентов (чтобы они спорили, но в живую друг с другом в одной ветке не сталкивались), или просто разделяют потоки пользователей, сохраняя основную ветку.

То есть, то, что есть эта ветка по МО (наряду с основной по МО) - это не экстраординарный, а обычный случай.

-------------------

Тут вопрос в том - кто будет вести эту ветку ... и кто будет отвечать на вопросы новичков (пусть непонятные и неправильные вопросы).

Потому что часто стандартного ответа "см пост #1 " недостаточно.

-------------------

Еще пример.

Пока я делал/писал этот пост - на англоязычной форуме появилось 13 новых постов, и это только в разделе Общее Обсуждение

... а тут (в русскоязычном форуме) - один (мой - второй).

Тут не в том дело, что кто-то был против ветки или против МО вообще.

Тут дело в разной квалификации пользователей, которые хотят что-то обсуждать.

------------------

Пример.

В ключевую ветку как-то зашел пользователь, и спросил про summary (краткий обзор): "а можно подвести краткий итог" и так далее. Пользователь уже делал посты в той ветке, нареканий не было.

Так этого пользователя почти растерзали ... за что? За недостаточную квалификацию в МО (говорили, что это флуд, а тот просто спросил).

Кто решает о том - какая квалификация и кто может постить в ключевой ветке по МО?

Максим решает.

Поэтому в этой ветке (по альтернативным теориям и мнениям) я сделал summary, но общее (пост #1), и обозначил ключевую ветку как

ветка по дискуссиям профессионалов:

Теперь, если кто-то зайдет в ключевую ветку, а у него будет недостаточная квалификация для обсуждения среди профессионалов -

можно просто пост переместить сюда. Таким образом - новички не буду уходить с форума совсем, а останутся, и у них даже будет возможность чего-то спросить по теме МО.

-----------------------

Кстати, summary (ветки и посты как обзоры по теме) очень популярны на англоязычном форуме

(они бывают как ветками, так и просто постами).

Например -

В англоязычном форуме:

Здесь на форуме:

--------------------

Например, в одной моей ветке 237 листов, а новички не буду читать столько листов, даже если там индикаторы исходниками и советники с тестами и настройками. Я сделал summary ветки #613

А 3 тысячи листов точно читать не будут (многие новенькие и один лист то ....).

--------------------

Поэтому рекомендую делать summary постами или ветками (лучше постами).

Так как эти summary популярны, и любому новичку (который что-то спросил, как бы прервав дискуссию) - можно просто дать ссылку на summary.

То есть, на вопрос "а что вы тут обсуждаете на 3 тыс листов?" (были такие вопросы, и воспринимались как флуд) - может быть ответ:

"обсуждем это - см пост #1".

И никакой суммари там не может быть, т.к. обсуждались десятки-сотни разных вещей. Резюмировать 5-10 строками это невозможно.

Понимаю, что людям хотелось бы сразу большую красную кнопку "Бабло". Но к сожалению её нет. Кто хочет заниматься МО, должен быть готов потратить на это годы и возможно, что и это ничего не даст.

Когда я решил заняться МО в 2018, там было около 900 страниц. Читал неделю, потому что интерес был вникнуть в тему. Остальные страницы уже читал по мере появления.

И никакой суммари там не может быть, т.к. обсуждались десятки-сотни разных вещей. Резюмировать 5-10 строками это невозможно.

Понимаю, что людям хотелось бы сразу большую красную кнопку "Бабло". Но к сожалению её нет. Кто хочет заниматься МО, должен быть готов потратить на это годы и возможно, что и это ничего не даст.

На этом сайте достаточно много внимания уделяется МО, форум, заказные статьи, подборки литературы, сделанные метаквотами. подавляющем числе случае обсуждают модели, в основном разные варианты нейросетей, но крайне мало уделяется внимания препроцессингу входных данных.

Делаю копипаст шагов препроцессинга из пакета recipe из R. Из названия функция можно судить о содержании шага препроцессинга:

#> [1] "step_BoxCox" "step_YeoJohnson"

#> [3] "step_arrange" "step_bagimpute"#> [5] "step_bin2factor" "step_bs"

#> [7] "step_center" "step_classdist"#> [9] "step_corr" "step_count"

#> [11] "step_cut" "step_date"#> [13] "step_depth" "step_discretize"

#> [15] "step_dummy" "step_dummy_extract"#> [17] "step_dummy_multi_choice" "step_factor2string"

#> [19] "step_filter" "step_filter_missing"#> [21] "step_geodist" "step_harmonic"

#> [23] "step_holiday" "step_hyperbolic"#> [25] "step_ica" "step_impute_bag"

#> [27] "step_impute_knn" "step_impute_linear"#> [29] "step_impute_lower" "step_impute_mean"

#> [31] "step_impute_median" "step_impute_mode"#> [33] "step_impute_roll" "step_indicate_na"

#> [35] "step_integer" "step_interact"#> [37] "step_intercept" "step_inverse"

#> [39] "step_invlogit" "step_isomap"#> [41] "step_knnimpute" "step_kpca"

#> [43] "step_kpca_poly" "step_kpca_rbf"#> [45] "step_lag" "step_lincomb"

#> [47] "step_log" "step_logit"#> [49] "step_lowerimpute" "step_meanimpute"

#> [51] "step_medianimpute" "step_modeimpute"#> [53] "step_mutate" "step_mutate_at"

#> [55] "step_naomit" "step_nnmf"#> [57] "step_nnmf_sparse" "step_normalize"

#> [59] "step_novel" "step_ns"#> [61] "step_num2factor" "step_nzv"

#> [63] "step_ordinalscore" "step_other"#> [65] "step_pca" "step_percentile"

#> [67] "step_pls" "step_poly"#> [69] "step_poly_bernstein" "step_profile"

#> [71] "step_range" "step_ratio"#> [73] "step_regex" "step_relevel"

#> [75] "step_relu" "step_rename"#> [77] "step_rename_at" "step_rm"

#> [79] "step_rollimpute" "step_sample"#> [81] "step_scale" "step_select"

#> [83] "step_shuffle" "step_slice"#> [85] "step_spatialsign" "step_spline_b"

#> [87] "step_spline_convex" "step_spline_monotone"#> [89] "step_spline_natural" "step_spline_nonnegative"

#> [91] "step_sqrt" "step_string2factor"#> [93] "step_time" "step_unknown"

#> [95] "step_unorder" "step_window"#> [97] "step_zv"

По моему опыту трудоемкость препроцессинга в разы ниже (от 3 до 5 раз) трудоемкости применения собственно модели

Может мои посты тут будут не к месту в таком уважаемом уголке МО, но всё же попробую спросить до случайной вероятности очередного бана.)

Хочу задать вопрос знатокам т.н. МО.

Как вы оцениваете вероятность прогноза в МО, если существует вероятность роста, падения и в то же время существует вероятность длительного топтания на месте?

Вероятность ведь от 0 до 1.

Меня интересует оценка ошибки прогноза в МО. В каком диапазоне оценка???