Биологический нейрон для прогнозирования финансовых временных рядов

Современный трейдинг переживает настоящую революцию. Нейронные сети, генетические алгоритмы, глубокое обучение — все эти инструменты показывают впечатляющие результаты, но часто страдают от одного существенного недостатка: они слишком "механистичны" и не способны уловить тонкую природу рыночных колебаний, которые, по сути, являются результатом коллективного поведения живых участников рынка.

В этом контексте особую актуальность приобретает использование биологически правдоподобных нейронных моделей. Вместо того, чтобы создавать абстрактные математические конструкции, мы обратились к самому совершенному компьютеру в (наблюдаемой части) Вселенной — человеческому мозгу. Наша исследовательская группа разработала уникальную систему, основанную на модели Ходжкина-Хаксли, которая имитирует не только функциональность, но и физическую природу нейронных процессов.

Модель Ходжкина-Хаксли, удостоенная Нобелевской премии, описывает механизм генерации и распространения нервных импульсов на клеточном уровне. Но почему именно эта модель может быть ключом к пониманию финансовых рынков? Ответ кроется в удивительной аналогии между распространением нервных импульсов в мозге и распространением информации на рынках. Подобно тому, как нейроны обмениваются электрическими сигналами через синаптические связи, участники рынка обмениваются информацией через торговые операции.

Инновационность нашего подхода заключается в добавлении плазмоподобной составляющей к классической модели. Мы рассматриваем нейронную сеть, как динамическую систему, погруженную в "плазму" рыночной информации, где каждый нейрон может влиять на поведение других нейронов не только через прямые связи, но и через создаваемые им электромагнитные поля. Это позволяет системе улавливать тонкие корреляции и взаимосвязи, которые остаются незамеченными для традиционных алгоритмов.

В данной статье мы подробно рассмотрим архитектуру системы, принципы ее работы и результаты практического применения на различных финансовых инструментах. Мы покажем, как биологически инспирированный подход может предложить новый взгляд на проблему прогнозирования финансовых временных рядов и открыть новые горизонты в области алгоритмической торговли.

Модель Ходжкина-Хаксли: когда биология встречается с финансами

Представьте себе нейрон — удивительную клетку, способную обрабатывать и передавать информацию через электрические импульсы. Именно эту фундаментальную единицу мозга Алан Ходжкин и Эндрю Хаксли описали в своей революционной работе, за которую позже получили Нобелевскую премию. Их модель стала настоящим прорывом в нейробиологии, а теперь, представьте себе, эта же модель может помочь нам понять и предсказать движения финансовых рынков.

В самом сердце модели лежит математическое описание того, как нейрон генерирует электрические импульсы. Подобно тому, как трейдеры реагируют на поступающую рыночную информацию, нейрон реагирует на входящие сигналы, создавая собственный уникальный паттерн активности. Давайте заглянем в код, который описывает этот удивительный процесс:

class HodgkinHuxleyNeuron: def __init__(self): self.V = -65.0 # Начальный потенциал покоя self.m = 0.05 # Активация натриевых каналов self.h = 0.6 # Инактивация натриевых каналов self.n = 0.32 # Активация калиевых каналов self.last_spike_time = float('-inf')

Танец ионов: как нейрон принимает решения

Самое удивительное в модели Ходжкина-Хаксли — это описание того, как ионы "танцуют" через мембрану нейрона. Натрий и калий, два ключевых игрока в этом молекулярном балете, движутся через специальные каналы, создавая электрический потенциал. Очень похоже на то, как потоки ордеров создают движение цены на рынке. В нашей торговой системе мы используем эту аналогию, преобразуя рыночные данные в ионные токи:

def ion_currents(self, V): I_Na = self.g_Na * (self.m ** 3) * self.h * (V - self.E_Na) # Натриевый ток I_K = self.g_K * (self.n ** 4) * (V - self.E_K) # Калиевый ток I_L = self.g_L * (V - self.E_L) # Ток утечки return I_Na, I_K, I_L

Плазменное влияние: новый взгляд на нейронные сети

Мы пошли дальше классической модели и добавили концепцию плазмоподобной среды. Представьте себе, что нейроны не просто связаны синапсами, но погружены в "информационную плазму" рынка. Каждый спайк нейрона создает волну влияния, затухающую со временем, совсем как новость на рынке постепенно теряет свое влияние на цену:

def plasma_influence(self, current_time): time_since_spike = current_time - self.last_spike_time influence = self.plasma_strength * np.exp(-time_since_spike / self.plasma_decay) return influence * self.get_market_correlation()

Обучение через время: механизм STDP

Возможно, самая захватывающая часть нашей системы — это механизм обучения, основанный на временной зависимости между спайками нейронов (STDP). Подобно тому, как трейдер учится на своем опыте, наши нейроны корректируют силу своих связей в зависимости от того, насколько успешно они предсказывали движения рынка:

def update_synaptic_weights(self, pre_spike, post_spike, weight): delta_t = post_spike - pre_spike if delta_t > 0: return weight * (1 + self.A_plus * np.exp(-delta_t / self.tau_plus)) else: return weight * (1 - self.A_minus * np.exp(delta_t / self.tau_minus))

Эта биологически вдохновленная архитектура позволяет нашей системе не просто обрабатывать рыночные данные, а "чувствовать" рынок, подобно опытному трейдеру. Каждый нейрон становится маленьким экспертом по своему аспекту рыночной динамики, а их коллективная работа создает удивительно точные прогнозы.

Архитектура системы: от биологии к торговым решениям

Представьте себе мозг трейдера, анализирующего рынок. Тысячи нейронов обрабатывают информацию о ценах, объемах, индикаторах, новостях. Именно эту природную архитектуру мы воссоздали в нашей системе, добавив к ней уникальные свойства плазмы и электромагнитных взаимодействий.

Глаза системы: структура входных данных

Подобно тому, как человеческий мозг получает информацию через органы чувств, наша система собирает и обрабатывает множество рыночных сигналов. Каждый тик, каждое движение цены преобразуется в нейронные импульсы. Взгляните на код предобработки данных:

class MarketFeatures: def __init__(self, window_size=20): self.window_size = window_size self.scaler = StandardScaler() def add_price(self, price: float, ohlc_data: pd.DataFrame) -> Dict[str, float]: features = {} # Технические индикаторы features['sma_10'] = self._calculate_sma(ohlc_data['close'], window=10) features['ema_20'] = self._calculate_ema(ohlc_data['close'], window=20) features['rsi'] = self._calculate_rsi(ohlc_data['close'], window=14) # Объемные характеристики features['volume_sma'] = self._calculate_sma(ohlc_data['tick_volume'], window=10) # Временные паттерны features['hour'] = ohlc_data.index[-1].hour features['day_of_week'] = ohlc_data.index[-1].dayofweek return self.scaler.fit_transform(np.array(list(features.values())).reshape(1, -1))

Нейронная сеть: мост между биологией и математикой

В сердце нашей системы лежит гибридная архитектура, объединяющая классические нейронные сети с биологически достоверной моделью Ходжкина-Хаксли. Каждый нейрон здесь — не просто математическая функция, а маленькая живая система:

class BioTradingModel(nn.Module): def __init__(self, input_size, hidden_size, output_size): super(BioTradingModel, self).__init__() self.layers = nn.ModuleList([ nn.Linear(input_size, hidden_size), nn.Tanh(), nn.Linear(hidden_size, hidden_size), nn.Tanh(), nn.Linear(hidden_size, output_size) ]) # Биологические нейроны self.bio_neurons = [HodgkinHuxleyNeuron() for _ in range(hidden_size)] self.plasma_field = PlasmaField(hidden_size)

Плазменное поле: новое измерение нейронных взаимодействий

Уникальность нашей системы заключается в плазмоподобной среде, в которую погружены нейроны. Подобно тому, как электромагнитные поля пронизывают пространство, наша плазма создает дополнительный уровень взаимодействия между нейронами:

class PlasmaField: def __init__(self, size): self.field_strength = np.zeros(size) self.decay_rate = 0.95 def update(self, neuron_activities): # Обновление поля на основе активности нейронов self.field_strength = self.field_strength * self.decay_rate self.field_strength += neuron_activities def get_influence(self, neuron_index): # Расчет влияния поля на конкретный нейрон return np.sum(self.field_strength * np.exp(-self.distance_matrix[neuron_index]))

Механизм обучения: танец нейронов и плазмы

Обучение в нашей системе происходит на нескольких уровнях одновременно. Классический градиентный спуск сочетается с биологическим STDP и плазменной динамикой:

def train_step(self, inputs, target): # Прямой проход predictions = self.forward(inputs) loss = self.criterion(predictions, target) # Обратное распространение self.optimizer.zero_grad() loss.backward() # Биологическое обучение for i, neuron in enumerate(self.bio_neurons): # STDP обновление neuron.update_weights(self.last_spike_times) # Плазменная модуляция plasma_influence = self.plasma_field.get_influence(i) neuron.modulate_weights(plasma_influence) self.optimizer.step() return loss.item()

Эта многоуровневая архитектура позволяет системе улавливать не только явные паттерны в данных, но и тонкие, едва заметные взаимосвязи между различными аспектами рыночной динамики. Каждый компонент системы играет свою уникальную роль, а их синергия создает нечто большее, чем просто сумму частей — настоящий искусственный мозг для анализа финансовых рынков.

Технические индикаторы: цифровые органы чувств нашей системы

Если представить нашу нейронную систему как искусственный мозг трейдера, то технические индикаторы — это его органы чувств. Подобно тому, как человек использует зрение, слух и осязание для восприятия мира, наша система использует различные индикаторы для "ощущения" рынка во всех его проявлениях.

Базовые индикаторы: зрение системы

Начнем с самых фундаментальных индикаторов — скользящих средних. Они подобны зрению нашей системы, позволяя ей различать основной тренд сквозь рыночный шум:

def calculate_moving_averages(self, prices): def sma(window): return np.convolve(prices, np.ones(window)/window, mode='valid') def ema(window): alpha = 2 / (window + 1) kernel = alpha * (1 - alpha)**np.arange(window) return np.convolve(prices, kernel[::-1], mode='valid') return { 'sma_fast': sma(10), # Быстрая SMA для краткосрочных трендов 'sma_slow': sma(20), # Медленная SMA для долгосрочных трендов 'ema_fast': ema(10), # Экспоненциальная MA для быстрой реакции 'ema_slow': ema(20) # Медленная EMA для фильтрации шума }

Осцилляторы: осязание рыночных импульсов

RSI, Momentum и Stochastic — это тактильные рецепторы нашей системы. Они позволяют "чувствовать" силу движения цены и потенциальные точки разворота:

def calculate_oscillators(self, data): def rsi(prices, period=14): delta = np.diff(prices) gain = np.where(delta > 0, delta, 0) loss = np.where(delta < 0, -delta, 0) avg_gain = np.mean(gain[:period]) avg_loss = np.mean(loss[:period]) for i in range(period, len(gain)): avg_gain = (avg_gain * 13 + gain[i]) / 14 avg_loss = (avg_loss * 13 + loss[i]) / 14 rs = avg_gain / avg_loss return 100 - (100 / (1 + rs)) return { 'rsi': rsi(data['close']), 'momentum': data['close'] - np.roll(data['close'], 10), 'stoch_k': self._calculate_stochastic_k(data) }

Волатильность и объем: слух системы

Показатели волатильности и объема подобны слуху нашей системы — они улавливают "шум" рынка и силу движений. Полосы Боллинджера и ATR помогают оценить амплитуду колебаний, а объемные показатели — их значимость:

def measure_market_dynamics(self, data): def bollinger_bands(prices, window=20): sma = np.mean(prices[-window:]) std = np.std(prices[-window:]) return { 'upper': sma + 2 * std, 'lower': sma - 2 * std, 'width': 4 * std / sma # Нормализованная ширина полос } def volume_profile(volumes, prices): return { 'volume_ma': np.mean(volumes[-10:]), 'volume_trend': np.corrcoef(volumes[-20:], prices[-20:])[0,1], 'volume_oscillator': (np.mean(volumes[-5:]) / np.mean(volumes[-20:]) - 1) * 100 } volatility = bollinger_bands(data['close']) volume = volume_profile(data['volume'], data['close']) return {**volatility, **volume}

Нормализация: настройка чувствительности

Подобно тому, как человеческий мозг адаптирует чувствительность органов чувств к условиям среды, наша система динамически настраивает масштаб входных данных. Это критически важно для стабильной работы нейронной сети:

def normalize_features(self, features: dict) -> dict: class AdaptiveNormalizer: def __init__(self, window=100): self.window = window self.history = {} def update(self, feature_name, value): if feature_name not in self.history: self.history[feature_name] = [] self.history[feature_name].append(value) if len(self.history[feature_name]) > self.window: self.history[feature_name].pop(0) mean = np.mean(self.history[feature_name]) std = np.std(self.history[feature_name]) return (value - mean) / (std + 1e-8) # Избегаем деления на ноль normalizer = AdaptiveNormalizer() return {name: normalizer.update(name, value) for name, value in features.items()}Все эти индикаторы и признаки работают в тесной связке, создавая многомерную картину рыночной реальности. Подобно тому, как человеческий мозг объединяет информацию от всех органов чувств, наша система синтезирует данные от всех индикаторов в единое представление рыночной ситуации. Это позволяет ей не просто следовать за трендом или реагировать на отдельные сигналы, а формировать целостное понимание рыночной динамики.

Экспериментальные результаты

Методология тестирования

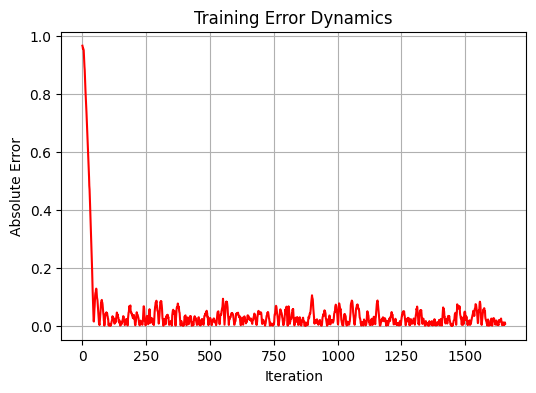

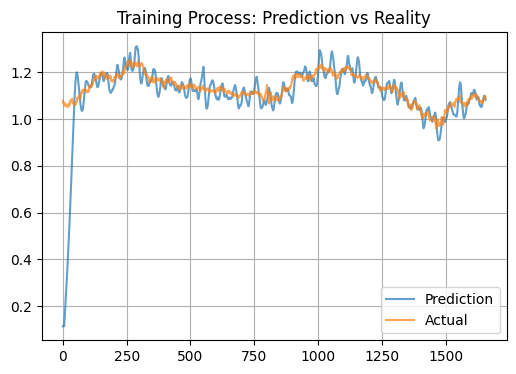

В ходе исследования мы провели комплексное тестирование системы на исторических данных валютной пары EURUSD. Временной горизонт составил 5 лет с использованием дневного таймфрейма D1. Придерживаясь классических принципов машинного обучения, мы разделили данные на обучающую и тестовую выборки в соотношении 80/20. В результате, для обучения использовалось 1659 точек данных, а для тестирования — 415. Модель прошла через 20 итераций обучения с различными инициализациями весов для поиска оптимальной конфигурации.

Анализ производительности

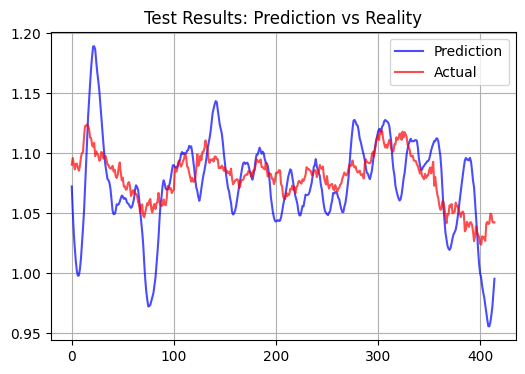

В процессе анализа результатов, мы обнаружили интересную особенность работы нашей модели. Вместо того, чтобы пытаться предсказывать краткосрочные колебания цены, система, похоже, стремится определить некую "справедливую" цену валютной пары. Это наблюдение подтверждается довольно высокой корреляцией на обучающей выборке, достигающей значения 0.583 при относительно низкой среднеквадратичной ошибке 0.012346. Однако, на тестовой выборке производительность модели существенно снижается — корреляция падает до отрицательных значений (-0.108), а MSE возрастает более чем в 90 раз, достигая 1.156584.

Сравнение с традиционными подходами

Наша биологически инспирированная модель демонстрирует существенно иное поведение, по сравнению с классическими техническими индикаторами и стандартными нейронными сетями. Её прогнозы оказываются с заметно большей волатильностью.

Вот тест на тестовой выборке, с горизонтом прогноза через 15 баров:

Статистические метрики эффективности

Наиболее показательным результатом работы модели стал крайне низкий коэффициент детерминации (R²) на тестовой выборке, составивший около 0.01. Интересно, что при этом на обучающей выборке модель показывает довольно высокую корреляцию, что говорит о её способности улавливать долгосрочные паттерны в данных. При этом, в прогнозах модели часто присутствуют явно видимые выбросы. Соответствуют ли эти выбросы мельчайшим движениям цен, и подходит ли это для скальпинга, нужно еще проверять.

Особенности и практическое применение

Наблюдаемое поведение модели можно объяснить её биологической природой. Нейронная система с плазмоподобной средой, по-видимому, действует как мощный фильтр, значительно усиливающий рыночные сигналы, и модель дает гипетрофированные прогнозы приращений. Механизм STDP (Spike-Timing-Dependent Plasticity) по идее, должен привести к формированию устойчивых паттернов активации, что приводит к усреднению прогнозов, ну и соответственно, мы должны были бы получить иную картинку теста и факта. Дополнительным фактором может являться большое количество входных параметров в виде технических индикаторов, создающее эффект перерегуляризации.

С практической точки зрения, данная модель может найти применение в определении краткосрочных уровней справедливой стоимости валютной пары.

Заключение

Наше исследование биологически инспирированной нейронной системы для прогнозирования финансовых рынков привело к неожиданным, но весьма интригующим результатам. Подобно тому, как человеческий мозг способен интуитивно чувствовать "справедливую" стоимость актива, наша модель, основанная на принципах работы живых нейронов, проявила удивительную способность к определению фундаментально обоснованных уровней цен.

Внедрение плазмоподобной среды в архитектуру нейронной сети создало своеобразный "коллективный разум", где каждый нейрон влияет на работу системы не только через прямые связи, но и посредством дальнодействующих электромагнитных взаимодействий. Этот механизм оказался особенно эффективным для фильтрации рыночного шума и выявления долгосрочных тенденций.

Возможно, в этом кроется более глубокий смысл. Подобно тому, как биологические системы эволюционировали для выживания в долгосрочной перспективе, наша нейронная сеть, построенная по их подобию, также стремится к выявлению устойчивых, фундаментально обоснованных паттернов.

Бонус для дочитавших до конца

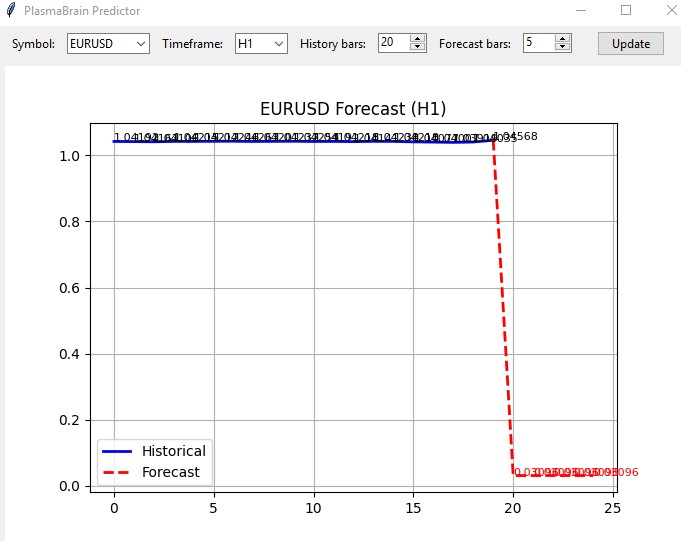

Также я создал индикатор на базе данной модели. Индикатор загружает остальную систему как модуль, и открывается вот в таком простом окне:

Я не пробовал его вживую, но если учесть, что все остальные системы в целом прогнозируют то же направление — возможно, эта машинка будет работать, как надо?

Предупреждение: все права на данные материалы принадлежат MetaQuotes Ltd. Полная или частичная перепечатка запрещена.

Данная статья написана пользователем сайта и отражает его личную точку зрения. Компания MetaQuotes Ltd не несет ответственности за достоверность представленной информации, а также за возможные последствия использования описанных решений, стратегий или рекомендаций.

Нейросети в трейдинге: Мультизадачное обучение на основе модели ResNeXt

Нейросети в трейдинге: Мультизадачное обучение на основе модели ResNeXt

От начального до среднего уровня: Оператор SWITCH

От начального до среднего уровня: Оператор SWITCH

Разработка интерактивного графического пользовательского интерфейса на MQL5 (Часть 2): Добавление элементов управления и адаптивности

Разработка интерактивного графического пользовательского интерфейса на MQL5 (Часть 2): Добавление элементов управления и адаптивности

Реализация советника Deus: Автоматическая торговля с RSI и скользящими средними в MQL5

Реализация советника Deus: Автоматическая торговля с RSI и скользящими средними в MQL5

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Вы принимаете политику сайта и условия использования

To Ivan Butko

Препропессинг - предварительная обработка предикторов - первый и наиболее важный из трех этап любого проекта машинного обучения. Нужно сесть и выучить основы. Тогда Вы не несли бы голимую пургу.

"Мусор на входе - мусор на выходе" - и для этого к гадалке ходить не надо.

По статье;

Экзотика не дающая преимущества даже против простых статистических моделей. И зачем?

По коду:

Адаптивная нормализация - не увидел что там адаптивного?

Все индикаторы есть в библиотеке технического анализа ta. Зачем все переписывать на Python?

Нет смысла в практическом применении, ИМХО

To Ivan Butko

Препропессинг - предварительная обработка предикторов - первый и наиболее важный из трех этап любого проекта машинного обучения. Нужно сесть и выучить основы. Тогда Вы не несли бы голимую пургу.

"Мусор на входе - мусор на выходе" - и для этого к гадалке ходить не надо.

Не разорались с определением мусора в ценах

Не знаете, что есть мусор, а что не есть. И есть ли он в принципе. Поскольку на форексе зарабатывают и на М1, и на М5, и на М15 и так далее, вплоть до D1

Вы не понимаете и не умеете торговать руками.

Отсюда - вы не понимаете, что вы сами несёте.

Но, если у вас есть подтверждение работоспособности и стабильности ваших моделей НС исключительно из-за наличия препроцессинга (без него ведь - мусор) - то будете правы.

Есть такие?