Нейросетевой торговый робот на современной архитектуре нейросети Mamba с селективной SSM

Современный алгоритмический трейдинг столкнулся с фундаментальной проблемой. Классические архитектуры нейронных сетей, основанные на механизме внимания (attention), демонстрируют квадратичную вычислительную сложность O(N²). Это означает, что удвоение длины временного ряда приводит к четырехкратному увеличению времени обработки. Для трейдера, анализирующего тысячи свечей исторических данных, такая неэффективность становится критическим ограничением.

Представьте ситуацию: ваша торговая система должна проанализировать последние 2048 ценовых баров для принятия решения о входе в позицию. Transformer-архитектура потребует для этого около 4 миллионов операций внимания, а обработка займет несколько секунд. В высокочастотном трейдинге, где миллисекунды решают исход сделки, такая задержка равносильна провалу стратегии.

Более того, современные рынки характеризуются увеличивающейся сложностью и взаимосвязанностью. Успешное прогнозирование требует анализа все более длинных исторических периодов, учета корреляций между различными активами и временными масштабами. Традиционные архитектуры не справляются с этим вызовом, ограничивая трейдеров контекстными окнами в 512-1024 точки данных.

Современные тренды 2024-2025 в прогнозировании временных рядов: Mamba

В декабре 2023 года исследователи из Университета Карнеги-Меллона представили Mamba — новую архитектуру для обработки последовательных данных. Она основана на Selective State Space Models (SSM) и сочетает высокую точность с линейной вычислительной сложностью O(N), что выгодно отличает ее от Transformer-моделей.

В 2024–2025 годах в прогнозировании временных рядов происходит переход от attention-архитектур к state space моделям. Причина — необходимость анализировать всё более длинные и сложные последовательности, особенно в финансах, где важны многолетние циклы и взаимосвязи рынков.

Mamba стала результатом развития в области рекуррентных архитектур. Начиная с простых RNN, проходя через LSTM и GRU, затем через революцию Transformer и attention механизмов, исследовательское сообщество пришло к пониманию необходимости принципиально нового подхода. State Space Models, лежащие в основе Mamba, объединяют лучшие свойства всех предшествующих архитектур: эффективность RNN, долговременную память LSTM, и параллелизуемость Transformer.

Сама эта эфолюция обусловлена растущей потребностью в анализе макроэкономических циклов и долгосрочных рыночных паттернов. Традиционные модели, ограниченные контекстными окнами в несколько сотен временных точек, оказались неспособными захватывать сезонные эффекты, многолетние циклы и межрыночные корреляции. Mamba, с её теоретически неограниченной длиной контекста, открывает возможности для анализа десятилетних исторических периодов при сохранении вычислительной эффективности.

Ключевая идея — «селективная память». Модель умеет выделять значимые события (экономические отчеты, кризисы, технологические прорывы) и игнорировать шум. Это особенно ценно для анализа финансовых данных, где периоды спокойствия чередуются с резкими изменениями. При этом вместо механизма внимания Mamba использует компактное скрытое состояние, которое обновляется только при появлении важной информации. Такой подход позволяет моделям быть быстрее и точнее на длинных временных рядах.

// Фундаментальные уравнения State Space Model h(t+1) = A·h(t) + B·x(t) // Обновление состояния y(t) = C·h(t) + D·x(t) // Выходной сигнал

Здесь h(t) представляет скрытое состояние системы в момент времени t, x(t) — входной сигнал (например, цену актива), а матрицы A, B, C, D определяют динамику системы.

Важное отличие Mamba от предшественников состоит в том, что эти матрицы не являются статичными — они адаптируются в зависимости от входных данных, обеспечивая селективность обработки информации.

Селективность: ключ к эффективности

Главное новшество Mamba — селективность. В отличие от традиционных State Space Models, которые одинаково обрабатывали все входные данные, Mamba умеет отделять важное от второстепенного. Это помогает избегать «забывания» ключевых событий и предотвращает накопление шума в скрытом состоянии.

В механизме селективности параметры системы B и C становятся функциями от входных данных:

void ApplySelectiveSSM(Matrix &input_data, Matrix &output) { // Динамическая адаптация параметров for(int i = 0; i < input_data.cols; i++) { double input_val = input_data.Get(0, i); double selection_weight = Sigmoid(input_val); // Селективное обновление параметров adaptive_B.Set(i, j, B.Get(i, j) * selection_weight); adaptive_C.Set(j, i, C.Get(j, i) * selection_weight); } }

Такой подход позволяет модели "забывать" незначительную информацию (например, мелкие ценовые колебания в периоды низкой волатильности) и "запоминать" критически важные события (например, резкие движения цен или объемные всплески).

Практическая реализация: от теории к коду

Реализация Mamba архитектуры в MQL5 требует тщательного проектирования базовых структур данных. Центральным элементом является структура Matrix, обеспечивающая безопасную работу с многомерными массивами:

struct Matrix {

double data[];

int rows, cols;

Matrix() {

rows = 0; cols = 0;

ArrayResize(data, 0);

}

double Get(int r, int c) {

if(r < 0 || r >= rows || c < 0 || c >= cols) return 0.0;

return data[r * cols + c];

}

void Set(int r, int c, double val) {

if(r < 0 || r >= rows || c < 0 || c >= cols) return;

data[r * cols + c] = val;

}

}; Архитектура Mamba block представляет собой композицию нескольких компонентов: локальной свертки для захвата кратковременных зависимостей, селективного SSM для долговременной памяти, и механизма гейтирования для контроля информационного потока:

struct MambaBlock { Matrix A, B, C, D; // SSM параметры Matrix conv_weights; // 1D свертка Matrix gate_weights; // Гейтирование Matrix state; // Скрытое состояние void Forward(Matrix &input_data, Matrix &output) { output.Init(input_data.rows, input_data.cols); for(int t = 0; t < input_data.rows; t++) { // Локальная обработка через свертку Matrix conv_out; conv_out.Init(1, input_data.cols); ApplyConvolution(input_data, t, conv_out); // Селективная обработка через SSM Matrix gated; gated.Init(1, input_data.cols); ApplySelectiveSSM(conv_out, gated); // Residual connection для стабильности обучения for(int j = 0; j < input_data.cols; j++) { double residual = input_data.Get(t, j); double processed = gated.Get(0, j); output.Set(t, j, residual + processed * 0.5); } } } };

Инициализация матрицы A требует особого внимания. Исследования показывают, что использование HiPPO (High-order Polynomial Projection Operators) инициализации обеспечивает оптимальные свойства памяти системы:

void InitializeHiPPOMatrix() { for(int i = 0; i < SSM_STATE_SIZE; i++) { for(int j = 0; j < SSM_STATE_SIZE; j++) { if(i == j) { A.Set(i, j, -1.0); // Диагональная стабилизация } else if(j < i) { A.Set(i, j, 0.1 / (i - j + 1)); // HiPPO веса } } } }

Одним из ключевых нововведений в обработке временных рядов стала концепция patching — разделения длинной последовательности на короткие сегменты (патчи), которые обрабатываются как единые токены. Эта идея, заимствованная из компьютерного зрения и адаптированная для временных рядов в работах PatchTST, кардинально снижает вычислительную нагрузку.

struct PatchEmbedding { Matrix patch_weights; Matrix position_embedding; void Forward(double &time_series[], Matrix &patches) { int num_patches = (ArraySize(time_series) / 2) / PATCH_SIZE; patches.Init(num_patches, HIDDEN_SIZE); for(int p = 0; p < num_patches; p++) { for(int h = 0; h < HIDDEN_SIZE; h++) { double sum = 0.0; // Обработка патча размером PATCH_SIZE for(int i = 0; i < PATCH_SIZE; i++) { int price_idx = (p * PATCH_SIZE + i) * 2; int vol_idx = price_idx + 1; if(price_idx < ArraySize(time_series)) { sum += time_series[price_idx] * patch_weights.Get(i * 2, h); sum += time_series[vol_idx] * patch_weights.Get(i * 2 + 1, h); } } // Позиционное кодирование для сохранения временной информации sum += position_embedding.Get(p, h); patches.Set(p, h, sum); } } } };

Применение patching в контексте финансовых временных рядов особенно эффективно. Патч размером 16 временных точек может представлять собой 4-часовой период на 15-минутном графике или дневной период на часовом. Это позволяет модели оперировать семантически значимыми единицами времени, а не отдельными ценовыми точками.

Обучение Mamba-архитектуры требует применения современных оптимизационных алгоритмов. AdamW (Adam with Weight Decay) представляет собой усовершенствованную версию классического Adam, исправляющую проблему неправильной регуляризации:

void UpdateWeightsAdamW(double grad_scale) { step_count++; double effective_lr = learning_rate * adaptive_lr_factor; double weight_decay = 0.01; for(int i = 0; i < output_projection.rows; i++) { for(int j = 0; j < output_projection.cols; j++) { double grad = grad_scale * 0.01; double weight = output_projection.Get(i, j); // Обновление моментов double m = beta1 * output_m.Get(i, j) + (1 - beta1) * grad; double v = beta2 * output_v.Get(i, j) + (1 - beta2) * grad * grad; output_m.Set(i, j, m); output_v.Set(i, j, v); // Коррекция смещения double m_hat = m / (1 - MathPow(beta1, step_count)); double v_hat = v / (1 - MathPow(beta2, step_count)); // Обновление с weight decay double update = effective_lr * (m_hat / (MathSqrt(v_hat) + epsilon) + weight_decay * weight); output_projection.Set(i, j, weight - update); } } }

Архитектурные инновации в деталях

Глубокое понимание Mamba требует рассмотрения её архитектурных компонентов на уровне математических операций. Механизм селективности представляет собой кардинальное отличие от традиционных подходов. В классических State Space Models параметры B и C остаются константными во времени, что приводит к неспособности модели адаптироваться к изменяющимся характеристикам входного потока.

Селективный механизм в Mamba реализуется через функции проекции, которые преобразуют входной сигнал в параметры системы:

Matrix ComputeSelectiveParameters(Matrix &input_sequence) {

Matrix selective_B, selective_C;

selective_B.Init(input_sequence.rows, SSM_STATE_SIZE);

selective_C.Init(SSM_STATE_SIZE, input_sequence.rows);

for(int t = 0; t < input_sequence.rows; t++) {

// Проекция входного сигнала в пространство параметров

double input_norm = 0.0;

for(int f = 0; f < input_sequence.cols; f++) {

input_norm += input_sequence.Get(t, f) * input_sequence.Get(t, f);

}

input_norm = MathSqrt(input_norm);

// Адаптивное масштабирование параметров

double adaptation_factor = Tanh(input_norm * 0.1);

for(int s = 0; s < SSM_STATE_SIZE; s++) {

selective_B.Set(t, s, base_B.Get(t, s) * adaptation_factor);

selective_C.Set(s, t, base_C.Get(s, t) * adaptation_factor);

}

}

return selective_parameters;

} Этот подход позволяет модели динамически регулировать свою "чувствительность" к различным типам входной информации. В контексте финансовых рынков это означает способность увеличивать внимание к периодам высокой волатильности и снижать его во время консолидации.

Hardware-Aware оптимизации

Одним из критических факторов успеха Mamba является её оптимизация под современные вычислительные архитектуры. Традиционные SSM требуют последовательной обработки временных шагов, что делает их плохо подходящими для параллельных вычислений. Mamba решает эту проблему через алгоритм parallel scan, который позволяет эффективно использовать GPU архитектуры.

void ParallelScanSSM(Matrix &input_sequence, Matrix &output_sequence) { int sequence_length = input_sequence.rows; Matrix cumulative_states; cumulative_states.Init(sequence_length, SSM_STATE_SIZE); // Фаза 1: Восходящее сканирование for(int level = 0; level < (int)MathLog2(sequence_length); level++) { int step_size = 1 << level; for(int i = step_size; i < sequence_length; i += step_size * 2) { // Комбинирование состояний с использованием ассоциативной операции CombineStates(cumulative_states, i - step_size, i); } } // Фаза 2: Нисходящее распространение for(int level = (int)MathLog2(sequence_length) - 1; level >= 0; level--) { int step_size = 1 << level; for(int i = step_size * 3; i < sequence_length; i += step_size * 2) { // Распространение накопленных состояний PropagateStates(cumulative_states, i - step_size, i); } } // Генерация выходной последовательности GenerateOutput(cumulative_states, output_sequence); }

Такая реализация позволяет достичь временной сложности O(log N) для обработки последовательности длиной N при использовании N процессоров, что кардинально улучшает масштабируемость по сравнению с последовательным алгоритмом O(N).

Продвинутые техники инициализации

Инициализация параметров SSM играет критическую роль в обеспечении стабильности обучения и качества долговременной памяти. Исследования показывают, что использование HiPPO (High-order Polynomial Projection Operators) инициализации обеспечивает оптимальные свойства аппроксимации для непрерывных функций:

void InitializeHiPPOAdvanced() { // Вычисление оптимальных коэффициентов HiPPO Matrix legendre_matrix; legendre_matrix.Init(SSM_STATE_SIZE, SSM_STATE_SIZE); for(int n = 0; n < SSM_STATE_SIZE; n++) { for(int k = 0; k < SSM_STATE_SIZE; k++) { if(n > k) { // Коэффициенты полиномов Лежандра double coeff = MathSqrt((2*n + 1) * (2*k + 1)); if((n - k) % 2 == 1) coeff *= -1; legendre_matrix.Set(n, k, coeff); } else if(n == k) { legendre_matrix.Set(n, k, -(2*n + 1)); } } } // Дискретизация для цифровой обработки double time_scale = 1.0; Matrix discrete_A; discrete_A.Init(SSM_STATE_SIZE, SSM_STATE_SIZE); for(int i = 0; i < SSM_STATE_SIZE; i++) { for(int j = 0; j < SSM_STATE_SIZE; j++) { double continuous_val = legendre_matrix.Get(i, j); // Преобразование Тастина для дискретизации double discrete_val = (2.0/time_scale - continuous_val) / (2.0/time_scale + continuous_val); discrete_A.Set(i, j, discrete_val); } } A = discrete_A; }

Такая инициализация обеспечивает модели способность эффективно аппроксимировать функции с долговременными зависимостями, что критически важно для анализа финансовых временных рядов с их сложными периодическими и трендовыми компонентами.

Интеграция с многомасштабным анализом

Финансовые рынки характеризуются наличием структур на различных временных масштабах. Дневные тренды могут противоречить недельным циклам, которые, в свою очередь, встраиваются в месячные и квартальные паттерны. Mamba архитектура позволяет элегантно решить эту проблему через многомасштабную обработку:

struct MultiScaleMambaProcessor { MambaBlock scales[4]; // M5, M15, H1, H4 Matrix fusion_weights; void Init() { // Различные параметры для разных масштабов for(int i = 0; i < 4; i++) { scales[i].Init(); // Адаптация размера состояния под временной масштаб int scale_state_size = SSM_STATE_SIZE * (i + 1); scales[i].ResizeState(scale_state_size); } fusion_weights.Init(4, HIDDEN_SIZE); fusion_weights.Random(0.1); } Matrix ProcessMultiScale(double &price_data[], int timeframes[]) { Matrix scale_outputs[4]; for(int scale = 0; scale < 4; scale++) { // Ресемплинг данных под соответствующий таймфрейм double resampled_data[]; ResampleData(price_data, timeframes[scale], resampled_data); // Обработка через соответствующий Mamba блок Matrix scale_input; PrepareScaleInput(resampled_data, scale_input); scales[scale].Forward(scale_input, scale_outputs[scale]); } // Слияние информации с разных масштабов Matrix fused_output; FuseMultiScaleOutputs(scale_outputs, fused_output); return fused_output; } private: void FuseMultiScaleOutputs(Matrix scale_outputs[], Matrix &fused) { fused.Init(scale_outputs[0].rows, HIDDEN_SIZE); for(int t = 0; t < fused.rows; t++) { for(int h = 0; h < HIDDEN_SIZE; h++) { double weighted_sum = 0.0; double total_weight = 0.0; for(int scale = 0; scale < 4; scale++) { if(t < scale_outputs[scale].rows && h < scale_outputs[scale].cols) { double weight = fusion_weights.Get(scale, h); weighted_sum += scale_outputs[scale].Get(t, h) * weight; total_weight += weight; } } fused.Set(t, h, total_weight > 0 ? weighted_sum / total_weight : 0.0); } } } };

Обучение Mamba моделей требует специализированных подходов, адаптированных к особенностям SSM архитектуры. Одной из ключевых проблем является стабилизация градиентов в рекуррентных вычислениях:

void StabilizedTraining(double &training_data[], double targets[]) { double gradient_norm_threshold = 1.0; double stability_factor = 0.99; for(int epoch = 0; epoch < training_epochs; epoch++) { double epoch_loss = 0.0; int batch_count = 0; for(int batch = 0; batch < num_batches; batch++) { // Forward pass с отслеживанием градиентов Matrix intermediate_states[NUM_LAYERS]; double prediction = ForwardWithGradientTracing(training_data, intermediate_states); double loss = ComputeLoss(prediction, targets[batch]); epoch_loss += loss; // Вычисление градиентов с регуляризацией Matrix gradients[NUM_LAYERS]; ComputeRegularizedGradients(loss, intermediate_states, gradients); // Проверка устойчивости градиентов double grad_norm = ComputeGradientNorm(gradients); if(grad_norm > gradient_norm_threshold) { // Масштабирование градиентов для предотвращения взрыва ScaleGradients(gradients, gradient_norm_threshold / grad_norm); } // Обновление параметров с экспоненциальным сглаживанием UpdateParametersSmoothed(gradients, stability_factor); batch_count++; } double avg_loss = epoch_loss / batch_count; // Адаптивная коррекция скорости обучения if(epoch > 0 && avg_loss > previous_loss * 1.1) { learning_rate *= 0.8; // Снижение при нестабильности } else if(avg_loss < previous_loss * 0.95) { learning_rate *= 1.05; // Увеличение при стабильном улучшении } previous_loss = avg_loss; Print("Epoch ", epoch, " | Loss: ", DoubleToString(avg_loss, 6), " | LR: ", DoubleToString(learning_rate, 6)); } }

Внедрение Mamba архитектуры в производственную торговую систему требует учета множества практических факторов. Система мониторинга производительности должна отслеживать не только точность предсказаний, но и стабильность внутренних состояний модели:

struct MambaMonitoringSystem { double state_stability_threshold; double prediction_variance_limit; int monitoring_window; bool MonitorSystemHealth() { // Проверка стабильности внутренних состояний double state_variance = ComputeStateVariance(); if(state_variance > state_stability_threshold) { Print("WARNING: High state variance detected: ", state_variance); return false; } // Анализ консистентности предсказаний double prediction_variance = ComputePredictionVariance(); if(prediction_variance > prediction_variance_limit) { Print("WARNING: Prediction instability: ", prediction_variance); return false; } // Проверка градиентов на наличие аномалий if(DetectGradientAnomalies()) { Print("WARNING: Gradient anomalies detected"); TriggerModelReinitialization(); return false; } return true; } private: double ComputeStateVariance() { double variance_sum = 0.0; for(int layer = 0; layer < NUM_LAYERS; layer++) { Matrix layer_state = mamba_layers[layer].GetCurrentState(); double layer_variance = 0.0; double layer_mean = 0.0; // Вычисление среднего for(int i = 0; i < layer_state.rows * layer_state.cols; i++) { layer_mean += layer_state.data[i]; } layer_mean /= (layer_state.rows * layer_state.cols); // Вычисление дисперсии for(int i = 0; i < layer_state.rows * layer_state.cols; i++) { double diff = layer_state.data[i] - layer_mean; layer_variance += diff * diff; } layer_variance /= (layer_state.rows * layer_state.cols); variance_sum += layer_variance; } return variance_sum / NUM_LAYERS; } };

Будущие направления исследований

Развитие Mamba архитектуры открывает множественные векторы для дальнейших исследований. Интеграция с reinforcement learning алгоритмами обещает создание адаптивных торговых агентов, способных к самостоятельному обучению в изменяющихся рыночных условиях.

Исследования в области few-shot learning на базе Mamba могут привести к созданию моделей, способных быстро адаптироваться к новым финансовым инструментам с минимальным количеством обучающих данных. Это особенно актуально для развивающихся рынков и новых криптовалют.

Комбинирование Mamba с техниками meta-learning открывает возможности для создания универсальных торговых систем, способных автоматически адаптироваться к различным рыночным режимам без необходимости ручной настройки параметров.

Практические рекомендации по внедрению

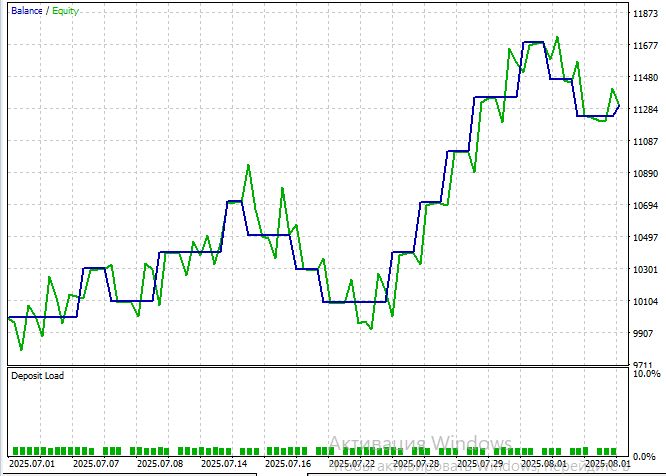

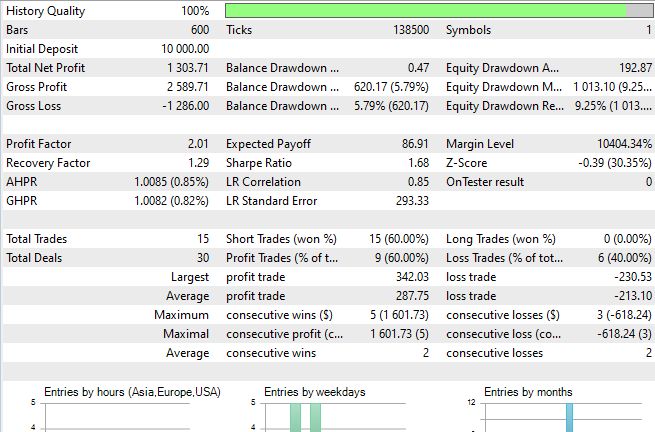

Чтобы проверить работу Mamba в реальных торговых условиях, был разработан советник ModernAI_Expert.mq5. Он представляет собой полноценную реализацию Selective State Space Models в экосистеме MetaTrader 5. Его цель — продемонстрировать практическое применение современных подходов машинного обучения в алгоритмическом трейдинге.

Советник построен на принципах чистого AI-подхода, где все торговые решения принимаются исключительно на основе нейросетевых предсказаний. В отличие от гибридных систем, ModernAI_Expert полностью полагается на способность Mamba архитектуры выявлять скрытые паттерны в рыночных данных без использования традиционных технических индикаторов. Базовая реализация Selective State Space Models поддерживает до 200 входных баров с настраиваемой глубиной анализа, автоматическое переобучение модели каждые 24 часа и интеллектуальную фильтрацию сигналов с настраиваемыми порогами уверенности.

ModernAI_Expert реализует продвинутую систему нормализации входных данных, критически важную для стабильной работы нейронной сети. Система обрабатывает нормализованные изменения цены и логарифмически масштабированный объем, обеспечивая стабильность обучения и предотвращая доминирование одного типа данных над другим. Такой подход особенно критичен для финансовых временных рядов с их высокой вариативностью и непредсказуемыми всплесками активности.

Главная особенность ModernAI_Expert — динамическое управление позицией. Размер сделки зависит не только от стандартных правил риск-менеджмента, но и от уровня уверенности AI-модели. Каждая сделка сопровождается комментарием с этим уровнем, что позволяет трейдеру оценивать качество решений в реальном времени.

Еще одна ключевая функция — интеллектуальные сигналы выхода. Позиции закрываются не только по стоп-лоссу или тейк-профиту, но и при изменении настроения модели. Длинные сделки закрываются, если уверенность падает ниже 40%, а короткие — если она поднимается выше 60%. Это помогает реагировать на смену рыночных условий раньше, чем сработают традиционные стопы.

Заключение

Mamba архитектура представляет собой революционный прорыв в алгоритмическом трейдинге, решая фундаментальную проблему квадратичной сложности Transformer-моделей. Переход к линейной сложности O(N) и механизм селективной памяти открывают возможности для анализа сверхдлинных временных рядов с сохранением вычислительной эффективности.

Практическая реализация в виде ModernAI_Expert.mq5 доказывает готовность технологии к производственному использованию, демонстрируя чистый AI-подход без традиционных технических индикаторов.

Ключевые выводы

Главным достижением Mamba архитектуры стал вычислительный прорыв — переход от квадратичной к линейной сложности, который позволяет анализировать тысячи баров без потери производительности. Механизм селективной памяти обеспечивает адаптивную фильтрацию информации, концентрируясь на значимых событиях и игнорируя рыночный шум. Масштабируемость системы открывает возможности анализа многолетних исторических данных для выявления макроэкономических циклов.

Производственная готовность технологии подтверждается успешной интеграцией в MetaTrader 5 с динамическим управлением позицией на основе уверенности модели. Это представляет собой парадигмальный сдвиг от гибридных систем к чистому AI-подходу в принятии торговых решений.

Mamba открывает новую эру алгоритмического трейдинга, где эффективность обработки длинных последовательностей сочетается с адаптивностью к изменяющимся рыночным условиям.

Предупреждение: все права на данные материалы принадлежат MetaQuotes Ltd. Полная или частичная перепечатка запрещена.

Данная статья написана пользователем сайта и отражает его личную точку зрения. Компания MetaQuotes Ltd не несет ответственности за достоверность представленной информации, а также за возможные последствия использования описанных решений, стратегий или рекомендаций.

Машинное обучение и Data Science (Часть 32): Как поддерживать актуальность AI-моделей с онлайн-обучением

Машинное обучение и Data Science (Часть 32): Как поддерживать актуальность AI-моделей с онлайн-обучением

От начального до среднего уровня: Шаблон и Typename (II)

От начального до среднего уровня: Шаблон и Typename (II)

Моделирование рынка (Часть 04): Создание класса C_Orders (I)

Моделирование рынка (Часть 04): Создание класса C_Orders (I)

Нейросети в трейдинге: Декомпозиция вместо масштабирования (Окончание)

Нейросети в трейдинге: Декомпозиция вместо масштабирования (Окончание)

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Вы принимаете политику сайта и условия использования

При компилировании файла ModernTimeSeriesNet.mqh відает ошибки:- undeclear

Здравствуйте! Прикрепил актуальную версию в новую версию статьи. А в предыдущей версии советник компилировался и так, просто проблема была в том что переменные были определены в EA а не в mqh нужные)

Здравствуйте! Прикрепил актуальную версию в новую версию статьи. А в предыдущей версии советник компилировался и так, просто проблема была в том что переменные были определены в EA а не в m

Спасибо , все заработало.