Modelos de classificação da biblioteca Scikit-learn e sua exportação para o formato ONNX

O desenvolvimento da tecnologia levou ao surgimento de uma abordagem fundamentalmente nova para construir algoritmos de processamento de dados. Anteriormente, para resolver cada problema específico, era necessária uma formulação e um desenvolvimento claros dos algoritmos correspondentes.

No aprendizado de máquina, o computador aprende por si mesmo a encontrar as melhores maneiras de processar dados. Os modelos de aprendizado de máquina podem resolver com êxito os problemas de classificação (há um conjunto fixo de classes, encontrar as probabilidades de pertencimento de um determinado conjunto de características a cada classe) e regressão (estimar o valor numérico da variável-alvo com base em um determinado conjunto de características). Com base nestes componentes fundamentais, podem ser construídos modelos mais complexos de processamento de dados.

Na biblioteca Scikit-learn, estão disponíveis muitas ferramentas tanto para classificação quanto para regressão. A escolha de métodos e modelos específicos depende das características dos dados, pois diferentes métodos podem ter eficiências variadas e fornecer resultados diferentes, dependendo do problema.

No comunicado de imprensa "ONNX Runtime is now open source", afirma-se que o ONNX Runtime também suporta o perfil ONNX-ML:

O perfil ONNX-ML é uma parte do ONNX, criada especificamente para modelos de aprendizado de máquina (ML). Ele é destinado à descrição e representação de vários tipos de modelos de ML, tais como modelos de classificação, regressão, agrupamento e outros, em uma forma conveniente que pode ser usada em diferentes plataformas e ambientes que suportam ONNX. O perfil ONNX-ML simplifica a transferência, implantação e execução de modelos de aprendizado de máquina, tornando-os mais acessíveis e portáveis.

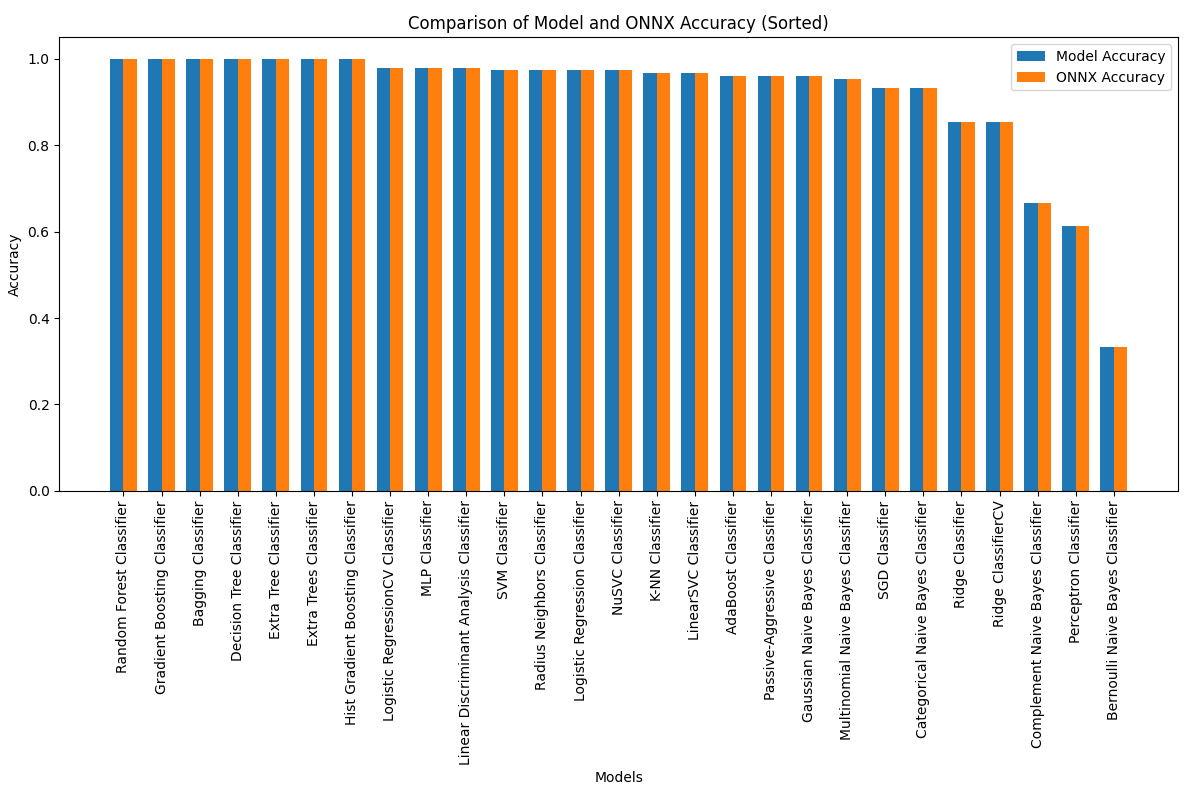

Neste artigo, exploraremos o uso de todos os modelos de classificação do pacote Scikit-learn para resolver o problema de classificação dos íris de Fisher, tentaremos convertê-los para o formato ONNX e usaremos os modelos resultantes em programas MQL5.

Também compararemos a precisão dos modelos originais e suas versões ONNX no Iris dataset completo.

Conteúdo

- 1. Íris de Fisher

- 2. Modelos para classificação

Lista de classificadores do pacote Scikit-learn

Diferentes representações de dados de saída existentes nos modelos iris.mqh - 2.1. SVC Classifier

2.1.1. Código de criação do modelo SVC Classifier

2.1.2. Código no MQL5 para trabalhar com o modelo SVC Classifier

2.1.3. Representação ONNX do modelo SVC Classifier - 2.2. LinearSVC Classifier

2.2.1. Código de criação do modelo LinearSVC Classifier

2.2.2. Código no MQL5 para trabalhar com o modelo LinearSVC Classifier

2.2.3. Representação ONNX do modelo LinearSVC Classifier - 2.3. NuSVC Classifier

2.3.1. Código de criação do modelo NuSVC Classifier

2.3.2. Código no MQL5 para trabalhar com o modelo NuSVC Classifier

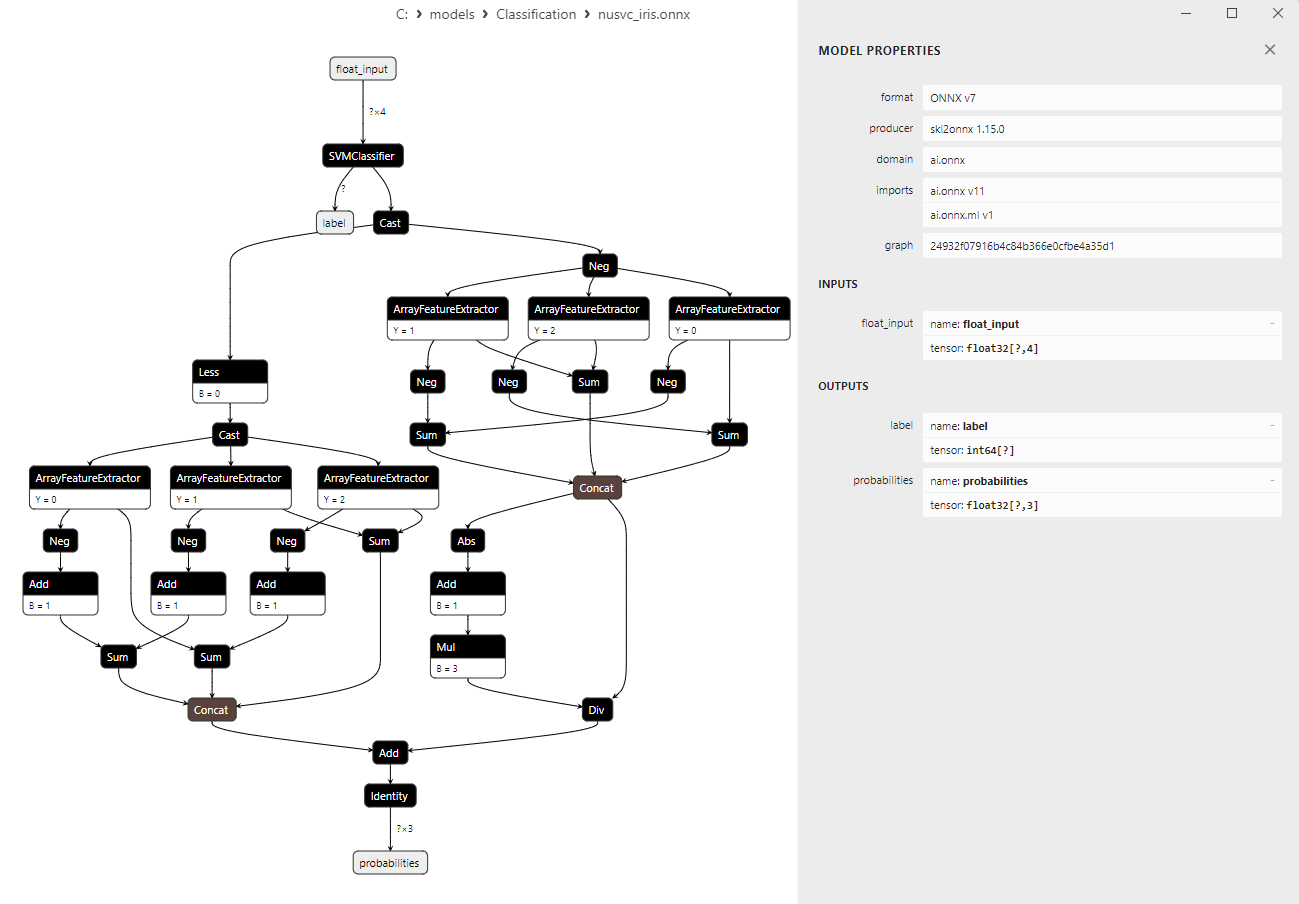

2.3.3. Representação ONNX do modelo NuSVC Classifier - 2.4. Radius Neighbors Classifier

2.4.1. Código de criação do modelo Radius Neighbors Classifier

2.4.2. Código no MQL5 para trabalhar com o modelo Radius Neighbors Classifier

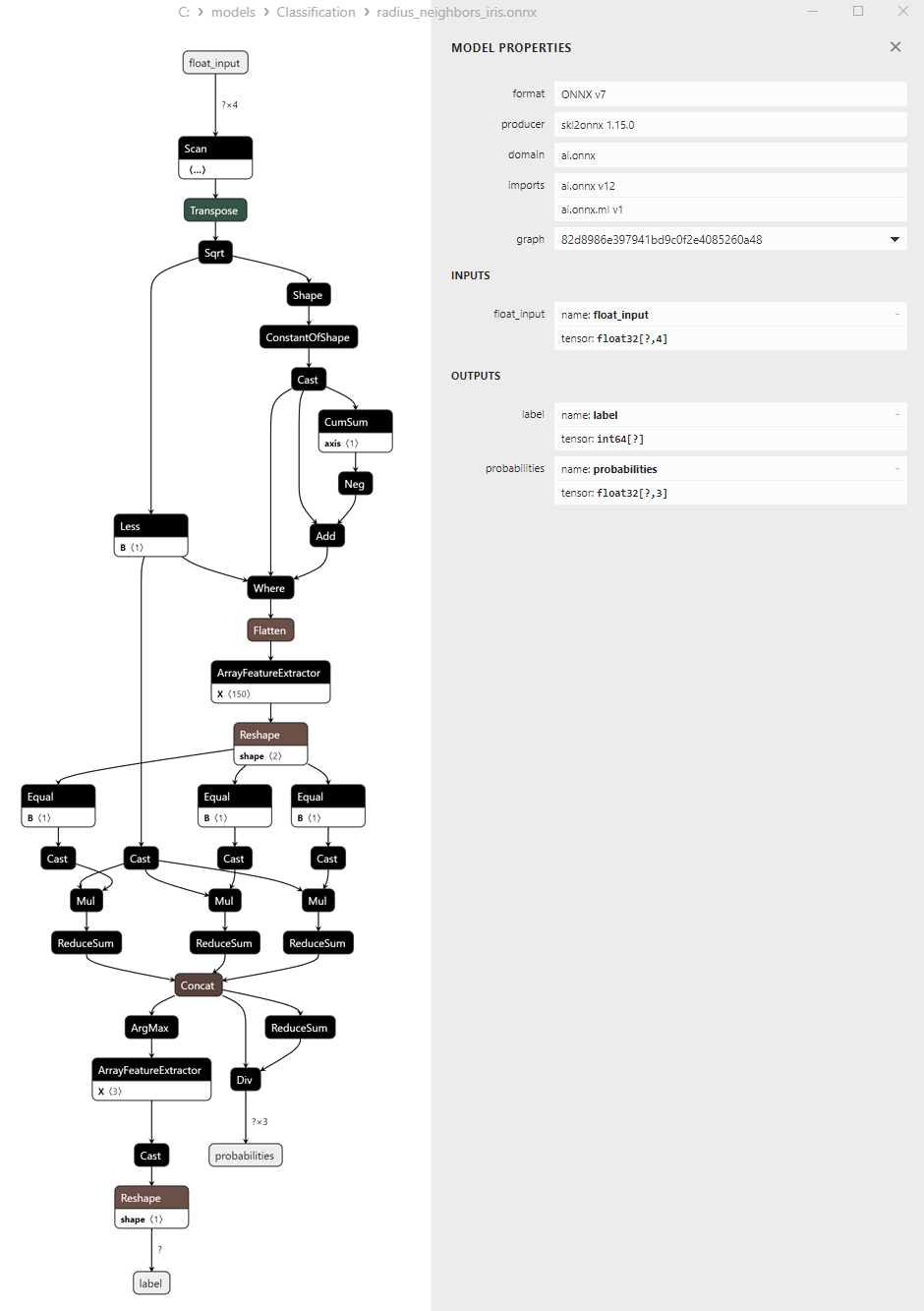

2.3.3. Representação ONNX do modelo NuSVC Classifier - 2.5. Ridge Classifier

2.5.1. Código de criação do modelo Ridge Classifier

2.5.2. Código no MQL5 para trabalhar com o modelo Ridge Classifier

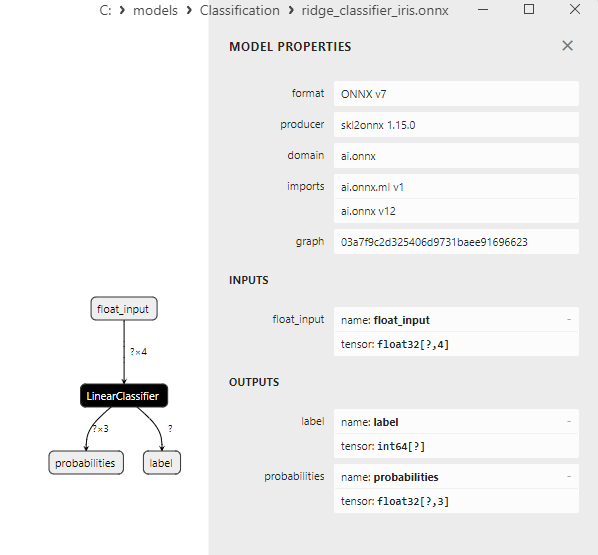

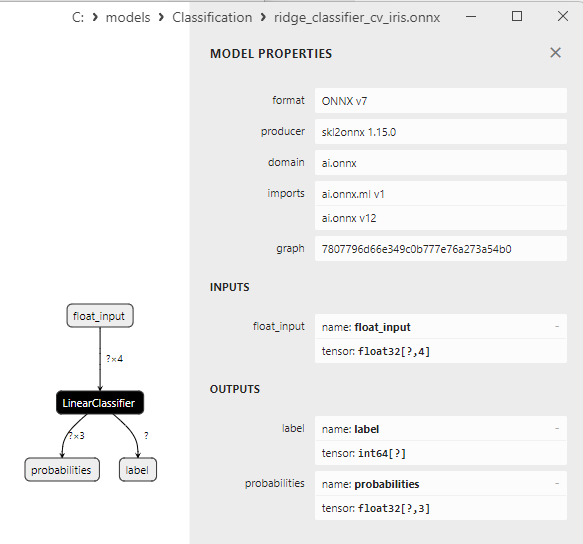

2.5.3. Representação ONNX do modelo Ridge Classifier - 2.6. RidgeClassifierCV

2.6.1. Código de criação do modelo RidgeClassifierCV

2.6.2. Código no MQL5 para trabalhar com o modelo RidgeClassifierCV

2.6.3. Representação ONNX do modelo RidgeClassifierCV - 2.7. Random Forest Classifier

2.7.1. Código de criação do modelo Random Forest Classifier

2.7.2. Código no MQL5 para trabalhar com o modelo Random Forest Classifier

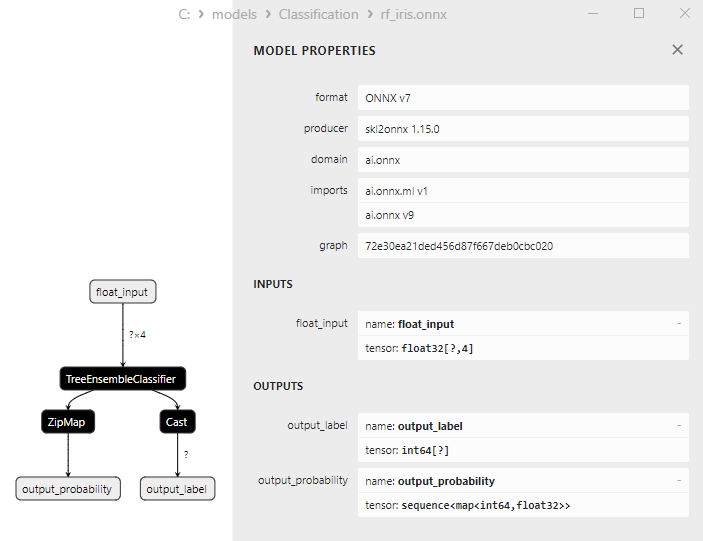

2.7.3. Representação ONNX do modelo Random Forest Classifier - 2.8. Gradient Boosting Classifier

2.8.1. Código de criação do modelo Gradient Boosting Classifier

2.8.2. Código no MQL5 para trabalhar com o modelo Gradient Boosting Classifier

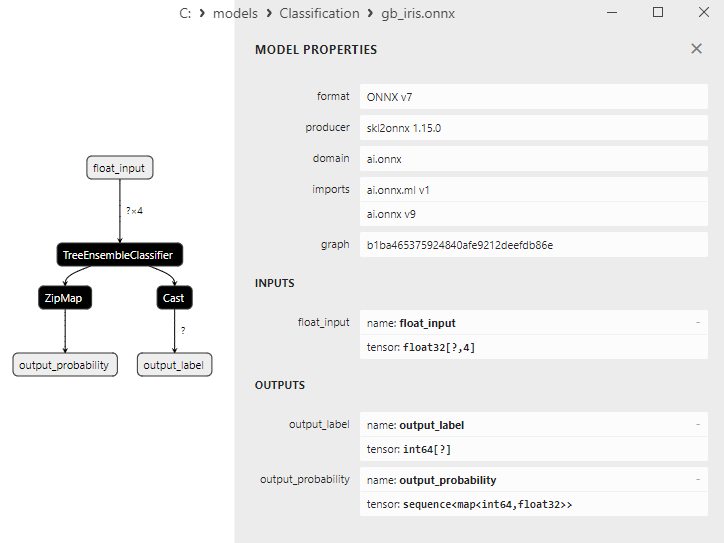

2.8.3. Representação ONNX do modelo Gradient Boosting Classifier - 2.9. Adaptive Boosting Classifier

2.9.1. Código de criação do modelo Adaptive Boosting Classifier

2.9.2. Código no MQL5 para trabalhar com o modelo Adaptive Boosting Classifier

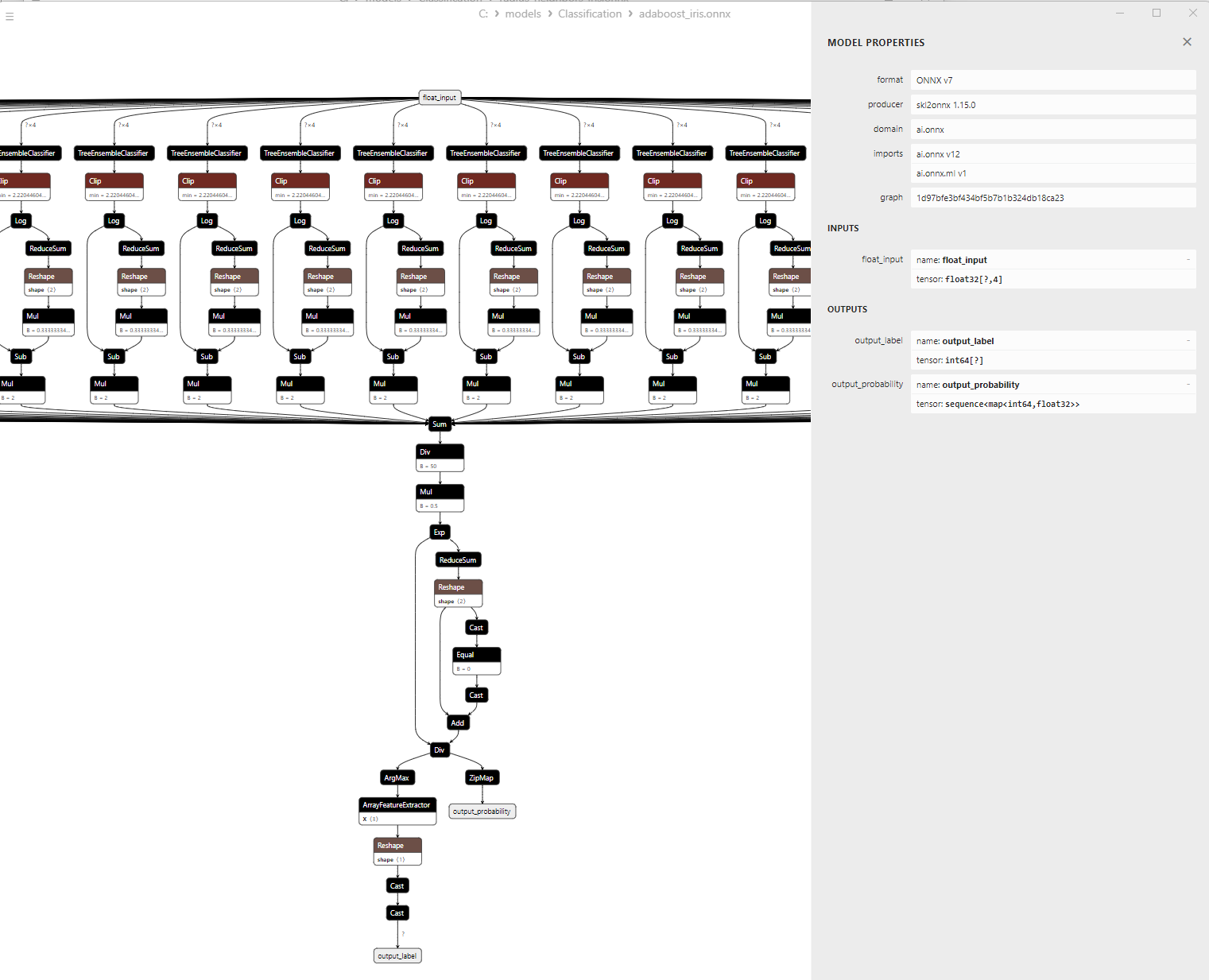

2.9.3. Representação ONNX do modelo Adaptive Boosting Classifier - 2.10. Bootstrap Aggregating Classifier

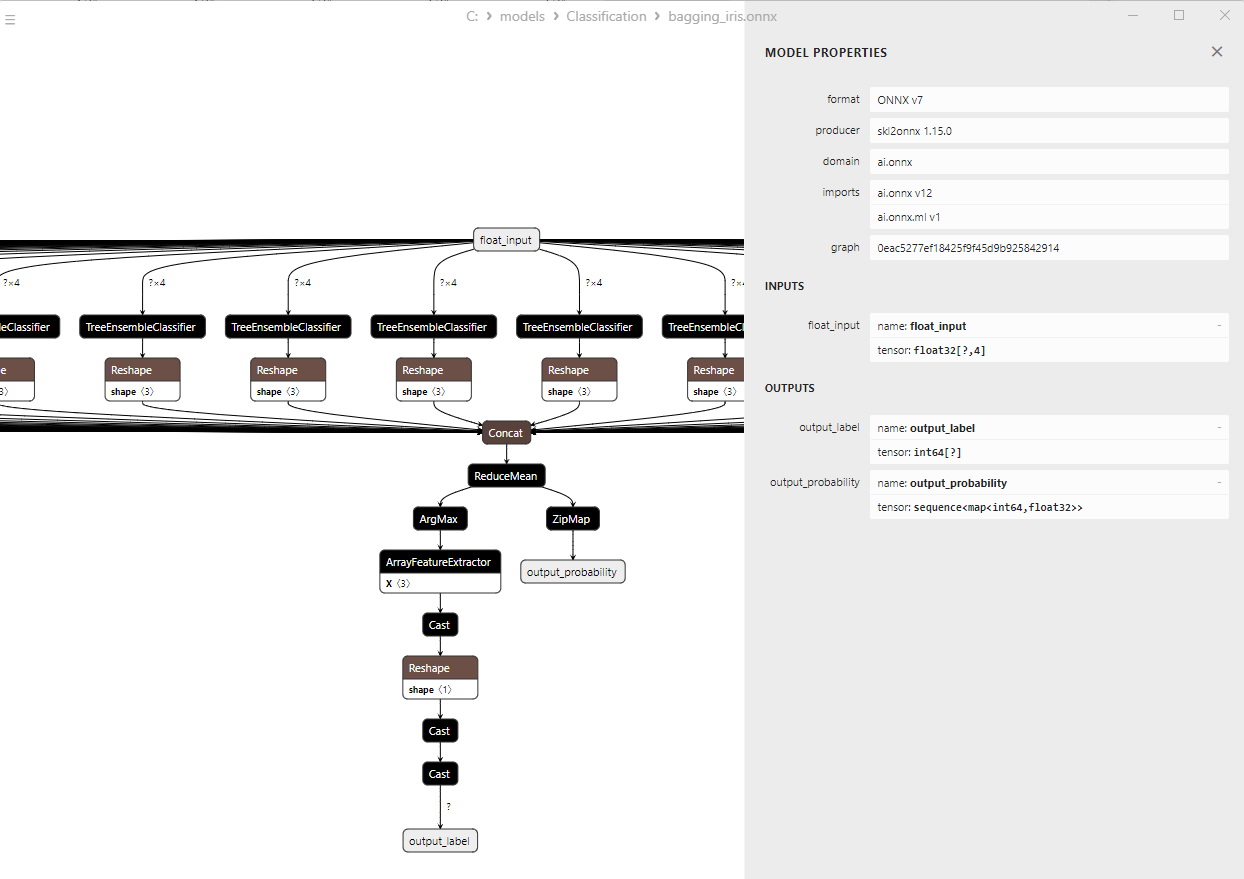

2.10.1. Código de criação do modelo Bootstrap Aggregating Classifier

2.10.2. Código no MQL5 para trabalhar com o modelo Bootstrap Aggregating Classifier

2.10.3. Representação ONNX do modelo Bootstrap Aggregating Classifier - 2.11. K-Nearest Neighbors (K-NN) Classifier

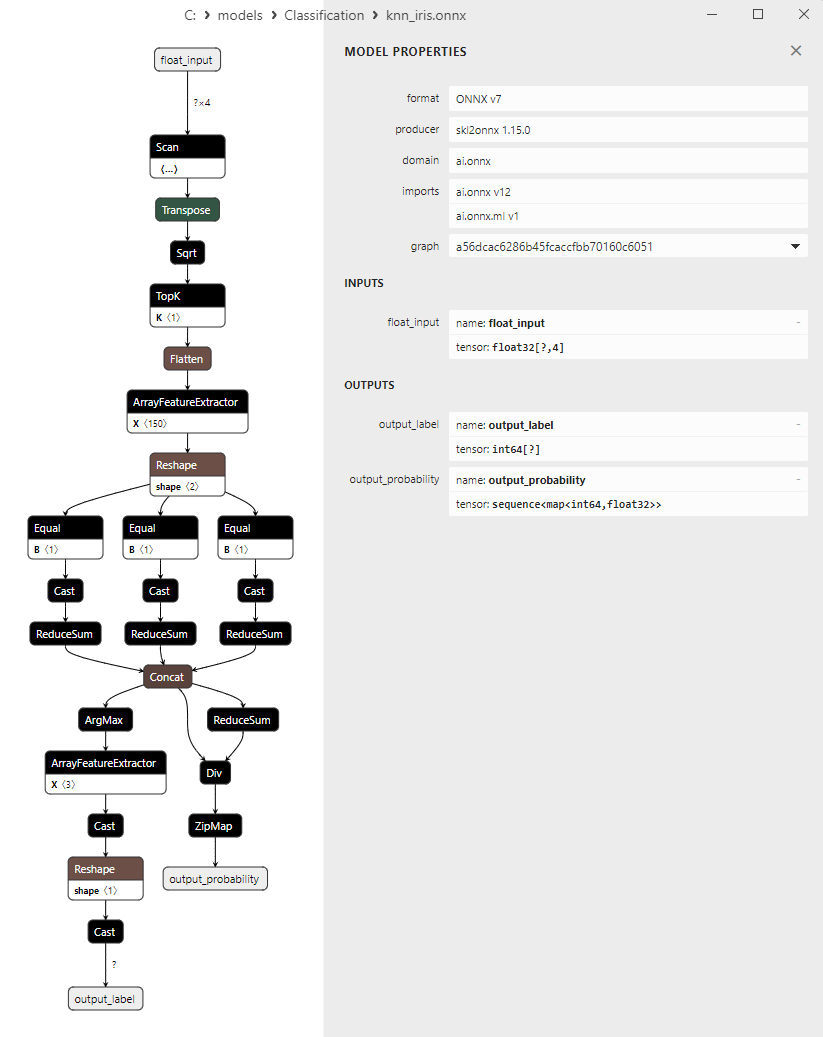

2.11.1. Código de criação do modelo K-Nearest Neighbors (K-NN) Classifier

2.11.2. Código no MQL5 para trabalhar com o modelo K-Nearest Neighbors (K-NN) Classifier

2.11.3. Representação ONNX do modelo K-Nearest Neighbors (K-NN) Classifier - 2.12. Decision Tree Classifier<

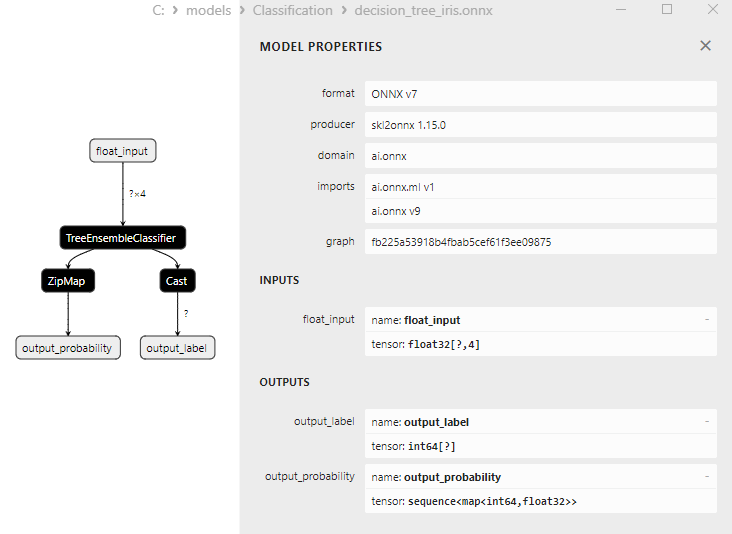

2.12.1. Código de criação do modelo Decision Tree Classifier

2.12.2. Código no MQL5 para trabalhar com o modelo Decision Tree Classifier

2.12.3. Representação ONNX do modelo Decision Tree Classifier - 2.13. Logistic Regression Classifier

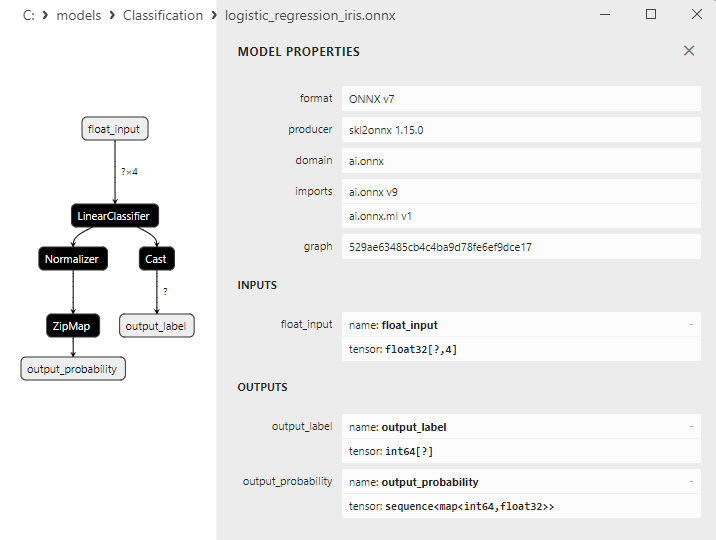

2.13.1. Código de criação do modelo Logistic Regression Classifier

2.13.2. Código no MQL5 para trabalhar com o modelo Logistic Regression Classifier

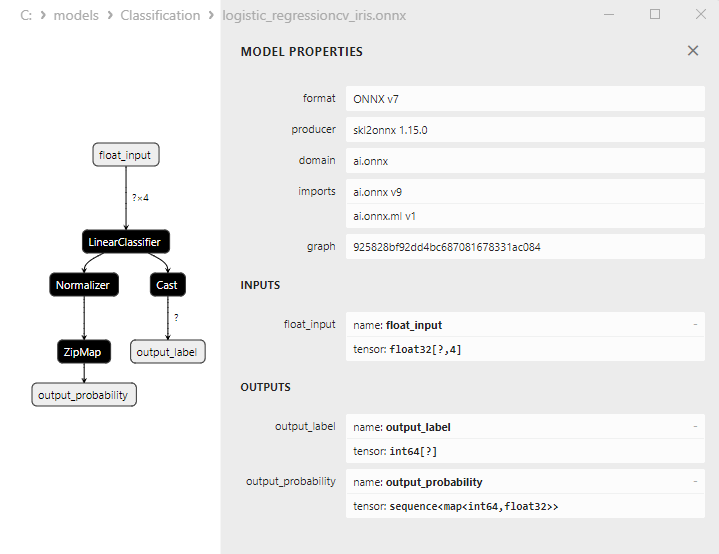

2.13.3. Representação ONNX do modelo Logistic Regression Classifier - 2.14. LogisticRegressionCV Classifier

2.14.1. Código de criação do modelo LogisticRegressionCV Classifier

2.14.2. Código no MQL5 para trabalhar com o modelo LogisticRegressionCV Classifier

2.14.3. Representação ONNX do modelo LogisticRegressionCV Classifier - 2.15. Passive-Aggressive (PA) Classifier

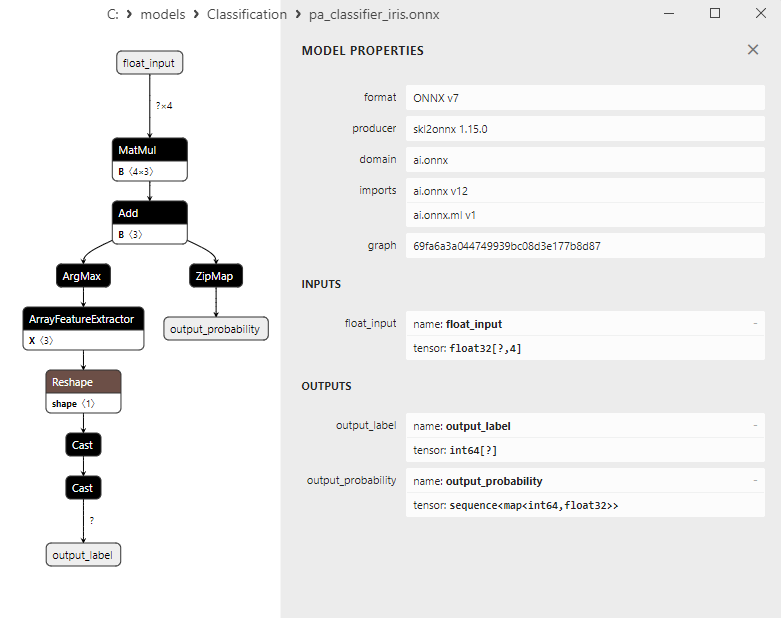

2.15.1. Código de criação do modelo Passive-Aggressive (PA) Classifier

2.15.2. Código no MQL5 para trabalhar com o modelo Passive-Aggressive (PA) Classifier

2.15.3. Representação ONNX do modelo Passive-Aggressive (PA) Classifier - 2.16. Perceptron Classifier

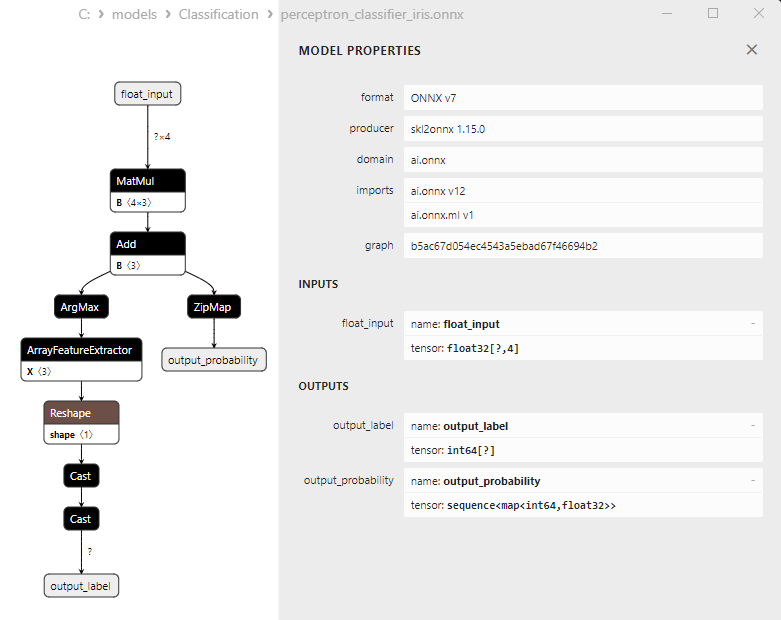

2.16.1. Código de criação do modelo perceptron Classifier

2.16.2. Código no MQL5 para trabalhar com o modelo perceptron Classifier

2.16.3. Representação ONNX do modelo perceptron Classifier - 2.17. Stochastic Gradient Descent Classifier

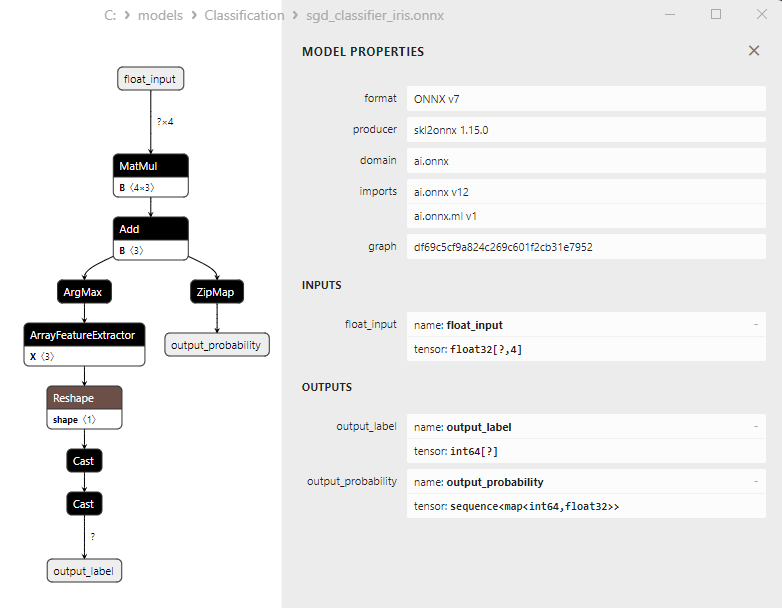

2.17.1. Código de criação do modelo Stochastic Gradient Descent Classifier

2.17.2. Código no MQL5 para trabalhar com o modelo Stochastic Gradient Descent Classifier

2.17.3. Representação ONNX do modelo Stochastic Gradient Descent Classifier - 2.18. Gaussian Naive Bayes (GNB) Classifier

2.18.1. Código de criação do modelo Gaussian Naive Bayes (GNB) Classifier

2.18.2. Código no MQL5 para trabalhar com o modelo Gaussian Naive Bayes (GNB) Classifier

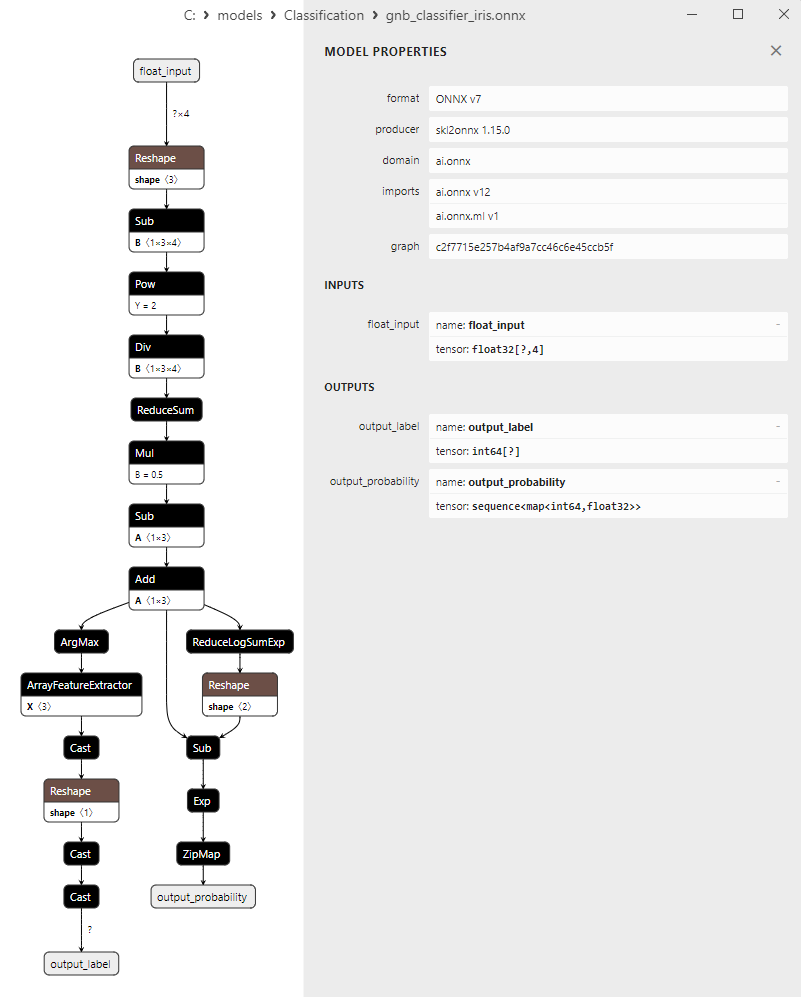

2.18.3. Representação ONNX do modelo Gaussian Naive Bayes (GNB) Classifier - 2.19. Multinomial Naive Bayes (MNB) Classifier

2.19.1. Código de criação do modelo Multinomial Naive Bayes (MNB) Classifier

2.19.2. Código no MQL5 para trabalhar com o modelo Multinomial Naive Bayes (MNB) Classifier

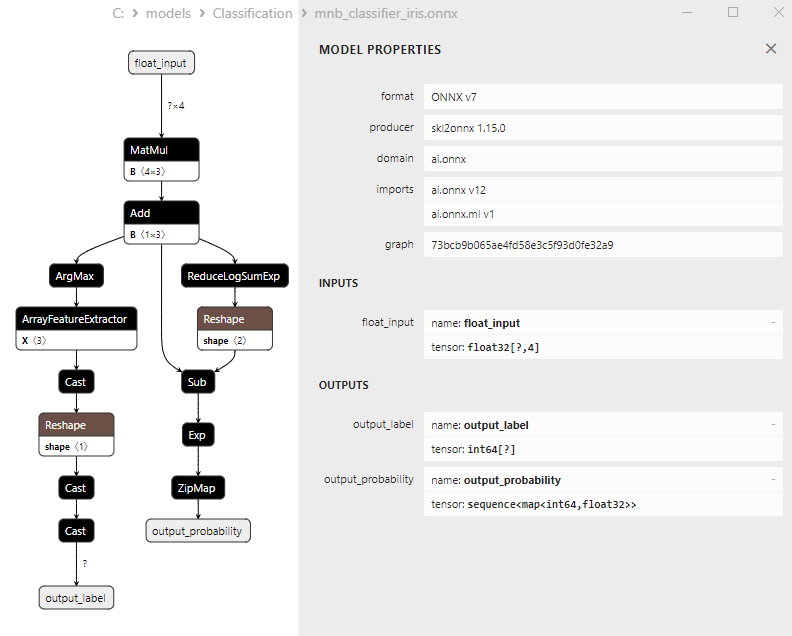

2.19.3. Representação ONNX do modelo Multinomial Naive Bayes (MNB) Classifier - 2.20. Complement Naive Bayes (CNB) Classifier

2.20.1. Código de criação do modelo Complement Naive Bayes (CNB) Classifier

2.20.2. Código no MQL5 para trabalhar com o modelo Complement Naive Bayes (CNB) Classifier

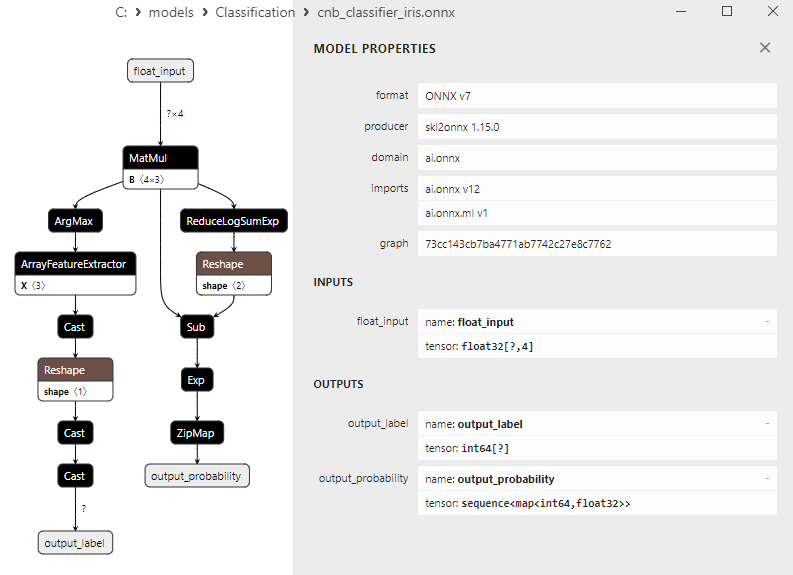

2.20.3. Representação ONNX do modelo Complement Naive Bayes (CNB) Classifier - 2.21. Bernoulli Naive Bayes (BNB) Classifier

2.21.1. Código de criação do modelo Bernoulli Naive Bayes (BNB) Classifier

2.21.2. Código no MQL5 para trabalhar com o modelo Bernoulli Naive Bayes (BNB) Classifier

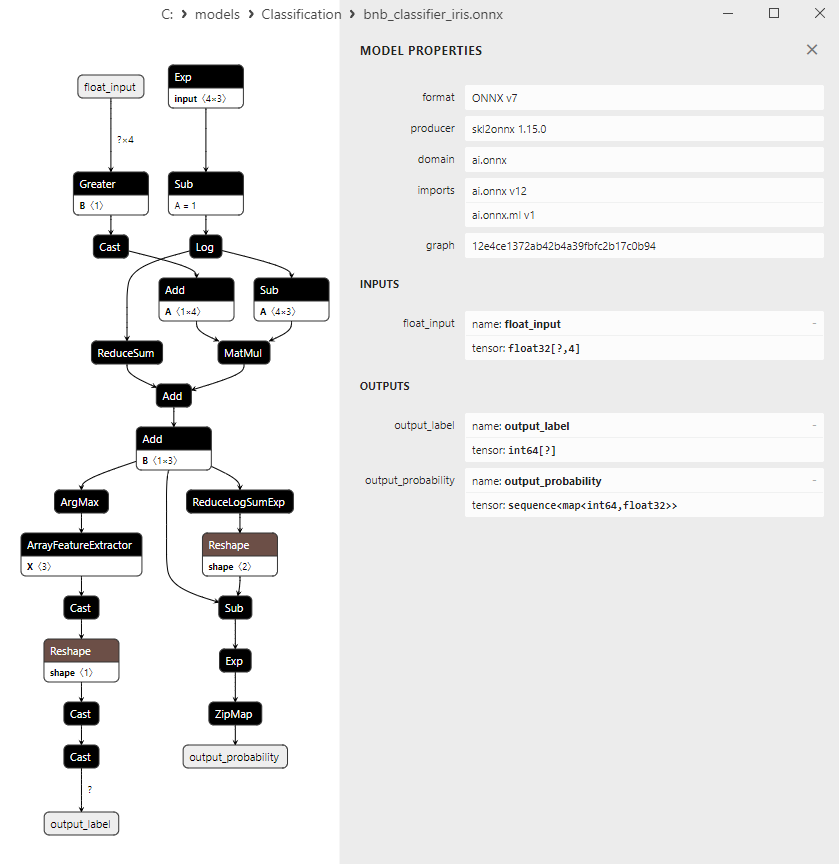

2.21.3. Representação ONNX do modelo Bernoulli Naive Bayes (BNB) Classifier - 2.22. Multilayer perceptron Classifier

2.22.1. Código de criação do modelo Multilayer perceptron Classifier

2.22.2. Código no MQL5 para trabalhar com o modelo Multilayer perceptron Classifier

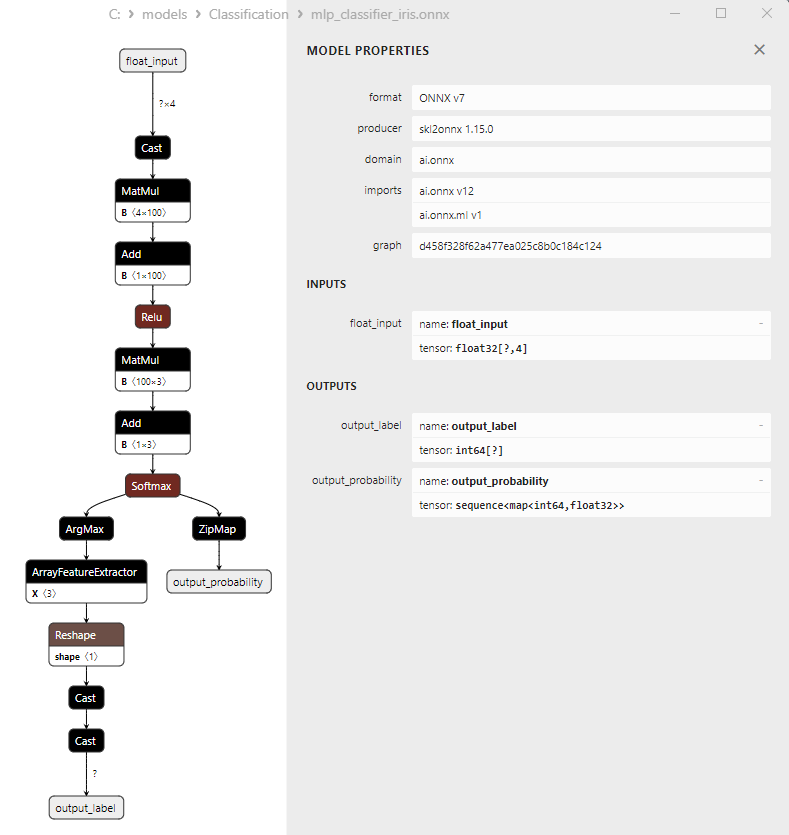

2.22.3. Representação ONNX do modelo Multilayer perceptron Classifier - 2.23. Linear Discriminant Analysis (LDA) Classifier

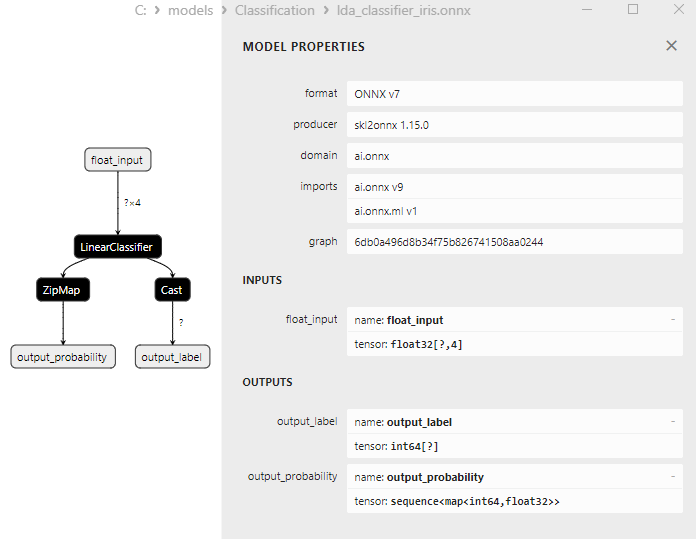

2.23.1. Código de criação do modelo Linear Discriminant Analysis (LDA) Classifier

2.23.2. Código no MQL5 para trabalhar com o modelo Linear Discriminant Analysis (LDA) Classifier

2.23.3. Representação ONNX do modelo Linear Discriminant Analysis (LDA) Classifier - 2.24. Hist Gradient Boosting

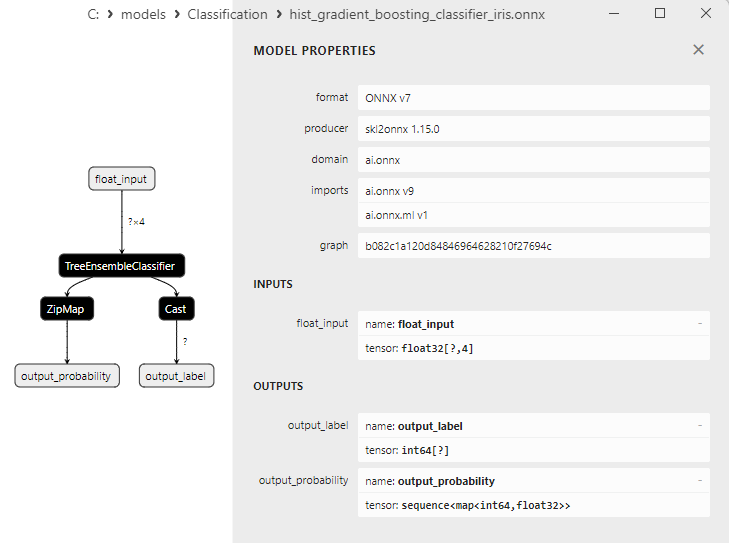

2.24.1. Código de criação do modelo Histogram-Based Gradient Boosting Classifier

2.24.2. Código no MQL5 para trabalhar com o modelo Histogram-Based Gradient Boosting Classifier

2.24.3. Representação ONNX do modelo Histogram-Based Gradient Boosting Classifier - 2.25. CategoricalNB Classifier

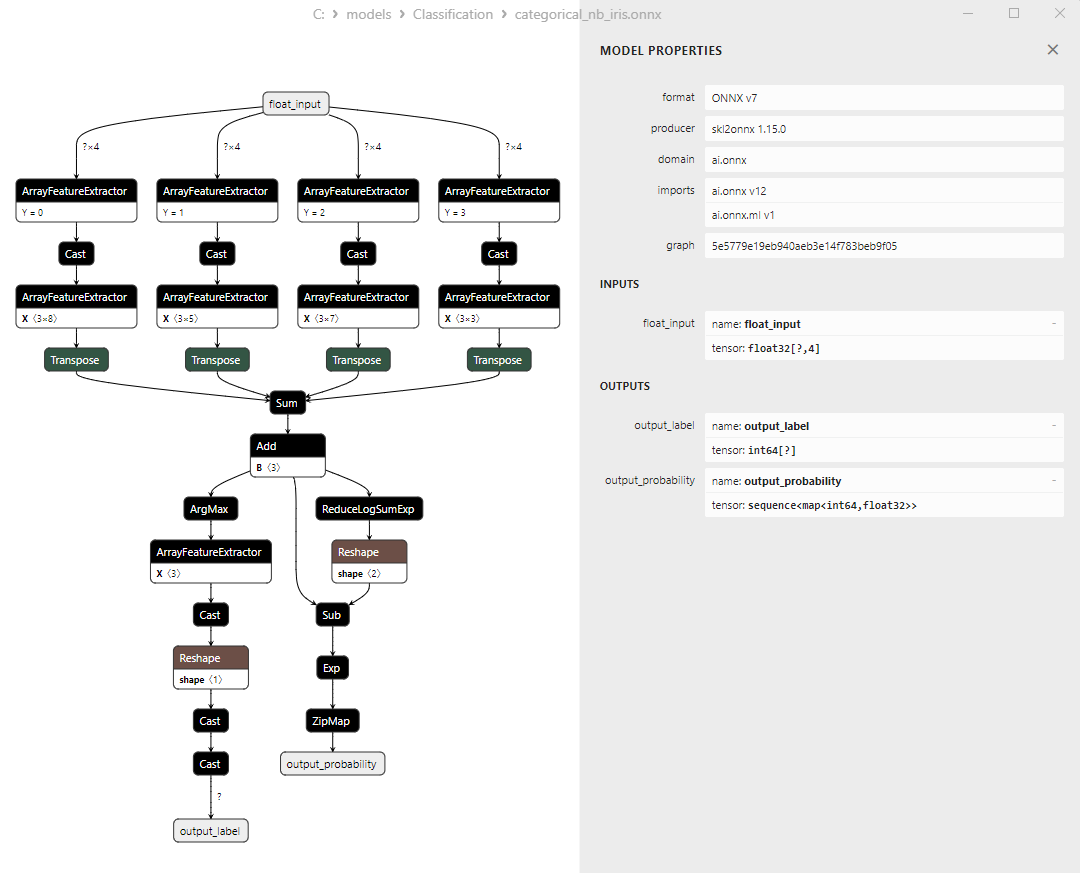

2.25.1. Código de criação do modelo CategoricalNB Classifier

2.23.2. Código no MQL5 para trabalhar com o modelo CategoricalNB Classifier

2.23.3. Representação ONNX do modelo CategoricalNB Classifier - 2.26. ExtraTreeClassifier

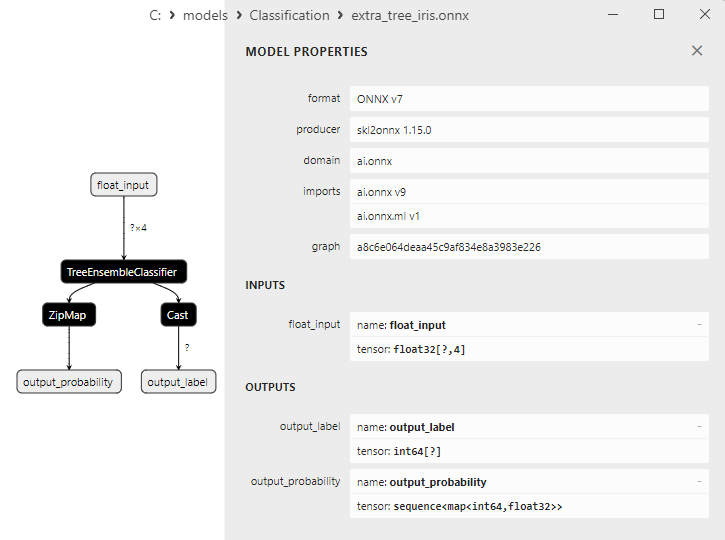

2.26.1. Código de criação do modelo ExtraTreeClassifier

2.26.2. Código no MQL5 para trabalhar com o modelo ExtraTreeClassifier

2.26.3. Representação ONNX do modelo ExtraTreeClassifier - 2.27. ExtraTreesClassifier

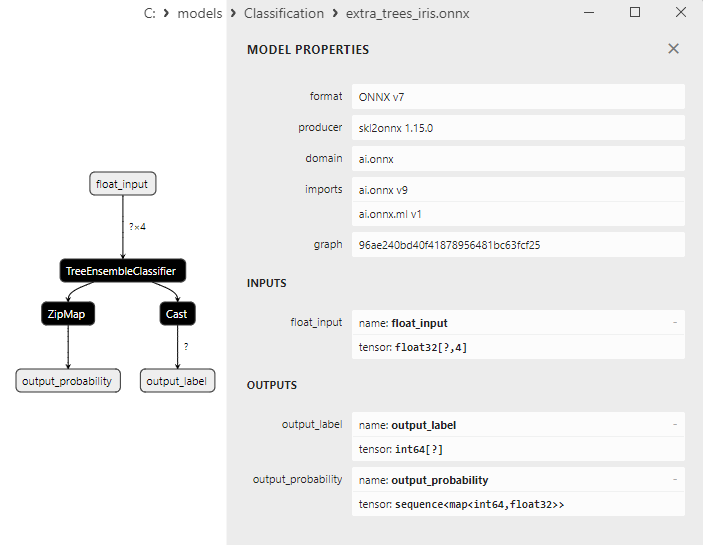

2.27.1. Código de criação do modelo ExtraTreesClassifier

2.27.2. Código no MQL5 para trabalhar com o modelo ExtraTreesClassifier

2.27.3. Representação ONNX do modelo ExtraTreesClassifier - 2.28. Comparação da precisão de todos os modelos

2.28.1. Código para calcular todos os modelos e construir o diagrama de comparação de precisão

2.28.2. Código no MQL5 para a execução de todos os modelos ONNX - 2.29. Modelos de classificação do Scikit-Learn que não puderam ser convertidos para ONNX

- 2.29.1. DummyClassifier

2.29.1.1. Código de criação do modelo DummyClassifier - 2.29.2. GaussianProcessClassifier

2.29.2.1. Código de criação do modelo GaussianProcessClassifier - 2.29.3. LabelPropagation Classifier

2.29.3.1. Código de criação do modelo LabelPropagationClassifier - 2.29.4. LabelSpreading Classifier

2.29.4.1. Código de criação do modelo LabelSpreadingClassifier - 2.29.5. NearestCentroid Classifier

2.29.5.1. Código de criação do modelo NearestCentroid - 2.29.6. Quadratic Discriminant Analysis Classifier

2.29.6.1.Código de criação do modelo Quadratic Discriminant Analysis - Considerações finais

1. Íris de Fisher

O conjunto de dados Iris é um dos conjuntos de dados mais famosos e amplamente usados no mundo do aprendizado de máquina. Foi apresentado pela primeira vez em 1936 pelo estatístico e biólogo R.A. Fisher e desde então se tornou um conjunto de dados clássico para tarefas de classificação.

O conjunto de dados Iris consiste em medições das sépalas e pétalas de três espécies de íris: Iris setosa, Iris virginica e Iris versicolor.

Fig.1. Iris setosa

Fig.2. Iris virginica

Fig.3. Iris versicolor

O conjunto de dados Iris consiste em 150 instâncias de íris, com 50 instâncias de cada uma das três espécies. Cada instância tem quatro características numéricas (em centímetros):

- Comprimento da sépala (sepal length)

- Largura da sépala (sepal width)

- Comprimento da pétala (petal length)

- Largura da pétala (petal width)

Cada instância também tem uma classe que indica a espécie de íris (Iris setosa, Iris virginica ou Iris versicolor). Este atributo de classificação torna o conjunto de dados Iris ideal para tarefas de aprendizado de máquina, como classificação e agrupamento.

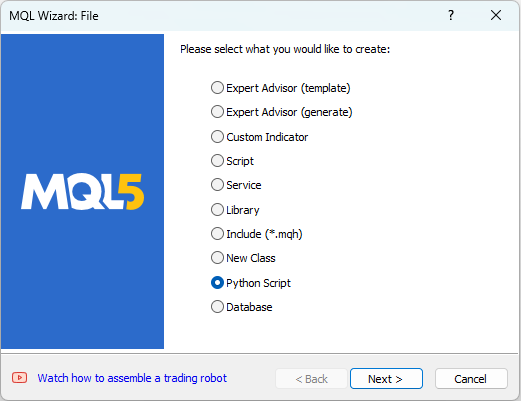

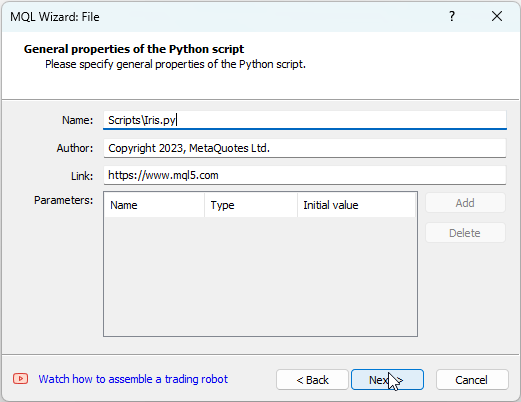

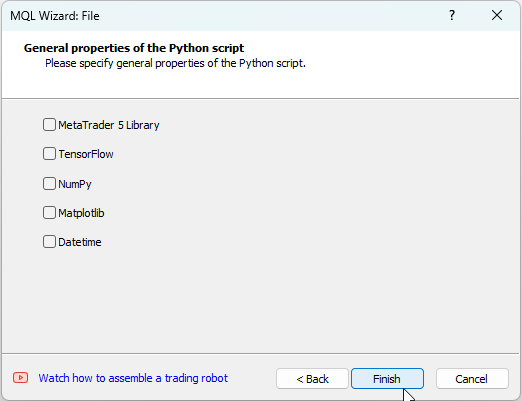

O MetaEditor permite trabalhar com scripts em Python. Para criar um script Python, é necessário selecionar "Novo" no menu "Arquivo" do MetaEditor. Aparece a janela de diálogo para selecionar o objeto a ser criado (Fig. 4).

Fig.4. Criando um script Python no Assistente MQL5 - Etapa 1

Em seguida, é necessário nomear o script, por exemplo, IRIS.py

Fig.5. Criando um script Python no Assistente MQL5 - Etapa 2 - Nome do script

Após isso, pode-se indicar quais bibliotecas serão utilizadas, no nosso caso deixaremos esses campos em branco.

Fig.6. Criando um script Python no Assistente MQL5 - Etapa 3

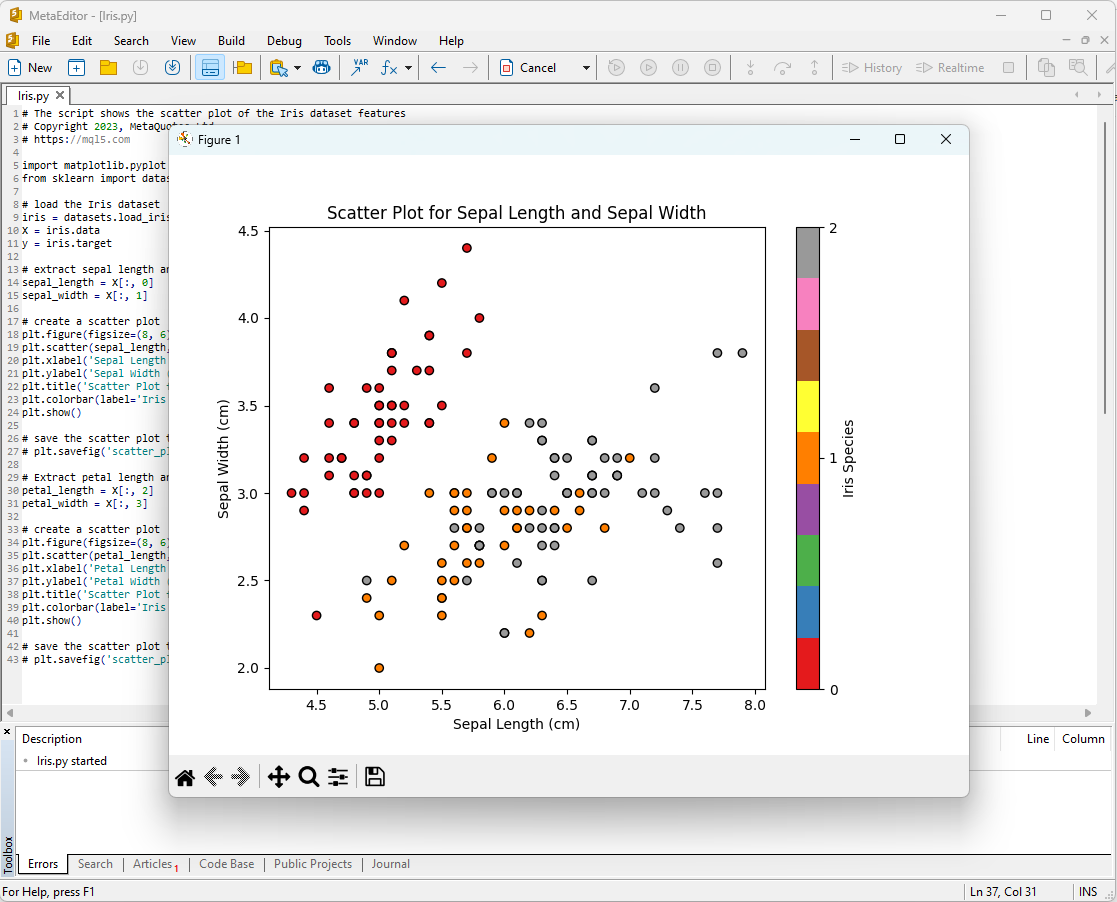

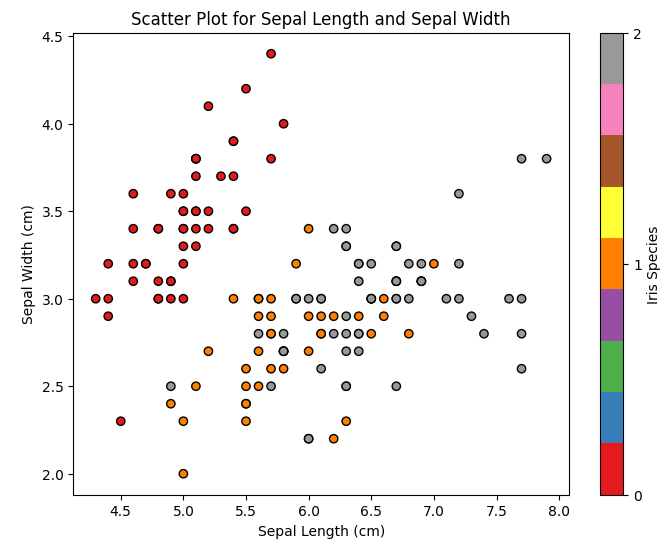

Uma das maneiras de começar a análise do Iris dataset é visualizar os dados. A representação gráfica nos permite entender melhor a estrutura dos dados e as relações entre as características.

Por exemplo, pode-se criar um gráfico de dispersão (scatter plot) para ver como as diferentes espécies de íris estão distribuídas no espaço de características.

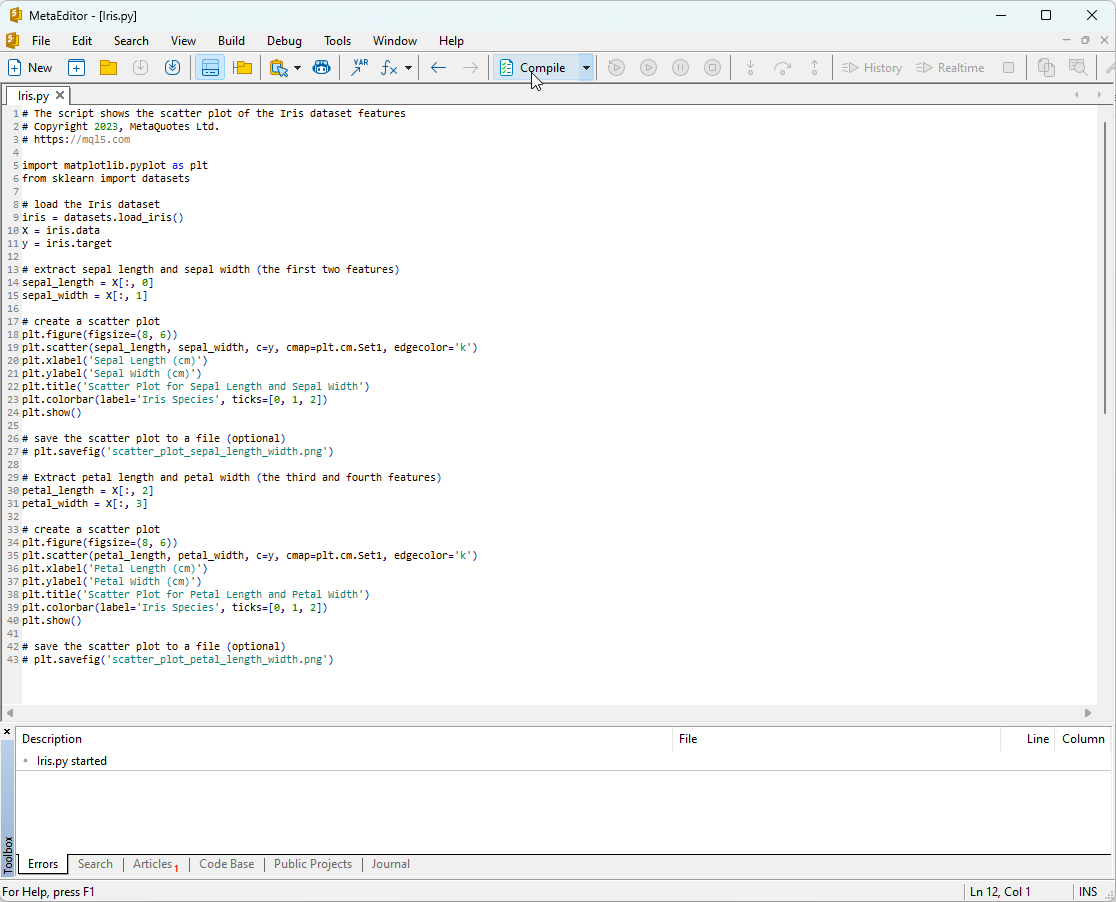

Código do script Python:

# The script shows the scatter plot of the Iris dataset features # Copyright 2023, MetaQuotes Ltd. # https://mql5.com import matplotlib.pyplot as plt from sklearn import datasets # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # extract sepal length and sepal width (the first two features) sepal_length = X[:, 0] sepal_width = X[:, 1] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(sepal_length, sepal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Sepal Length (cm)') plt.ylabel('Sepal Width (cm)') plt.title('Scatter Plot for Sepal Length and Sepal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_sepal_length_width.png') # Extract petal length and petal width (the third and fourth features) petal_length = X[:, 2] petal_width = X[:, 3] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(petal_length, petal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Petal Length (cm)') plt.ylabel('Petal Width (cm)') plt.title('Scatter Plot for Petal Length and Petal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_petal_length_width.png')

Para executar este script, é necessário copiá-lo no MetaEditor (Fig.7) e pressionar "Compilar".

Fig.7. Script IRIS.py no MetaEditor

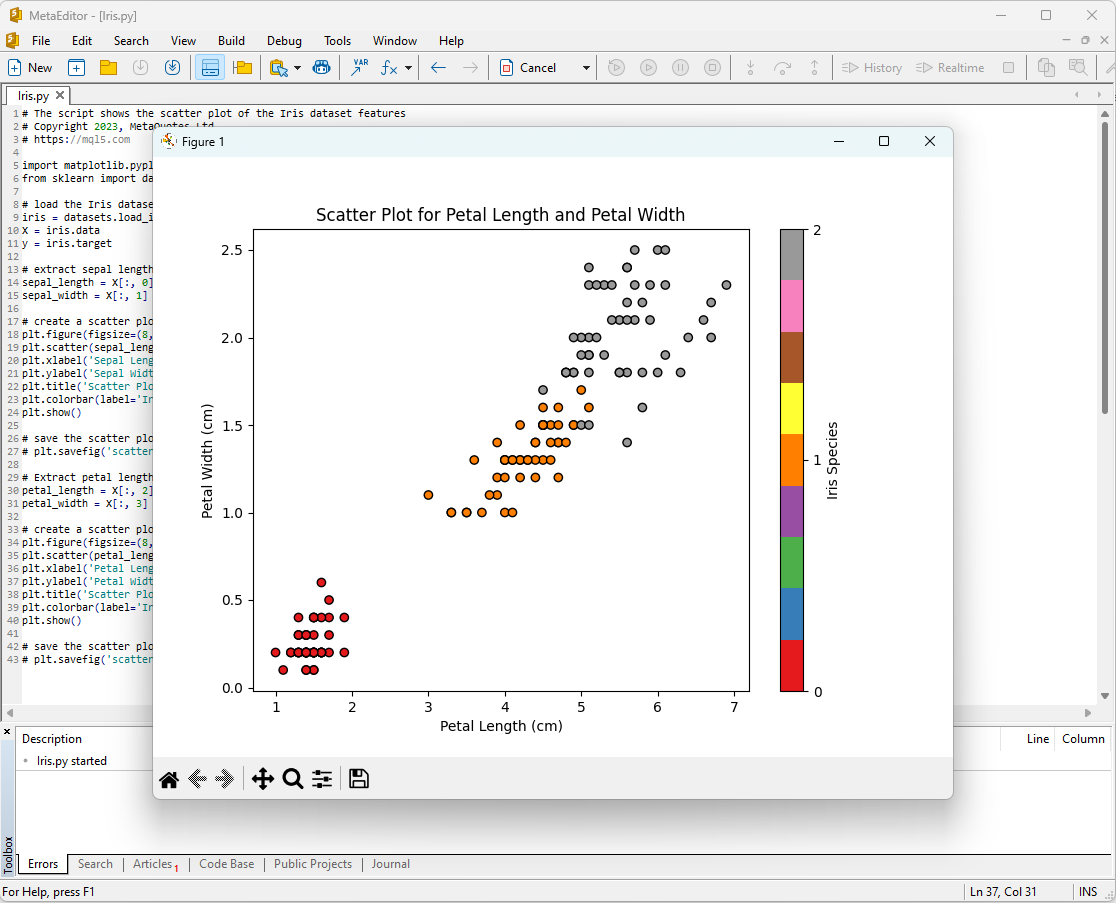

Depois disso, os gráficos serão exibidos na tela:

Fig.8. Script IRIS.py no MetaEditor com o gráfico Sepal Length/Sepal Width

Fig.9. Script IRIS.py no MetaEditor com o gráfico Petal Length/Petal Width

Vamos examiná-los em detalhes.

Fig. 10. Diagrama de dispersão para o comprimento e largura da sépala (Scatter Plot Sepal Length vs Sepal Width)

Neste diagrama, vemos como as diferentes espécies de íris estão distribuídas pelo comprimento e largura da sépala. Podemos ver que o Iris setosa geralmente tem sépalas mais curtas e largas do que as outras duas espécies.

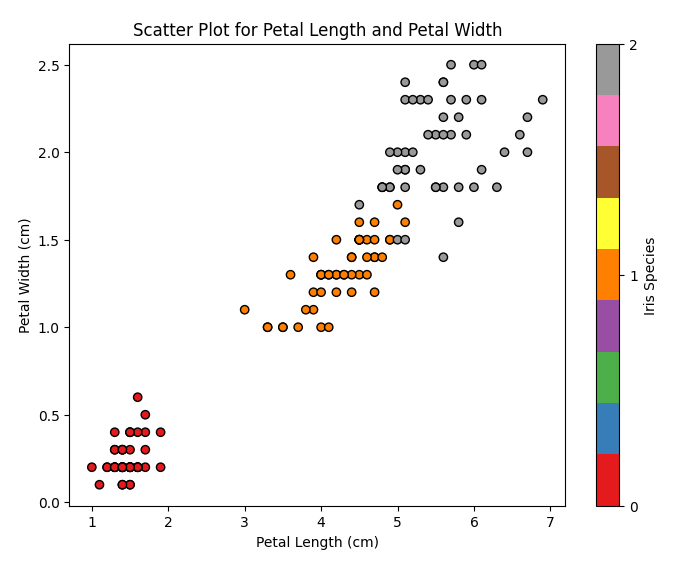

Fig.11. Diagrama de dispersão para o comprimento e largura da pétala (Scatter Plot Petal Length vs Petal Width)

Neste diagrama, vemos como as diferentes espécies de íris estão distribuídas pelo comprimento e largura da pétala. Podemos notar que o Iris setosa tem as pétalas mais curtas e estreitas, o Iris virginica tem as pétalas mais longas e largas, e o Iris versicolor está entre eles.

O Iris dataset é um conjunto de dados ideal para treinamento e teste de modelos de aprendizado de máquina. Vamos usá-lo para analisar o desempenho dos modelos de aprendizado de máquina para a tarefa de classificação.

2. Modelos para classificação

A tarefa de classificação é uma das principais tarefas do aprendizado de máquina, e seu objetivo é dividir os dados em diferentes categorias ou classes com base em algumas características.

Vamos considerar os principais modelos de aprendizado de máquina do pacote scikit-learn.

Lista de classificadores do pacote Scikit-learn

Para exibir a lista de classificadores disponíveis do Scikit-learn, pode-se usar o script:

# ScikitLearnClassifiers.py # The script lists all the classification algorithms available in scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn classifiers from sklearn.utils import all_estimators classifiers = all_estimators(type_filter='classifier') for index, (name, ClassifierClass) in enumerate(classifiers, start=1): print(f"Classifier {index}: {name}")

Resultado:

Python The scikit-learn version is 1.2.2.

Python Classifier 1: AdaBoostClassifier

Python Classifier 2: BaggingClassifier

Python Classifier 3: BernoulliNB

Python Classifier 4: CalibratedClassifierCV

Python Classifier 5: CategoricalNB

Python Classifier 6: ClassifierChain

Python Classifier 7: ComplementNB

Python Classifier 8: DecisionTreeClassifier

Python Classifier 9: DummyClassifier

Python Classifier 10: ExtraTreeClassifier

Python Classifier 11: ExtraTreesClassifier

Python Classifier 12: GaussianNB

Python Classifier 13: GaussianProcessClassifier

Python Classifier 14: GradientBoostingClassifier

Python Classifier 15: HistGradientBoostingClassifier

Python Classifier 16: KNeighborsClassifier

Python Classifier 17: LabelPropagation

Python Classifier 18: LabelSpreading

Python Classifier 19: LinearDiscriminantAnalysis

Python Classifier 20: LinearSVC

Python Classifier 21: LogisticRegression

Python Classifier 22: LogisticRegressionCV

Python Classifier 23: MLPClassifier

Python Classifier 24: MultiOutputClassifier

Python Classifier 25: MultinomialNB

Python Classifier 26: NearestCentroid

Python Classifier 27: NuSVC

Python Classifier 28: OneVsOneClassifier

Python Classifier 29: OneVsRestClassifier

Python Classifier 30: OutputCodeClassifier

Python Classifier 31: PassiveAggressiveClassifier

Python Classifier 32: Perceptron

Python Classifier 33: QuadraticDiscriminantAnalysis

Python Classifier 34: RadiusNeighborsClassifier

Python Classifier 35: RandomForestClassifier

Python Classifier 36: RidgeClassifier

Python Classifier 37: RidgeClassifierCV

Python Classifier 38: SGDClassifier

Python Classifier 39: SVC

Python Classifier 40: StackingClassifier

Python Classifier 41: VotingClassifier

Por praticidade, nesta lista de classificadores, eles são destacados em diferentes cores. Modelos que requerem classificadores base são destacados em amarelo, enquanto os demais modelos podem ser usados independentemente.

Adiantando-nos, notamos que os modelos marcados em verde são os que foram exportados com sucesso para o formato ONNX, enquanto os modelos marcados em vermelho são aqueles que, na versão atual do scikit-learn 1.2.2, apresentam erros ao serem convertidos.

Diferentes representações de dados de saída existentes nos modelos

Deve-se notar que diferentes modelos representam as informações de saída de maneiras variadas, portanto, ao trabalhar com modelos convertidos para ONNX, é preciso ter cuidado.

Para a tarefa de classificação dos íris de Fisher, os tensores de entrada têm a mesma forma para todos esses modelos:

1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Os tensores de saída dos modelos ONNX variam.

1. Modelos que não requerem pós-processamento

- SVC Classifier;

- LinearSVC Classifier;

- NuSVC Classifier;

- Radius Neighbors Classifier;

- Ridge Classifier;

- Ridge Classifier CV.

1. Name: label, Data Type: tensor(int64), Shape: [None]

2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Eles retornam o resultado (número da classe) de forma explícita no primeiro tensor de saída inteiro label tensor(int64), não requerendo pós-processamento.

2. Modelos cujos resultados requerem pós-processamento:

- Random Forest Classifier;

- Gradient Boosting Classifier;

- AdaBoost Classifier;

- Bagging Classifier;

- K-NN_Classifier;

- Decision Tree Classifier;

- Logistic Regression Classifier;

- Logistic Regression CV Classifier;

- Passive-Aggressive Classifier;

- Perceptron Classifier;

- SGD Classifier;

- Gaussian Naive Bayes Classifier;

- Multinomial Naive Bayes Classifier;

- Complement Naive Bayes Classifier;

- Bernoulli Naive Bayes Classifier;

- Multilayer perceptron Classifier;

- Linear Discriminant Analysis Classifier;

- Hist Gradient Boosting Classifier;

- Categorical Naive Bayes Classifier;

- ExtraTree Classifier;

- ExtraTrees Classifier.

1. Name: output_label, Data Type: tensor(int64), Shape: [None]

2. Name: output_probability, Data Type: seq(map(int64,tensor(float))), Shape: []

Na saída, retornam uma lista de classes e as probabilidades de pertencer a cada classe.

Para obter o resultado nestes casos, é necessário um pós-processamento do tipo seq(map(int64,tensor(float) (encontrando o elemento com a maior probabilidade).

Bem, é preciso ter cuidado e considerar esses pontos ao trabalhar com modelos ONNX. Um exemplo de tratamento diferenciado dos resultados é apresentado no script em 2.28.2.1.

iris.mqh

Para testar os modelos no conjunto completo de dados iris no MQL5, será necessário formar os dados do conjunto, para isso será usada a função PrepareIrisDataset().

É conveniente separar essas funções no arquivo iris.mqh

//+------------------------------------------------------------------+ //| Iris.mqh | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" //+------------------------------------------------------------------+ //| Structure for the IRIS Dataset sample | //+------------------------------------------------------------------+ struct sIRISsample { int sample_id; // sample id (1-150) double features[4]; // SepalLengthCm,SepalWidthCm,PetalLengthCm,PetalWidthCm string class_name; // class ("Iris-setosa","Iris-versicolor","Iris-virginica") int class_id; // class id (0,1,2), calculated by function IRISClassID }; //--- Iris dataset sIRISsample ExtIRISDataset[]; int Exttotal=0; //+------------------------------------------------------------------+ //| Returns class id by class name | //+------------------------------------------------------------------+ int IRISClassID(string class_name) { //--- if(class_name=="Iris-setosa") return(0); else if(class_name=="Iris-versicolor") return(1); else if(class_name=="Iris-virginica") return(2); //--- return(-1); } //+------------------------------------------------------------------+ //| AddSample | //+------------------------------------------------------------------+ bool AddSample(const int Id,const double SepalLengthCm,const double SepalWidthCm,const double PetalLengthCm,const double PetalWidthCm, const string Species) { //--- ExtIRISDataset[Exttotal].sample_id=Id; //--- ExtIRISDataset[Exttotal].features[0]=SepalLengthCm; ExtIRISDataset[Exttotal].features[1]=SepalWidthCm; ExtIRISDataset[Exttotal].features[2]=PetalLengthCm; ExtIRISDataset[Exttotal].features[3]=PetalWidthCm; //--- ExtIRISDataset[Exttotal].class_name=Species; ExtIRISDataset[Exttotal].class_id=IRISClassID(Species); //--- Exttotal++; //--- return(true); } //+------------------------------------------------------------------+ //| Prepare Iris Dataset | //+------------------------------------------------------------------+ bool PrepareIrisDataset(sIRISsample &iris_samples[]) { ArrayResize(ExtIRISDataset,150); Exttotal=0; //--- AddSample(1,5.1,3.5,1.4,0.2,"Iris-setosa"); AddSample(2,4.9,3.0,1.4,0.2,"Iris-setosa"); AddSample(3,4.7,3.2,1.3,0.2,"Iris-setosa"); AddSample(4,4.6,3.1,1.5,0.2,"Iris-setosa"); AddSample(5,5.0,3.6,1.4,0.2,"Iris-setosa"); AddSample(6,5.4,3.9,1.7,0.4,"Iris-setosa"); AddSample(7,4.6,3.4,1.4,0.3,"Iris-setosa"); AddSample(8,5.0,3.4,1.5,0.2,"Iris-setosa"); AddSample(9,4.4,2.9,1.4,0.2,"Iris-setosa"); AddSample(10,4.9,3.1,1.5,0.1,"Iris-setosa"); AddSample(11,5.4,3.7,1.5,0.2,"Iris-setosa"); AddSample(12,4.8,3.4,1.6,0.2,"Iris-setosa"); AddSample(13,4.8,3.0,1.4,0.1,"Iris-setosa"); AddSample(14,4.3,3.0,1.1,0.1,"Iris-setosa"); AddSample(15,5.8,4.0,1.2,0.2,"Iris-setosa"); AddSample(16,5.7,4.4,1.5,0.4,"Iris-setosa"); AddSample(17,5.4,3.9,1.3,0.4,"Iris-setosa"); AddSample(18,5.1,3.5,1.4,0.3,"Iris-setosa"); AddSample(19,5.7,3.8,1.7,0.3,"Iris-setosa"); AddSample(20,5.1,3.8,1.5,0.3,"Iris-setosa"); AddSample(21,5.4,3.4,1.7,0.2,"Iris-setosa"); AddSample(22,5.1,3.7,1.5,0.4,"Iris-setosa"); AddSample(23,4.6,3.6,1.0,0.2,"Iris-setosa"); AddSample(24,5.1,3.3,1.7,0.5,"Iris-setosa"); AddSample(25,4.8,3.4,1.9,0.2,"Iris-setosa"); AddSample(26,5.0,3.0,1.6,0.2,"Iris-setosa"); AddSample(27,5.0,3.4,1.6,0.4,"Iris-setosa"); AddSample(28,5.2,3.5,1.5,0.2,"Iris-setosa"); AddSample(29,5.2,3.4,1.4,0.2,"Iris-setosa"); AddSample(30,4.7,3.2,1.6,0.2,"Iris-setosa"); AddSample(31,4.8,3.1,1.6,0.2,"Iris-setosa"); AddSample(32,5.4,3.4,1.5,0.4,"Iris-setosa"); AddSample(33,5.2,4.1,1.5,0.1,"Iris-setosa"); AddSample(34,5.5,4.2,1.4,0.2,"Iris-setosa"); AddSample(35,4.9,3.1,1.5,0.2,"Iris-setosa"); AddSample(36,5.0,3.2,1.2,0.2,"Iris-setosa"); AddSample(37,5.5,3.5,1.3,0.2,"Iris-setosa"); AddSample(38,4.9,3.6,1.4,0.1,"Iris-setosa"); AddSample(39,4.4,3.0,1.3,0.2,"Iris-setosa"); AddSample(40,5.1,3.4,1.5,0.2,"Iris-setosa"); AddSample(41,5.0,3.5,1.3,0.3,"Iris-setosa"); AddSample(42,4.5,2.3,1.3,0.3,"Iris-setosa"); AddSample(43,4.4,3.2,1.3,0.2,"Iris-setosa"); AddSample(44,5.0,3.5,1.6,0.6,"Iris-setosa"); AddSample(45,5.1,3.8,1.9,0.4,"Iris-setosa"); AddSample(46,4.8,3.0,1.4,0.3,"Iris-setosa"); AddSample(47,5.1,3.8,1.6,0.2,"Iris-setosa"); AddSample(48,4.6,3.2,1.4,0.2,"Iris-setosa"); AddSample(49,5.3,3.7,1.5,0.2,"Iris-setosa"); AddSample(50,5.0,3.3,1.4,0.2,"Iris-setosa"); AddSample(51,7.0,3.2,4.7,1.4,"Iris-versicolor"); AddSample(52,6.4,3.2,4.5,1.5,"Iris-versicolor"); AddSample(53,6.9,3.1,4.9,1.5,"Iris-versicolor"); AddSample(54,5.5,2.3,4.0,1.3,"Iris-versicolor"); AddSample(55,6.5,2.8,4.6,1.5,"Iris-versicolor"); AddSample(56,5.7,2.8,4.5,1.3,"Iris-versicolor"); AddSample(57,6.3,3.3,4.7,1.6,"Iris-versicolor"); AddSample(58,4.9,2.4,3.3,1.0,"Iris-versicolor"); AddSample(59,6.6,2.9,4.6,1.3,"Iris-versicolor"); AddSample(60,5.2,2.7,3.9,1.4,"Iris-versicolor"); AddSample(61,5.0,2.0,3.5,1.0,"Iris-versicolor"); AddSample(62,5.9,3.0,4.2,1.5,"Iris-versicolor"); AddSample(63,6.0,2.2,4.0,1.0,"Iris-versicolor"); AddSample(64,6.1,2.9,4.7,1.4,"Iris-versicolor"); AddSample(65,5.6,2.9,3.6,1.3,"Iris-versicolor"); AddSample(66,6.7,3.1,4.4,1.4,"Iris-versicolor"); AddSample(67,5.6,3.0,4.5,1.5,"Iris-versicolor"); AddSample(68,5.8,2.7,4.1,1.0,"Iris-versicolor"); AddSample(69,6.2,2.2,4.5,1.5,"Iris-versicolor"); AddSample(70,5.6,2.5,3.9,1.1,"Iris-versicolor"); AddSample(71,5.9,3.2,4.8,1.8,"Iris-versicolor"); AddSample(72,6.1,2.8,4.0,1.3,"Iris-versicolor"); AddSample(73,6.3,2.5,4.9,1.5,"Iris-versicolor"); AddSample(74,6.1,2.8,4.7,1.2,"Iris-versicolor"); AddSample(75,6.4,2.9,4.3,1.3,"Iris-versicolor"); AddSample(76,6.6,3.0,4.4,1.4,"Iris-versicolor"); AddSample(77,6.8,2.8,4.8,1.4,"Iris-versicolor"); AddSample(78,6.7,3.0,5.0,1.7,"Iris-versicolor"); AddSample(79,6.0,2.9,4.5,1.5,"Iris-versicolor"); AddSample(80,5.7,2.6,3.5,1.0,"Iris-versicolor"); AddSample(81,5.5,2.4,3.8,1.1,"Iris-versicolor"); AddSample(82,5.5,2.4,3.7,1.0,"Iris-versicolor"); AddSample(83,5.8,2.7,3.9,1.2,"Iris-versicolor"); AddSample(84,6.0,2.7,5.1,1.6,"Iris-versicolor"); AddSample(85,5.4,3.0,4.5,1.5,"Iris-versicolor"); AddSample(86,6.0,3.4,4.5,1.6,"Iris-versicolor"); AddSample(87,6.7,3.1,4.7,1.5,"Iris-versicolor"); AddSample(88,6.3,2.3,4.4,1.3,"Iris-versicolor"); AddSample(89,5.6,3.0,4.1,1.3,"Iris-versicolor"); AddSample(90,5.5,2.5,4.0,1.3,"Iris-versicolor"); AddSample(91,5.5,2.6,4.4,1.2,"Iris-versicolor"); AddSample(92,6.1,3.0,4.6,1.4,"Iris-versicolor"); AddSample(93,5.8,2.6,4.0,1.2,"Iris-versicolor"); AddSample(94,5.0,2.3,3.3,1.0,"Iris-versicolor"); AddSample(95,5.6,2.7,4.2,1.3,"Iris-versicolor"); AddSample(96,5.7,3.0,4.2,1.2,"Iris-versicolor"); AddSample(97,5.7,2.9,4.2,1.3,"Iris-versicolor"); AddSample(98,6.2,2.9,4.3,1.3,"Iris-versicolor"); AddSample(99,5.1,2.5,3.0,1.1,"Iris-versicolor"); AddSample(100,5.7,2.8,4.1,1.3,"Iris-versicolor"); AddSample(101,6.3,3.3,6.0,2.5,"Iris-virginica"); AddSample(102,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(103,7.1,3.0,5.9,2.1,"Iris-virginica"); AddSample(104,6.3,2.9,5.6,1.8,"Iris-virginica"); AddSample(105,6.5,3.0,5.8,2.2,"Iris-virginica"); AddSample(106,7.6,3.0,6.6,2.1,"Iris-virginica"); AddSample(107,4.9,2.5,4.5,1.7,"Iris-virginica"); AddSample(108,7.3,2.9,6.3,1.8,"Iris-virginica"); AddSample(109,6.7,2.5,5.8,1.8,"Iris-virginica"); AddSample(110,7.2,3.6,6.1,2.5,"Iris-virginica"); AddSample(111,6.5,3.2,5.1,2.0,"Iris-virginica"); AddSample(112,6.4,2.7,5.3,1.9,"Iris-virginica"); AddSample(113,6.8,3.0,5.5,2.1,"Iris-virginica"); AddSample(114,5.7,2.5,5.0,2.0,"Iris-virginica"); AddSample(115,5.8,2.8,5.1,2.4,"Iris-virginica"); AddSample(116,6.4,3.2,5.3,2.3,"Iris-virginica"); AddSample(117,6.5,3.0,5.5,1.8,"Iris-virginica"); AddSample(118,7.7,3.8,6.7,2.2,"Iris-virginica"); AddSample(119,7.7,2.6,6.9,2.3,"Iris-virginica"); AddSample(120,6.0,2.2,5.0,1.5,"Iris-virginica"); AddSample(121,6.9,3.2,5.7,2.3,"Iris-virginica"); AddSample(122,5.6,2.8,4.9,2.0,"Iris-virginica"); AddSample(123,7.7,2.8,6.7,2.0,"Iris-virginica"); AddSample(124,6.3,2.7,4.9,1.8,"Iris-virginica"); AddSample(125,6.7,3.3,5.7,2.1,"Iris-virginica"); AddSample(126,7.2,3.2,6.0,1.8,"Iris-virginica"); AddSample(127,6.2,2.8,4.8,1.8,"Iris-virginica"); AddSample(128,6.1,3.0,4.9,1.8,"Iris-virginica"); AddSample(129,6.4,2.8,5.6,2.1,"Iris-virginica"); AddSample(130,7.2,3.0,5.8,1.6,"Iris-virginica"); AddSample(131,7.4,2.8,6.1,1.9,"Iris-virginica"); AddSample(132,7.9,3.8,6.4,2.0,"Iris-virginica"); AddSample(133,6.4,2.8,5.6,2.2,"Iris-virginica"); AddSample(134,6.3,2.8,5.1,1.5,"Iris-virginica"); AddSample(135,6.1,2.6,5.6,1.4,"Iris-virginica"); AddSample(136,7.7,3.0,6.1,2.3,"Iris-virginica"); AddSample(137,6.3,3.4,5.6,2.4,"Iris-virginica"); AddSample(138,6.4,3.1,5.5,1.8,"Iris-virginica"); AddSample(139,6.0,3.0,4.8,1.8,"Iris-virginica"); AddSample(140,6.9,3.1,5.4,2.1,"Iris-virginica"); AddSample(141,6.7,3.1,5.6,2.4,"Iris-virginica"); AddSample(142,6.9,3.1,5.1,2.3,"Iris-virginica"); AddSample(143,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(144,6.8,3.2,5.9,2.3,"Iris-virginica"); AddSample(145,6.7,3.3,5.7,2.5,"Iris-virginica"); AddSample(146,6.7,3.0,5.2,2.3,"Iris-virginica"); AddSample(147,6.3,2.5,5.0,1.9,"Iris-virginica"); AddSample(148,6.5,3.0,5.2,2.0,"Iris-virginica"); AddSample(149,6.2,3.4,5.4,2.3,"Iris-virginica"); AddSample(150,5.9,3.0,5.1,1.8,"Iris-virginica"); //--- ArrayResize(iris_samples,150); for(int i=0; i<Exttotal; i++) { iris_samples[i]=ExtIRISDataset[i]; } //--- return(true); } //+------------------------------------------------------------------+

Nota sobre os métodos de classificação: SVC, LinearSVC e NuSVC

Vamos comparar três métodos populares de classificação: classificação de vetores de suporte (SVC), classificação de vetores de suporte linear (LinearSVC) e classificação de vetores de suporte Nu (NuSVC).

Princípios de funcionamento:

- SVC (Support Vector Classification)

Como funciona: O SVC é um método de classificação baseado na maximização da margem entre as classes. Ele busca a hiperplano separador ótimo, que maximiza a separação entre as classes e suporta os vetores de suporte - pontos mais próximos ao hiperplano.

Funções de kernel: O SVC pode usar diferentes funções de kernel, tais como linear, função de base radial (RBF), polinomial, e outras. A função de kernel determina como os dados são transformados para encontrar o hiperplano ótimo. - LinearSVC (Linear Support Vector Classification)

Como funciona: LinearSVC é uma variante do SVC que se especializa em classificação linear. Ele busca o hiperplano separador linear ótimo, sem usar funções de kernel. Isso o torna mais rápido e mais eficiente para lidar com grandes volumes de dados. - NuSVC (Nu Support Vector Classification)

Como funciona: O NuSVC também é baseado no método de vetores de suporte, mas introduz o parâmetro Nu (nu), que controla a complexidade do modelo e a fração dos vetores de suporte. O valor de Nu está no intervalo de 0 a 1 e determina qual fração dos dados pode ser usada para vetores de suporte e erros.

Vantagens:

- SVC

Algoritmo poderoso: O SVC pode lidar com tarefas complexas de classificação e trabalhar com dados não lineares graças ao uso de funções de kernel.

Resistência a valores atípicos: O SVC é resistente a valores atípicos nos dados, pois usa vetores de suporte para construir o hiperplano separador. - LinearSVC

Alta eficiência: O LinearSVC é mais rápido e eficiente ao lidar com grandes volumes de dados, especialmente quando há muitos dados e o hiperplano separador linear é adequado para a tarefa.

Classificação linear: Se a tarefa for bem separável linearmente, o LinearSVC pode oferecer bons resultados sem a necessidade de usar funções de kernel complexas. - NuSVC

Controle da complexidade do modelo: O parâmetro Nu no NuSVC permite controlar a complexidade do modelo e o equilíbrio entre o ajuste dos dados e a capacidade de generalização.

Resistência a valores atípicos: Assim como o SVC, o NuSVC é resistente a valores atípicos, o que o torna útil para tarefas com dados imprecisos.

Limitações:

- SVC

Complexidade computacional: O SVC pode ser lento em grandes volumes de dados e/ou ao usar funções de kernel complexas.

Sensibilidade à escolha do kernel: Escolher a função de kernel correta pode ser uma tarefa difícil e pode afetar significativamente o desempenho do modelo. - LinearSVC

Limitação para linearidade: O LinearSVC está limitado à separação linear dos dados e pode apresentar resultados pobres em caso de relações não lineares entre as características e a variável alvo. - NuSVC

Ajuste do parâmetro Nu: Ajustar o parâmetro Nu pode exigir tempo e experimentação para alcançar os melhores resultados.

Dependendo das características da tarefa e do volume de dados, cada um desses métodos pode ser a melhor escolha. É importante realizar experimentos e escolher o método que melhor atenda aos requisitos específicos da tarefa de classificação.

2.1. SVC Classifier

O método de classificação Support Vector Classification (SVC) é um poderoso algoritmo de aprendizado de máquina amplamente utilizado para resolver tarefas de classificação.

Princípios de funcionamento:

- Busca do hiperplano separador ótimo

Como funciona: A ideia principal do SVC é encontrar o hiperplano separador ótimo no espaço de características. Esse hiperplano deve maximizar a separação entre os objetos de classes diferentes e sustentar os vetores de suporte - pontos de dados mais próximos ao hiperplano.

Maximização da margem: O SVC visa maximizar a margem entre as classes, ou seja, a distância dos vetores de suporte ao hiperplano. Isso permite que o método seja resistente a valores atípicos e generalize bem para novos dados. - Uso de funções de kernel

Funções de kernel: O SVC pode usar diferentes funções de kernel, tais como linear, função de base radial (RBF), polinomial, e outras. A função de kernel permite projetar os dados em um espaço de maior dimensão, onde a tarefa se torna linear, mesmo se não houver separabilidade linear no espaço original dos dados.

Escolha do kernel: A escolha da função de kernel correta pode afetar significativamente o desempenho do modelo SVC. Não sempre uma hiperplano linear é a solução ótima.

Vantagens:

- Algoritmo poderoso. Tratamento de tarefas complexas: O SVC é capaz de resolver tarefas de classificação complexas, incluindo aquelas com dependências não lineares entre características e a variável alvo.

- Resistência a valores atípicos: O uso de vetores de suporte torna o método resistente a valores atípicos nos dados. Ele não depende de toda a amostra, mas apenas dos vetores de suporte.

- Flexibilidade na escolha do kernel. Adaptabilidade aos dados: A capacidade de usar diferentes funções de kernel permite adaptar o método SVC aos dados específicos e procurar dependências não lineares.

- Boa capacidade de generalização. Generalização para novos dados: O modelo SVC é capaz de generalizar para novos dados, o que o torna útil para tarefas de previsão.

Limitações:

- Complexidade dos cálculos. Tempo de treinamento: O SVC pode ser lento para treinar, especialmente quando usado com grandes volumes de dados ou funções de kernel complexas.

- Escolha do kernel. Escolha da função de kernel ótima: A escolha da função de kernel correta pode exigir experimentação e depende das características dos dados.

- Sensibilidade à escala das características. Normalização dos dados: O SVC é sensível à escala das características, portanto, recomenda-se realizar a normalização ou padronização dos dados antes do treinamento.

- Interpretação do modelo. Dificuldade de interpretação: Os modelos SVC podem ser difíceis de interpretar devido ao uso de kernels não lineares e ao grande número de vetores de suporte.

Dependendo da tarefa específica e do volume de dados, o método SVC pode ser uma ferramenta poderosa para resolver problemas de classificação. No entanto, é importante considerar suas limitações e ajustar os parâmetros para alcançar os melhores resultados.

2.1.1. Código de criação do modelo SVC Classifier

Este código demonstra o processo de treinamento do modelo SVC Classifier no conjunto de dados Iris, sua exportação para o formato ONNX e a realização de classificação usando o modelo ONNX. Também avalia a precisão tanto do modelo original quanto do modelo ONNX.

# Iris_SVCClassifier.py # The code demonstrates the process of training SVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import SVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create an SVC Classifier model with a linear kernel svc_model = SVC(kernel='linear', C=1.0) # train the model on the entire dataset svc_model.fit(X, y) # predict classes for the entire dataset y_pred = svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of SVC Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path +"svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of SVC Classifier model in ONNX format:", accuracy_onnx)

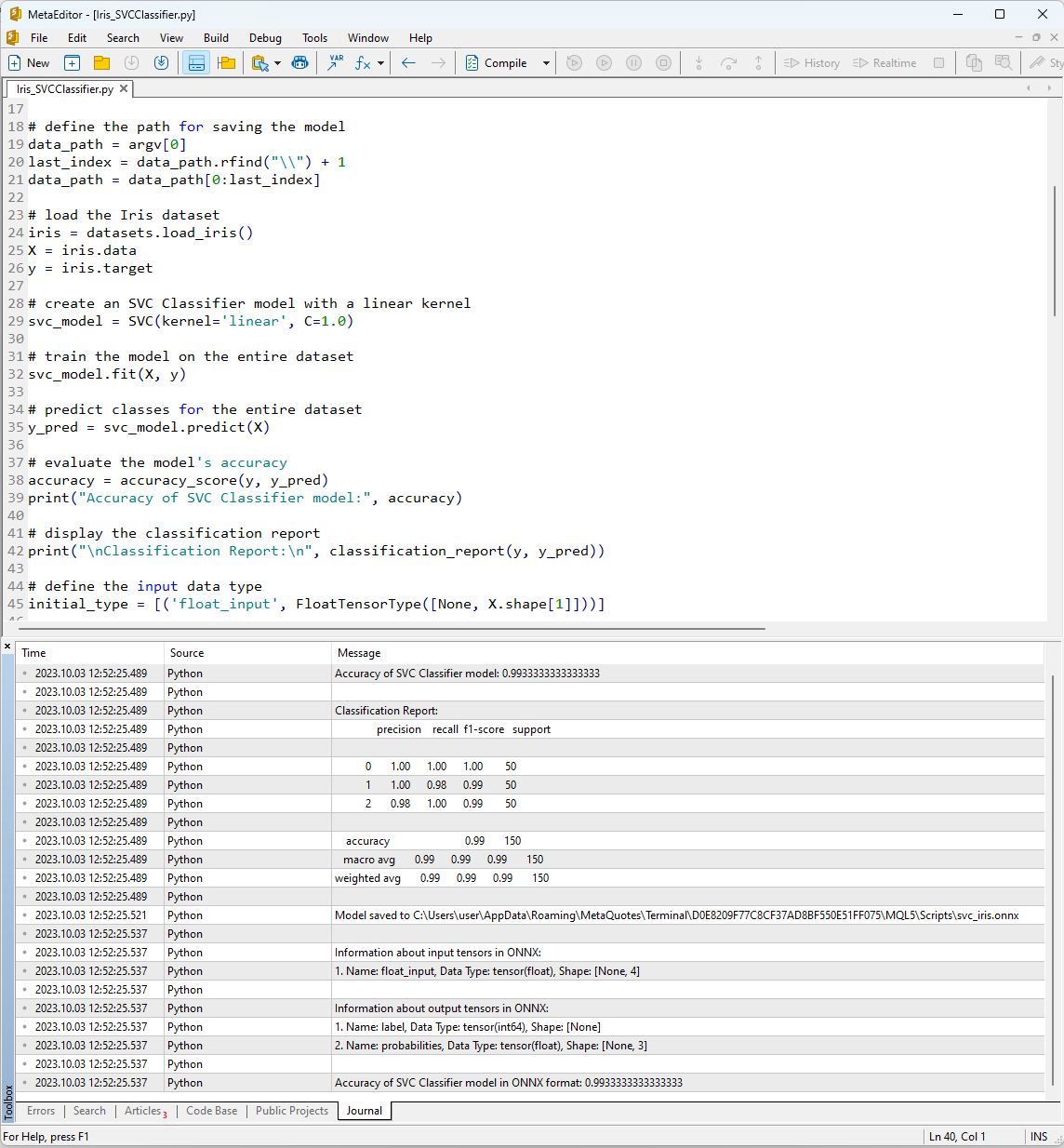

Após executar o script no MetaEditor usando o botão "Compilar" na aba Journal, é possível ver os resultados de seu trabalho.

Fig.12. Resultados do trabalho do script Iris_SVMClassifier.py no MetaEditor

Resultados do trabalho do script Iris_SVCClassifier.py:

Python Accuracy of SVC Classifier model: 0.9933333333333333

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 1.00 0.98 0.99 50

Python 2 0.98 1.00 0.99 50

Python

Python accuracy 0.99 150

Python macro avg 0.99 0.99 0.99 150

Python weighted avg 0.99 0.99 0.99 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of SVC Classifier model in ONNX format: 0.9933333333333333

Aqui é possível encontrar informações sobre o caminho onde o modelo ONNX foi salvo, os tipos de parâmetros de entrada e saída do modelo ONNX, bem como a precisão da descrição do Iris dataset.

A precisão da descrição do conjunto de dados usando o SVM Classifier é de 99%, precisão similar é mostrada pelo modelo exportado no formato ONNX.

Agora, vamos verificar esses resultados do MQL5, executando o modelo construído para cada uma das 150 amostras de dados. Além disso, o script contém um exemplo de processamento em lote de dados.

2.1.2. Código no MQL5 para trabalhar com o modelo SVC Classifier

//+------------------------------------------------------------------+ //| Iris_SVCClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="SVCClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Os resultados do trabalho do script são exibidos na aba "Experts" do terminal MetaTrader 5.

Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier correct results: 99.33% Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier all samples accuracy=0.993333 Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier batch test accuracy=1.000000

O modelo SVC conseguiu distinguir corretamente 149 amostras de 150, o que é um resultado muito bom. O modelo cometeu apenas um erro de classificação no conjunto de dados Iris, prevendo a classe 2 (versicolor) em vez da classe 1 (virginica) para a amostra №84.

Note-se que a precisão do modelo ONNX exportado no Iris dataset completo é de 99.33%, o que corresponde à precisão do original.

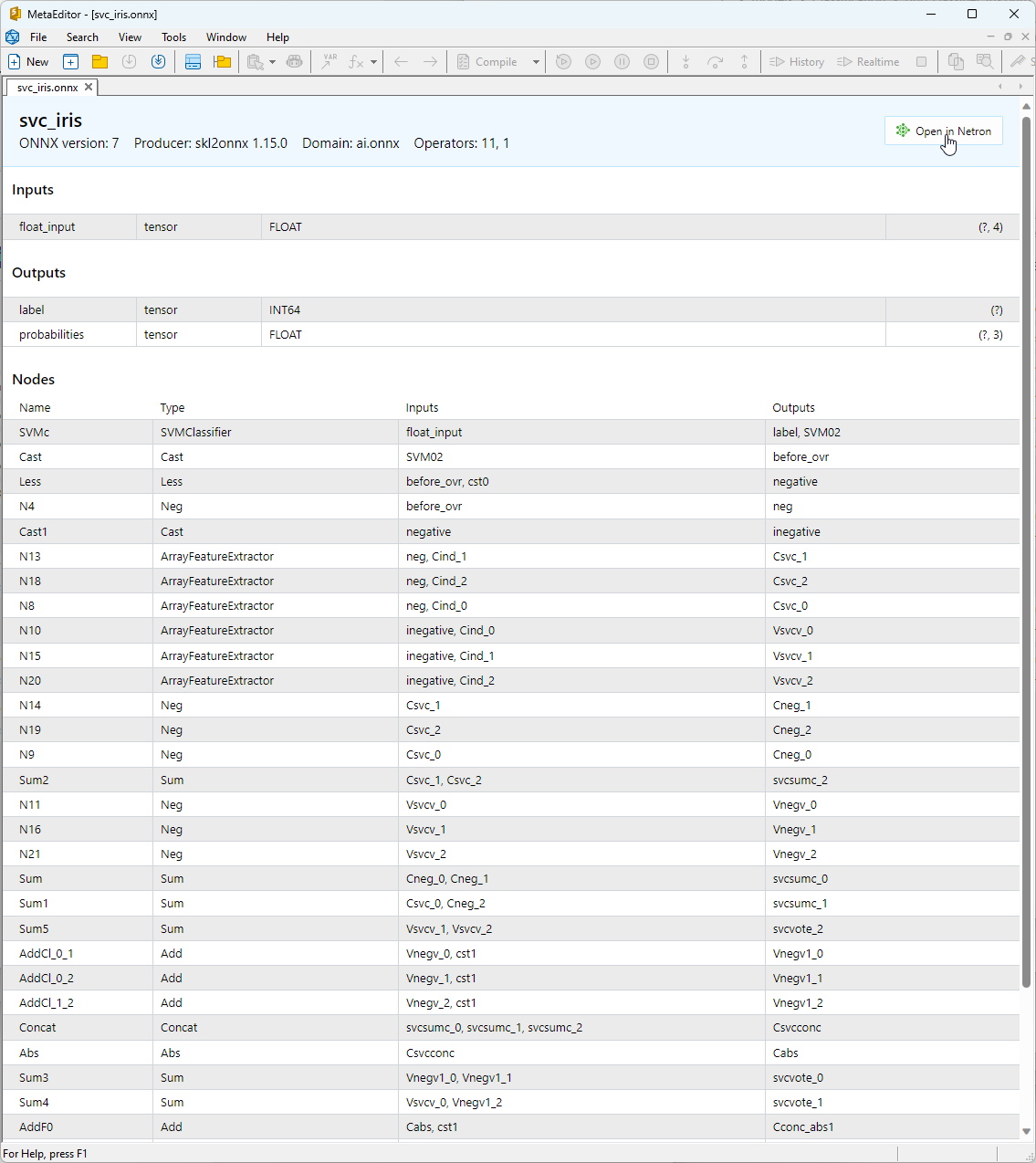

2.1.3. Representação ONNX do modelo SVC Classifier

O modelo ONNX construído pode ser visualizado no MetaEditor:

Fig.13. Modelo ONNX svc_iris.onnx no MetaEditor

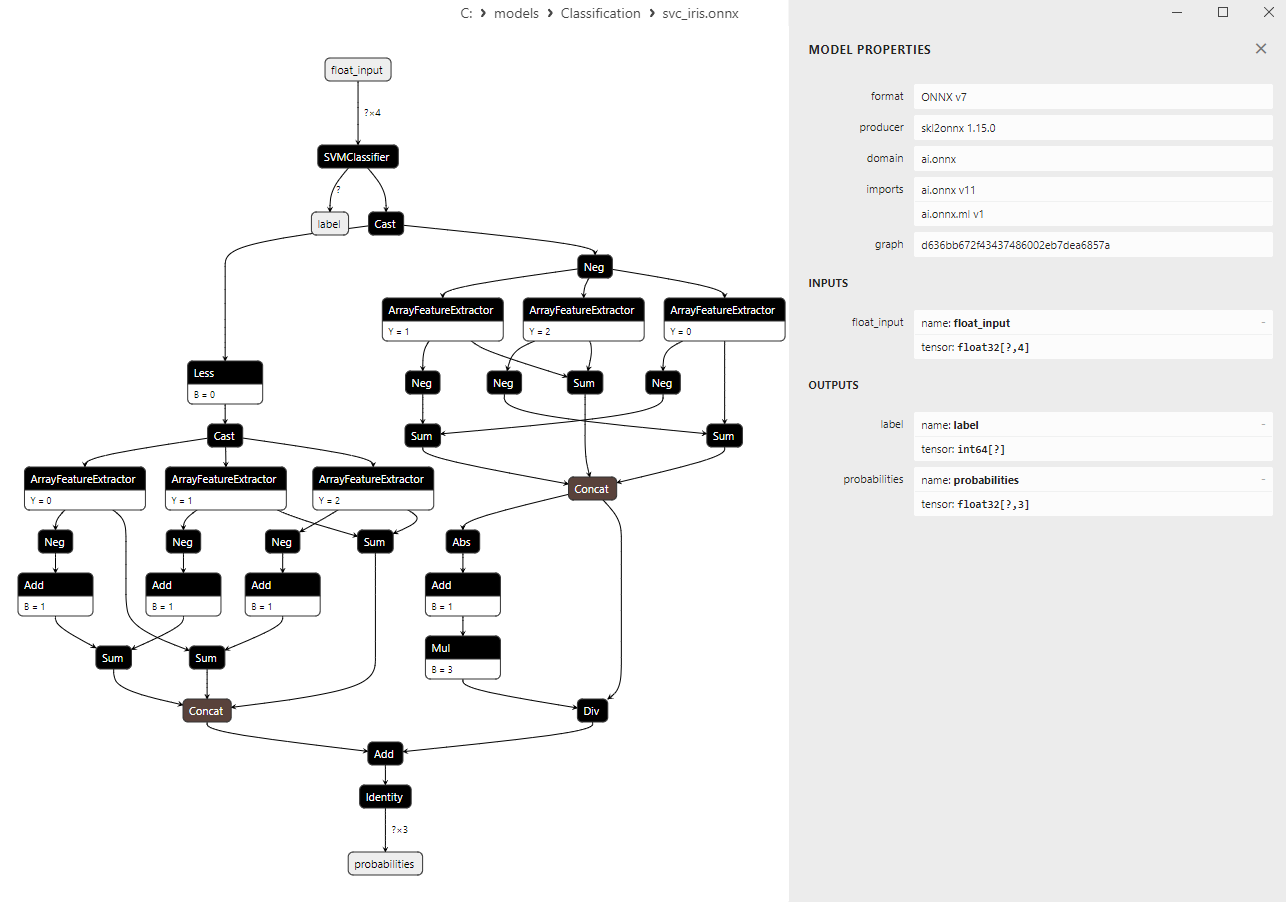

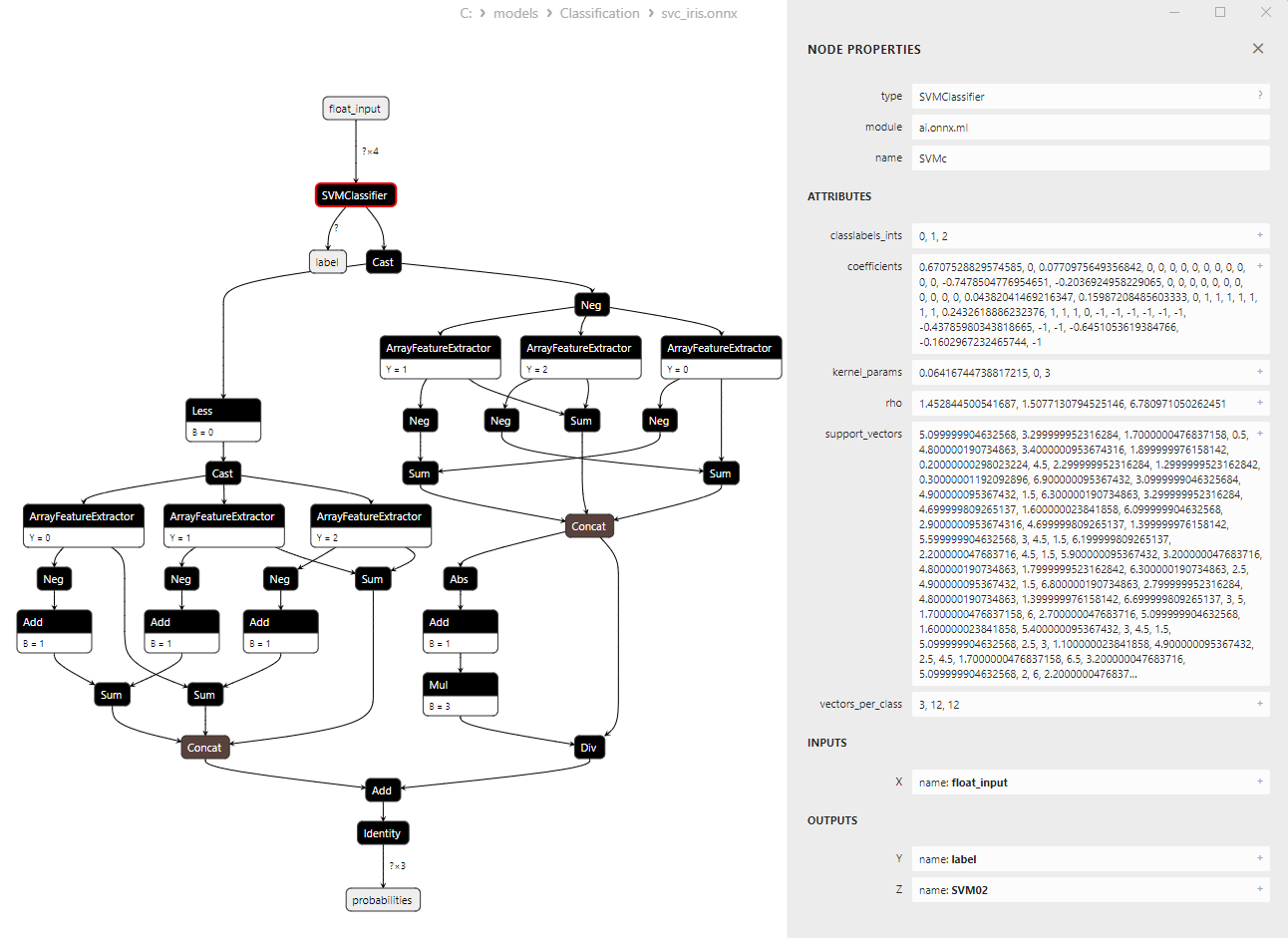

Para obter mais informações sobre a arquitetura do modelo, pode-se usar o Netron; para isso, na descrição do modelo no MetaEditor, é necessário pressionar o botão "Open in Netron".

Fig.14. Modelo ONNX svc_iris.onnx no Netron

Fig.15. Modelo ONNX svc_iris.onnx no Netron (parâmetros do operador ONNX SVMClassifier)

2.2. LinearSVC Classifier

LinearSVC (Classificação de Vetores de Suporte Linear) é um poderoso algoritmo de aprendizado de máquina usado para tarefas de classificação binária e multiclasse. Ele é baseado na ideia de encontrar a hiperplano que melhor separa os dados.

Princípios de funcionamento do LinearSVC:

- Busca do hiperplano ótimo: A ideia principal do LinearSVC é encontrar o hiperplano ótimo que maximiza a separação entre duas classes de dados. Um hiperplano é uma superfície multidimensional definida como uma equação linear.

- Minimização das margens: O LinearSVC visa minimizar as margens (distâncias entre os pontos de dados e o hiperplano). Quanto maiores as margens, mais confiável o hiperplano separa as classes.

- Trabalho com dados linearmente inseparáveis: O LinearSVC pode lidar com dados que não podem ser particionados linearmente no espaço original, por meio do uso de funções de kernel (kernel trick) que permitem que os dados sejam projetados em um espaço de dimensão mais alta, onde podem ser particionados linearmente.

Vantagens do LinearSVC:

- Boa capacidade de generalização: O LinearSVC tem uma boa capacidade de generalização e pode fornecer bons resultados em novos dados, não vistos anteriormente.

- Eficiência: O LinearSVC é rápido em grandes conjuntos de dados e requer relativamente poucos recursos computacionais.

- Trabalho com dados linearmente inseparáveis: Graças ao uso de funções de kernel, o LinearSVC pode resolver tarefas de classificação com dados linearmente inseparáveis.

- Escalabilidade: O LinearSVC pode ser eficientemente utilizado em tarefas com um grande número de características e grandes volumes de dados.

Limitações do LinearSVC:

- Apenas hiperplanos separadores lineares: O LinearSVC constrói apenas hiperplanos separadores lineares, o que pode ser insuficiente para tarefas de classificação complexas com dependências não lineares.

- Escolha de parâmetros: A escolha dos parâmetros corretos (por exemplo, o parâmetro de regularização) pode requerer conhecimento especializado ou validação cruzada.

- Sensibilidade a valores atípicos: O LinearSVC pode ser sensível a valores atípicos nos dados, o que pode afetar a qualidade da classificação.

- Interpretação do modelo: Modelos criados usando o LinearSVC podem ser menos interpretáveis do que alguns outros métodos.

O LinearSVC é um algoritmo de classificação poderoso, que possui uma boa capacidade de generalização, alta eficiência e suporte para trabalhar com dados linearmente inseparáveis. Ele é aplicável em diversas tarefas de classificação, especialmente nos casos em que os dados podem ser separados por um hiperplano linear. No entanto, é importante considerar que para tarefas complexas que requerem modelagem de dependências não lineares, o LinearSVC pode ser uma escolha menos adequada, e nesses casos, deve-se considerar o uso de métodos com superfícies separadoras mais complexas.

2.2.1. Código de criação do modelo LinearSVC Classifier

Este código demonstra o processo de treinamento do modelo LinearSVC Classifier no conjunto de dados Iris, sua exportação para o formato ONNX e a realização de classificação usando o modelo ONNX. Também avalia a precisão tanto do modelo original quanto do modelo ONNX.

# Iris_LinearSVC.py # The code demonstrates the process of training LinearSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import LinearSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a LinearSVC model linear_svc_model = LinearSVC(C=1.0, max_iter=10000) # train the model on the entire dataset linear_svc_model.fit(X, y) # predict classes for the entire dataset y_pred = linear_svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of LinearSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(linear_svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "linear_svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of LinearSVC model in ONNX format:", accuracy_onnx)

Resultado:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.94 0.95 50

Python 2 0.94 0.96 0.95 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\linear_svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of LinearSVC model in ONNX format: 0.9666666666666667

2.2.2. Código no MQL5 para trabalhar com o modelo LinearSVC Classifier

//+------------------------------------------------------------------+ //| Iris_LinearSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "linear_svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="LinearSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Resultado:

Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=71 FAILED [class=2, true class=1] features=(5.90,3.20,4.80,1.80] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=85 FAILED [class=2, true class=1] features=(5.40,3.00,4.50,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=130 FAILED [class=1, true class=2] features=(7.20,3.00,5.80,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=134 FAILED [class=1, true class=2] features=(6.30,2.80,5.10,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC correct results: 96.67% Iris_LinearSVC (EURUSD,H1) model=LinearSVC all samples accuracy=0.966667 Iris_LinearSVC (EURUSD,H1) model=LinearSVC batch test accuracy=1.000000

A precisão do modelo ONNX exportado no Iris dataset completo é de 96.67%, o que corresponde à precisão do original.

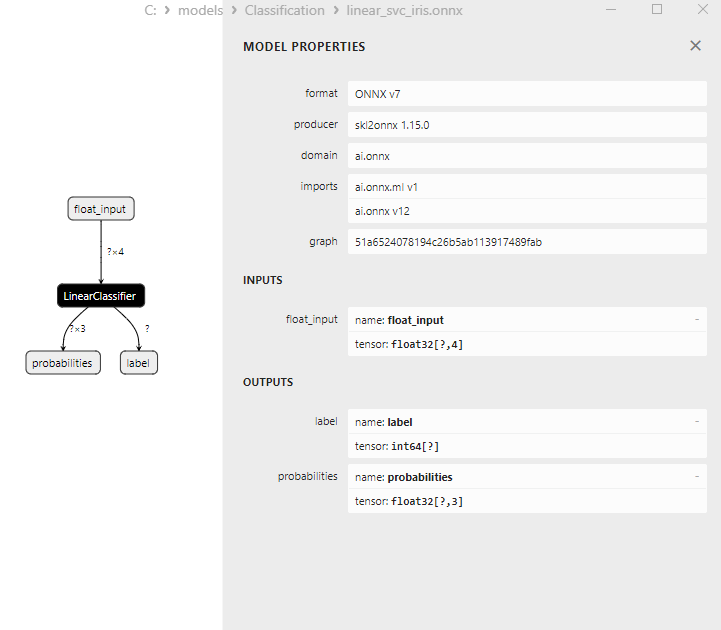

2.2.3. Representação ONNX do modelo LinearSVC Classifier

Fig.16. Representação ONNX do modelo LinearSVC Classifier no Netron

2.3. NuSVC Classifier

O método de classificação Nu-Support Vector Classification (NuSVC) é um poderoso algoritmo de aprendizado de máquina, baseado no método de vetores de suporte (Support Vector Machine, SVM).

Princípios de funcionamento do NuSVC:

- Método de vetores de suporte (SVM): O NuSVC é uma variante do SVM, utilizado para resolver tarefas de classificação binária e multiclasse. O principal princípio do SVM é encontrar o hiperplano separador ótimo que maximiza a separação entre as classes e possui a maior margem entre elas.

- Parâmetro Nu: Um dos parâmetros chave do NuSVC é o parâmetro Nu (nu), que controla a complexidade do modelo e determina a fração da amostra que pode ser usada como vetores de suporte e erros. O valor de Nu está no intervalo de 0 a 1, onde 0.5 significa que aproximadamente metade da amostra será utilizada como vetores de suporte e erros.

- Ajuste de parâmetros: Determinar os valores ótimos do parâmetro Nu e outros hiperparâmetros pode exigir validação cruzada e a busca pelos melhores valores nos dados de treinamento.

- Funções de kernel: O NuSVC pode usar várias funções de kernel, como linear, função de base radial (RBF), polinomial e outras. A função de kernel determina a maneira de transformar o espaço de características para encontrar o hiperplano separador.

Vantagens do NuSVC:

- Eficiência em espaços de alta dimensão: O NuSVC pode operar eficientemente em espaços de alta dimensão, o que o torna adequado para tarefas com um grande número de características.

- Resistência a valores atípicos: O SVM e o NuSVC, em particular, são resistentes a valores atípicos nos dados graças ao uso de vetores de suporte.

- Controle da complexidade do modelo: O parâmetro Nu permite controlar a complexidade do modelo e gerenciar o equilíbrio entre o ajuste dos dados e a capacidade de generalização.

- Boa capacidade de generalização: O SVM e o NuSVC, em particular, têm uma boa capacidade de generalização, o que permite obter bons resultados em novos dados, anteriormente não vistos.

Limitações do NuSVC:

- Ineficiência com grandes volumes de dados: O NuSVC pode ser ineficiente ao treinar em grandes volumes de dados devido à complexidade dos cálculos.

- Necessidade de ajuste de parâmetros: Ajustar os parâmetros Nu e a função de kernel pode exigir tempo e recursos computacionais.

- Linearidade da função de kernel: A eficácia do NuSVC pode depender fortemente da escolha da função de kernel, e para algumas tarefas, pode ser necessário experimentar com diferentes funções.

- Dificuldade de interpretação: O SVM e o NuSVC oferecem bons resultados, mas seus modelos podem ser difíceis de interpretar, especialmente ao usar kernels não lineares.

O Nu-Support Vector Classification (NuSVC) é um poderoso método de classificação baseado em SVM, que possui várias vantagens, incluindo resistência a valores atípicos e boa capacidade de generalização. No entanto, sua eficácia pode depender da escolha de parâmetros e da função de kernel, além de poder ser ineficiente ao treinar em grandes volumes de dados. É importante ajustar cuidadosamente os parâmetros do método e adaptá-lo às tarefas de classificação específicas.

2.3.1. Código de criação do modelo NuSVC Classifier

Este código demonstra o processo de treinamento do modelo NuSVC Classifier no conjunto de dados Iris, sua exportação para o formato ONNX e a realização de classificação usando o modelo ONNX. Também avalia a precisão tanto do modelo original quanto do modelo ONNX.

# Iris_NuSVC.py # The code demonstrates the process of training NuSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import NuSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a NuSVC model nusvc_model = NuSVC(nu=0.5, kernel='linear') # train the model on the entire dataset nusvc_model.fit(X, y) # predict classes for the entire dataset y_pred = nusvc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of NuSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(nusvc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "nusvc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of NuSVC model in ONNX format:", accuracy_onnx)

Resultado:

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.96 0.96 50

Python 2 0.96 0.96 0.96 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\nusvc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of NuSVC model in ONNX format: 0.9733333333333334

2.3.2. Código no MQL5 para trabalhar com o modelo NuSVC Classifier