将您自己的LLM集成到EA中(第1部分):硬件和环境部署

概述

本文主要针对那些希望在本地环境中经济实用地部署LLM并能够根据需要对模型进行微调的人。我们将详细介绍所需的硬件配置和软件环境配置,并提供一些实用的建议和提示。

我们希望通过阅读本文,您将清楚地了解部署LLM所需的硬件条件,并能够根据本文的指导成功构建基本的部署环境。

目录:

LLM是什么

1. 关于LLM

LLM(大型语言模型)是在自然语言处理(NLP)和自然语言生成(NLG)任务中利用深度学习的基本模型。为了帮助他们学习语言的复杂性和联系,大型语言模型是在大量数据上预先训练的。LLM本质上是一个基于Transformer的神经网络(不要问我Transformer是什么,你没有听说过“注意力就是你所需要的一切”吗?)。LLM主要指开源模型,如LLama2。就像 OpenAI 的闭源的 ChatGPT 一样强大,但它无法利用我们的个性化数据。当然,它们也可以与算法交易集成,但这不是本系列文章的主题。

2.为什么以及如何将LLM应用于算法交易

我们为什么选择LLM?原因很简单:它们有很强的逻辑理解和推理能力。所以问题来了,我们如何在算法交易中使用这种强大的功能?作为一个简单的例子,如果你想通过使用斐波那契序列进行算法交易,你会怎么做?如果你用传统的编程方法来实现它,那将是一件残酷的事情。但如果我们使用LLM,我们只需要根据斐波那契理论制作相应的数据集,然后使用这个数据集对LLM进行微调,并直接调用LLM在我们的算法交易中生成的结果。一切都变得容易了。

3. 为什么在本地部署LLM

1). 本地部署可以提供更高的数据安全性。对于一些涉及敏感信息的应用程序,如医疗、金融等领域,数据安全至关重要。通过在本地环境中部署LLM,我们可以确保数据不会离开我们的控制范围。

2). 本地部署可以提供更高的性能。通过选择合适的硬件配置,我们可以根据自己的需求优化模型的运行效率。此外,本地环境中的网络延迟通常低于云环境中的延迟,这对于一些需要实时响应的应用程序来说非常重要。

3). 通过在本地环境中部署LLM,并根据我们的个性化数据对其进行微调,我们可以获得更好地满足我们需求的模型。这是因为每个应用场景都有其独特性,通过微调,我们可以使模型更好地适应我们的应用场景。

总之,LLM的本地部署不仅可以提供更高的数据安全性和性能,还可以让我们获得更好地满足我们需求的模型。因此,了解如何在本地环境中部署LLM并根据我们的个性化数据对其进行微调,对于我们如何融入算法交易非常重要。在以下内容中,我们将详细介绍如何选择硬件配置和构建软件环境。

硬件配置

在本地部署LLM时,硬件配置是一个非常重要的部分。这里我们主要讨论主流PC,不讨论MacOS和其他小众产品。

用于部署LLM的产品主要涉及CPU、GPU、内存和存储设备。其中,CPU和GPU是运行模型的主要计算设备,内存和存储设备用于存储模型和数据。

正确的硬件配置不仅可以保证模型的运行效率,而且在一定程度上影响模型的性能。因此,我们需要根据自己的需求和预算选择合适的硬件配置。

1. 处理器

目前,由于像Llama.cpp这样的框架的出现,语言模型可以在CPU上直接推断或训练。所以,如果你没有独立的显卡,别担心,CPU也是你的一个选择。

目前,市场上主要的处理器品牌是英特尔和AMD。英特尔的至强系列和AMD的EPYC系列是目前最受欢迎的服务器级处理器。这些处理器具有高频率、多核和大缓存,非常适合运行大型语言模型(LLM)。

在选择处理器时,我们需要考虑其内核数量、频率和缓存大小。一般来说,具有更多内核、更高频率和更大缓存的处理器性能更好,但它们也更昂贵。因此,我们需要根据自己的预算和需求进行选择。

对于LLM的本地部署,我们建议进行以下硬件配置:

CPU:至少4核,频率至少为2.5GHz

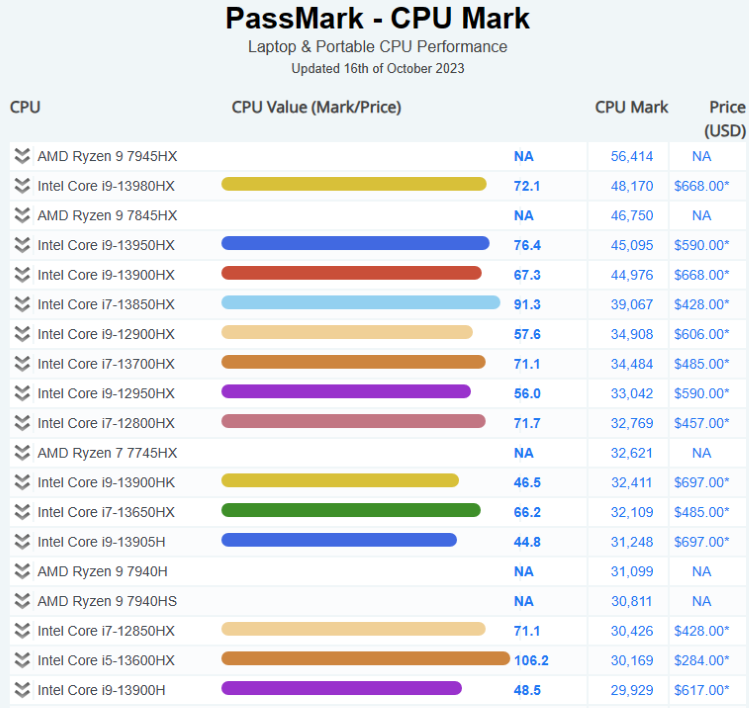

以下是当前CPU市场情况,供参考:

您可以在此处找到更多信息:通过标记CPU基准

2. 显卡

对于运行大型语言模型(LLM),图形卡是非常重要的。图形卡的计算能力和内存大小直接影响模型的训练和推理速度。一般来说,计算能力更强、内存更大的显卡性能更好,但也更贵。

NVIDIA的特斯拉和Quadro系列以及AMD的Radeon Pro系列是目前最受欢迎的专业显卡。这些显卡具有大量的内存和强大的并行计算能力,可以有效地加速模型训练和推理。

对于LLM的本地部署,我们建议进行以下硬件配置:

具有8G或更多内存的显卡。

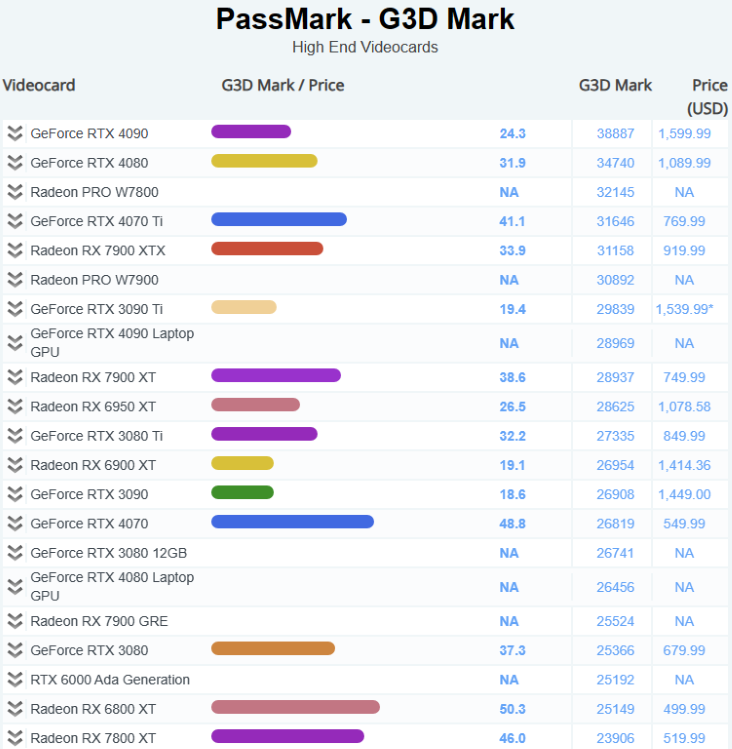

以下是当前GPU市场情况,供参考:

您可以在此处找到更多信息:通过标记软件-显卡(GPU)基准

3. 内存

DDR5已成为主流。对于运行大型语言模型(LLM),我们建议使用尽可能多的内存。

对于LLM的本地部署,我们建议进行以下硬件配置:

至少16GB的DDR4内存。

4. 存储

存储设备的速度和容量直接影响数据读取速度和数据存储容量。一般来说,速度更快、容量更大的存储设备性能更好,但也更昂贵。

固态硬盘(SSD)由于其高速度和低延迟而成为主流存储设备。NVMe接口SSD由于其更高的速度而逐渐取代SATA接口SSD。固态硬盘(SSD)由于其高速度和低延迟而成为主流存储设备。

对于LLM的本地部署,我们建议进行以下硬件配置:

至少1TB NVMe SSD。

软件环境配置

1. 不同操作系统环境的构建和分析

在本地部署LLM时,我们需要考虑操作系统环境的选择。目前,最常见的操作系统环境包括Windows、Linux和MacOS。每个操作系统都有自己的优点和缺点,我们需要根据自己的需求进行选择。

- Windows:

Windows操作系统因其用户友好的界面和丰富的软件支持而受到大量用户的喜爱。然而,由于其封闭源代码的性质,Windows在一些高级功能和自定义方面可能不如Linux和MacOS。

- Linux:

Linux操作系统以其开源、高度可定制和强大的命令行工具而闻名。对于需要执行大规模计算或服务器部署的用户来说,Linux是一个不错的选择。然而,由于其陡峭的学习曲线,对于初学者来说可能有点困难。

- MacOS:

MacOS操作系统以其优雅的设计和卓越的性能受到许多专业用户的喜爱。然而,由于其硬件限制,MacOS可能不适合需要执行大规模计算的用户。

- Windows + WSL:

WSL允许我们在Windows操作系统上运行Linux环境,这使我们能够在使用Linux强大的命令行工具的同时享受Windows的用户友好界面。

以上是我们对不同操作系统环境的简单分析。我们强烈建议使用Windows+WSL,它可以照顾日常使用并为我们的专业计算服务。

2. 相关软件配置

在选择了适当的硬件配置后,我们需要在操作系统上安装和配置一些必要的软件。这些软件包括操作系统、编程语言环境、开发工具等。以下是一些常见的软件配置步骤:

- 操作系统:

首先,我们需要安装一个操作系统。对于大型语言模型(LLM)的训练和推理,我们建议使用Linux操作系统,因为它提供了强大的命令行工具和高度可定制的环境。

- 编程语言环境:

我们需要安装Python环境,因为大多数LLM都是使用Python开发的。我们建议使用Anaconda来管理Python环境,因为它可以轻松地安装和管理Python包。

- 开发工具:

我们需要安装一些开发工具,如文本编辑器(如VS Code或Sublime Text)、版本控制工具(如Git)等。

- LLM相关软件:

我们需要安装一些与LLM相关的软件,如TensorFlow或PyTorch深度学习框架,以及Hugging Face的Transformers库等。

3. 推荐配置

以下是一些推荐的软件工具和版本:

- 操作系统:

我们建议使用Windows11+Ubuntu 20.04 LTS(WSL)。这是一个稳定且广泛使用的Linux发行版,具有丰富的软件包和良好的社区支持。

- Python环境:

我们建议使用Anaconda来管理Python环境。Anaconda是一个流行的Python数据科学平台,可以轻松安装和管理Python包。我们建议使用Python 3.10,因为它是一个稳定且广泛支持的版本。

- 深度学习框架:

我们建议使用PyTorch 2.0或更高版本,这是最流行的深度学习之一。

云计算平台

1. 平台

以下是一些最受欢迎的:

1). 亚马逊网络服务(Amazon Web Services,AWS)

亚马逊网络服务(AWS)是由亚马逊股份有限公司提供的云计算平台,全球各地的数据中心提供200多个全功能服务。AWS的服务涵盖计算、存储和数据库等基础设施技术,以及机器学习、人工智能、数据湖和分析以及物联网等新兴技术。AWS的客户包括数百万活跃用户和各种规模和行业的组织,包括初创公司、大型企业和政府机构。

2). Microsoft Azure

Microsoft Azure是由Microsoft提供的云计算平台,具有以下优势。Azure有多层安全措施,覆盖数据中心、基础设施和运营层,以保护客户和组织数据。Azure还提供最全面的法规遵从性覆盖,支持90多种法规遵从性产品和业界领先的服务级别协议。Azure通过为混合云设计的工具和服务,如Azure Arc和Azure Stack1,实现了跨本地、多云和边缘环境的无缝操作。Azure还允许客户使用自己的Windows Server和SQL Server许可证,并在Azure上节省高达40%的费用。Azure支持所有语言和框架,允许客户使用自己选择的语言或平台构建、部署和管理应用程序。Azure还提供了丰富的人工智能和机器学习服务和工具,允许客户创建智能应用程序,并利用OpenAI Whisper模型进行高质量的转录和翻译。Azure提供了200多种服务和工具,允许客户实现应用程序的无限规模,并利用云的创新。Azure在过去12个月里推出了1000多项新功能,涵盖了人工智能、机器学习、虚拟化、Kubernetes和数据库等领域。

3). 谷歌云平台(Google Cloud Platform,GCP)

谷歌云平台(GCP)是谷歌提供的一套云计算服务和工具。GCP允许客户在与谷歌相同的基础设施上构建、部署和扩展应用程序、网站和服务。GCP提供各种技术,如计算、存储、数据库、分析、机器学习和物联网。GCP被不同行业和部门的数百万客户使用,包括初创公司、企业和政府机构。GCP也是当今最安全、最灵活、最可靠的云计算环境之一。

2. 云计算的优势

- 成本效益:与传统的IT基础设施相比,云计算更具成本效益,因为用户只为他们使用的计算资源付费。

- 托管基础设施:云提供商管理底层基础设施,包括硬件和软件。

- 可扩展性:云的可扩展性非常强,允许组织根据需要轻松调整资源使用情况。

- 全局和可访问:云是全局的、方便的和可访问的,加快了创建和部署软件应用程序的时间。

- 无限存储容量:无论您使用何种云,您都可以购买所需的所有存储。

- 自动备份/恢复:云备份是一种服务,其中企业服务器上的数据和应用程序被备份并存储在远程服务器上。

3. 云计算的缺点

- 数据安全:虽然云提供商实施了强大的安全措施,但将敏感数据存储在云中仍然会带来风险。

- 合规性法规:根据您所在的行业,可能会有一些法规限制哪些数据可以存储在云中。

- 停机的可能性:虽然很少发生,但云服务可能会出现停机,从而导致潜在的停机时间。

结论

LLM的本地部署和个性化数据的微调是一项复杂但非常有价值的任务,正确的硬件配置和软件环境配置是实现这一目标的关键。

在硬件配置方面,我们需要根据自己的预算和需求选择合适的CPU、GPU、内存和存储设备。在软件环境配置方面,我们需要根据自己的操作系统选择合适的编程语言解释器、深度学习框架和其他必要的库。

虽然这些任务可能会遇到一些挑战,但只要我们有明确的目标,愿意投入时间和精力学习和实践,我们一定会成功。

我希望这篇文章能给你一些见解。在下一篇文章中,我们将给出一个环境部署的示例。

敬请期待!

本文由MetaQuotes Ltd译自英文

原文地址: https://www.mql5.com/en/articles/13495

注意: MetaQuotes Ltd.将保留所有关于这些材料的权利。全部或部分复制或者转载这些材料将被禁止。

本文由网站的一位用户撰写,反映了他们的个人观点。MetaQuotes Ltd 不对所提供信息的准确性负责,也不对因使用所述解决方案、策略或建议而产生的任何后果负责。

了解如何在MQL5中处理日期和时间

了解如何在MQL5中处理日期和时间

掌握ONNX:MQL5交易者的游戏规则改变者

掌握ONNX:MQL5交易者的游戏规则改变者

关于硬件和操作系统只是泛泛而谈,是桌面小工具的基准,而移动处理器则很抽象,不适用于任务。

感觉这篇文章是由人工智能生成的。

我想知道 LLM 能否转换成 ONNX,它的重量是多少:)

似乎可以

RWKV-4 重量不到一千克。

主页