独自のLLMをEAに統合する(第1部):ハードウェアと環境の導入

はじめに

この記事は主に、ローカル環境にLLMを経済的かつ実際的に展開し、必要に応じてモデルを微調整できることを望んでいるユーザーを対象としています。必要なハードウェア構成とソフトウェア環境構成について詳しく説明し、いくつかの実践的な提案とヒントを提供します。

この記事を読んで、読者がLLMの展開に必要なハードウェア条件を明確に理解し、この記事のガイダンスに従って基本的な展開環境を正常に構築できることを願っています。

目次

LLMとは

1.LLMSについて

LLM(大規模言語モデル)は、自然言語処理(NLP)および自然言語生成(NLG)タスクで深層学習を利用する基本的なモデルです。言語の複雑さとつながりを学習できるよう、大規模な言語モデルが大量のデータで事前訓練されています。LLMは本質的に、Transformerに基づくニューラルネットワークです(Transformerが何であるかは聞かないでください。「Attention is All You Need」について聞いたことはありませんか?)。LLMとは、主にLLama2のようなオープンソースモデルを指します。OpenAIと同様に、クローズドソースのChatGPTは強力ですが、パーソナライズされたデータを活用することはできません。もちろん、アルゴリズム取引と統合することもできますが、それは本連載の内容ではありません。

2. LLMをアルゴリズム取引に適用する理由と方法

なぜLLMSを選んだのでしょうか。理由は簡単です。論理的理解力と推論能力が高いからです。ここで問題は、この強力な機能をアルゴリズム取引でどのように使用できるかということです。 簡単な例として、フィボナッチ数列を使用してアルゴリズム取引をおこないたい場合はどうするでしょうか。従来のプログラミング手法で実装すると大変なことになりますが、LLMを使用する場合は、フィボナッチ理論に従って対応するデータセットを作成し、このデータセットを使用してLLMを微調整し、アルゴリズム取引でLLMによって生成された結果を直接呼び出すだけで済みます。すべてが簡単になりました。

3.LLMをローカルに導入する理由

1) ローカル展開では、より高度なデータセキュリティを提供できます。医療、金融、その他の分野など、機密情報が関係する一部のアプリケーションでは、データセキュリティが非常に重要です。LLMをローカル環境に導入することで、データが管理範囲外に漏れないようにすることができます。

2) ローカルに展開すると、より高いパフォーマンスが得られます。適切なハードウェア構成を選択することで、ニーズに応じてモデルの実行効率を最適化できます。さらに、ローカル環境のネットワーク遅延は通常、クラウド環境よりも低く、これはリアルタイム応答を必要とする一部のアプリケーションにとって非常に重要です。

3) LLMをローカル環境に展開し、パーソナライズされたデータに従って微調整することで、ニーズをより適切に満たすモデルを取得できます。これは、各アプリケーションシナリオには独自性があり、微調整することでモデルをアプリケーションシナリオによりよく適合させることができるためです。

要約すると、LLMをローカルに展開すると、より高いデータセキュリティとパフォーマンスが提供されるだけでなく、ニーズをより適切に満たすモデルを入手できるようになります。したがって、ローカル環境にLLMを展開し、パーソナライズされたデータに従ってLLMを微調整する方法を理解することは、アルゴリズム取引にどのように統合するかにとって非常に重要です。次のコンテンツでは、ハードウェア構成の選択とソフトウェア環境の構築方法について詳しく説明します。

ハードウェア構成

LLMをローカルに展開する場合、ハードウェア構成は非常に重要な部分です。ここでは主にメインストリームPCについて説明し、MacOSやその他のニッチな製品については説明しません。

LLMの展開に使用される製品には、主にCPU、GPU、メモリ、ストレージデバイスが含まれます。このうち、CPUとGPUはモデルを実行するための主要なコンピューティングデバイスであり、メモリとストレージデバイスはモデルとデータを保存するために使用されます。

正しいハードウェア構成は、モデルの実行効率を確保するだけでなく、モデルのパフォーマンスにもある程度の影響を与えます。したがって、ニーズと予算に応じて適切なハードウェア構成を選択する必要があります。

1.プロセッサー

現在、Llama.cppのようなフレームワークの出現により、言語モデルをCPU上で直接推論または訓練できるようになりました。したがって、スタンドアロンのグラフィックスカードをお持ちでない場合でも、CPUも選択肢の1つであるため、ご心配なく。

現在、市場に出回っている主なプロセッサブランドはIntelとAMDです。IntelのXeonシリーズとAMDのEPYCシリーズは、現在最も人気のあるサーバーレベルのプロセッサです。これらのプロセッサは、高周波数、マルチコア、および大規模なキャッシュを備えており、大規模言語モデル(LLM)の実行に非常に適しています。

プロセッサを選択するときは、コアの数、周波数、キャッシュサイズを考慮する必要があります。一般に、コア数が多く、周波数が高く、キャッシュが大きいプロセッサほどパフォーマンスが向上しますが、高価でもあります。したがって、自分の予算とニーズに応じて選択する必要があります。

LLMをローカルに展開する場合は、次のハードウェア構成をお勧めします。

CPU:少なくとも4コア、少なくとも2.5GHzの周波数

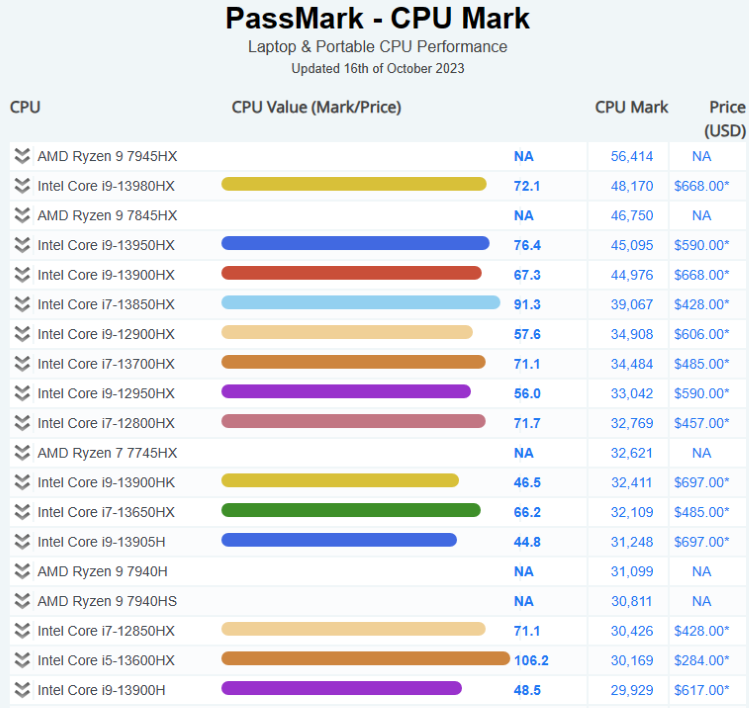

参考までに現在のCPU市場状況を以下に示します。

詳細については、こちらをご覧ください。パスマークCPUベンチマーク

2.グラフィックスカード

大規模言語モデル(LLM)を実行するには、グラフィックカードが非常に重要です。グラフィックスカードの計算能力とメモリサイズは、モデルの訓練と推論の速度に直接影響します。一般に、より強力なコンピューティング能力とより大きなメモリを備えたグラフィックスカードはパフォーマンスが優れていますが、高価でもあります。

NVIDIAのTeslaおよびQuadroシリーズ、およびAMDのRadeonProシリーズは、現在最も人気のあるプロフェッショナルグラフィックカードです。これらのグラフィックスカードは、モデルの訓練と推論を効果的に加速できる大量のメモリと強力な並列コンピューティング機能を備えています。

LLMをローカルに展開する場合は、次のハードウェア構成をお勧めします。

8G以上のメモリを搭載したグラフィックスカード。

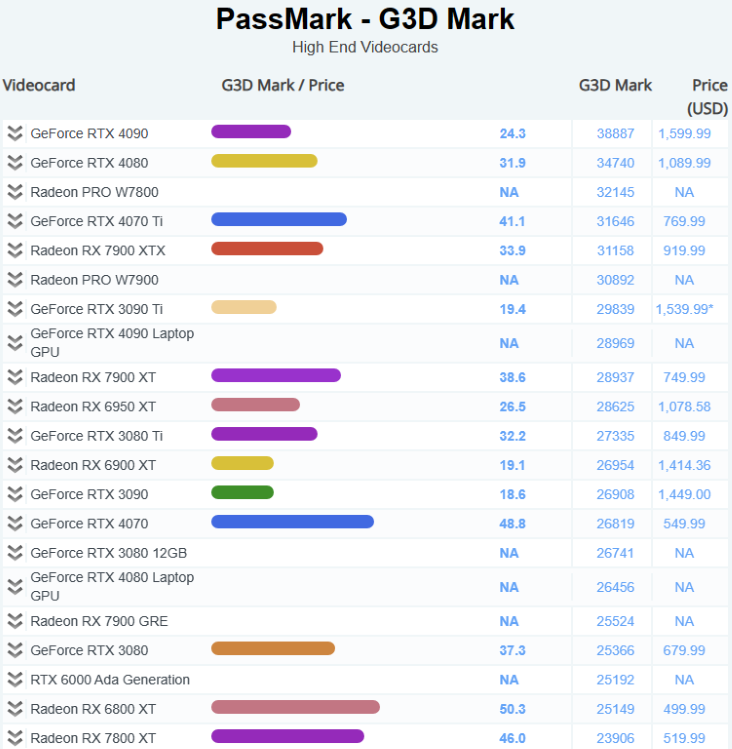

参考として、現在のGPU市場状況を以下に示します。

詳細については、こちらをご覧ください。 パスマークソフトウェア-ビデオカード(GPU)ベンチマーク

3.メモリ

DDR5が主流になってきました。大規模言語モデル(LLM)を実行する場合は、できるだけ多くのメモリを使用することをお勧めします。

LLMをローカルに展開する場合は、次のハードウェア構成をお勧めします。

少なくとも16GBのDDR4メモリ。

4.ストレージ

ストレージデバイスの速度と容量は、データの読み取り速度とデータストレージ容量に直接影響します。一般に、高速で大容量のストレージデバイスはパフォーマンスが優れていますが、高価でもあります。

ソリッドステートドライブ(SSD)は、その高速性と低遅延により、主流のストレージデバイスとなっています。NVMeインターフェイスSSDは、その高速性により、徐々にSATAインターフェイスSSDに取って代わりつつあります。ソリッドステートドライブ(SSD)は、その高速性と低遅延により、主流のストレージデバイスとなっています。

LLMをローカルに展開する場合は、次のハードウェア構成をお勧めします。

少なくとも1TBNVMeSSD。

ソフトウェア環境の構成

1.さまざまなオペレーティングシステム環境の構築と分析

LLMをローカルに展開する場合は、オペレーティングシステム環境の選択を考慮する必要があります。現在、最も一般的なオペレーティングシステム環境には、Windows、Linux、MacOSが含まれます。各オペレーティングシステムには独自の長所と短所があるため、自分のニーズに応じて選択する必要があります。

-ウィンドウズ:

Windowsオペレーティングシステムは、その使いやすいインターフェイスと豊富なソフトウェアサポートにより、多くのユーザーに愛されています。ただし、Windowsはクローズドソースであるため、一部の高度な機能やカスタマイズではLinuxやMacOSほど優れていない可能性があります。

Linux

Linuxオペレーティングシステムは、オープンソース、高度にカスタマイズ可能な強力なコマンドラインツールで知られています。大規模なコンピューティングやサーバーの展開を実行する必要があるユーザーには、Linuxが適しています。ただし、学習曲線が急であるため、初心者には少し難しいかもしれません。

-マックOS:

MacOSオペレーティングシステムは、そのエレガントなデザインと優れたパフォーマンスにより、多くのプロフェッショナルユーザーに愛されています。ただし、MacOSはハードウェアの制限により、大規模なコンピューティングを実行する必要があるユーザーには適さない場合があります。

Windows+WSL

WSLを使用すると、Windowsオペレーティングシステム上でLinux環境を実行できるため、Linuxの強力なコマンドラインツールを使用しながら、Windowsのユーザーフレンドリーなインターフェイスを楽しむことができます。

上記は、さまざまなオペレーティングシステム環境の単純な分析です。日常的な使用に対応し、プロフェッショナルなコンピューティングを提供できるWindows+WSLを使用することを強くお勧めします。

2.関連するソフトウェア構成

適切なハードウェア構成を選択したら、オペレーティングシステムに必要なソフトウェアをインストールして構成する必要があります。これらのソフトウェアには、オペレーティングシステム、プログラミング言語環境、開発ツールなどが含まれます。一般的なソフトウェア構成手順をいくつか示します。

-オペレーティング·システム:

まず、オペレーティングシステムをインストールする必要があります。大規模言語モデル(LLM)の訓練と推論には、強力なコマンドラインツールと高度にカスタマイズ可能な環境を提供するLinuxオペレーティングシステムを使用することをお勧めします。

プログラミング言語環境

ほとんどのLLMはPythonを使用して開発されるため、Python環境をインストールする必要があります。Anacondaを使用すると、Pythonパッケージを簡単にインストールして管理できるため、Python環境の管理にはAnacondaを使用することをお勧めします。

開発ツール

テキストエディタ(VSCodeやSublimeTextなど)、バージョン管理ツール(Gitなど)などの開発ツールをインストールする必要があります。

LLM関連ソフトウェア

TensorFlowやPyTorch深層学習フレームワークなどのLLMに関連するソフトウェアや、HuggingFaceのTransformersライブラリなどをインストールする必要があります。

3.推奨される構成

推奨されるソフトウェアツールとバージョンは次のとおりです。

-オペレーティング·システム

Windows11+Ubuntu 20.04 LTS (WSL)の使用を推奨します。これは、豊富なパッケージと優れたコミュニティサポートを備えた、安定して広く使用されているLinuxディストリビューションです。

-Python環境

Python環境の管理にはAnacondaを使用することをお勧めします。Anacondaは、Pythonパッケージを簡単にインストールして管理できる人気のPythonデータサイエンスプラットフォームです。Python3.10は安定していて広くサポートされているバージョンであるため、Python3.10の使用をお勧めします。

-深層学習フレームワーク

最も人気のある深層学習の1つであるPyTorch 2.0以降を使用することをお勧めします。

クラウドコンピューティングプラットフォーム

1.プラットホーム

最も人気のあるもののいくつかを次に示します。

1) アマゾンウェブサービス(AWS)

アマゾンウェブサービス(AWS)は、Amazon,Inc.が提供するクラウドコンピューティングプラットフォームであり、世界中のデータセンターで200以上のフル機能のサービスを提供しています。AWSのサービスは、コンピューティング、ストレージ、データベースなどのインフラストラクチャテクノロジーだけでなく、機械学習、人工知能、データレイクと分析、モノのインターネットなどの新興テクノロジーにも及びます。AWSの顧客には、スタートアップ、大企業、政府機関を含む、あらゆる規模と業界の何百万ものアクティブユーザーと組織が含まれます。

2) Microsoft Azure

Microsoft Azureはマイクロソフト社が提供するクラウドコンピューティングプラットフォームであり、以下のようなメリットがあります。Azureには、データセンター、インフラストラクチャ、運用の各層をカバーする複数の層のセキュリティ対策があり、顧客と組織のデータを保護します。また、Azureは最も包括的なコンプライアンス対応範囲を提供し、90を超えるコンプライアンス製品と業界をリードするサービスレベルアグリーメントをサポートしています。Azureでは、Azure ArcやAzure Stack1などのハイブリッドクラウド向けに設計されたツールとサービスを使用して、オンプレミス、複数のクラウド、エッジ環境にわたるシームレスな運用を可能にします。Azureでは、顧客が独自のWindows ServerおよびSQL Serverライセンスを使用し、Azureを最大40%節約することもできます。Azureはすべての言語とフレームワークをサポートしているため、顧客は選択した言語またはプラットフォームでアプリケーションを構築、展開、管理できます。また、Azureは、顧客がインテリジェントなアプリケーションを作成し、OpenAIWhisperモデルを活用して高品質の文字起こしと翻訳を可能にする、豊富なAIおよび機械学習のサービスとツールを提供します。Azureは、顧客が無制限のアプリケーションのスケールを実現し、クラウドのイノベーションを活用できるようにする200以上のサービスとツールを提供します。Azureは過去12か月間で1,000を超える新機能を展開し、AI、機械学習、仮想化、Kubernetes、データベースなどの分野をカバーしました。

3) Google Cloud Platform (GCP)

GoogleCloudPlatform (GCP)は、Googleが提供するクラウドコンピューティングサービスとツールのスイートです。GCPを使用すると、顧客はGoogleと同じインフラストラクチャ上でアプリケーション、ウェブサイト、サービスを構築、展開、拡張できます。GCPは、コンピューティング、ストレージ、データベース、分析、機械学習、モノのインターネットなどのさまざまなテクノロジーを提供します。GCPは、新興企業、企業、政府機関など、さまざまな業界や部門にわたる何百万もの顧客によって使用されています。GCPは、現在利用可能なクラウドコンピューティング環境の中で最も安全、柔軟、信頼性の高い環境の1つでもあります。

2.クラウドコンピューティングの利点

-費用対効果が高い:クラウドコンピューティングは、ユーザーが使用したコンピューティングリソースに対してのみ料金を支払うため、従来のITインフラストラクチャと比較してコスト効率が高くなります。

-管理されたインフラストラクチャ:クラウドプロバイダーは、ハードウェアやソフトウェアなどの基盤となるインフラストラクチャを管理します。

-スケーラビリティ:クラウドは拡張性に優れているため、組織はニーズに基づいてリソースの使用量を簡単に調整できます。

-グローバルでアクセス可能:クラウドはグローバルで便利でアクセスしやすいため、ソフトウェアアプリケーションの作成と展開にかかる時間が短縮されます。

-無制限のストレージ容量:どのようなクラウドを使用していても、必要なストレージをすべて購入できます。

-自動バックアップ/復元:クラウドバックアップは、企業のサーバー上のデータとアプリケーションをバックアップし、リモートサーバーに保存するサービスです。

3.クラウドコンピューティングのデメリット

-データセキュリティ:クラウドプロバイダーは堅牢なセキュリティ対策を実装していますが、機密データをクラウドに保存すると依然としてリスクが生じる可能性があります。

-コンプライアンス規定:業界によっては、クラウドに保存できるデータを制限する規制がある場合があります。

-停止の可能性:まれですが、クラウドサービスで停止が発生し、ダウンタイムが発生する可能性があります。

結論

LLMのローカル展開とパーソナライズされたデータによる微調整は複雑ですが、非常に価値のあるタスクであり、正しいハードウェア構成とソフトウェア環境構成がこの目標を達成するための鍵となります。

ハードウェア構成に関しては、予算とニーズに応じて適切なCPU、GPU、メモリ、ストレージデバイスを選択する必要があります。ソフトウェア環境の構成に関しては、独自のオペレーティングシステムに応じて、適切なプログラミング言語インタプリタ、深層学習フレームワーク、その他の必要なライブラリを選択する必要があります。

これらの課題にはいくつかの困難が伴うかもしれませんが、明確な目標があり、学習と実践に時間とエネルギーを投資する意欲がある限り、必ず成功します。

この記事が何かのヒントになれば幸いです。次回は環境展開の例を紹介します。

ご期待ください。

MetaQuotes Ltdにより英語から翻訳されました。

元の記事: https://www.mql5.com/en/articles/13495

警告: これらの資料についてのすべての権利はMetaQuotes Ltd.が保有しています。これらの資料の全部または一部の複製や再プリントは禁じられています。

この記事はサイトのユーザーによって執筆されたものであり、著者の個人的な見解を反映しています。MetaQuotes Ltdは、提示された情報の正確性や、記載されているソリューション、戦略、または推奨事項の使用によって生じたいかなる結果についても責任を負いません。

独自のLLMをEAに統合する(第2部):環境展開例

独自のLLMをEAに統合する(第2部):環境展開例

知っておくべきMQL5ウィザードのテクニック(第07回):樹状図

知っておくべきMQL5ウィザードのテクニック(第07回):樹状図

MQL5での価格バーの並べ替え

MQL5での価格バーの並べ替え

- 無料取引アプリ

- 8千を超えるシグナルをコピー

- 金融ニュースで金融マーケットを探索

ハードウェアとOSについては一般的な言葉だけで、デスクトップ・ウィジェットのベンチマークはあるが、モバイル・プロセッサは抽象的で、タスクには当てはまらない。

まるでAIが作成した記事のようだ。

LLMはONNXに変換できるのだろうか?)

可能だと 思う

RWKV-4の重さは1ギガ以下です。

ホームページ