Scikit-learn 라이브러리의 회귀 모델과 이 모델을 ONNX로 내보내기

ONNX(오픈 신경망 교환)은 머신러닝 모델을 설명하고 교환하기 위한 형식으로서 서로 다른 머신러닝 프레임워크 간에 모델을 전송할 수 있는 기능을 제공합니다. 딥 러닝과 신경망에서는 float32와 같은 데이터 유형이 자주 사용됩니다. 일반적으로 딥러닝 모델 학습에 적합한 정확도와 효율성을 제공하기 때문에 널리 적용됩니다.

일부 고전적인 머신러닝 모델은 ONNX 연산자로 표현하기 어렵습니다. 따라서 ONNX에서 이를 구현하기 위해 연산자 (ai.onnx.ml)가 추가로 도입되었습니다. ONNX 사양에 따르면 이 집합의 키 연산자 )는 다양한 유형의 입력 데이터(tensor(float), tensor(double), tensor(int64), tensor(int32))를 받을 수 있지만 항상 출력시에는 tensor(float) 유형을 반환한다는 점에 주목할 필요가 있습니다. 이러한 연산자를 매개변수화 할때도 부동 소수점 수를 사용하여 수행 되므로 특히 원래 모델의 매개변수를 정의하는 데 배정밀도 수를 사용한 경우 계산의 정확도가 제한될 수 있습니다.

이로 인해 ONNX에서 데이터를 변환하고 처리하는 과정에서 모델을 변환하거나 다른 데이터 유형을 사용할 때 정확도가 떨어질 수 있습니다. 나중에 살펴보겠지만 일부 모델은 이러한 제한을 우회하고 ONNX 모델의 완전한 휴대성을 보장하여 정확도를 잃지 않고 이중 정밀도로 작업할 수 있습니다. 특히 데이터 표현의 정확성이 중요한 경우에는 ONNX에서 모델과 그 표현으로 작업할 때 이러한 특성을 고려하는 것이 중요합니다.

Scikit-learn은 파이썬 커뮤니티에서 가장 인기 있고 널리 사용되는 머신 러닝 라이브러리 중 하나이며 다양한 알고리즘, 사용자 친화적인 인터페이스, 훌륭한 설명서를 제공합니다. 이전 문서인 "Scikit-learn 라이브러리의 분류 모델 및 ONNX로 내보내기"는 분류 모델에 대해 다루었습니다.

이 글에서 우리는 Scikit-learn 패키지의 회귀 모델의 적용에 대해 살펴보고 테스트 데이터 세트에 대해 배정밀도로 파라미터를 계산하고 이를 부동 소수점 및 배정밀도를 위한 ONNX 형식으로 변환하고 이렇게 얻은 모델을 MQL5의 프로그램에서 사용하는 방법에 대해 알아볼 것입니다. 또한 부동 소수점 및 배정밀도 정확도에 대해 원본 모델과 ONNX 버전의 정확도를 비교합니다. 또한 회귀 모델의 내부 구조와 작동을 더 잘 이해할 수 있도록 회귀 모델의 ONNX 표현을 살펴볼 것입니다.

내용

- 귀찮으시다면 기고해 주세요.

- 1. 테스트 데이터 세트

테스트 데이터 집합을 표시하는 스크립트 - 2. 회귀 모델

2.0. Scikit-learn 회귀 모델 목록 - 2.1. ONNX 모델로 변환하는 Scikit 학습 회귀 모델 float 및 double

- 2.1.1. sklearn.linear_model.ARDRegression

2.1.1.1. ARDRegression 생성 코드

2.1.1.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.1.3. ard_regression_float.onnx 및 ard_regression_double.onnx의 ONNX 표현 - 2.1.2. sklearn.linear_model.BayesianRidge

2.1.2.1. BayesianRidge 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.2.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.2.3. 베이시안_릿지_플로트.onnx 및 베이시안_릿지_더블.onnx의 ONNX 표현 - 2.1.3. sklearn.linear_model.ElasticNet

2.1.3.1. ElasticNet 모델을 생성하고 float 및 double을 위해 ONNX로 내보내는 코드

2.1.3.2. ONNX 모델 실행을 위한 MQL5 코드

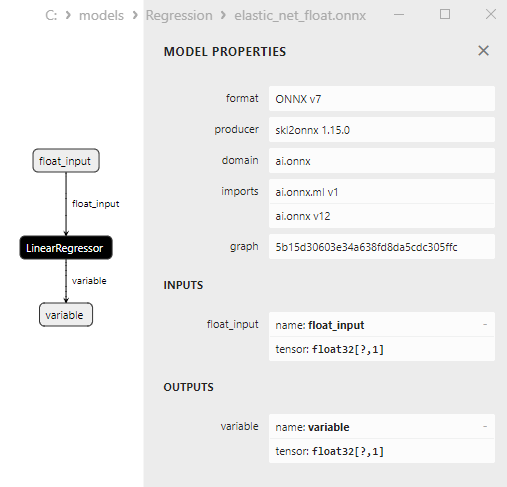

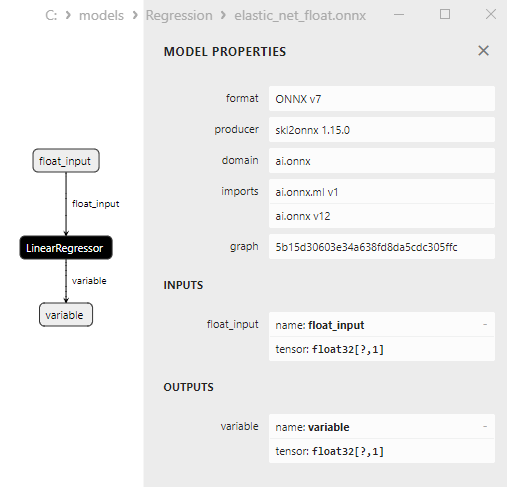

2.1.3.3. elastic_net_float.onnx 및 elastic_net_double.onnx의 ONNX 표현 - 2.1.4. sklearn.linear_model.ElasticNetCV

2.1.4.1. ElasticNet 모델을 생성하고 float 및 double을 위해 ONNX로 내보내는 코드

2.1.4.2. ONNX 모델 실행을 위한 MQL5 코드

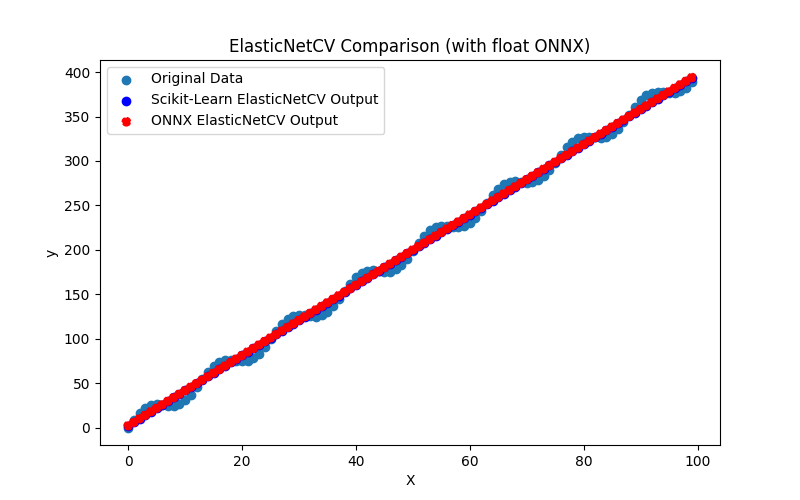

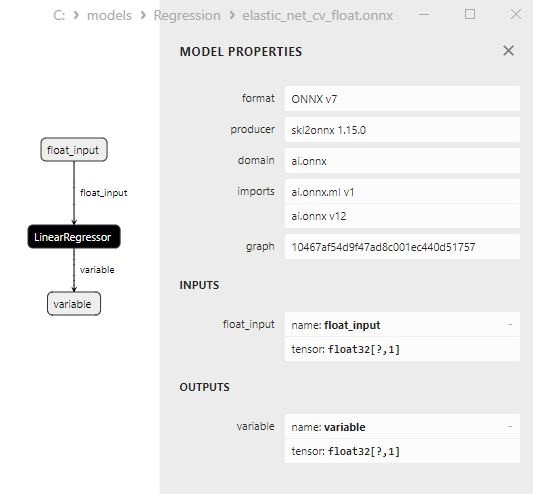

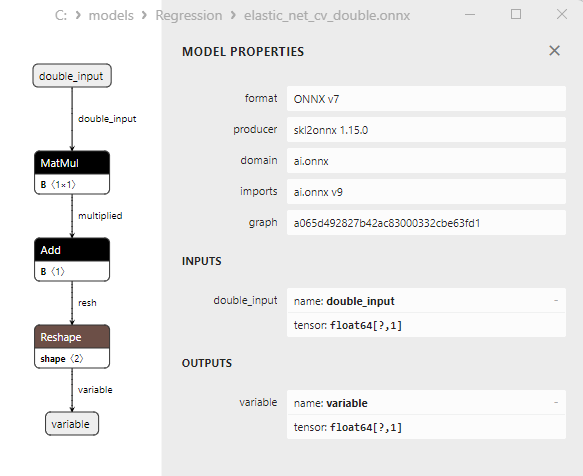

2.1.4.3. elastic_net_cv_float.onnx 및 elastic_net_cv_double.onnx의 ONNX 표현 - 2.1.5. sklearn.linear_model.HuberRegressor

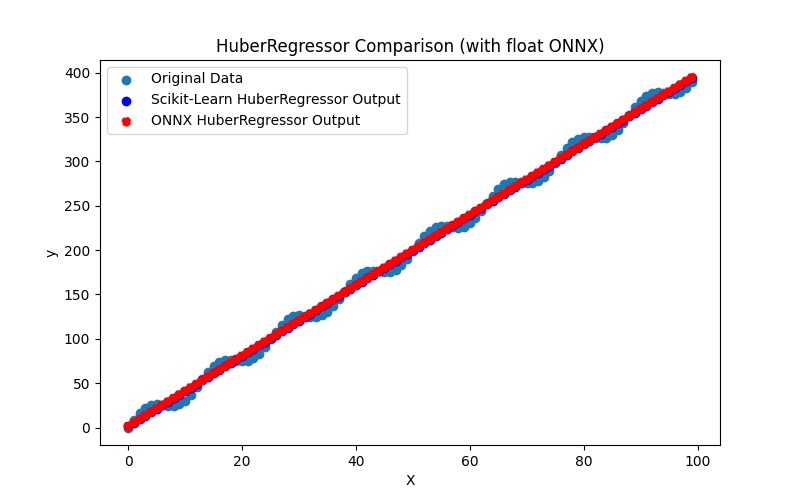

2.1.5.1. HuberRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.5.2. ONNX 모델 실행을 위한 MQL5 코드

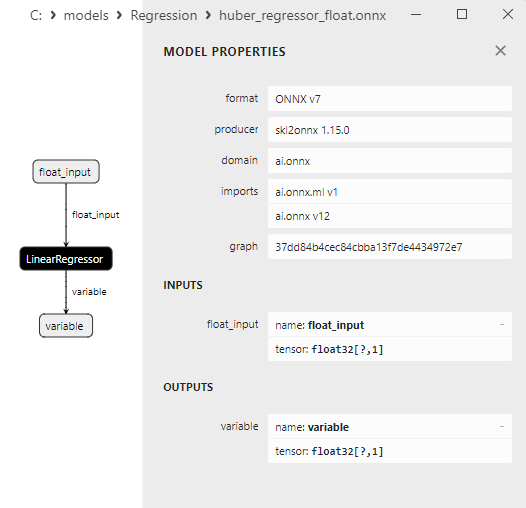

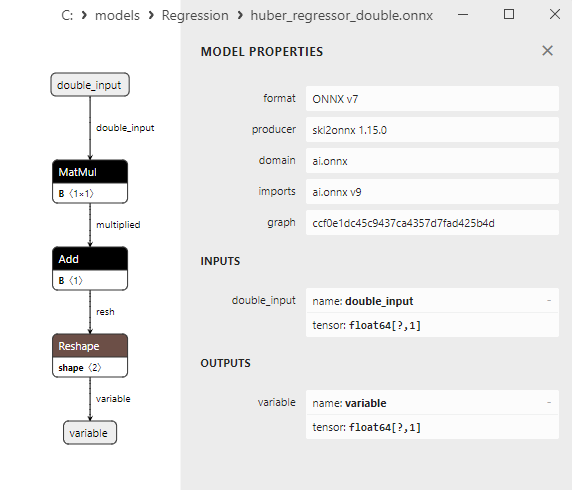

2.1.5.3. huber_regressor_float.onnx 및 huber_regressor_double.onnx의 ONNX 표현 - 2.1.6. sklearn.linear_model.Lars

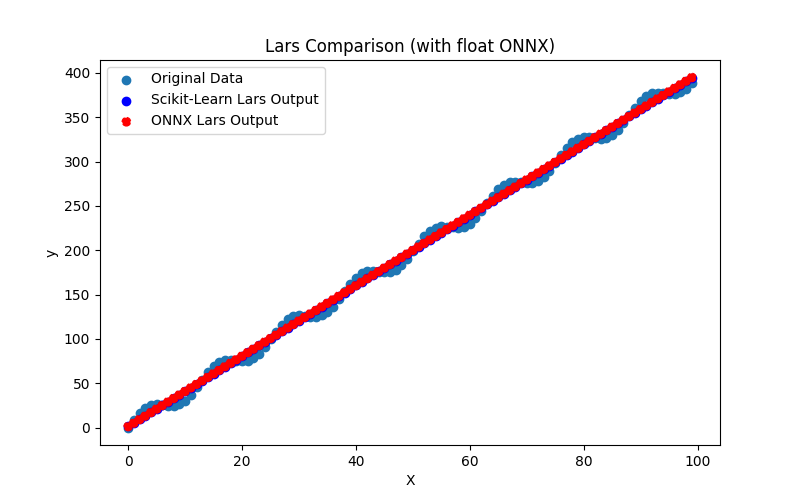

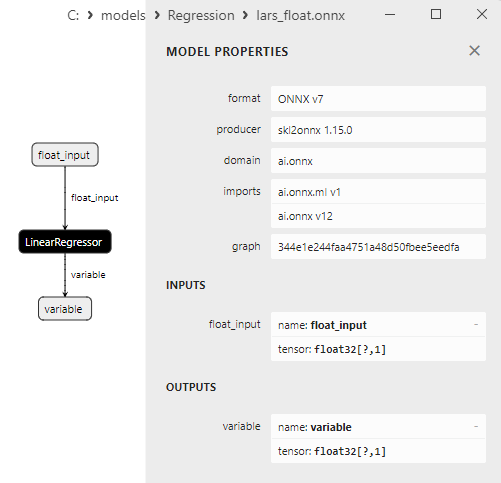

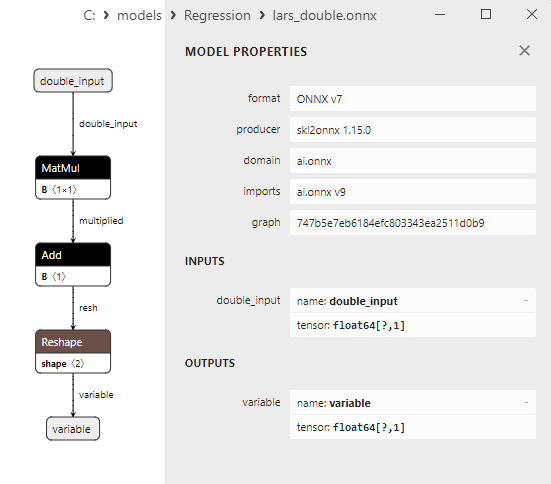

2.1.6.1. Lars 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.6.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.6.3. lars_float.onnx 및 lars_double.onnx의 ONNX 표현 - 2.1.7. sklearn.linear_model.LarsCV

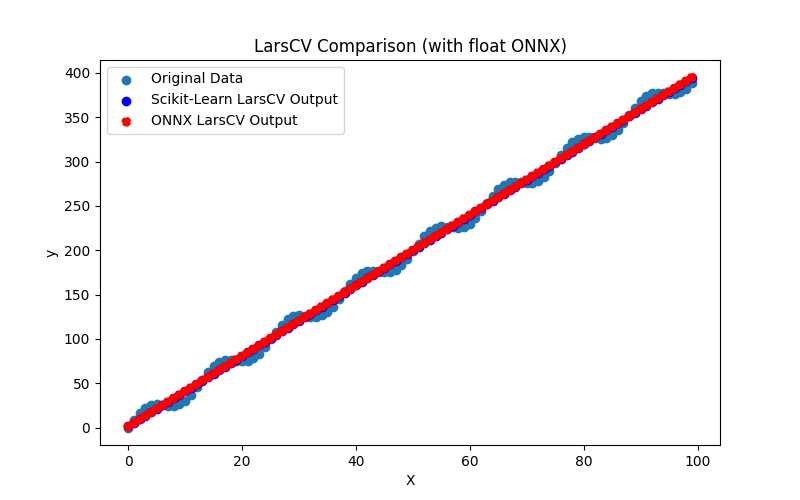

2.1.7.1. LarsCV 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.7.2. ONNX 모델 실행을 위한 MQL5 코드

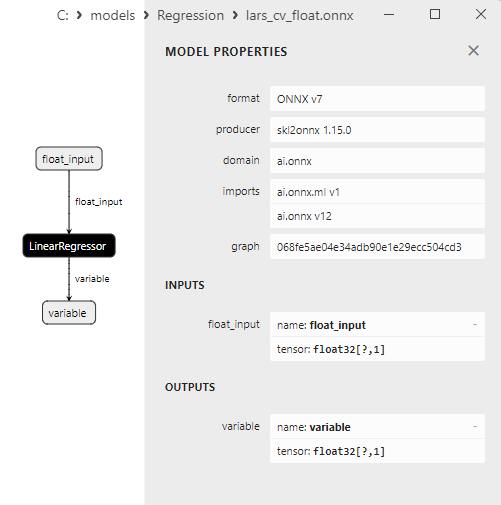

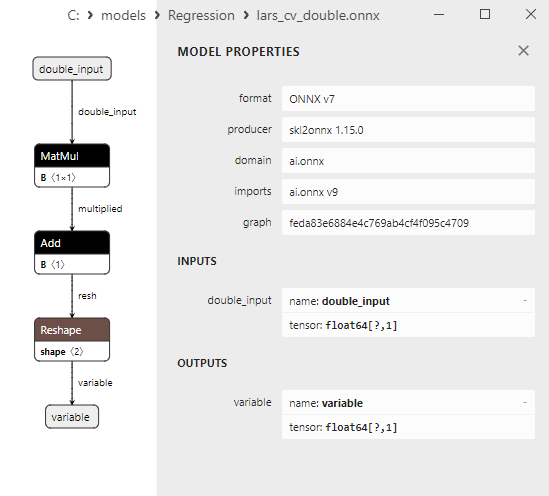

2.1.7.3. lars_cv_float.onnx 및 lars_cv_double.onnx의 ONNX 표현 - 2.1.8. sklearn.linear_model.Lasso

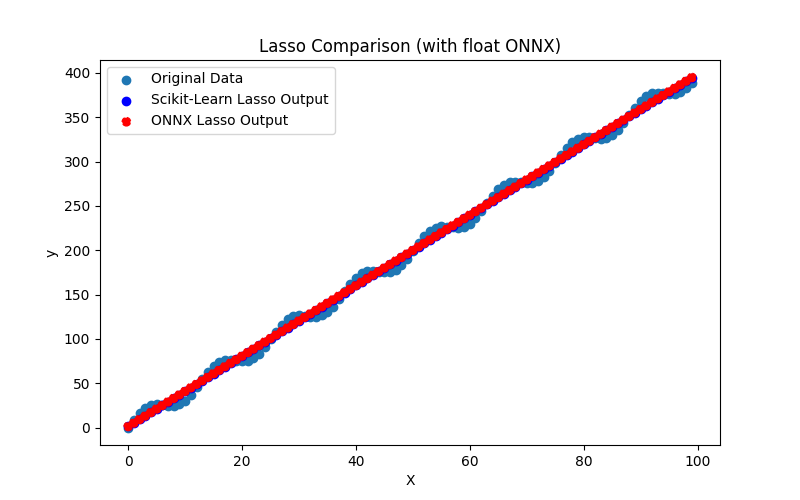

2.1.8.1. Lasso 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.8.2. ONNX 모델 실행을 위한 MQL5 코드

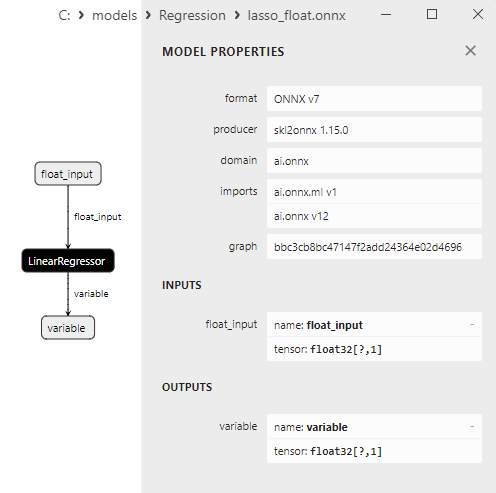

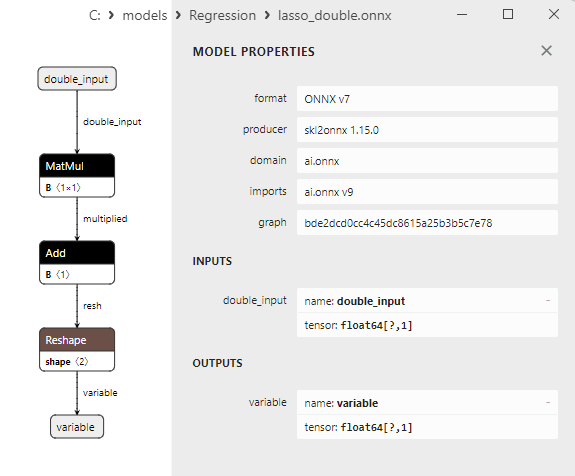

2.1.8.3. lasso_float.onnx 및 lasso_double.onnx의 ONNX 표현 - 2.1.9. sklearn.linear_model.LassoCV

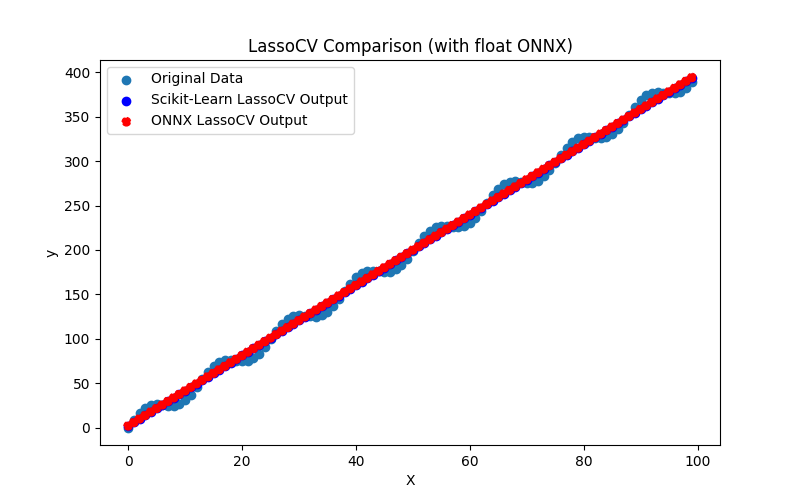

2.1.9.1. LassoCV 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.9.2. ONNX 모델 실행을 위한 MQL5 코드

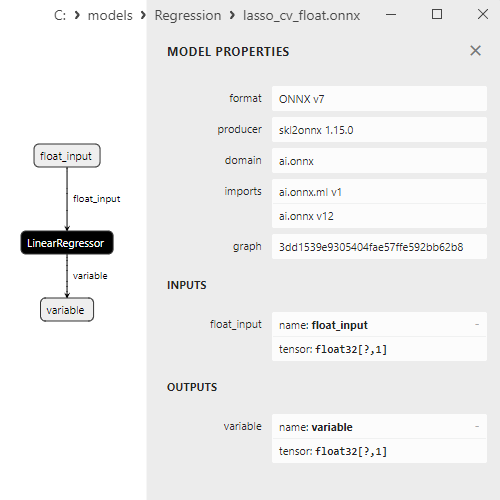

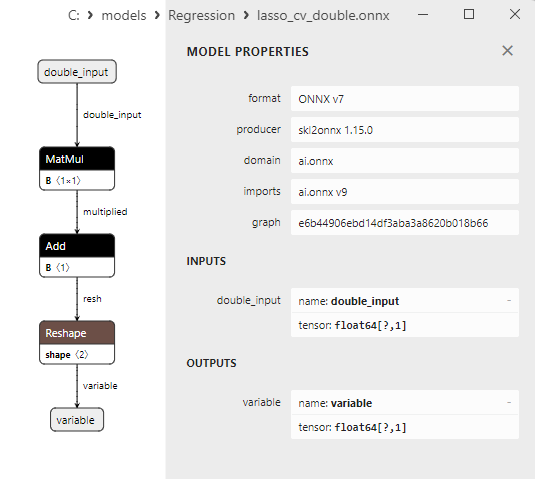

2.1.9.3. lasso_cv_float.onnx 및 lasso_cv_double.onnx의 ONNX 표현 - 2.1.10. sklearn.linear_model.LassoLars

2.1.10.1. LassoLars 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.10.2. ONNX 모델 실행을 위한 MQL5 코드

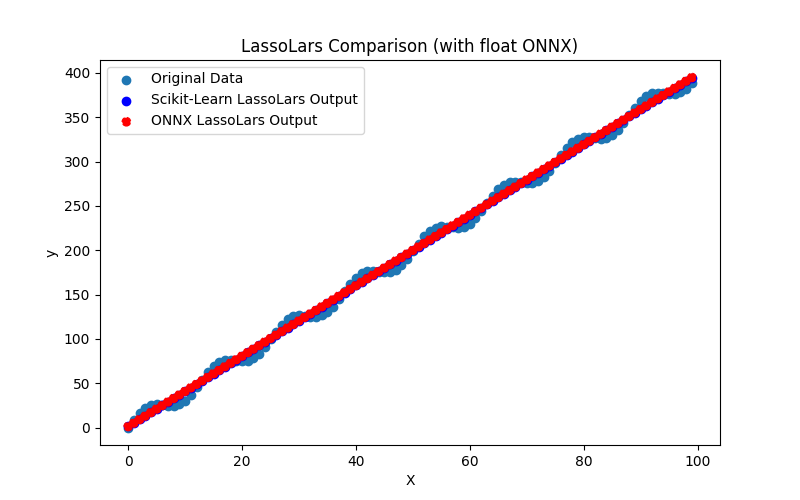

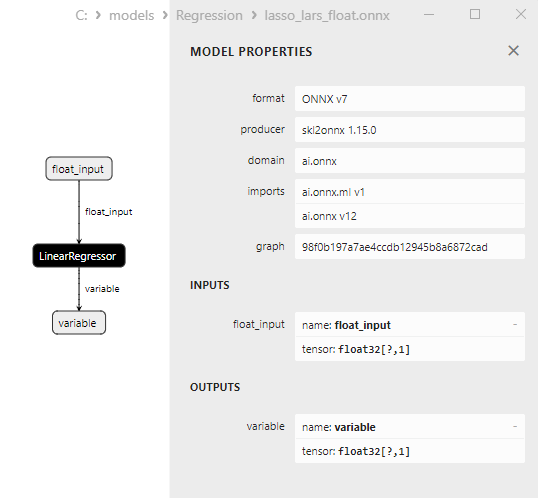

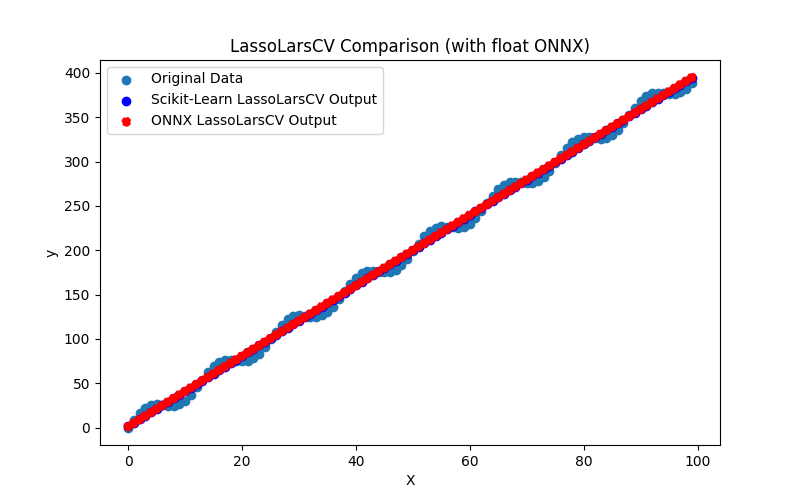

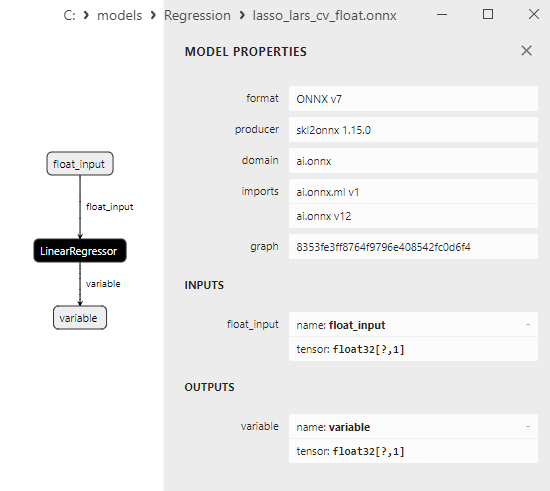

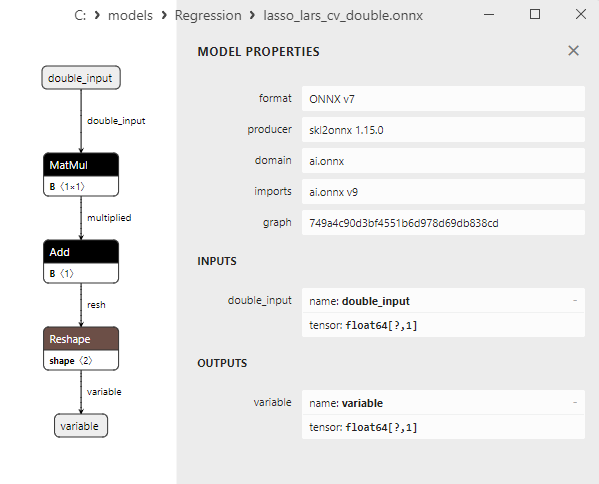

2.1.10.3. lasso_lars_float.onnx 및 lasso_lars_double.onnx의 ONNX 표현 - 2.1.11. sklearn.linear_model.LassoLarsCV

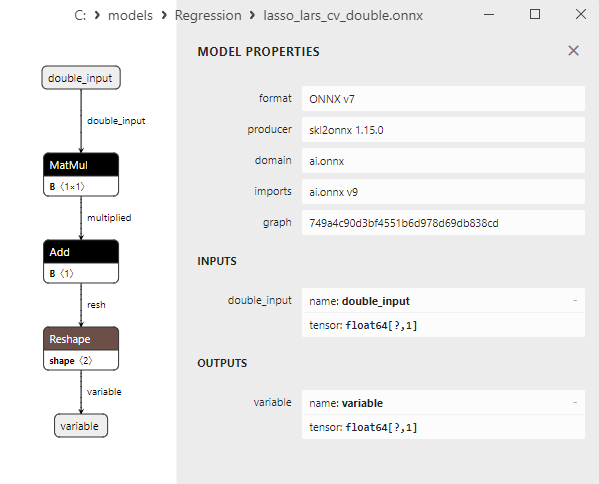

2.1.11.1. LassoLarsCV 모델을 생성하고 float 및 double용으로 ONNX로 내보내기 위한 코드

2.1.11.2. ONNX 모델 실행을 위한 MQL5 코드

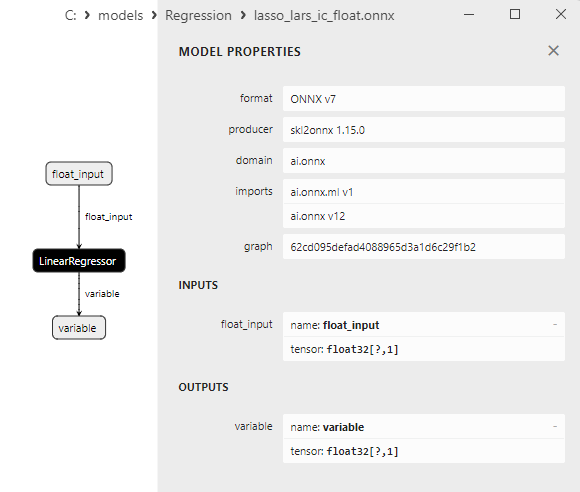

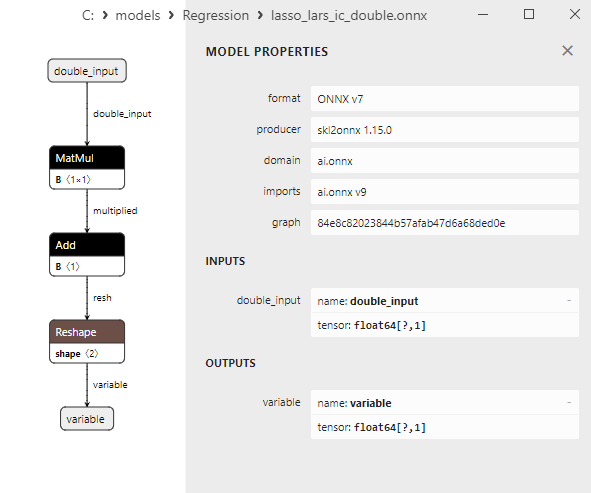

2.1.11.3. lasso_lars_cv_float.onnx 및 lasso_lars_cv_double.onnx의 ONNX 표현 - 2.1.12. sklearn.linear_model.LassoLarsIC

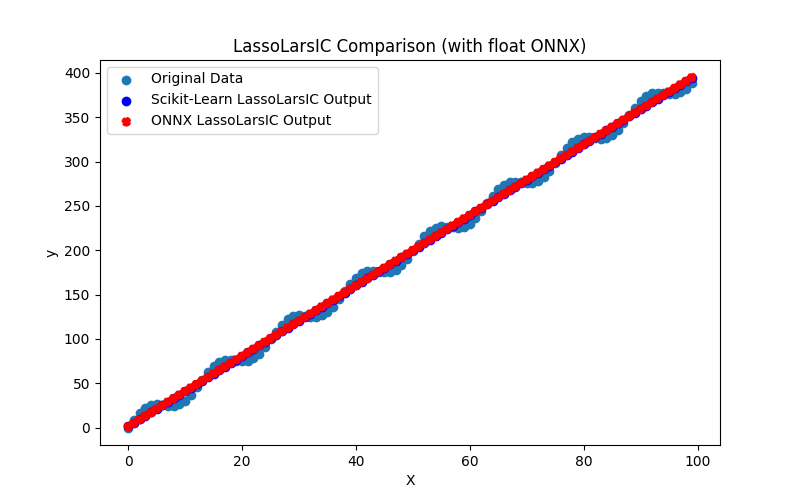

2.1.12.1. LassoLarsIC 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.12.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.12.3. lasso_lars_ic_float.onnx 및 lasso_lars_ic_double.onnx의 ONNX 표현 - 2.1.13. sklearn.linear_model.LinearRegression

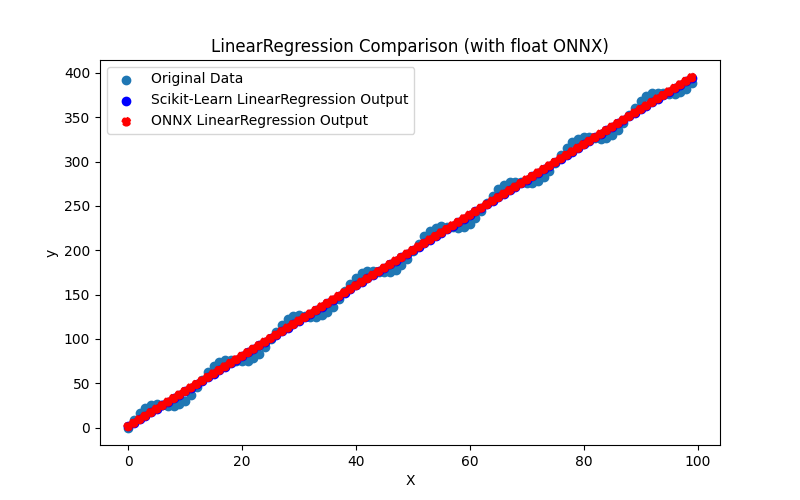

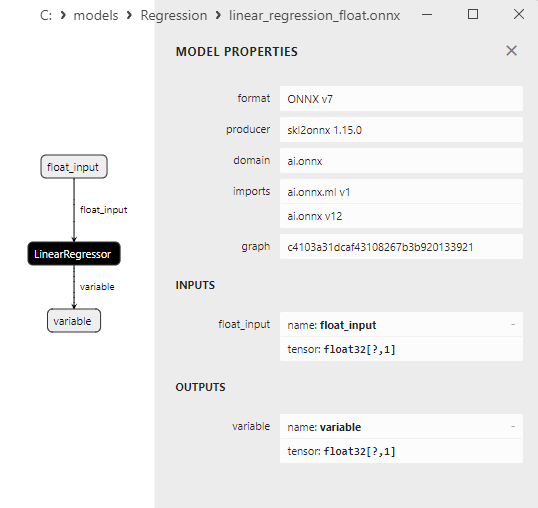

2.1.13.1. LinearRegression 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.13.2. ONNX 모델 실행을 위한 MQL5 코드

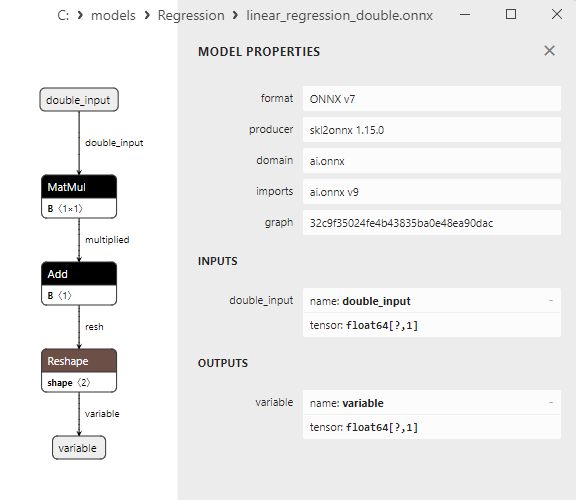

2.1.13.3. linear_regression_float.onnx 및 linear_regression_double.onnx의 ONNX 표현 - 2.1.14. sklearn.linear_model.Ridge

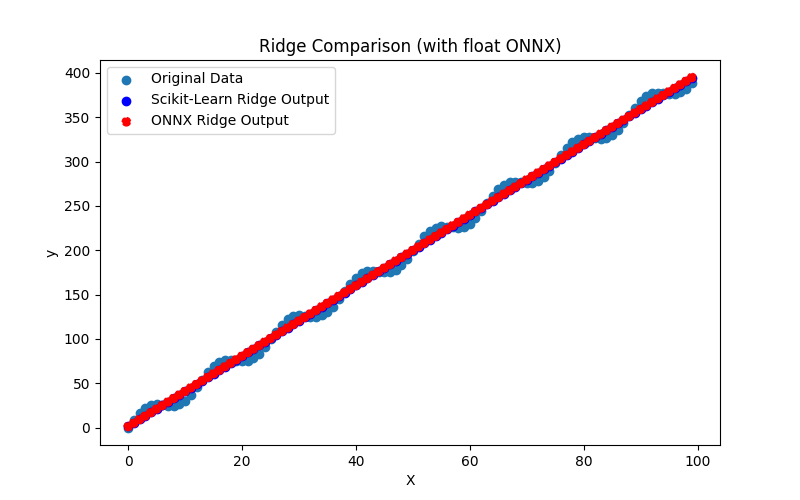

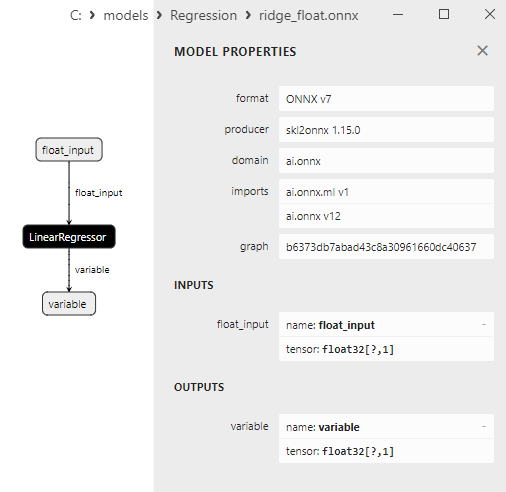

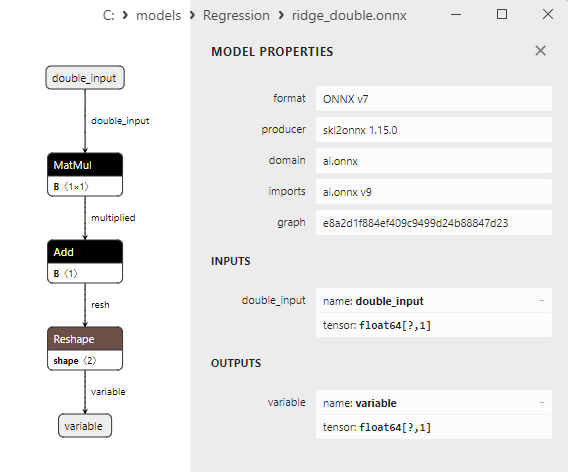

2.1.14.1. Ridge 모델을 생성하고 float 및 double을 위해 ONNX로 내보내기 위한 코드

2.1.14.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.14.3. 릿지_플로트.onnx 및 릿지_더블.onnx의 ONNX 표현 - 2.1.15. sklearn.linear_model.RidgeCV

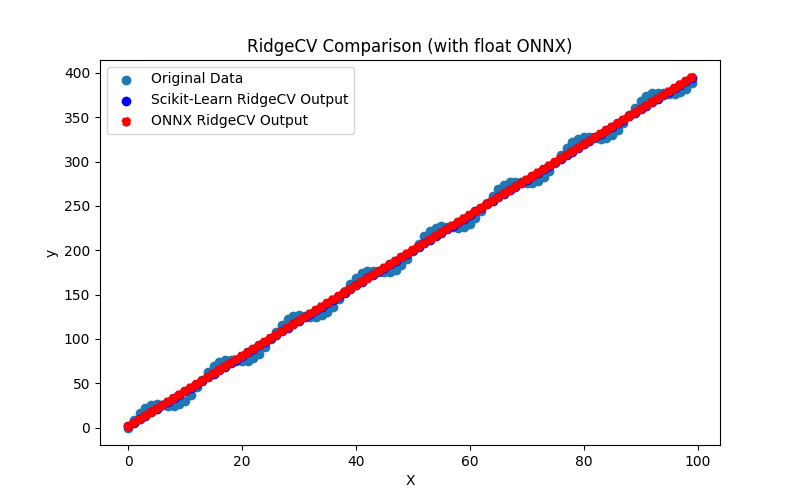

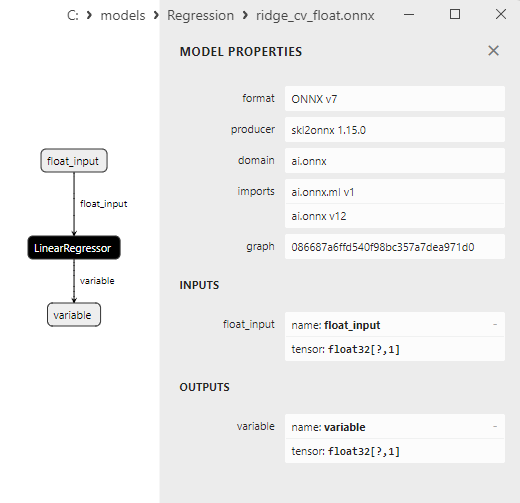

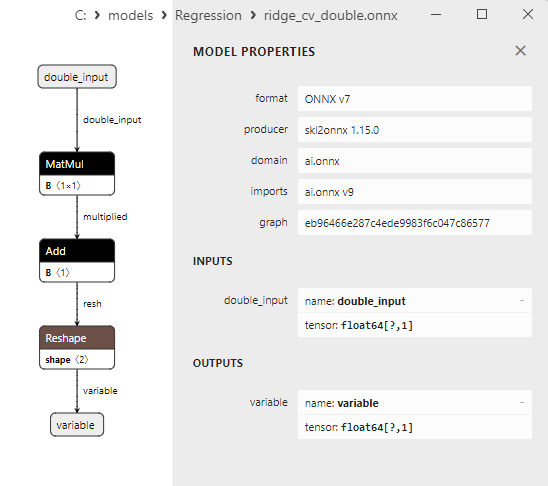

2.1.15.1. RidgeCV 모델을 생성하고 float 및 double을 위해 ONNX로 내보내기 위한 코드

2.1.15.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.15.3. ridge_cv_float.onnx 및 ridge_cv_double.onnx의 ONNX 표현 - 2.1.16. sklearn.linear_model.OrthogonalMatchingPursuit

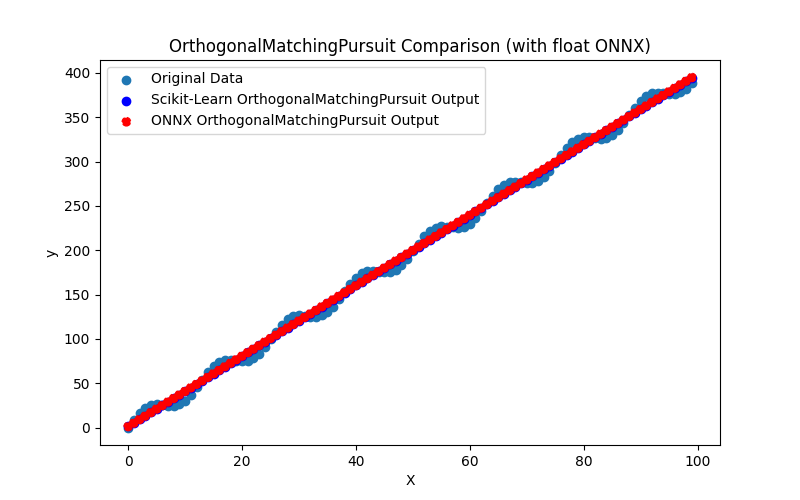

2.1.16.1. OrthogonalMatchingPursuit 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.16.2. ONNX 모델 실행을 위한 MQL5 코드

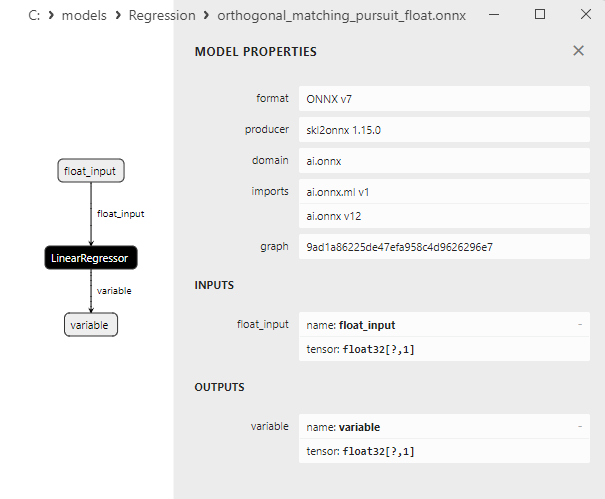

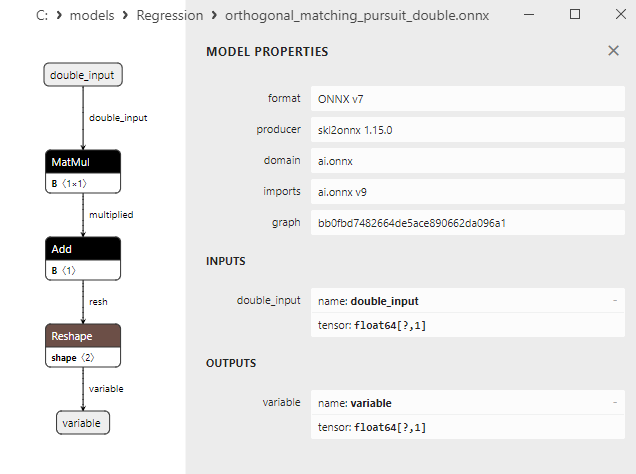

2.1.16.3. orthogonal_matching_pursuit_float.onnx 및 orthogonal_matching_pursuit_double.onnx의 ONNX 표현 - 2.1.17. sklearn.linear_model.PassiveAggressiveRegressor

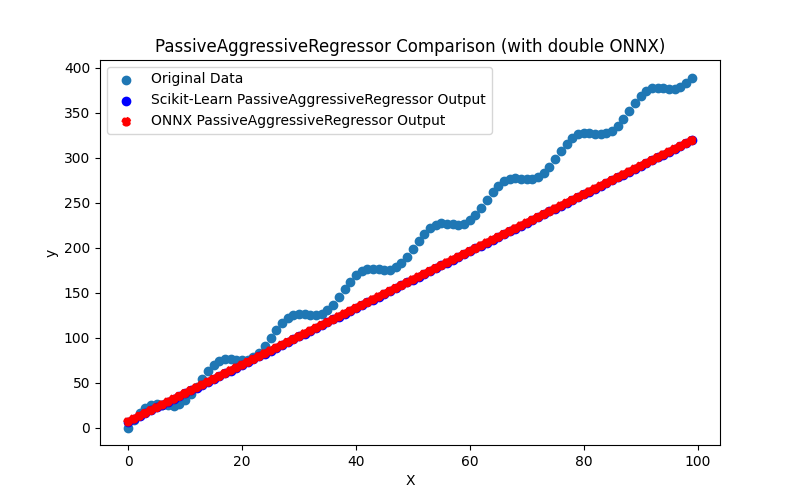

2.1.17.1. float 및 double용 PassiveAgressiveRegressor 모델을 생성하고 이를 ONNX로 내보내기 위한 코드

2.1.17.2. ONNX 모델 실행을 위한 MQL5 코드

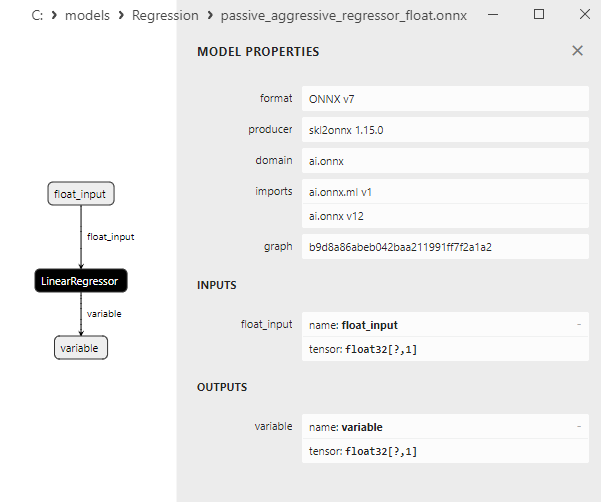

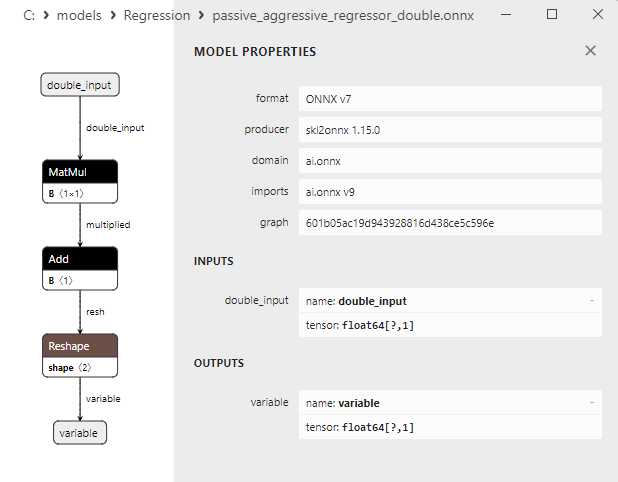

2.1.17.3. passive_aggressive_regressor_float.onnx 및 passive_aggressive_regressor_double.onnx의 ONNX 표현 - 2.1.18. sklearn.linear_model.QuantileRegressor

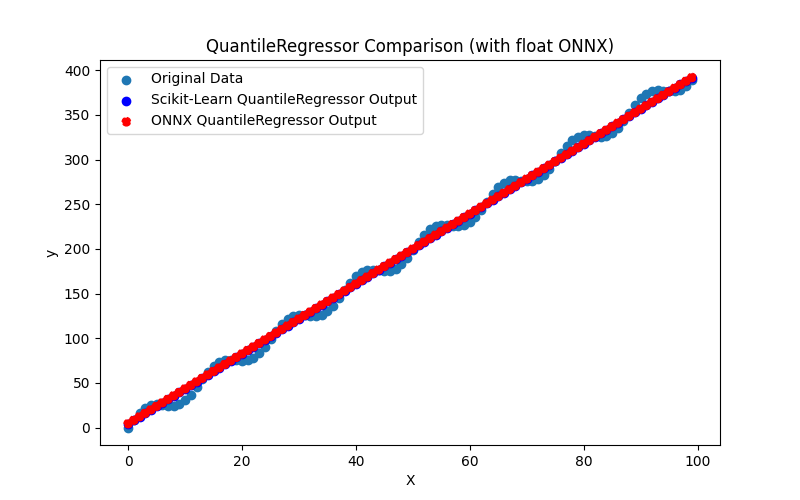

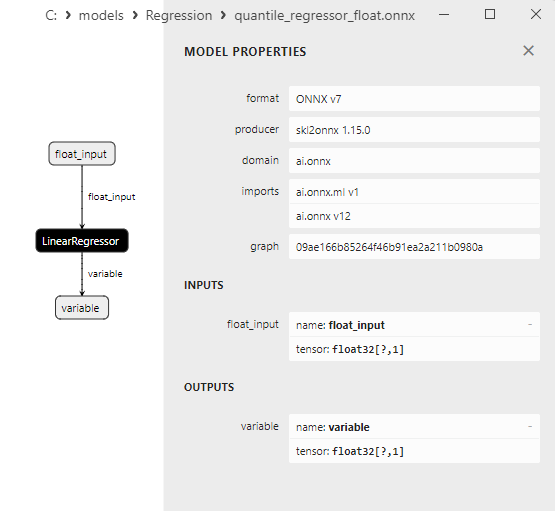

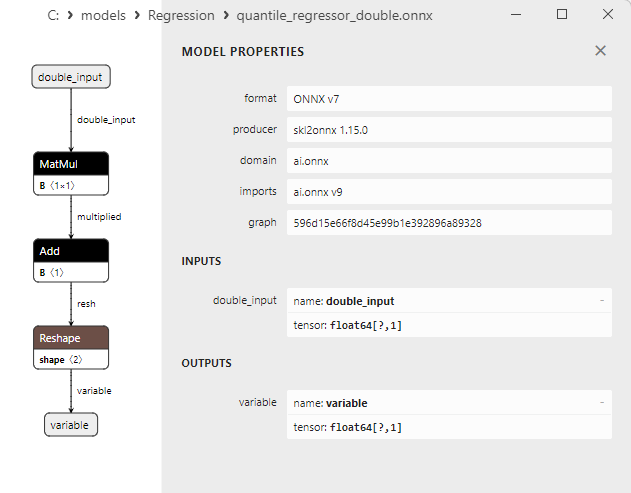

2.1.18.1. QuantileRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내는 코드

2.1.18.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.18.3. quantile_regressor_float.onnx 및 quantile_regressor_double.onnx의 ONNX 표현 - 2.1.19. sklearn.linear_model.RANSACRegressor

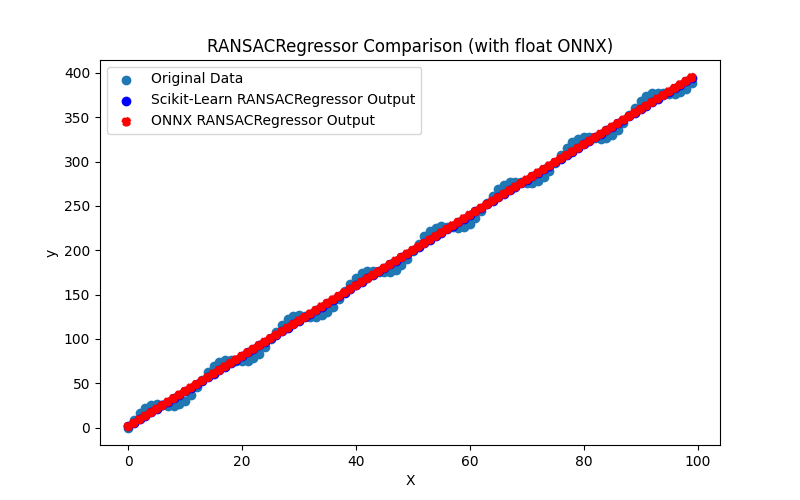

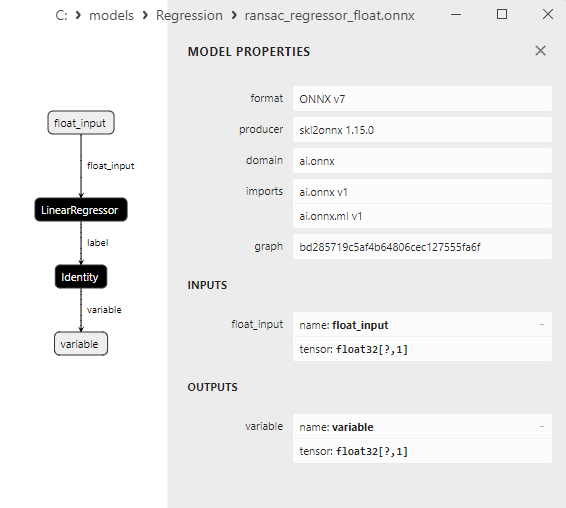

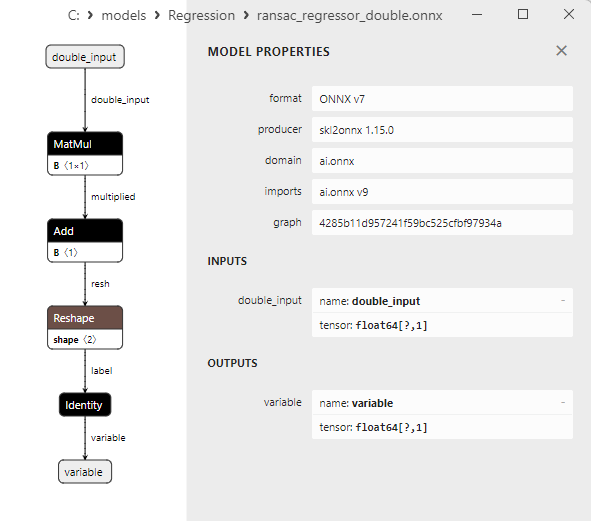

2.1.19.1. RANSACRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.19.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.19.3. ransac_regressor_float.onnx 및 ransac_regressor_double.onnx의 ONNX 표현 - 2.1.20. sklearn.linear_model.TheilSenRegressor

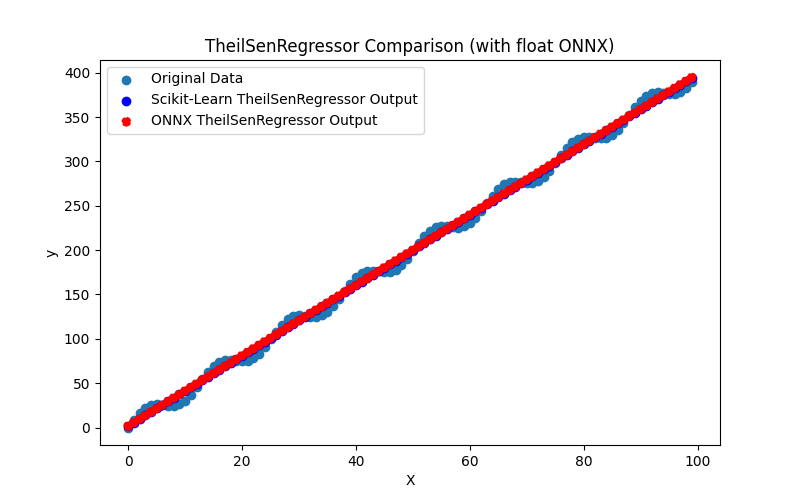

2.1.20.1. TheilSenRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.20.2. ONNX 모델 실행을 위한 MQL5 코드

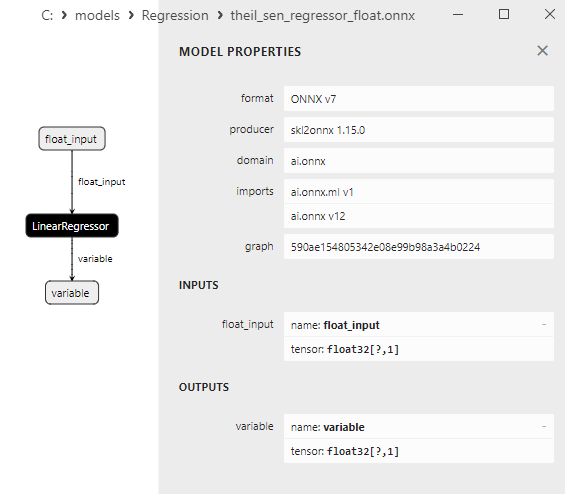

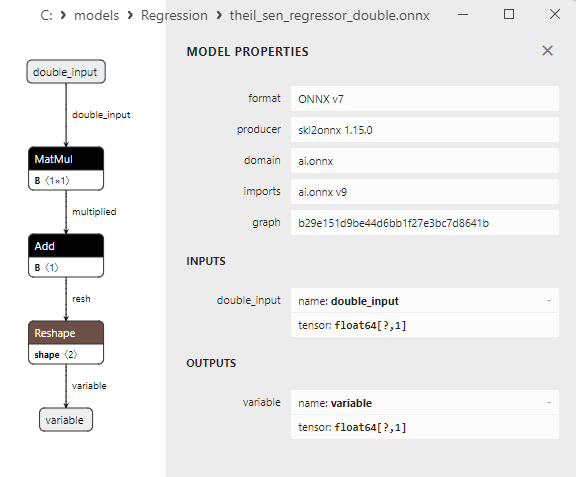

2.1.20.3. theil_sen_regressor_float.onnx 및 theil_sen_regressor_double.onnx의 ONNX 표현 - 2.1.21. sklearn.linear_model.LinearSVR

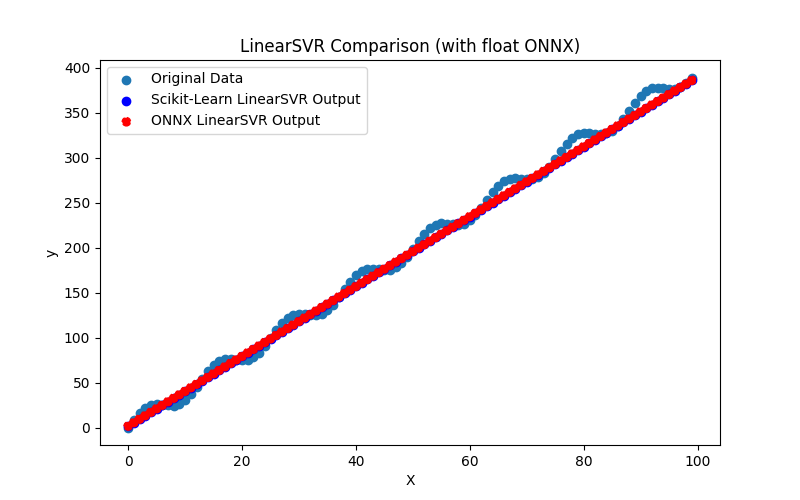

2.1.21.1. LinearSVR 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.21.2. ONNX 모델 실행을 위한 MQL5 코드

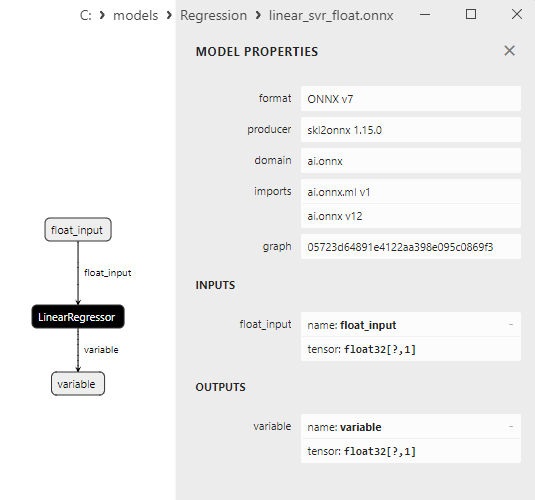

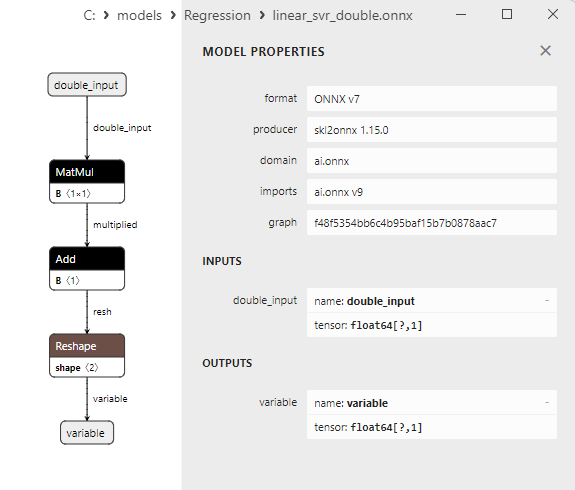

2.1.21.3. linear_svr_float.onnx 및 linear_svr_double.onnx의 ONNX 표현 - 2.1.22. sklearn.linear_model.MLPRegressor

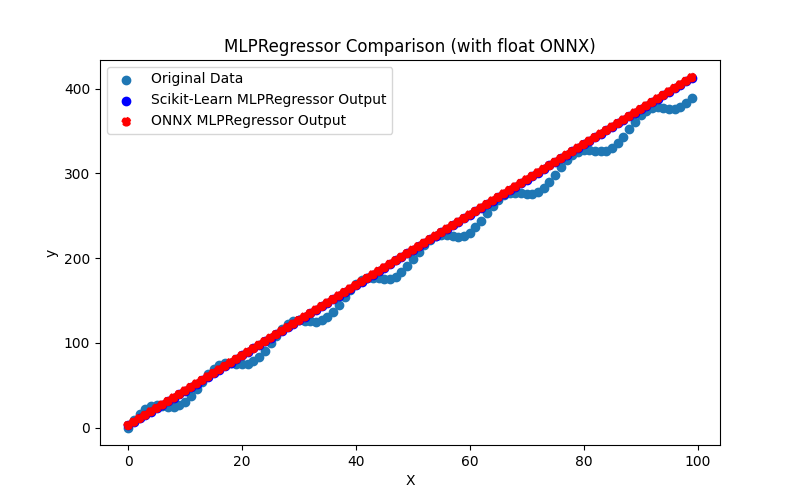

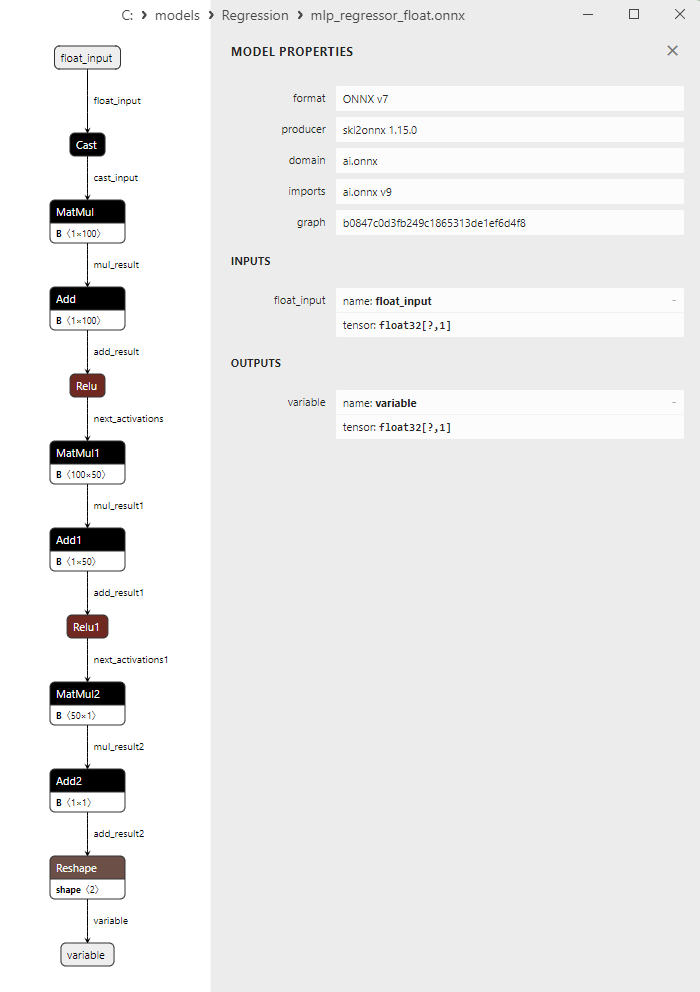

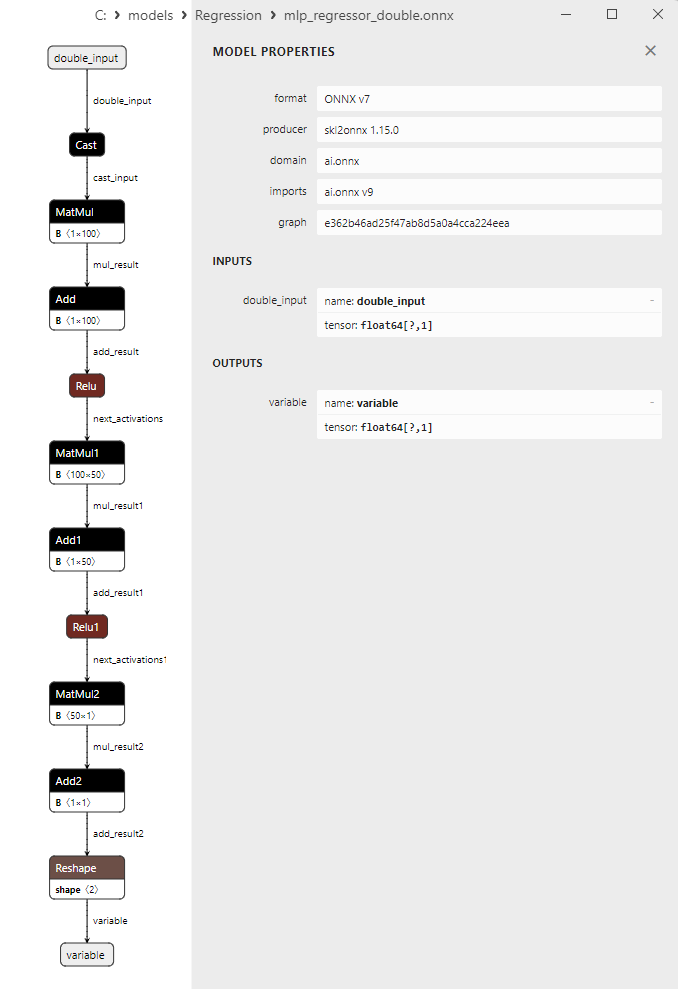

2.1.22.1. MLPRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.22.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.22.3. mlp_regressor_float.onnx 및 mlp_regressor_double.onnx의 ONNX 표현 - 2.1.23. sklearn.cross_decomposition.PLSRegression

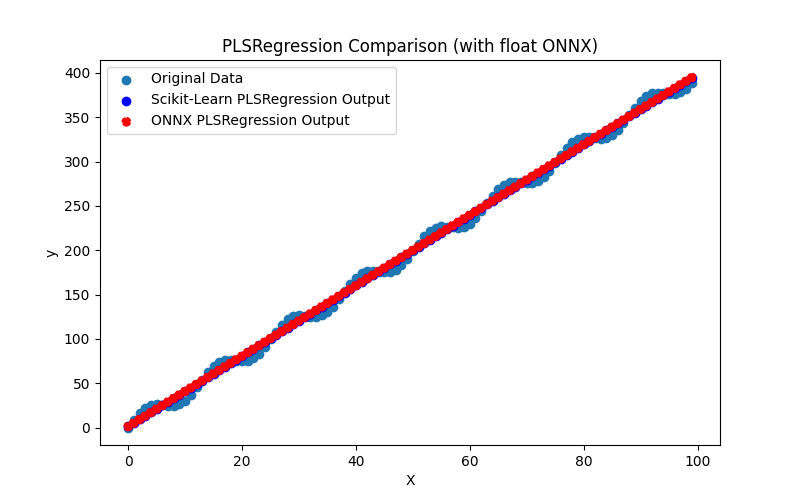

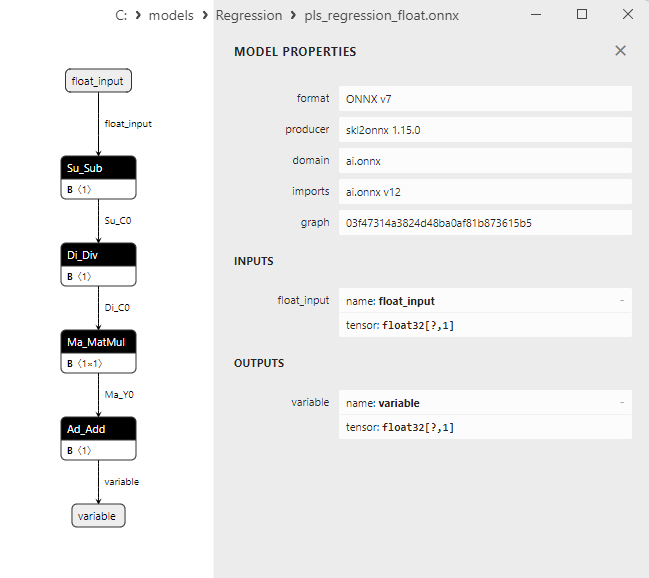

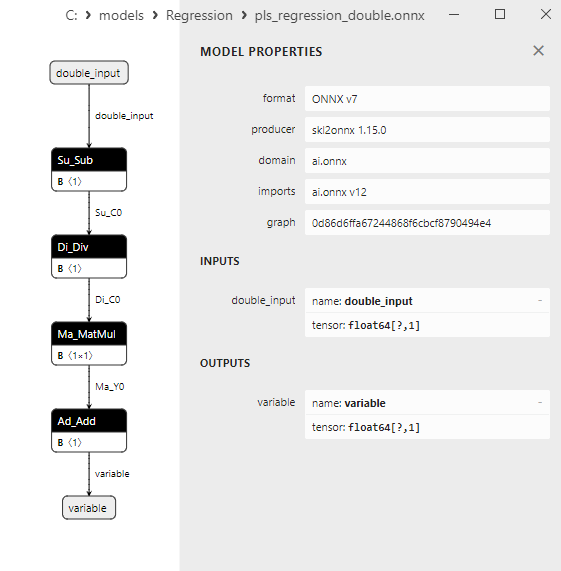

2.1.23.1. float 및 double용PLSRegression 모델을 생성하고 이를 ONNX로 내보내기 위한 코드

2.1.23.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.23.3. pls_regression_float.onnx 및 pls_regression_double.onnx의 ONNX 표현 - 2.1.24. sklearn.linear_model.TweedieRegressor

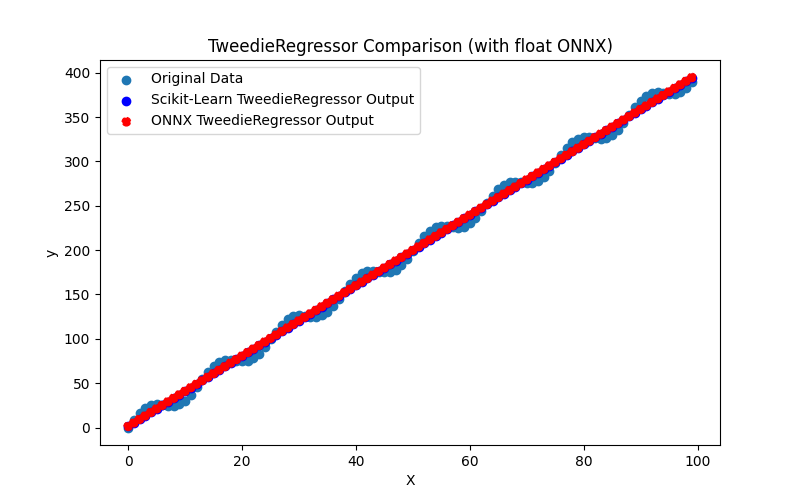

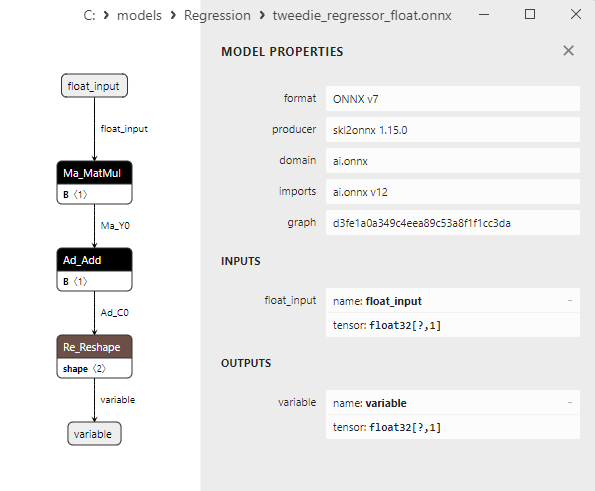

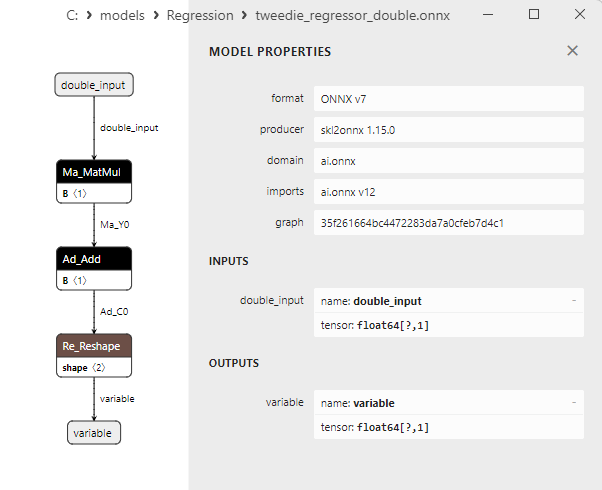

2.1.24.1. TweedieRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.24.2. ONNX 모델 실행을 위한 MQL5 코드

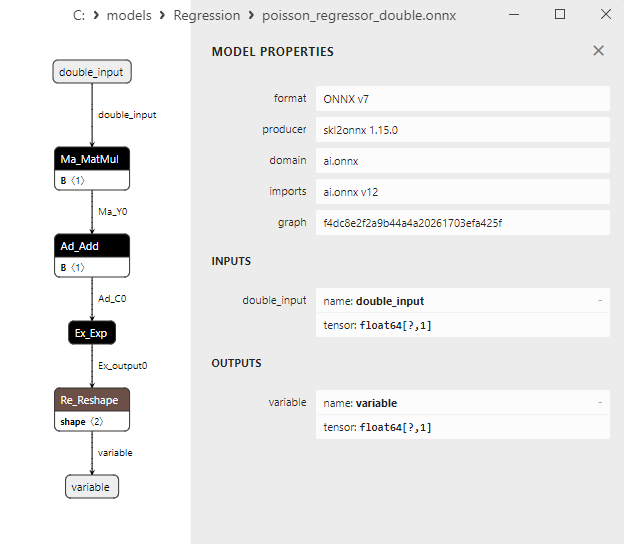

2.1.24.3. tweedie_regressor_float.onnx 및 tweedie_regressor_double.onnx의 ONNX 표현 - 2.1.25. sklearn.linear_model.PoissonRegressor

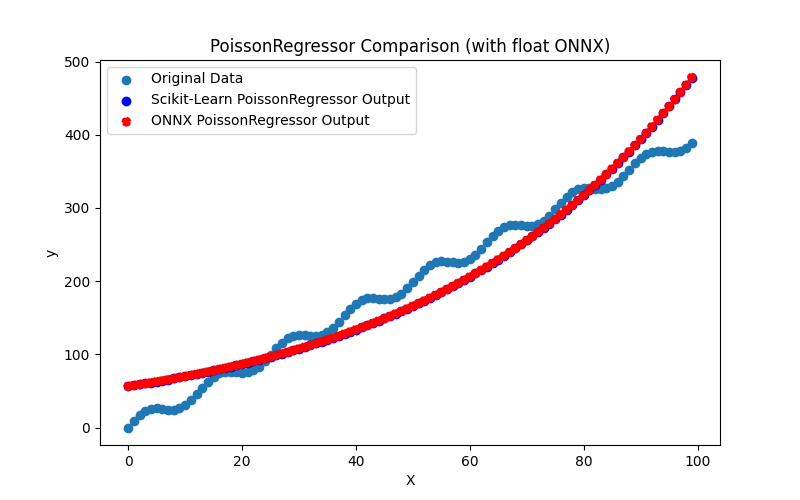

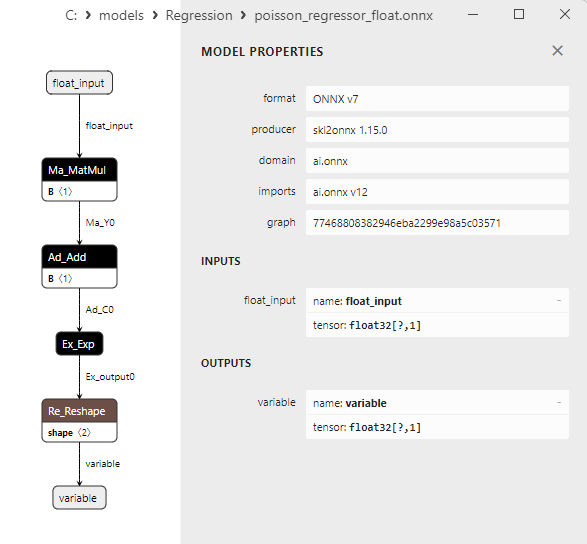

2.1.25.1. 포아송 회귀 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.25.2. ONNX 모델 실행을 위한 MQL5 코드

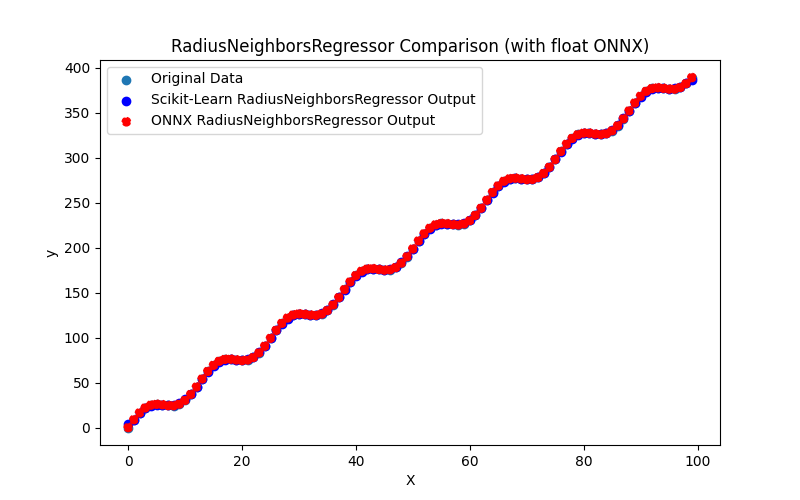

2.1.25.3. poisson_regressor_float.onnx 및 poisson_regressor_double.onnx의 ONNX 표현 - 2.1.26. sklearn.neighbors.RadiusNeighborsRegressor

2.1.26.1. RadiusNeighborsRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내는 코드

2.1.26.2. ONNX 모델 실행을 위한 MQL5 코드

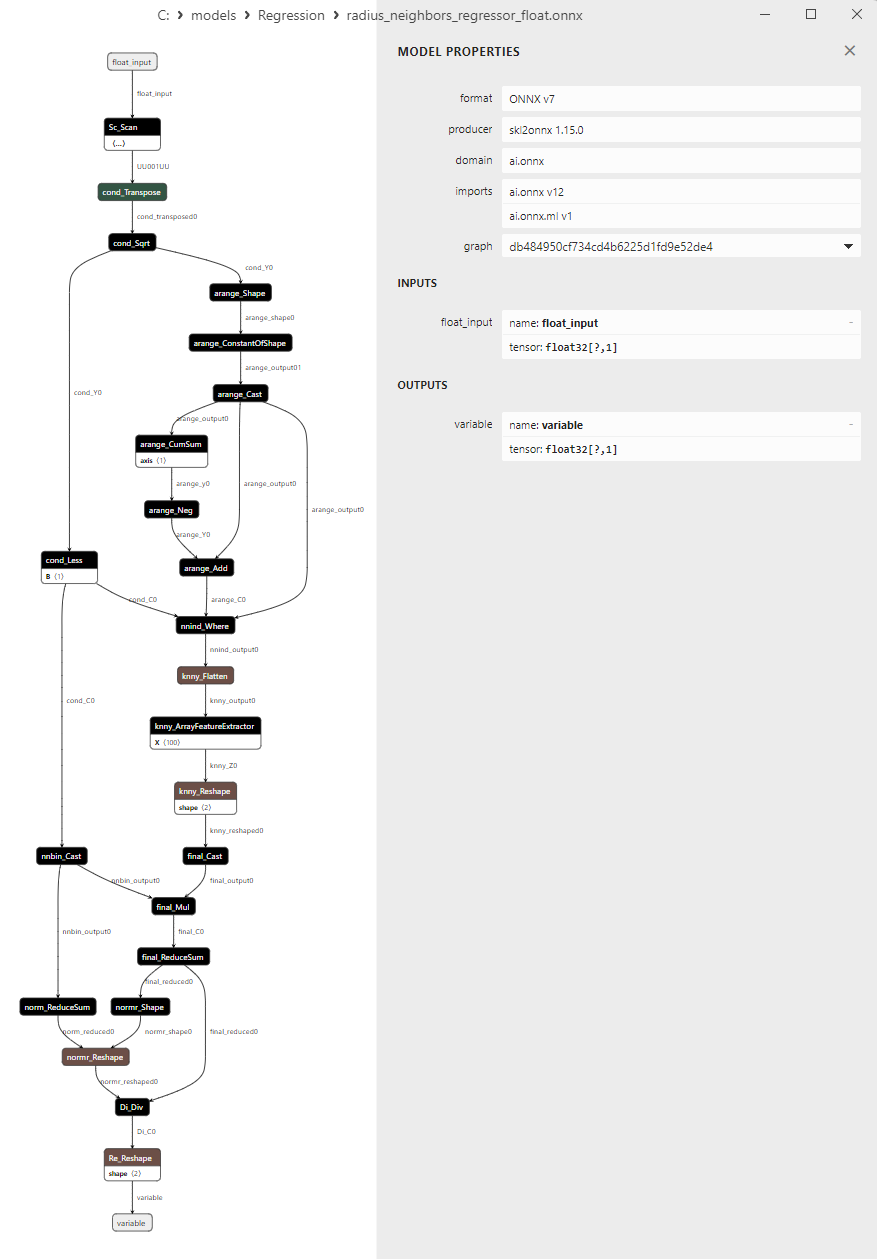

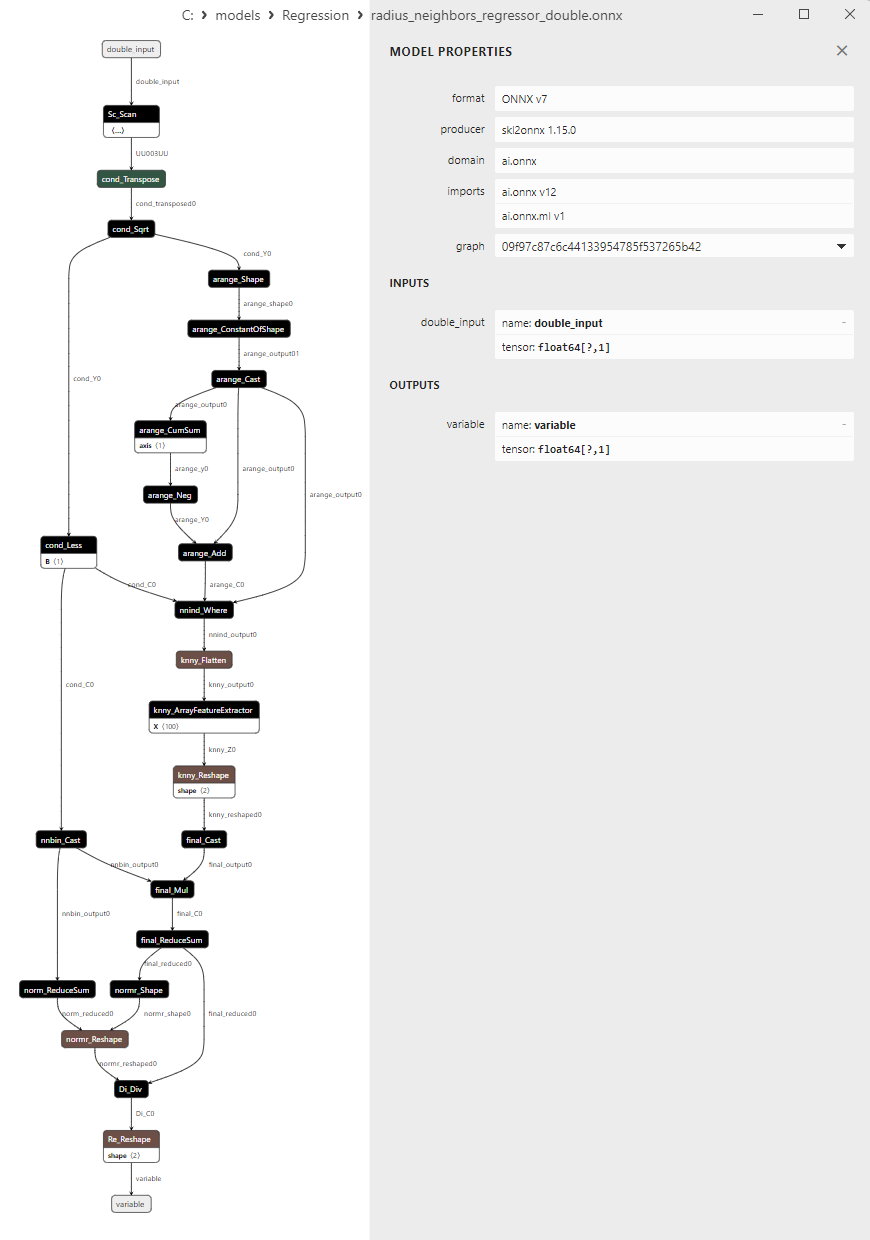

2.1.26.3. radius_neighbors_regressor_float.onnx 및 radius_neighbors_regressor_double.onnx의 ONNX 표현입니다. - 2.1.27. sklearn.neighbors.KNeighborsRegressor

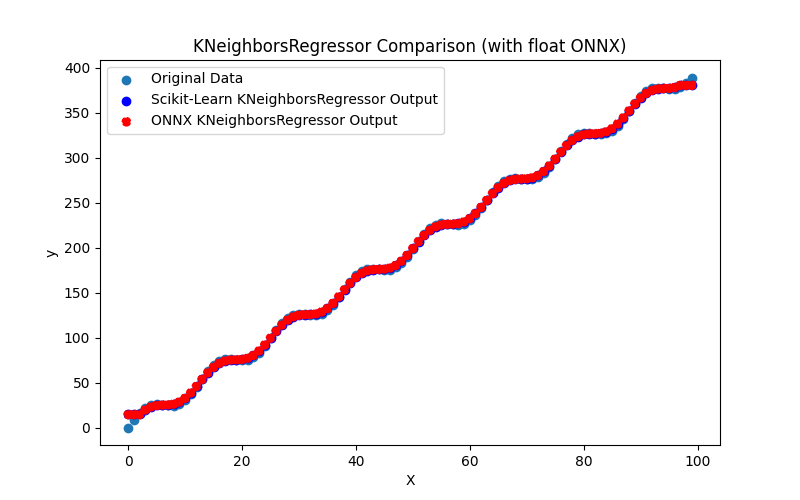

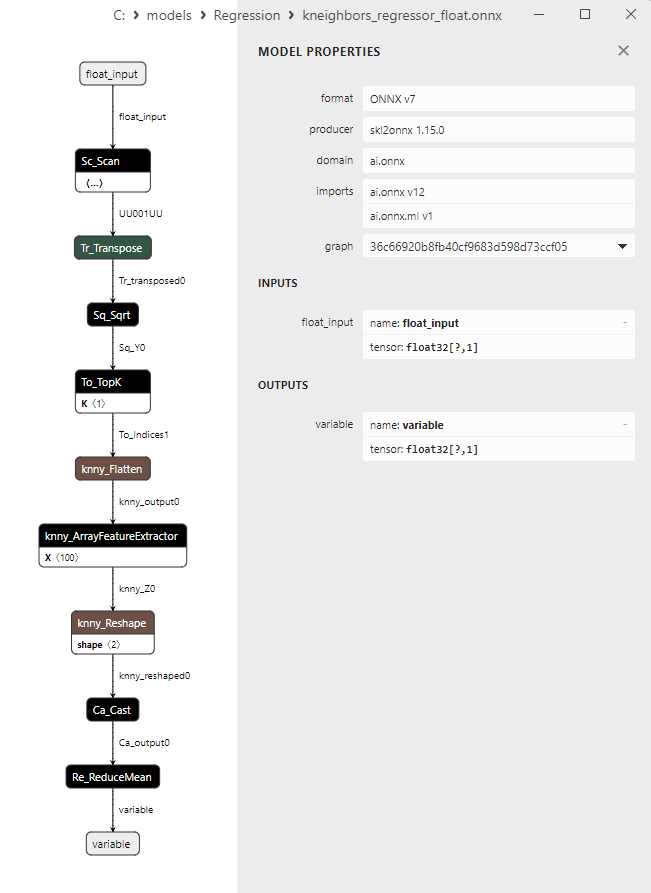

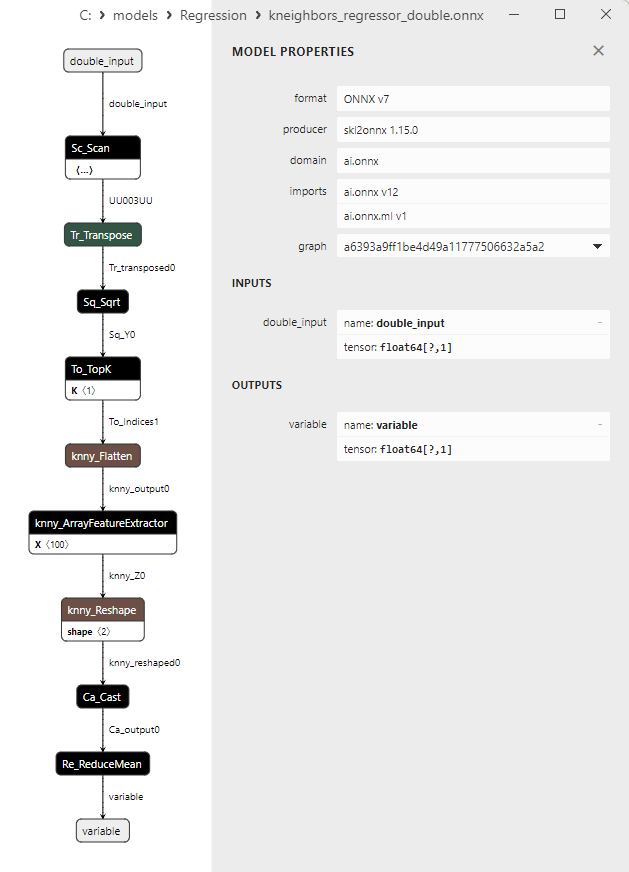

2.1.27.1. KNeighborsRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내는 코드

2.1.27.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.27.3. kneighbors_regressor_float.onnx 및 kneighbors_regressor_double.onnx의 ONNX 표현

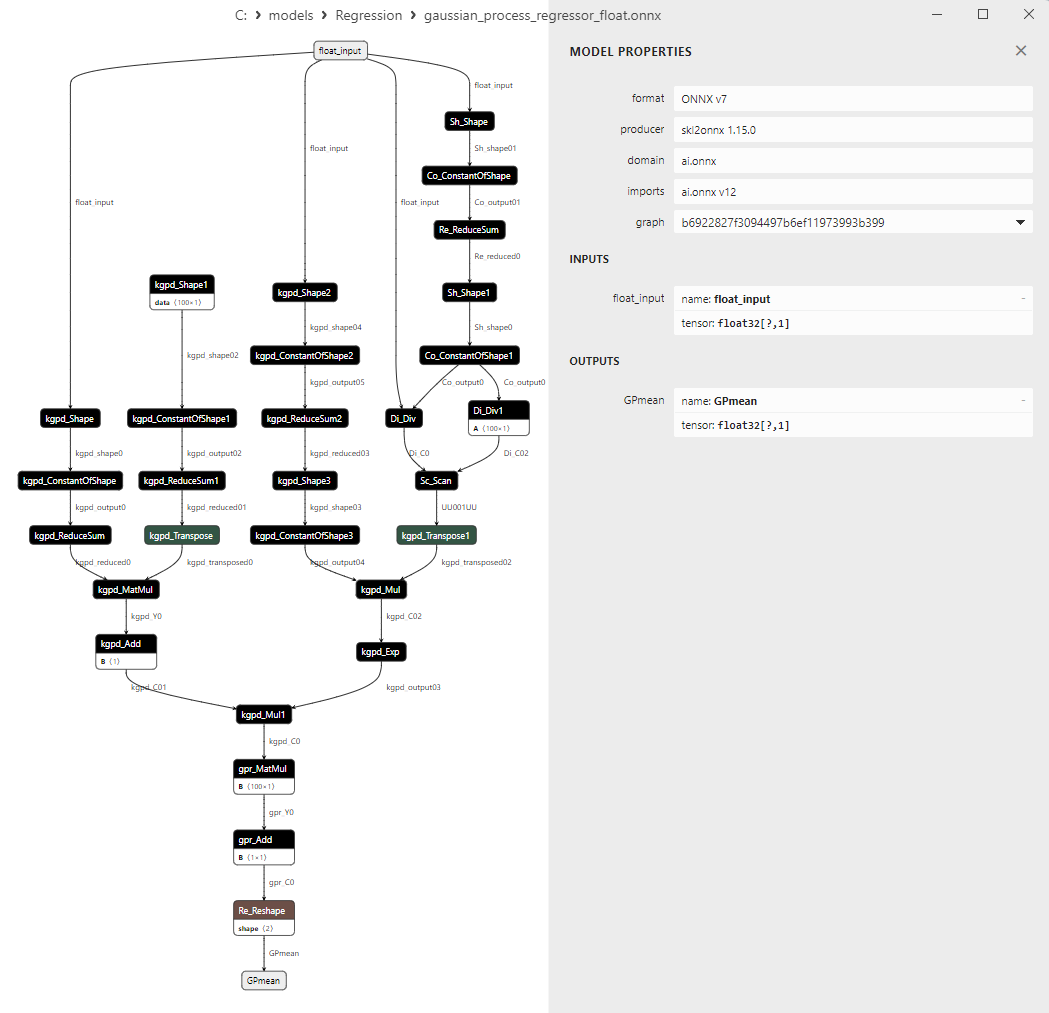

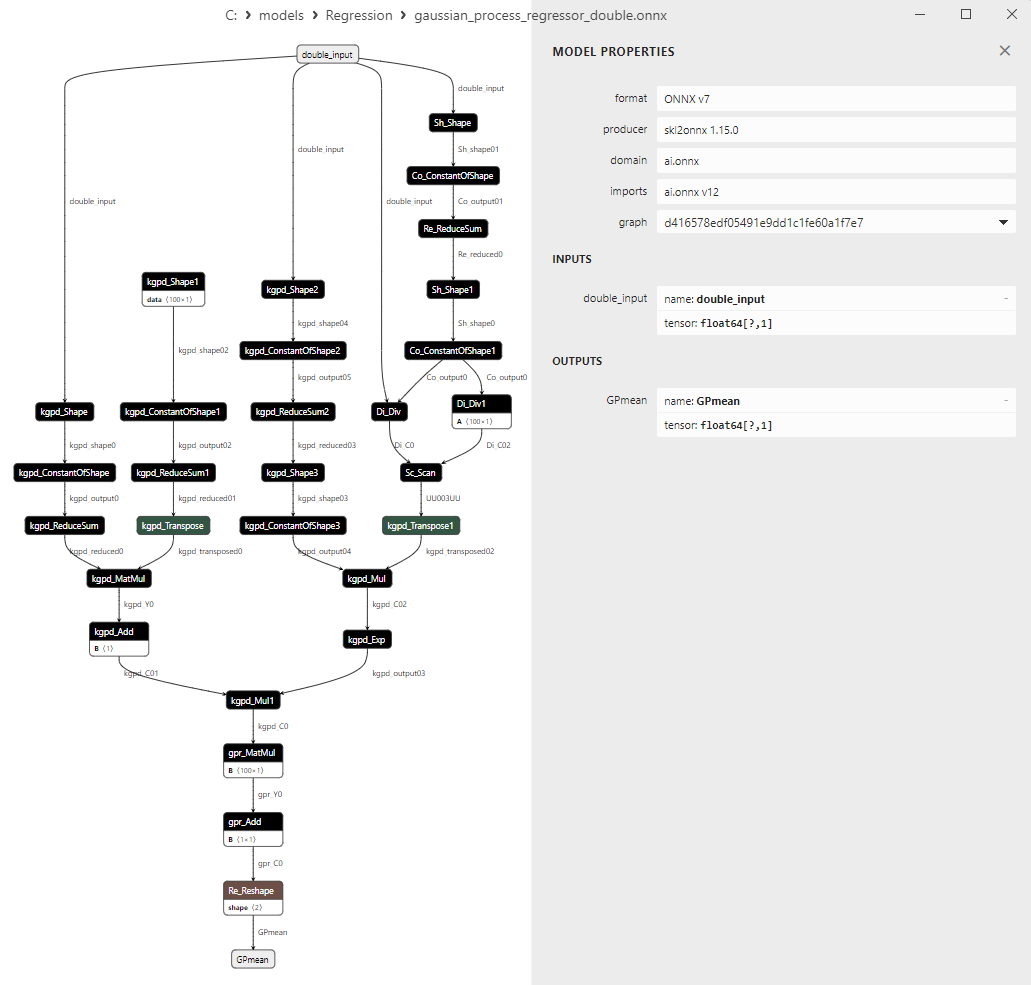

- 2.1.28. sklearn.gaussian_process.GaussianProcessRegressor

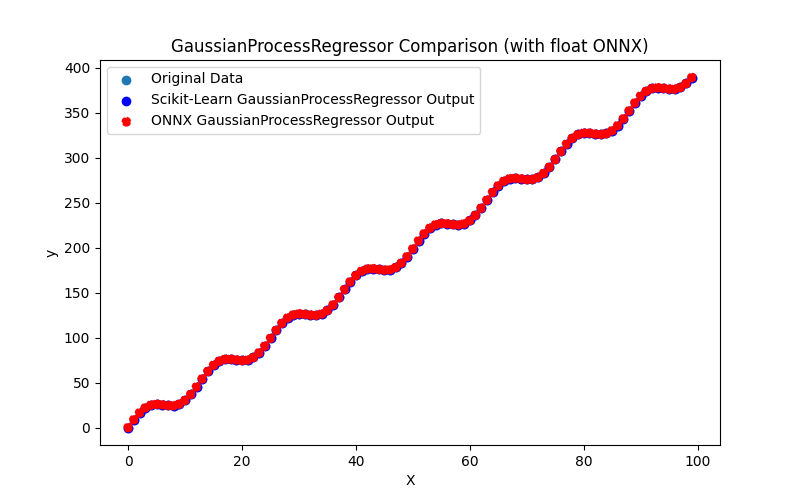

2.1.28.1. GaussianProcessRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.28.2. ONNX 모델 실행을 위한 MQL5 코드

2.1.28.3. gaussian_process_regressor_float.onnx 및 gaussian_process_regressor_double.onnx의 ONNX 표현

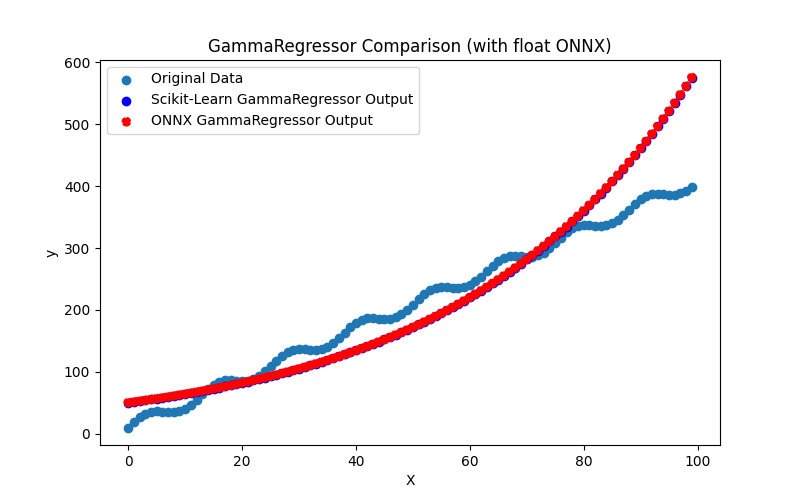

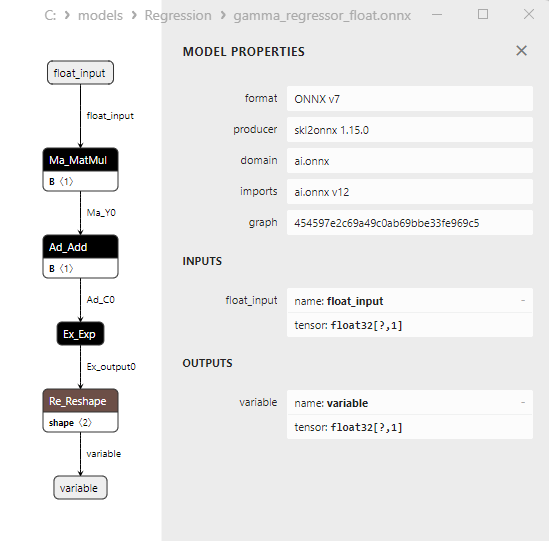

- 2.1.29. sklearn.linear_model.GammaRegressor

2.1.29.1. GammaRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.29.2. ONNX 모델 실행을 위한 MQL5 코드

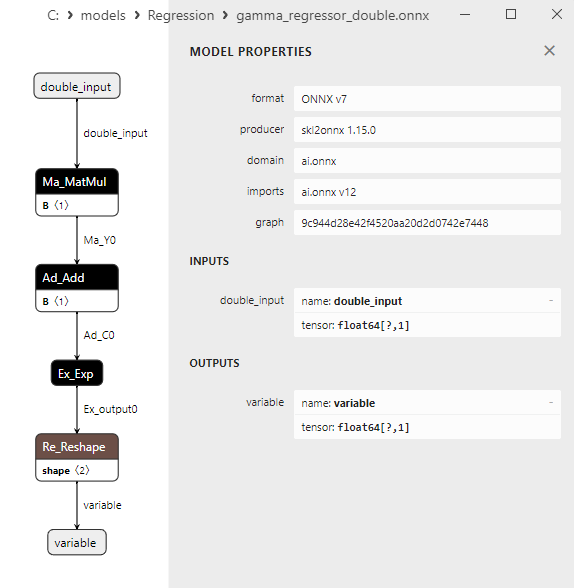

2.1.29.3. gamma_regressor_float.onnx 및 gamma_regressor_double.onnx의 ONNX 표현 - 2.1.30. sklearn.linear_model.SGDRegressor

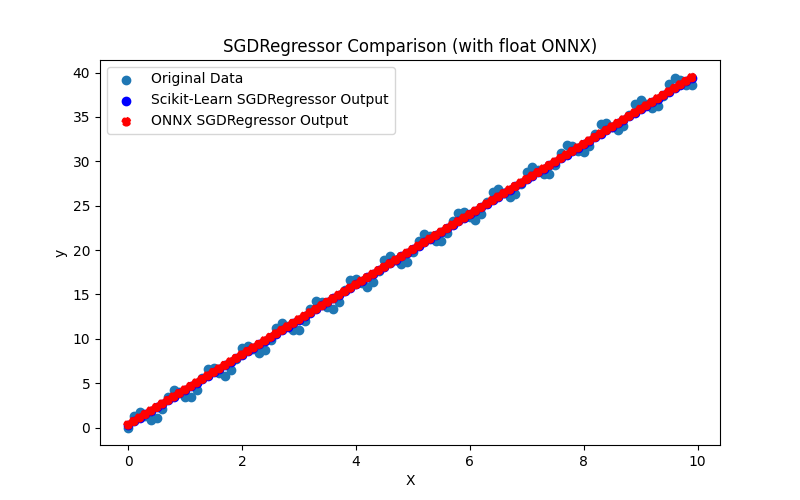

2.1.30.1. SGDRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.1.30.2. ONNX 모델 실행을 위한 MQL5 코드

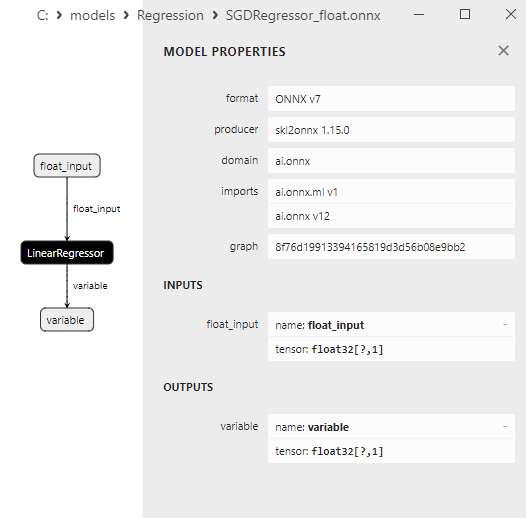

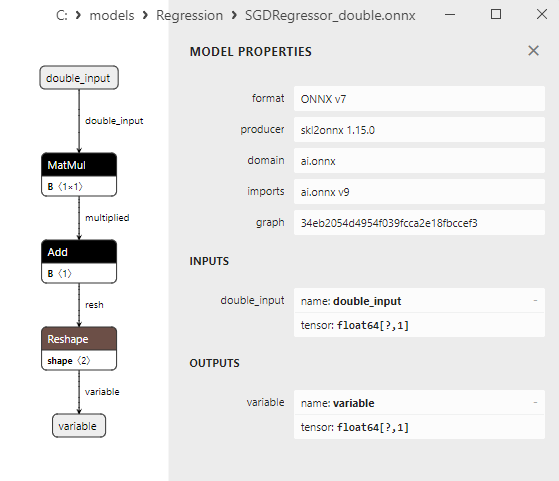

2.1.30.3. sgd_regressor_float.onnx 및 sgd_rgressor_double.onnx의 ONNX 표현

- 2.2. 부동 소수점 정밀도 ONNX 모델로만 변환되는 Scikit-learn 라이브러리의 회귀 모델

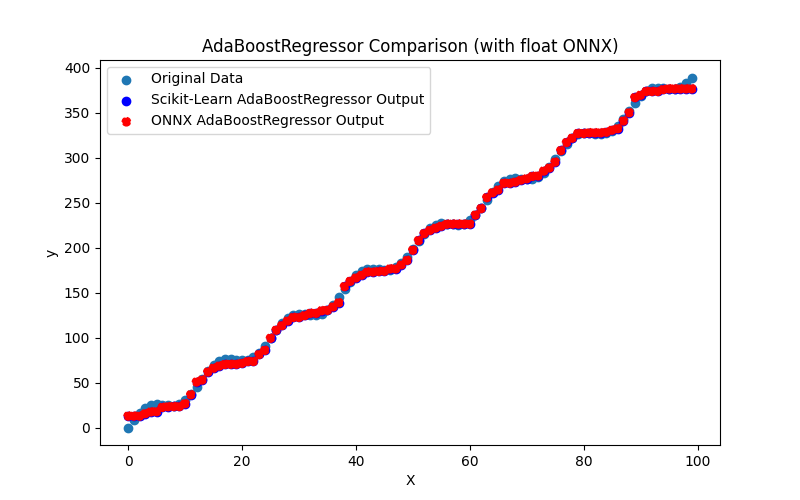

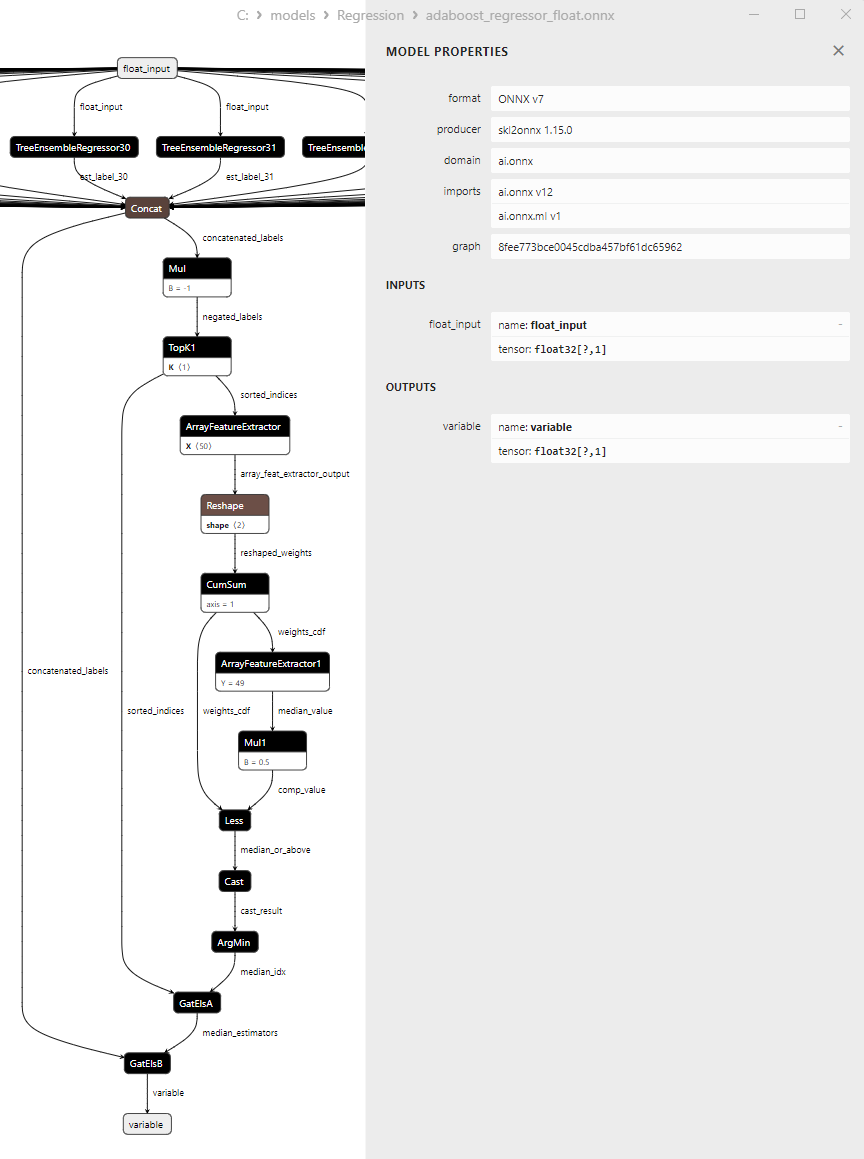

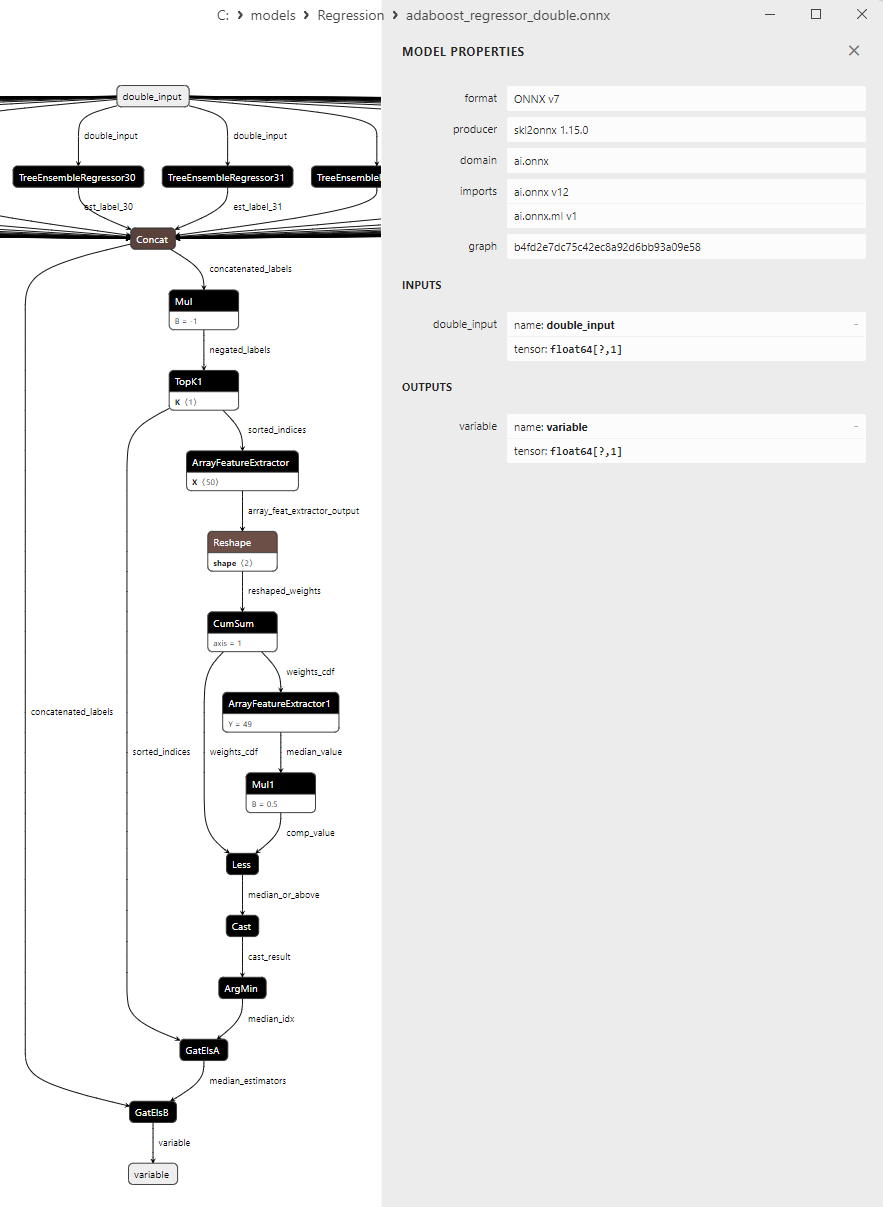

- 2.2.1. sklearn.linear_model.AdaBoostRegressor

2.2.1.1. AdaBoostRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.1.2. ONNX 모델 실행을 위한 MQL5 코드

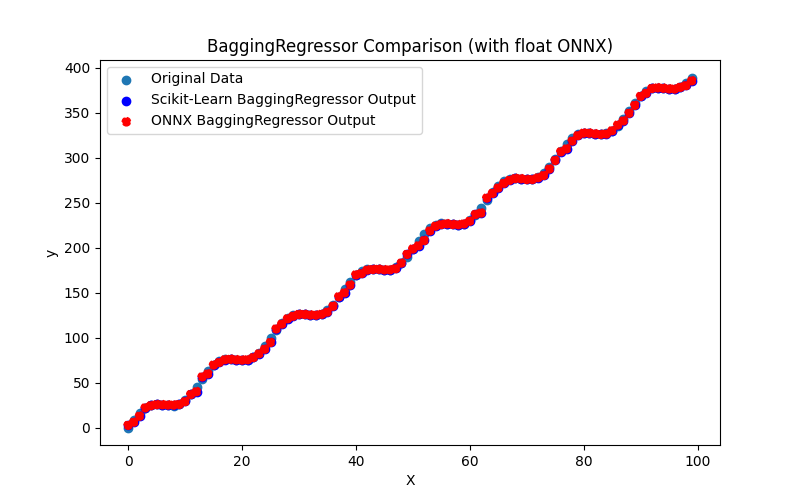

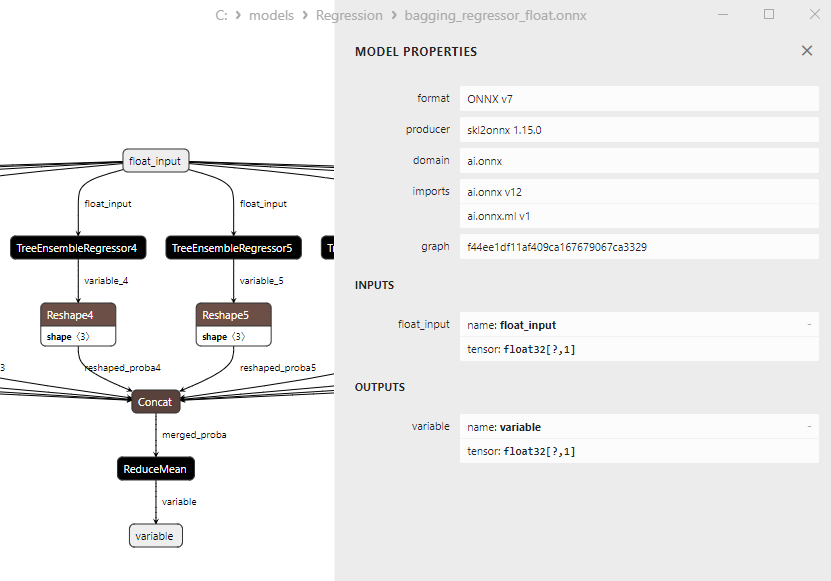

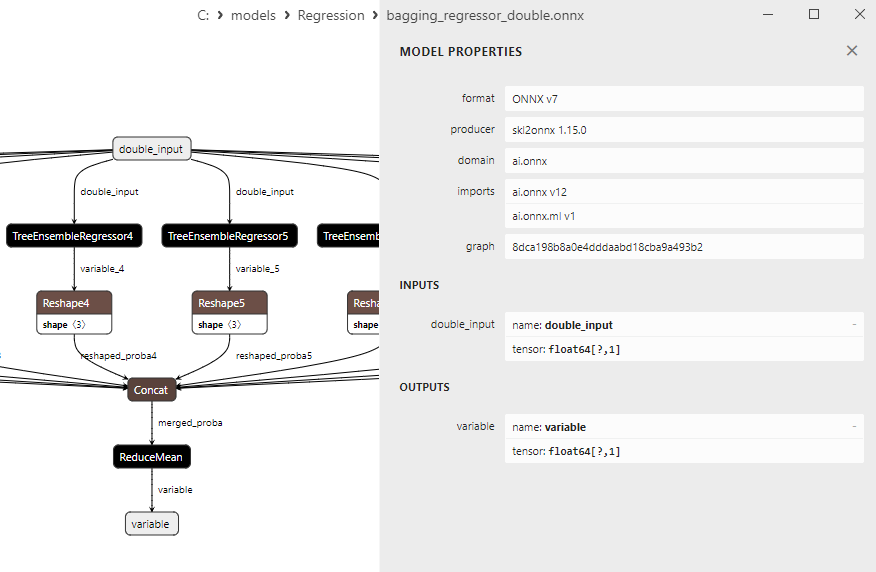

2.2.1.3. adaboost_regressor_float.onnx 및 adaboost_regressor_double.onnx의 ONNX 표현 - 2.2.2. sklearn.linear_model.BaggingRegressor

2.2.2.1. BaggingRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.2.2. ONNX 모델 실행을 위한 MQL5 코드

2.2.2.3. bagging_regressor_float.onnx 및 bagging_regressor_double.onnx의 ONNX 표현 - 2.2.3. sklearn.linear_model.DecisionTreeRegressor

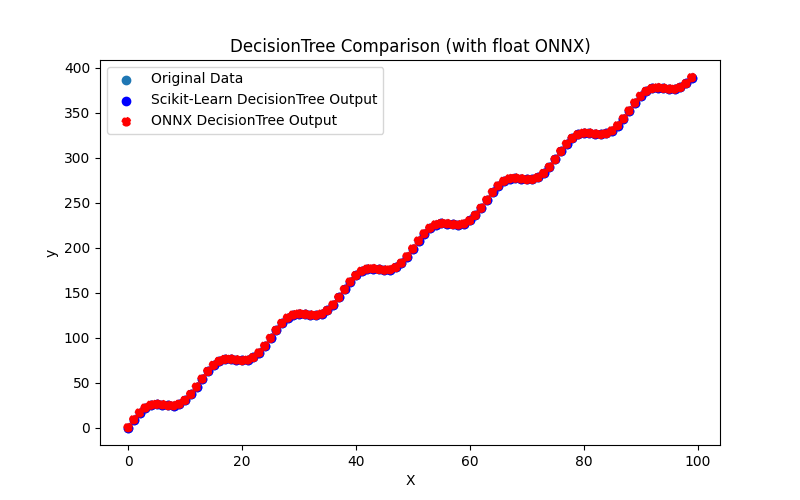

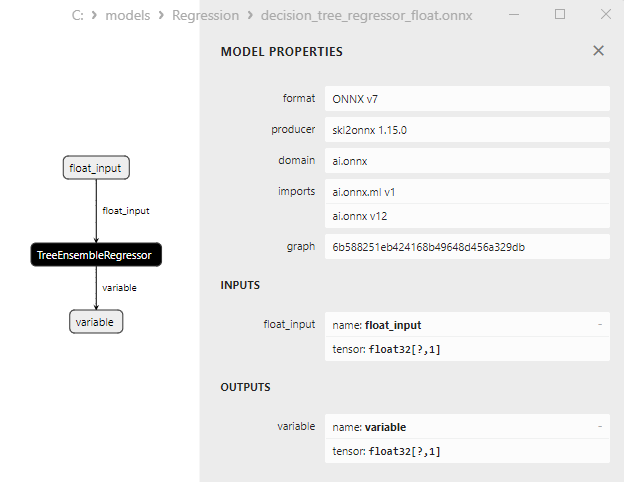

2.2.3.1. DecisionTreeRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.3.2. ONNX 모델 실행을 위한 MQL5 코드

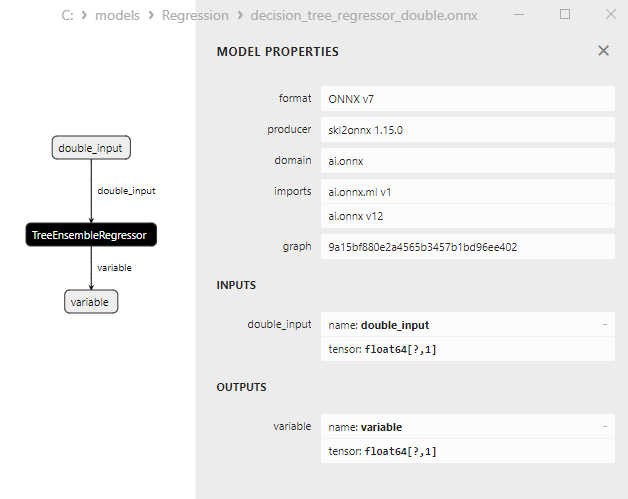

2.2.3.3. decision_tree_regressor_float.onnx 및 decision_tree_regressor_double.onnx의 ONNX 표현 - 2.2.4. sklearn.linear_model.ExtraTreeRegressor

2.2.4.1. ExtraTreeRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.4.2. ONNX 모델 실행을 위한 MQL5 코드

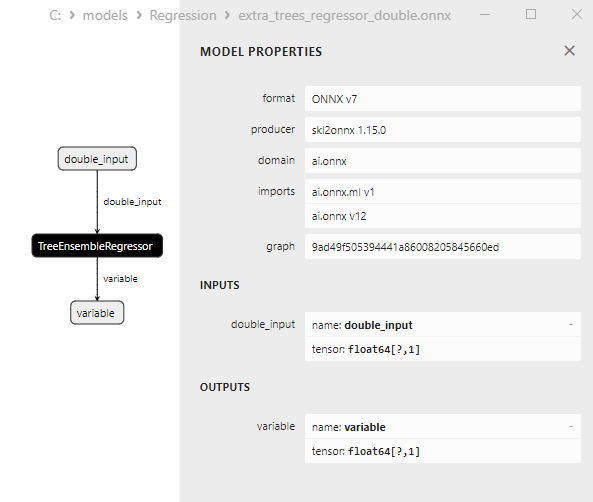

2.2.4.3. extra_tree_regressor_float.onnx 및 extra_tree_regressor_double.onnx의 ONNX 표현 - 2.2.5. sklearn.ensemble.ExtraTreesRegressor

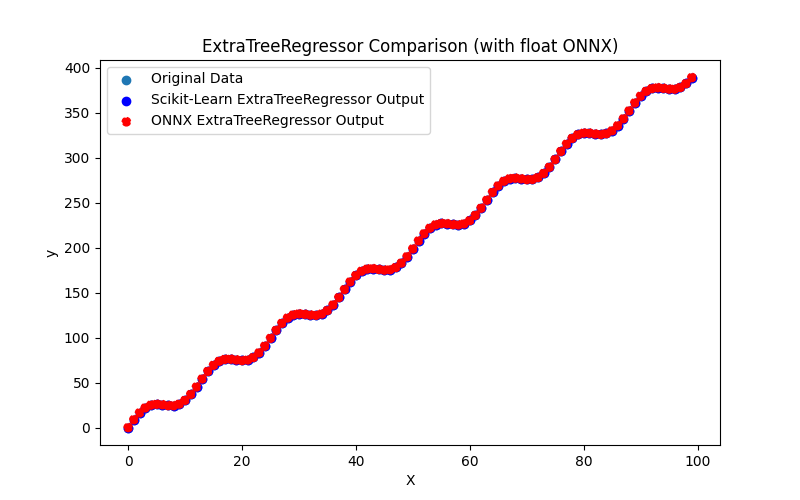

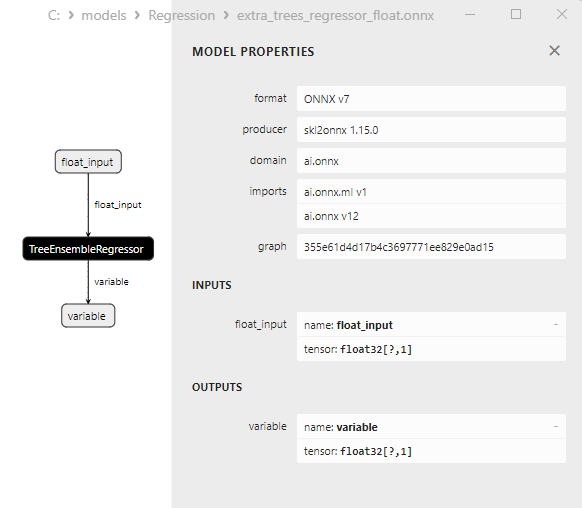

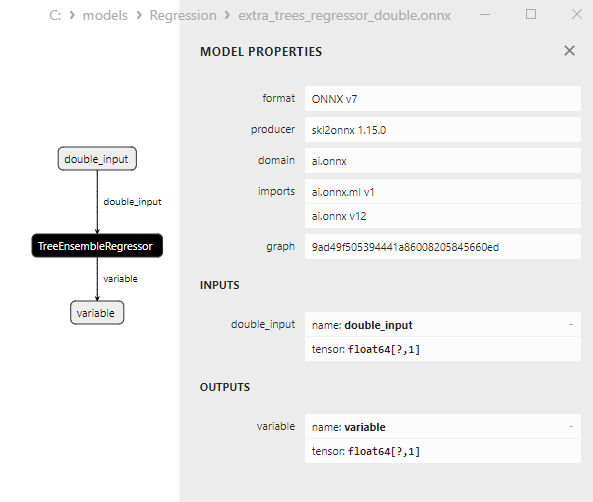

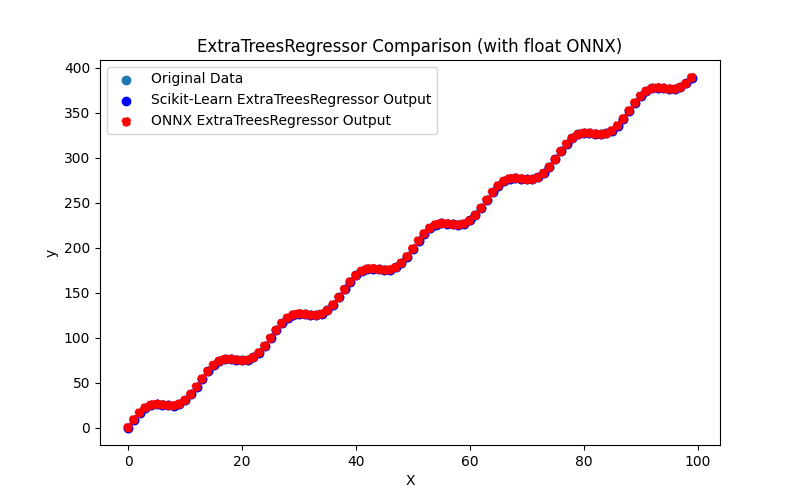

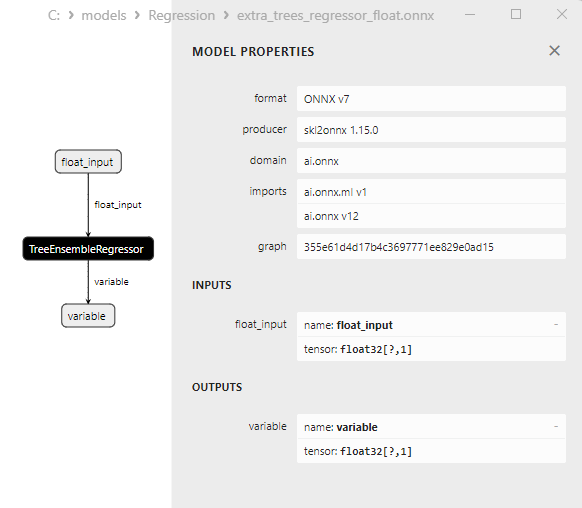

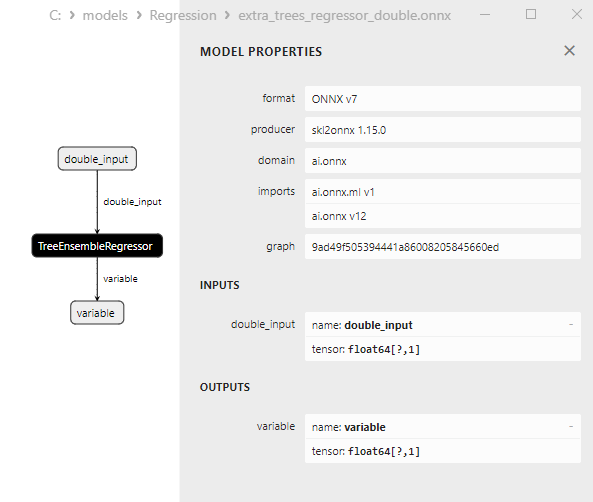

2.2.5.1. ExtraTreesRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내는 코드

2.2.5.2. ONNX 모델 실행을 위한 MQL5 코드

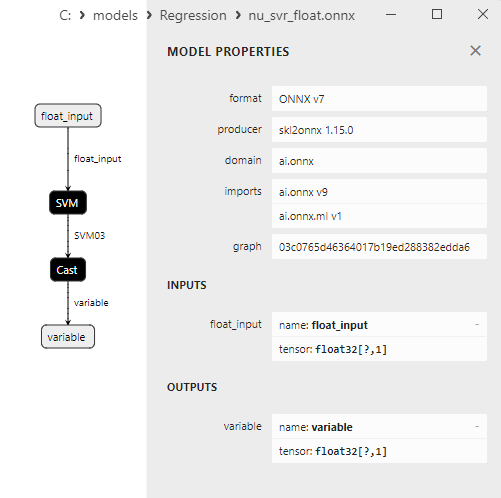

2.2.5.3. extra_trees_regressor_float.onnx 및 extra_trees_regressor_double.onnx의 ONNX 표현 - 2.2.6. sklearn.svm.NuSVR

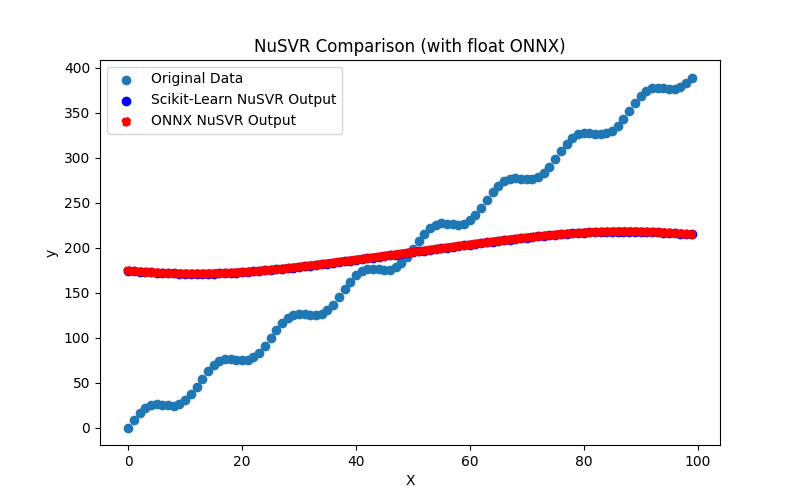

2.2.6.1. NuSVR 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.6.2. ONNX 모델 실행을 위한 MQL5 코드

2.2.6.3. nu_svr_float.onnx 및 nu_svr_double.onnx의 ONNX 표현 - 2.2.7. sklearn.ensemble.RandomForestRegressor

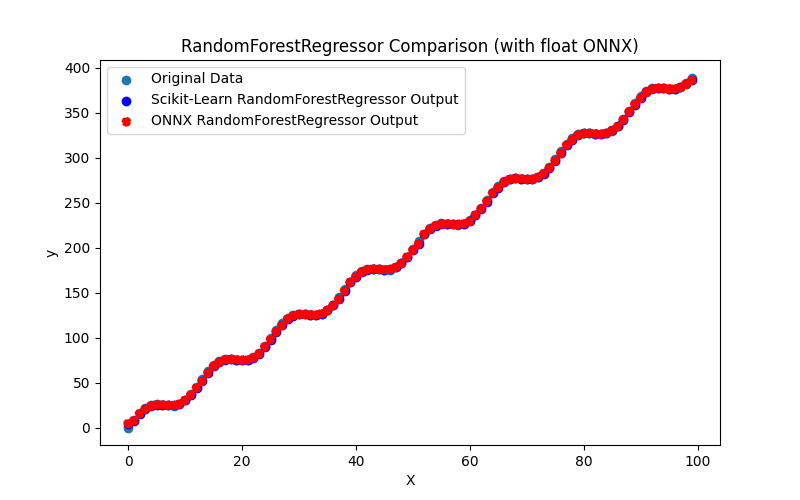

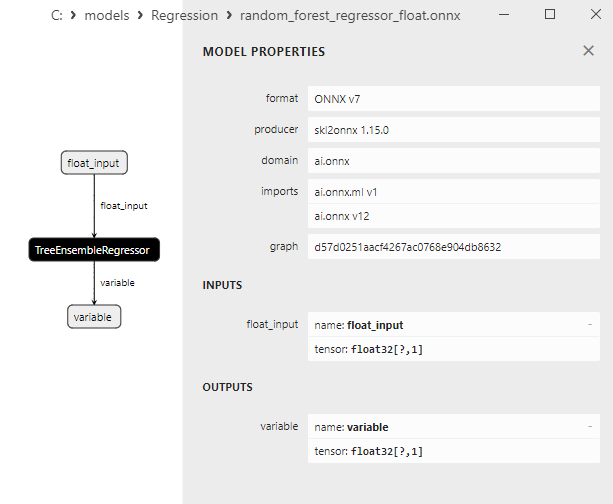

2.2.7.1. RandomForestRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.7.2. ONNX 모델 실행을 위한 MQL5 코드

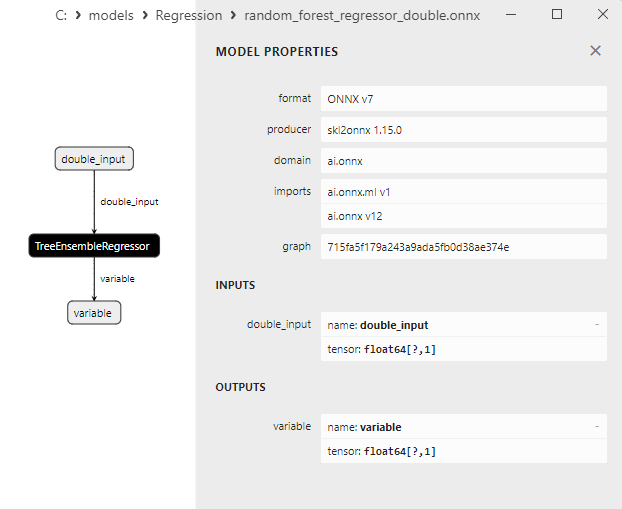

2.2.7.3. random_forest_regressor_float.onnx 및 random_forest_regressor_double.onnx의 ONNX 표현

- 2.2.8. sklearn.ensemble.GradientBoostingRegressor

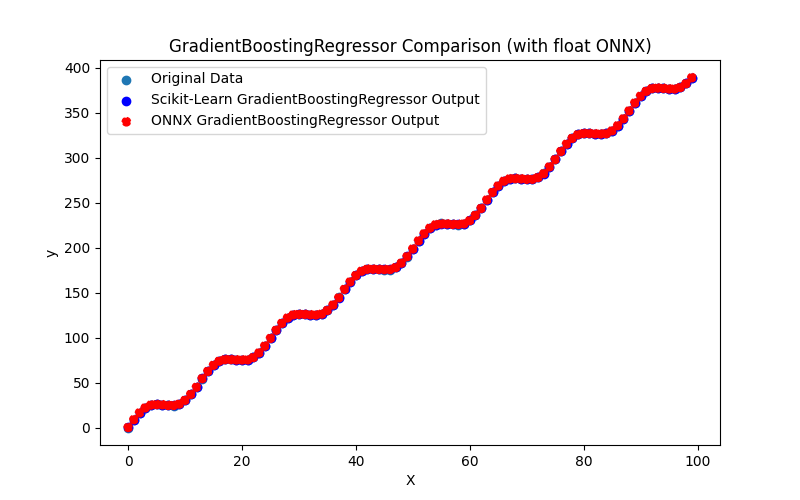

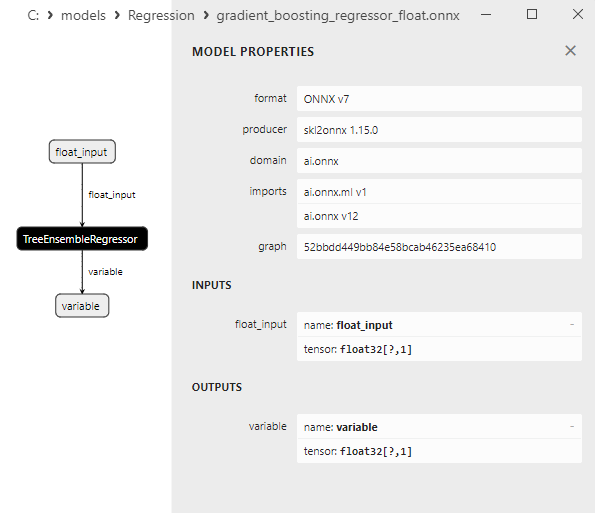

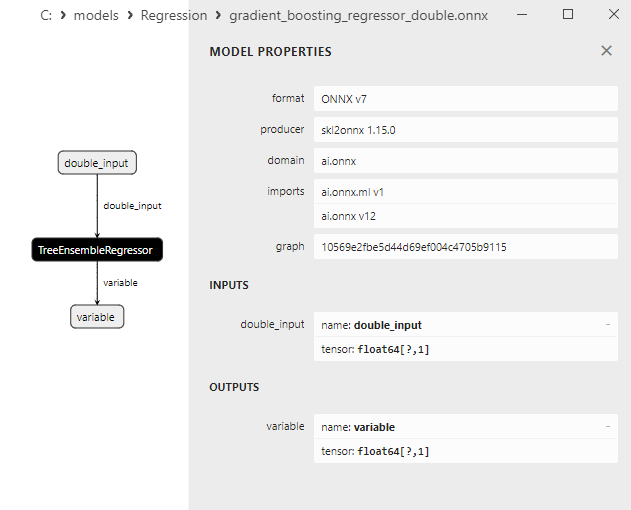

2.2.8.1. GradientBoostingRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.8.2. ONNX 모델 실행을 위한 MQL5 코드

2.2.8.3. gradient_boosting_regressor_float.onnx 및 gradient_boosting_regressor_double.onnx의 ONNX 표현

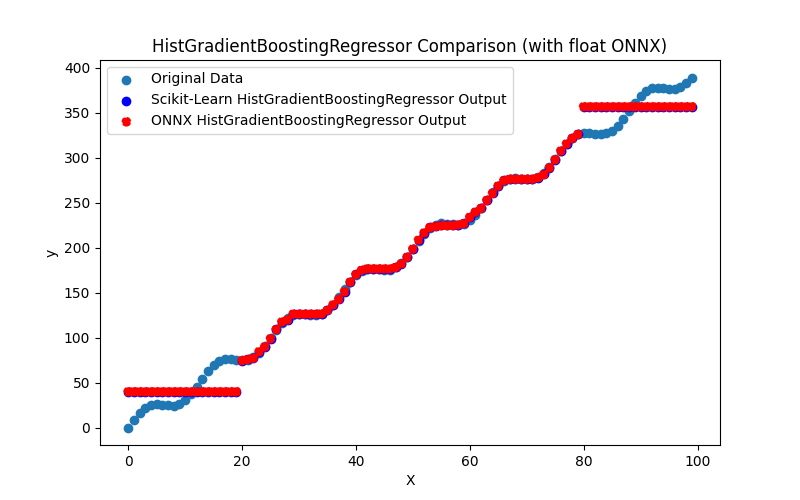

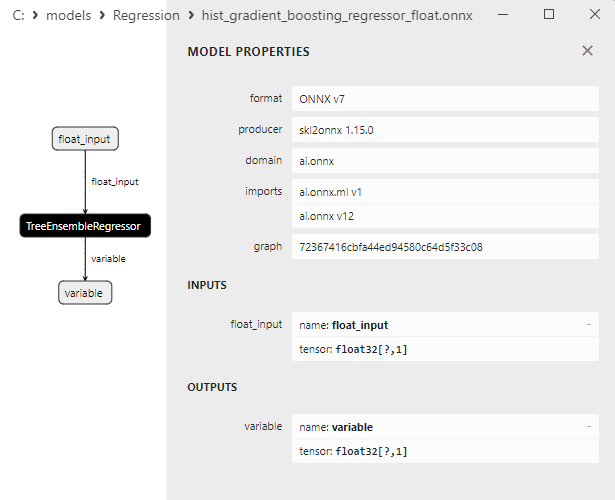

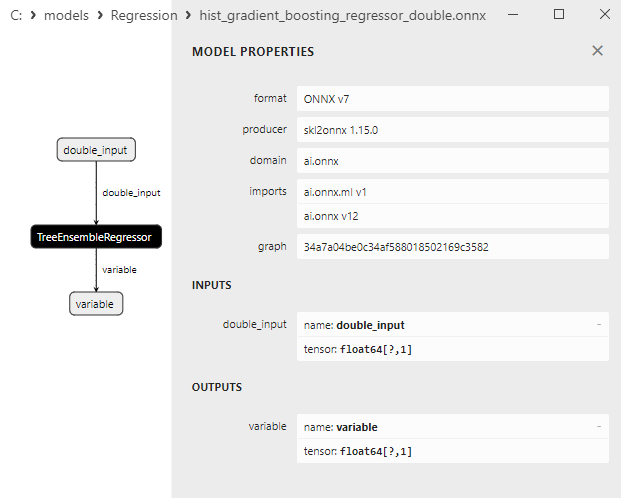

- 2.2.9. sklearn.ensemble.HistGradientBoostingRegressor

2.2.9.1. HistGradientBoostingRegressor 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.9.2. ONNX 모델 실행을 위한 MQL5 코드

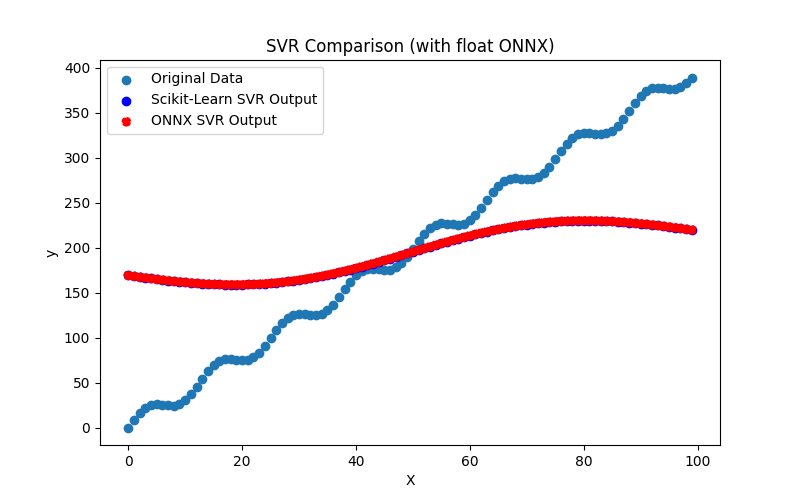

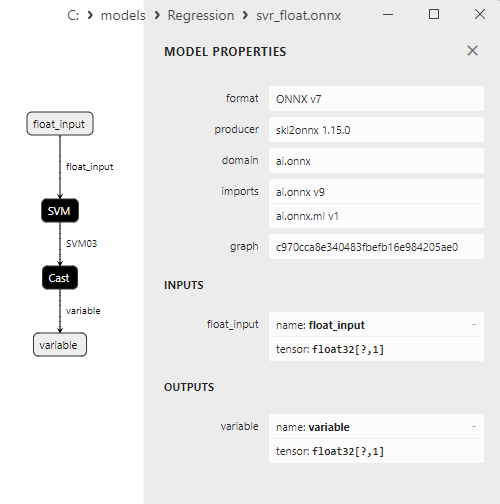

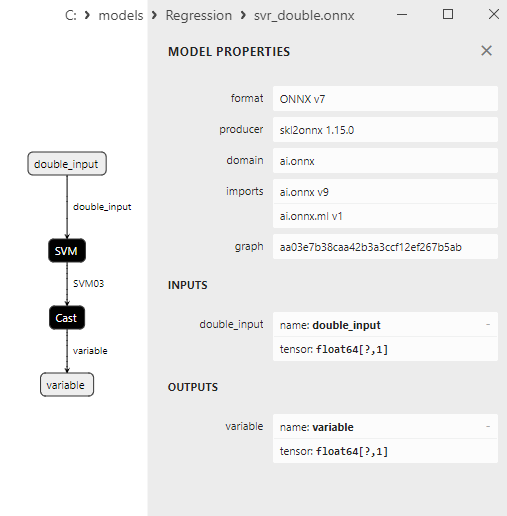

2.2.9.3. hist_gradient_boosting_regressor_float.onnx 및 hist_gradient_boosting_regressor_double.onnx의 ONNX 표현 - 2.2.10. sklearn.svm.SVR

2.2.10.1. SVR 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

2.2.10.2. ONNX 모델 실행을 위한 MQL5 코드

2.2.10.3. svr_float.onnx 및 svr_double.onnx의 ONNX 표현

- 2.3. ONNX로 변환할 때 문제가 발생한 회귀 모델

- 2.3.1. sklearn.dummy.DummyRegressor

DummyRegressor 생성 코드 - 2.3.2. sklearn.kernel_ridge.KernelRidge

KernelRidge 생성 코드 - 2.3.3. sklearn.isotonic.IsotonicRegression

IsotonicRegression를 생성하는 코드 - 2.3.4. sklearn.cross_decomposition.PLSCanonical

PLSCanonical 생성 코드 - 2.3.5. sklearn.cross_decomposition.CCA

CCA 생성 코드 - 결론

- 요약

귀찮으시다면 기고해 주세요.

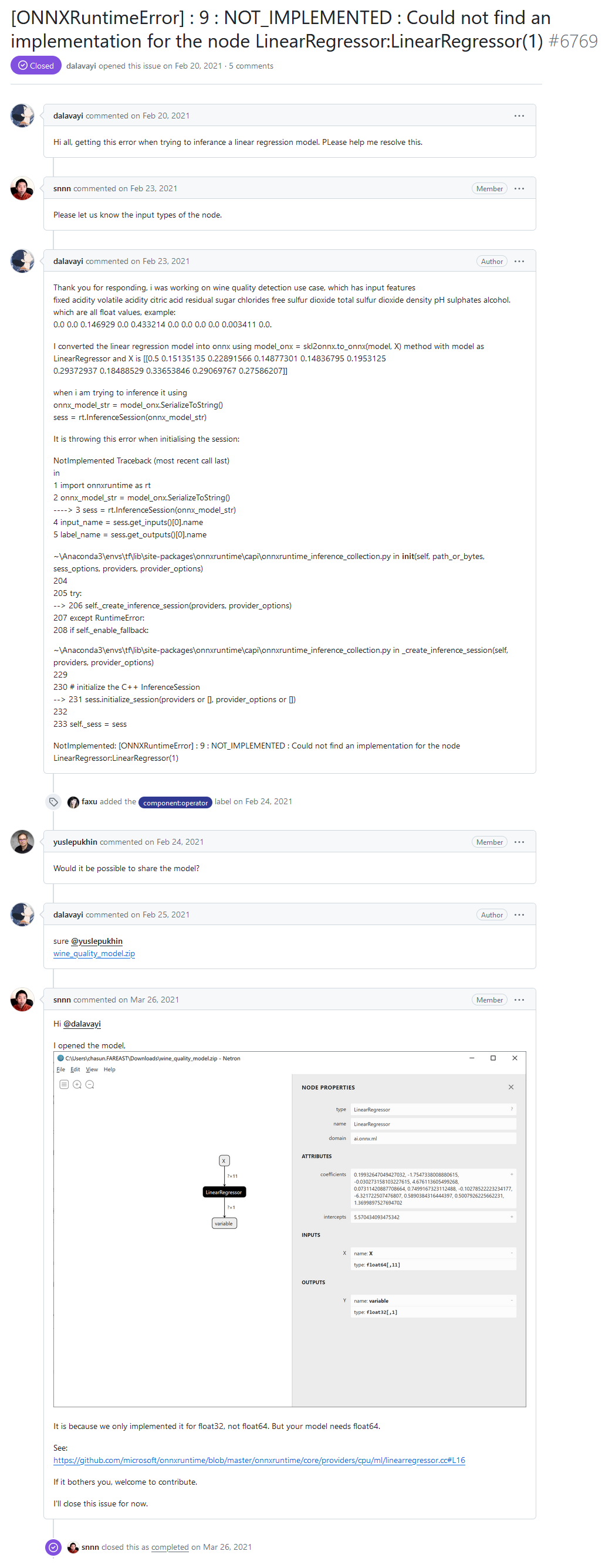

런타임 개발자 포럼에서 사용자 중 한 명이 "[ONNXRuntimeError] 오류를 보고했습니다: 9 : NOT_IMPLEMENTED : ONNX 런타임을 통해 모델을 실행할 때 'LinearRegressor:LinearRegressor(1)' 노드에 대한 구현을 찾을 수 없습니다.

안녕하세요 선형 회귀 모델을 추론하려고 할 때 이 오류가 발생합니다. 이 문제를 해결하도록 도와주세요.

"NOT_IMPLEMENTED : ONNX 런타임 개발자 포럼에서 "노드 LinearRegressor:LinearRegressor(1)"에 대한 구현을 찾을 수 없습니다 라는 에러.

개발자의 답변:

float64가 아닌 float32에 대해서만 구현했기 때문입니다. 하지만 귀하의 모델에는 float64가 필요합니다.

참조:

hgithub.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16https://github.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16

귀찮으시다면 기고해 주세요.

사용자의 ONNX 모델에서 연산자는 double(float64) 데이터 유형으로 호출되며 ONNX 런타임이 배정밀도 LinearRegressor() 연산자를 지원하지 않기 때문에 오류 메시지가 발생합니다.

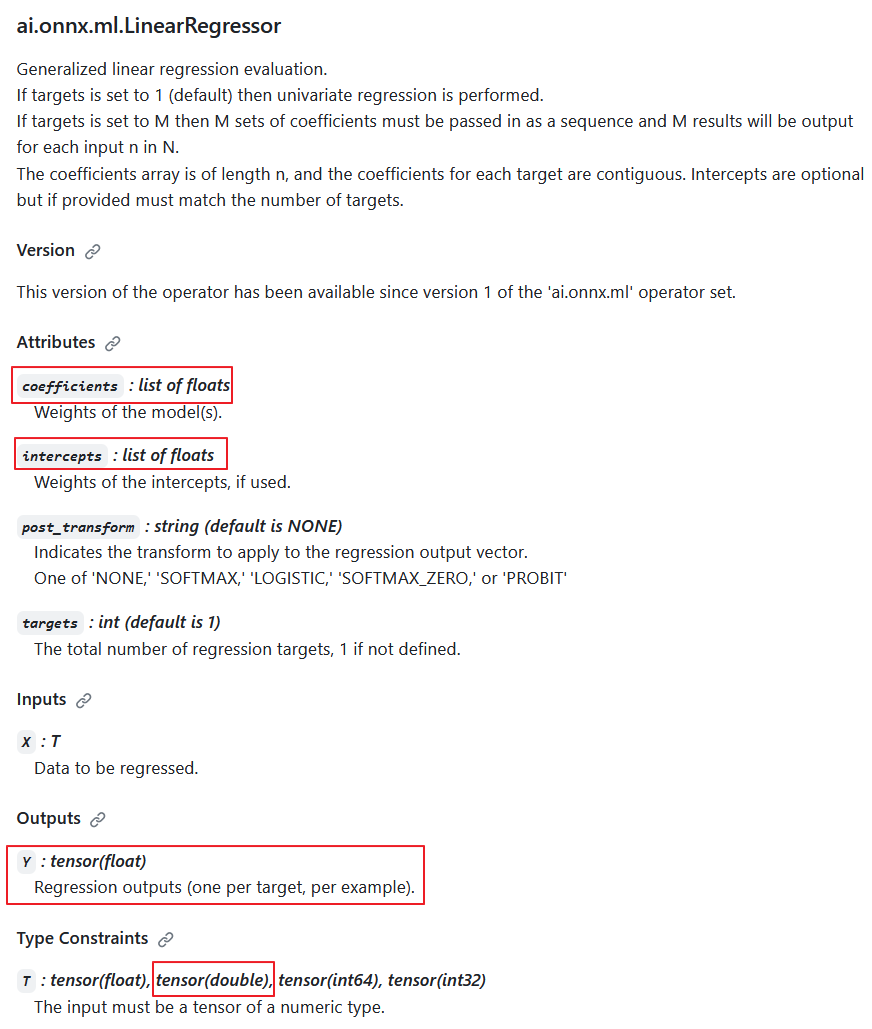

연산자의 사양에 따르면 double 입력 데이터 유형(T: tensor(float), tensor(double), tensor(int64), tensor(int32)이 가능하지만 개발자는 의도적으로 이를 구현하지 않기로 결정했습니다.

그 이유는 출력에 항상 Y: tensor(float) 값이 반환되기 때문입니다. 또한 계산 매개변수는 실수입니다(계수: 실수 목록, 인터셉트: 실수 목록).

따라서 계산이 배정밀도로 수행될 때 이 연산자는 정밀도를 부동 소수점으로 감소시키므로 배정밀도 계산에서 필요할지 의심스럽습니다.

ai.onnx.ml.LinearRegressor 연산자 설명

따라서 매개변수 및 출력 값의 정밀도를 float으로 낮추면 double(float64) 수로 완전히 작동할 수 없게 됩니다. 아마도 이러한 이유로 ONNX 런타임 개발자는 double 유형에 대한 구현을 자제하기로 결정했을 것입니다.

'double 지원 추가' 메서드는 개발자가 코드 주석(노란색으로 강조 표시)을 통해 시연했습니다.

ONNX 런타임에서는 LinearRegressor 클래스(https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.h)를 사용하여 계산을 수행합니다.

연산자의 매개변수인 coefficients_ 및 intercepts_는 std::vector<float>로 저장됩니다:

#pragma once #include "core/common/common.h" #include "core/framework/op_kernel.h" #include "core/util/math_cpuonly.h" #include "ml_common.h" namespace onnxruntime { namespace ml { class LinearRegressor final : public OpKernel { public: LinearRegressor(const OpKernelInfo& info); Status Compute(OpKernelContext* context) const override; private: int64_t num_targets_; std::vector<float> coefficients_; std::vector<float> intercepts_; bool use_intercepts_; POST_EVAL_TRANSFORM post_transform_; }; } // namespace ml } // namespace onnxruntimeLinearRegressor 연산자 구현 (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.cc)

// Copyright (c) Microsoft Corporation. All rights reserved. // Licensed under the MIT License. #include "core/providers/cpu/ml/linearregressor.h" #include "core/common/narrow.h" #include "core/providers/cpu/math/gemm.h" namespace onnxruntime { namespace ml { ONNX_CPU_OPERATOR_ML_KERNEL( LinearRegressor, 1, // KernelDefBuilder().TypeConstraint("T", std::vector<MLDataType>{ // DataTypeImpl::GetTensorType<float>(), // DataTypeImpl::GetTensorType<double>()}), KernelDefBuilder().TypeConstraint("T", DataTypeImpl::GetTensorType<float>()), LinearRegressor); LinearRegressor::LinearRegressor(const OpKernelInfo& info) : OpKernel(info), intercepts_(info.GetAttrsOrDefault<float>("intercepts")), post_transform_(MakeTransform(info.GetAttrOrDefault<std::string>("post_transform", "NONE"))) { ORT_ENFORCE(info.GetAttr<int64_t>("targets", &num_targets_).IsOK()); ORT_ENFORCE(info.GetAttrs<float>("coefficients", coefficients_).IsOK()); // use the intercepts_ if they're valid use_intercepts_ = intercepts_.size() == static_cast<size_t>(num_targets_); } // Use GEMM for the calculations, with broadcasting of intercepts // https://github.com/onnx/onnx/blob/main/docs/Operators.md#Gemm // // X: [num_batches, num_features] // coefficients_: [num_targets, num_features] // intercepts_: optional [num_targets]. // Output: X * coefficients_^T + intercepts_: [num_batches, num_targets] template <typename T> static Status ComputeImpl(const Tensor& input, ptrdiff_t num_batches, ptrdiff_t num_features, ptrdiff_t num_targets, const std::vector<float>& coefficients, const std::vector<float>* intercepts, Tensor& output, POST_EVAL_TRANSFORM post_transform, concurrency::ThreadPool* threadpool) { const T* input_data = input.Data<T>(); T* output_data = output.MutableData<T>(); if (intercepts != nullptr) { TensorShape intercepts_shape({num_targets}); onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, intercepts->data(), &intercepts_shape, output_data, threadpool); } else { onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, nullptr, nullptr, output_data, threadpool); } if (post_transform != POST_EVAL_TRANSFORM::NONE) { ml::batched_update_scores_inplace(gsl::make_span(output_data, SafeInt<size_t>(num_batches) * num_targets), num_batches, num_targets, post_transform, -1, false, threadpool); } return Status::OK(); } Status LinearRegressor::Compute(OpKernelContext* ctx) const { Status status = Status::OK(); const auto& X = *ctx->Input<Tensor>(0); const auto& input_shape = X.Shape(); if (input_shape.NumDimensions() > 2) { return ORT_MAKE_STATUS(ONNXRUNTIME, INVALID_ARGUMENT, "Input shape had more than 2 dimension. Dims=", input_shape.NumDimensions()); } ptrdiff_t num_batches = input_shape.NumDimensions() <= 1 ? 1 : narrow<ptrdiff_t>(input_shape[0]); ptrdiff_t num_features = input_shape.NumDimensions() <= 1 ? narrow<ptrdiff_t>(input_shape.Size()) : narrow<ptrdiff_t>(input_shape[1]); Tensor& Y = *ctx->Output(0, {num_batches, num_targets_}); concurrency::ThreadPool* tp = ctx->GetOperatorThreadPool(); auto element_type = X.GetElementType(); switch (element_type) { case ONNX_NAMESPACE::TensorProto_DataType_FLOAT: { status = ComputeImpl<float>(X, num_batches, num_features, narrow<ptrdiff_t>(num_targets_), coefficients_, use_intercepts_ ? &intercepts_ : nullptr, Y, post_transform_, tp); break; } case ONNX_NAMESPACE::TensorProto_DataType_DOUBLE: { // TODO: Add support for 'double' to the scoring functions in ml_common.h // once that is done we can just call ComputeImpl<double>... // Alternatively we could cast the input to float. } default: status = ORT_MAKE_STATUS(ONNXRUNTIME, FAIL, "Unsupported data type of ", element_type); } return status; } } // namespace ml } // namespace onnxruntime

입력 값으로 double 숫자를 사용하고 float 매개 변수로 연산자의 계산을 수행하는 옵션이 있다는 것이 밝혀졌습니다. 또 다른 가능성은 입력 데이터의 정밀도를 float으로 낮추는 것입니다. 그러나 이러한 옵션 중 어느 것도 적절한 솔루션으로 간주될 수 없습니다.

ai.onnx.ml.LinearRegressor 연산자의 사양은 매개변수와 출력 값이 float 유형으로 제한되어 있기 때문에 double 숫자로 전체 연산을 할 수 있는 기능이 제한되어 있습니다.

다른 ONNX ML 운영업체에서도 비슷한 상황이 발생합니다. ai.onnx.ml.SVMRegressor 및 ai.onnx.ml.TreeEnsembleRegressor 등

그 결과 배정밀도의 ONNX 모델 실행을 사용하는 모든 개발자는 이와 같은 사양의 한계에 직면하게 됩니다. 해결책은 ONNX 사양을 확장하는 것(또는 매개변수와 출력값이 두 배인 LinearRegressor64, SVMRegressor64, TreeEnsembleRegressor64와 같은 유사한 연산자를 추가하는 것)이 될 것입니다. 하지만 현재 이 문제는 아직 해결되지 않은 상태입니다.

ONNX 변환기에 따라 많은 것이 달라지게 됩니다. double로 계산되는 모델의 경우 이러한 연산자를 사용하지 않는 것이 바람직할 수 있습니다(항상 가능한 것은 아니지만). 이 경우에는 ONNX로 변환기가 사용자의 모델에서 최적으로 작동하지 않았습니다.

나중에 살펴보겠지만 sklearn-onnx 변환기는 LinearRegressor의 제한을 우회하여 ONNX double 모델의 경우 ONNX 연산자 MatMul() 및 Add() 를 대신 사용합니다. 이 메서드 덕분에 Scikit-learn 라이브러리의 수많은 회귀 모델이 원래 double 모델의 정확성을 유지하면서 double로 계산된 ONNX 모델로 성공적으로 변환됩니다.

1. 테스트 데이터 세트

예제를 실행하려면 파이썬(3.10.8 버전 사용), 추가 라이브러리(pip install -U scikit-learn numpy matplotlib onnx onnxruntime skl2onnx)를 설치하고 메타에디터의 메뉴(도구->옵션->컴파일러->파이썬)에서 파이썬의 경로를 지정해야 합니다.

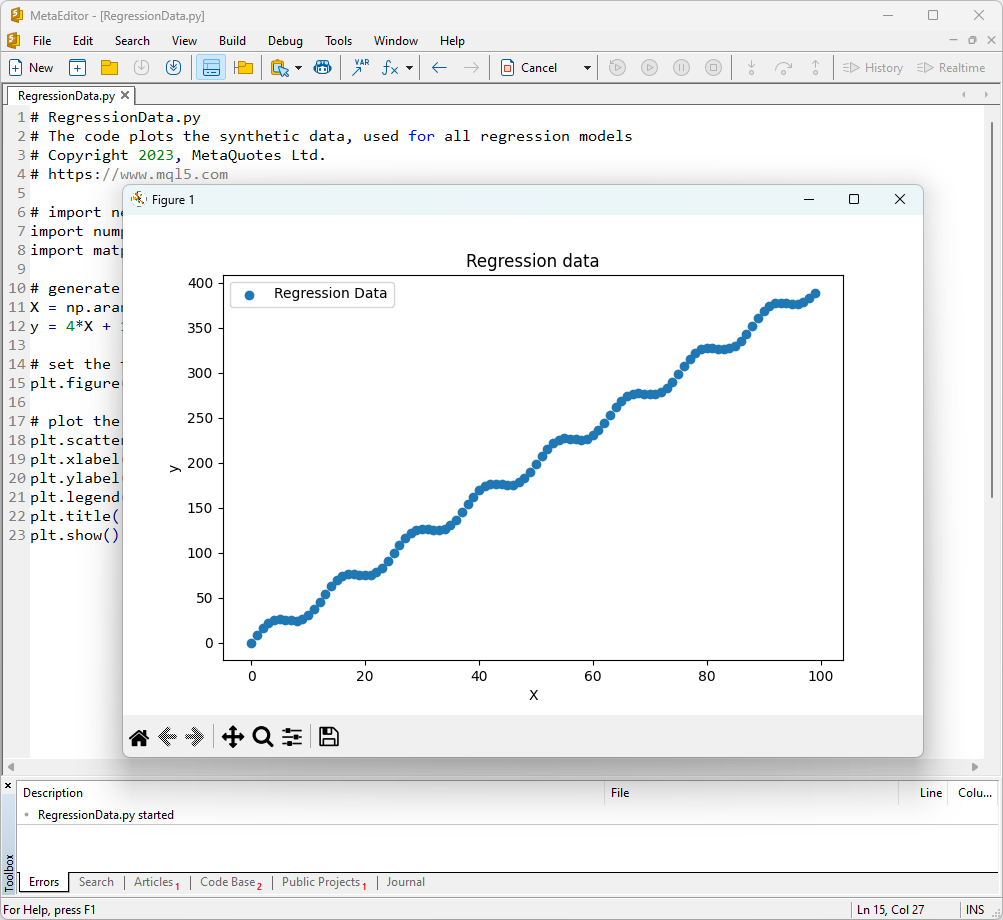

테스트 데이터셋으로는 y = 4X + 10sin(X*0.5) 함수로 생성된 값을 사용하겠습니다.

이러한 함수의 그래프를 표시하려면 메타에디터를 열고 RegressionData.py라는 파일을 만든 다음 스크립트 텍스트를 복사하고 "컴파일" 버튼을 클릭하여 실행합니다.

테스트 데이터 집합을 표시하는 스크립트

# RegressionData.py # The code plots the synthetic data, used for all regression models # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # import necessary libraries import numpy as np import matplotlib.pyplot as plt # generate synthetic data for regression X = np.arange(0,100,1).reshape(-1,1) y = 4*X + 10*np.sin(X*0.5) # set the figure size plt.figure(figsize=(8,5)) # plot the initial data for regression plt.scatter(X, y, label='Regression Data', marker='o') plt.xlabel('X') plt.ylabel('y') plt.legend() plt.title('Regression data') plt.show()

결과적으로 함수 그래프가 표시되며 우리는 이를 사용하여 회귀 메서드를 테스트할 것입니다.

그림 1. 회귀 모델 테스트용 함수

2. 회귀 모델

회귀 작업을 하는 목표는 새로운 데이터의 수치 값을 예측하기 위해 피처와 대상 변수 간의 관계를 가장 잘 설명하는 수학적 함수 또는 모델을 찾는 것입니다. 이를 통해 우리는 예측을 하고 솔루션을 최적화하고 데이터를 기반으로 정보에 입각한 의사 결정을 내릴 수 있습니다.

이제 scikit-learn 패키지의 주요 회귀 모델에 대해 살펴보도록 하겠습니다.

2.0. Scikit-learn 회귀 모델 목록

사용 가능한 scikit-learn 회귀 모델 목록을 표시하려면 스크립트를 사용하면 됩니다:

# ScikitLearnRegressors.py # The script lists all the regression algorithms available inb scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn regression models from sklearn.utils import all_estimators regressors = all_estimators(type_filter='regressor') for index, (name, RegressorClass) in enumerate(regressors, start=1): print(f"Regressor {index}: {name}")

출력:

scikit-learn 버전은 1.3.2입니다.

Regressor 1: ARDRegression

Regressor 2: AdaBoostRegressor

Regressor 3: BaggingRegressor

Regressor 4: BayesianRidge

Regressor 5: CCA

Regressor 6: DecisionTreeRegressor

Regressor 7: DummyRegressor

Regressor 8: ElasticNet

Regressor 9: ElasticNetCV

Regressor 10: ExtraTreeRegressor

Regressor 11: ExtraTreesRegressor

Regressor 12: GammaRegressor

Regressor 13: GaussianProcessRegressor

Regressor 14: GradientBoostingRegressor

Regressor 15: HistGradientBoostingRegressor

Regressor 16: HuberRegressor

Regressor 17: IsotonicRegression

Regressor 18: KNeighborsRegressor

Regressor 19: KernelRidge

Regressor 20: Lars

Regressor 21: LarsCV

Regressor 22: Lasso

Regressor 23: LassoCV

Regressor 24: LassoLars

Regressor 25: LassoLarsCV

Regressor 26: LassoLarsIC

Regressor 27: LinearRegression

Regressor 28: LinearSVR

Regressor 29: MLPRegressor

Regressor 30: MultiOutputRegressor

Regressor 31: MultiTaskElasticNet

Regressor 32: MultiTaskElasticNetCV

Regressor 33: MultiTaskLasso

Regressor 34: MultiTaskLassoCV

Regressor 35: NuSVR

Regressor 36: OrthogonalMatchingPursuit

Regressor 37: OrthogonalMatchingPursuitCV

Regressor 38: PLSCanonical

Regressor 39: PLSRegression

Regressor 40: PassiveAggressiveRegressor

Regressor 41: PoissonRegressor

Regressor 42: QuantileRegressor

Regressor 43: RANSACRegressor

Regressor 44: RadiusNeighborsRegressor

Regressor 45: RandomForestRegressor

Regressor 46: RegressorChain

Regressor 47: Ridge

Regressor 48: RidgeCV

Regressor 49: SGDRegressor

Regressor 50: SVR

Regressor 51: StackingRegressor

Regressor 52: TheilSenRegressor

Regressor 53: TransformedTargetRegressor

Regressor 54: TweedieRegressor

Regressor 55: VotingRegressor

이 회귀 변수 목록의 편의성을 위해 회귀 ㅂㄴ수들은 다른 색상으로 강조 표시되어 있습니다. 기본 회귀 모델이 필요한 모델은 회색으로 강조 표시되고 다른 모델은 독립적으로 사용할 수 있습니다. ONNX 형식으로 성공적으로 내보낸 모델은 녹색으로 표시되고 현재 버전의 scikit-learn 1.2.2에서 변환하는 동안 오류가 발생한 모델은 빨간색으로 표시됩니다. 테스트 작업에 적합하지 않은 메서드는 파란색으로 강조 표시됩니다.

회귀 품질 분석은 실제 값과 예측 값의 함수인 회귀 메트릭을 사용합니다. MQL5 언어에서는 "회귀 메트릭을 사용하여 ONNX 모델 평가하기"라는 문서에 자세히 설명된 여러 가지 메트릭을 사용할 수 있습니다.

이 글에서는 세 가지 메트릭을 사용하여 서로 다른 모델의 품질을 비교합니다:

- 결정 계수 R-제곱(R2);

- 평균 절대 오류(MAE);

- 평균 제곱 오차(MSE).

2.1. ONNX 모델 float 및 double로 변환하는 Scikit 학습 회귀 모델

이 섹션에서는 부동 소수점 및 배정밀도 모두에서 ONNX 형식으로 성공적으로 변환된 회귀 모델을 소개합니다.

이후 다룰 회귀 모델은 다음의 형식입니다:

- 모델 설명, 작동 원리, 장점 및 제한 사항

- 모델을 생성하고 float 및 double 형식의 ONNX 파일로 내보내고 파이썬의 ONNX 런타임을 사용하여 얻은 모델을 실행하기 위한 파이썬 스크립트입니다. sklearn.metrics를 사용하여 계산된 R^2, MAE, MSE와 같은 메트릭은 원본 및 ONNX 모델의 품질을 평가하는 데 사용됩니다.

- ONNX 런타임을 통해 ONNX 모델(float 및 double)을 실행하기 위한 MQL5 스크립트로, RegressionMetric()을 사용하여 메트릭을 계산합니다.

- 부동 소수점 및 배정밀도용 Netron의 ONNX 모델 표현.

2.1.1. sklearn.linear_model.ARDRegression

ARDRegression (자동 관련성 결정 회귀)는 모델 학습 과정에서 피처의 중요도(관련성)를 자동으로 결정하고 가중치를 설정하면서 회귀 문제를 해결하기 위해 고안된 회귀 메서드입니다.

ARDRegression을 사용하면 회귀 모델을 구축하는 데 가장 중요한 변수만 감지하고 사용할 수 있으므로 많은 변수를 다룰 때 유용할 수 있습니다.

ARDRegression의 작동 원리:

- 선형 회귀: ARDRegression은 독립 변수(피처)와 대상 변수 간의 선형 관계를 가정하는 선형 회귀를 기반으로 합니다.

- 자동 피처 중요도 결정: ARDRegression의 주요 피처는 대상 변수를 예측하는 데 가장 중요한 변수를 자동으로 결정한다는 점입니다. 이는 가중치에 사전 분포(정규화)를 도입하여 모델이 중요도가 낮은 변수에 대해 자동으로 0이란 가중치를 설정하도록 함으로써 달성할 수 있습니다.

- 사후 확률 추정: ARDRegression은 각 변수에 대한 사후 확률을 계산하여 그 중요성을 결정할 수 있습니다. 사후 확률이 높은 변수는 관련성이 높은 것으로 간주되어 0이 아닌 가중치를 받고 사후 확률이 낮은 변수는 0의 가중치를 받습니다.

- 차원 감소: 따라서 ARDRegression는 중요하지 않은 변수를 제거하여 데이터 차원을 줄일 수 있습니다.

ARDRegression의 장점:

- 중요한 변수의 자동 결정: 이 메서드는 가장 중요한 메서드만 자동으로 식별하여 사용하므로 잠재적으로 모델의 성능을 향상시키고 과적합 되는 위험을 줄일 수 있습니다.

- 다중 선형성에 대한 복원력: ARDRegression은 변수의 상관관계가 높은 경우에도 다중 공선형성을 잘 처리합니다.

ARDRegression의 한계:

- 사전 배포를 선택해야 합니다: 적절한 사전 배포를 선택하려면 실험이 필요할 수 있습니다.

- 계산의 복잡성: 특히 대규모 데이터 세트의 경우 ARDRegression 훈련은 계산 비용이 많이 들 수 있습니다.

ARDRegression은 자동으로 변수의 중요도를 결정하고 사후 확률을 기반으로 가중치를 설정하는 회귀 메서드입니다. 이 메서드는 회귀 모델을 구축할 때 중요한 변수만 고려해야 할 때와 데이터 차원을 줄여야 할 때 유용합니다.

2.1.1.1. ARDRegression 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

이 코드는 sklearn.linear_model.ARDRegression 모델을 생성하고 합성 데이터로 학습시키고 모델을 ONNX 형식으로 저장하고 float 및 double 입력 데이터를 모두 사용하여 예측을 수행합니다. 또한 원본 모델과 ONNX로 내보낸 모델 모두의 정확도를 평가합니다.

# 이 코드는 ARDRegressor 모델을 학습하고 이를 ONNX 형식(float 및 double 모두)으로 내보내고 ONNX 모델을 사용하여 예측하는 과정을 보여 줍니다.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# 소수점 이하 자릿수를 비교학 위한 함수

def compare_decimal_places(value1, value2):

# 두 값을 모두 문자열로 변환

str_value1 = str(value1)

str_value2 = str(value2)

# 문자열에서 소수점 위치 찾기

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# 값 중 소수점이 없는 경우 0을 반환합니다.

만약 dot_position1 == --1 또는 dot_position2 == --1:

return 0

# 소수점 이하 자릿수 계산

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# 소수점 이하 두 자리 수 중 최소값 찾기

min_decimal_places = min(decimal_places1, decimal_places2)

# 소수점 이하 자릿수가 일치하도록 카운트를 초기화

matching_count = 0

# 소수점 이하 문자 비교

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# 필요한 라이브러리 가져오기

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ARDRegression

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# 모델 저장 경로를 정의합니다.

data_path = argv[0]

last_index = data_path.rfind("\\")+ 1

data_path = data_path[0:last_index]

# 회귀를 위한 합성 데이터 생성

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X+ 10*np.sin(X*0.5)

model_name="ARDRegression"

onnx_model_filename = data_path + "ard_regression"

# ARDRegression 모델 만들기

regression_model = ARDRegression()

# 데이터에 모델 맞추기

regression_model.fit(X, y.ravel())

# 전체 데이터 집합에 대한 값 예측

y_pred = regression_model.predict(X)

# 모델의 성능 평가

r2 = r2_score(y, y_pred)

MSE = MEAN_SQUARE_ERROR(Y, Y_PED)

MAE = MEAN_ABSOLUTE_ERROR(Y, Y_PED)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("평균 제곱 오차:", mse)

# ONNX 모델로 변환 (float)

# 입력 데이터 유형을 FloatTensorType으로 정의합니다.

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]])]]

# 모델을 ONNX 형식으로 내보내기

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# 파일에 모델 저장

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# 모델 경로 인쇄

print(f"ONNX model saved to {onnx_filename}")

# ONNX 모델을 로드하고 예측을 수행합니다.

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# ONNX에서 입력 텐서에 대한 정보를 표시합니다.

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# ONNX에서 출력 텐서에 대한 정보를 표시합니다.

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# 입력 데이터 유형을 FloatTensorType으로 정의합니다.

initial_type_float = X.astype(np.float32)

# ONNX를 사용하여 전체 데이터 세트의 값을 예측합니다.

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# 원본 및 ONNX 모델에 대한 오류를 계산하고 표시합니다.

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# 그림 크기 설정

plt.figure(figsize=(8, 5))

# 원본 데이터와 회귀 데이터를 플로팅합니다.

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# ONNX 모델로 변환 (double)

# 입력 데이터 유형을 DoubleTensorType으로 정의합니다.

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# 모델을 ONNX 형식으로 내보내기

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# 파일에 모델 저장

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# 모델 경로 인쇄

print(f"ONNX model saved to {onnx_filename}")

# ONNX 모델을 로드하고 예측을 수행합니다.

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# ONNX에서 입력 텐서에 대한 정보를 표시합니다.

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# ONNX에서 출력 텐서에 대한 정보를 표시합니다.

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# 입력 데이터 유형을 DoubleTensorType으로 정의합니다.

initial_type_double = X.astype(np.float64)

# ONNX를 사용하여 전체 데이터 세트의 값을 예측합니다.

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# 원본 및 ONNX 모델에 대한 오류를 계산하고 표시합니다.

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# 그림 크기 설정

plt.figure(figsize=(8, 5))

# 원본 데이터와 회귀선을 그림으로 표시합니다.

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

이 스크립트는 sklearn.linear_model.ARDRegression 모델을 생성하고 학습한 다음(원래 모델은 double로 간주됨), float 및 double용 ONNX로 모델을 내보내고(ard_regression_float.onnx 및 ard_regression_double.onnx) 그 연산 정확도를 비교합니다.

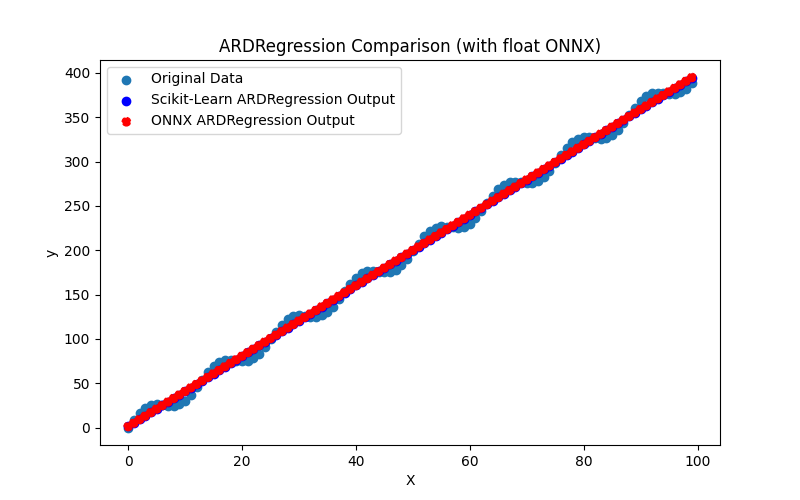

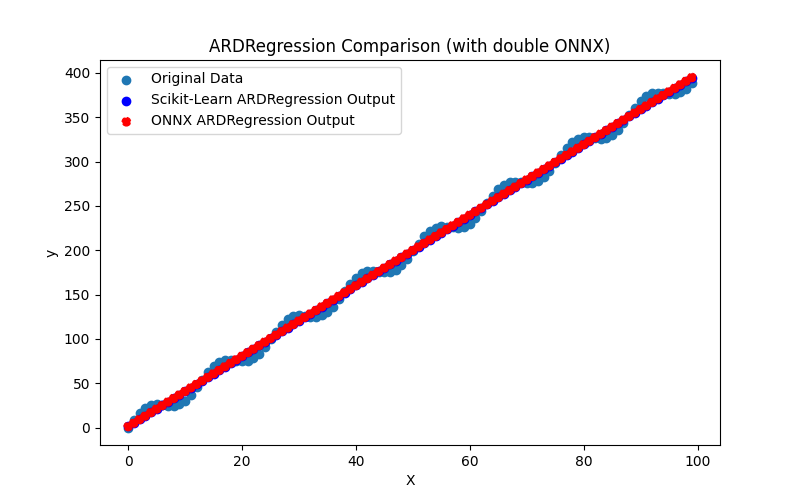

또한 float 및 double에 대한 ONNX 모델의 결과를 시각적으로 평가할 수 있도록 ARDRegression_plot_float.png 및 ARDRegression_plot_double.png 파일을 생성합니다(그림 2-3).

그림 2. ARDRegression.py의 결과(float)

그림 3. ARDRegression.py의 결과(double)

시각적으로 float 및 double용ONNX 모델은 동일하게 보입니다(그림 2-3), 자세한 정보는 저널 탭에서 확인할 수 있습니다:

Python ARDRegression Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python Python ARDRegression ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python ONNX: MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python ARDRegression ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

이 예제에서는 원본 모델을 double로 고려한 다음 각각 float 및 double에 대해 ONNX 모델 ard_regression_float.onnx 및 ard_regression_double.onnx로 내보냈습니다.

모델의 정확도를 평균 절대 오차(MAE)로 평가할 경우 float용 ONNX 모델의 정확도는 소수점 이하 6자리까지 double을 사용한 ONNX 모델은 소수점 이하 15자리까지 정확도를 유지하여 원래 모델의 정밀도와 비슷하게 유지되는 것으로 나타났습니다.

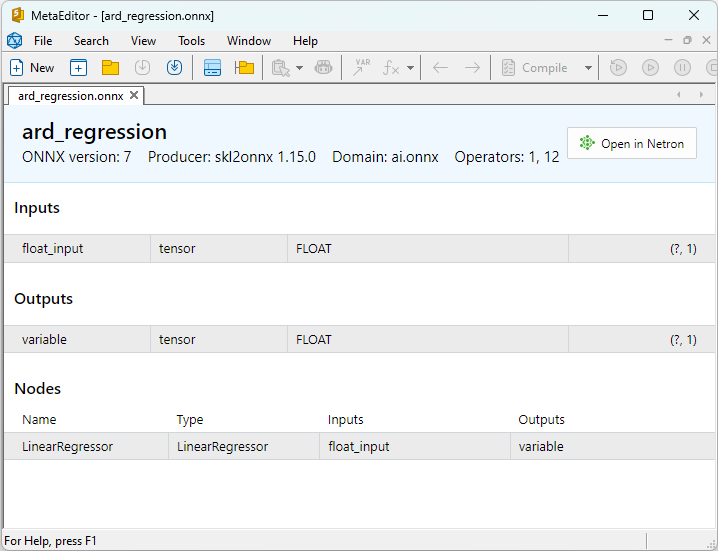

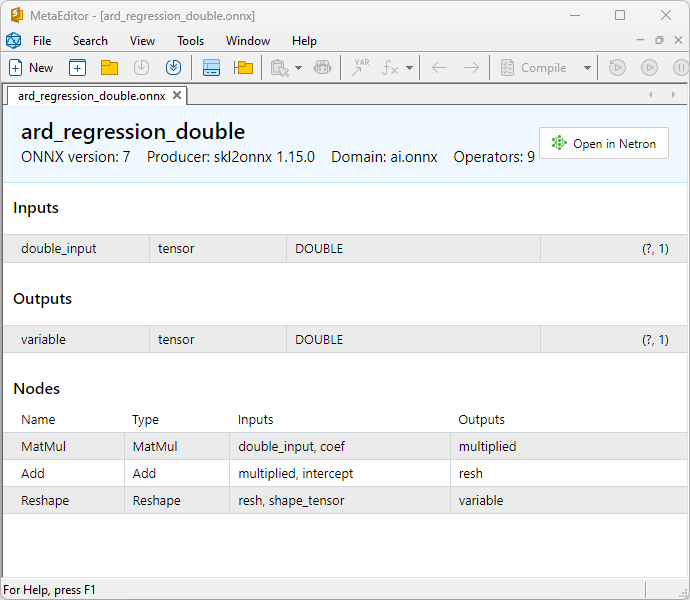

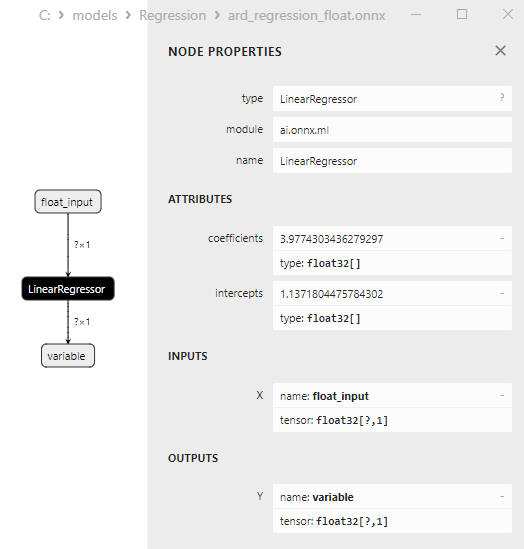

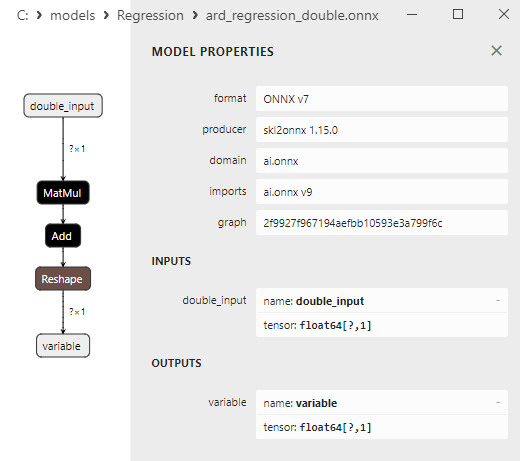

ONNX 모델의 속성은 MetaEditor에서 볼 수 있습니다(그림 4-5).

그림 4. MetaEditor의 ard_regression_float.onnx ONNX 모델

그림 5. MetaEditor의 ard_regression_double.onnx ONNX 모델

실수형과 이중 ONNX 모델을 비교하면 이 경우 ARDRegression을 위한 ONNX 모델의 계산이 다르게 수행된다는 것을 알 수 있습니다. 실수형에는 ONNX-ML의 LinearRegressor() 연산자가 사용되는 반면 이중 숫자에는 ONNX 연산자 , Add()와 Reshape() 가 사용됩니다.

ONNX에서 모델을 구현하는 것은 변환기에 따라 다릅니다; ONNX로 내보내기 예제에서는 skl2onnx 라이브러리의 skl2onnx.convert_sklearn() 함수가 사용됩니다.

2.1.1.2. ONNX 모델 실행을 위한 MQL5 코드

이 코드는 저장된 ard_regression_float.onnx 및 ard_regression_double.onnx ONNX 모델을 실행하고 MQL5에서 회귀 메트릭을 사용하는 것을 보여줍니다.

//+------------------------------------------------------------------+ //| ARDRegression.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "ARDRegression" #define ONNXFilenameFloat "ard_regression_float.onnx" #define ONNXFilenameDouble "ard_regression_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

출력:

ARDRegression (EURUSD,H1) Testing ONNX float: ARDRegression (ard_regression_float.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 ARDRegression (EURUSD,H1) ARDRegression (EURUSD,H1) Testing ONNX double: ARDRegression (ard_regression_double.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537597 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128795

파이썬에서 원래 double 모델과 비교:

Testing ONNX float: ARDRegression (ard_regression_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: ARDRegression (ard_regression_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537597

ONNX float MAE의 정확도: 소수점 이하 6자리, 정확도 ONNX double MAE: 소수점 이하 14자리.

2.1.1.3. 모델 ard_regression_float.onnx 및 ard_regression_double.onnx의 ONNX 표현은 다음과 같습니다.

Netron (웹 버전)은 모델을 시각화하고 계산 그래프를 분석하는 도구로, ONNX(Open Neural Network Exchange) 형식의 모델에 사용할 수 있습니다.

Netron은 모델 그래프와 그 아키텍처를 명확하고 인터랙티브한 형태로 표시하여 ONNX를 사용하여 만든 모델을 포함한 딥 러닝 모델의 구조와 매개변수를 탐색할 수 있습니다.

Netron의 주요 기능은 다음과 같습니다:

- 그래프 시각화: Netron은 모델의 아키텍처를 그래프로 표시하여 여러분이 레이어, 작업 및 이들 간의 연결을 확인할 수 있게 합니다. 여러분은 모델 내의 구조와 데이터 흐름을 쉽게 이해할 수 있을 것입니다.

- 대화형 탐색: 그래프에서 노드를 선택하여 각 연산자 및 해당 매개변수에 대한 추가 정보를 얻을 수 있습니다.

- 다양한 형식 지원: 네트론은 ONNX, 텐서플로우, 파이토치, 코어ML 등 다양한 딥러닝 모델 형식을 지원합니다.

- 매개변수 분석 기능: 모델의 매개변수와 가중치를 볼 수 있어 모델의 여러 부분에서 사용된 값을 이해하는 데 유용합니다.

Netron은 모델의 시각화 및 분석을 단순화하는 것을 통해 복잡한 신경망의 이해와 디버깅을 도와줍니다. 이는 머신러닝 및 딥러닝 분야의 개발자와 연구자들에게 도움이 되는 기능입니다.

이 도구를 사용하면 모델을 빠르게 검사하고 구조와 매개변수를 탐색하여 심층 신경망 작업을 쉽게 수행될 수 있도록 합니다.

네트론에 대한 자세한 내용은 관련 문서를 참조하세요: Netron을 사용한 신경망 및 Netron을 사용한 Keras 신경망.

Netron 관련 동영상::

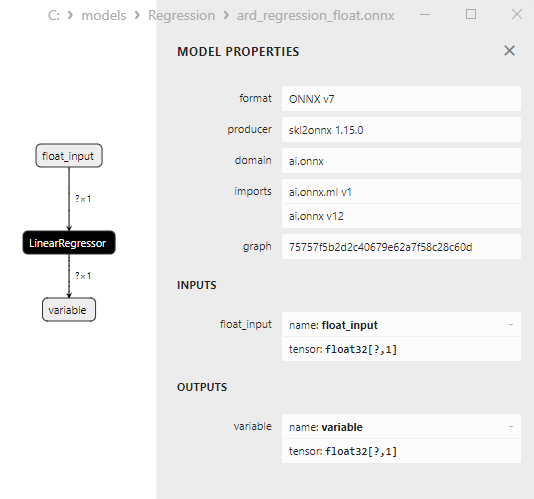

ard_regression_float.onnx 모델은 그림 6에 나와 있습니다:

그림 6. 네트론의 ard_regression_float.onnx 모델에 대한 ONNX 표현

ai.onnx.ml LinearRegressor() ONNX 연산자는 ONNX 표준의 일부로 회귀 작업에 대한 모델을 설명합니다. 이 연산자는 입력 피처를 기반으로 숫자(연속형) 값을 예측하는 회귀에 사용됩니다.

가중치, 바이어스 등 모델 파라미터와 입력 피처를 입력으로 받아 선형 회귀를 실행합니다. 선형 회귀는 각 입력 피처에 대한 매개변수(가중치)를 추정하고 이러한 피처와 가중치의 선형 조합을 수행하여 예측을 생성합니다.

이 오퍼레이터는 다음 단계를 수행합니다:

- 입력 피처와 함께 모델의 가중치 및 편향성을 가져옵니다.

- 입력 데이터의 각 예에 대해 해당 피처와 가중치의 선형 조합을 수행합니다.

- 결과 값에 바이어스를 추가합니다.

그 결과 회귀 작업에서 대상 변수를 예측할 수 있습니다.

LinearRegressor() 매개변수는 그림 7에 나와 있습니다.

그림 7. 네트론에서 ard_regression_float.onnx 모델의 LinearRegressor() 연산자 속성

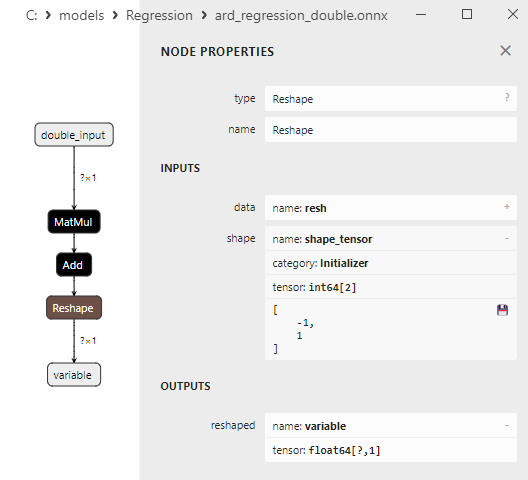

그림 8. 네트론에서 ard_regression_double.onnx 모델에 대한 ONNX 표현

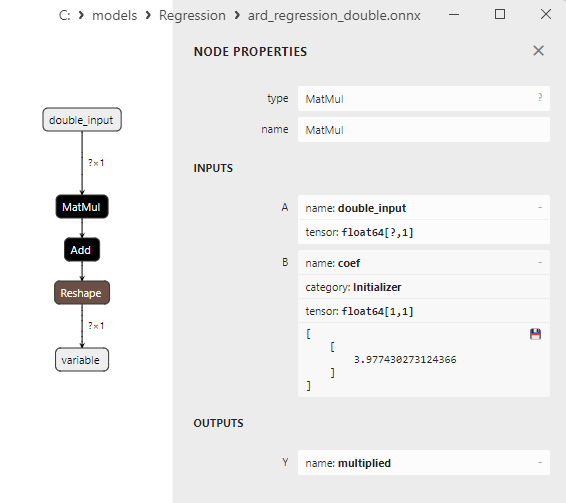

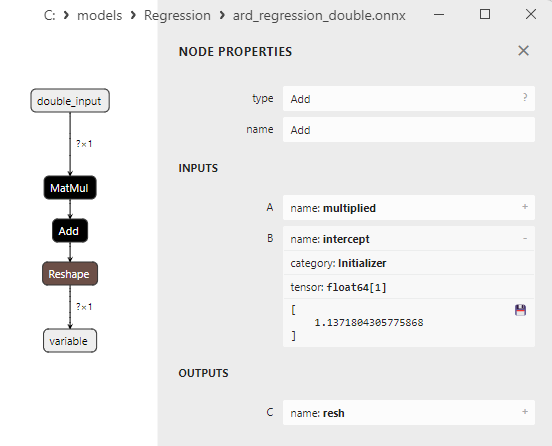

MatMul(), Add()와 , titlehttps://github.com/onnx/onnx/blob/main/docs/Operators.md#ReshapetitleReshape() ONNX 연산자의 매개변수는 그림 9-11에 나와 있습니다.

그림 9. 네트론의 ard_regression_double.onnx 모델에서 MatMul 연산자의 속성

MatMul (행렬 곱셈) ONNX 연산자는 두 행렬의 곱셈을 수행하며

두 개의 입력, 즉 두 개의 행렬을 받아 행렬의 곱을 반환합니다.

만약 두 행렬 A와 B가 있는 경우 Matmul(A, B)의 결과는 행렬 C이며, 여기서 각 요소 C[i][j]는 행렬 A의 행 i에 있는 요소와 행렬 B의 열 j에 있는 요소의 곱의 합으로 계산됩니다.

그림 10. 네트론 ard_regression_double.onnx 모델에서 추가 연산자의 속성

Add() ONNX 연산자는 같은 모양의 텐서 또는 배열 두 개를 요소 단위로 더하는 작업을 수행하며

두 개의 입력을 받아 결과 텐서의 각 요소는 입력 텐서의 해당 요소의 합과 같은 결과를 반환합니다.

그림 11. 네트론의 ard_regression_double.onnx 모델에서 Reshape 연산자의 속성

Reshape(-1,1) ONNX 연산자는 입력 데이터의 모양(또는 차원)을 수정하는 데 사용됩니다. 이 연산자에서 차원에 대한 값 -1은 데이터 일관성을 보장하기 위해 다른 차원을 기준으로 해당 차원의 크기가 자동으로 계산되어야 한다는 것을 나타냅니다.

두 번째 차원의 값 1은 도형 변환 후 각 요소가 하나의 하위 차원을 갖도록 지정합니다.

2.1.2. sklearn.linear_model.BayesianRidge

BayesianRidge는 베이지안 접근 방식을 사용하여 모델 매개 변수를 추정하는 회귀 메서드입니다. 이 메서드를 사용하면 파라미터의 사전 분포를 모델링하고 데이터를 고려하여 업데이트하여 파라미터의 사후 분포를 얻을 수 있습니다.

BayesianRidge는 하나 또는 여러 개의 독립 변수를 기반으로 종속 변수를 예측하도록 설계된 베이지안 회귀 메서드입니다.

BayesianRidge의 작동 원리:

- 매개변수의 사전 배포: 모델 파라미터의 사전 분포를 정의하는 것으로 시작합니다. 이 분포는 데이터를 고려하기 전에 모델 매개변수에 대한 사전 지식 또는 가정을 나타냅니다. BayesianRidge의 경우 가우스 형태의 사전 분포가 사용됩니다.

- 매개변수 분포 업데이트하기: 사전 매개변수 분포가 설정되면 데이터를 기반으로 업데이트됩니다. 이는 데이터를 고려하여 매개변수의 사후 분포를 계산하는 베이지안 이론을 사용하여 수행됩니다. 필수적인 측면은 후행 분포의 형태에 영향을 미치는 하이퍼패러미터의 추정입니다.

- 예측: 매개변수의 사후 분포를 추정하고 나면 새로운 관측값에 대한 예측을 할 수 있습니다. 이렇게 하면 단일 포인트 값이 아닌 예측 분포가 생성되므로 예측의 불확실성을 고려할 수 있습니다.

BayesianRidge의 장점:

- 불확실성 고려: BayesianRidge는 모델 매개변수 및 예측의 불확실성을 설명합니다. 포인트 예측 대신 신뢰 구간이 제공됩니다.

- 정규화: 베이지안 회귀 메서드는 모델 정규화에 유용하며 과적합을 방지하는 데 도움이 될 수 있습니다.

- 자동 피처 선택: BayesianRidge는 중요하지 않은 피처의 가중치를 줄여 피처의 중요도를 자동으로 결정할 수 있습니다.

BayesianRidge의 한계:

- 계산의 복잡성: 이 메서드를 사용하려면 매개변수를 추정하고 사후 분포를 계산하는 데 계산 리소스가 필요합니다.

- 높은 추상화 수준: 베이지안 리지를 이해하고 사용하려면 베이지안 통계에 대한 더 깊은 이해가 필요할 수 있으며

- 항상 최선의 선택은 아닙니다: 특히 제한된 데이터를 다루는 경우 특정 회귀 작업에서는 BayesianRidge가 가장 적합한 메서드가 아닐 수도 있습니다.

BayesianRidge는 매개변수 및 예측의 불확실성이 중요한 회귀 작업과 모델 정규화가 필요한 경우에 유용합니다.

2.1.2.1. BayesianRidge 모델을 생성하고 float 및 double용 ONNX로 내보내기 위한 코드

이 코드는 sklearn.linear_model.BayesianRidge 모델을 생성하고 합성 데이터로 학습시키고 모델을 ONNX 형식으로 저장하고 플로트 및 더블 입력 데이터를 모두 사용하여 예측을 수행합니다. 또한 원본 모델과 ONNX로 내보낸 모델 모두의 정확도를 평가합니다.

# 이 코드는 BayesianRidge 모델을 학습하고, 이를 ONNX 형식(float 및 double 모두)으로 내보내고 ONNX 모델을 사용하여 예측하는 과정을 보여 줍니다.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# 소수점 이하 자릿수를 비교학 위한 함수

def compare_decimal_places(value1, value2):

# 두 값을 모두 문자열로 변환

str_value1 = str(value1)

str_value2 = str(value2)

# 문자열에서 소수점 위치 찾기

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# 값 중 소수점이 없는 경우 0을 반환합니다.

if dot_position1 == -1 or dot_position2 == -1:

return 0

# 소수점 이하 자릿수 계산

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# 소수점 이하 두 자리 수 중 최소값 찾기

min_decimal_places = min(decimal_places1, decimal_places2)

# 소수점 이하 자릿수가 일치하도록 카운트를 초기화

matching_count = 0

# 소수점 이하 문자 비교

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# 필요한 라이브러리 가져오기

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import BayesianRidge

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# 모델 저장 경로를 정의합니다.

data_path = argv[0]

last_index = data_path.rfind("\\")+ 1

data_path = data_path[0:last_index]

# 회귀를 위한 합성 데이터 생성

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X+ 10*np.sin(X*0.5)

model_name = "BayesianRidge"

onnx_model_filename = data_path + "bayesian_ridge"

# BayesianRidge 회귀 모델 만들기

regression_model = BayesianRidge()

# 데이터에 모델 맞추기

regression_model.fit(X, y.ravel())

# 전체 데이터 집합에 대한 값 예측

y_pred = regression_model.predict(X)

# 모델의 성능 평가

r2 = r2_score(y, y_pred)

MSE = MEAN_SQUARE_ERROR(Y, Y_PED)

MAE = MEAN_ABSOLUTE_ERROR(Y, Y_PED)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# ONNX 모델로 변환 (float)

# 입력 데이터 유형을 FloatTensorType으로 정의합니다.

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]])]]

# 모델을 ONNX 형식으로 내보내기

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# 파일에 모델 저장

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# 모델 경로 인쇄

print(f"ONNX model saved to {onnx_filename}")

# ONNX 모델을 로드하고 예측을 수행합니다.

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# ONNX에서 입력 텐서에 대한 정보를 표시합니다.

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# ONNX에서 출력 텐서에 대한 정보를 표시합니다.

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# 입력 데이터 유형을 FloatTensorType으로 정의합니다.

initial_type_float = X.astype(np.float32)

# ONNX를 사용하여 전체 데이터 세트의 값을 예측합니다.

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# 원본 및 ONNX 모델에 대한 오류를 계산하고 표시합니다.

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# 그림 크기 설정

plt.figure(figsize=(8,5))

# 원본 데이터와 회귀 데이터를 플로팅합니다.

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# ONNX 모델로 변환 (double)

# 입력 데이터 유형을 DoubleTensorType으로 정의합니다.

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# 모델을 ONNX 형식으로 내보내기

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# 파일에 모델 저장

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# 모델 경로 인쇄

print(f"ONNX model saved to {onnx_filename}")

# ONNX 모델을 로드하고 예측을 수행합니다.

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# ONNX에서 입력 텐서에 대한 정보를 표시합니다.

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# ONNX에서 출력 텐서에 대한 정보를 표시합니다.

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# 입력 데이터 유형을 DoubleTensorType으로 정의합니다.

initial_type_double = X.astype(np.float64)

# ONNX를 사용하여 전체 데이터 세트의 값을 예측합니다.

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# 원본 및 ONNX 모델에 대한 오류를 계산하고 표시합니다.

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# 그림 크기 설정

plt.figure(figsize=(8,5))

# 원본 데이터와 회귀선을 그림으로 표시합니다.

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

출력:

Python BayesianRidge Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python Python BayesianRidge ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python BayesianRidge ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

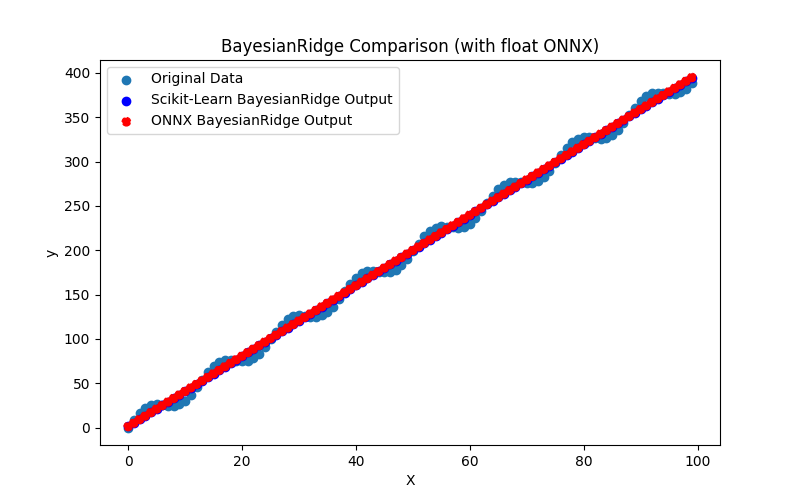

그림 12. BayesianRidge.py의 결과(float ONNX)

2.1.2.2. ONNX 모델 실행을 위한 MQL5 코드

이 코드는 저장된 bayesian_ridge_float.onnx 및 bayesian_ridge_double.onnx ONNX 모델을 실행하고 MQL5에서 회귀 메트릭을 사용하는 것을 보여 줍니다.

//+------------------------------------------------------------------+ //| BayesianRidge.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "BayesianRidge" #define ONNXFilenameFloat "bayesian_ridge_float.onnx" #define ONNXFilenameDouble "bayesian_ridge_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

출력:

BayesianRidge (EURUSD,H1) Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 BayesianRidge (EURUSD,H1) BayesianRidge (EURUSD,H1) Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) BayesianRidge (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 BayesianRidge (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537624 BayesianRidge (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128866

파이썬에서 원래 double 모델과 비교:

Testing ONNX float: BayesianRidge (bayesian_ridge_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: BayesianRidge (bayesian_ridge_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537624

ONNX float MAE의 정확도: 소수점 이하 6자리, 정확도 ONNX double MAE: 소수점 이하 13자리.

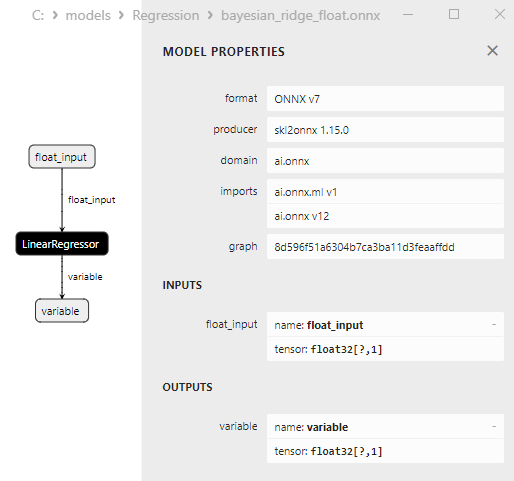

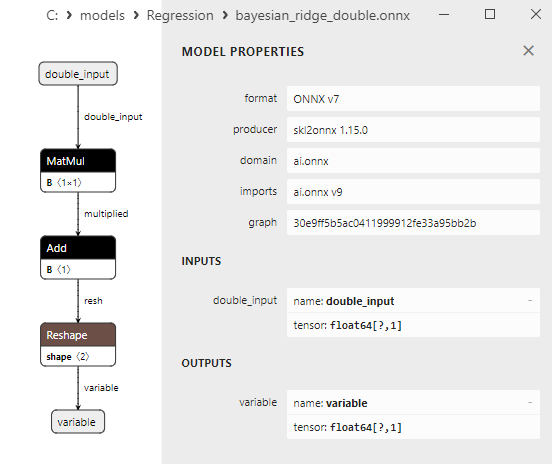

2.1.2.3. bayesian_ridge_float.onnx and bayesian_ridge_double.onnx의 ONNX 표현

그림 13. 네트론에서 bayesian_ridge_float.onnx의 ONNX 표현

그림 14. 네트론에서 bayesian_ridge_double.onnx의 ONNX 표현

ElasticNet 및 ElasticNetCV 메서드에 대한 참고 사항

회귀 모델, 특히 선형 회귀를 정규화하는 데 사용되는 두 가지 관련 머신 러닝 메서드로는 ElasticNet과 ElasticNetCV가 있습니다. 이들은 서로 공통의 기능을 공유하지만 사용 및 적용 방식이 다릅니다.

ElasticNet(엘라스틱 넷 회귀):

- 작동 원리: ElasticNet은 Lasso(L1 정규화)와 Ridge(L2 정규화)를 결합한 회귀 메서드입니다. 하나는 올가미처럼 계수의 절대값이 큰 경우 모델에 불이익을 주고 다른 하나는 릿지처럼 계수의 제곱이 큰 경우 모델에 불이익을 주는 두 가지 정규화 구성 요소를 손실 함수에 추가합니다.

- ElasticNet은 일반적으로 데이터에 다중 상관관계가 있는 경우(피처의 상관관계가 높은 경우)와 차원 축소 및 계수 값 제어가 필요한 경우에 사용됩니다.

ElasticNetCV(Elastic Net 교차 검증):

- 작동 원리: ElasticNetCV는 교차 검증을 사용하여 최적의 하이퍼파라미터 알파(L1과 L2 정규화 사이의 혼합 계수)와 람다(정규화 강도)를 자동으로 선택하는 ElasticNet의 확장 기능입니다. 다양한 알파 및 람다 값을 반복하여 교차하여 유효성 검사에서 가장 우수한 성능을 발휘하는 조합을 선택합니다.

- 장점: ElasticNetCV는 교차 검증을 기반으로 모델 매개변수를 자동으로 조정하므로 수동으로 조정할 필요 없이 최적의 하이퍼파라미터 값을 선택할 수 있습니다. 이렇게 하면 더 편리하게 사용할 수 있고 모델의 과적합을 방지할 수 있습니다.

따라서 ElasticNet과 ElasticNetCV의 가장 큰 차이점은 ElasticNet은 데이터에 적용되는 회귀 메서드인 반면 ElasticNetCV는 교차 검증을 사용하여 ElasticNet 모델에 대한 최적의 하이퍼파라미터 값을 자동으로 찾아주는 도구라는 점입니다. 최적의 모델 매개변수를 찾고 튜닝 프로세스를 더욱 자동화해야 할 때 ElasticNetCV가 유용합니다.

2.1.3. sklearn.linear_model.ElasticNet

ElasticNet은 L1(올가미)과 L2(릿지) 정규화의 조합을 나타내는 회귀 메서드입니다.

이 메서드는 일련의 피처을 기반으로 대상 변수의 수치 값을 예측하는 회귀 분석에 사용됩니다. ElasticNet은 과적합을 제어하고 모델 계수에 대한 L1 및 L2 페널티를 모두 고려합니다.

ElasticNet의 작동 원리:

- 입력 데이터: 피처(독립 변수)와 대상 변수의 해당 값이 있는 원본 데이터 세트에서 시작합니다.

- 목적 함수: ElasticNet은 평균 제곱 오차(MSE)와 두 개의 정규화라는 두 가지 구성 요소를 포함하는 손실 함수를 최소화합니다: L1(올가미) 및 L2(능선). 즉 목적 함수는 다음과 같습니다:

Objective Function = MSE + α * L1 + β * L2

여기서 α와 β는 각각 L1 및 L2 정규화의 가중치를 제어하는 하이퍼파라미터입니다. - 최적의 α와 β 찾기: 교차 검증 메서드는 일반적으로 α와 β의 최적 값을 찾는 데 사용됩니다. 이를 통해 과적합을 줄이는 것과 필수 피처를 보존하는 것 사이에서 균형을 이루는 값을 선택할 수 있습니다.

- 모델 교육: ElasticNet은 목적 함수를 최소화하여 최적의 α와 β를 고려하며 모델을 학습시킵니다.

- 예측: 모델이 학습된 후에는 ElasticNet을 사용해 새로운 데이터의 목표 변수 값을 예측할 수 있습니다.

ElasticNet의 장점:

- 피처 선택 능력: ElasticNet은 중요하지 않은 피처에 대해서는 가중치를 0으로 설정하여 가장 중요한 피처를 자동으로 선택할 수 있습니다(Lasso와 유사).

- 과적합 제어: ElasticNet을 사용하면 L1 및 L2 정규화로 인한 과적합을 제어할 수 있습니다.

- 다연속성 다루기: 이 메서드는 다중 선형성(피처 간의 높은 상관관계)이 존재하는 경우 L2 정규화를 통해 다중 선형 피처의 영향을 줄일 수 있으므로 유용합니다.

ElasticNet의 한계:

- 하이퍼파라미터 α와 β의 조정이 필요한데 이는 간단한 작업이 아닐 수 있습니다.

- 매개변수 선택에 따라 ElasticNet은 너무 적거나 너무 많은 피처를 유지하게 되고 이에 따라 모델의 품질에 영향을 미칠 수 있습니다.

ElasticNet은 피처 선택과 과적합 제어가 중요한 작업에서 유용할 수 있는 강력한 회귀 메서드입니다.

2.1.3.1. ElasticNet 모델을 생성하고 float 및 double 용의 ONNX로 내보내는 코드

이 코드는 sklearn.linear_model.ElasticNet 모델을 생성하고 합성 데이터로 학습시키고 모델을 ONNX 형식으로 저장하고 플로트 및 더블 입력 데이터를 모두 사용하여 예측을 수행합니다. 또한 원본 모델과 ONNX로 내보낸 모델 모두의 정확도를 평가합니다.

# 이 코드는 ElasticNet 모델을 학습하고 이를 ONNX 형식(float 및 double)으로 내보내고 ONNX 모델을 사용하여 예측하는 과정을 보여줍니다.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# 소수점 이하 자릿수를 비교학 위한 함수

def compare_decimal_places(value1, value2):

# 두 값을 모두 문자열로 변환

str_value1 = str(value1)

str_value2 = str(value2)

# 문자열에서 소수점 위치 찾기

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# 값 중 소수점이 없는 경우 0을 반환합니다.

if dot_position1 == -1 or dot_position2 == -1:

return 0

# 소수점 이하 자릿수 계산

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# 소수점 이하 두 자리 수 중 최소값 찾기

min_decimal_places = min(decimal_places1, decimal_places2)

# 소수점 이하 자릿수가 일치하도록 카운트를 초기화

matching_count = 0

# 소수점 이하 문자 비교

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# 필요한 라이브러리 가져오기

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ElasticNet

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# 모델 저장 경로를 정의합니다.

data_path = argv[0]

last_index = data_path.rfind("\\")+ 1

data_path = data_path[0:last_index]

# 회귀를 위한 합성 데이터 생성

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name = "ElasticNet"

onnx_model_filename = data_path + "elastic_net"

# ElasticNet 모델 생성

regression_model = ElasticNet()

# 데이터에 모델 맞추기

regression_model.fit(X,y)

# 전체 데이터 집합에 대한 값 예측

y_pred = regression_model.predict(X)

# 모델의 성능 평가

r2 = r2_score(y, y_pred)

MSE = MEAN_SQUARE_ERROR(Y, Y_PED)

MAE = MEAN_ABSOLUTE_ERROR(Y, Y_PED)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# ONNX 모델로 변환 (float)

# 입력 데이터 유형을 FloatTensorType으로 정의합니다.

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]])]]

# 모델을 ONNX 형식으로 내보내기

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# 파일에 모델 저장

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# 모델 경로 인쇄

print(f"ONNX model saved to {onnx_filename}")

# ONNX 모델을 로드하고 예측을 수행합니다.

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# ONNX에서 입력 텐서에 대한 정보를 표시합니다.

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# ONNX에서 출력 텐서에 대한 정보를 표시합니다.

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# 입력 데이터 유형을 FloatTensorType으로 정의합니다.

initial_type_float = X.astype(np.float32)

# ONNX를 사용하여 전체 데이터 세트의 값을 예측합니다.

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# 원본 및 ONNX 모델에 대한 오류를 계산하고 표시합니다.

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-squared (Coefficient of determination)", r2_onnx_float)

print("Mean Absolute Error:", mae_onnx_float)

print("Mean Squared Error:", mse_onnx_float)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_float))

print("float ONNX model precision: ",compare_decimal_places(mae, mae_onnx_float))

# 그림 크기 설정

plt.figure(figsize=(8,5))

# 원본 데이터와 회귀선을 그림으로 표시합니다.

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with float ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# ONNX 모델로 변환 (double)

# 입력 데이터 유형을 DoubleTensorType으로 정의합니다.

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# 모델을 ONNX 형식으로 내보내기

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# 파일에 모델 저장

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" ONNX model (double)")

# 모델 경로 인쇄

print(f"ONNX model saved to {onnx_filename}")

# ONNX 모델을 로드하고 예측을 수행합니다.

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# ONNX에서 입력 텐서에 대한 정보를 표시합니다.

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# ONNX에서 출력 텐서에 대한 정보를 표시합니다.

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# 입력 데이터 유형을 DoubleTensorType으로 정의합니다.

initial_type_double = X.astype(np.float64)

# ONNX를 사용하여 전체 데이터 세트의 값을 예측합니다.

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# 원본 및 ONNX 모델에 대한 오류를 계산하고 표시합니다.

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-squared (Coefficient of determination)", r2_onnx_double)

print("Mean Absolute Error:", mae_onnx_double)

print("Mean Squared Error:", mse_onnx_double)

print("R^2 matching decimal places: ",compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places: ",compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places: ",compare_decimal_places(mse, mse_onnx_double))

print("double ONNX model precision: ",compare_decimal_places(mae, mae_onnx_double))

# 그림 크기 설정

plt.figure(figsize=(8,5))

# 원본 데이터와 회귀선을 그림으로 표시합니다.

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparison (with double ONNX)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

출력:

Python ElasticNet Original model (double) Python R-squared (Coefficient of determination): 0.9962377031744798 Python Mean Absolute Error: 6.344394662876524 Python Mean Squared Error: 49.78556489812415 Python Python ElasticNet ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\elastic_net_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962377032416807 Python Mean Absolute Error: 6.344395027824294 Python Mean Squared Error: 49.78556400887057 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 5 Python MSE matching decimal places: 6 Python float ONNX model precision: 5 Python Python ElasticNet ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\elastic_net_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962377031744798 Python Mean Absolute Error: 6.344394662876524 Python Mean Squared Error: 49.78556489812415 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

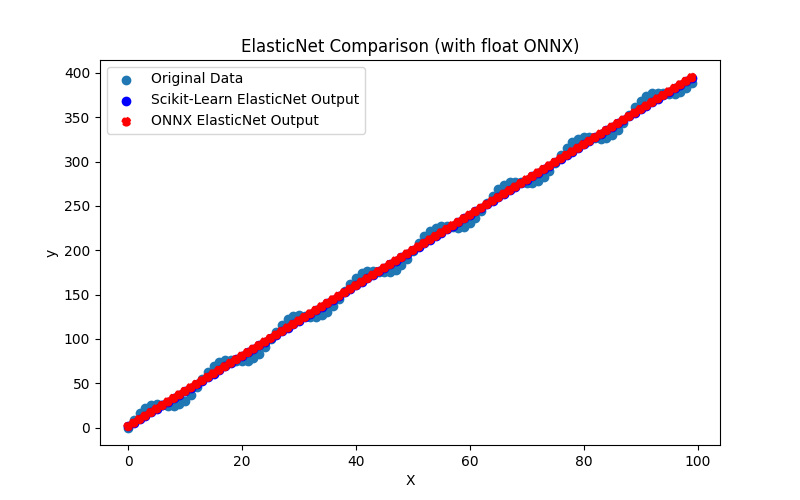

그림 15. ElasticNet.py의 결과(float ONNX)

2.1.3.2. ONNX 모델 실행을 위한 MQL5 코드

이 코드는 저장된 elastic_net_double.onnx 및 elastic_net_float.onnx 모델을 실행하고 MQL5에서 회귀 메트릭을 사용하는 것을 보여줍니다.