Modèles de régression de la bibliothèque Scikit-learn et leur export vers ONNX

ONNX(Open Neural Network Exchange) est un format de description et d'échange de modèles d'apprentissage automatique, qui permet de transférer des modèles entre différents modèles d'apprentissage automatique. Dans l'apprentissage profond et les réseaux neuronaux, des types de données comme float32 sont fréquemment utilisés. Ils sont largement appliqués car ils offrent généralement une précision et une efficacité acceptables pour la formation des modèles d'apprentissage profond.

Certains modèles classiques d'apprentissage automatique sont difficiles à représenter sous forme d’opérateurs ONNX. Des opérateurs ML (ai.onnx.ml) supplémentaires ont été introduits pour les mettre en œuvre dans ONNX. Il est intéressant de noter que selon la spécification ONNX, les opérateurs clés de cet ensemble (LinearRegressor, SVMRegressor, TreeEnsembleRegressor) peuvent accepter différents types de données d'entrée (tensor(float), tensor(double), tensor(int64), tensor(int32)), mais qu’ils renvoient toujours le type tensor(float) en sortie. Le paramétrage de ces opérateurs est également effectué à l'aide de nombres à virgule flottante, ce qui peut limiter la précision des calculs, en particulier si des nombres à double précision ont été utilisés pour définir les paramètres du modèle original.

Cela peut entraîner une perte de précision lors de la conversion de modèles ou de l'utilisation de différents types de données dans le processus de conversion et de traitement des données dans ONNX. Beaucoup dépend du convertisseur, comme nous le verrons plus loin ; certains modèles parviennent à contourner ces limitations et à assurer la portabilité totale des modèles ONNX, ce qui permet de travailler avec eux en double précision sans perdre en précision. Il est important de prendre en compte ces caractéristiques lorsque l'on travaille avec des modèles et leur représentation dans ONNX. En particulier dans les cas où la précision de la représentation des données est importante.

Scikit-learn est l'une des bibliothèques les plus populaires et les plus utilisées pour l'apprentissage automatique dans la communauté Python. Elle offre un large éventail d'algorithmes, une interface conviviale et une bonne documentation. L'article précédent, "Modèles de classification de la bibliothèque Scikit-learn et leur export vers ONNX", traitait des modèles de classification.

Dans cet article, nous allons explorer l'application des modèles de régression dans le package Scikit-learn, calculer leurs paramètres en double précision pour le jeu de données de test, tenter de les convertir au format ONNX pour la précision flottante et pour précision double, et utiliser les modèles obtenus dans des programmes MQL5. Nous comparerons également la précision des modèles originaux et de leurs versions ONNX pour la précision flottante et la précision double. Nous examinerons aussi la représentation ONNX des modèles de régression, ce qui permettra de mieux comprendre leur structure interne et leur fonctionnement.

Sommaire

- Si cela vous dérange, vous pouvez apporter votre contribution

- 1. Ensemble des Données de Test

Le script d'affichage de l'ensemble des données de test - 2. Modèles de régression

2.0. Liste des Modèles de Régression Scikit-learn - 2.1. Modèles de Régression Scikit-learn convertis en modèles ONNX float et double

- 2.1.1. sklearn.linear_model.ARDRegression

2.1.1.1. Code de création de l'ARDRegression

2.1.1.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.1.3. Représentation ONNX de ard_regression_float.onnx et ard_regression_double.onnx - 2.1.2. sklearn.linear_model.BayesianRidge

2.1.2.1. Code pour créer le modèle BayesianRidge et l'exporter vers ONNX pour float et double

2.1.2.2. Code MQL5 pour l'exécution des modèles ONNX

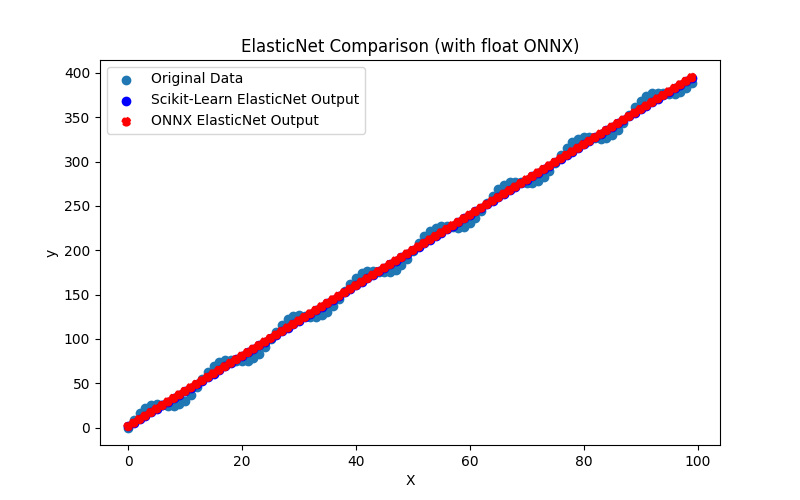

2.1.2.3. Représentation ONNX de bayesian_ridge_float.onnx et bayesian_ridge_double.onnx - 2.1.3. sklearn.linear_model.ElasticNet

2.1.3.1. Code pour créer le modèle ElasticNet et l'exporter vers ONNX pour float et double

2.1.3.2. Code MQL5 pour l'exécution des modèles ONNX

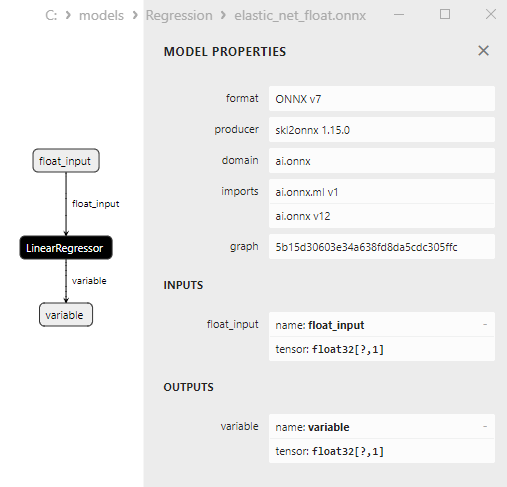

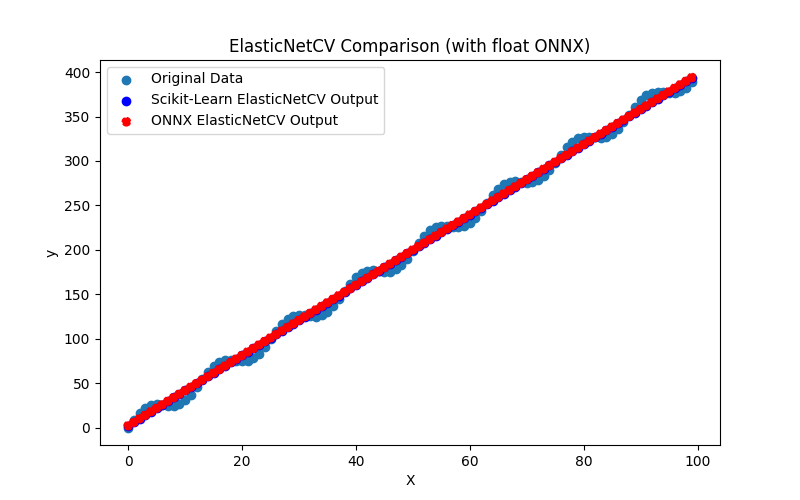

2.1.3.3. Représentation ONNX de elastic_net_float.onnx et elastic_net_double.onnx - 2.1.4. sklearn.linear_model.ElasticNetCV

2.1.4.1. Code pour créer le modèle ElasticNet et l'exporter vers ONNX pour float et double

2.1.4.2. Code MQL5 pour l'exécution des modèles ONNX

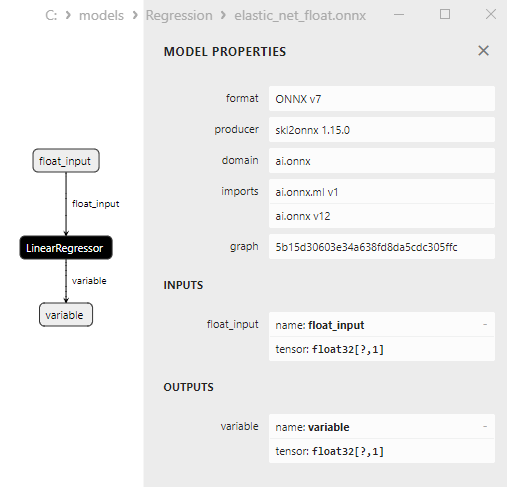

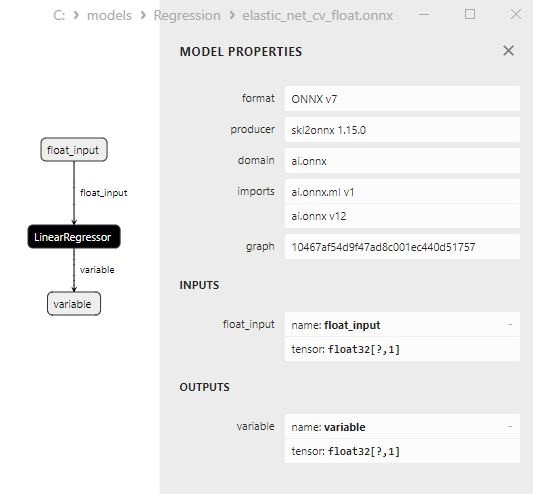

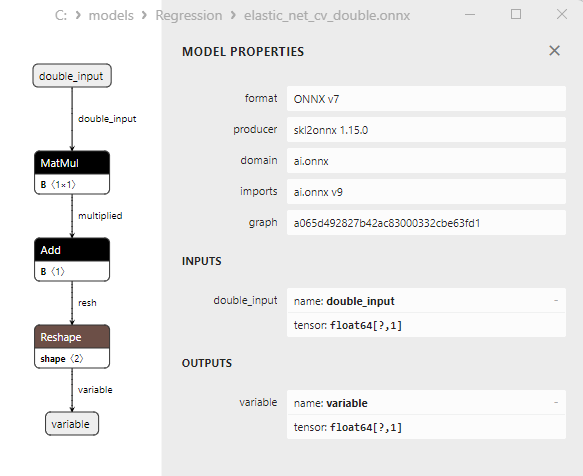

2.1.4.3. Représentation ONNX de elastic_net_cv_float.onnx et elastic_net_cv_double.onnx - 2.1.5. sklearn.linear_model.HuberRegressor

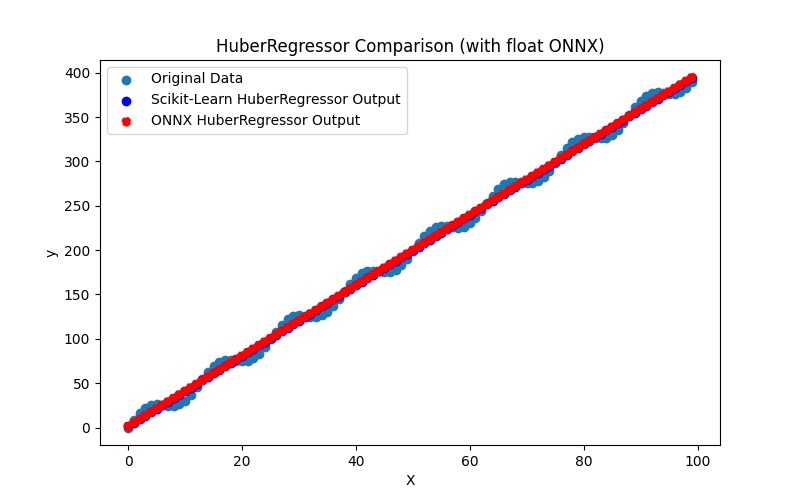

2.1.5.1. Code pour créer le modèle HuberRegressor et l'exporter vers ONNX pour float et double

2.1.5.2. Code MQL5 pour l'exécution des modèles ONNX

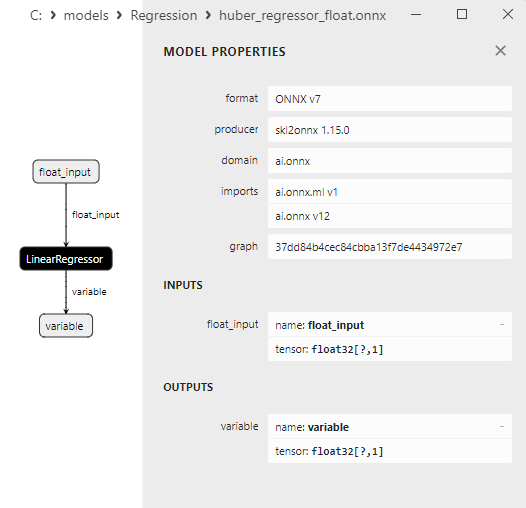

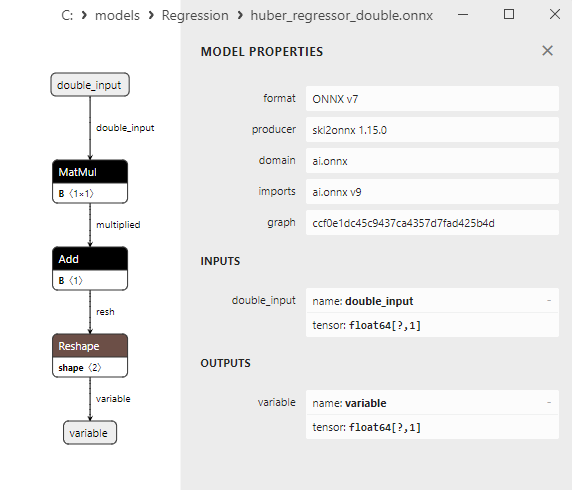

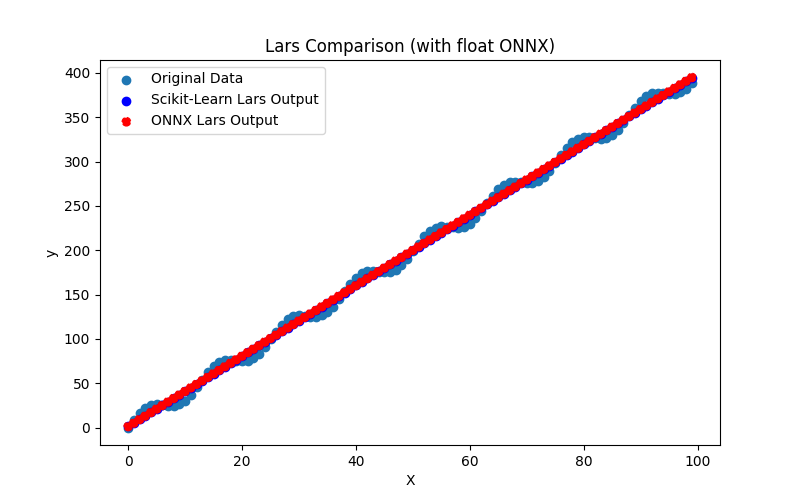

2.1.5.3. Représentation ONNX de huber_regressor_float.onnx et huber_regressor_double.onnx - 2.1.6. sklearn.linear_model.Lars

2.1.6.1. Code pour créer le modèle Lars et l'exporter vers ONNX pour float et double

2.1.6.2. Code MQL5 pour l'exécution des modèles ONNX

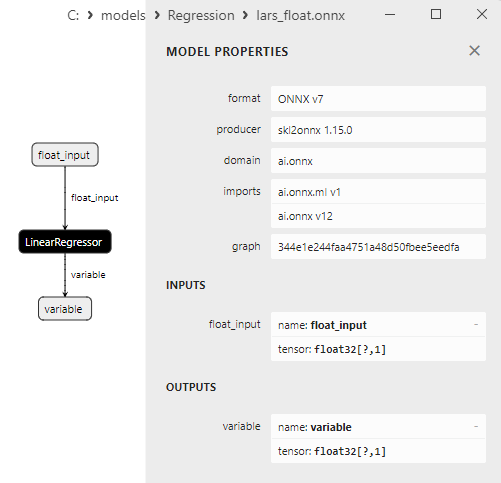

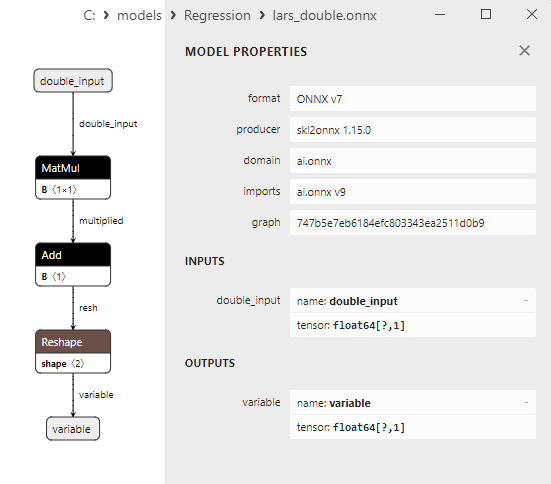

2.1.6.3. Représentation ONNX de lars_float.onnx et lars_double.onnx - 2.1.7. sklearn.linear_model.LarsCV

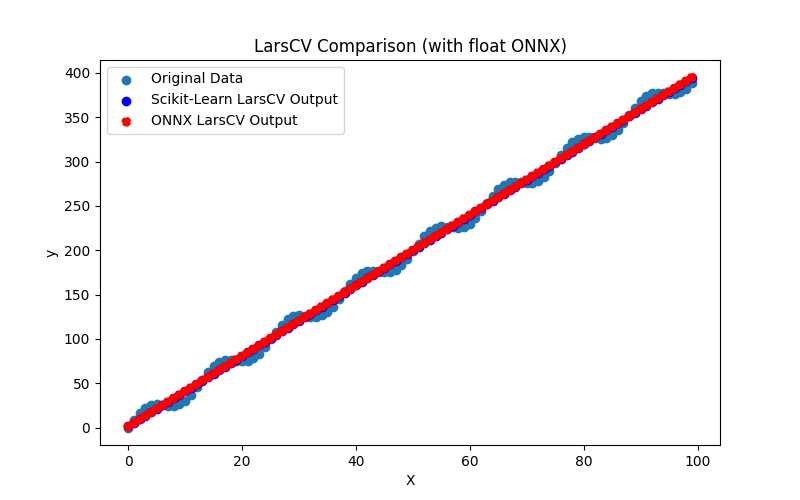

2.1.7.1. Code pour créer le modèle LarsCV et l'exporter vers ONNX pour float et double

2.1.7.2. Code MQL5 pour l'exécution des modèles ONNX

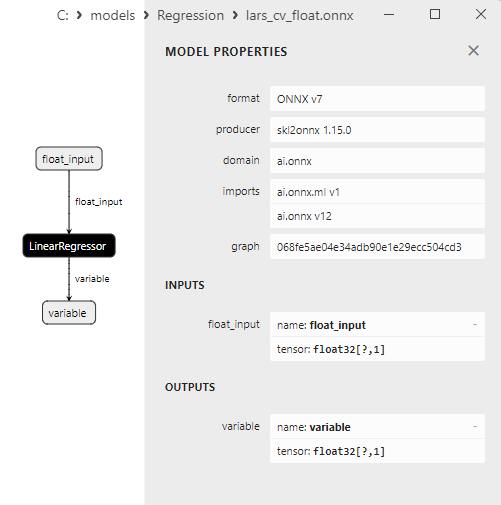

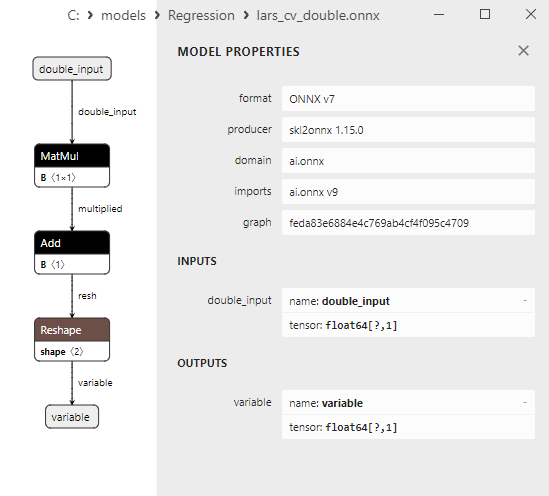

2.1.7.3. Représentation ONNX de lars_cv_float.onnx et lars_cv_double.onnx - 2.1.8. sklearn.linear_model.Lasso

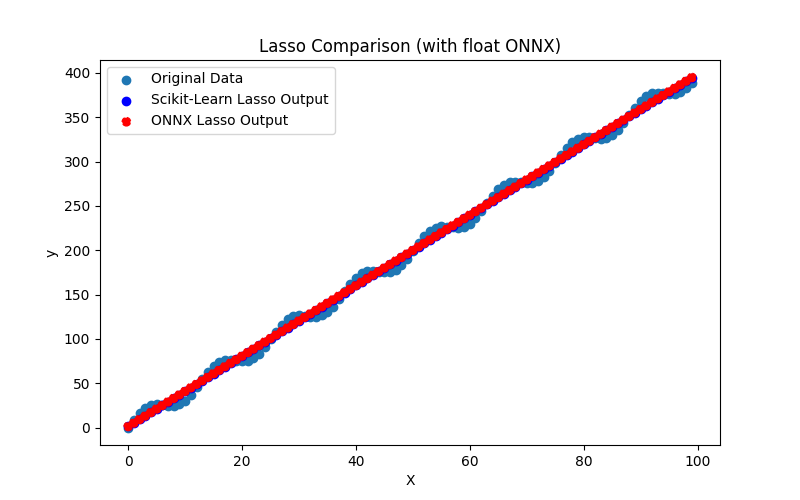

2.1.8.1. Code pour créer le modèle Lasso et l'exporter vers ONNX pour float et double

2.1.8.2. Code MQL5 pour l'exécution des modèles ONNX

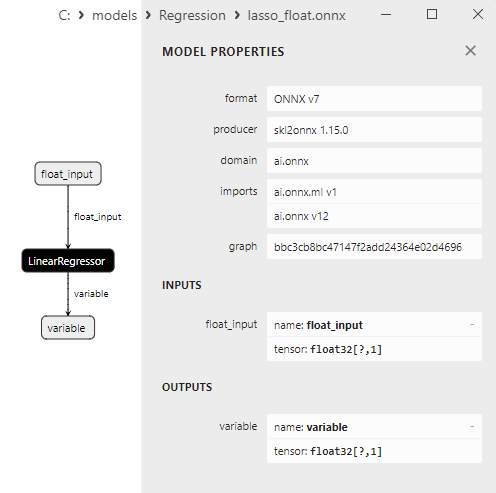

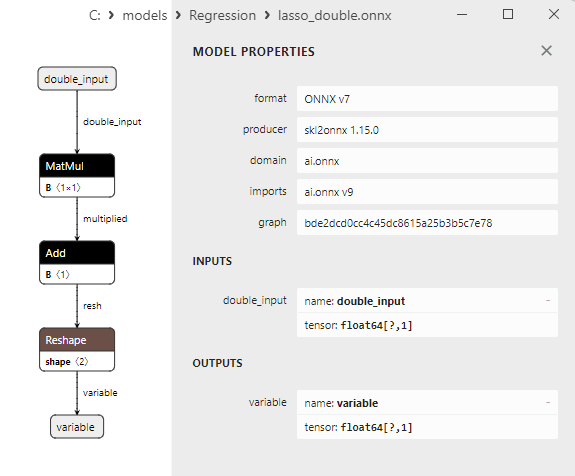

2.1.8.3. Représentation ONNX de lasso_float.onnx et lasso_double.onnx - 2.1.9. sklearn.linear_model.LassoCV

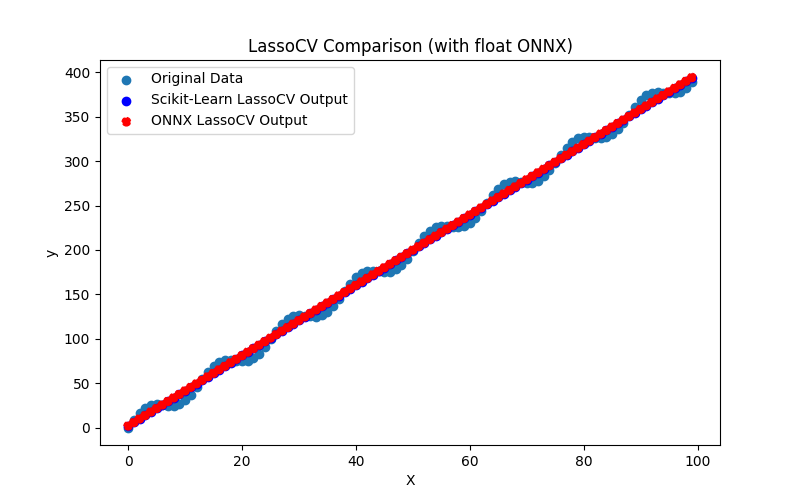

2.1.9.1. Code pour créer le modèle LassoCV et l'exporter vers ONNX pour float et double

2.1.9.2. Code MQL5 pour l'exécution des modèles ONNX

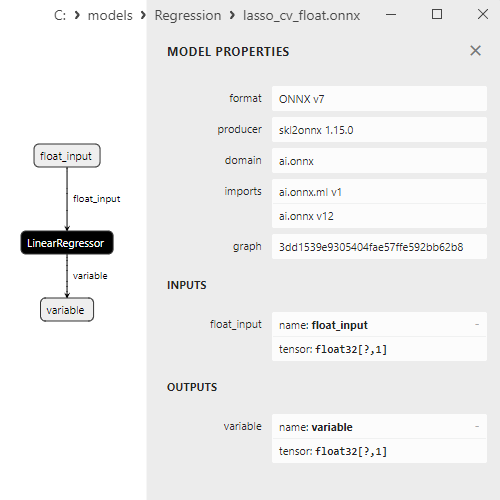

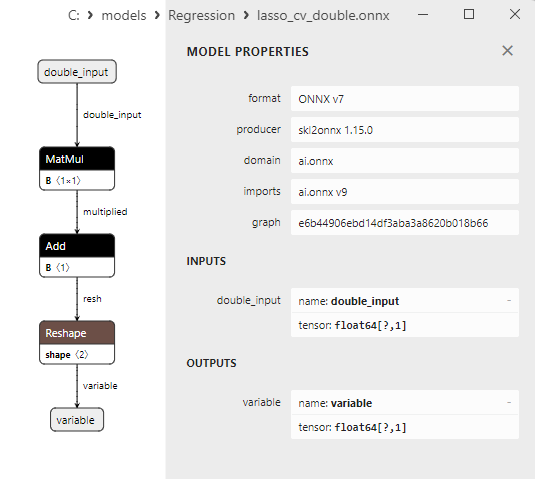

2.1.9.3. Représentation ONNX de lasso_cv_float.onnx et lasso_cv_double.onnx - 2.1.10. sklearn.linear_model.LassoLars

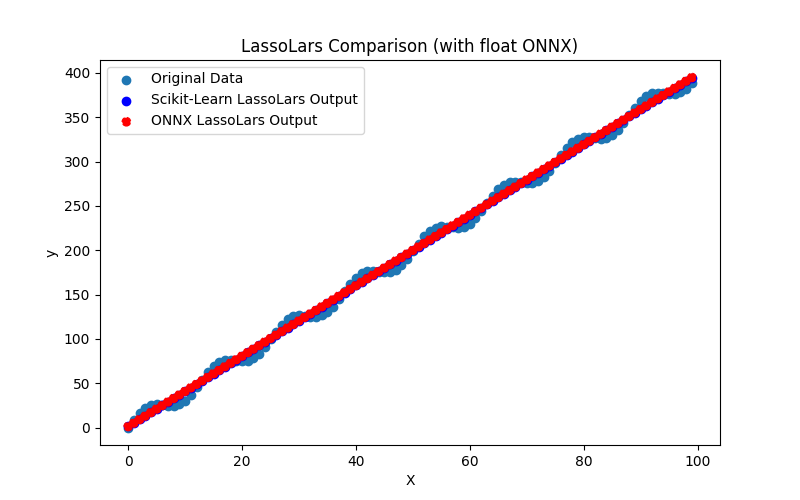

2.1.10.1. Code pour créer le modèle LassoLars et l'exporter vers ONNX pour float et double

2.1.10.2. Code MQL5 pour l'exécution des modèles ONNX

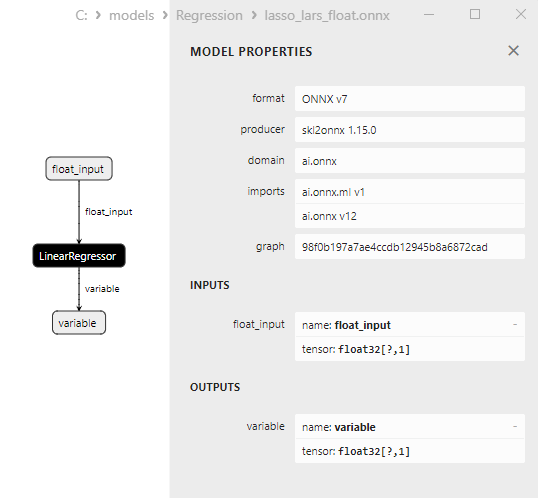

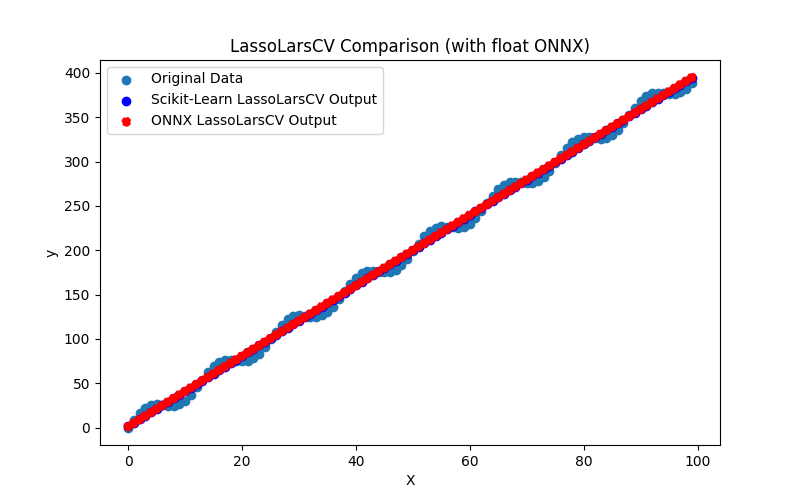

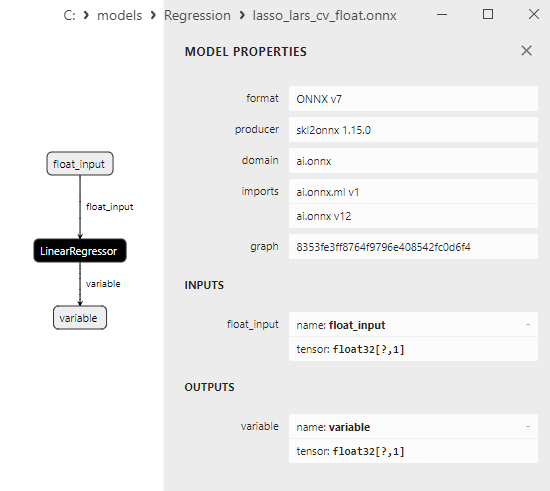

2.1.10.3. Représentation ONNX de lasso_lars_float.onnx et lasso_lars_double.onnx - 2.1.11. sklearn.linear_model.LassoLarsCV

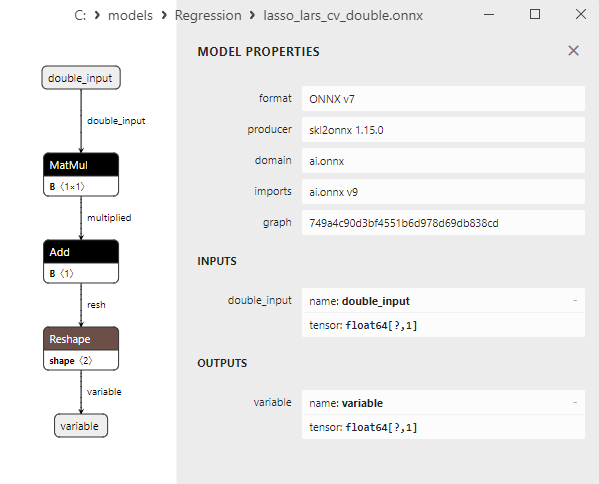

2.1.11.1. Code pour créer le modèle LassoLarsCV et l'exporter vers ONNX pour float et double

2.1.11.2. Code MQL5 pour l'exécution des modèles ONNX

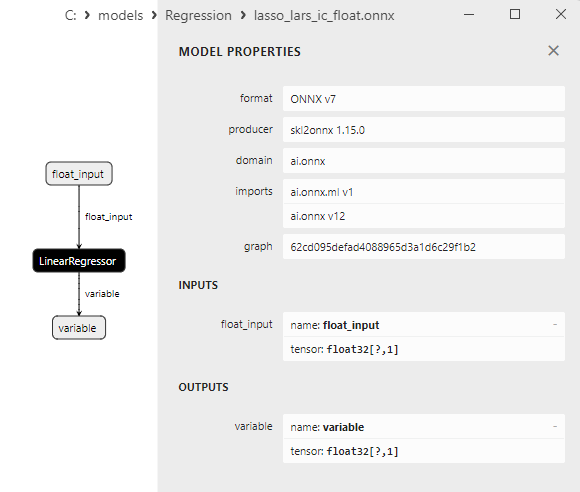

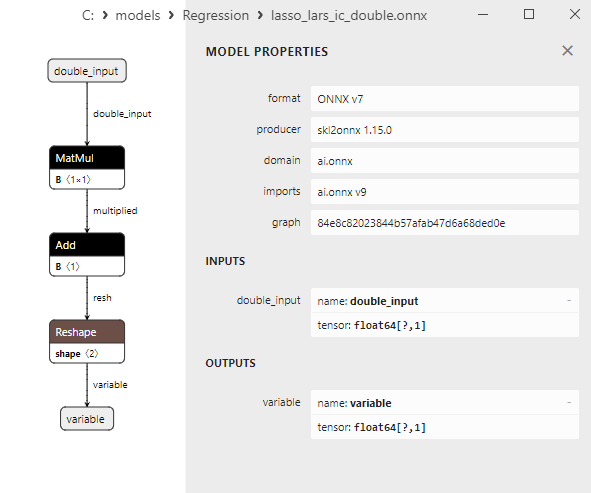

2.1.11.3. Représentation ONNX de lasso_lars_cv_float.onnx et lasso_lars_cv_double.onnx - 2.1.12. sklearn.linear_model.LassoLarsIC

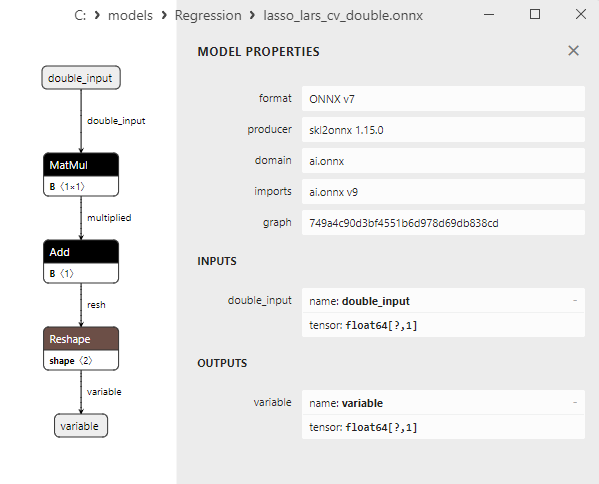

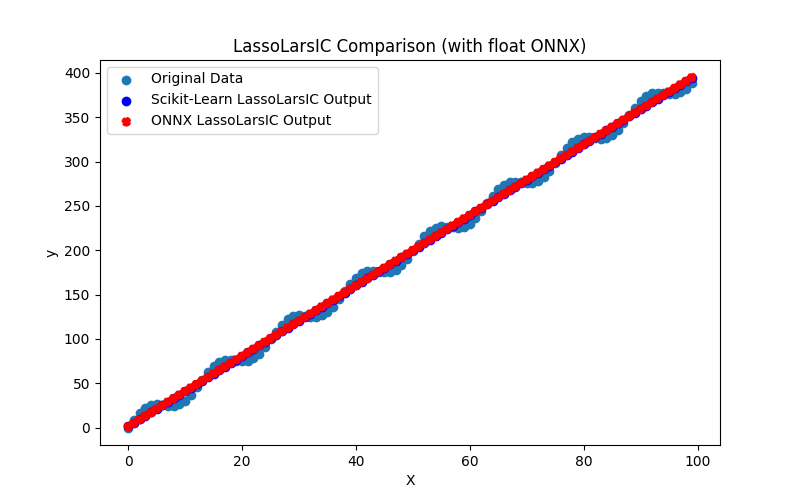

2.1.12.1. Code pour créer le modèle LassoLarsIC et l'exporter vers ONNX pour float et double

2.1.12.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.12.3. Représentation ONNX de lasso_lars_ic_float.onnx et lasso_lars_ic_double.onnx - 2.1.13. sklearn.linear_model.LinearRegression

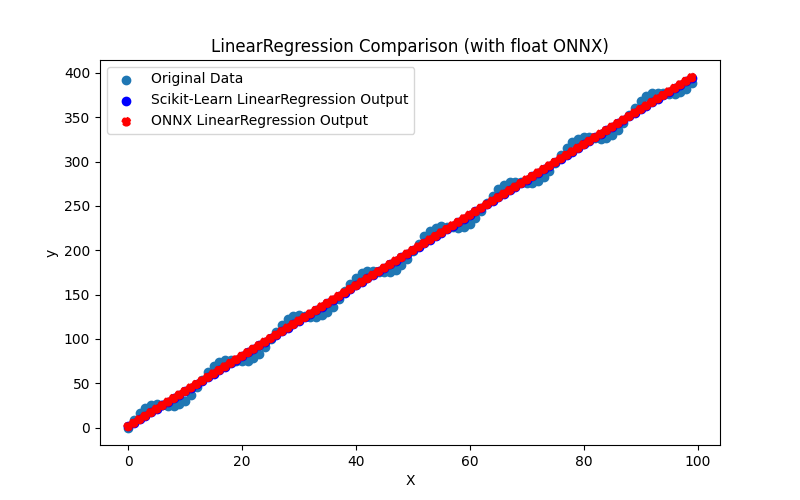

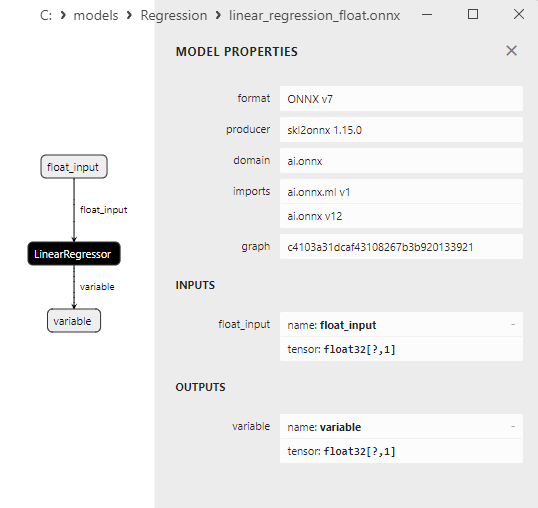

2.1.13.1. Code pour créer le modèle LinearRegression et l'exporter vers ONNX pour float et double

2.1.13.2. Code MQL5 pour l'exécution des modèles ONNX

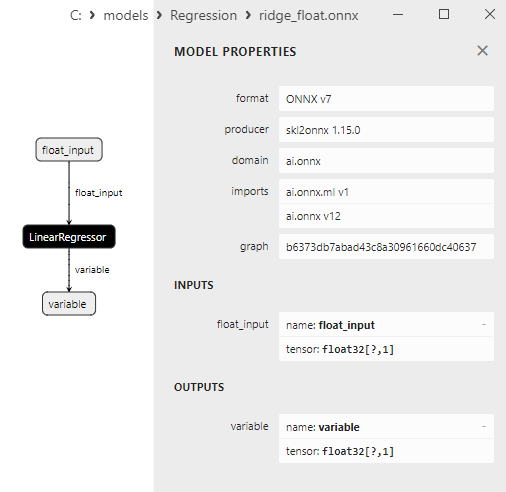

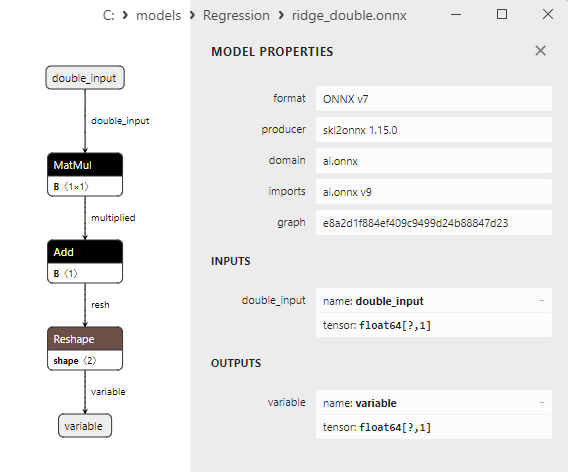

2.1.13.3. Représentation ONNX de linear_regression_float.onnx et linear_regression_double.onnx - 2.1.14. sklearn.linear_model.Ridge

2.1.14.1. Code pour créer le modèle Ridge et l'exporter vers ONNX pour float et double

2.1.14.2. Code MQL5 pour l'exécution des modèles ONNX

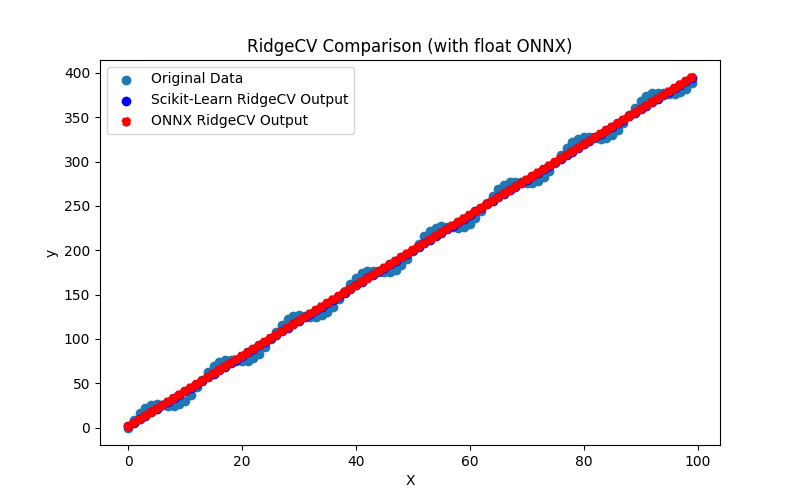

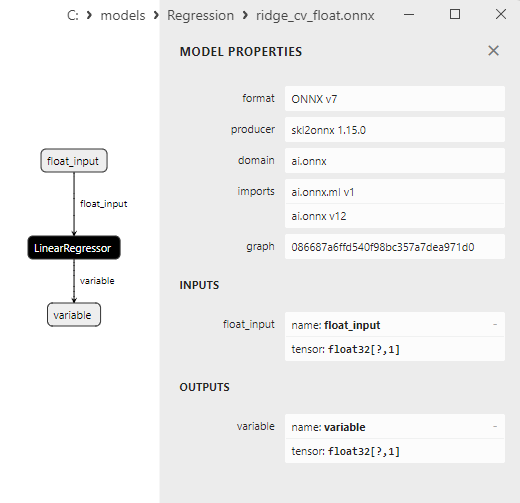

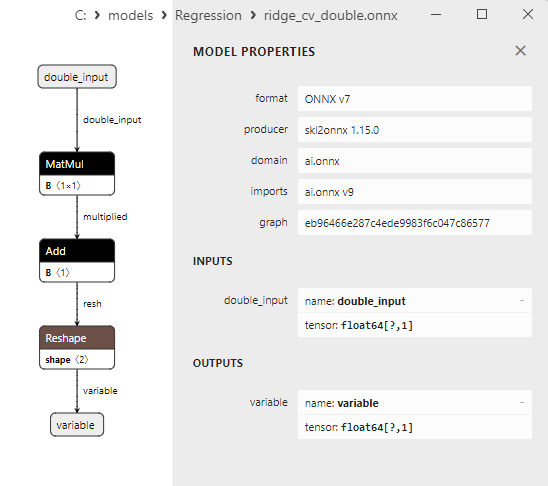

2.1.14.3. Représentation ONNX de ridge_float.onnx et ridge_double.onnx - 2.1.15. sklearn.linear_model.RidgeCV

2.1.15.1. Code pour créer le modèle RidgeCV et l'exporter vers ONNX pour float et double

2.1.15.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.15.3. Représentation ONNX de ridge_cv_float.onnx et ridge_cv_double.onnx - 2.1.16. sklearn.linear_model.OrthogonalMatchingPursuit

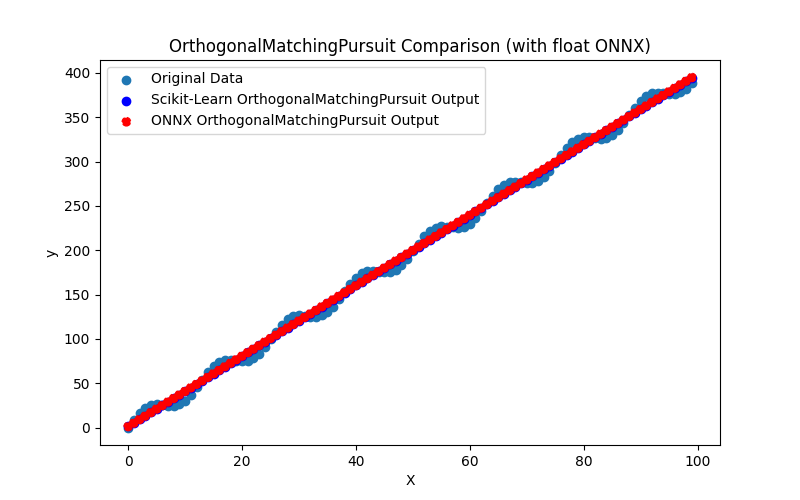

2.1.16.1. Code pour créer le modèle OrthogonalMatchingPursuit et l'exporter vers ONNX pour float et double

2.1.16.2. Code MQL5 pour l'exécution des modèles ONNX

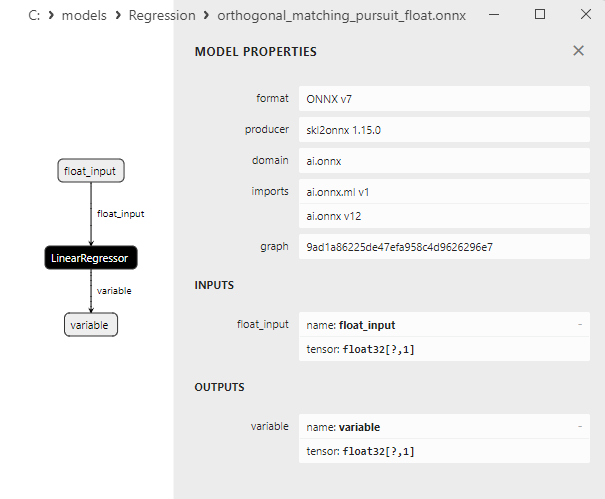

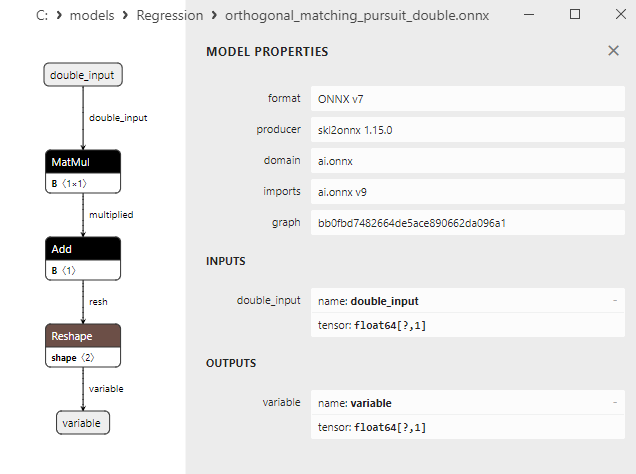

2.1.16.3. Représentation ONNX de l'orthogonal_matching_pursuit_float.onnx et de l'orthogonal_matching_pursuit_double.onnx - 2.1.17. sklearn.linear_model.PassiveAggressiveRegressor

2.1.17.1. Code pour créer le modèle PassiveAggressiveRegressor et l'exporter vers ONNX pour float et double

2.1.17.2. Code MQL5 pour l'exécution des modèles ONNX

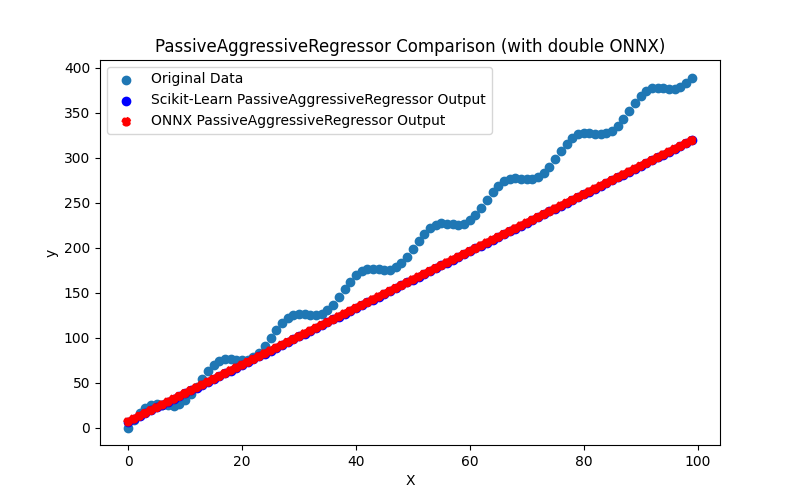

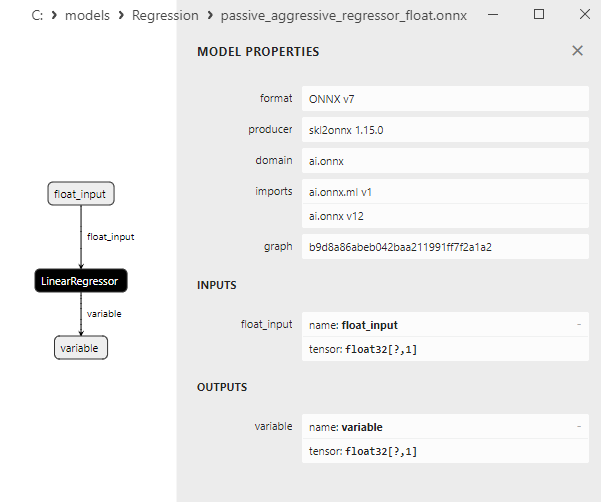

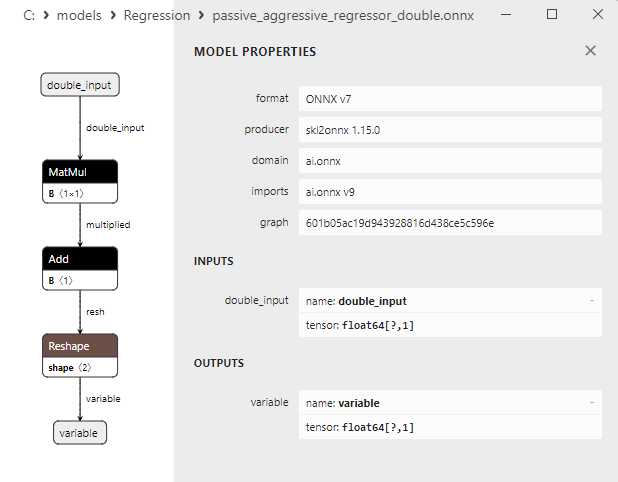

2.1.17.3. Représentation ONNX de passive_aggressive_regressor_float.onnx et passive_aggressive_regressor_double.onnx - 2.1.18. sklearn.linear_model.QuantileRegressor

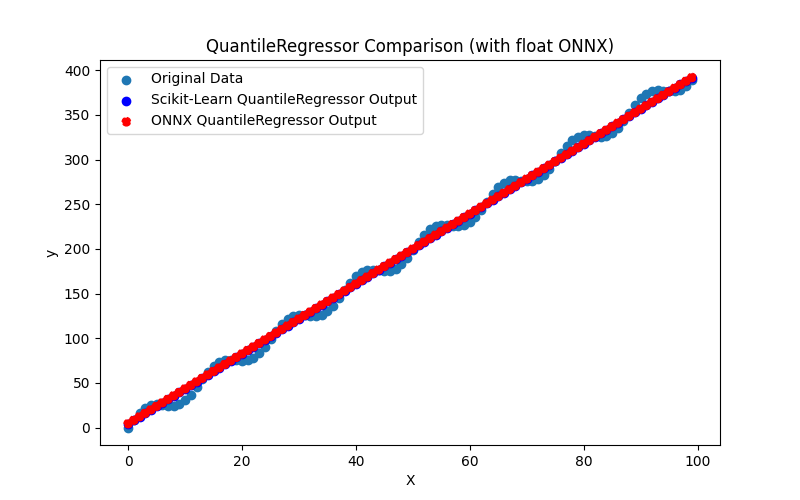

2.1.18.1. Code pour créer le modèle QuantileRegressor et l'exporter vers ONNX pour float et double

2.1.18.2. Code MQL5 pour l'exécution des modèles ONNX

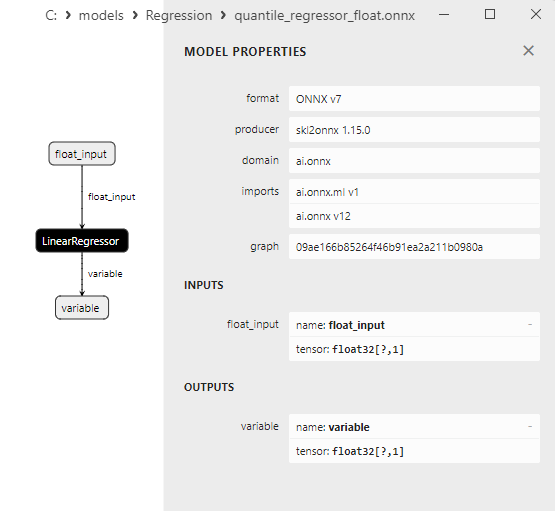

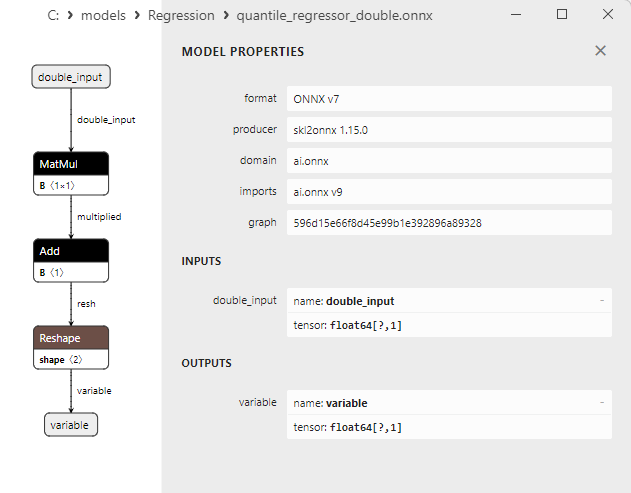

2.1.18.3. Représentation ONNX du quantile_regressor_float.onnx et du quantile_regressor_double.onnx - 2.1.19. sklearn.linear_model.RANSACRegressor

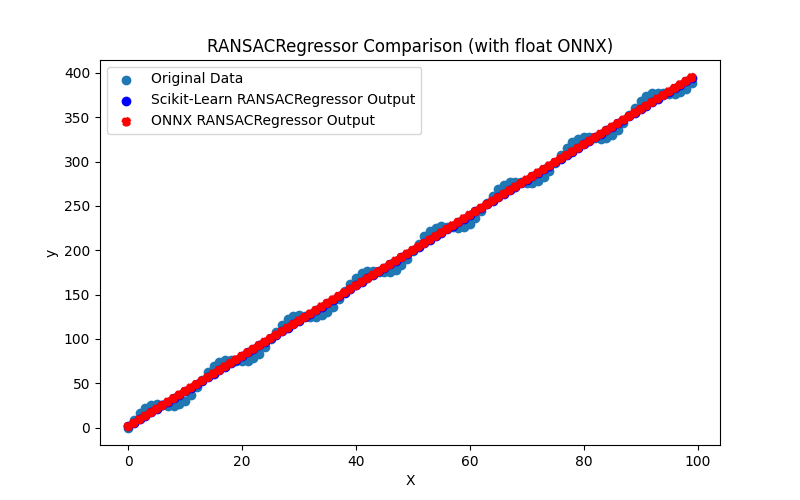

2.1.19.1. Code pour créer le modèle RANSACRegressor et l'exporter vers ONNX pour float et double

2.1.19.2. Code MQL5 pour l'exécution des modèles ONNX

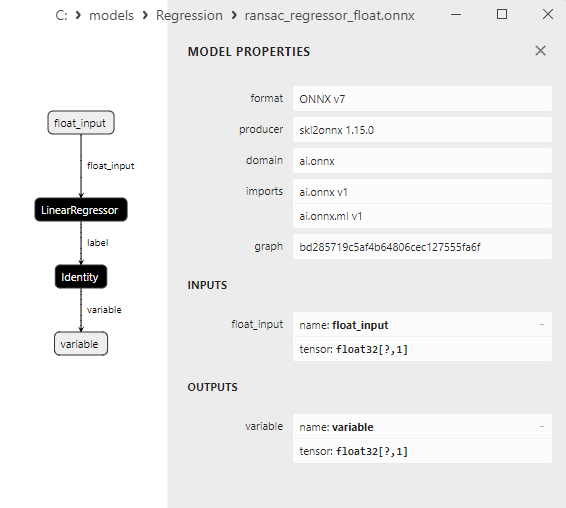

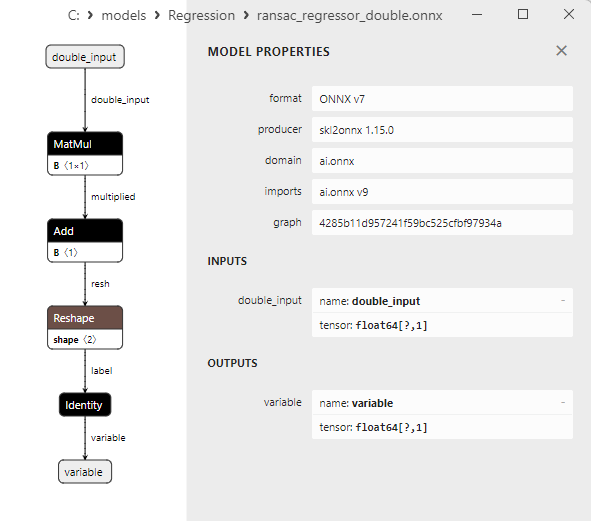

2.1.19.3. Représentation ONNX du ransac_regressor_float.onnx et du ransac_regressor_double.onnx - 2.1.20. sklearn.linear_model.TheilSenRegressor

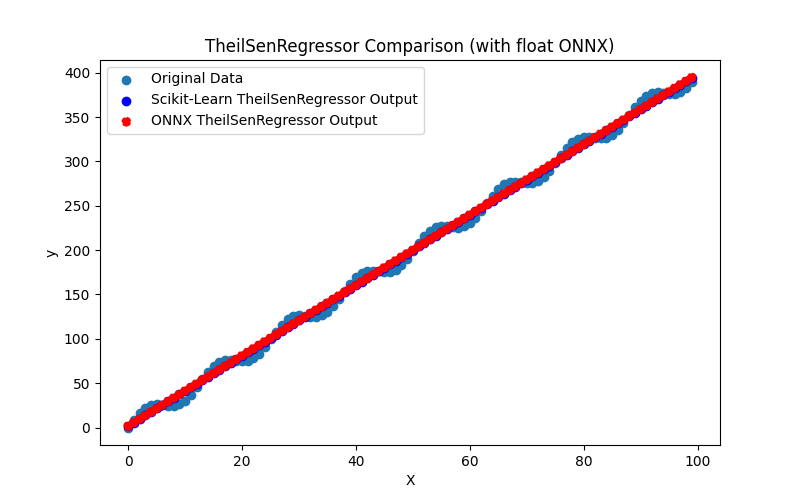

2.1.20.1. Code pour créer le modèle TheilSenRegressor et l'exporter vers ONNX pour float et double

2.1.20.2. Code MQL5 pour l'exécution des modèles ONNX

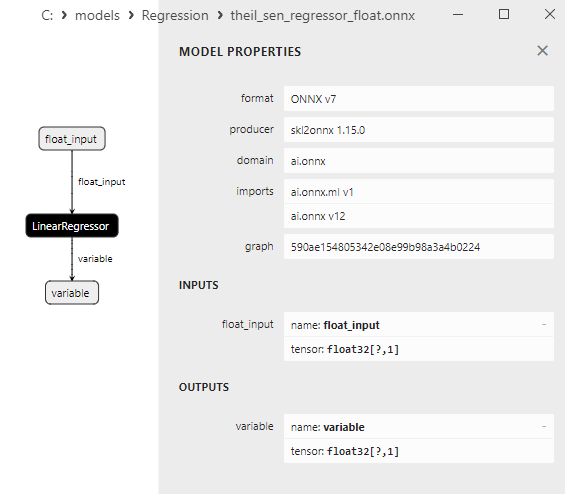

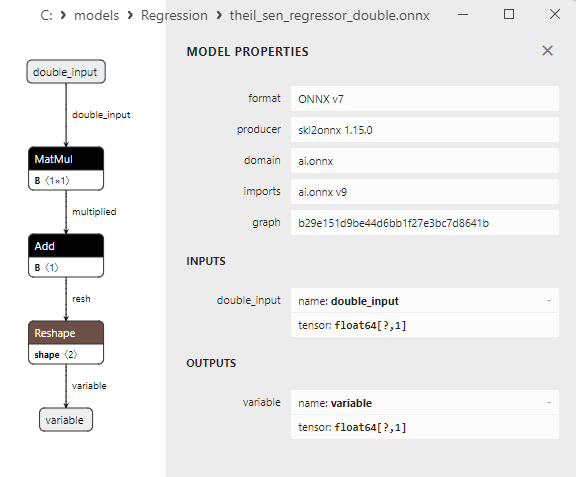

2.1.20.3. Représentation ONNX de theil_sen_regressor_float.onnx et theil_sen_regressor_double.onnx - 2.1.21. sklearn.linear_model.LinearSVR

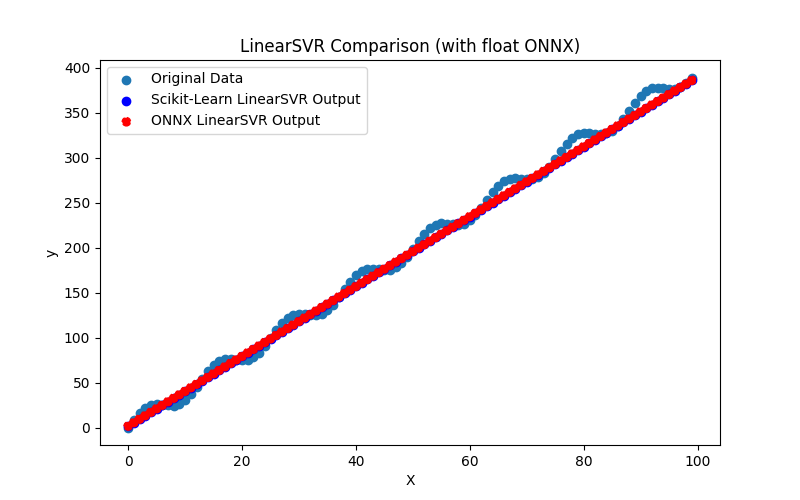

2.1.21.1. Code pour créer le modèle LinearSVR et l'exporter vers ONNX pour float et double

2.1.21.2. Code MQL5 pour l'exécution des modèles ONNX

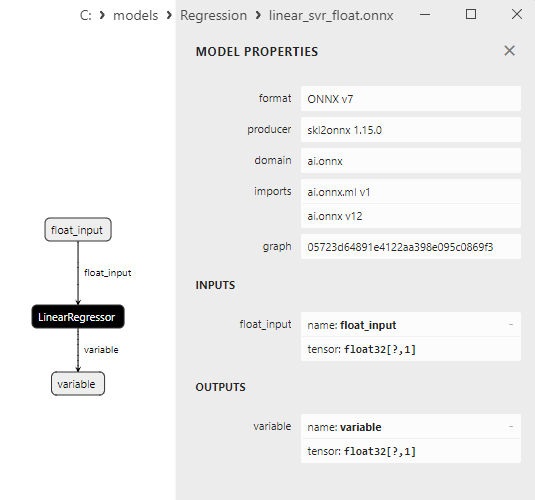

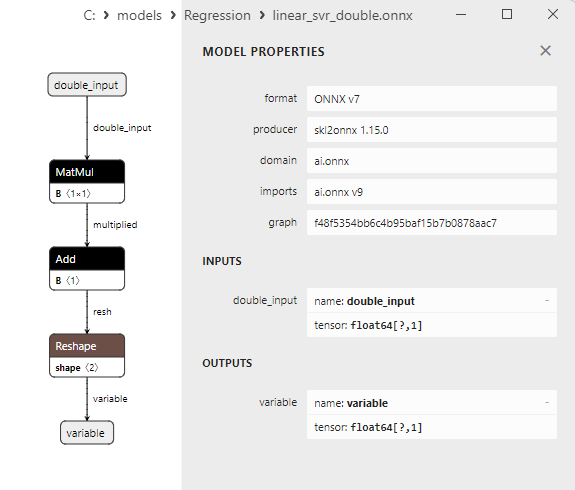

2.1.21.3. Représentation ONNX de linear_svr_float.onnx et linear_svr_double.onnx - 2.1.22. sklearn.linear_model.MLPRegressor

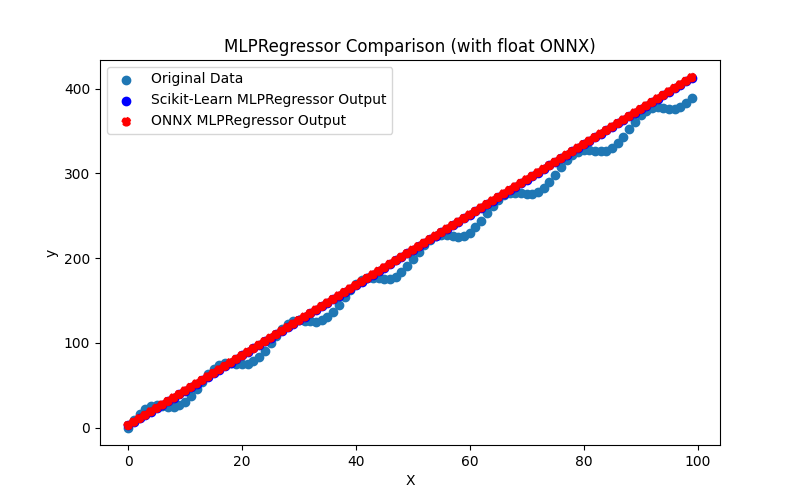

2.1.22.1. Code pour créer le modèle MLPRegressor et l'exporter vers ONNX pour float et double

2.1.22.2. Code MQL5 pour l'exécution des modèles ONNX

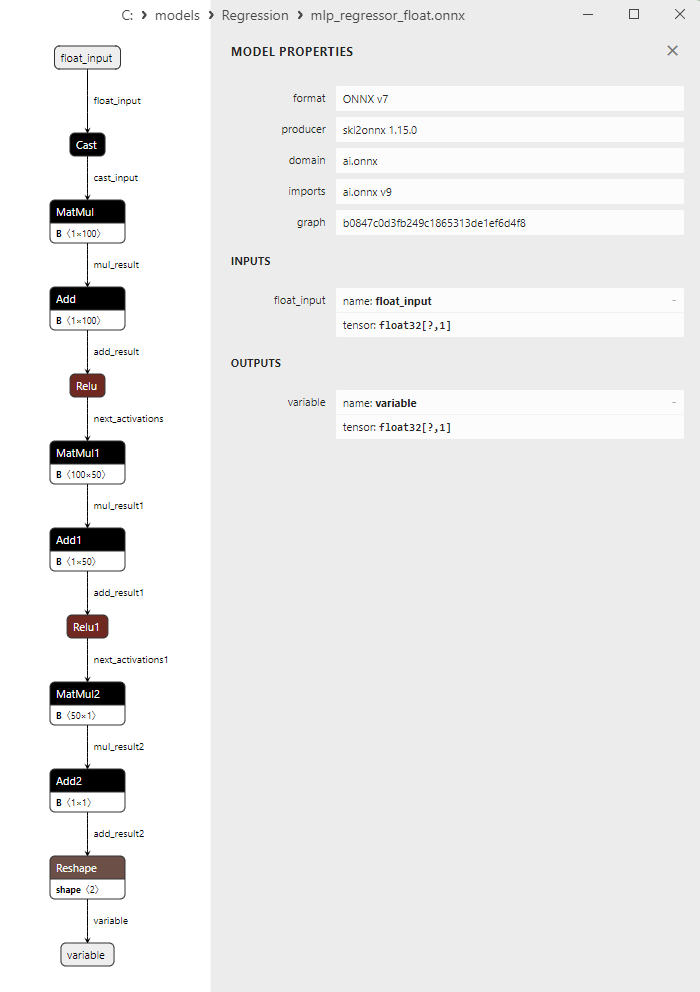

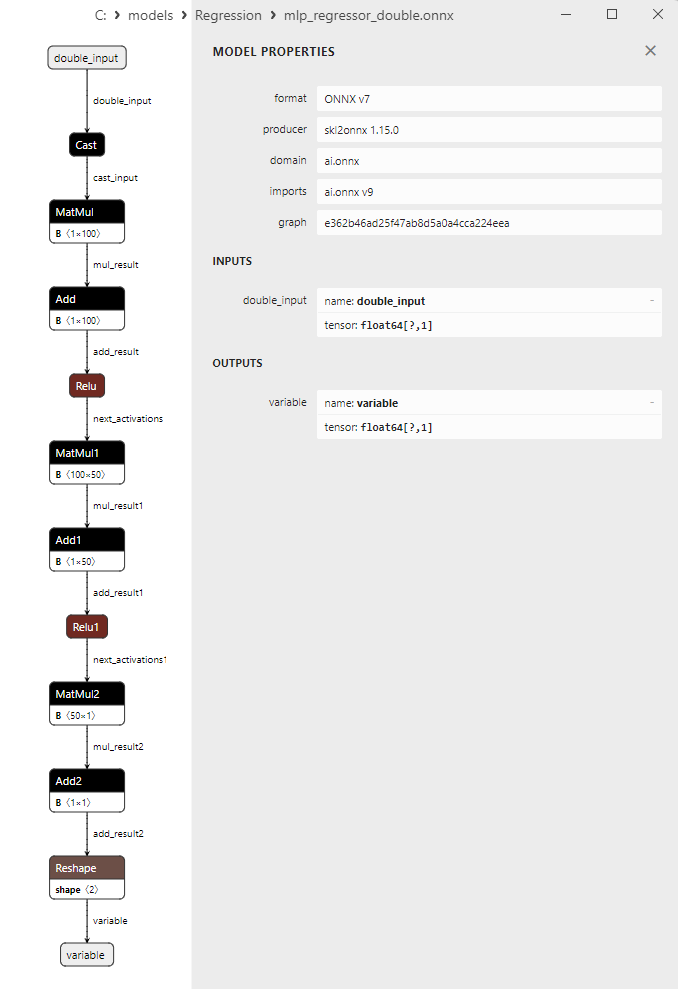

2.1.22.3. Représentation ONNX de mlp_regressor_float.onnx et mlp_regressor_double.onnx - 2.1.23. sklearn.cross_decomposition.PLSRegression

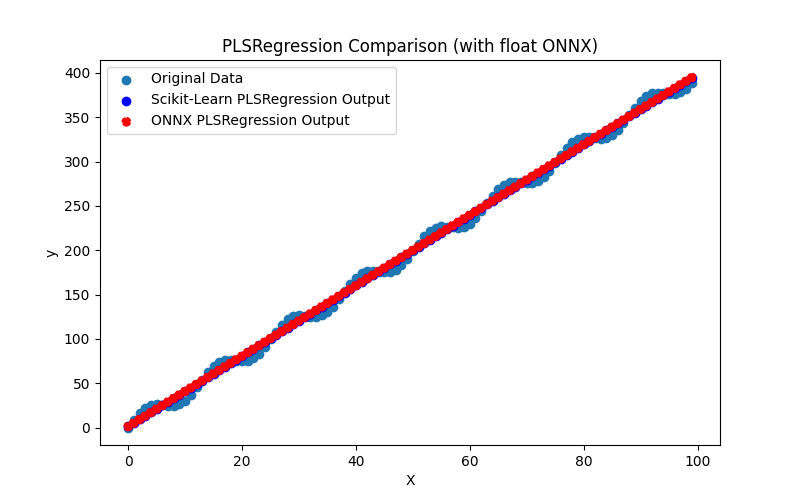

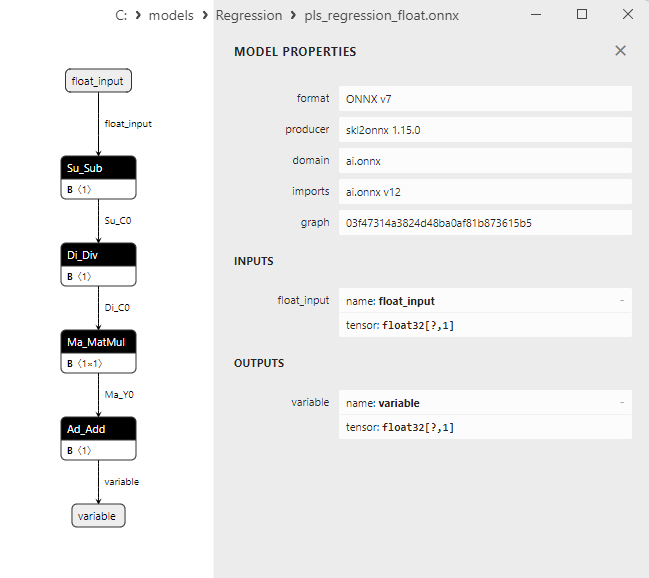

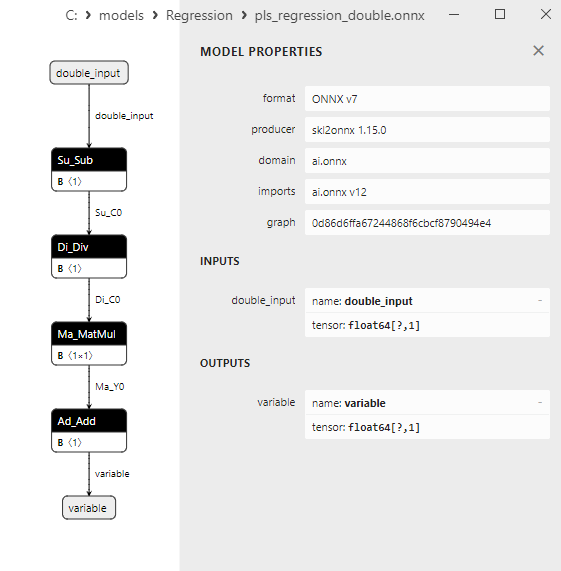

2.1.23.1. Code pour créer le modèle PLSRegression et l'exporter vers ONNX pour float et double

2.1.23.2. Code MQL5 pour l'exécution des modèles ONNX

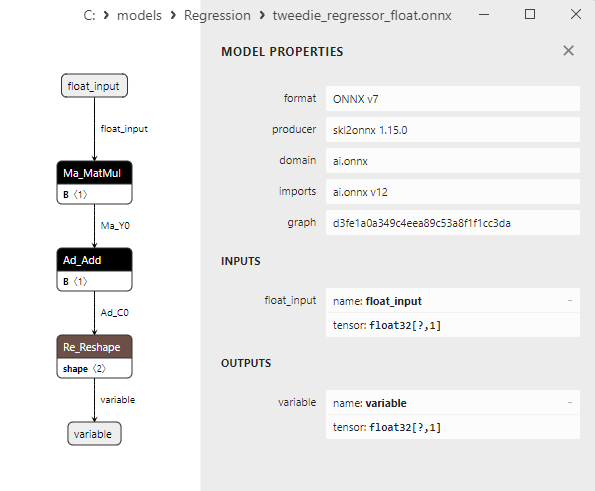

2.1.23.3. Représentation ONNX de pls_regression_float.onnx et pls_regression_double.onnx - 2.1.24. sklearn.linear_model.TweedieRegressor

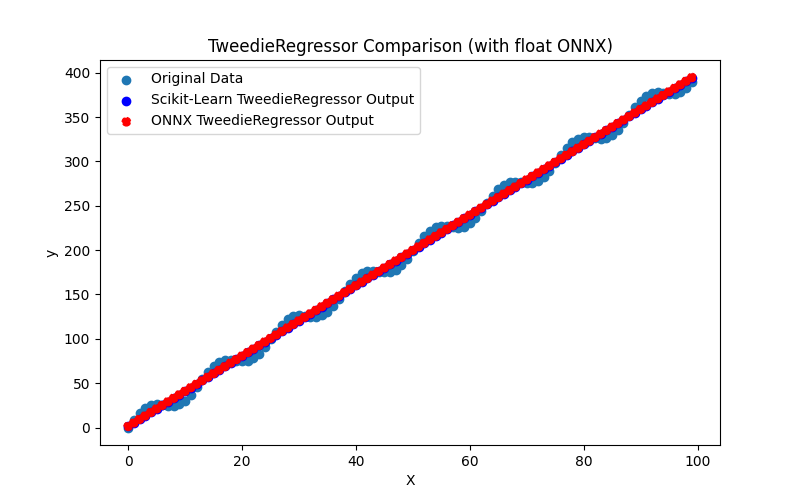

2.1.24.1. Code pour créer le modèle TweedieRegressor et l'exporter vers ONNX pour float et double

2.1.24.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.24.3. Représentation ONNX de tweedie_regressor_float.onnx et tweedie_regressor_double.onnx - 2.1.25. sklearn.linear_model.PoissonRegressor

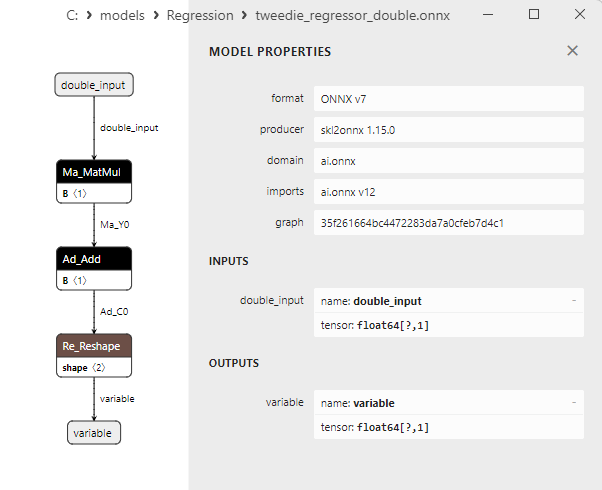

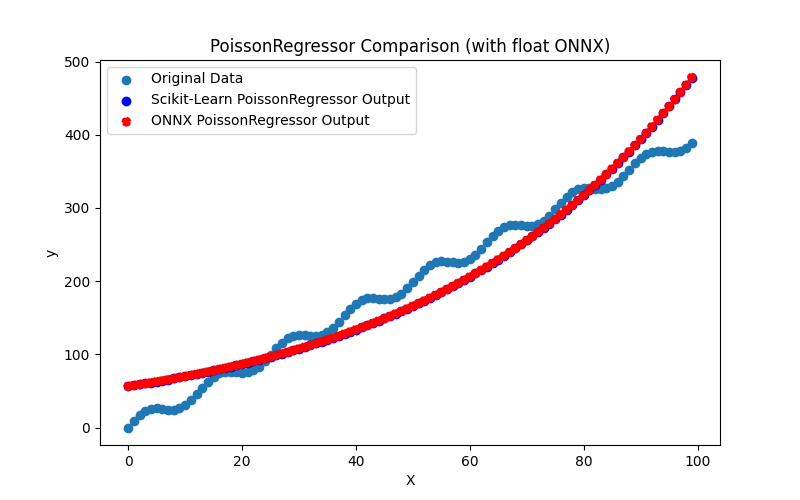

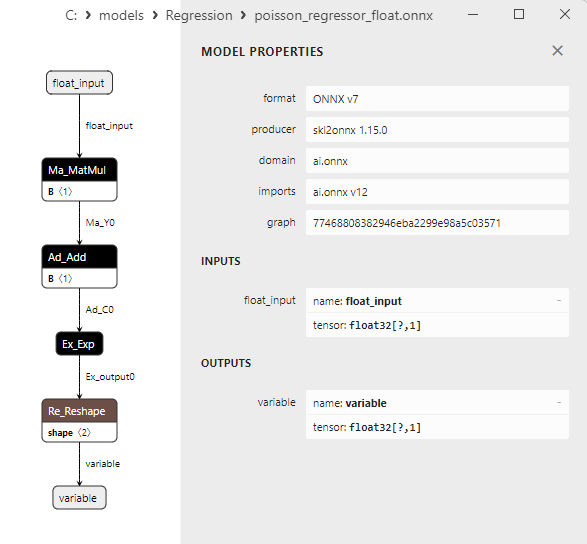

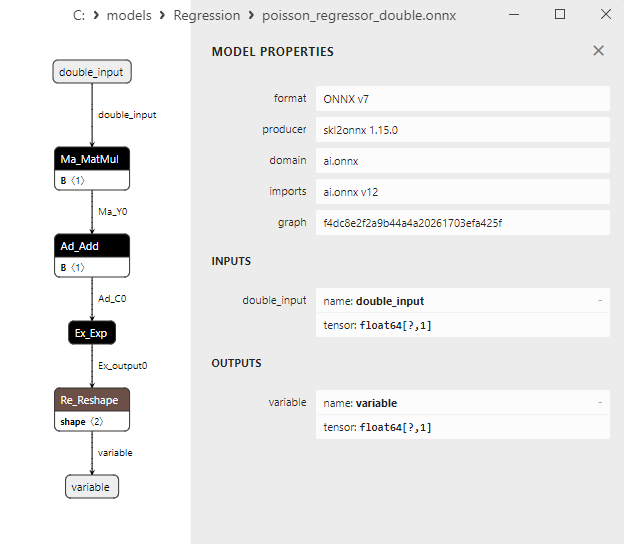

2.1.25.1. Code pour créer le modèle PoissonRegressor et l'exporter vers ONNX pour float et double

2.1.25.2. Code MQL5 pour l'exécution des modèles ONNX

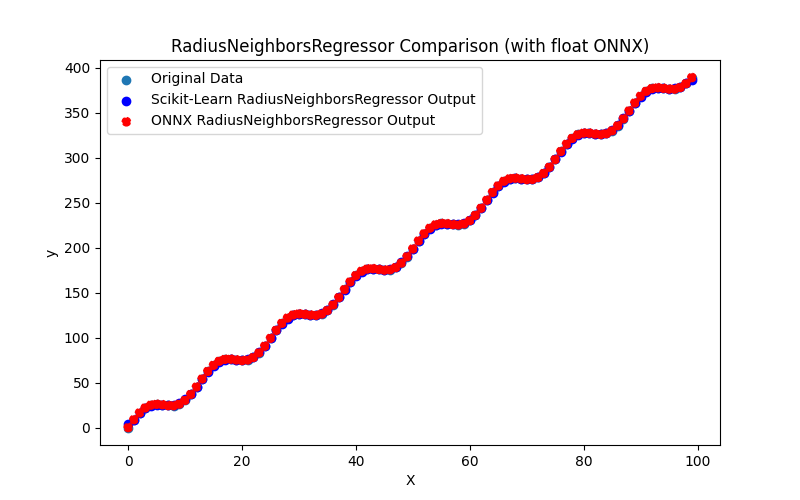

2.1.25.3. Représentation ONNX du poisson_regressor_float.onnx et du poisson_regressor_double.onnx - 2.1.26. sklearn.neighbors.RadiusNeighborsRegressor

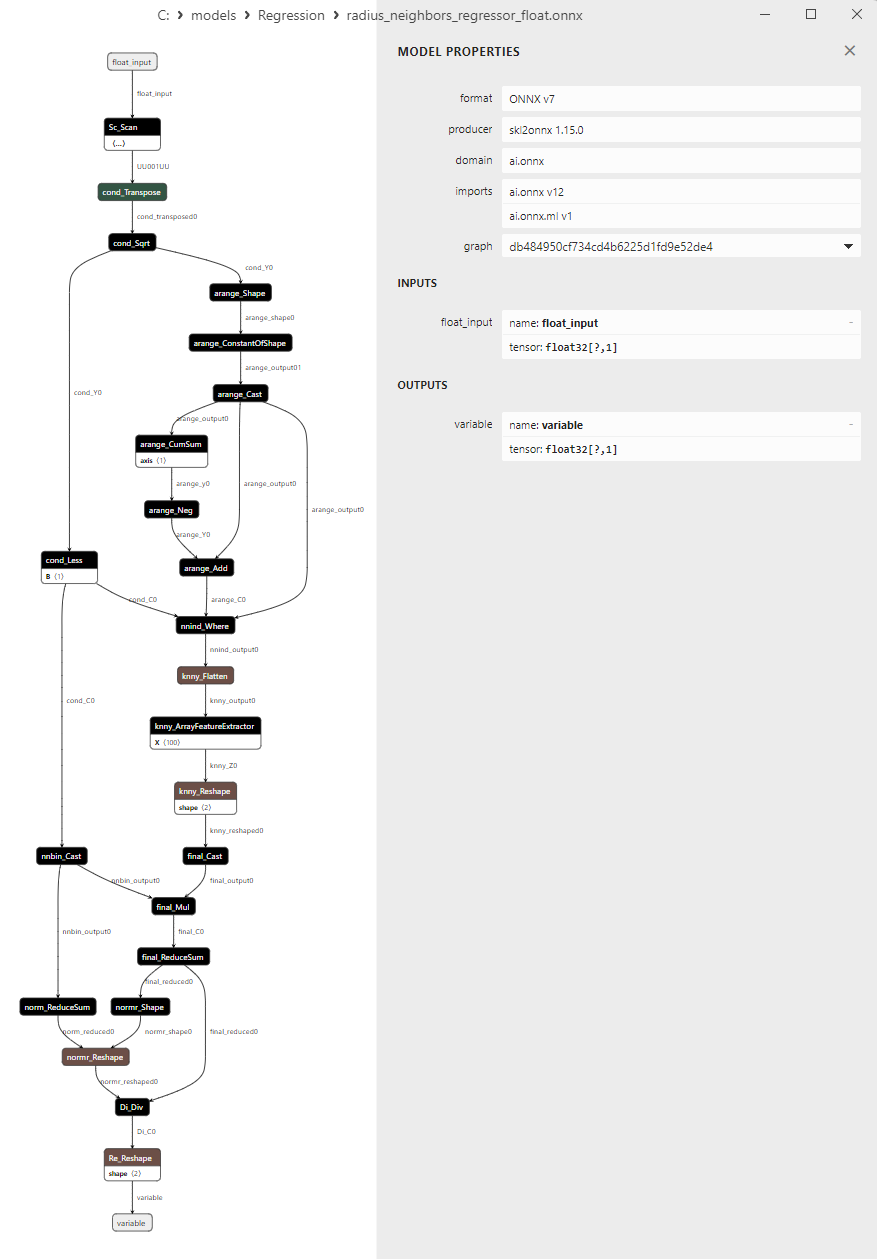

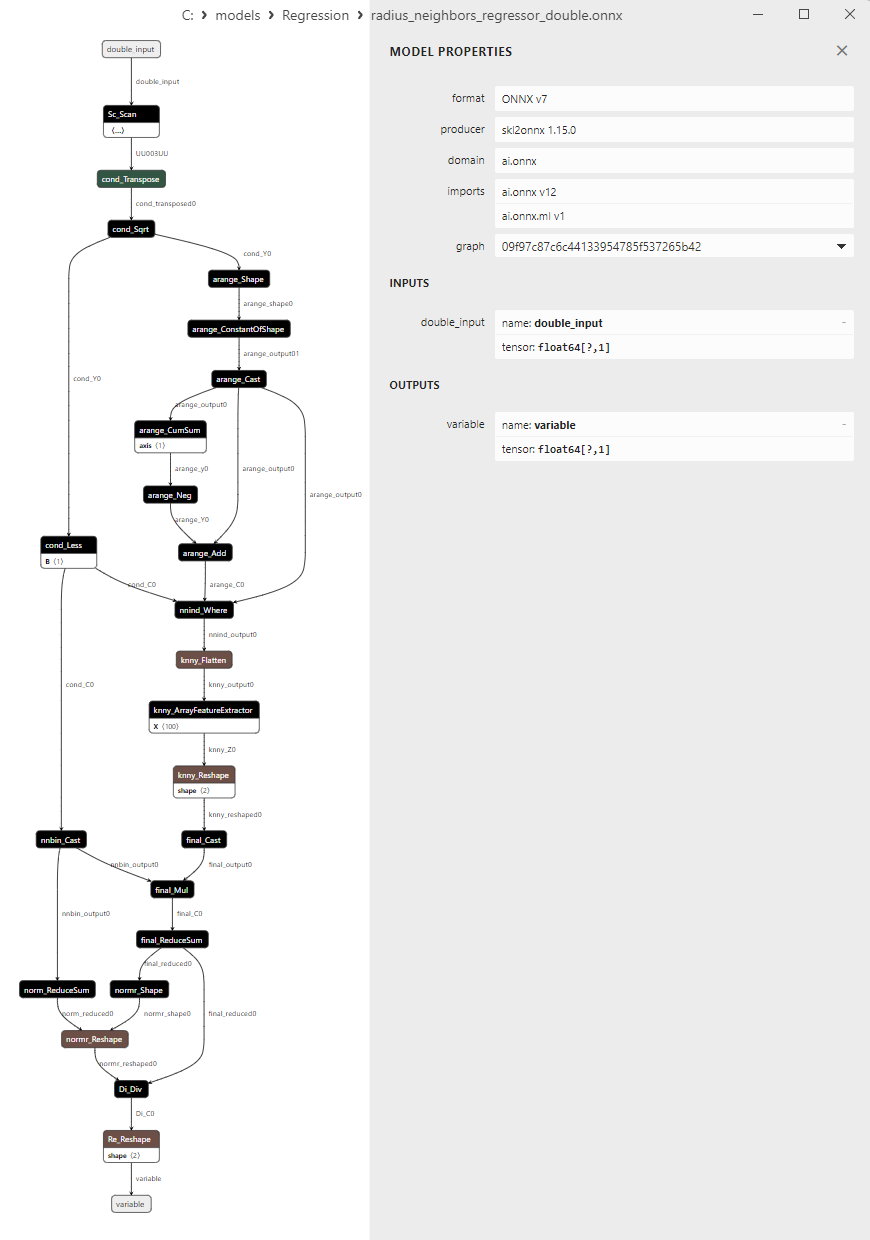

2.1.26.1. Code pour créer le modèle RadiusNeighborsRegressor et l'exporter vers ONNX pour float et double

2.1.26.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.26.3. Représentation ONNX du radius_neighbors_regressor_float.onnx et du radius_neighbors_regressor_double.onnx - 2.1.27. sklearn.neighbors.KNeighborsRegressor

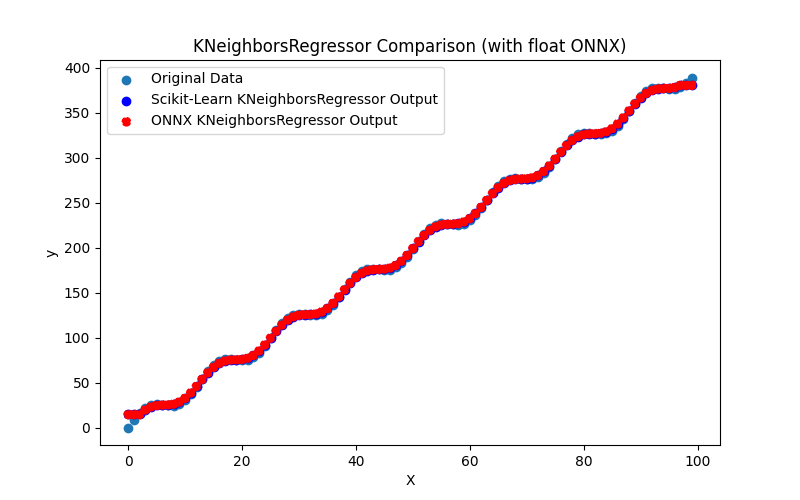

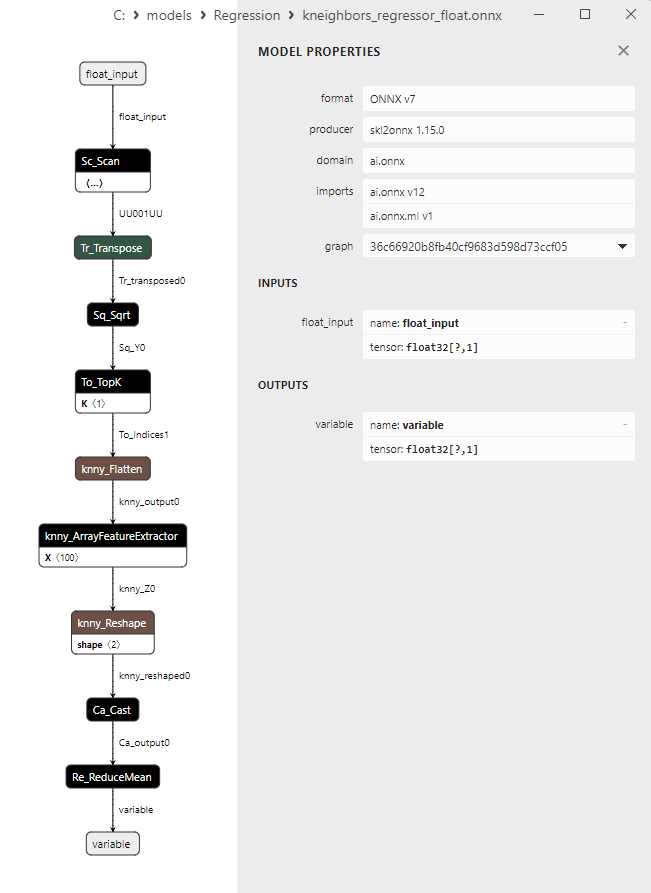

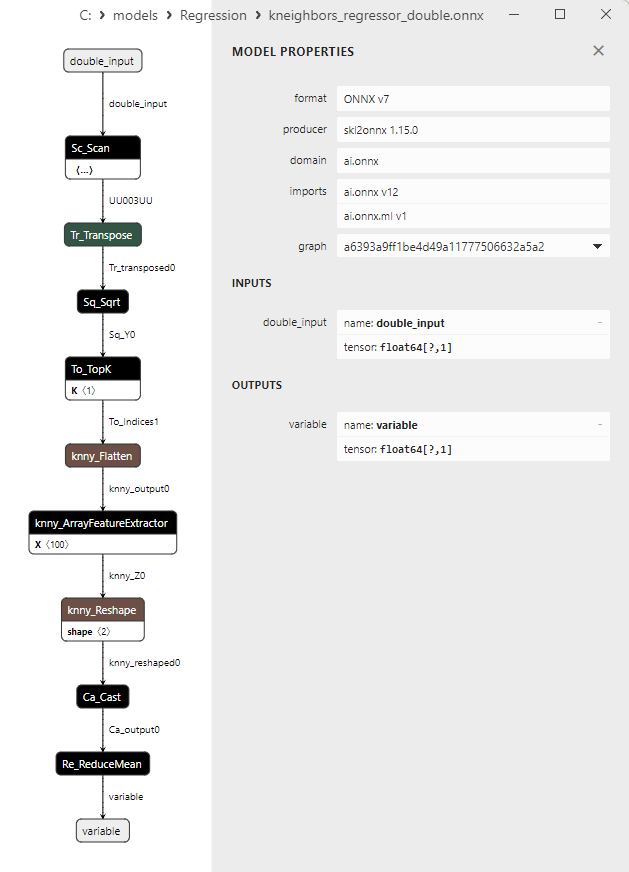

2.1.27.1. Code pour créer le modèle KNeighborsRegressor et l'exporter vers ONNX pour float et double

2.1.27.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.27.3. Représentation ONNX de kneighbors_regressor_float.onnx et kneighbors_regressor_double.onnx

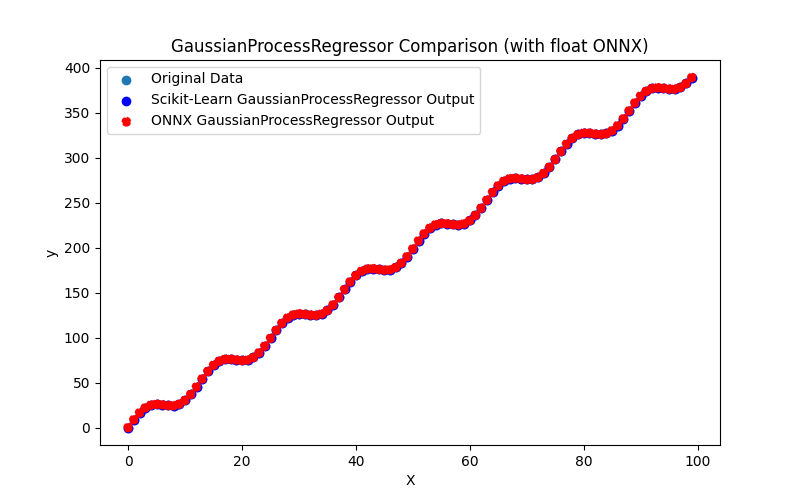

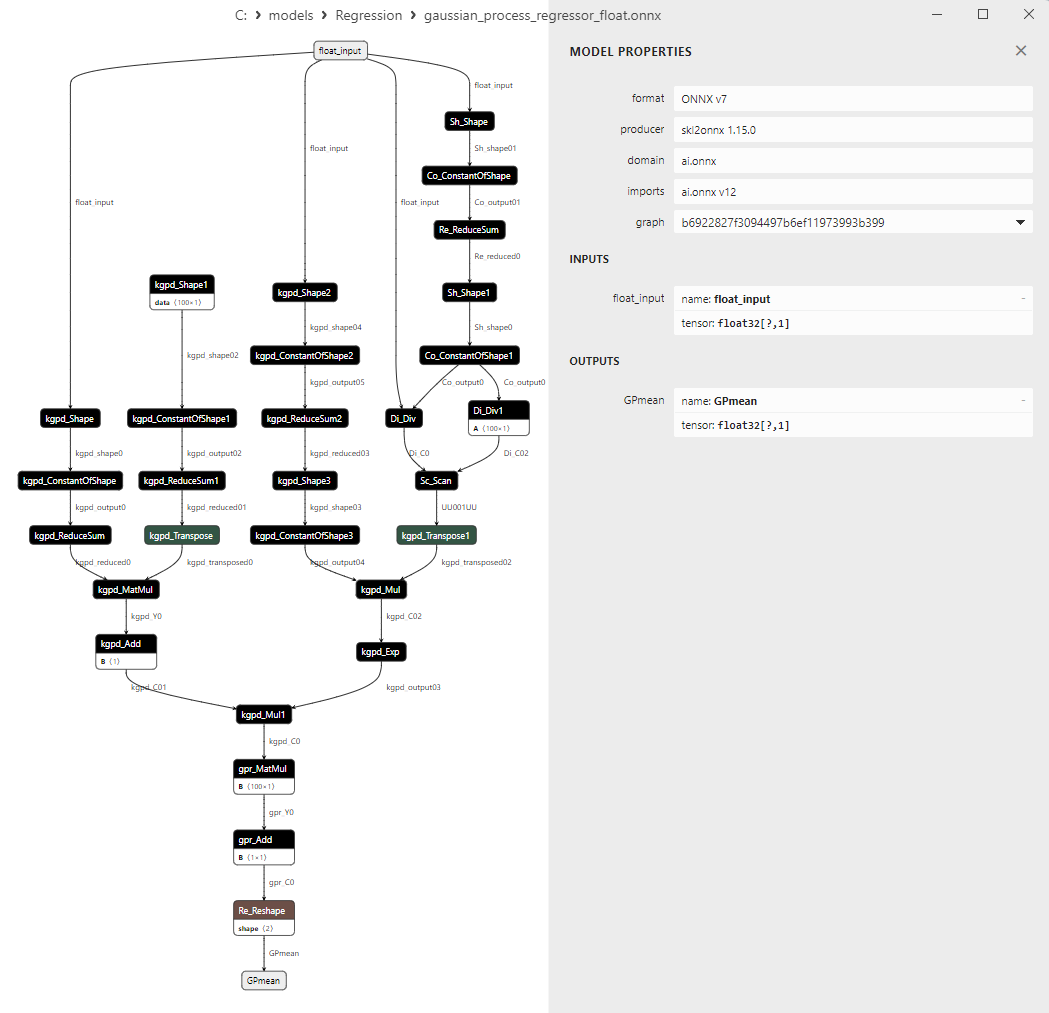

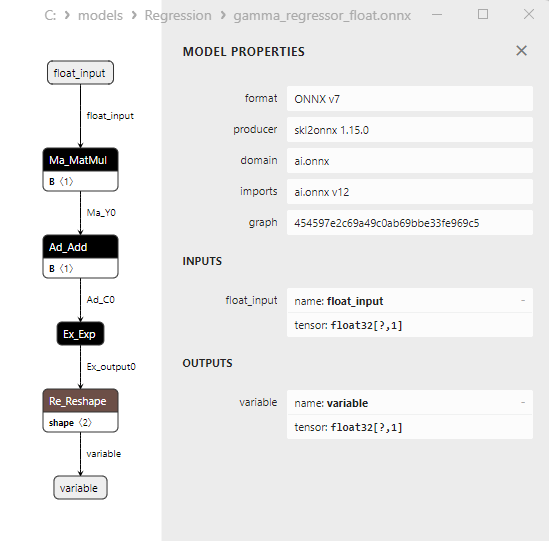

- 2.1.28. sklearn.gaussian_process.GaussianProcessRegressor

2.1.28.1. Code pour créer le modèle GaussianProcessRegressor et l'exporter vers ONNX pour float et double

2.1.28.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.28.3. Représentation ONNX du gaussian_process_regressor_float.onnx et du gaussian_process_regressor_double.onnx

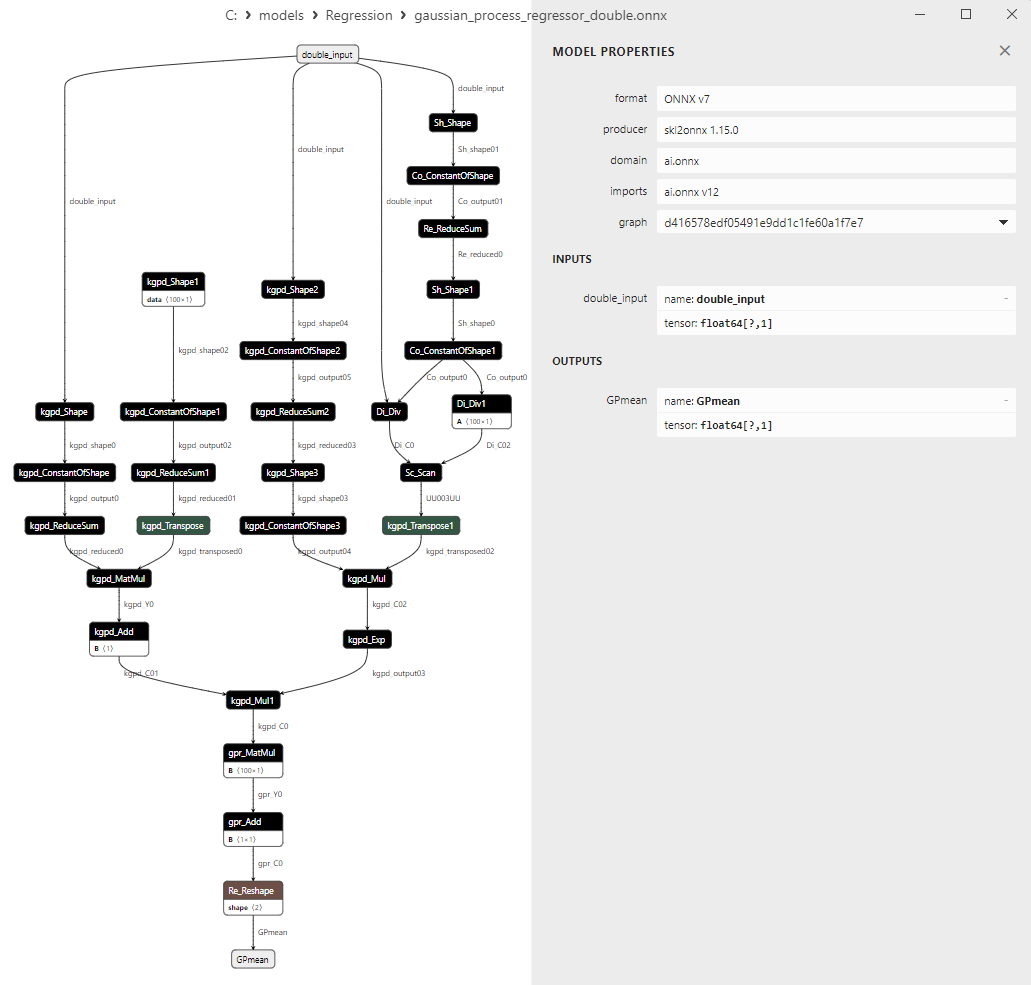

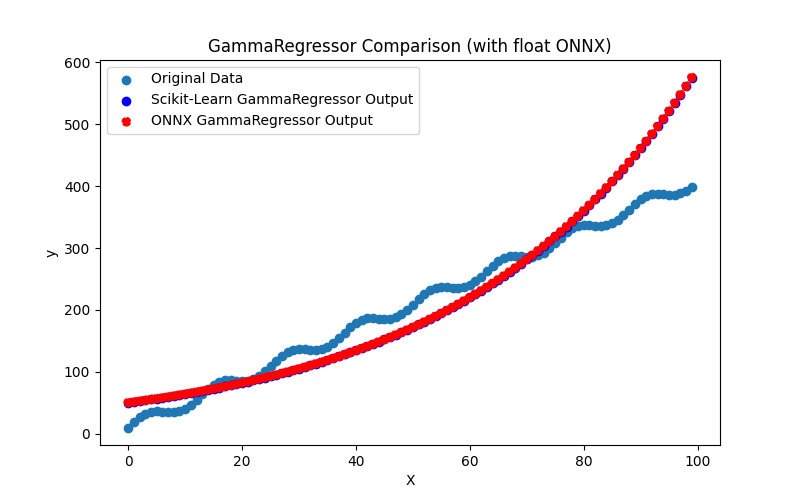

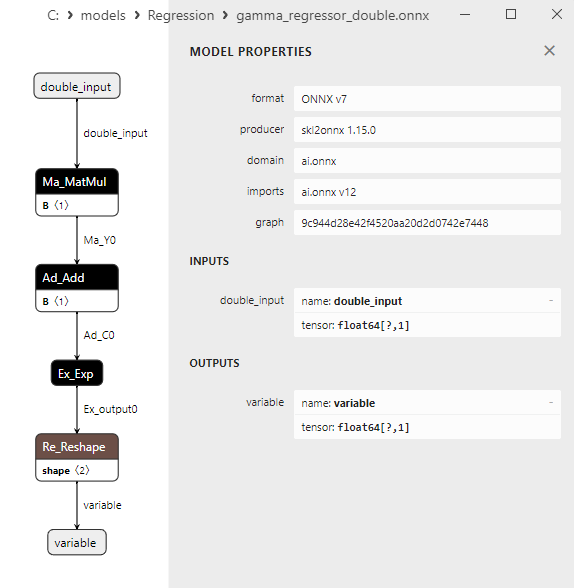

- 2.1.29. sklearn.linear_model.GammaRegressor

2.1.29.1. Code pour créer le modèle GammaRegressor et l'exporter vers ONNX pour float et double

2.1.29.2. Code MQL5 pour l'exécution des modèles ONNX

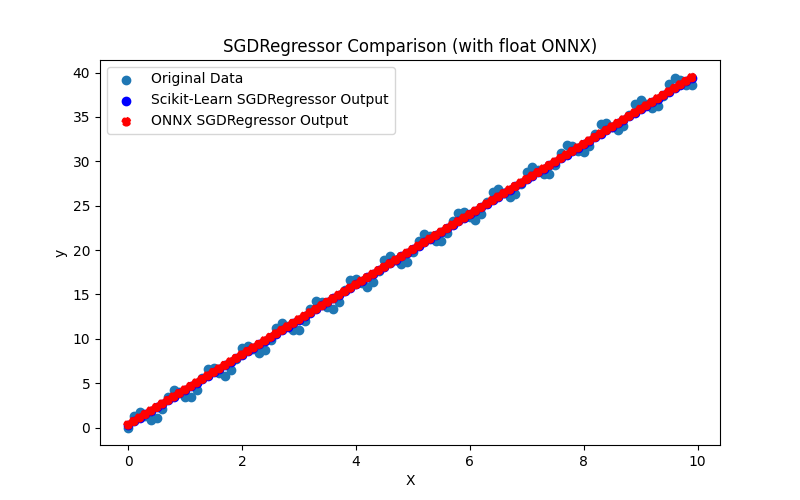

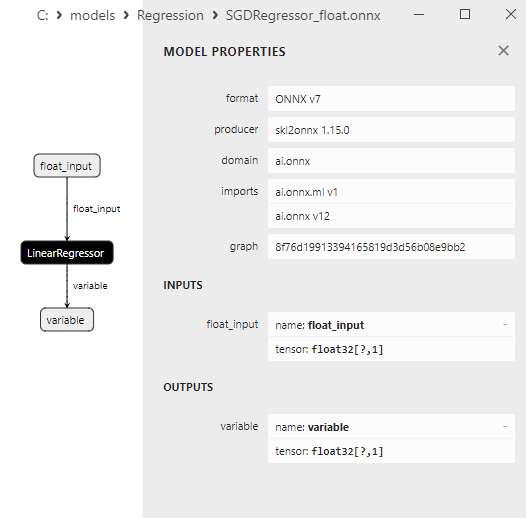

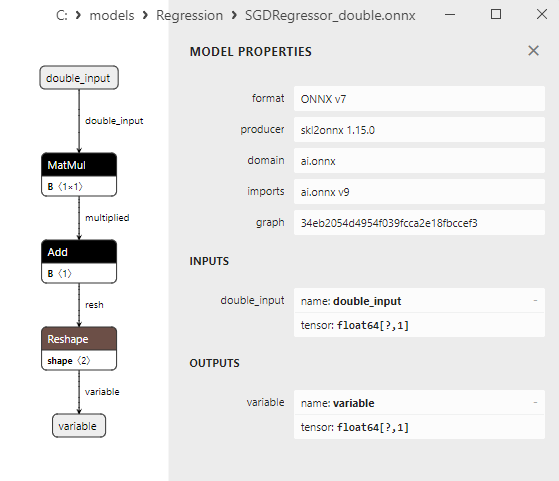

2.1.29.3. Représentation ONNX du gamma_regressor_float.onnx et du gamma_regressor_double.onnx - 2.1.30. sklearn.linear_model.SGDRegressor

2.1.30.1. Code pour créer le modèle SGDRegressor et l'exporter vers ONNX pour float et double

2.1.30.2. Code MQL5 pour l'exécution des modèles ONNX

2.1.30.3. Représentation ONNX de sgd_regressor_float.onnx et sgd_rgressor_double.onnx

- 2.2. Modèles de régression de la bibliothèque Scikit-learn qui sont convertis uniquement en modèles ONNX de précision flottante

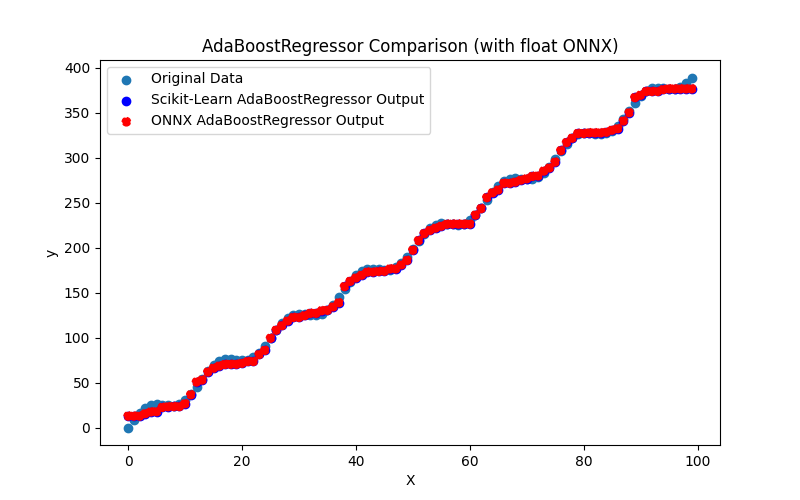

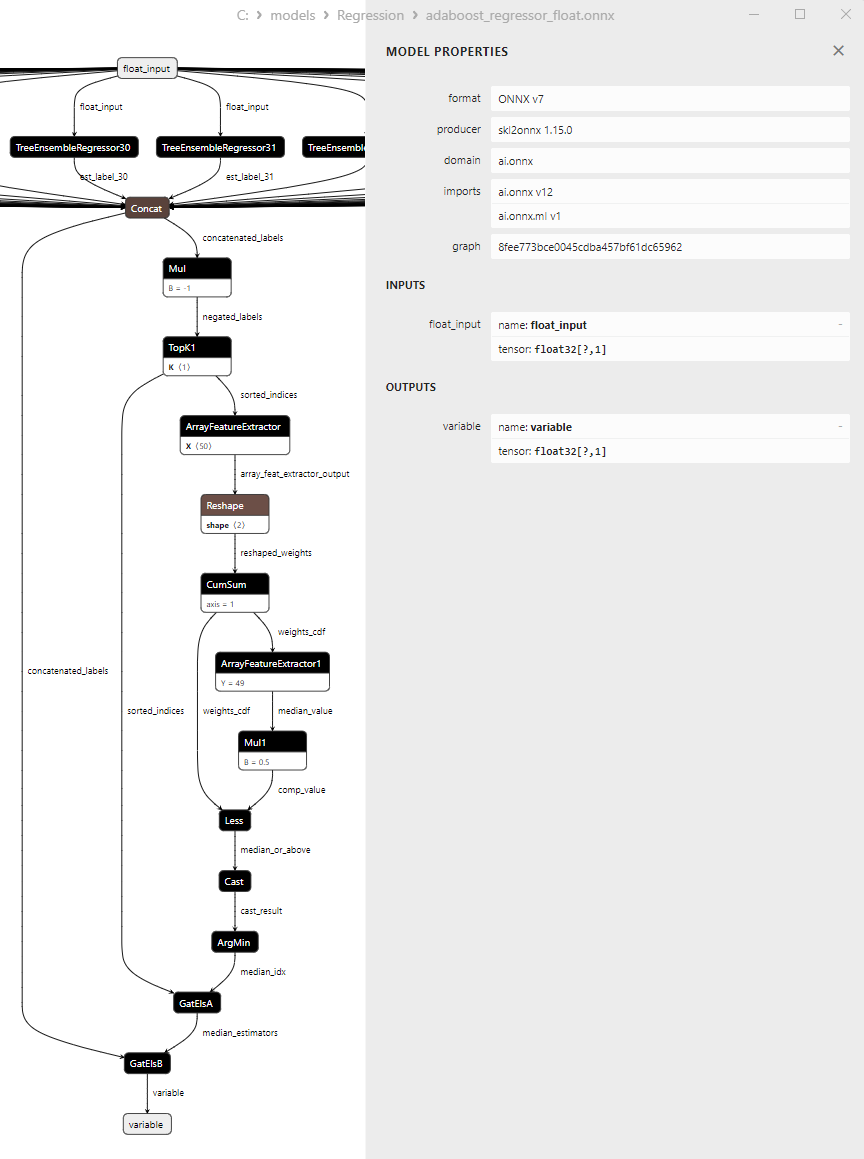

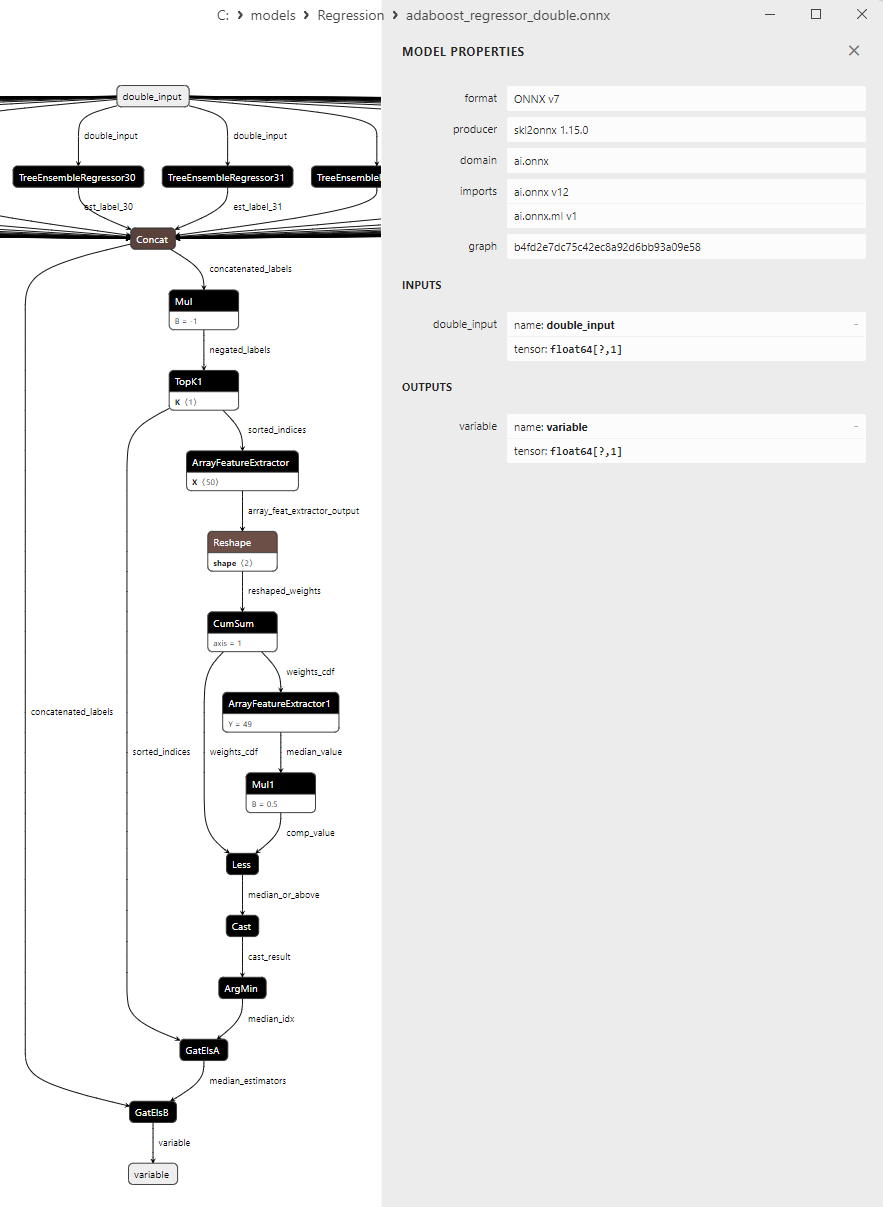

- 2.2.1. sklearn.linear_model.AdaBoostRegressor

2.2.1.1. Code pour créer le modèle AdaBoostRegressor et l'exporter vers ONNX pour float et double

2.2.1.2. Code MQL5 pour l'exécution des modèles ONNX

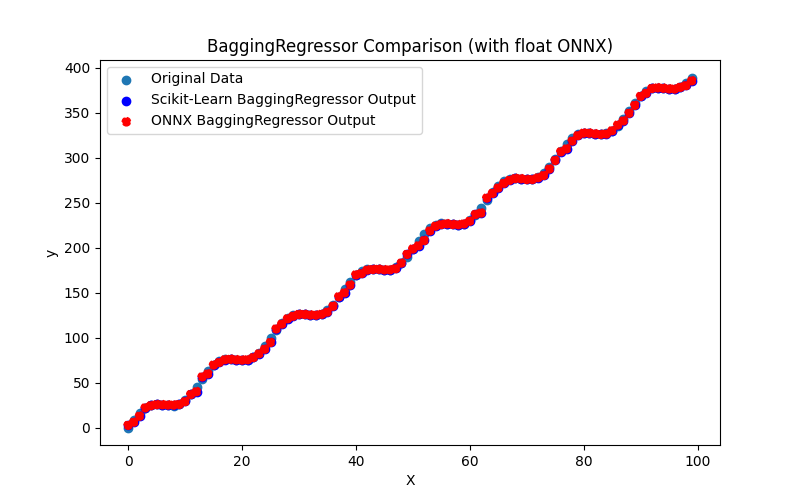

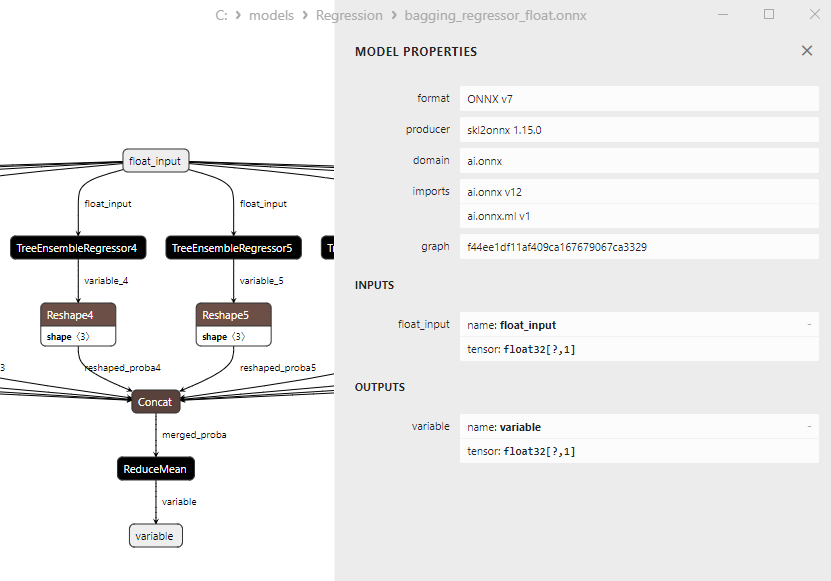

2.2.1.3. Représentation ONNX de adaboost_regressor_float.onnx et adaboost_regressor_double.onnx - 2.2.2. sklearn.linear_model.BaggingRegressor

2.2.2.1. Code pour créer le modèle BaggingRegressor et l'exporter vers ONNX pour float et double

2.2.2.2. Code MQL5 pour l'exécution des modèles ONNX

2.2.2.3. Représentation ONNX du bagging_regressor_float.onnx et du bagging_regressor_double.onnx - 2.2.3. sklearn.linear_model.DecisionTreeRegressor

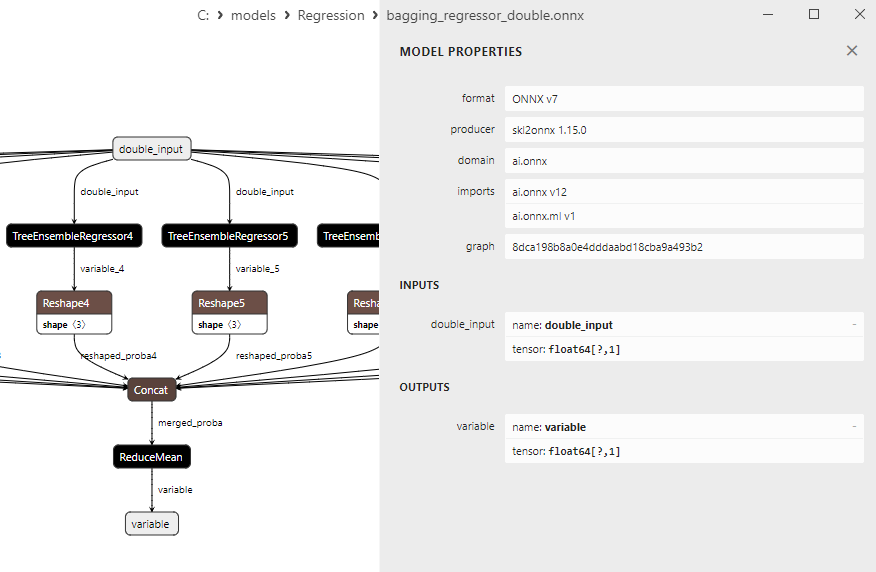

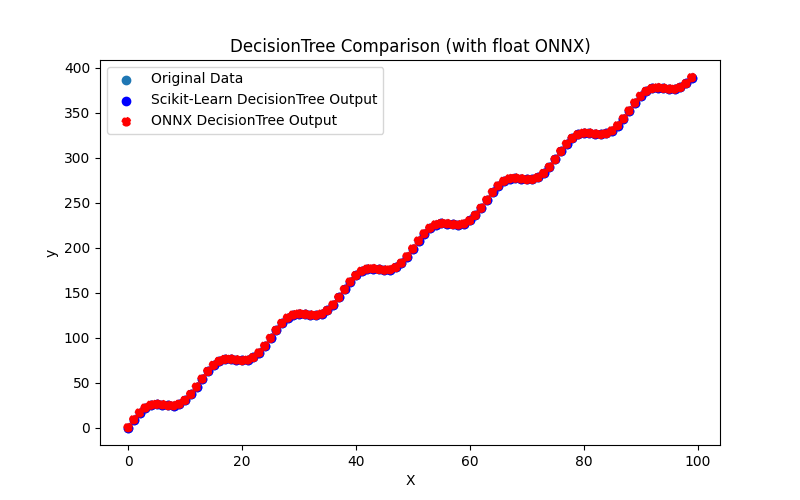

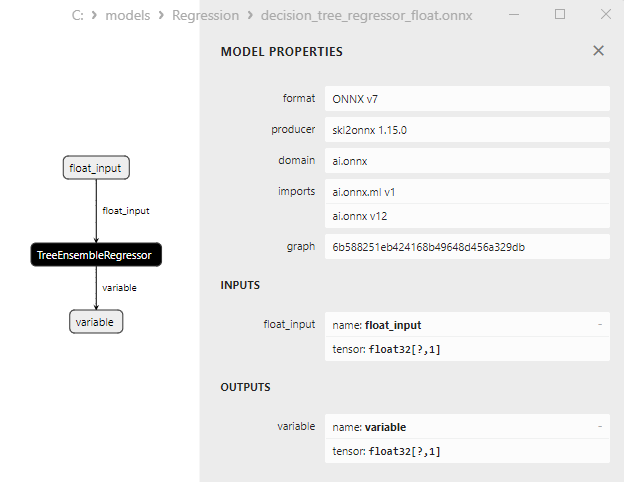

2.2.3.1. Code pour créer le modèle DecisionTreeRegressor et l'exporter vers ONNX pour float et double

2.2.3.2. Code MQL5 pour l'exécution des modèles ONNX

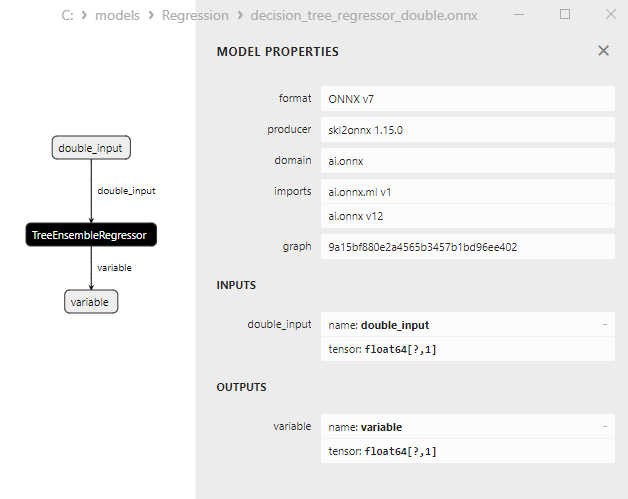

2.2.3.3. Représentation ONNX de decision_tree_regressor_float.onnx et decision_tree_regressor_double.onnx - 2.2.4. sklearn.linear_model.ExtraTreeRegressor

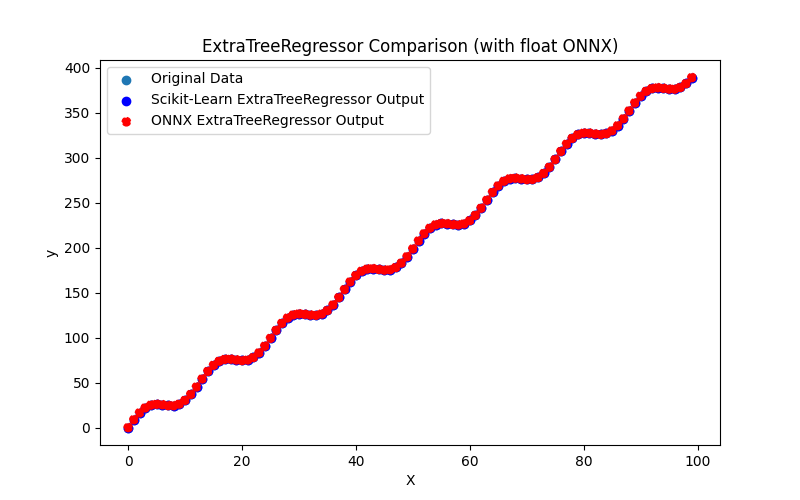

2.2.4.1. Code pour créer le modèle ExtraTreeRegressor et l'exporter vers ONNX pour float et double

2.2.4.2. Code MQL5 pour l'exécution des modèles ONNX

2.2.4.3. Représentation ONNX de l'extra_tree_regressor_float.onnx et de l'extra_tree_regressor_double.onnx - 2.2.5. sklearn.ensemble.ExtraTreesRegressor

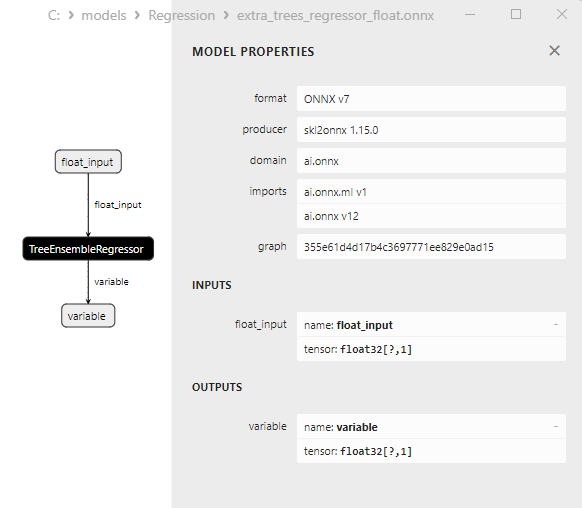

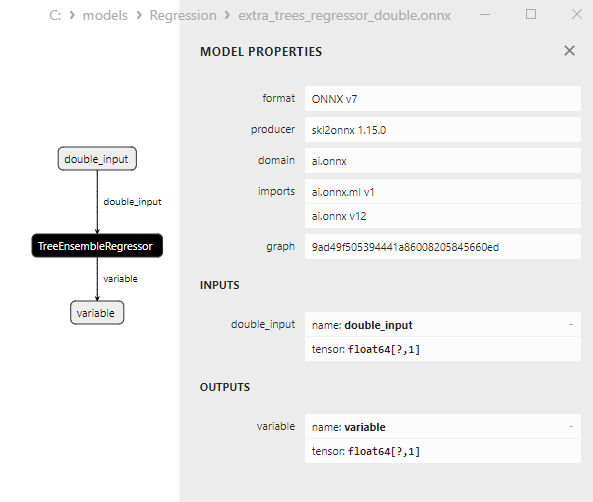

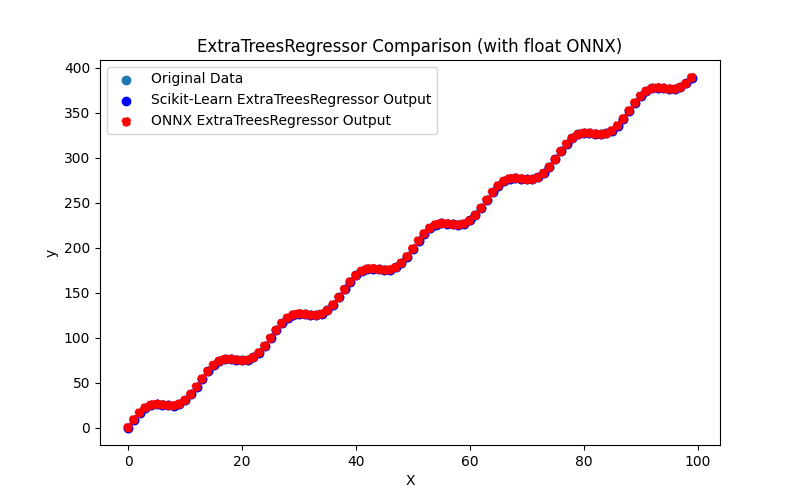

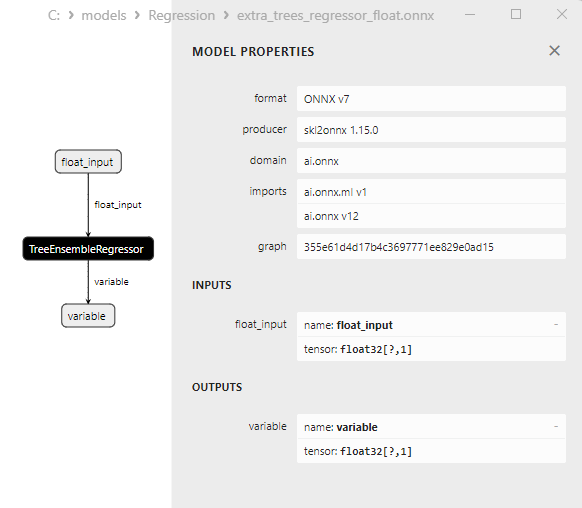

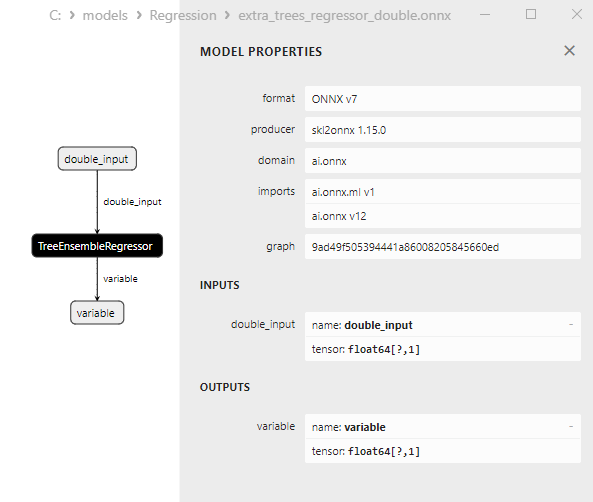

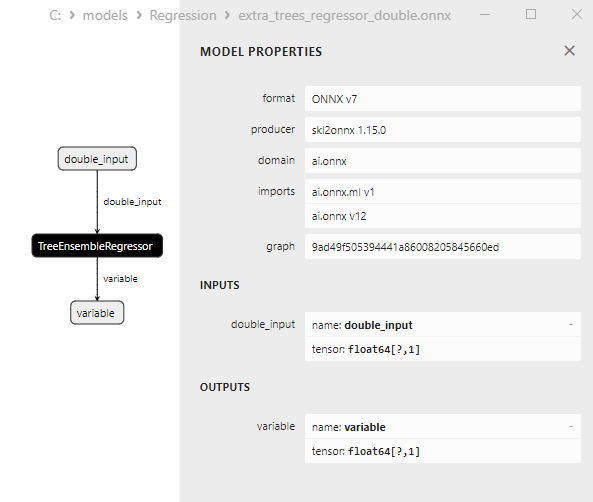

2.2.5.1. Code pour créer le modèle ExtraTreesRegressor et l'exporter vers ONNX pour float et double

2.2.5.2. Code MQL5 pour l'exécution des modèles ONNX

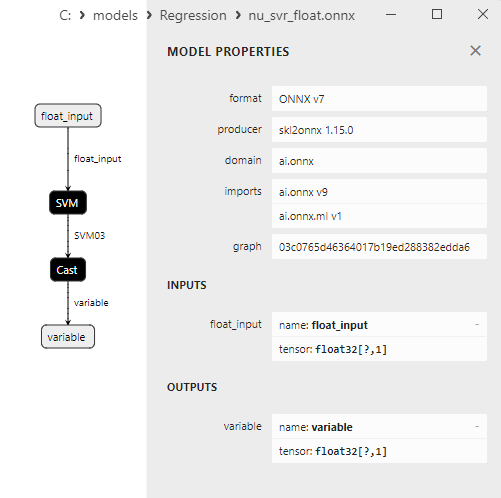

2.2.5.3. Représentation ONNX des extra_trees_regressor_float.onnx et extra_trees_regressor_double.onnx - 2.2.6. sklearn.svm.NuSVR

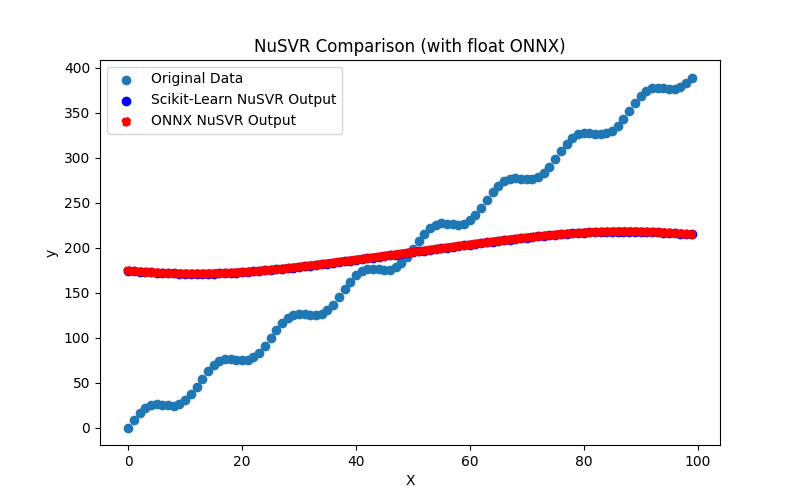

2.2.6.1. Code pour créer le modèle NuSVR et l'exporter vers ONNX pour float et double

2.2.6.2. Code MQL5 pour l'exécution des modèles ONNX

2.2.6.3. Représentation ONNX de nu_svr_float.onnx et nu_svr_double.onnx - 2.2.7. sklearn.ensemble.RandomForestRegressor

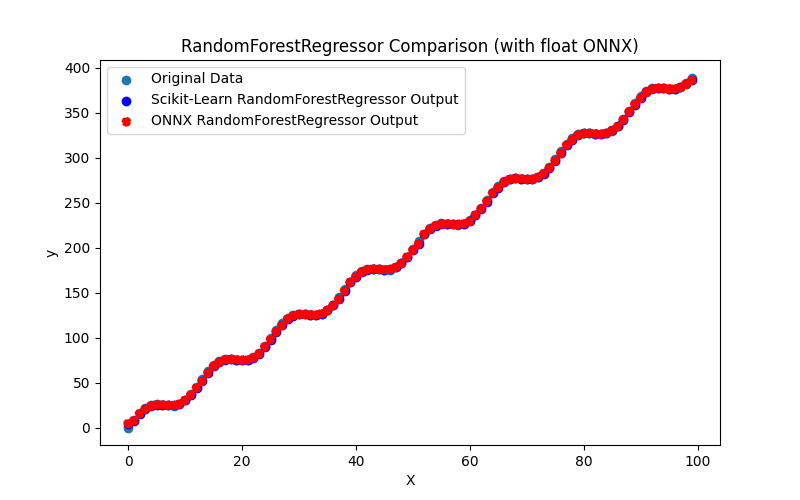

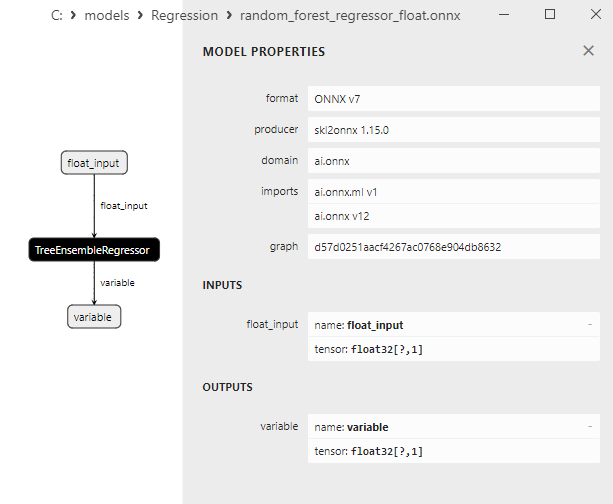

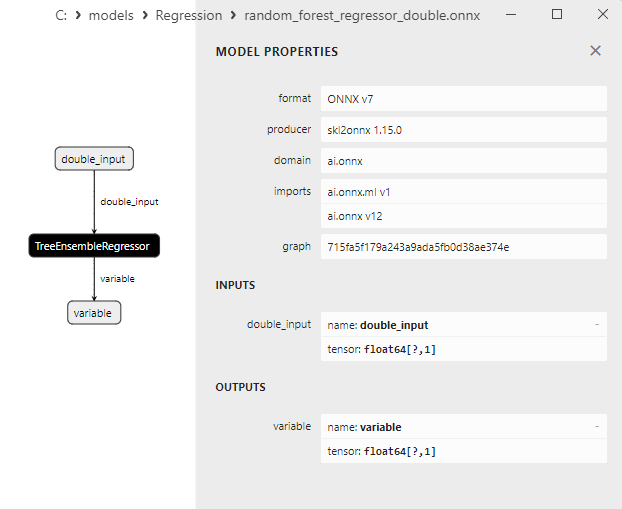

2.2.7.1. Code pour créer le modèle RandomForestRegressor et l'exporter vers ONNX pour float et double

2.2.7.2. Code MQL5 pour l'exécution des modèles ONNX

2.2.7.3. Représentation ONNX de random_forest_regressor_float.onnx et random_forest_regressor_double.onnx

- 2.2.8. sklearn.ensemble.GradientBoostingRegressor

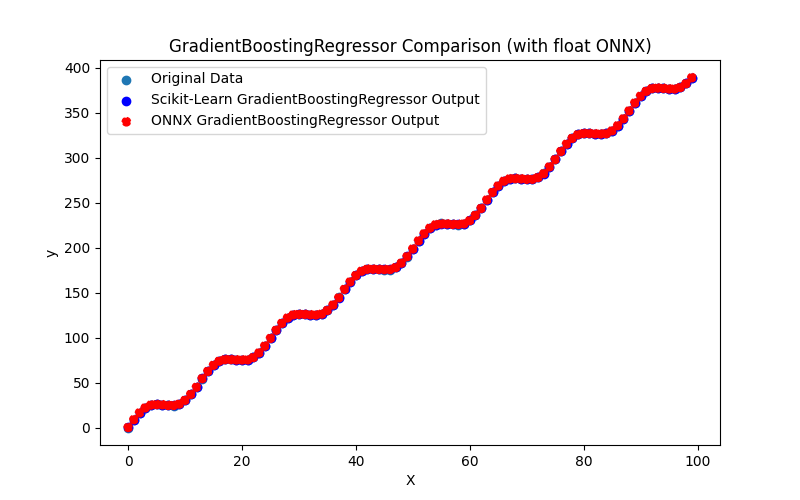

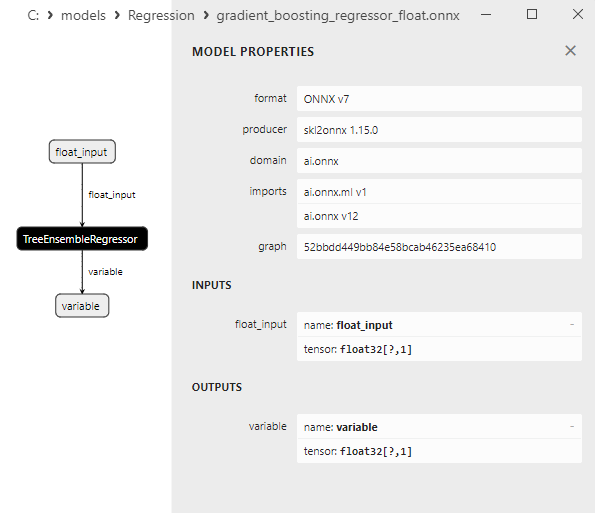

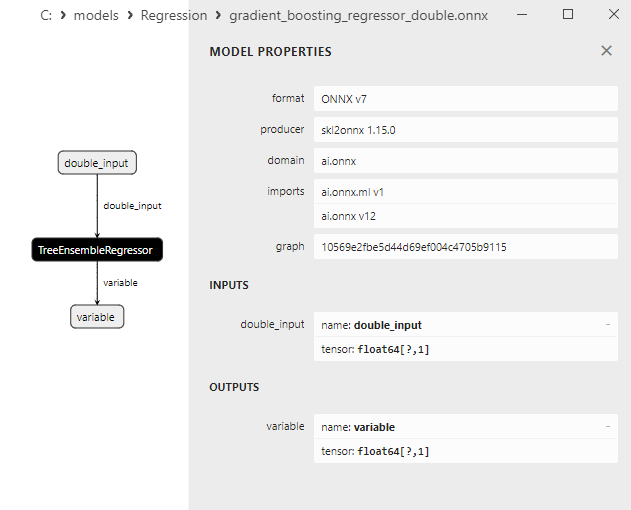

2.2.8.1. Code pour créer le modèle GradientBoostingRegressor et l'exporter vers ONNX pour float et double

2.2.8.2. Code MQL5 pour l'exécution des modèles ONNX

2.2.8.3. Représentation ONNX du gradient_boosting_regressor_float.onnx et du gradient_boosting_regressor_double.onnx

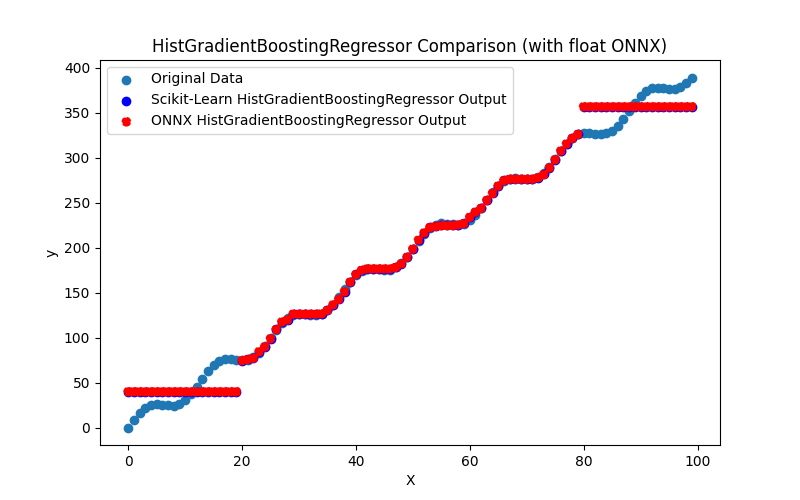

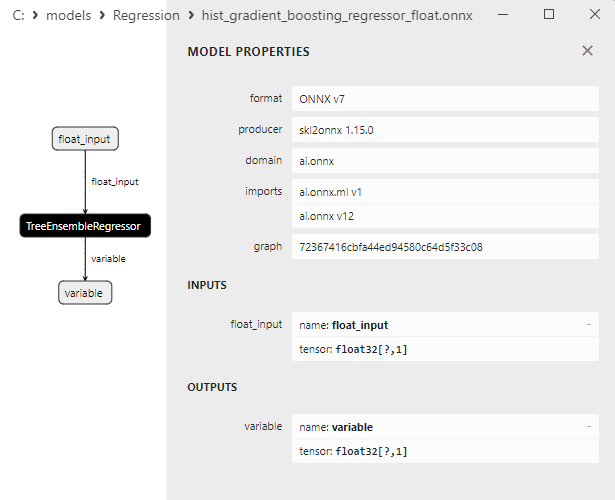

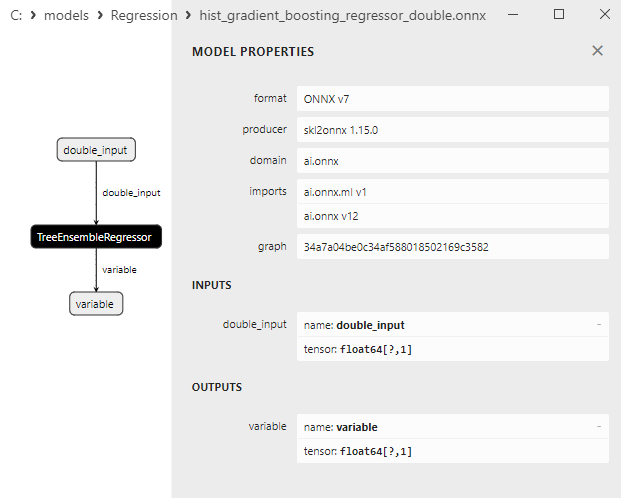

- 2.2.9. sklearn.ensemble.HistGradientBoostingRegressor

2.2.9.1. Code pour créer le modèle HistGradientBoostingRegressor et l'exporter vers ONNX pour float et double

2.2.9.2. Code MQL5 pour l'exécution des modèles ONNX

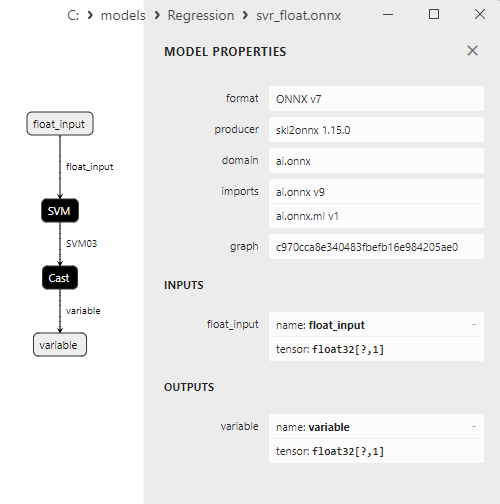

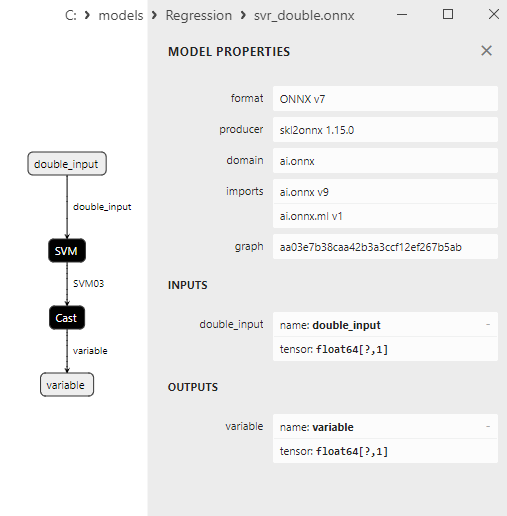

2.2.9.3. Représentation ONNX de hist_gradient_boosting_regressor_float.onnx et hist_gradient_boosting_regressor_double.onnx - 2.2.10. sklearn.svm.SVR

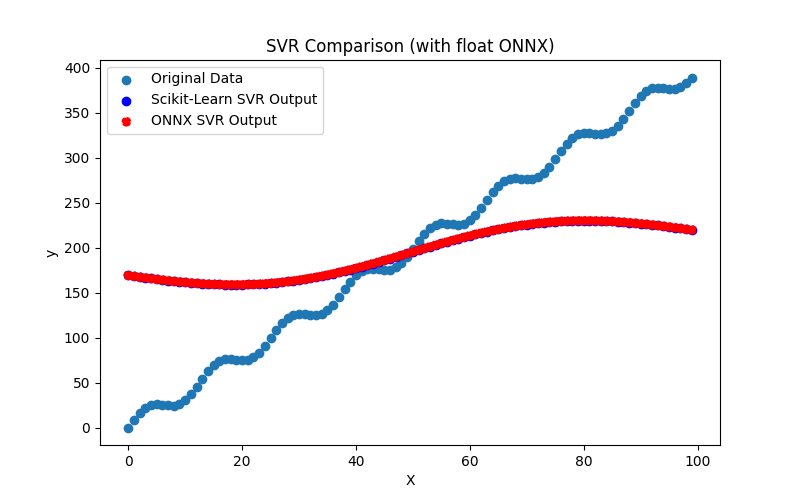

2.2.10.1. Code pour créer le modèle SVR et l'exporter vers ONNX pour float et double

2.2.10.2. Code MQL5 pour l'exécution des modèles ONNX

2.2.10.3. Représentation ONNX de svr_float.onnx et svr_double.onnx

- 2.3. Modèles de Régression qui ont rencontré des problèmes lors de la conversion en ONNX

- 2.3.1. sklearn.dummy.DummyRegressor

Code pour la création du DummyRegressor - 2.3.2. sklearn.kernel_ridge.KernelRidge

Code pour la création du KernelRidge - 2.3.3. sklearn.isotonic.IsotonicRegression

Code de création de IsotonicRegression - 2.3.4. sklearn.cross_decomposition.PLSCanonical

Code pour la création de PLSCanonical - 2.3.5. sklearn.cross_decomposition.CCA

Code de création de CCA - Conclusion

- Résumé

Si cela vous dérange, vous pouvez apporter votre contribution

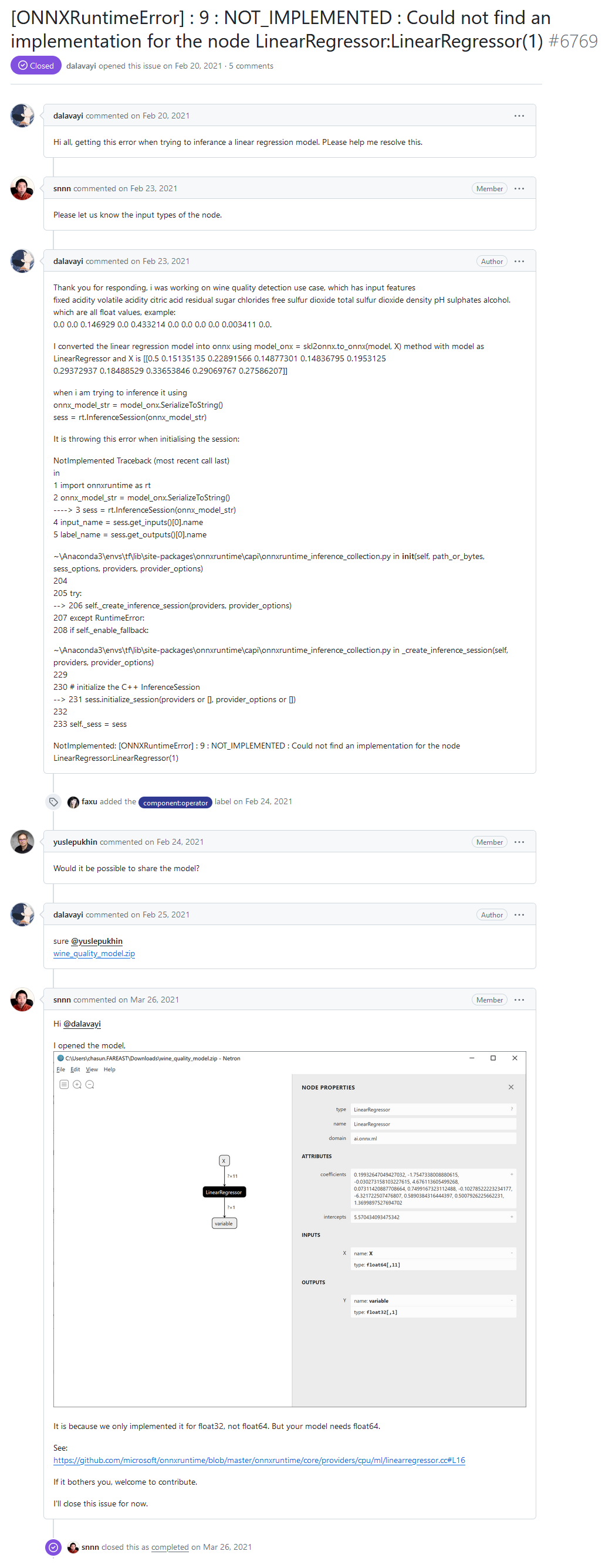

Sur le forum des développeurs du Runtime ONNX, l'un des utilisateurs a signalé une erreur "[ONNXRuntimeError] : 9 : NOT_IMPLEMENTED : Impossible de trouver une implémentation pour le nœud LinearRegressor:LinearRegressor(1)" lors de l'exécution d'un modèle via ONNX Runtime.

Bonjour à tous, j'obtiens cette erreur lorsque j'essaie de déduire un modèle de régression linéaire. Veuillez m'aider à résoudre ce problème.

"NOT_IMPLEMENTED : Impossible de trouver une implémentation pour le nœud LinearRegressor:LinearRegressor(1)" dans le forum des développeurs du Runtime ONNX

Réponse du développeur :

C'est parce que nous ne l'avons implémenté que pour float32, pas pour float64. Mais votre modèle a besoin de float64.

Voir :

https://github.com/microsoft/onnxruntime/blob/master/onnxruntime/core/providers/cpu/ml/linearregressor.cc#L16

Si cela vous dérange, n'hésitez pas à y contribuer.

Dans le modèle ONNX de l'utilisateur, l'opérateur est appelé avec un type de données double (float64), et le message d'erreur apparaît parce que le Runtime ONNX ne supporte pas l'opérateur LinearRegressor() avec une double précision.

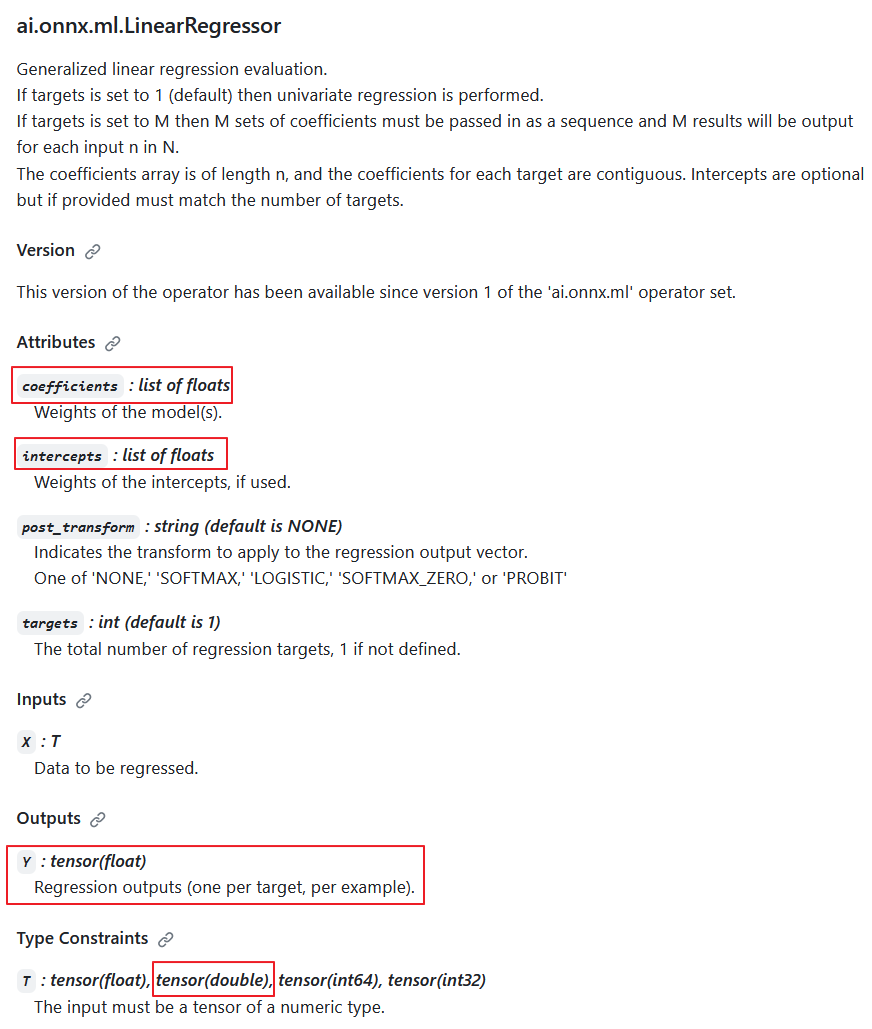

Selon la spécification de l'opérateur ai.onnx.ml.LinearRegressor, le type de données d'entrée double est possible (T: tensor(float), tensor(double), tensor(int64), tensor(int32)). Cependant, les développeurs ont intentionnellement choisi de ne pas l'implémenter.

La raison en est que la sortie renvoie toujours la valeur Y: tensor(float). De plus, les paramètres de calcul sont aussi des nombres flottants (coefficients : liste de float, intercepts : liste de float).

Par conséquent, lorsque les calculs sont effectués en double précision, cet opérateur réduit la précision à un flottant, et sa mise en œuvre dans les calculs en double précision a une valeur discutable.

Description de l'opérateur ai.onnx.ml.LinearRegressor

Ainsi, la réduction de la précision à des valeurs flottantes dans les paramètres et la valeur de sortie empêche le ai.onnx.ml.LinearRegressor de fonctionner pleinement avec des nombres doubles (float64). C'est probablement pour cette raison que les développeurs du Runtime ONNX ont décidé de ne pas l'implémenter pour le type double

La méthode consistant à "ajouter le support du type double" a été démontrée par les développeurs dans les commentaires du code (surlignés en jaune).

Dans le Runtime ONNX, son calcul est effectué en utilisant la classe LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.h).

Les paramètres de l'opérateur, coefficients_ et intercepts_, sont stockés sous forme de std::vector<float> :

#pragma once #include "core/common/common.h" #include "core/framework/op_kernel.h" #include "core/util/math_cpuonly.h" #include "ml_common.h" namespace onnxruntime { namespace ml { class LinearRegressor final : public OpKernel { public: LinearRegressor(const OpKernelInfo& info); Status Compute(OpKernelContext* context) const override; private: int64_t num_targets_; std::vector<float> coefficients_; std::vector<float> intercepts_; bool use_intercepts_; POST_EVAL_TRANSFORM post_transform_; }; } // namespace ml } // namespace onnxruntimeL'implémentation de l'opérateur LinearRegressor (https://github.com/microsoft/onnxruntime/blob/main/onnxruntime/core/providers/cpu/ml/linearregressor.cc) :

// Copyright (c) Microsoft Corporation. All rights reserved. // Licensed under the MIT License. #include "core/providers/cpu/ml/linearregressor.h" #include "core/common/narrow.h" #include "core/providers/cpu/math/gemm.h" namespace onnxruntime { namespace ml { ONNX_CPU_OPERATOR_ML_KERNEL( LinearRegressor, 1, // KernelDefBuilder().TypeConstraint("T", std::vector<MLDataType>{ // DataTypeImpl::GetTensorType<float>(), // DataTypeImpl::GetTensorType<double>()}), KernelDefBuilder().TypeConstraint("T", DataTypeImpl::GetTensorType<float>()), LinearRegressor); LinearRegressor::LinearRegressor(const OpKernelInfo& info) : OpKernel(info), intercepts_(info.GetAttrsOrDefault<float>("intercepts")), post_transform_(MakeTransform(info.GetAttrOrDefault<std::string>("post_transform", "NONE"))) { ORT_ENFORCE(info.GetAttr<int64_t>("targets", &num_targets_).IsOK()); ORT_ENFORCE(info.GetAttrs<float>("coefficients", coefficients_).IsOK()); // use the intercepts_ if they're valid use_intercepts_ = intercepts_.size() == static_cast<size_t>(num_targets_); } // Use GEMM for the calculations, with broadcasting of intercepts // https://github.com/onnx/onnx/blob/main/docs/Operators.md#Gemm // // X: [num_batches, num_features] // coefficients_: [num_targets, num_features] // intercepts_: optional [num_targets]. // Output: X * coefficients_^T + intercepts_: [num_batches, num_targets] template <typename T> static Status ComputeImpl(const Tensor& input, ptrdiff_t num_batches, ptrdiff_t num_features, ptrdiff_t num_targets, const std::vector<float>& coefficients, const std::vector<float>* intercepts, Tensor& output, POST_EVAL_TRANSFORM post_transform, concurrency::ThreadPool* threadpool) { const T* input_data = input.Data<T>(); T* output_data = output.MutableData<T>(); if (intercepts != nullptr) { TensorShape intercepts_shape({num_targets}); onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, intercepts->data(), &intercepts_shape, output_data, threadpool); } else { onnxruntime::Gemm<T>::ComputeGemm(CBLAS_TRANSPOSE::CblasNoTrans, CBLAS_TRANSPOSE::CblasTrans, num_batches, num_targets, num_features, 1.f, input_data, coefficients.data(), 1.f, nullptr, nullptr, output_data, threadpool); } if (post_transform != POST_EVAL_TRANSFORM::NONE) { ml::batched_update_scores_inplace(gsl::make_span(output_data, SafeInt<size_t>(num_batches) * num_targets), num_batches, num_targets, post_transform, -1, false, threadpool); } return Status::OK(); } Status LinearRegressor::Compute(OpKernelContext* ctx) const { Status status = Status::OK(); const auto& X = *ctx->Input<Tensor>(0); const auto& input_shape = X.Shape(); if (input_shape.NumDimensions() > 2) { return ORT_MAKE_STATUS(ONNXRUNTIME, INVALID_ARGUMENT, "Input shape had more than 2 dimension. Dims=", input_shape.NumDimensions()); } ptrdiff_t num_batches = input_shape.NumDimensions() <= 1 ? 1 : narrow<ptrdiff_t>(input_shape[0]); ptrdiff_t num_features = input_shape.NumDimensions() <= 1 ? narrow<ptrdiff_t>(input_shape.Size()) : narrow<ptrdiff_t>(input_shape[1]); Tensor& Y = *ctx->Output(0, {num_batches, num_targets_}); concurrency::ThreadPool* tp = ctx->GetOperatorThreadPool(); auto element_type = X.GetElementType(); switch (element_type) { case ONNX_NAMESPACE::TensorProto_DataType_FLOAT: { status = ComputeImpl<float>(X, num_batches, num_features, narrow<ptrdiff_t>(num_targets_), coefficients_, use_intercepts_ ? &intercepts_ : nullptr, Y, post_transform_, tp); break; } case ONNX_NAMESPACE::TensorProto_DataType_DOUBLE: { // TODO: Add support for 'double' to the scoring functions in ml_common.h // once that is done we can just call ComputeImpl<double>... // Alternatively we could cast the input to float. } default: status = ORT_MAKE_STATUS(ONNXRUNTIME, FAIL, "Unsupported data type of ", element_type); } return status; } } // namespace ml } // namespace onnxruntime

Il s'avère qu'il existe une option permettant d'utiliser des nombres doubles comme valeurs d'entrée et d'effectuer le calcul de l'opérateur avec des paramètres flottants. Une autre possibilité serait de réduire la précision des données d'entrée à des valeurs flottantes. Mais aucune de ces options ne peut être considérée comme une solution adéquate.

La spécification de l'opérateur ai.onnx.ml.LinearRegressor limite la possibilité d'un fonctionnement complet avec des nombres doubles puisque les paramètres et la valeur de sortie sont limités au type flottant.

Une situation similaire se produit avec d'autres opérateurs ML d'ONNX, tels que ai.onnx.ml.SVMRegressor et ai.onnx.ml.TreeEnsembleRegressor.

Par conséquent, tous les développeurs utilisant l'exécution de modèles ONNX en double précision sont confrontés à cette limitation de la spécification. Une solution pourrait consister à étendre la spécification ONNX (ou à ajouter des opérateurs similaires tels que LinearRegressor64, SVMRegressor64 et TreeEnsembleRegressor64 avec des paramètres et des valeurs de sortie en double). Mais à l'heure actuelle, cette question n'est pas résolue.

Tout dépend du convertisseur ONNX. Pour les modèles calculés en double, il peut être préférable de ne pas utiliser ces opérateurs (bien que cela ne soit pas toujours possible). Dans ce cas particulier, le convertisseur vers ONNX n'a pas fonctionné de manière optimale avec le modèle de l'utilisateur.

Comme nous le verrons plus loin, le convertisseur sklearn-onnx parvient à contourner la limitation de LinearRegressor : pour les modèles ONNX double, il utilise les opérateurs ONNX MatMul() et Add() à la place. Grâce à cette méthode, de nombreux modèles de régression de la bibliothèque Scikit-learn sont convertis avec succès en modèles ONNX calculés en double, tout en préservant la précision des modèles doubles originaux.

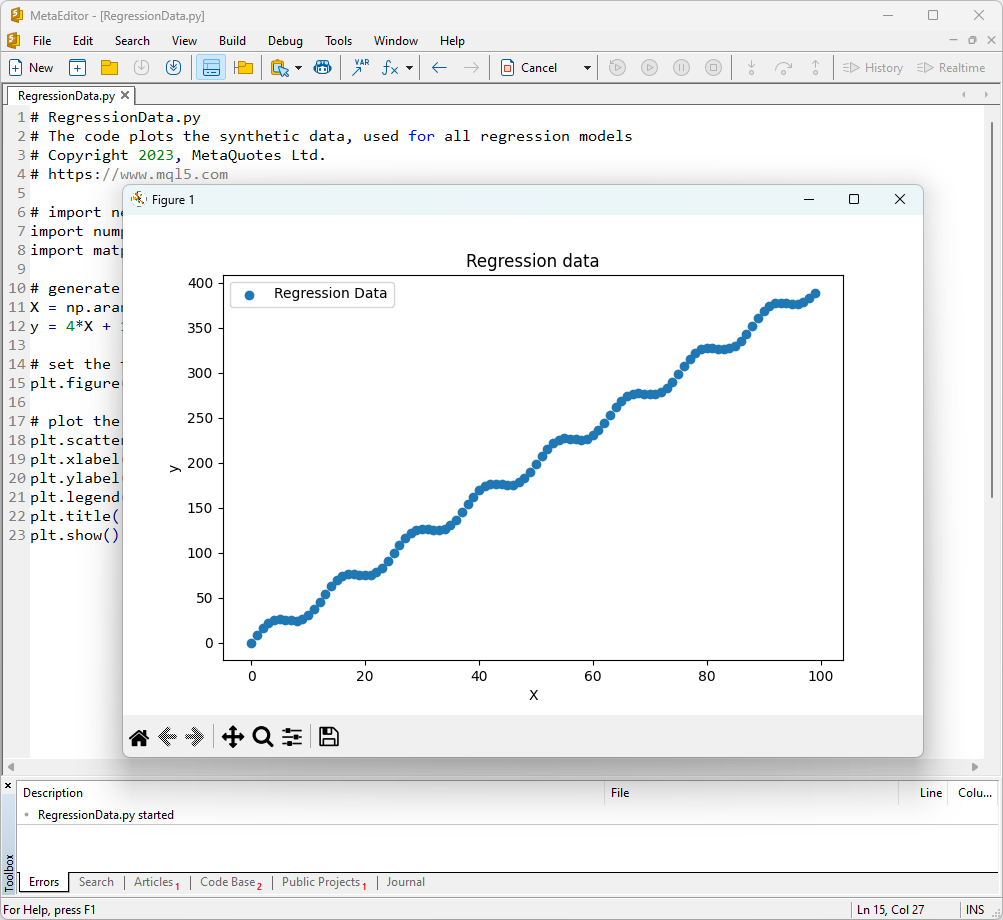

1. Ensemble des Données de Test

Pour exécuter les exemples, vous devrez installer Python (nous avons utilisé la version 3.10.8), des bibliothèques supplémentaires (pip install -U scikit-learn numpy matplotlib onnx onnxruntime skl2onnx), et spécifier le chemin vers Python dans MetaEditor (dans le menu Outils->Options->Compilateurs->Python).

Comme ensemble de données de test, nous utiliserons les valeurs générées de la fonction y = 4X + 10sin(X*0.5).

Pour afficher le graphique d'une telle fonction, ouvrez MetaEditor, créez un fichier nommé RegressionData.py, copiez le texte du script et exécutez-le en cliquant sur le bouton "Compiler".

Le script d'affichage de l'ensemble des données de test

# RegressionData.py # The code plots the synthetic data, used for all regression models # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # import necessary libraries import numpy as np import matplotlib.pyplot as plt # generate synthetic data for regression X = np.arange(0,100,1).reshape(-1,1) y = 4*X + 10*np.sin(X*0.5) # set the figure size plt.figure(figsize=(8,5)) # plot the initial data for regression plt.scatter(X, y, label='Regression Data', marker='o') plt.xlabel('X') plt.ylabel('y') plt.legend() plt.title('Regression data') plt.show()

Un graphique de la fonction sera ensuite affiché? Nous l’utiliserons pour tester les méthodes de régression.

Fig. 1. Fonction de test des modèles de régression

2. Modèles de Régression

L'objectif d'une tâche de régression est de trouver une fonction mathématique ou un modèle qui décrit au mieux la relation entre les caractéristiques et la variable cible afin de prédire les valeurs numériques des nouvelles données. Cela permet de faire des prévisions, d'optimiser les solutions et de prendre des décisions éclairées sur la base de ces données.

Considérons les principaux modèles de régression du paquet scikit-learn.

2.0. Liste des Modèles de Régression Scikit-learn

Pour afficher la liste des modèles de régression scikit-learn disponibles, vous pouvez utiliser le script suivant :

# ScikitLearnRegressors.py # The script lists all the regression algorithms available inb scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn regression models from sklearn.utils import all_estimators regressors = all_estimators(type_filter='regressor') for index, (name, RegressorClass) in enumerate(regressors, start=1): print(f"Regressor {index}: {name}")

Sortie :

The scikit-learn version is 1.3.2.

Regressor 1: ARDRegression

Regressor 2: AdaBoostRegressor

Regressor 3: BaggingRegressor

Regressor 4: BayesianRidge

Regressor 5: CCA

Regressor 6: DecisionTreeRegressor

Regressor 7: DummyRegressor

Regressor 8: ElasticNet

Regressor 9: ElasticNetCV

Regressor 10: ExtraTreeRegressor

Regressor 11: ExtraTreesRegressor

Regressor 12: GammaRegressor

Regressor 13: GaussianProcessRegressor

Regressor 14: GradientBoostingRegressor

Regressor 15: HistGradientBoostingRegressor

Regressor 16: HuberRegressor

Regressor 17: IsotonicRegression

Regressor 18: KNeighborsRegressor

Regressor 19: KernelRidge

Regressor 20: Lars

Regressor 21: LarsCV

Regressor 22: Lasso

Regressor 23: LassoCV

Regressor 24: LassoLars

Regressor 25: LassoLarsCV

Regressor 26: LassoLarsIC

Regressor 27: LinearRegression

Regressor 28: LinearSVR

Regressor 29: MLPRegressor

Regressor 30: MultiOutputRegressor

Regressor 31: MultiTaskElasticNet

Regressor 32: MultiTaskElasticNetCV

Regressor 33: MultiTaskLasso

Regressor 34: MultiTaskLassoCV

Regressor 35: NuSVR

Regressor 36: OrthogonalMatchingPursuit

Regressor 37: OrthogonalMatchingPursuitCV

Regressor 38: PLSCanonical

Regressor 39: PLSRegression

Regressor 40: PassiveAggressiveRegressor

Regressor 41: PoissonRegressor

Regressor 42: QuantileRegressor

Regressor 43: RANSACRegressor

Regressor 44: RadiusNeighborsRegressor

Regressor 45: RandomForestRegressor

Regressor 46: RegressorChain

Regressor 47: Ridge

Regressor 48: RidgeCV

Regressor 49: SGDRegressor

Regressor 50: SVR

Regressor 51: StackingRegressor

Regressor 52: TheilSenRegressor

Regressor 53: TransformedTargetRegressor

Regressor 54: TweedieRegressor

Regressor 55: VotingRegressor

Pour des raisons de commodité, les régresseurs sont mis en évidence dans des couleurs différentes. Les modèles qui nécessitent un modèle de régression de base sont surlignés en gris, alors que les autres modèles peuvent être utilisés indépendamment. Notez que les modèles exportés avec succès au format ONNX sont marqués en vert, les modèles qui rencontrent des erreurs lors de la conversion dans la version actuelle de scikit-learn 1.2.2 sont marqués en rouge. Les méthodes inadaptées à la tâche d'essai considérée sont surlignées en bleu.

L'analyse de la qualité de la régression utilise des mesures de régression, qui sont des fonctions des valeurs réelles et des valeurs prédites. Dans le langage MQL5, plusieurs métriques différentes sont disponibles. Elles sont détaillées dans l'article "Evaluation des modèles ONNX à l’aide de métriques de régression".

Dans cet article, 3 métriques seront utilisées pour comparer la qualité des différents modèles :

- Le coefficient de détermination R-carré (R2) ;

- L’Erreur Absolue Moyenne (EAM) ;

- L’Erreur Quadratique Moyenne (EQM).

2.1. Modèles de régression Scikit-learn convertis en modèles ONNX float et double

Cette section présente les modèles de régression qui ont été convertis avec succès dans les formats ONNX en précision flottante et double.

Tous les modèles de régression examinés plus loin sont présentés sous la forme suivante :

- Description du modèle, principe de fonctionnement, avantages et limites

- Script Python pour créer le modèle, l'exporter vers des fichiers ONNX aux formats float et double, et exécuter les modèles obtenus en utilisant le Runtime ONNX en Python. Des métriques telles que R^2, MAE, MSE, calculées à l'aide de sklearn.metrics, sont utilisées pour évaluer la qualité des modèles originaux et ONNX.

- Script MQL5 pour l'exécution de modèles ONNX (float et double) via le Runtime ONNX, avec des métriques calculées en utilisant RegressionMetric().

- Représentation du modèle ONNX dans Netron pour les précisions float et double.

2.1.1. sklearn.linear_model.ARDRegression

L’ARDRegression (Automatic Relevance Determination Regression) est une méthode de régression conçue pour résoudre les problèmes de régression en déterminant automatiquement l'importance (la pertinence) des caractéristiques et en établissant leurs poids au cours du processus d'apprentissage du modèle.

L’ARDRegression permet de détecter et d'utiliser uniquement les caractéristiques les plus importantes pour construire un modèle de régression, ce qui peut s'avérer utile lorsqu'on a affaire à un grand nombre de caractéristiques.

Principe de fonctionnement de l'ARDRegression :

- Régression Linéaire : L’ARDRegression est basé sur la régression linéaire, en supposant une relation linéaire entre les variables indépendantes (caractéristiques) et la variable cible.

- Détermination Automatique de l'Importance des Caractéristiques : La principale caractéristique de l'ARDRegression est la détermination automatique des caractéristiques les plus importantes pour prédire la variable cible. Pour ce faire, on introduit des distributions préalables (régularisation) sur les poids, ce qui permet au modèle de fixer automatiquement des poids nuls pour les caractéristiques les moins significatives.

- Estimation des Probabilités Postérieures : L’ARDRegression calcule les probabilités postérieures pour chaque caractéristique, ce qui permet de déterminer leur importance. Les caractéristiques dont la probabilité a posteriori est élevée sont considérées comme pertinentes et reçoivent des poids non nuls, tandis que les caractéristiques dont la probabilité a posteriori est faible reçoivent des poids nuls.

- Réduction de la Dimensionnalité : Ainsi, l'ARDRegression peut conduire à une réduction de la dimensionnalité des données en supprimant les caractéristiques insignifiantes.

Avantages de l'ARDRegression :

- Détermination Automatique des Caractéristiques Importantes : La méthode identifie et utilise automatiquement les caractéristiques les plus importantes, ce qui peut améliorer les performances du modèle et réduire le risque de sur-ajustement.

- Résistance à la Multicolinéarité : L’ARDRegression gère bien la multicolinéarité, même lorsque les caractéristiques sont fortement corrélées.

Limites de l'ARDRegression :

- Nécessite la Sélection de Distributions Préalables : Le choix de distributions préalables appropriées peut nécessiter une expérimentation.

- Complexité de Calcul : L'apprentissage de l'ARDRegression peut être coûteux en termes de calcul, en particulier pour les grands ensembles de données.

L’ARDRegression est une méthode de régression qui détermine automatiquement l'importance des caractéristiques et établit leurs poids sur la base des probabilités a posteriori. Cette méthode est utile lorsque seules les caractéristiques significatives sont prises en compte pour construire un modèle de régression et qu'il est nécessaire de réduire la dimensionnalité des données.

2.1.1.1. Code pour créer le modèle ARDRegression et l'exporter vers ONNX pour float et double

Ce code crée le modèle sklearn.linear_model.ARDRegression, l'entraîne sur des données synthétiques, enregistre le modèle au format ONNX et effectue des prédictions en utilisant des données d'entrée flottantes et doubles. Il évalue également la précision du modèle original et des modèles exportés vers ONNX.

# Le code démontre le processus d'entraînement du modèle ARDRegressor, son export au format ONNX (à la fois float et double), et la réalisation de prédictions à l'aide des modèles ONNX.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# fonction de comparaison des décimales correspondantes

def compare_decimal_places(value1, value2):

# convertit les deux valeurs en chaînes de caractères

str_value1 = str(value1)

str_value2 = str(value2)

# trouve les positions des points décimaux dans les chaînes de caractères

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# si l'une des valeurs n'a pas de point décimal, retourne 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calcule le nombre de décimales

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# trouve le minimum du nombre de décimales

min_decimal_places = min(decimal_places1, decimal_places2)

# initialise un compte pour les décimales correspondantes

matching_count = 0

# compare les caractères après la virgule

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# importe les bibliothèques nécessaires

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import ARDRegression

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# définit le chemin d'accès pour l'enregistrement du modèle

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# génère des données synthétiques pour la régression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name="ARDRegression"

onnx_model_filename = data_path + "ard_regression"

# crée un modèle ARDRegression

regression_model = ARDRegression()

# ajuste le modèle aux données

regression_model.fit(X, y.ravel())

# prédit les valeurs pour l'ensemble du jeu de données

y_pred = regression_model.predict(X)

# évalue la performance du modèle

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convertit en modèle ONNX (float)

# définit le type de données d'entrée comme FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# exporte le modèle au format ONNX

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# enregistre le modèle dans un fichier

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# affiche le chemin du modèle

print(f"ONNX model saved to {onnx_filename}")

# charge le modèle ONNX et fait des prédictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# affiche les informations sur les tenseurs d'entrée dans ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# affiche les informations sur les tenseurs de sortie dans ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# définit le type de données d'entrée comme FloatTensorType

initial_type_float = X.astype(np.float32)

# prédit les valeurs pour l'ensemble du jeu de données en utilisant ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calcule et affiche les erreurs pour les modèles originaux et ONNX

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-carré (Coefficient de Détermination)", r2_onnx_float)

print("Erreur Absolue Moyenne :", mae_onnx_float)

print("Erreur Quadratique Moyenne :", mse_onnx_float)

print("R^2 matching decimal places : ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places : ", compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places : ", compare_decimal_places(mse, mse_onnx_float))

print("Précision du modèle ONNX float : ", compare_decimal_places(mae, mae_onnx_float))

# définit la taille de la figure

plt.figure(figsize=(8, 5))

# trace les données originales et les données de régression

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparaison (avec ONNX float)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convertit en modèle ONNX (double)

# définit le type de données d'entrée comme DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# exporte le modèle au format ONNX

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# enregistre le modèle dans un fichier

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" Modèle ONNX (double)")

# affiche le chemin du modèle

print(f"ONNX model saved to {onnx_filename}")

# charge le modèle ONNX et fait des prédictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# affiche les informations sur les tenseurs d'entrée dans ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# affiche les informations sur les tenseurs de sortie dans ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# définit le type de données d'entrée comme DoubleTensorType

initial_type_double = X.astype(np.float64)

# prédit les valeurs pour l'ensemble du jeu de données en utilisant ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calcule et affiche les erreurs pour les modèles originaux et ONNX

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-carré (Coefficient de Détermination)", r2_onnx_double)

print("Erreur Absolue Moyenne :", mae_onnx_double)

print("Erreur Quadratique Moyenne :", mse_onnx_double)

print("R^2 matching decimal places : ", compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places : ", compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places : ", compare_decimal_places(mse, mse_onnx_double))

print("Précision du modèle ONNX double : ", compare_decimal_places(mae, mae_onnx_float))

# définit la taille de la figure

plt.figure(figsize=(8, 5))

# trace les données originales et la ligne de régression

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparaison (avec ONNX double)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

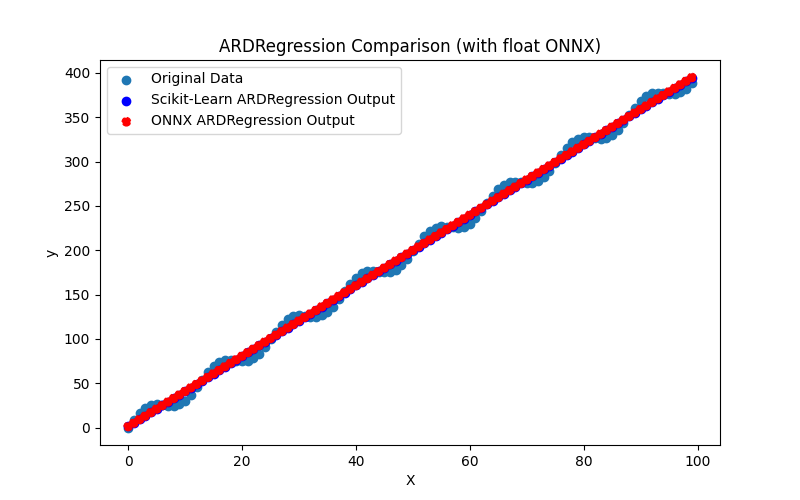

Le script crée et entraîne le modèle sklearn.linear_model.ARDRegression (le modèle original est considéré en type double), puis exporte le modèle vers ONNX pour les types float et double (ard_regression_float.onnx et ard_regression_double.onnx) et compare la précision de leurs fonctionnements.

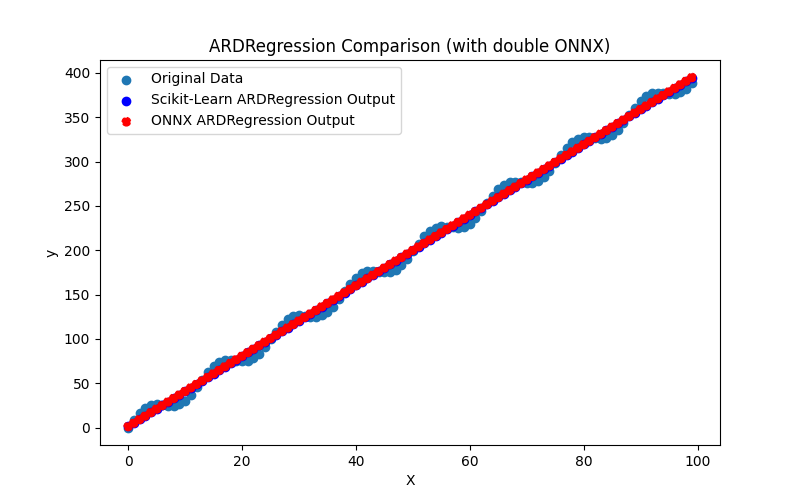

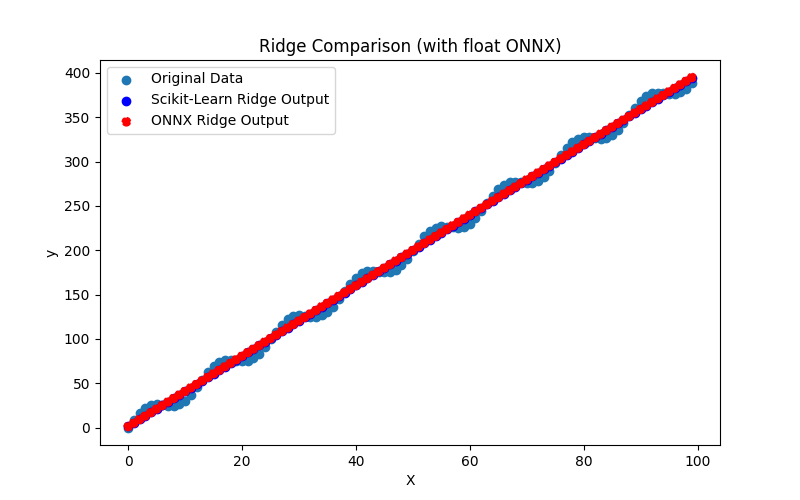

Il génère également les fichiers ARDRegression_plot_float.png et ARDRegression_plot_double.png, permettant une évaluation visuelle des résultats des modèles ONNX pour float et double (Fig. 2-3).

Fig. 2. Résultats de ARDRegression.py (float)

Fig. 3. Résultats de ARDRegression.py (double)

Visuellement, les modèles ONNX pour les flottants et les doubles sont identiques (Fig. 2-3), des informations détaillées peuvent être trouvées dans l'onglet Journal :

Python ARDRegression Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python Python ARDRegression ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python ONNX: MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python ARDRegression ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\ard_regression_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891289 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

Dans cet exemple, le modèle original a été considéré en double, puis il a été exporté dans les modèles ONNX ard_regression_float.onnx et ard_regression_double.onnx pour float et double, respectivement.

Si la précision du modèle est évaluée par l'Erreur Absolue Moyenne (MAE), la précision du modèle ONNX pour le flottant est de 6 décimales, alors que le modèle ONNX utilisant le type double a montré une rétention de précision jusqu'à 15 décimales, en ligne avec la précision du modèle original.

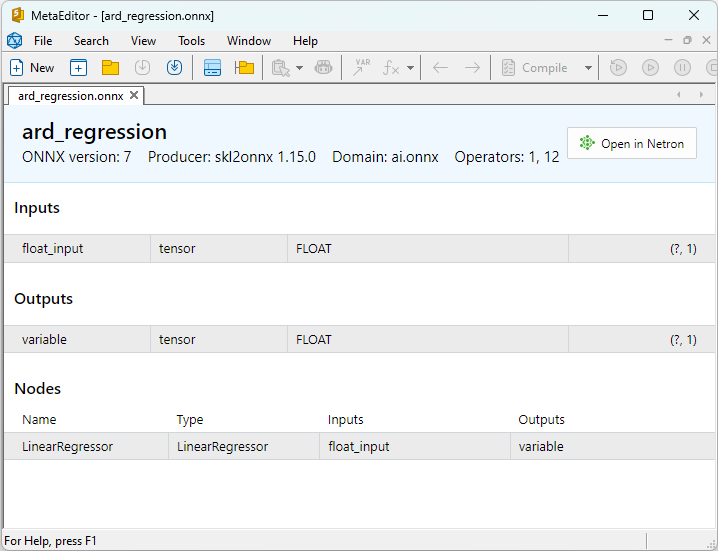

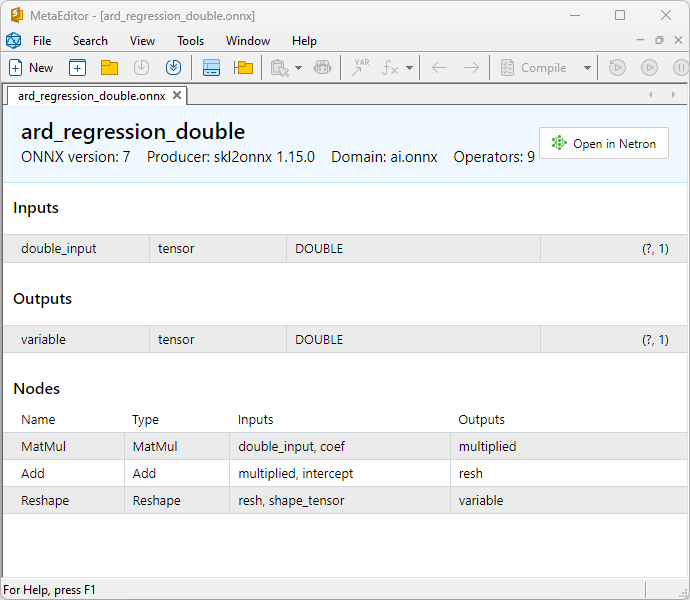

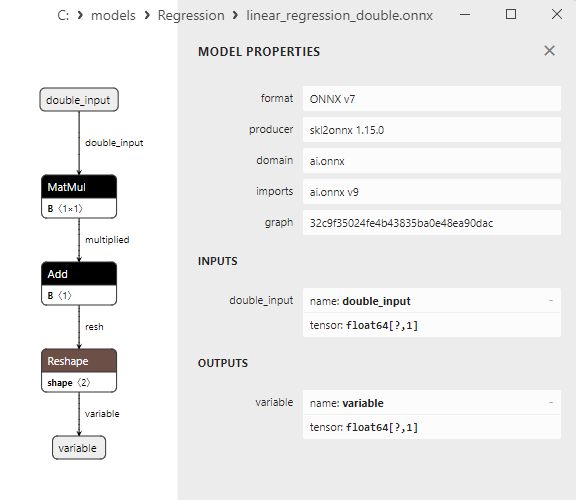

Les propriétés des modèles ONNX peuvent être visualisées dans MetaEditor (Fig. 4-5).

Fig. 4. Modèle ONNX ard_regression_float.onnx dans MetaEditor

Fig. 5. Modèle ONNX ard_regression_double.onnx dans MetaEditor

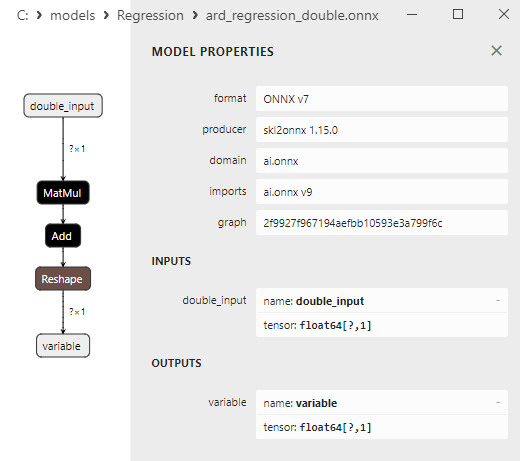

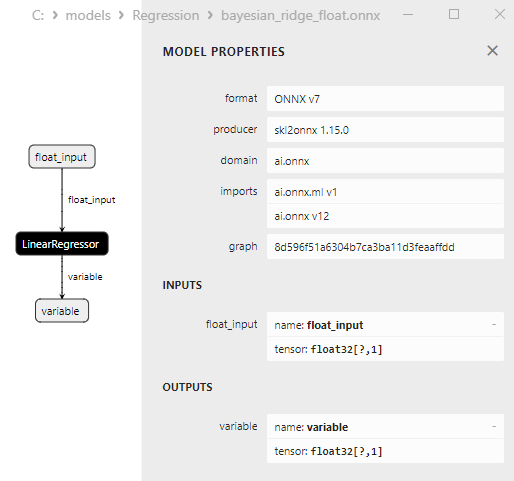

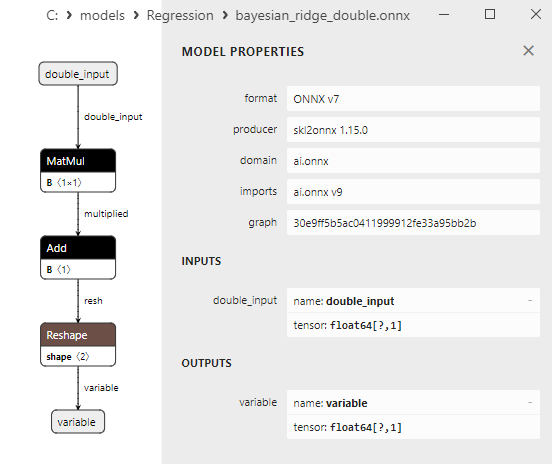

Une comparaison entre les modèles ONNX flottants et doubles montre que dans ce cas, le calcul des modèles ONNX pour ARDRegression se fait différemment : pour les nombres flottants, l'opérateur LinearRegressor() d'ONNX-ML est utilisé, alors que pour les nombres doubles, les opérateurs ONNX MatMul(), Add(), et Reshape() sont utilisés.

L'implémentation du modèle dans ONNX dépend du convertisseur ; dans les exemples d'export vers ONNX, la fonction skl2onnx.convert_sklearn() de la bibliothèque skl2onnx sera utilisée.

2.1.1.2. Code MQL5 pour l'exécution des modèles ONNX

Ce code exécute les modèles ONNX ard_regression_float.onnx et ard_regression_double.onnx sauvegardés et démontre l'utilisation des métriques de régression dans MQL5.

//+------------------------------------------------------------------+ //| ARDRegression.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #define ModelName "ARDRegression" #define ONNXFilenameFloat "ard_regression_float.onnx" #define ONNXFilenameDouble "ard_regression_double.onnx" #resource ONNXFilenameFloat as const uchar ExtModelFloat[]; #resource ONNXFilenameDouble as const uchar ExtModelDouble[]; #define TestFloatModel 1 #define TestDoubleModel 2 //+------------------------------------------------------------------+ //| Calculate regression using float values | //+------------------------------------------------------------------+ bool RunModelFloat(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor float input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=(float)input_vector[k]; //--- prepare output tensor float output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Calculate regression using double values | //+------------------------------------------------------------------+ bool RunModelDouble(long model,vector &input_vector, vector &output_vector) { //--- check number of input samples ulong batch_size=input_vector.Size(); if(batch_size==0) return(false); //--- prepare output array output_vector.Resize((int)batch_size); //--- prepare input tensor double input_data[]; ArrayResize(input_data,(int)batch_size); //--- set input shape ulong input_shape[]= {batch_size, 1}; OnnxSetInputShape(model,0,input_shape); //--- copy data to the input tensor for(int k=0; k<(int)batch_size; k++) input_data[k]=input_vector[k]; //--- prepare output tensor double output_data[]; ArrayResize(output_data,(int)batch_size); //--- set output shape ulong output_shape[]= {batch_size,1}; OnnxSetOutputShape(model,0,output_shape); //--- run the model bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output_data); //--- copy output to vector if(res) { for(int k=0; k<(int)batch_size; k++) output_vector[k]=output_data[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Generate synthetic data | //+------------------------------------------------------------------+ bool GenerateData(const int n,vector &x,vector &y) { if(n<=0) return(false); //--- prepare arrays x.Resize(n); y.Resize(n); //--- for(int i=0; i<n; i++) { x[i]=(double)1.0*i; y[i]=(double)(4*x[i] + 10*sin(x[i]*0.5)); } //--- return(true); } //+------------------------------------------------------------------+ //| TestRegressionModel | //+------------------------------------------------------------------+ bool TestRegressionModel(const string model_name,const int model_type) { //--- long model=INVALID_HANDLE; ulong flags=ONNX_DEFAULT; if(model_type==TestFloatModel) { PrintFormat("\nTesting ONNX float: %s (%s)",model_name,ONNXFilenameFloat); model=OnnxCreateFromBuffer(ExtModelFloat,flags); } else if(model_type==TestDoubleModel) { PrintFormat("\nTesting ONNX double: %s (%s)",model_name,ONNXFilenameDouble); model=OnnxCreateFromBuffer(ExtModelDouble,flags); } else { PrintFormat("Model type is not incorrect."); return(false); } //--- check if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d",model_name,GetLastError()); return(false); } //--- vector x_values= {}; vector y_true= {}; vector y_predicted= {}; //--- int n=100; GenerateData(n,x_values,y_true); //--- bool run_result=false; if(model_type==TestFloatModel) { run_result=RunModelFloat(model,x_values,y_predicted); } else if(model_type==TestDoubleModel) { run_result=RunModelDouble(model,x_values,y_predicted); } //--- if(run_result) { PrintFormat("MQL5: R-Squared (Coefficient of determination): %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_R2)); PrintFormat("MQL5: Mean Absolute Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MAE)); PrintFormat("MQL5: Mean Squared Error: %.16f",y_predicted.RegressionMetric(y_true,REGRESSION_MSE)); } else PrintFormat("Error %d",GetLastError()); //--- release model OnnxRelease(model); //--- return(true); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { //--- test ONNX regression model for float TestRegressionModel(ModelName,TestFloatModel); //--- test ONNX regression model for double TestRegressionModel(ModelName,TestDoubleModel); //--- return(0); } //+------------------------------------------------------------------+

Sortie :

ARDRegression (EURUSD,H1) Testing ONNX float: ARDRegression (ard_regression_float.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382627587808 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475682837447049 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781600542671896 ARDRegression (EURUSD,H1) ARDRegression (EURUSD,H1) Testing ONNX double: ARDRegression (ard_regression_double.onnx) ARDRegression (EURUSD,H1) MQL5: R-Squared (Coefficient of determination): 0.9962382628120845 ARDRegression (EURUSD,H1) MQL5: Mean Absolute Error: 6.3475680128537597 ARDRegression (EURUSD,H1) MQL5: Mean Squared Error: 49.7781593489128795

Comparaison avec le modèle double original en Python :

Testing ONNX float: ARDRegression (ard_regression_float.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475682837447049 Testing ONNX double: ARDRegression (ard_regression_double.onnx) Python Mean Absolute Error: 6.347568012853758 MQL5: Mean Absolute Error: 6.3475680128537597

Précision de la MAE ONNX float : 6 décimales, Précision de la MAE ONNX double : 14 décimales.

2.1.1.3. Les représentations ONNX des modèles ard_regression_float.onnx et ard_regression_double.onnx

Netron (version web) est un outil de visualisation des modèles et d'analyse des graphes de calcul, qui peut être utilisé pour les modèles au format ONNX (Open Neural Network Exchange).

Netron présente les graphes des modèles et leur architecture sous une forme claire et interactive, permettant l'exploration de la structure et des paramètres des modèles d'apprentissage profond, y compris ceux créés à l'aide d'ONNX.

Les principales caractéristiques de Netron sont les suivantes

- Visualisation de graphiques : Netron affiche l'architecture du modèle sous forme de graphique, ce qui vous permet de voir les couches, les opérations et les connexions entre elles. Vous pouvez facilement comprendre la structure et le flux de données dans le modèle.

- Exploration interactive : Vous pouvez sélectionner des nœuds dans le graphique pour obtenir des informations supplémentaires sur chaque opérateur et sur ses paramètres.

- Prise en charge de différents formats : Netron prend en charge une variété de formats de modèles d'apprentissage profond, notamment ONNX, TensorFlow, PyTorch, CoreML, et d'autres.

- Capacité d'analyse des paramètres : Vous pouvez visualiser les paramètres et les poids du modèle, ce qui est utile pour comprendre les valeurs utilisées dans les différentes parties du modèle.

Netron est pratique pour les développeurs et les chercheurs dans le domaine de l'apprentissage automatique et de l'apprentissage profond, car il simplifie la visualisation et l'analyse des modèles, aidant à la compréhension et au débogage des réseaux neuronaux complexes.

Cet outil permet d'inspecter rapidement les modèles, d'explorer leur structure et leurs paramètres, ce qui facilite le travail avec les réseaux neuronaux profonds.

Pour plus de détails sur Netron, consultez les articles : Visualisez votre réseau neuronal avec Netron et Visualize Keras Neural Networks with Netron.

Vidéo sur Netron :

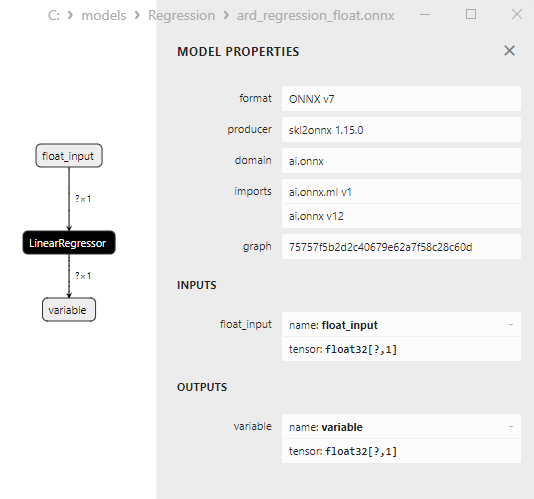

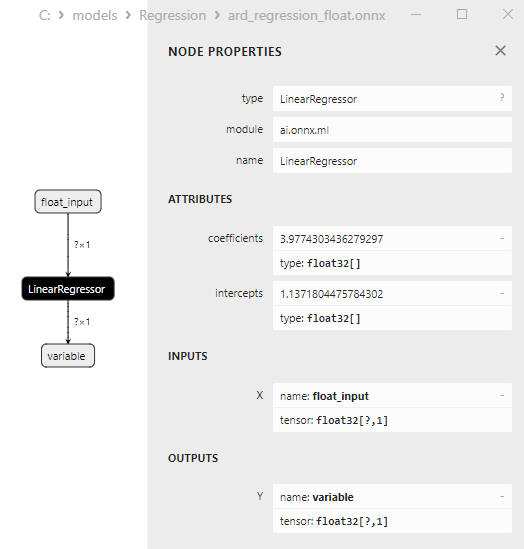

Le modèle ard_regression_float.onnx est présenté à la figure 6 :

Fig. 6. Représentation du modèle ONNX ard_regression_float.onnx dans Netron

L'opérateur ONNX ai.onnx.ml LinearRegressor() fait partie de la norme ONNX, qui décrit un modèle pour les tâches de régression. Cet opérateur est utilisé pour la régression, il consiste à prédire des valeurs numériques (continues) sur la base de caractéristiques d'entrée.

Il prend en entrée les paramètres du modèle, tels que les poids et les biais, ainsi que les caractéristiques d'entrée, et exécute une régression linéaire. La régression linéaire estime les paramètres (poids) pour chaque caractéristique d'entrée et effectue ensuite une combinaison linéaire de ces caractéristiques avec les poids pour générer une prédiction.

Cet opérateur effectue les étapes suivantes :

- Il prend les poids et les biais du modèle, ainsi que les caractéristiques d'entrée.

- Pour chaque exemple de données d'entrée, il effectue une combinaison linéaire des poids avec les caractéristiques correspondantes.

- Il ajoute le biais à la valeur obtenue.

Le résultat est la prédiction de la variable cible dans la tâche de régression.

Les paramètres de LinearRegressor() sont présentés à la figure 7.

Fig. 7. Les propriétés de l'opérateur LinearRegressor() du modèle ard_regression_float.onnx dans Netron

Fig. 8. Représentation ONNX du modèle ard_regression_double.onnx dans Netron

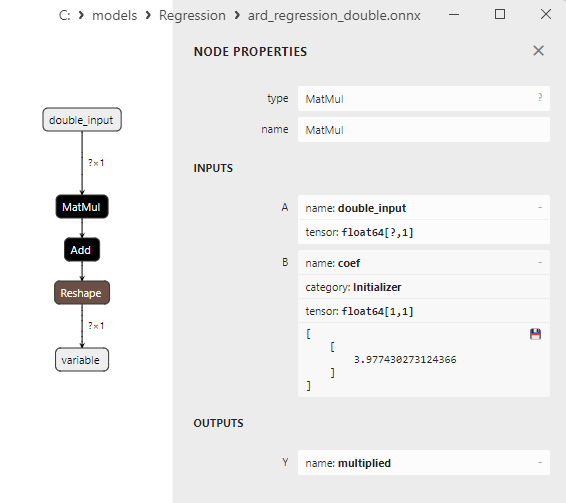

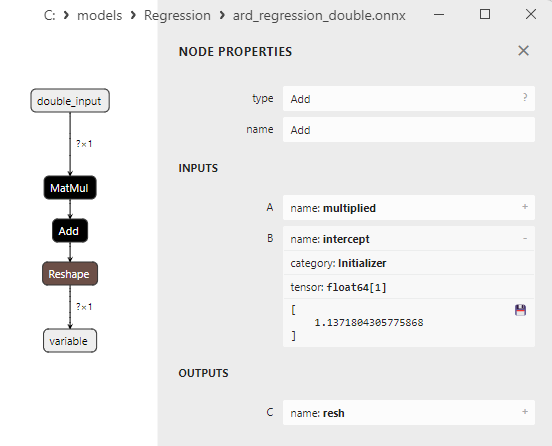

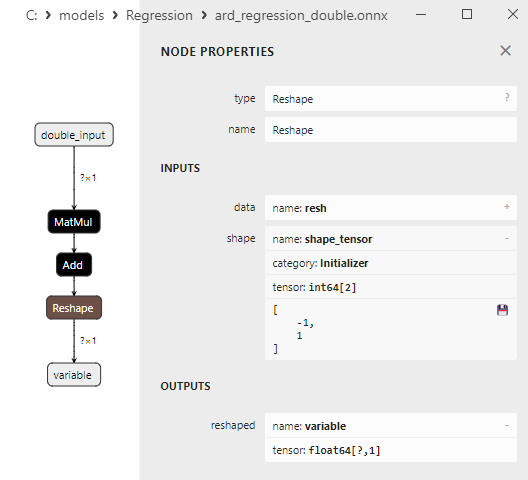

Les paramètres des opérateurs ONNX MatMul(), Add() et Reshape() sont présentés à la figure 9-11.

Fig. 9. Propriétés de l'opérateur MatMul dans le modèle ard_regression_double.onnx de Netron

L’opérateur ONNX MatMul (multiplication matricielle) effectue la multiplication de deux matrices.

Il prend deux entrées : deux matrices et renvoie leur produit matriciel.

Si vous avez deux matrices, A et B, le résultat de Matmul(A, B) est une matrice C, où chaque élément C[i][j] est calculé comme la somme des produits des éléments de la ligne i de la matrice A par les éléments de la colonne j de la matrice B.

Fig. 10. Propriétés de l'opérateur Add dans le modèle ard_regression_double.onnx de Netron

L’opérateur ONNX Add() effectue l'addition par élément de deux tenseurs ou tableaux de même forme.

Il prend deux entrées et renvoie le résultat, où chaque élément du tenseur résultant est égal à la somme des éléments correspondants des tenseurs d'entrée.

Fig. 11. Propriétés de l'opérateur Reshape dans le modèle ard_regression_double.onnx de Netron

L’opérateur ONNX Reshape(-1,1) est utilisé pour modifier la forme (ou la dimension) des données d'entrée. Dans cet opérateur, la valeur -1 pour la dimension indique que la taille de cette dimension doit être automatiquement calculée sur la base des autres dimensions afin de garantir la cohérence des données.

La valeur 1 dans la deuxième dimension indique qu'après la transformation de la forme, chaque élément aura une seule sous-dimension.

2.1.2. sklearn.linear_model.BayesianRidge

BayesianRidge est une méthode de régression qui utilise une approche bayésienne pour estimer les paramètres du modèle. Cette méthode permet de modéliser la distribution préalable des paramètres et de la mettre à jour en fonction des données pour obtenir la distribution postérieure des paramètres.

BayesianRidge est une méthode de régression bayésienne conçue pour prédire la variable dépendante en fonction d'une ou plusieurs variables indépendantes.

Principe de fonctionnement de BayesianRidge :

- Distribution préalable des paramètres : Elle commence par la définition de la distribution préalable des paramètres du modèle. Cette distribution représente les connaissances préalables ou les hypothèses sur les paramètres du modèle avant l'examen des données. Dans le cas de BayesianRidge, des distributions préalables de forme gaussienne sont utilisées.

- Mise à jour de la distribution des paramètres : Une fois que la distribution préalable des paramètres est définie, elle est mise à jour en fonction des données. Pour ce faire, on utilise la théorie bayésienne, dans laquelle la distribution postérieure des paramètres est calculée à partir des données. Un aspect essentiel est l'estimation des hyper-paramètres, qui influencent la forme de la distribution postérieure.

- Prédiction : Après avoir estimé la distribution postérieure des paramètres, des prédictions peuvent être faites pour de nouvelles observations. Il en résulte une distribution des prévisions plutôt qu'une valeur ponctuelle unique, ce qui permet de prendre en compte l'incertitude des prévisions.

Avantages de BayesianRidge :

- Prise en compte de l'incertitude : BayesianRidge tient compte de l'incertitude des paramètres du modèle et des prévisions. Au lieu de prédictions ponctuelles, des intervalles de confiance sont fournis.

- Régularisation : La méthode de régression bayésienne peut être utile pour la régularisation du modèle, en aidant à prévenir l'ajustement excessif.

- Sélection automatique des caractéristiques : BayesianRidge peut déterminer automatiquement l'importance des caractéristiques en réduisant les poids des caractéristiques non significatives.

Limites de BayesianRidge :

- Complexité de calcul : La méthode nécessite des ressources de calcul pour estimer les paramètres et calculer la distribution postérieure.

- Niveau d'abstraction élevé : Une connaissance plus approfondie des statistiques bayésiennes peut être nécessaire pour comprendre et utiliser BayesianRidge.

- Ce n'est pas toujours le meilleur choix : La méthode BayesianRidge peut ne pas être la plus appropriée pour certaines tâches de régression, en particulier lorsqu'il s'agit de données limitées.

BayesianRidge est utile dans les tâches de régression où l'incertitude des paramètres et des prédictions est importante et dans les cas où la régularisation du modèle est nécessaire.

2.1.2.1. Code pour créer le modèle BayesianRidge et l'exporter vers ONNX pour float et double

Ce code crée le modèle sklearn.linear_model.BayesianRidge, l'entraîne sur des données synthétiques, enregistre le modèle au format ONNX et effectue des prédictions en utilisant des données d'entrée float et double. Il évalue également la précision du modèle original et des modèles exportés vers ONNX.

# Le code démontre le processus d'entraînement du modèle BayesianRidge, son export au format ONNX (à la fois float et double), et la réalisation de prédictions à l'aide des modèles ONNX.

# Copyright 2023, MetaQuotes Ltd.

# https://www.mql5.com

# fonction de comparaison des décimales correspondantes

def compare_decimal_places(value1, value2):

# convertit les deux valeurs en chaînes de caractères

str_value1 = str(value1)

str_value2 = str(value2)

# trouve les positions des points décimaux dans les chaînes de caractères

dot_position1 = str_value1.find(".")

dot_position2 = str_value2.find(".")

# si l'une des valeurs n'a pas de point décimal, retourne 0

if dot_position1 == -1 or dot_position2 == -1:

return 0

# calcule le nombre de décimales

decimal_places1 = len(str_value1) - dot_position1 - 1

decimal_places2 = len(str_value2) - dot_position2 - 1

# trouve le minimum du nombre de décimales

min_decimal_places = min(decimal_places1, decimal_places2)

# initialise un compteur pour les décimales correspondantes

matching_count = 0

# compare les caractères après la virgule

for i in range(1, min_decimal_places + 1):

if str_value1[dot_position1 + i] == str_value2[dot_position2 + i]:

matching_count += 1

else:

break

return matching_count

# importe les bibliothèques nécessaires

import numpy as np

import matplotlib.pyplot as plt

from sklearn.linear_model import BayesianRidge

from sklearn.metrics import r2_score,mean_absolute_error,mean_squared_error

import onnx

import onnxruntime as ort

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

from skl2onnx.common.data_types import DoubleTensorType

from sys import argv

# définit le chemin d'accès pour l'enregistrement du modèle

data_path = argv[0]

last_index = data_path.rfind("\\") + 1

data_path = data_path[0:last_index]

# génère des données synthétiques pour la régression

X = np.arange(0,100,1).reshape(-1,1)

y = 4*X + 10*np.sin(X*0.5)

model_name = "BayesianRidge"

onnx_model_filename = data_path + "bayesian_ridge"

# crée un modèle de régression bayésienne de type Ridge

regression_model = BayesianRidge()

# ajuste le modèle aux données

regression_model.fit(X, y.ravel())

# prédit les valeurs pour l'ensemble du jeu de données

y_pred = regression_model.predict(X)

# évalue la performance du modèle

r2 = r2_score(y, y_pred)

mse = mean_squared_error(y, y_pred)

mae = mean_absolute_error(y, y_pred)

print("\n"+model_name+" Original model (double)")

print("R-squared (Coefficient of determination):", r2)

print("Mean Absolute Error:", mae)

print("Mean Squared Error:", mse)

# convertit en modèle ONNX (float)

# définit le type de données d'entrée comme FloatTensorType

initial_type_float = [('float_input', FloatTensorType([None, X.shape[1]]))]

# exporte le modèle au format ONNX

onnx_model_float = convert_sklearn(regression_model, initial_types=initial_type_float, target_opset=12)

# enregistre le modèle dans un fichier

onnx_filename=onnx_model_filename+"_float.onnx"

onnx.save_model(onnx_model_float, onnx_filename)

print("\n"+model_name+" ONNX model (float)")

# affiche le chemin du modèle

print(f"ONNX model saved to {onnx_filename}")

# charge le modèle ONNX et fait des prédictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# affiche les informations sur les tenseurs d'entrée dans ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# affiche les informations sur les tenseurs de sortie dans ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# définit le type de données d'entrée comme FloatTensorType

initial_type_float = X.astype(np.float32)

# prédit les valeurs pour l'ensemble du jeu de données en utilisant ONNX

y_pred_onnx_float = onnx_session.run([output_name], {input_name: initial_type_float})[0]

# calcule et affiche les erreurs pour les modèles originaux et ONNX

r2_onnx_float = r2_score(y, y_pred_onnx_float)

mse_onnx_float = mean_squared_error(y, y_pred_onnx_float)

mae_onnx_float = mean_absolute_error(y, y_pred_onnx_float)

print("R-carré (Coefficient de Détermination)", r2_onnx_float)

print("Erreur Absolue Moyenne :", mae_onnx_float)

print("Erreur Quadratique Moyenne :", mse_onnx_float)

print("R^2 matching decimal places: ", compare_decimal_places(r2, r2_onnx_float))

print("MAE matching decimal places : ", compare_decimal_places(mae, mae_onnx_float))

print("MSE matching decimal places : ", compare_decimal_places(mse, mse_onnx_float))

print("Précision du modèle ONNX float : ", compare_decimal_places(mae, mae_onnx_float))

# définit la taille de la figure

plt.figure(figsize=(8,5))

# trace les données originales et les données de régression

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparaison (avec ONNX float)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_float.png')

# convertit en modèle ONNX (double)

# définit le type de données d'entrée comme DoubleTensorType

initial_type_double = [('double_input', DoubleTensorType([None, X.shape[1]]))]

# exporte le modèle au format ONNX

onnx_model_double = convert_sklearn(regression_model, initial_types=initial_type_double, target_opset=12)

# enregistre le modèle dans un fichier

onnx_filename=onnx_model_filename+"_double.onnx"

onnx.save_model(onnx_model_double, onnx_filename)

print("\n"+model_name+" Modèle ONNX (double)")

# affiche le chemin du modèle

print(f"ONNX model saved to {onnx_filename}")

# charge le modèle ONNX et fait des prédictions

onnx_session = ort.InferenceSession(onnx_filename)

input_name = onnx_session.get_inputs()[0].name

output_name = onnx_session.get_outputs()[0].name

# affiche les informations sur les tenseurs d'entrée dans ONNX

print("Information about input tensors in ONNX:")

for i, input_tensor in enumerate(onnx_session.get_inputs()):

print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}")

# affiche les informations sur les tenseurs de sortie dans ONNX

print("Information about output tensors in ONNX:")

for i, output_tensor in enumerate(onnx_session.get_outputs()):

print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}")

# définit le type de données d'entrée comme DoubleTensorType

initial_type_double = X.astype(np.float64)

# prédit les valeurs pour l'ensemble du jeu de données en utilisant ONNX

y_pred_onnx_double = onnx_session.run([output_name], {input_name: initial_type_double})[0]

# calcule et affiche les erreurs pour les modèles originaux et ONNX

r2_onnx_double = r2_score(y, y_pred_onnx_double)

mse_onnx_double = mean_squared_error(y, y_pred_onnx_double)

mae_onnx_double = mean_absolute_error(y, y_pred_onnx_double)

print("R-carré (Coefficient de Détermination)", r2_onnx_double)

print("Erreur Absolue Moyenne :", mae_onnx_double)

print("Erreur Quadratique Moyenne :", mse_onnx_double)

print("R^2 matching decimal places : ", compare_decimal_places(r2, r2_onnx_double))

print("MAE matching decimal places : ", compare_decimal_places(mae, mae_onnx_double))

print("MSE matching decimal places : ", compare_decimal_places(mse, mse_onnx_double))

print("Précision du modèle ONNX double : ", compare_decimal_places(mae, mae_onnx_float))

# définit la taille de la figure

plt.figure(figsize=(8,5))

# trace les données originales et la ligne de régression

plt.scatter(X, y, label='Original Data', marker='o')

plt.scatter(X, y_pred, color='blue', label='Scikit-Learn '+model_name+' Output', marker='o')

plt.scatter(X, y_pred_onnx_float, color='red', label='ONNX '+model_name+' Output', marker='o', linestyle='--')

plt.xlabel('X')

plt.ylabel('y')

plt.legend()

plt.title(model_name+' Comparaison (avec ONNX double)')

#plt.show()

plt.savefig(data_path + model_name+'_plot_double.png')

Sortie :

Python BayesianRidge Original model (double) Python R-squared (Coefficient of determination): 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python Python BayesianRidge ONNX model (float) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_float.onnx Python Information about input tensors in ONNX: Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(float), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382627587808 Python Mean Absolute Error: 6.347568283744705 Python Mean Squared Error: 49.778160054267204 Python R^2 matching decimal places: 9 Python MAE matching decimal places: 6 Python MSE matching decimal places: 4 Python float ONNX model precision: 6 Python Python BayesianRidge ONNX model (double) Python ONNX model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\Regression\bayesian_ridge_double.onnx Python Information about input tensors in ONNX: Python 1. Name: double_input, Data Type: tensor(double), Shape: [None, 1] Python Information about output tensors in ONNX: Python 1. Name: variable, Data Type: tensor(double), Shape: [None, 1] Python R-squared (Coefficient of determination) 0.9962382628120845 Python Mean Absolute Error: 6.347568012853758 Python Mean Squared Error: 49.77815934891288 Python R^2 matching decimal places: 16 Python MAE matching decimal places: 15 Python MSE matching decimal places: 14 Python double ONNX model precision: 15

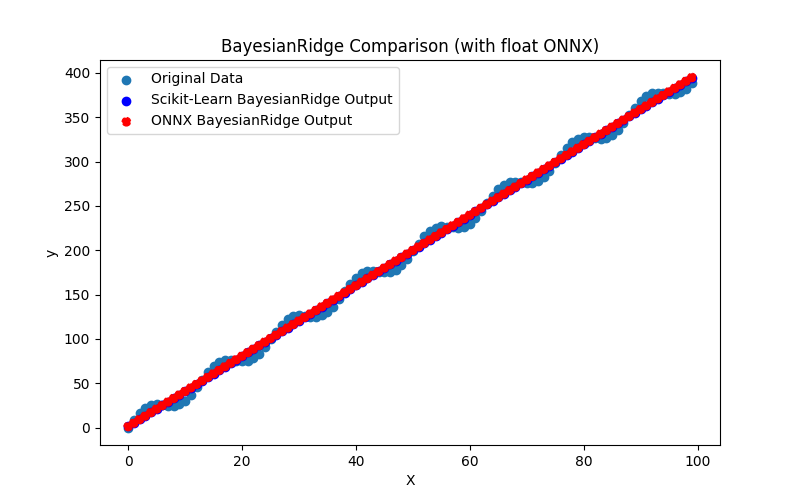

Fig. 12. Résultats de BayesianRidge.py (ONNX float)

2.1.2.2. Code MQL5 pour l'exécution des modèles ONNX

Ce code exécute les modèles ONNX bayesian_ridge_float.onnx et bayesian_ridge_double.onnx sauvegardés et démontre l'utilisation des métriques de régression dans MQL5.