Машинное обучение в трейдинге: теория, модели, практика и алготорговля - страница 858

Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

я не пользуюсь чужими алгоритмами.

Понятно, дух Кулибина это конечно хорошо, но самое интересное и нужное уже придумано, и лежит как на ладони. Яб не отказывался от результатов десятилетий исследований по всему миру.

У меня тоже такие есть, есть также те, которые зарабатывают но не всегда, а я хочу что бы всегда (или почти всегда). И только тогда смогу раздавать советы.

В копилку! Буду вставлять каждый раз когда ты начнёшь раздавать советы там где не разбираешься :)

Понятно, дух Кулибина это конечно хорошо, но самое интересное и нужное уже придумано, и лежит как на ладони. Яб не отказывался от результатов десятилетий исследований по всему миру.

отчет? вы меня доконаете тут со своими пустыми утверждениями

В копилку! Буду вставлять каждый раз когда ты начнёшь раздавать советы там где не разбираешься :)

я уже понял что бесполезно просить дохлую лошадь что-то предъявить внятное, проще слезть и не реагировать

Через 2 минуты работы с матрицей 13х6400 (раз в 10 больше примера)

Происходит такое

Ошибка: не могу разместить вектор размером 3.2 Gb

Причем пытается занять 12-13 Гб, а всего у меня 16 Гб

R обычно память кусочками понемногу занимает. Он уже занял 12-13, хочет ещё 3, и неизвестно сколько потом ещё понадобится.

Уменьшил матрицу - даже 13х500 не смог посчитать... Видимо рыночные данные без закономерностей сводят его с ума)). Это вам не по глюкозе диабет определять.

Кто-то с рыночными данными пробовал? Есть успехи?

Наконец то... с 13х100 справился: (но по 100 строкам конечно глупо что-то отсеивать). Что-то вход №2 самым важным оказался, по предыдущим пакетам он в конце был. Видимо это из за того, что оценка по 100 строкам, а не по 6400.

Ordered variables (decreasing importance):

2 5 10 12 6 4 7 8 9 1 11

Scores 0.24 0.025 0.019 -0.048 -0.05 -0.055 -0.057 -0.05 -0.063 -0.067 -0.072

3

Scores NA

---

Matrix of scores:

2 5 10 12 6 4 7 8 9 1 11

2 0.24

5 0.128 0.025

10 0.186 -0.002 0.019

12 0.015 -0.043 -0.051 -0.048

6 0.086 -0.053 -0.011 -0.068 -0.05

4 0.066 -0.029 -0.073 -0.054 -0.065 -0.055

7 0.134 -0.088 -0.101 -0.188 -0.121 -0.099 -0.057

8 0.12 -0.202 -0.069 -0.1 -0.068 -0.089 -0.061 -0.05

9 0.092 -0.004 -0.138 -0.097 -0.088 -0.069 -0.112 -0.088 -0.063

1 0.086 -0.06 -0.088 -0.107 -0.083 -0.084 -0.066 -0.081 -0.076 -0.067

11 0.095 -0.017 -0.183 -0.115 -0.083 -0.078 -0.066 -0.086 -0.066 -0.082 -0.072

3 0.059 -0.132 -0.102 -0.146 -0.114 -0.126 -0.109 -0.113 -0.131 -0.117 -0.135

Привет!

А робот нейро с ИИ готов?

Дайте на пробу. )))

а между тем я узнал как сделать тиковый бот - чтобы заработал также как на тестере )))

An Introduction to Greta

I was surprised by greta. I had assumed that the tensorflow and reticulate packages would eventually enable R developers to look beyond deep learning applications and exploit the TensorFlow platform to create all manner of production-grade statistical applications. But I wasn’t thinking Bayesian. After all, Stan is probably everything a Bayesian modeler could want. Stan is a powerful, production-level probability distribution modeling engine with a slick R interface, deep documentation, and a dedicated development team.

But greta lets users write TensorFlow-based Bayesian models directly in R! What could be more charming? greta removes the barrier of learning an intermediate modeling language while still promising to deliver high-performance MCMC models that run anywhere TensorFlow can go.

In this post, I’ll introduce you to greta with a simple model used by Richard McElreath in section 8.3 of his iconoclastic book: Statistical Rethinking: A Bayesian Course with Examples in R and Stan. This model seeks to explain the log of a country’s GDP based on a measure of terrain ruggedness while controlling for whether or not the country is in Africa. I am going to use it just to illustrate MCMC sampling with greta. The extended example in McElreath’s book, however, is a meditation on the subtleties of modeling interactions, and is well worth studying.

First, we load the required packages and fetch the data. DiagrammeR is for plotting the TensorFlow flow diagram of the model, and bayesplot is used to plot trace diagrams of the Markov chains. The rugged data set which provides 52 variables for 234 is fairly interesting, but we will use a trimmed-down data set with only 170 counties and three variables.

Далее приведен код по использованию.

Привет изобретателям велосипедов!

)))

For the first search, it is advised to use either “peng” (faster) or “esteves”

(more reliable but much slower for large datasets) and, in case the number of

variables is large (>100), restrict the “forward” search to “n.var = 100.” The

progress bar will give you an idea of the remaining run time.

library(varrank)

data(nassCDS, package = "DAAG")

nassCDS.varrank <- varrank(data.df = nassCDS,

method = "peng",

variable.important = "dead",

discretization.method = "sturges",

algorithm = "forward",

scheme = "mid",

verbose = FALSE)

summary(nassCDS.varrank)

plot(nassCDS.varrank, notecex = 0.5)

Вот этот конкретный алгоритм, он отбирает предикторы хорошо или плохо?

Вообще, в отборе предикторов, что такое хорошо и что такое плохо?

На поверхности лежит увязать отбор предикторов с результативностью какой-либо модели.

По мне это второй шаг.

На первом шаге ВСЕГДА надо решать проблему переобученности модели, ситуации, когда поведение модели в будущем не соответствует ее поведению в прошлом. Если у нас нет каких-либо соображений на эту тему, то все это игра в цифирь.

Если вернуться к Вашему посту.

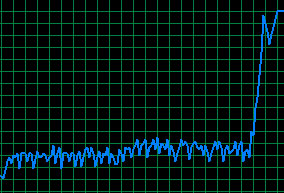

Я считаю, что поведение модели в будущем будет мало отличаться от поведения на исторических данных если ПРЕДСКАЗАТЕЛЬНАЯ СПОСОБНОСТЬ предикторов при движении окна будет мало меняться.

Вот ранги, которые вычисляет пакет, они будут меняться на некотором наборе предикторов или нет? Понятно, что результат может быть разный для разных наборов предикторов, тем не менее, если бы (как я выше) здесь выкладывались подобные посты...