市場のエチケット、あるいは地雷原でのマナー - ページ 57 1...505152535455565758596061626364...104 新しいコメント paralocus 2009.06.09 19:36 #561 paralocus >> : ここでまた、市場のOTOについて。事実は、バーの真ん中は、その開口部の直後に来るので、もちろん、遅延があるということですが、バーが既に形成されているとき、我々はこの黄金の平均が来ているバーの内部正確にときに気にしないので、その一方で、それは、存在しない。真ん中から始まって、真ん中で終わるようなバーを見たことがあります。あなたのニュートロンとの議論の本質は、一言も価値がない。 それは、バーがあなたにとってBARであるのに対し、商が時間によって量子化されていないため、ニュートロンにとってバーでないからだ。 あなたには異なる「参照枠」がある、ただそれだけのことです。 Khristian Piligrim 2009.06.09 19:43 #562 Neutron писал(а)>> いや、古くないか...。>>あ、スーパースターだ! まだバカにしてるのか、お前?老後は本当に楽しくない。 Сергей 2009.06.09 19:51 #563 paralocus >> : ここでまた、市場のOTOについて。事実は、バーの真ん中は、その開口部の直後に来るので、もちろん、遅延があるということですが、一方では、バーが既に形成されているとき、誰もこのバーの内側の黄金の平均が来たときに気にしないので、それは、存在しない。真ん中に始まり、真ん中に終わるバーを見たことがあります。あなたのニュートロンとの議論の本質は、一言も価値がない。 それは、バーがあなたにとってBARであるのに対し、商が時間によって量子化されていないため、ニュートロンにとってバーでないからだ。 あなたには異なる「参照枠」がある、ただそれだけのことです。 議論はいろいろありますが、特にこの点です。セルゲイさんは「説得力」のある主張をしてくれました。しかし、どうやら私は簡単なことが説明できないようです。遅れは一切ありません。定義上、ありえないんです。これらの数値の根拠となるデータは重複していない。位相がなく、数字が完全に等しいんです。 補足:正弦波上の2点を取り出して、0.1刻みでxのところと10.0刻みでxのところに遅れがあると言っているようなものです。 それでいいんです。私たちは自分の意見を貫きますから...。 TheXpert 2009.06.09 20:06 #564 gpwr >> : 試してみてください。 だから、頑張ってください :)テイラー級数分解は、0次でない多項式は値の範囲が限定されないので、高調波への分解よりさらに悪い。 さらに、あなたの言葉から、多項式ではなく、普通のSMAウェービングマシンであることがわかりました。 paralocus 2009.06.09 20:10 #565 gpwr >> : よし、それならこれがアイデアそのものです。深く考えれば、2小節、4小節、11小節を隣の小節と比較して過小評価する市場勢力はないだろう。つまり、隣り合ったバーは非常に近い値を示すと考えるべきだろう。11時間前に起きたことも、12時間前に起きたことも、同じように重要なのです。そのため、あるバーから隣のバーへの重量の移行がスムーズに行われることが期待されます。そのため、バー番号(ディレイ)の関数として重量を記述する曲線は滑らかであるべきです。もしこれが本当なら、この曲線w[n]はテイラー級数、すなわち多項式で近似することができる。例えば、3次や4次の多項式を重みに当てはめることができます。次に私のアイデアの前提は次の通りです。ウェイト自体の最適化(16個ある)の代わりに、多項式係数の最適化(a0+a1*n+a2*n^2+a3*n^3、a0・・・a3を最適化すると、合計4つのパラメータが得られる)、およびn番目のバーに対してa0+a1*n+a2*n^2+a3*n^3式を使用します。ずっと計算が少ない。試してみてください。 しかし、子供の頃、玄関で男の子から「基礎に間違いがあると、科学的な魅力があろうとも、それ以降の構造は無視される」と聞いたことがあります。ある(市場の)状態から別の状態への移行に必要な機能としての滑らかさの考え方に間違いがあるのです。嗚呼。しかし、そのようなことはありません。市場は、AからZへ、中間的な敬意を払うことなく移行しています。もしそうでなければ、それはフォーラムではなく、ソロスの会合になってしまいます。 気にしないでください...新しいアイデア(市場コンセプト)を出しますよ、今までのものより確実に実りがありますよ。 一見すると、とてもシンプルです。 規則性は、ランダム性が存在するための方法です。その逆はありません。 paralocus 2009.06.09 20:29 #566 to 中性子 このオペレーティングシステムでは製品は 動作しません 石鹸を買いに行って... Сергей 2009.06.09 20:30 #567 HideYourRichess >> : ちなみに私もそんな風に予測することができます。ARが無くても。:)しかし、それは何も与えてくれなかった。私は80%の精度で価格が「どこに」行くかを当てることができますが、利益はありません。悲しいことです。;) シリーズ(H+L)/2。簡略化のため、Muと表記する。この値を正確に予測することはできないが、差分Mu(n)-Mu(n+1)の符号を正確に予測することができると仮定する。 例えば、現在のバーでは、次のデルタMu(n)-Mu(n+1)が正値になることが分かっています。そして、新しい増分を統計的に推定し、そこからMu(n+1)に行く必要があります。このレベルにバースプレッドのRMS推定値を追加してみよう。貿易レベルを取得し、芸術的な表現を高めるために絵も描きました。 これらのレベルの発生頻度が大きく、スプレッドに見合ったものであれば、成功する可能性があります。このデルタを本当に80%で予測しているのですか? 追記:個人的にはそこまで値段に近い仕事はしていません。チャンスはあまりない、というか、まったくない。ただ、正確な予測ではなく、方向性のみの予測も可能なのではと思いつきました。私はこのような「技術」を使って自分なりの予測をしました:「この絵を見たことがありますか?」 少なくとも15分足で24時間、ここに実際の予測の例があります、私は次のテストを終了します - もっとあるでしょう(ちょうどデバッグ、すべてのアストロレーブがまだ構築されていません)。 「リアルタイム予測システムのテスト paralocus 2009.06.09 21:20 #568 に、gpwr はい、私はあなたの最後の投稿をどうにかして見逃していました。ここで興味深い質問があります。重量が(原理的に)時間から自身のインデックスの関数になり得ると考えるのはなぜでしょうか?重さのグラフを見るという発想の原点がわかった気がします。微妙な点があります。2つの異なる実験(同じ学習ベクトルでの学習結果)において、これらのグラフは(視覚的、位相的に)大きく異なるかもしれませんが、グリッドの結果は(統計的に)実質的に同じです。もし、提案した方法でネットワークを学習 するための満足な関数さえ見つけることができれば、学習結果(同じベクトルに対する2回の連続した実験)は完全に同一になる--つまり、ニューラルネットワークではなく、完全に決定論的な何かになる。すでに眠っているニュートロンが 言うように、このようなネットワークは、1つのベクトルについては正確に学習されるが、詩を詠むことはできないだろう。そのため、取引には使えません。連続する各カウントは、前のものと(そして新鮮なものと)類似しておらず、通常のグリッドはそれさえもカウントしない。学習したあるイメージにほぼ似て いる。近似的に、正確に 置き換えるなら、このようなネットワークのエントロピーはゼロに等しくなる(すなわち、左への一歩、右への一歩-銃殺刑、その場でのホップ-挑発)。 多項式の係数を1つ変えるのに、1つの重みを修正するのと全く同じリソースが必要ですし、(各重みに対して)係数がn個 あるのですから、得られるものは何でしょうか。 Hide 2009.06.10 06:43 #569 grasn >> : シリーズ(H+L)/2。簡略化のため、Muと表記する。この値を正確に予測することはできないが、差分Mu(n)-Mu(n+1)の符号は正確に予測できるとする。 例えば、現在のバーでは、次のデルタMu(n)-Mu(n+1)が正であることが分かっています。そして、新しい増分を統計的に推定し、そこからMu(n+1)に行く必要があります。このレベルにバースプレッドのRMS推定値を追加してみよう。貿易レベルを取得し、芸術的な表現を高めるために絵も描きました。 これらのレベルの発生頻度が大きく、スプレッドに見合ったものであれば、成功する可能性があります。このデルタを本当に80%も見込んでいるのですか? まさに8割を実証するアルゴリズムに驚き。エラーを探しています。見た目はとてもシンプルです。そのようなことはありません。 Neutron 2009.06.10 07:01 #570 grasn писал(а)>> а-а-а-а-а-а-а-а-а-а-а-!!!!!月の位置を確認する必要がある、それが理由かもしれません。言葉が足りない」という表現がよくわかりました。そこが遅れているのか? あなたのために特別に作りました。 FZは常にそこにあり、コチラの鋭い動きに視覚的にはっきりと現れているのがよくわかります。 遅延が常に発生していることがわかりますし、コチラのシャープな動きにも視覚的にわかりやすいですね。そして、次に超ド級の素晴らしいアイデアを思いついたとき、その実現には1つか2つの研究機関とPCのクラスタが必要だと考えたとき、ちょっと考えてみてください - たぶん、あなたはただ知らないか、理解していないのだと思います。結局のところ、これは「画期的な発見」よりも、目の前のすべてが踏みにじられた領域で、可能性が高いということなのです。 gpwr さんが書き込みました >>1 私は、すべてのスケールを短く記述する方法、この場合は多項式を提案します。ここでは、あなたの例でお見せします。ある入力ベクトルに対してネットワークを学習させ、すべての重みw[n](n=0...15)の値を得たとする。 パラローカス さんの考えは、NSに割り当てられた市場プロセスの定常性という未確認の仮説に基づいていることを、極めて的確に指摘されていると思うのです。これが確認された場合のみ、NS重みの定常性が期待でき、結果としてネットワーク学習なしで重みを求める外挿手法が適用できる。しかし、もしそうであれば、新しいBPデータごとにグリッドを再トレーニングする必要はないはずです。また,数値実験を行い,学習済みグリッドの重みがサンプルごとにどのような挙動を示すかを常に確認することができます.見てみようか? そのために、1本ずつずらしながら500回の実験を行い、次のバーを予測することを学習します。私たちは、すべてのバーでネットを新たに教えます。500回分の重みのベクトルを1つのグラフに表示するのを避けるため、得られた値を重みごとに平均化し、各重みに対応する分散(値のばらつき)を1/e水準に沿ってプロットしたハンドルの形で表示します。 横軸はNS入力の番号、縦軸はこの入力に対する重みの平均値を示し、完全に学習されたネットワークについてである。このように,時間マーカー(左図)については,重みの値が統計的にばらつく領域(ひげの範囲)にあり,定常性の仮説を真っ向から否定するものであった。統計的に有意なのはNSの最初の入力(グラフではゼロサンプル)であり、これは小さなTFにおけるkotier(隣接するサンプル間の最初の差の系列における負の相関係数)の既知の反存性の原因である。 したがって、NSウエイトを多項式で近似する手法を開発する必要があるという話は時期尚早である。 1...505152535455565758596061626364...104 新しいコメント 取引の機会を逃しています。 無料取引アプリ 8千を超えるシグナルをコピー 金融ニュースで金融マーケットを探索 新規登録 ログイン スペースを含まないラテン文字 このメールにパスワードが送信されます エラーが発生しました Googleでログイン WebサイトポリシーおよびMQL5.COM利用規約に同意します。 新規登録 MQL5.com WebサイトへのログインにCookieの使用を許可します。 ログインするには、ブラウザで必要な設定を有効にしてください。 ログイン/パスワードをお忘れですか? Googleでログイン

ここでまた、市場のOTOについて。事実は、バーの真ん中は、その開口部の直後に来るので、もちろん、遅延があるということですが、バーが既に形成されているとき、我々はこの黄金の平均が来ているバーの内部正確にときに気にしないので、その一方で、それは、存在しない。真ん中から始まって、真ん中で終わるようなバーを見たことがあります。あなたのニュートロンとの議論の本質は、一言も価値がない。 それは、バーがあなたにとってBARであるのに対し、商が時間によって量子化されていないため、ニュートロンにとってバーでないからだ。

あなたには異なる「参照枠」がある、ただそれだけのことです。

いや、古くないか...。>>あ、スーパースターだ!

まだバカにしてるのか、お前?老後は本当に楽しくない。

ここでまた、市場のOTOについて。事実は、バーの真ん中は、その開口部の直後に来るので、もちろん、遅延があるということですが、一方では、バーが既に形成されているとき、誰もこのバーの内側の黄金の平均が来たときに気にしないので、それは、存在しない。真ん中に始まり、真ん中に終わるバーを見たことがあります。あなたのニュートロンとの議論の本質は、一言も価値がない。 それは、バーがあなたにとってBARであるのに対し、商が時間によって量子化されていないため、ニュートロンにとってバーでないからだ。

あなたには異なる「参照枠」がある、ただそれだけのことです。

議論はいろいろありますが、特にこの点です。セルゲイさんは「説得力」のある主張をしてくれました。しかし、どうやら私は簡単なことが説明できないようです。遅れは一切ありません。定義上、ありえないんです。これらの数値の根拠となるデータは重複していない。位相がなく、数字が完全に等しいんです。

補足:正弦波上の2点を取り出して、0.1刻みでxのところと10.0刻みでxのところに遅れがあると言っているようなものです。

それでいいんです。私たちは自分の意見を貫きますから...。

試してみてください。

だから、頑張ってください :)テイラー級数分解は、0次でない多項式は値の範囲が限定されないので、高調波への分解よりさらに悪い。

さらに、あなたの言葉から、多項式ではなく、普通のSMAウェービングマシンであることがわかりました。

よし、それならこれがアイデアそのものです。深く考えれば、2小節、4小節、11小節を隣の小節と比較して過小評価する市場勢力はないだろう。つまり、隣り合ったバーは非常に近い値を示すと考えるべきだろう。11時間前に起きたことも、12時間前に起きたことも、同じように重要なのです。そのため、あるバーから隣のバーへの重量の移行がスムーズに行われることが期待されます。そのため、バー番号(ディレイ)の関数として重量を記述する曲線は滑らかであるべきです。もしこれが本当なら、この曲線w[n]はテイラー級数、すなわち多項式で近似することができる。例えば、3次や4次の多項式を重みに当てはめることができます。次に私のアイデアの前提は次の通りです。ウェイト自体の最適化(16個ある)の代わりに、多項式係数の最適化(a0+a1*n+a2*n^2+a3*n^3、a0・・・a3を最適化すると、合計4つのパラメータが得られる)、およびn番目のバーに対してa0+a1*n+a2*n^2+a3*n^3式を使用します。ずっと計算が少ない。試してみてください。

しかし、子供の頃、玄関で男の子から「基礎に間違いがあると、科学的な魅力があろうとも、それ以降の構造は無視される」と聞いたことがあります。ある(市場の)状態から別の状態への移行に必要な機能としての滑らかさの考え方に間違いがあるのです。嗚呼。しかし、そのようなことはありません。市場は、AからZへ、中間的な敬意を払うことなく移行しています。もしそうでなければ、それはフォーラムではなく、ソロスの会合になってしまいます。

気にしないでください...新しいアイデア(市場コンセプト)を出しますよ、今までのものより確実に実りがありますよ。

一見すると、とてもシンプルです。

規則性は、ランダム性が存在するための方法です。その逆はありません。

to 中性子

このオペレーティングシステムでは製品は 動作しません

石鹸を買いに行って...

ちなみに私もそんな風に予測することができます。ARが無くても。:)しかし、それは何も与えてくれなかった。私は80%の精度で価格が「どこに」行くかを当てることができますが、利益はありません。悲しいことです。;)

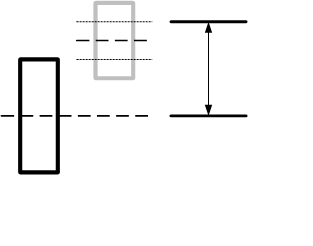

シリーズ(H+L)/2。簡略化のため、Muと表記する。この値を正確に予測することはできないが、差分Mu(n)-Mu(n+1)の符号を正確に予測することができると仮定する。 例えば、現在のバーでは、次のデルタMu(n)-Mu(n+1)が正値になることが分かっています。そして、新しい増分を統計的に推定し、そこからMu(n+1)に行く必要があります。このレベルにバースプレッドのRMS推定値を追加してみよう。貿易レベルを取得し、芸術的な表現を高めるために絵も描きました。

これらのレベルの発生頻度が大きく、スプレッドに見合ったものであれば、成功する可能性があります。このデルタを本当に80%で予測しているのですか?

追記:個人的にはそこまで値段に近い仕事はしていません。チャンスはあまりない、というか、まったくない。ただ、正確な予測ではなく、方向性のみの予測も可能なのではと思いつきました。私はこのような「技術」を使って自分なりの予測をしました:「この絵を見たことがありますか?」 少なくとも15分足で24時間、ここに実際の予測の例があります、私は次のテストを終了します - もっとあるでしょう(ちょうどデバッグ、すべてのアストロレーブがまだ構築されていません)。

「リアルタイム予測システムのテスト

に、gpwr

はい、私はあなたの最後の投稿をどうにかして見逃していました。ここで興味深い質問があります。重量が(原理的に)時間から自身のインデックスの関数になり得ると考えるのはなぜでしょうか?重さのグラフを見るという発想の原点がわかった気がします。微妙な点があります。2つの異なる実験(同じ学習ベクトルでの学習結果)において、これらのグラフは(視覚的、位相的に)大きく異なるかもしれませんが、グリッドの結果は(統計的に)実質的に同じです。もし、提案した方法でネットワークを学習 するための満足な関数さえ見つけることができれば、学習結果(同じベクトルに対する2回の連続した実験)は完全に同一になる--つまり、ニューラルネットワークではなく、完全に決定論的な何かになる。すでに眠っているニュートロンが 言うように、このようなネットワークは、1つのベクトルについては正確に学習されるが、詩を詠むことはできないだろう。そのため、取引には使えません。連続する各カウントは、前のものと(そして新鮮なものと)類似しておらず、通常のグリッドはそれさえもカウントしない。学習したあるイメージにほぼ似て いる。近似的に、正確に 置き換えるなら、このようなネットワークのエントロピーはゼロに等しくなる(すなわち、左への一歩、右への一歩-銃殺刑、その場でのホップ-挑発)。

多項式の係数を1つ変えるのに、1つの重みを修正するのと全く同じリソースが必要ですし、(各重みに対して)係数がn個 あるのですから、得られるものは何でしょうか。

シリーズ(H+L)/2。簡略化のため、Muと表記する。この値を正確に予測することはできないが、差分Mu(n)-Mu(n+1)の符号は正確に予測できるとする。 例えば、現在のバーでは、次のデルタMu(n)-Mu(n+1)が正であることが分かっています。そして、新しい増分を統計的に推定し、そこからMu(n+1)に行く必要があります。このレベルにバースプレッドのRMS推定値を追加してみよう。貿易レベルを取得し、芸術的な表現を高めるために絵も描きました。

これらのレベルの発生頻度が大きく、スプレッドに見合ったものであれば、成功する可能性があります。このデルタを本当に80%も見込んでいるのですか?

まさに8割を実証するアルゴリズムに驚き。エラーを探しています。見た目はとてもシンプルです。そのようなことはありません。

а-а-а-а-а-а-а-а-а-а-а-!!!!!月の位置を確認する必要がある、それが理由かもしれません。言葉が足りない」という表現がよくわかりました。そこが遅れているのか?

あなたのために特別に作りました。

FZは常にそこにあり、コチラの鋭い動きに視覚的にはっきりと現れているのがよくわかります。

遅延が常に発生していることがわかりますし、コチラのシャープな動きにも視覚的にわかりやすいですね。そして、次に超ド級の素晴らしいアイデアを思いついたとき、その実現には1つか2つの研究機関とPCのクラスタが必要だと考えたとき、ちょっと考えてみてください - たぶん、あなたはただ知らないか、理解していないのだと思います。結局のところ、これは「画期的な発見」よりも、目の前のすべてが踏みにじられた領域で、可能性が高いということなのです。

私は、すべてのスケールを短く記述する方法、この場合は多項式を提案します。ここでは、あなたの例でお見せします。ある入力ベクトルに対してネットワークを学習させ、すべての重みw[n](n=0...15)の値を得たとする。

パラローカス さんの考えは、NSに割り当てられた市場プロセスの定常性という未確認の仮説に基づいていることを、極めて的確に指摘されていると思うのです。これが確認された場合のみ、NS重みの定常性が期待でき、結果としてネットワーク学習なしで重みを求める外挿手法が適用できる。しかし、もしそうであれば、新しいBPデータごとにグリッドを再トレーニングする必要はないはずです。また,数値実験を行い,学習済みグリッドの重みがサンプルごとにどのような挙動を示すかを常に確認することができます.見てみようか?

そのために、1本ずつずらしながら500回の実験を行い、次のバーを予測することを学習します。私たちは、すべてのバーでネットを新たに教えます。500回分の重みのベクトルを1つのグラフに表示するのを避けるため、得られた値を重みごとに平均化し、各重みに対応する分散(値のばらつき)を1/e水準に沿ってプロットしたハンドルの形で表示します。

横軸はNS入力の番号、縦軸はこの入力に対する重みの平均値を示し、完全に学習されたネットワークについてである。このように,時間マーカー(左図)については,重みの値が統計的にばらつく領域(ひげの範囲)にあり,定常性の仮説を真っ向から否定するものであった。統計的に有意なのはNSの最初の入力(グラフではゼロサンプル)であり、これは小さなTFにおけるkotier(隣接するサンプル間の最初の差の系列における負の相関係数)の既知の反存性の原因である。

したがって、NSウエイトを多項式で近似する手法を開発する必要があるという話は時期尚早である。