交易中的机器学习:理论、模型、实践和算法交易 - 页 3309 1...330233033304330533063307330833093310331133123313331433153316...3399 新评论 Andrey Dik 2023.10.15 15:42 #33081 СанСаныч Фоменко #:我不需要你回答我的问题。如果我找到了答案,我将何去何从?问题答案的实用价值是什么?我将在 EA 中的哪个位置插入您问题的答案?我将在 IO 中的哪个位置输入您问题的答案?为什么要问一百次我不需要答案的问题? 下面是对您问题的回答(或者说是对我最初向您提出的问题的回答): 改变超出范围的红色虚线的符号,在所需区间内的剩余部分将具有您所寻找的最大分值,因此优化将简化为寻找最大值。您所寻找的将具有最大可能的分值。 但这并不是正确的方法,正确的方法是使用一个最初在您所寻找的位置具有最大值的分数。 神经网络训练、函数优化、策略优化等所有方面都是如此。 因此,"你不需要寻找最大值,你需要寻找一个稳定的高原 "这种说法本身就是错误的,说明估算的使用是错误的。 Maxim Dmitrievsky 2023.10.15 15:51 #33082 Maxim Dmitrievsky #:我猜,安德鲁把 NS 训练和优化参数混为一谈了。两者都有点像优化,当一只小猫被灌了很多食物时,这有点令人不安。 СанСаныч Фоменко 2023.10.15 15:59 #33083 Andrey Dik #: 因此,"你不需要寻找一个最大值,你需要寻找一个稳定的高原 "这种说法本身就是错误的,是对估算的错误使用。 与您的断言相反,您已经证明通过估算找到了高原。 在实践中,我可以在哪里应用这一点呢? 我们讨论的是过拟合,而过拟合通常基于优化。 在 MO 中,通过在不同文件上运行模型可以发现过度拟合。模型性能的变化是超拟合:不需要任何标准。还有一个软件包是通过过度拟合显示出来的。 从天上下来吧,原谅我,从你的极端来到地面,这里的情况有所不同。 Andrey Dik 2023.10.15 16:05 #33084 СанСаныч Фоменко #:与你的断言相反,你已经通过展示赞赏发现了高原。在实践中,我可以在哪里应用这一点?我们正在讨论过度拟合,这通常是基于优化。在 MO 中,通过在不同文件上运行模型可以发现过度拟合。模型性能的变化就是超拟合:不需要任何标准。还有一个软件包可以检测过度拟合。从你的极端中走下来,到不同的地方去。你不知道自己到底在寻找什么(你从未回答过这个问题)。 Maxim Dmitrievsky 2023.10.15 16:08 #33085 СОЗДАТЕЛЬ ИИ: ИСКУССТВЕННЫЙ МОЗГ, СВОБОДА ВОЛИ, СИНГУЛЯРНОСТЬ 2023.10.15www.youtube.com Освойте бесплатно за 2 недели основы Python и анализа данных на курсе «Специалист по Data Science» от Яндекс Практикум: https://ya.cc/t/HG2PtD254WHFyvПереход... Maxim Dmitrievsky 2023.10.16 08:32 #33086 mytarmailS 匹配参数,它能被视为一个未经训练的模型吗? 毕竟,"我们想 出的 "这句话本身也意味着某种思考过程(迭代)。最终的模型如何知道是大脑迭代还是计算机迭代,两者之间是否存在差异?这个问题是在阅读了普拉多的文章 后产生的 P hacking(黑客技术)就是按照你的要求扩展数据。你可以使用任何 FF,并在输入中添加尽可能多的数据,使其最大化。如果没有达到最大化,就添加更多数据或选择更精确的优化算法。也就是说,任何 FF 都可以通过这种方式最大化。这是 TC 优化中最常见的情况。在这种情况下,更多的数据--更多的过度训练。没有选项。全局最小值-最大值根本说明不了问题。合乎逻辑的解决方案是最大化 FF,同时最小化特征数量,就像我上面写的那样。可以说,这是最无害的方法。用科学术语来说,Baes 就是变体 traidof。相反的过程就是研究,在研究过程中,你不做最初的假设,不从天花板上获取 FF,而是研究数据,寻找规律。"你编造的 "与现实无关。而 "你根据研究得出结论 "才是。如果你要做研究,至少要确定研究的主题和方法,然后选择研究工具。如果你的研究对象甚至不是 BP,而是一个你自己知道的实体,你甚至可以提前确定这样的研究结果。我知道大学里不教这个,所以就这样吧:) СанСаныч Фоменко 2023.10.16 09:52 #33087 Maxim Dmitrievsky #: P hacking 就是按照你的要求扩展数据。你可以使用任何 FF,并在输入中添加尽可能多的数据,使其最大化。如果最大化效果不佳,则添加更多数据或选择更精确的优化算法。也就是说,任何 FF 都可以通过这种方式最大化。这是 TC 优化中最常见的情况。在这种情况下,更多的数据--更多的过度训练。没有选项。全局最小值-最大值根本说明不了问题。合乎逻辑的解决方案是最大化 FF,同时最小化特征数量,就像我上面写的那样。可以说,这是最无害的方法。Baes--用科学术语来说,就是变式折衷。 相反的过程就是研究,这时你不做初始假设,不从天花板上获取 FF,而是研究数据中的模式。 "你编造的 "与现实无关。而 "你根据研究得出结论 "则与现实有关。 如果你要做研究,你至少需要确定研究的主题和方法,然后选择研究工具。如果你的研究对象甚至不是 BP,而是你一个人知道的实体,你甚至可以提前确定这样的研究结果。 我知道大学里不教这个,所以就这样吧:) 一桶蜂蜜加一勺焦油,这样蜂蜜就可以扔掉了。正如施蒂尔利茨所说,最后一句话才令人难忘。 Maxim Dmitrievsky 2023.10.16 10:08 #33088 СанСаныч Фоменко #:一桶蜂蜜加一勺焦油,这样蜂蜜就可以丢弃了。正如斯特里茨所说,最后一句才是关键。 这样你听起来就不会太聪明了。 mytarmailS 2023.10.16 11:08 #33089 优化过程是对未知参数的搜索。每次迭代都是一次实验/研究,提出假设(参数)并验证实验结果(FF)。因此,优化(搜索)过程是一项相当复杂的研究。但这并不是给知识分子虚无的理解,当然不是给,这里需要思考,逻辑应该包括....。 Maxim Dmitrievsky 2023.10.16 11:37 #33090 mytarmailS #: 优化过程是对未知参数的搜索。每次迭代都是一次实验/研究,提出假设(参数)并验证实验结果(FF)。因此,优化(搜索)过程也是一项研究。但这并不是为了理解智力上的虚无,当然也不是为了理解,在这里你需要思考,逻辑要包括...... 模仿研究者的人并没有意识到,在优化开始之前,所有参数都是已知的。而优化的过程就是寻找参数值,以最大限度地实现他头脑发热所发明的任何功能。他的优化变成了一条漫长的荆棘之路,探索他所在的底部。 1...330233033304330533063307330833093310331133123313331433153316...3399 新评论 您错过了交易机会: 免费交易应用程序 8,000+信号可供复制 探索金融市场的经济新闻 注册 登录 拉丁字符(不带空格) 密码将被发送至该邮箱 发生错误 使用 Google 登录 您同意网站政策和使用条款 如果您没有帐号,请注册 可以使用cookies登录MQL5.com网站。 请在您的浏览器中启用必要的设置,否则您将无法登录。 忘记您的登录名/密码? 使用 Google 登录

我不需要你回答我的问题。如果我找到了答案,我将何去何从?问题答案的实用价值是什么?

我将在 EA 中的哪个位置插入您问题的答案?我将在 IO 中的哪个位置输入您问题的答案?

为什么要问一百次我不需要答案的问题?

下面是对您问题的回答(或者说是对我最初向您提出的问题的回答):

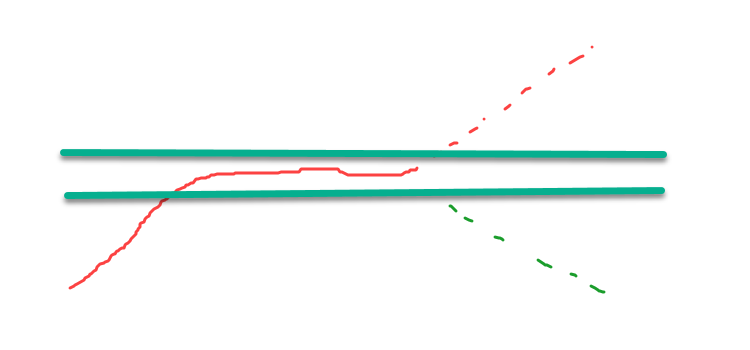

改变超出范围的红色虚线的符号,在所需区间内的剩余部分将具有您所寻找的最大分值,因此优化将简化为寻找最大值。您所寻找的将具有最大可能的分值。

但这并不是正确的方法,正确的方法是使用一个最初在您所寻找的位置具有最大值的分数。

神经网络训练、函数优化、策略优化等所有方面都是如此。

因此,"你不需要寻找最大值,你需要寻找一个稳定的高原 "这种说法本身就是错误的,说明估算的使用是错误的。

我猜,安德鲁把 NS 训练和优化参数混为一谈了。

两者都有点像优化,当一只小猫被灌了很多食物时,这有点令人不安。

因此,"你不需要寻找一个最大值,你需要寻找一个稳定的高原 "这种说法本身就是错误的,是对估算的错误使用。

与您的断言相反,您已经证明通过估算找到了高原。

在实践中,我可以在哪里应用这一点呢?

我们讨论的是过拟合,而过拟合通常基于优化。

在 MO 中,通过在不同文件上运行模型可以发现过度拟合。模型性能的变化是超拟合:不需要任何标准。还有一个软件包是通过过度拟合显示出来的。

从天上下来吧,原谅我,从你的极端来到地面,这里的情况有所不同。

与你的断言相反,你已经通过展示赞赏发现了高原。

在实践中,我可以在哪里应用这一点?

我们正在讨论过度拟合,这通常是基于优化。

在 MO 中,通过在不同文件上运行模型可以发现过度拟合。模型性能的变化就是超拟合:不需要任何标准。还有一个软件包可以检测过度拟合。

从你的极端中走下来,到不同的地方去。

毕竟,"我们想 出的 "这句话本身也意味着某种思考过程(迭代)。

最终的模型如何知道是大脑迭代还是计算机迭代,两者之间是否存在差异?

这个问题是在阅读了普拉多的文章 后产生的

P hacking 就是按照你的要求扩展数据。你可以使用任何 FF,并在输入中添加尽可能多的数据,使其最大化。如果最大化效果不佳,则添加更多数据或选择更精确的优化算法。也就是说,任何 FF 都可以通过这种方式最大化。这是 TC 优化中最常见的情况。在这种情况下,更多的数据--更多的过度训练。没有选项。全局最小值-最大值根本说明不了问题。合乎逻辑的解决方案是最大化 FF,同时最小化特征数量,就像我上面写的那样。可以说,这是最无害的方法。Baes--用科学术语来说,就是变式折衷。

一桶蜂蜜加一勺焦油,这样蜂蜜就可以扔掉了。正如施蒂尔利茨所说,最后一句话才令人难忘。

一桶蜂蜜加一勺焦油,这样蜂蜜就可以丢弃了。正如斯特里茨所说,最后一句才是关键。

优化过程是对未知参数的搜索。