Sie verpassen Handelsmöglichkeiten:

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Registrierung

Einloggen

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Wenn Sie kein Benutzerkonto haben, registrieren Sie sich

Nicht, dass das falsch wäre. Richtig, so richtig wie die Redewendung "billig kaufen, teuer verkaufen". Es kommt nicht nur auf die Korrektheit an, sondern auch auf die Formalisierbarkeit. Es hat keinen Sinn, kluge philosophische marktnahe Konstrukte zu konstruieren, wenn sie (die Konstrukte) wie die Milch einer Ziege sind.

Glauben Sie, dass es schwierig ist, die Zeitspanne nach der Annahme eines Verlustes zu formalisieren? Oder was ist anders?

Danke. Ich werde in aller Ruhe über SOM nachdenken.

Der Artikel unter dem Link gibt einen Überblick über die Methoden zur Segmentierung von Zeitreihen. Sie tun alle ungefähr das Gleiche. Nicht, dass SOM die beste Methode für Forex ist, aber es ist auch nicht die schlechteste, das ist eine Tatsache ))

http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.115.6594&rep=rep1&type=pdf

Meine Kollegen lassen es leider nicht zu, dass ich mehr Zeit für den Handel aufbringe, aber ich habe etwas Zeit gefunden und beschlossen, mich zu erkundigen (aus eigenem Interesse, damit ich es nicht vergesse :o, also werde ich später wiederkommen, wenn ich mehr Zeit habe)

Die Essenz des Phänomens.

Ich möchte Sie an das Wesen dieses Phänomens erinnern. Sie wurde bei der Analyse des Einflusses von "Long Tails" auf künftige Preisabweichungen entdeckt. Wenn wir Long Tails klassifizieren und die Zeitreihen ohne sie betrachten, können wir einige merkwürdige Phänomene beobachten, die für fast jedes Symbol einzigartig sind. Der Kern des Phänomens ist eine sehr spezifische Klassifizierung, die in gewisser Weise auf einem "neuronalen" Ansatz beruht. Diese Klassifizierung "zerlegt" die Rohdaten, d.h. den Quotierungsprozess selbst, in zwei Teilprozesse, die üblicherweise als"alpha" und"betta" bezeichnet werden. Im Allgemeinen kann der ursprüngliche Prozess in mehrere Teilprozesse unterteilt werden.

System mit zufälliger Struktur

Dieses Phänomen trifft sehr gut auf Systeme mit zufälliger Struktur zu. Das Modell selbst wird sehr einfach aussehen. Schauen wir uns ein Beispiel an. Die ursprüngliche EURUSD-Serie M15(wir brauchen eine lange Stichprobe, und so klein wie möglich Rahmen), von einigen "jetzt":

Schritt 1: Klassifizierung

Es wird eine Klassifizierung vorgenommen, und es werden zwei Prozesse"alpha" und"beta" ermittelt. Parameter des Kontrollprozesses werden definiert (der Prozess, der sich mit der endgültigen "Zusammenstellung" des Angebots befasst)

Schritt 2 Identifizierung

Für jeden Teilprozess wird ein Modell auf der Grundlage des Volterry-Netzwerks definiert:

Oh, wie mühsam ist es, sie zu identifizieren.

Schritt 3 Teilprozessvorhersage

Für jeden Prozess wird eine Prognose für 100 Zählungen erstellt (für 15 Minuten, d. h. etwas mehr als einen Tag).

Schritt 4: Simulationsmodellierung

Es wird ein Simulationsmodell erstellt, das die Anzahl der zukünftigen Implementierungen generieren wird. Der Aufbau des Systems ist einfach:

Drei Randomisierungen: ein Fehler für jedes Modell und Prozessübergangsbedingungen. Hier sind die Realisierungen selbst (von Null an):

Schritt 5: Die Handelslösung.

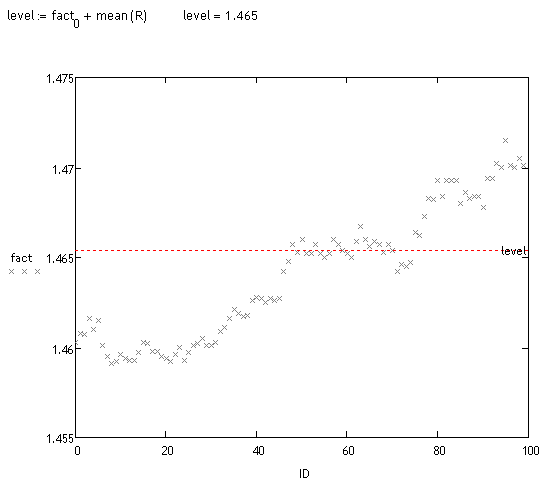

Es wird eine Verzerrungsanalyse dieser Realisierungen durchgeführt. Dies kann auf unterschiedliche Weise geschehen. Optisch ist zu erkennen, dass eine große Anzahl von Flugbahnen verschoben wird. Schauen wir uns die Fakten an:

<>

Vorläufige Prüfung

Ich habe etwa 70 "Messungen" nach dem Zufallsprinzip vorgenommen (das Zählen dauert sehr lange). Etwa 70 % der vom System festgestellten Abweichungen sind korrekt, also hat es noch nichts gesagt, aber ich hoffe, dass ich in ein paar Monaten wieder auf diese Spur zurückkomme, obwohl ich die Arbeit am Hauptprojekt noch nicht abgeschlossen habe :o(.

zu Sayfuji

Может не совсем корректно: по какому принципу производится классификация и, собственно, разложение на какие процессы предполагается?

Nein, alles ist korrekt. Dies war eines der Themen, die auf mehreren Dutzend Seiten dieses Threads diskutiert wurden. Alles, was ich für notwendig hielt, habe ich geschrieben. Leider habe ich keine Zeit, das Thema weiter auszubauen. Außerdem ist gerade dieses Phänomen zwar interessant, aber nicht sehr vielversprechend. Das Phänomen der "Long Tails" tritt auf langen Zeithorizonten auf, d.h. bei großen Abweichungen der Trajektorien, aber zu diesem Zweck ist es notwendig, die Prozesse Alpha und Betta (und andere Prozesse) weit weg vorherzusagen. Und das ist unmöglich. Es gibt keine solche Technologie...

:о(

für alle

Liebe Kolleginnen und Kollegen, es hat sich herausgestellt, dass es Beiträge gibt, die ich nicht beantwortet habe. Verzeihen Sie mir, es hat keinen Sinn, sich jetzt zu bewegen.

Prohwessor Fransfort, bitte antworten Sie, welches Programm Sie für Ihre Recherche verwenden.

Und außerdem... falls jemand ein Handbuch auf Russisch oder einen Russifier für das Programm http://originlab.com/ (OriginPro 8.5.1) hat

Ein interessantes Ergebnis.

Könnte dieses Phänomen auf die Tatsache zurückzuführen sein, dass es sich bei den historischen Daten um Geldkurse handelt? (Lambda im Experiment ist vergleichbar mit der Streuung).

Halten Sie es nicht für sinnvoller, die Qualität des sich ergebenden "Trend"-Prozesses mit Hilfe einer linearen Regression mit stückweise konstanten Koeffizienten zu testen, wenn man sie als Funktionen der Zeit betrachtet?

Sie können die gefilterten Inkremente addieren und erhalten zwei Prozesse: