Aprendizaje automático en el trading: teoría, práctica, operaciones y más - página 626

Está perdiendo oportunidades comerciales:

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Registro

Entrada

Usted acepta la política del sitio web y las condiciones de uso

Si no tiene cuenta de usuario, regístrese

Pues no, hay demasiados árboles... estaba bien incluso con 10 (no recuerdo cuántos puse)

500 es mucho, suficiente para cualquier conjunto de datos

¿Por qué esos errores con números fraccionarios? ... extraño, esperaba que la máquina pudiera aprender exactamente... Así que en el caso de los patrones (en forex) su forma está lejos de ser clara (como la tabla de multiplicar) es bueno si se obtienen predicciones correctas en el 60% de los casos.

Los errores se produjeron porque el parámetro r era bajo, lo que significa que sólo se utilizó la mitad de los ejemplos para el entrenamiento, y esta mitad se entrenó en la mitad de los árboles :) y hay pocos ejemplos

hay que poner r~1 para ser exactos. Se utiliza para la pseudoregularización y para las pruebas con muestras fuera de bolsa

es que este mecanismo necesita ser ajustado, en el caso del bosque, sólo hay 2 ajustes

También debe entender que NS (RF) no es una calculadora, sino que aproxima una función, y una precisión demasiado alta es más mala que buena para muchas tareas.

Me temo que la regresión/previsión en la red producirá más o menos lo mismo que buscar sitios/patrones similares en la historia (cosa que hice hace 3 meses):

Los errores se produjeron porque el parámetro r era bajo, lo que significa que sólo se utilizó la mitad de los ejemplos para el entrenamiento, y esta mitad se entrenó en la mitad de los árboles :) y hay pocos ejemplos

hay que poner r~1 para ser exactos. Se utiliza para la pseudoregularización y para las pruebas con muestras fuera de bolsa

Sólo hay que saber afinar este mecanismo, en el caso del bosque, sólo hay 2 ajustes

Es decir, si se establece r en 1, entonces se entrenará en todas las muestras.

El bosque no utilizará todos los atributos de todos modos, por lo que hay una modificación del modelo en la que se puede establecer que se utilicen todos los atributos. Pero esto no es recomendable porque el bosque recordará todas las opciones

y la selección de los ajustes suele ser algo tan subjetivo, que hay que experimentar

si es menor que 1, entonces en las muestras restantes se valida el modelo (el modelo se estima en los datos que no se tomaron en la muestra de entrenamiento). r clásico es 0,67, en el 33% restante se valida el modelo. Por supuesto, esto es cierto para las muestras grandes, para las pequeñas es igual que con la tabla de multiplicar - es mejor poner 1.

El bosque no utilizará todos los atributos de todos modos, por lo que hay una modificación del modelo en la que se puede establecer que se utilicen todos los atributos. Pero esto no es recomendable porque el bosque recordará todas las opciones

y la selección de los ajustes suele ser algo tan subjetivo, que hay que experimentar

Si es inferior a 1, el modelo se valida en las muestras restantes (el modelo se estima en los datos que no se tomaron en la muestra de entrenamiento). Según el clásico r se fija en 0,67, el modelo se valida en el 33% restante

Selección de características

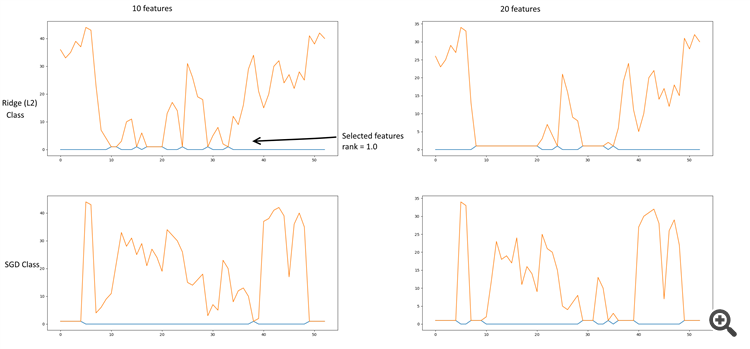

Un poco de búsqueda de datos. Estaba haciendo la selección de características a través de Chi^2 + KBest, RFE (Recursive feature elimination) + (SGDClassifier, RidgeClassifier), L2 (Ridge, RidgeClassifier), L1 (Lasso). La regularización de la cresta da resultados más sanos.

Algunos gráficos:

RFE + Ridge y SGD

Regresión de cresta (L2).

Clasificador de cresta (L2)

El archivo contiene una tabla con los valores de los parámetros y su muestreo por selección de características.

Los coeficientes más significativos resultaron ser:

- 10, 11 - Cerrar, Delta (Abrir-Cerrar)

- 18-20 - Derivado Alto, Bajo, Cierre

- 24 - Cierre de la derivación del registro

- 29, 30 - Lowess

- 33 - Detranding Close - Lowess

- 35 - EMA 26 (13 como opción)

- 40 - Derivados EMA 13

PS. La línea del clasificador Ridge en la tabla se basa en una clase, no refleja la dependencia de los parámetros de las otras clases.Referencia al guión.

esbozó un nuevo diagrama de red, esta es la primera descripción. Más adelante habrá más (ojalá)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

esbozó un nuevo diagrama de red, esta es la primera descripción. Más adelante habrá más (ojalá)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

Me pregunto por qué se ha borrado el primer post. Ha publicado el plan en el blog. =)