Машинное обучение в трейдинге: теория, модели, практика и алготорговля - страница 3308

Вы упускаете торговые возможности:

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Регистрация

Вход

Вы принимаете политику сайта и условия использования

Если у вас нет учетной записи, зарегистрируйтесь

причем здесь тестер и при чем здесь зелёный цвет?

дадите ответ на мой вопрос - перестанете искать это пресловутое плато.

Мне НЕ нужен ответ на Ваш вопрос. Найду я ответ, и куда я с ним пойду? Какая практическая ценность ответа на Ваш вопрос?

Где в советник я вставлю ответ на Ваш вопрос? Где в МО я вставлю этот самый ответ?

Че задавать сто раз вопрос, ответ на который мне не нужен.

Эндрю путает обучение НС и оптимизацию ее параметров, наверное

и там и там типа как оптимизация, что немного обескураживает, когда котенку насыпали много еды.. вроде везде вокруг оптимизация еда и непонятно какую есть

Мне НЕ нужен ответ на Ваш вопрос. Найду я ответ, и куда я с ним пойду? Какая практическая ценность ответа на Ваш вопрос?

Где в советник я вставлю ответ на Ваш вопрос? Где в МО я вставлю этот самый ответ?

Че задавать сто раз вопрос, ответ на который мне не нужен.

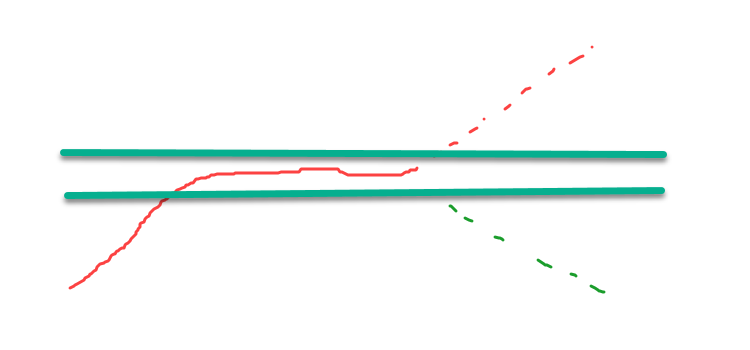

вот ответ на ваш вопрос (вернее на мой изначальный вам вопрос):

поменяйте знак у красной штрих линии что вышла за диапазон, то что останется в требуемом интервале будет иметь максимальную оценку того что ищете, а значит оптимизация будет сведена к поиску МАКСИМУМА. то что ищете будет иметь максимально возможную оценку.

это простой способ конвертировать оценку, которую используете, в оценку с максимальным значением лежащем на плато. но это не самый правильный путь, правильный - использовать оценку, которая изначально имеет максимум в искомом месте.

справедливо это ко всему, обучению нейросетей, оптимизации функций, оптимизации стратегий, ко всему.

поэтому утверждение "не надо искать максимум, нужно искать устойчивое плато" изначально ошибочно, говорящее об ошибочном использовании оценки.

Эндрю путает обучение НС и оптимизацию ее параметров, наверное

и там и там типа как оптимизация, что немного обескураживает, когда котенку насыпали много еды.. вроде везде вокруг оптимизация еда и непонятно какую есть

поэтому утверждение "не надо искать максимум, нужно искать устойчивое плато" изначально ошибочно, говорящее об ошибочном использовании оценки.

Вопреки своему утверждению Вы показали плато нашли, демонстрируя оценку.

Где на практике я могу это применить?

Обсуждаем сверх подгонку, в основе которой обычно лежит оптимизация. в тестере все наглядно.

В МО сверх подгонка выявляется прогоном модели на разных файлах. Разброс результативности модели - это сверх подгонка: никакие критерии НЕ нужны. Есть еще пакет, который выявляется сверх подгонку.

Спуститесь с небес, пардон, со своих экстремумов на землю, на которой все по другому.

Вопреки своему утверждению Вы показали плато нашли, демонстрируя оценку.

Где на практике я могу это применить?

Обсуждаем сверх подгонку, в основе которой обычно лежит оптимизация. в тестере все наглядно.

В МО сверх подгонка выявляется прогоном модели на разных файлах. Разброс результативности модели - это сверх подгонка: никакие критерии НЕ нужны. Есть еще пакет, который выявляется сверх подгонку.

Спуститесь с небес, пардон, со своих экстремумов на землю, на которой все по другому.

Кто-нибудь может мне обяснить проблему множественного тестирования.

Нет я понимаю что чем больше ищешь(итерации) тем больше вероятность найти что то случайное что будет выглядеть как НЕслучайное..

Но если мы придумали какую то идею ,а потом подобрали параметры к ней за 10 итераций , а не за 10000 то можно ли это считать непереобучной моделью?

Ведь сама фраза "мы придумали" подразумевает тоже некий мыслительный перебор (итерации)

Откуда конечной модели знать какие это были итерации, мозговые или копютерные и есть ли разница между тем и другим?

Вопрос возник после почтения статьи Прадо

Пи хакинг - это натягивание данных на свои хотелки. Берешь любую ФФ и добавляешь на вход столько данных, чтобы ее максимизировать. Плохо максимизируется - добавляешь еще данных или выбираешь более точный алгоритм оптимизации. То есть, таким образом можно максимизировать любую ФФ. Это самый распространенный случай в оптимизации ТС. В данном случае больше данных - больше переобучение. Без вариантов. Глобальные минимумы-максимумы ни о чем не говорят вообще. Логичное решение - максимизация ФФ при минимизации кол-ва признаков, о чем писал выше. Наименьшее зло, так скажем. Баес - варианс трейдоф, научными словами.

Бочка меда с ложкой дегтя, поэтому мед можно выбросить. Как говорил Штирлиц, запоминается последняя фраза.

Бочка меда с ложкой дегтя, поэтому мед можно выбросить. Как говорил Штирлиц, запоминается последняя фраза.