Discusión sobre el artículo "Redes neuronales en el trading: Enfoque sin máscara para la predicción del movimiento de precios"

Hola Dmitriy,

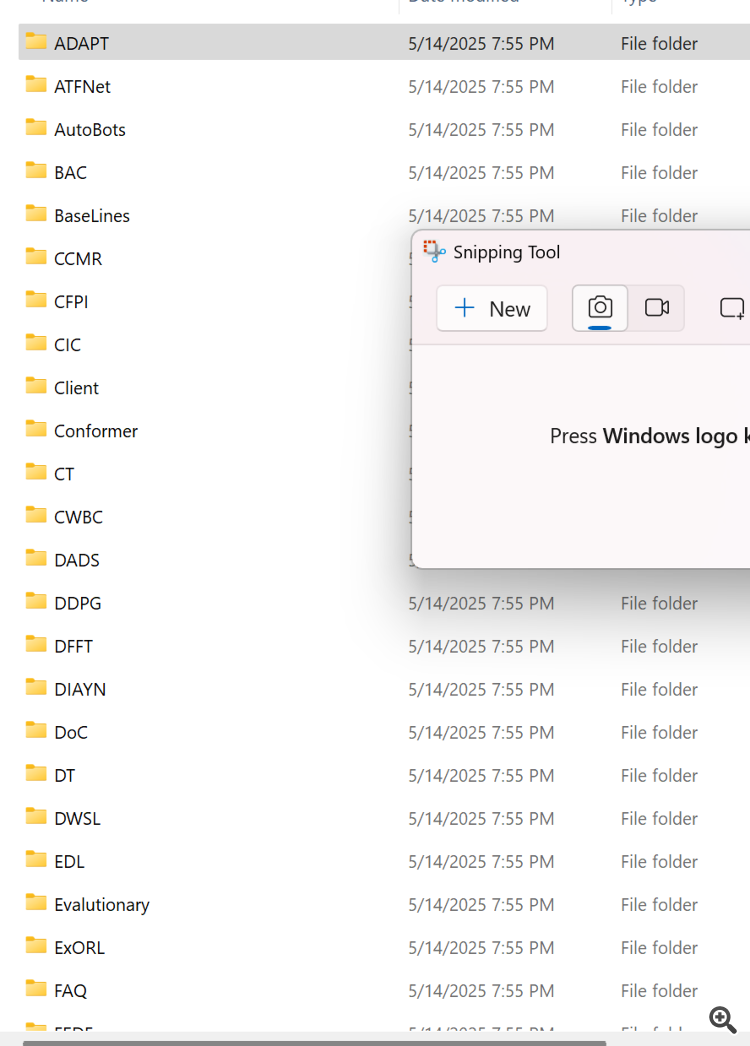

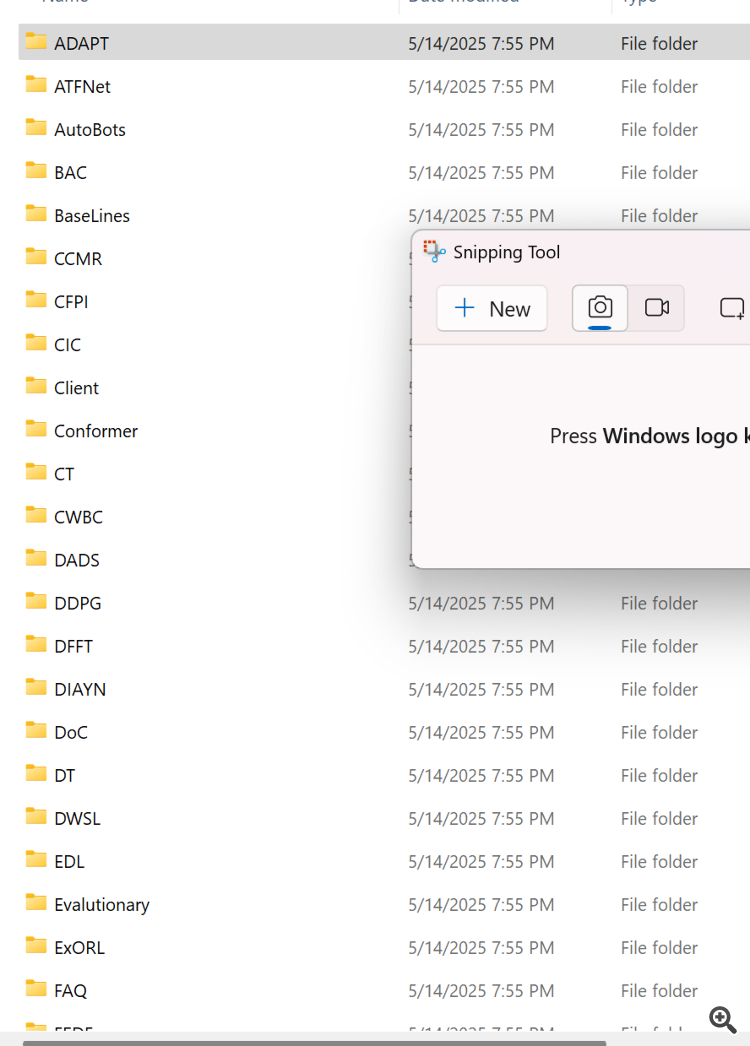

Parece que tus archivos zip están mal hechos. Esperaba ver el código fuente listado en tu caja en vez de esto es lo que contenía el zip. Parece que cada directorio listado contiene los archivos que has usado en tus diferentes artículos. Podrías proporcionar una descripción de cada uno o mejor aún, añadir el número de artículo a cada directorio según corresponda.

Gracias

CapeCoddah

Hola Dmitriy,

Parece que tus archivos zip están mal hechos. Esperaba ver el código fuente listado en tu caja en lugar de esto es lo que contenía el zip. Parece que cada directorio listado contiene los archivos que has usado en tus diferentes artículos. Podrías proporcionar una descripción de cada uno o mejor aún, añadir el número de artículo a cada directorio según corresponda.

Gracias

CapeCoddah

Hola CapeCoddah

El archivo zip contiene archivos de todas las series. El programa OpenCL guardado en "MQL5\Experts\NeuroNet_DNG\NeuroNet.cl". La libreria con todas las clases se encuentra en "MQL5Experts\NeuroNet_DNG\NeuroNet.mqh". Y el modelo y los expertos a los que hace referencia este artículo se encuentran en el directorio "MQL5\Experts\MAFT\".

Saludos,

Dmitriy.

Hola CapeCoddah,

El archivo zip contiene archivos de todas las series. El programa OpenCL guardado en "MQL5\Experts\NeuroNet_DNG\NeuroNet.cl". La libreria con todas las clases se encuentra en "MQL5Experts\NeuroNet_DNG\NeuroNet.mqh". Y el modelo y los expertos a los que hace referencia este artículo se encuentran en el directorio "MQL5\Experts\MAFT\".

Saludos,

Dmitriy.

Hola Dmitriy,

Gracias por la pronta respuesta. Entiendo lo que dices pero creo que no me has entendido. Como asocio los nombres de los subdirectorios con su respectivo articulo, ya sea por nombre o por numero de articulo a partir del cual se puede buscar para encontrar el articulo.

Saludos

CapeCoddah

Hola Dmitriy,

Gracias por la pronta respuesta. Entiendo lo que dices pero creo que no me has entendido bien. Cómo asocio los nombres de los subdirectorios con su artículo correspondiente, ya sea por nombre o por número de artículo a partir del cual se puede buscar para encontrar el artículo.

Saludos

CapeCoddah

Por el nombre del marco

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Usted acepta la política del sitio web y las condiciones de uso

Artículo publicado Redes neuronales en el trading: Enfoque sin máscara para la predicción del movimiento de precios:

El algoritmo SPFormer es un proceso integral que permite que las consultas de objetos generen directamente predicciones de instancias. Usando los decodificadores del Transformer, las consultas de objetos fijos agregan información de objetos globales en la nube de puntos analizada. Además, el SPFormer utiliza máscaras de objetos para controlar la atención cruzada, de modo que las consultas solo deberán tener en cuenta los rasgos enmascarados. Sin embargo, en las primeras fases del entrenamiento se usan máscaras de baja calidad. Y esto impide un alto rendimiento en las capas posteriores, lo cual aumenta la complejidad del proceso de aprendizaje del modelo.

Por ello, los autores del método MAFT introducen un problema de regresión central auxiliar para controlar la segmentación de las instancias. En primer lugar, se seleccionan las posiciones globales 𝒫 de la nube de puntos original y se extraen las características globales de los objetos ℱ usando la línea troncal básica. Pueden ser tanto vóxeles como Superpoints. Además de las solicitudes de contenido 𝒬0c, los autores del MAFT introducen un número fijo de consultas posicionales 𝒬0p que representan centros de objetos normalizados. 𝒬0p se inicializa con un valor aleatorio, mientras que 𝒬0c se inicializa con valores cero. El objetivo principal consiste en permitir que las consultas posicionales guíen a las consultas contextuales correspondientes en la atención cruzada, para después refinar iterativamente ambos conjuntos de consultas y predecir los centros, las clases y las máscaras de los objetos.

Autor: Dmitriy Gizlyk