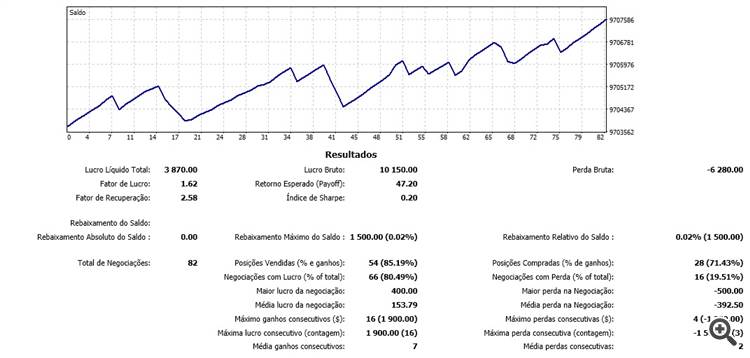

Muchas gracias por sus artículos. Sus algoritmos son muy buenos, para mí son los mejores algoritmos en mql5 para redes neuronales ya que permiten actualizar la red en tiempo real, durante el mercado, línea por línea. Estoy probando sus algoritmos en el mercado de futuros de Brasil y los resultados son alentadores, el pronóstico ha alcanzado una eficiencia de más del 80% en las últimas 100 barras, lo que ha llevado a operaciones positivas. Espero con interés el próximo artículo.

Nuevo artículo Neural networks made easy (Part 11): Se ha publicado un artículo sobre GPT:

Autor: Dmitriy Gizlyk

Material interesante, pero el código es todo en un enorme plato de espaguetis bastante difícil de conseguir a los apretones con él. Una clase por archivo habría sido más fácil.

Sería bueno tener un diagrama que muestra cómo todas las clases se mantienen juntos.

Ahora mismo estoy en NeuronBase que deriva de Object pero usa NeuronProof que deriva de NeuronBase y también Layer que usa prácticamente cada tipo de clase Neuron definida.

Un montón de declaraciones hacia adelante necesarias para poner todo en archivos separados y llegar a entenderlo.

Probablemente sea más fácil empezar de cero y utilizar los conceptos que has explicado en los distintos capítulos.

Intenté ejecutar el spaghetti bowl e hizo que mi GPU echara humo, no produciendo nada muy útil desafortunadamente.

En cualquier caso, gracias por el material.

:-)

Material interesante pero el código está todo en un enorme plato de espaguetis bastante difícil de entender. Una clase por archivo habría sido más fácil.

Sería bueno tener un diagrama que muestra cómo todas las clases se mantienen juntos.

Ahora mismo estoy en NeuronBase que se deriva de Object pero utiliza NeuronProof que se deriva de NeuronBase y también Layer que utiliza prácticamente cada tipo de clase Neuron definida.

Un montón de declaraciones hacia adelante necesarios con el fin de poner todo en archivos separados y llegar a enfrentarse con él.

Probablemente sea más fácil empezar de cero y utilizar los conceptos que han explicado en los distintos capítulos.

Traté de ejecutar el tazón de espaguetis que hizo que mi humo GPU, produciendo nada muy útil por desgracia.

De todos modos, gracias por los grandes materiales.

:-)

Hola,

Compruebe NN.chm. Tal vez te ayude.

Hola,

Sí, gracias.

El código no es tan malo ahora y puedo ver claramente cómo cambiar la arquitectura de red si es necesario.

Tengo todo en archivos de clase separados, además de un tazón de espaguetis mucho más pequeño que sigue siendo necesario porque mt5 tiene tanto la definición como las implementaciones en los mismos archivos.

Traté de hacer un poco de entrenamiento en GBPUSD utilizando el código como es, pero los resultados no parecen ser buenos el error sube de la natural del 50% al 70% y se mantiene allí sin mejora en épocas posteriores.

¿Alguna sugerencia de dónde empezar a ajustar?

BTW esta línea:

#define FileName Symb.Name()+"_"+EnumToString((ENUM_TIMEFRAMES)Period())+"_"+IntegerToString(HistoryBars,3)+StringSubstr(__FILE__,0,StringFind(__FILE__,".",0))

Necesita ser corregido a:

#define FileName Symb.Name()+"_"+EnumToString((ENUM_TIMEFRAMES)Period())+"_"+IntegerToString(HistoryBars)+StringSubstr(__FILE__,0,StringFind(__FILE__,".",0))

Al principio no estaba entendiendo mucho el artículo, porque no estaba entendiendo bien la idea principal.

Al preguntarle al propio ChatGPT sobre este texto me acalaró bastante las cosas y entendí la mayor parte de lo que estaba leyendo:

"El algoritmo Transformer es un modelo utilizado para procesar lenguaje natural, es decir, texto. Este modelo divide el texto en una secuencia de palabras (o "tokens"), y luego realiza una serie de operaciones en cada una de estas palabras para entender mejor su significado.

Una de las operaciones que hace el modelo es la auto-atención, que consiste en calcular la importancia que cada palabra tiene en relación a las demás palabras de la secuencia. Para hacer esto, el modelo utiliza tres vectores: el vector de consulta, el vector clave y el vector valor, que se calculan para cada palabra.

Luego, el modelo calcula la atención, que es la importancia que cada palabra tiene en relación a las demás palabras de la secuencia. Utiliza una función matemática llamada softmax para normalizar los coeficientes de atención.

Finalmente, el modelo combina todas las operaciones de auto-atención para producir un resultado final, que se utiliza para predecir el significado del texto.

En resumen, el algoritmo Transformer utiliza operaciones matemáticas complejas para entender el significado del texto."

Hola de nuevo :) He encontrado el problema. En la carpeta include la configuración de Opencl fallaba, porque probé mi sistema, y la GPU no soportaba el código solo la cpu, un pequeño cambio y funcionando perfectamente, pero lento :S

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Usted acepta la política del sitio web y las condiciones de uso

Artículo publicado Redes neuronales: así de sencillo (Parte 11): Variaciones de GTP:

Hoy en día, quizás uno de los modelos de lenguaje de redes neuronales más avanzados sea GPT-3, que en su versión máxima contiene 175 mil millones de parámetros. Obviamente, no vamos a crear semejante monstruo en condiciones domésticas. Pero sí que podemos ver qué soluciones arquitectónicas se pueden usar en nuestro trabajo y qué ventajas nos ofrecerán.

La prueba de la nueva clase de la red neuronal se ha realizado con el mismo conjunto de datos de las pruebas anteriores: instrumento EURUSD, marco temporal H1, con los datos históricos de las últimas 20 velas suministrados a la entrada de la red neuronal.

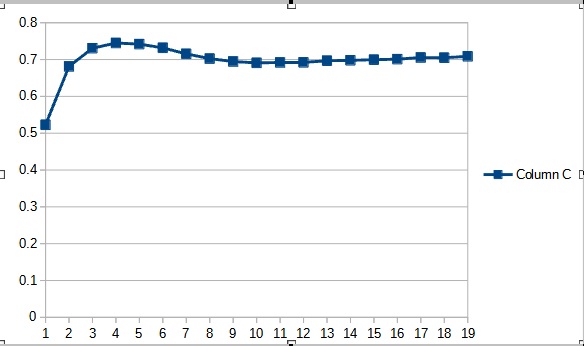

Los resultados de la prueba han confirmado nuestra suposición de que más parámetros requieren un periodo de entrenamiento mayor. En las primeras épocas del entrenamiento, el asesor experto con menos parámetros muestra resultados más estables. Pero al aumentar el periodo de entrenamiento, el asesor experto con un gran número de parámetros mejora los indicadores. En general, el error del asesor Fractal_OCL_AttentionMLMH_v2 después de 33 épocas de entrenamiento ha disminuido por debajo del nivel de error del asesor Fractal_OCL_AttentionMLMH y luego ha permanecido solamente más abajo.

Autor: Dmitriy Gizlyk