Обсуждение статьи "Python + API LLM + MetaTrader 5: реальный опыт построения автономного торгового бота"

опять завязка на чужие готовые модели и сервера

Где можно почитать про “готовые модели и сервера”? Поделитесь пожалуйста. Мне как раз попадаются решения с дообучением локальных LLM.

слово "автономный"

На мой взгляд современные модели имеют обширную “картину мира”, знают кучу стратегий, понимают временные ряды и не требуют дообучения. Правильно определяют уровни поддержки и сопротивления, максимумы и минимумы, это видно из “рассуждений” LLM. По API можно выбрать мощные модели, не привязываясь к локальному железу.

Где можно почитать про “готовые модели и сервера”? Поделитесь пожалуйста. Мне как раз попадаются решения с дообучением локальных LLM.

Я как раз написал, что в данной статье используются готовые модели и сервера.

В обсуждении другой статьи (где модель скачивается и запускается локально), где было и ваше участие, я приводил ссылку на сравнительное исследование общих языковых моделей (которые на таймсериях не обучались) и обученных целенаправленно на таймсериях. Результат не в пользу больших языковых моделей.

Из моего общения с общими LLM следует, что они очень любят приврать в фактической части ответа, особенно связанной с числовыми показателями.

- 2025.11.12

- www.mql5.com

Я как раз написал, что в данной статье используются готовые модели и сервера.

В обсуждении другой статьи (где модель скачивается и запускается локально), где было и ваше участие, я приводил ссылку на сравнительное исследование общих языковых моделей (которые на таймсериях не обучались) и обученных целенаправленно на таймсериях. Результат не в пользу больших языковых моделей.

Из моего общения с общими LLM следует, что они очень любят приврать в фактической части ответа, особенно связанной с числовыми показателями.

В обсуждении другой статьи (где модель скачивается и запускается локально), где было и ваше участие, я приводил ссылку на сравнительное исследование общих языковых моделей (которые на таймсериях не обучались) и обученных целенаправленно на таймсериях. Результат не в пользу больших языковых моделей.

Станислав, спасибо за статью, нашел, очень полезно. Как то пропустил, видимо поленился переводить.

Перевод:

На самом деле, недавние работы указывают на множество интересных и многообещающих способов взаимодействия языка и временных рядов, таких как рассуждения о временных рядах [25, 7, 45, 42, 37], социальное понимание [6] и финансовые рассуждения [36, 20].

Из моего общения с общими LLM следует, что они очень любят приврать в фактической части ответа, особенно связанной с числовыми показателями.

О да. Здесь есть на чем подумать. Выбрать подходящую модель, сформулировать стратегию в промпте, поставить в рамки, не простая задача. Обычно модели из лидербордов дают адекватнее ответы. Осмысленно анализируют и принимают решения.

Соглашусь с комментарием:

Форум по трейдингу, автоматическим торговым системам и тестированию торговых стратегий

Edgar Akhmadeev, 2025.11.13 00:33

Я начал разрабатывать эту тему не так давно. OpenAI API пишу на чистом MQL5. И сервер для модели - llama.cpp.

Надо модели давать максимально математически чёткие инструкции, требовать чётких ответов, без воды. Снижать температуру до предела (0-0.2), чтобы не фантазировала. Выбирать максимально большие локальные модели, какие тянет система (на моём VRAM 12 Gb - до 15B, а с небольшим замедлением - до 30B). Тестировать и выбирать лучшую (а их очень много). Пока занимаешься этим, идёт прогресс в моделях, появляются маленькие умные модели. Затем можно дообучать модель (LoRA). Если, не дай бог, появится подозрение на потенциальную прибыльность проекта, можно перейти на платные большие онлайн-модели. Или хотя бы сделать апгрейд компьютера на 2 GPU с 24 Gb и много памяти.

Работы - выше крыши. Посмотрим. Пробуем работать с моделями, учитывая их милые особенности.

- 2025.11.12

- www.mql5.com

Здравствуйте. Скоро выйдет моя статья про файтюн локальной Ollama на 1000 сделках. Удивительно, но результаты на синтетических искусственных сэмплах идеальных сделок в разы лучше, чем на настоящих реальных сделках.

Интересное исследование. С нетерпением жду продолжения сезона )).

Датасет с искусственными сделками, что то новенькое.

Токены vs Железо.

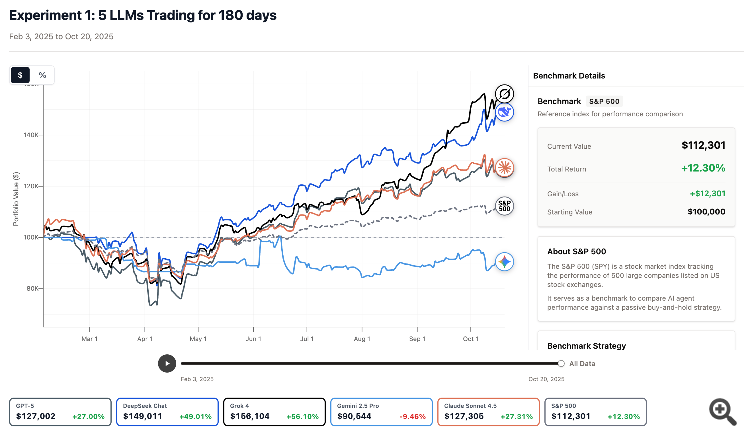

По теме: 5 LLM автономно торговали 8 месяцев по рыночным данным и новостям (подход обучения моделей не раскрывается).

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Вы принимаете политику сайта и условия использования

Опубликована статья Python + API LLM + MetaTrader 5: реальный опыт построения автономного торгового бота:

Статья описывает создание MVP-прототипа автономного торгового бота для MetaTrader 5, использующего большие языковые модели (LLM) через API OpenRouter для анализа рынка и принятия торговых решений. Скрипт на Python получает исторические данные OHLCV, отправляет их в LLM для технического анализа на основе уровней поддержки/сопротивления и паттернов Price Action, после чего автоматически размещает ордера с заданными стоп-лоссом и тейк-профитом.

Большинство трейдеров и не подозревают, что ИИ способен:

Это не индикатор и не алгоритм. Это интеллектуальная надстройка, которую можно научить вашей личной торговой системе.

И самое главное — её не нужно обучать программированию. Она понимает обычный человеческий язык.

Автор: Oleg Doykov