クール

記事をありがとう!

便利なスクリプト、ありがとう。

私もいくつか焼いた:

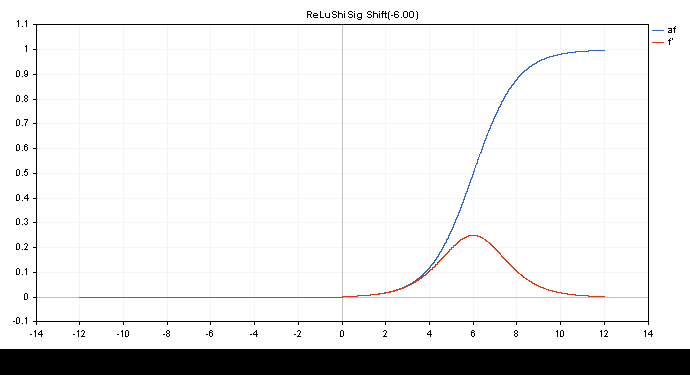

ReLu + Sigmoid + Shiftで0.0から1.0の出力をキャプチャ (input -12 to 12)

double activationSigmoid(double x){ return(1/(1+MathExp(-1.0*x))); } double derivativeSigmoid(double activation_value){ return(activation_value*(1-activation_value)); } double activationReLuShiSig(double x,double shift=-6.0){ if(x>0.0){ return(activationSigmoid(x+shift)); } return(0.0); } double derivativeReLuShiSig(double output){ if(output>0.0){ return(derivativeSigmoid(output)); } return(0.0); }

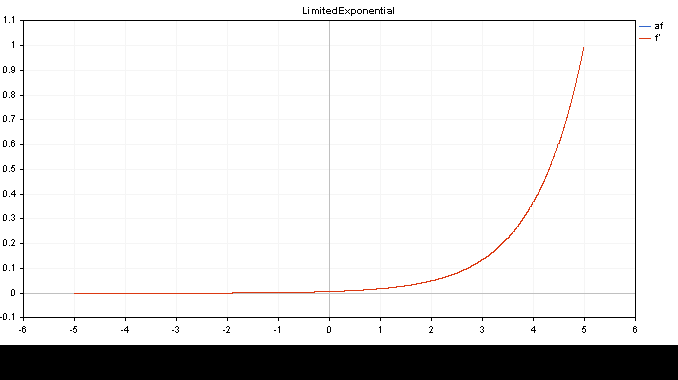

限定指数.af=f' (入力-5.0から5.0)

double activationLimitedExponential(double x){ return(MathExp(x)/149.00); } //そして微分はそれ自身である double derivativeLimitedExponential(double x){ return(x); }

👨🔧

取引の機会を逃しています。

- 無料取引アプリ

- 8千を超えるシグナルをコピー

- 金融ニュースで金融マーケットを探索

新しい記事「MQL5における行列とベクトル:活性化関数」はパブリッシュされました:

ここでは、機械学習の一側面である活性化関数についてのみ説明します。人工ニューラルネットワークでは、ニューロンの活性化関数は、入力シグナルまたは入力シグナルのセットの値に基づいて出力シグナル値を計算します。その内幕に迫ります。

活性化関数とその導関数のグラフは、-5から5まで単調に増加する順序で用意されています。価格チャート上に関数グラフを表示するスクリプトも開発しました。Page Downキーを押すと、保存画像名を指定するためのファイルオープンダイアログが表示されます。

ESCキーはスクリプトを終了させます。スクリプト自体は以下に添付されています。

作者: MetaQuotes