L'apprendimento automatico nel trading: teoria, modelli, pratica e algo-trading - pagina 2474

Ti stai perdendo delle opportunità di trading:

- App di trading gratuite

- Oltre 8.000 segnali per il copy trading

- Notizie economiche per esplorare i mercati finanziari

Registrazione

Accedi

Accetti la politica del sito e le condizioni d’uso

Se non hai un account, registrati

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

C'è un po' di verità qui, ma ho controllato il mio modello, la cosa principale è sapere su quale avanti stiamo contando....

Non capisco bene, ma è un mio problema, non ho studiato bene, guardo un po' diversamente agli algoritmi per il trading, più a regole asociali e regole di ricerca genetica o formule, come la regressione simbolica ecc. Ma se sei riuscito a far funzionare modelli semplici con nuovi dati, è molto interessante sentirne parlare...

https://www.mql5.com/ru/forum/231011

https://squeezemetrics.com/download/The_Implied_Order_Book.pdf

Grazie per aver letto...

Anch'io amo Maitreid, ho guardato il suo video probabilmente 8 volte, non una sola parola in più...

Per quanto riguarda il manichino, penso che sia molto più semplice: lo scambio vive con la commissione, e se la maggior parte della gente vuole comprare, e queste richieste di acquisto sotto il prezzo corrente, lo scambio è redditizio per soddisfare gli acquirenti perché ci sono più di loro, quindi la commissione (denaro) può guadagnare di più, quindi il prezzo scende e viceversa con i venditori ...

Come lo fa, stampa solo il prezzo o manipola il tumbler o qualcos'altro non lo so, ma credo che la linea di fondo sia la stessa...

Ecco perché il prezzo va contro le posizioni dei partecipanti.

Non ti capisco bene, ma è il mio problema che non ho studiato bene, guardo un po' diversamente per gli algoritmi di trading, più verso regole asociali e regole di ricerca genetica o formule, come la regressione simbolica ecc. Ma se sei riuscito a far funzionare modelli regolari su nuovi dati, è molto interessante sentirne parlare.

Sì, ce l'ho, la qualità non è così buona come sulla trama di allenamento ma sempre parte di quella qualità viene mantenuta, e la mia ricerca ha preso 10 anni di storia in avanti forse fino a un anno, in media 2-3 mesi funziona per una qualità abbastanza buona, rispetto alla trama di allenamento percentuale 60-70 in media probabilmente. Una rete neurale darà risultati migliori, ma c'è già bisogno di aggiungere questi criteri di riqualificazione, di inserire dati combinati come pesi, di dare un certo peso alla quantità di dati, poi la qualità del backsest finale per esempio l'aspettativa o il profitto e naturalmente la complessità dell'algoritmo finale, che si è rivelato (quantità di tutti i pesi di tutti i perceptrons per esempio). Per ottenerlo in una rete neurale, il tipo di neuroni dovrebbe essere il più diverso possibile, e il numero di strati e la loro composizione dovrebbero essere arbitrari, in questo caso è possibile. Fondamentalmente tutti usano reti neurali di architettura fissa, ma per qualche ragione non capiscono che l'architettura deve essere anche flessibile, distruggendo questa flessibilità si distrugge la possibilità di ridurre al minimo il retraining. In generale gli stessi criteri possono naturalmente essere applicati a modelli semplici, anche bisogno di, poi si otterrà un buon avanti, il mio modello dà un paio di mesi di profitto avanti e le impostazioni possono essere aggiornati in un giorno. Uno dei trucchi principali è quello di prendere più dati possibili (10 anni di storia o più), in questo caso stiamo cercando dei modelli globali, e sono basati sulla fisica del mercato e nella maggior parte dei casi funzionano per un tempo molto lungo.

L'ho fatto, la qualità non è .....

Ho bisogno di ferro forte, ho il soffitto di ferro, ma c'è una soluzione a questo problema.

Se non l'hai letto, ti piacerà, sono sicuro che ha idee interessanti sui criteri di qualità del modello.

Ho bisogno di ferro forte, anch'io ho problemi con l'hardware, ma c'è una soluzione a questo problema.

Davvero ho bisogno di server) ma non li ho (ho appena fatto tutti questi su netbook morto), ho bisogno di tempo lungo e doloroso per leggere. Ma di per sé non c'è altro modo, o si prende la potenza da qualche parte e li si carica duramente, in questo caso bisogna controllare 20-30 configurazioni almeno, e meglio vicino al centinaio, e per ogni segnale appendere e monitorare, più stabile che passerà una selezione naturale e lasciare, poi provare ad aggiungere più potenza. Non c'è altro modo, altrimenti è solo una strada verso il nulla, come molti hanno già scritto qui... può davvero estendersi per molti anni senza sapere dove scavare. L'alternativa è una laurea in scienze del forum e chiacchiere sulle fasi della luna e la loro influenza sul mercato nello spirito degli spettacoli di Prokopenko ))). Qual è la soluzione se non un segreto?

Qual è la soluzione, se non è un segreto?

Nel libro che ho linkato, la soluzione è descritta in modo più intelligente... Raccomando davvero di leggerlo...

In termini semplici la soluzione è elementare, è necessario dividere il problema, ad esempio raggruppare i dati e addestrare modelli diversi per ogni cluster.

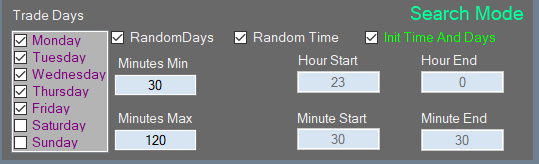

O un esempio ancora più semplice: ci sono 5 giorni di trading in una settimana, quindi alleniamo un modello al giorno per il lunedì, il secondo per il martedì, ecc. Quindi abbiamo ridotto il campione di allenamento 5 volte e abbiamo 2 anni di allenamento, non 10 anni, e così via dipende dalla nostra immaginazione.

Il libro che ho linkato descrive questa soluzione in modo più intelligente... Raccomando davvero di leggerlo...

In termini semplici, la soluzione è elementare: è necessario dividere il problema, per esempio raggruppare i dati e addestrare modelli diversi per ogni cluster.

O un esempio ancora più semplice: in una settimana di 5 giorni di trading, formiamo un modello rigorosamente per il lunedì, il secondo per il martedì, ecc. Si è scoperto di ridurre il campione di formazione di 5 volte e già 10 anni, e 2 anni di formazione, e così via è la fantasia ...

Non l'ho letto, ma è stato tutto implementato, l'ho fatto per lo stesso motivo, avevo bisogno di ridurre la dimensione del campione ma essere ancora in grado di analizzare in profondità nella storia, ma l'ho fatto sperimentalmente quando ho capito che non sono abbastanza forte nel mio computer e posso farlo meglio )))), più il multithreading e cose del genere... tutto per ottenere il massimo.

Non l'ho letto, ma è già stato implementato a casa mia. L'ho fatto per lo stesso motivo, dovevo ridurre il campionamento in qualche modo, ma essere ancora in grado di analizzare in profondità nella storia, ma ci sono arrivato sperimentalmente quando ho capito che il mio computer non è abbastanza forte e posso farlo meglio )))), più il multithreading e cose del genere... tutto per ottenere il massimo.

bene allora

)))

=====

Seriamente, il libro descrive come scaricare in modo più efficiente senza perdita di qualità, ma è improbabile che salvi ... Penso che sia ora di passare agli algoritmi euristici...

o qualcosa come una base di conoscenza, questa è la suddivisione più piccola, le mie idee e pensieri vanno in questa direzione, poiché le varianti di eventi e segni saranno per decine di gigabyte, e un modello con 20 milioni di segni non può essere addestrato...)) quindi una base di conoscenza mi sembra una via d'uscita dalla "maledizione della dimensione"

o qualcosa come una base di conoscenza, che è la cotta più piccola, le mie idee e pensieri vanno in quella direzione, dato che ci saranno decine di gigabyte di varianti di eventi e segni, e un modello con 20 milioni di segni non può essere addestrato...))

Dimenticate i cartelli. Per come la vedo io, è una quantità scalare (o in altre parole un'espressione matematica, anche se è logica, può essere ridotta ad una matematica, solo la precisione ne soffrirà). Tutti questi valori scalari o logici sono derivati dal prezzo, perché non abbiamo altri dati e cercare di usare altri dati potrebbe semplicemente peggiorare la previsione, perché i dati sono diversi e possono provenire da fonti diverse, nel qual caso non è chiaro a quali dati si debba dare la priorità. Qualsiasi serie numerica può contenere tutte le altre serie numeriche al suo interno, se si usano tutti i modi possibili di trasformare quella serie... cercate di capire questo. In questo caso, non date all'algoritmo questo spazio di caratteristiche ma lasciate che trovi queste caratteristiche da solo... non hai bisogno di nessuna base, hai bisogno di potenza. Se c'è un sistema e funziona almeno parzialmente, il passo successivo è la decentralizzazione dei calcoli. I lavoratori devono essere messi in rete e il database aiuterebbe, ma deve fungere da deposito per i risultati comuni. Questo suona già come una miniera.

Dimenticate gli attributi. La mia comprensione è che è una quantità scalare (o in altre parole un'espressione matematica, anche se è logica, può essere ridotta a matematica, solo la precisione ne soffrirà). Tutti questi valori scalari o logici sono derivati dal prezzo, perché non abbiamo altri dati e cercare di usare altri dati potrebbe semplicemente peggiorare la previsione, perché i dati sono diversi e possono provenire da diverse fonti, nel qual caso non è chiaro a quali dati si debba dare la priorità. Qualsiasi serie numerica può contenere tutte le altre serie numeriche al suo interno, se si usano tutti i modi possibili di trasformare quella serie... cercate di capire questo. In questo caso non c'è bisogno di dare all'algoritmo questo spazio di caratteristiche, bisogna lasciargli trovare queste caratteristiche da solo... non hai bisogno di nessuna base, hai bisogno di potenza. Se c'è un sistema e funziona almeno parzialmente, il passo successivo è la decentralizzazione dei calcoli. I lavoratori devono essere messi in rete e il database aiuterebbe, ma deve fungere da deposito per i risultati comuni. Questo suona già come una miniera.

Non capisco molto bene la tua visione, quindi non voglio discutere...

Vedo il mio algoritmo come una sequenza di eventi, l'evento è una regola di log, la sequenza non è temporizzata, o c'è o non c'è.

(come un trader che fissa un livello, il prezzo può raggiungerlo in 5 minuti o in un giorno, ma la situazione è la stessa)

Quindi l'insieme di tali sequenze di lavoro sarà TS.

Ma per trovare tali sequenze "non-dimensionali" abbiamo bisogno di passare attraverso trilioni di varianti, la soluzione che vedo - creare una base di conoscenza su un disco rigido...

Penso che tutti gli allenamenti "tipici" di qualsiasi algoritmo in una finestra mobile non siano varianti funzionanti, poiché il mercato non è stabile, l'output sarà una media mobile con una memoria del passato, che non si ripeterà mai nel futuro a causa della non stazionarietà...