Discussion de l'article "Algorithmes d'optimisation de la population : Essaim de Particules (OEP ou PSO en anglais)"

merci pour votre commentaire ! oui, il est possible de lier les coefficients aux itérations, comme c'est le cas dans l'algorithme d'optimisation d'une meute de loups gris. veuillez consulter mes articles suivants.

Malheureusement, tous les articles n'ont pas encore été publiés en anglais.

Population Optimization Algorithms : Ant Colony Optimization (ACO) : https://www.mql5.com/ru/articles/11602

Algorithmes d'optimisation de la population : Colonie d'abeilles artificielle (ABC) : https://www.mql5.com/ru/articles/11736

Algorithmes d'optimisation de la population : Optimisation par une meute de loups gris (GreyWolf Optimizer - GWO) : https://www.mql5.com/ru/articles/11785

Ces articles sur les techniques d'optimisation métaheuristiques sont géniaux ! Tu fais un travail formidable Andrey, c'est époustouflant la quantité d'expérience que tu as à partager avec nous, merci !

@METAQUOTES envisagez de mettre en œuvre ces objectifs d'optimisation métaheuristique dans l'optimiseur ! Ce serait formidable pour le logiciel.

Quelque chose de facile que l'utilisateur peut définir à l'intérieur de OnTester() comme :

OptimizerSetEngine("ACO"); // Optimisation par colonies de fourmis OptimizerSetEngine("COA"); // algorithme d'optimisation coucou OptimizerSetEngine("ABC")); // colonie d'abeilles artificielle OptimizerSetEngine("GWO"); // optimiseur loup gris OptimizerSetEngine("PSO"); // optimisation par essaims de particules

Merci du Brésil

Ces articles sur les techniques d'optimisation métaheuristiques sont géniaux ! Tu fais un travail formidable Andrey, c'est époustouflant la quantité d'expérience que tu as à partager avec nous, merci !

@METAQUOTES envisagez de mettre en œuvre ces objectifs d'optimisation métaheuristique dans l'optimiseur ! Ce serait génial pour le logiciel.

Quelque chose de facile que l'utilisateur peut définir à l'intérieur de OnTester() comme :

Merci du Brésil

- Applications de trading gratuites

- Plus de 8 000 signaux à copier

- Actualités économiques pour explorer les marchés financiers

Vous acceptez la politique du site Web et les conditions d'utilisation

Un nouvel article Algorithmes d'optimisation de la population : Essaim de Particules (OEP ou PSO en anglais) a été publié :

Dans cet article, j'examinerai l'algorithme populaire d'Optimisation par Essaims Particulaires (OEP ou Particle Swarm Optimization - PSO). Précédemment, nous avons abordé les caractéristiques importantes des algorithmes d'optimisation telles que la convergence, le taux de convergence, la stabilité et l'évolutivité, et nous avons développé un banc d'essai et examiné l'algorithme RNG le plus simple.

Étant donné que j'utilise la même structure de construction des algorithmes que dans le 1er article de la série (et que je continuerai à le faire à l'avenir), décrite dans la figure 2, il ne sera pas difficile pour nous de relier l'algorithme au banc d'essai.

Lors de l'exécution des tests, nous verrons des animations similaires à celles présentées ci-dessous. Grâce à cela, on voit clairement comment se comporte un essaim de particules. L'essaim se comporte vraiment comme un essaim dans la nature. Nous pouvons voir sur la carte thermique de la fonction qu’ils se déplace sous la forme d'un nuage dense.

Comme précédemment, le cercle noir représente l'optimum global (max) de la fonction, et le point noir représente les meilleures coordonnées moyennes de l'algorithme de recherche obtenues au moment de l'itération en cours. Laissez-moi vous expliquer d'où viennent les valeurs moyennes. La carte thermique est bidimensionnelle en coordonnées. La fonction optimisée peut comprendre des centaines de variables (mesures). La moyenne des résultats est donc calculée en fonction des coordonnées.

PSO sur la fonction de test Skin.

PSO sur la fonction de test Forest.

PSO sur la fonction de test Megacity.

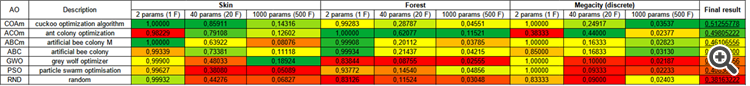

Comme vous pouvez le voir dans l'animation, les tests ont montré que le PSO s'adapte assez bien à la première fonction lisse, mais seulement lorsqu'il s'agit d'optimiser 2 variables. Avec l'augmentation de la dimension de l'espace de recherche, l'efficacité de l'algorithme diminue fortement. Ceci est particulièrement visible pour la 2ème et la 3ème fonction discrète. Les résultats sont nettement moins bons que ceux de l'algorithme aléatoire décrit dans l'article précédent. Nous reviendrons sur les résultats et nous en discuterons en détail lors de la constitution d'un tableau comparatif des résultats.

Auteur : Andrey Dik