Diskussion zum Artikel "Neuronale Netze leicht gemacht (Teil 38): Selbstüberwachte Erkundung bei Unstimmigkeit (Self-Supervised Exploration via Disagreement)"

Hallo. Es wird bereits zu einem Glücksspiel, eine weitere Ihrer Kreationen zu starten. Ich bin kein Experte in Sachen Programmierung, aber zumindest konnte ich die Tiefe des Themas und seine Weite einschätzen. Ich habe es im Strategietester mit Batch-Optimierung von 100 auf 110 laufen lassen. Der Indikator im Tray läuft und sonst passiert 12 Stunden lang nichts. Was mache ich falsch?

Ich werde mir die Änderungen in dieser Datei im Vergleich zu den letzten ansehen. Ich habe das gleiche Problem gesehen.

Wenn ich versuche, den Indikator aus MT5 zu entfernen oder wenn ich im Meta-Editor debugge, stürzt MetaTrader5 sofort ab.

Er läuft nicht, auch nicht nach vielen Stunden.

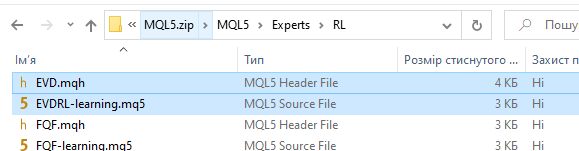

Ihr Link hat den besagten EA nicht!!! Es gibt nur den alten aus dem letzten Artikel. Zuerst dachte ich, dass du einfach vergessen hast, den Namen beim Kopieren zu ändern, aber beim Vergleichen fand ich eine vollständige Übereinstimmung des Codes!!!! CARAUL!!!

Im Archiv am Ende des Artikels ist ein kompletter Satz von Dateien angehängt. Es sind Expert Advisors aus früheren Artikeln. Aber es gibt auch den im Artikel erwähnten Expert Advisor.

Entschuldigung, noch eine Amateurfrage. Der Expert Advisor hat im Tester nicht einen einzigen Handel getätigt. Er hängt einfach auf dem Chart ohne Anzeichen von Aktivität. Warum eigentlich?

Und noch eine Sache. Werden Indikatordaten nur als zusätzlicher Filter verwendet, wenn ein Handel durchgeführt wird?

Vielen Dank für diesen Artikel!

Ich sehe, dass Sie auch eine Zip-Datei mit vielen RL-Experimenten darin anbieten. Gibt es eine bestimmte mq5-Datei, die ich kompilieren, ausführen und genauer auswerten kann?

Herzlichen Dank!

Vielen Dank für diesen Artikel!

Ich sehe, dass Sie auch eine Zip-Datei mit vielen RL-Experimenten anbieten. Gibt es eine bestimmte mq5-Datei, die ich kompilieren, ausführen und genauer auswerten kann?

Herzlichen Dank!

Hallo, ja das können Sie. Im Anhang alle Dateien aus früheren Artikeln.

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Neuer Artikel Neuronale Netze leicht gemacht (Teil 38): Selbstüberwachte Erkundung bei Unstimmigkeit (Self-Supervised Exploration via Disagreement) :

Eines der Hauptprobleme beim Verstärkungslernen ist die Erkundung der Umgebung. Zuvor haben wir bereits die Forschungsmethode auf der Grundlage der intrinsischen Neugier kennengelernt. Heute schlage ich vor, einen anderen Algorithmus zu betrachten: Erkundung bei Unstimmigkeit.

Eine Erkundung auf Basis von Unstimmigkeiten ist eine Methode des Reinforcement Learning, die es einem Agenten ermöglicht, seine Umgebung zu erkunden, ohne sich auf externe Belohnungen zu verlassen, sondern indem er mit Hilfe eines Ensembles von Modellen neue, unerforschte Gebiete findet.

In dem Artikel „Self-Supervised Exploration via Disagreement“ beschreiben die Autoren diesen Ansatz und schlagen eine einfache Methode vor: Training eines Ensembles von Vorwärtsdynamikmodellen und Ermutigung des Agenten, den Handlungsraum zu erkunden, in dem die maximale Inkonsistenz oder Varianz zwischen den Vorhersagen der Modelle im Ensemble besteht.

Anstatt also Aktionen zu wählen, die den größten erwarteten Gewinn bringen, wählt der Agent Aktionen, die die Unstimmigkeit zwischen den Modellen im Ensemble maximieren. Dies ermöglicht es dem Agenten, Regionen des Zustandsraums zu erkunden, in denen die Modelle des Ensembles nicht übereinstimmen und in denen es wahrscheinlich neue und unerforschte Regionen der Umgebung gibt.

In diesem Fall konvergieren alle Modelle des Ensembles zum Mittelwert, was letztlich die Streuung des Ensembles verringert und dem Agenten genauere Vorhersagen über den Zustand der Umwelt und die möglichen Folgen von Handlungen ermöglicht.

Darüber hinaus ermöglicht der Algorithmus der Erkundung durch Unstimmigkeit dem Agenten, erfolgreich mit der Stochastizität der Interaktion mit der Umwelt umzugehen. Die Ergebnisse der von den Autoren des Artikels durchgeführten Experimente haben gezeigt, dass der vorgeschlagene Ansatz die Exploration in stochastischen Umgebungen tatsächlich verbessert und die bisher existierenden Methoden der intrinsischen Motivation und der Unsicherheitsmodellierung übertrifft. Darüber hinaus haben sie festgestellt, dass ihr Ansatz auf überwachtes Lernen ausgeweitet werden kann, bei dem der Wert eines Beispiels nicht auf der Grundlage der Grundwahrheit, sondern auf der Grundlage des Zustands des Ensembles von Modellen bestimmt wird.

Somit stellt der Algorithmus der Exploration durch Unstimmigkeit einen vielversprechenden Ansatz zur Lösung des Explorationsproblems in stochastischen Umgebungen dar. Sie ermöglicht es dem Agenten, die Umgebung effizienter zu erkunden, ohne auf externe Belohnungen angewiesen zu sein, was in realen Anwendungen, in denen externe Belohnungen begrenzt oder kostspielig sein können, besonders nützlich ist.

Darüber hinaus kann der Algorithmus in einer Vielzahl von Kontexten angewendet werden, einschließlich der Arbeit mit hochdimensionalen Daten wie Bildern, bei denen die Messung und Maximierung der Modellunsicherheit eine besondere Herausforderung darstellen kann.

Die Autoren des Artikels demonstrierten die Effektivität des vorgeschlagenen Algorithmus bei verschiedenen Problemen, darunter Robotersteuerung, Atari-Spiele und Labyrinth-Navigationsaufgaben. Als Ergebnis ihrer Forschung zeigten sie, dass der Algorithmus der Exploration durch Unstimmigkeit andere Explorationsmethoden in Bezug auf Geschwindigkeit, Konvergenz und Lernqualität übertrifft.

Somit stellt dieser Ansatz der Erkundung durch Unstimmigkeit einen wichtigen Schritt auf dem Gebiet des Verstärkungslernens dar, der den Agenten helfen kann, die Umwelt besser und effizienter zu erkunden und bessere Ergebnisse bei verschiedenen Aufgaben zu erzielen.

Autor: Dmitriy Gizlyk