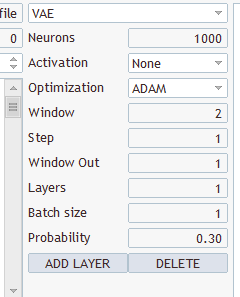

Для тестирования была создана сверточная модель следующей архитектуры:

- Слой исходных данных, 240 элементов (20 свечей, по 12 нейронов на описание одной свечи).

- Сверточный слой, окно исходных данных 24 (2 свечи), шаг 12 (1 свеча), на выходе 6 фильтров.

- Сверточный слой, окно исходных данных 2, шаг 1, 2 фильтра.

- Сверточный слой, окно исходных данных 3, шаг 1, 2 фильтра.

- Сверточный слой, окно исходных данных 3, шаг 1, 2 фильтра.

- Полносвязный нейронный слой на 1000 элементов.

- Полносвязный нейронный слой на 1000 элементов.

- Полносвязный слой из 3 элементов (слой результатов на 3 действия).

Кто-нибудь понял, как это сделать?

Есть Трансфер Лернинг, работает, скомпилировался, но как на нём создать такую модель?

Кто-нибудь понял, как это сделать?

Есть Трансфер Лернинг, работает, скомпилировался, но как на нём создать такую модель?

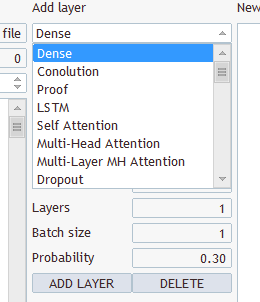

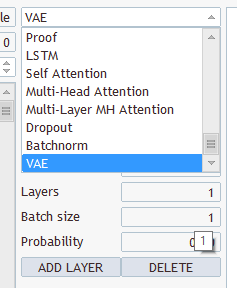

1. Запускаете TransferLearning.

2. Никакую модель НЕ открываете.

3. Просто накидываете новую модель, как добавление новые нейронные слои.

4. Нажимаете сохранить модель и указываете имя файла, который будете загружать из программы.

1. Запускаете TransferLearning.

2. Никакую модель НЕ открываете.

3. Просто накидываете новую модель, как добавление новые нейронные слои.

4. Нажимаете сохранить модель и указываете имя файла, который будете загружать из программы.

Какие именно слои и что выбирать? У Вас там несколько видов и несколько параметров

Выбираешь любые, сохраняешь под "EURUSD_PERIOD_H1_Q-learning.nnw", запускаешь Q-learning.mq5, тот в логе пишет

2022.10.14 15:09:51.743 Experts initializing of Q-learning (EURUSD,H1) failed with code 32767 (incorrect parameters)

А во во вкладке эксперты:

2022.10.14 15:09:51.626 Q-learning (EURUSD,H1) OpenCL: GPU device 'NVIDIA GeForce RTX 3080' selected

2022.10.14 15:09:51.638 Q-learning (EURUSD,H1) EURUSD_PERIOD_H1_Q-learning.nnw

Здравствуйте, господин Гизлик, прежде всего, я хотел бы поблагодарить вас за вашу хорошо обоснованную серию статей. Однако мне, как новичку, приходится сталкиваться с некоторыми проблемами в понимании вашей текущей статьи. После того как я смог восстановить файл VAE.mqh и класс CBufferDouble из ваших предыдущих статей, я могу скомпилировать ваш пример приложения из этой статьи. Для проверки я попытался создать сеть с помощью вашей программы NetCreater. После многих попыток я отказался от этой затеи. Сохраненные сети не были приняты вашим приложением из этой статьи. Не могли бы вы также предложить созданную вами сеть для скачивания? Еще раз спасибо за вашу работу!

Здравствуйте, господин Гизлик, прежде всего, я хотел бы поблагодарить вас за вашу хорошо обоснованную серию статей. Однако мне, как новичку, приходится сталкиваться с некоторыми проблемами в понимании вашей текущей статьи. После того как я смог восстановить файл VAE.mqh и класс CBufferDouble из ваших предыдущих статей, я могу скомпилировать ваш пример приложения из этой статьи. Для проверки я попытался создать сеть с помощью вашей программы NetCreater. После многих попыток я отказался от этой затеи. Сохраненные сети не были приняты вашим приложением из этой статьи. Не могли бы вы также предложить созданную вами сеть для скачивания? Еще раз спасибо за вашу работу!

Добрый день!

После обучения не сохраняется, обученная модель:,

2024.06.01 01:12:26.731 Q-learning (XAUUSD_t,H1) XAUUSD_t_PERIOD_H1_Q-learning.nnw

2024.06.01 01:12:26.833 Q-learning (XAUUSD_t,H1) Iteration 980, loss 0.75659

2024.06.01 01:12:26.833 Q-learning (XAUUSD_t,H1) ExpertRemove() function called

Пробую запустить тестер ошибка:

2024.06.01 01:16:31.860 Core 1 2024.01.01 00:00:00 XAUUSD_t_PERIOD_H1_Q-learning-test.nnw

2024.06.01 01:16:31.860 Core 1 tester stopped because OnInit returns non-zero code 1

2024.06.01 01:16:31.861 Core 1 disconnected

2024.06.01 01:16:31.861 Core 1 connection closed

Помогите пожалуйста кто сталкивался с таких как решили проблему?

- Бесплатные приложения для трейдинга

- 8 000+ сигналов для копирования

- Экономические новости для анализа финансовых рынков

Вы принимаете политику сайта и условия использования

Опубликована статья Нейросети — это просто (Часть 27): Глубокое Q-обучение (DQN):

Продолжаем изучение обучения с подкреплением. И в этой статье мы познакомимся с методом глубокого Q-обучения. Использование данного метода позволило команде DeepMind создать модель, способную превзойти человека при игре в компьютерные игры Atari. Думаю, будет полезно оценить возможности подобной технологии для решения задач трейдинга.

Вероятно, Вы уже догадались, что глубокое Q-обучение подразумевает использование нейронной сети для аппроксимации Q-функции. В чем же преимущество такого подхода? Давайте вспомним реализацию табличного метода кросс-энтропии в прошлой статье. Помните, в ней я акцентировал внимание, что реализация табличного метода предполагает конечное количество возможных состояний и действий. Мы, конечно, ограничили число возможных состояний с помощью кластеризации исходных данных. Но так ли это хорошо? Всегда ли кластеризация нам даст лучшие результаты? В то же время, использование нейронной сети перед нами не ставит ограничения по числу возможных состояний. И мне кажется, что в случае решения задач трейдинга это большой плюс.

И тут кажется вполне очевидным подход взять и заменить таблицу из предыдущей статьи на нейронную сеть. Но, к сожалению, не все так просто. На практике оказалось, что такой подход не так хорош, как кажется вначале. Для реализации подхода нам потребуется добавить несколько эвристик.

Вначале давайте посмотрим на цель обучения нашего агента. В общем случае его цель максимизация совокупной награды. Посмотрите на рисунок ниже. Агенту предстоит перейти из клетки Start в клетку Finish. Награду агент получает одноразово при попадании в клетку Finish. Во всех остальных состояниях награда нулевая.

На рисунке представлено 2 пути. Для нас очевидно, что оранжевый путь короче и более предпочтителен. Но с точки зрения максимизации награды они равнозначны.

Автор: Dmitriy Gizlyk