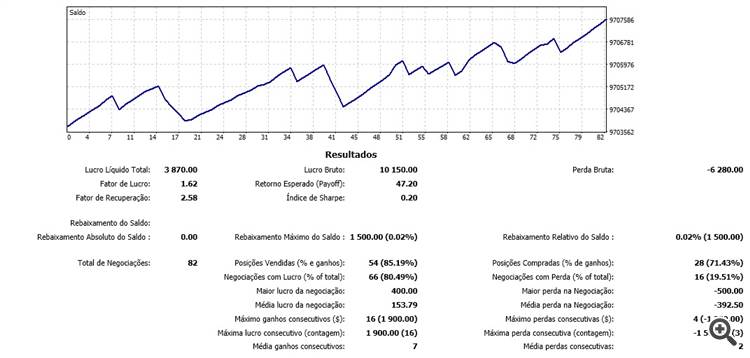

Muito obrigado por seus artigos. Seus algoritmos são muito bons, para mim são os melhores algoritmos do mql5 para redes neurais, pois permitem atualizar a rede em tempo real, durante o mercado, linha por linha. Estou testando seus algoritmos no mercado futuro brasileiro e os resultados são animadores, a previsão atingiu uma eficiência de mais de 80% nas últimas 100 barras, o que levou a negociações positivas. Aguardo ansiosamente o próximo artigo.

Novo artigo Redes neurais facilitadas (Parte 11): A take on GPT foi publicado:

Autor: Dmitriy Gizlyk

Material interessante, mas o código está todo em uma enorme tigela de espaguete, muito difícil de entender. Uma classe por arquivo teria sido mais fácil.

Seria bom ter um diagrama mostrando como todas as classes são mantidas juntas.

No momento, estou no NeuronBase, que é derivado do Object, mas usa o NeuronProof, que é derivado do NeuronBase, e também o Layer, que usa praticamente todos os tipos de classe Neuron definidos.

É necessário fazer muitas declarações para colocar tudo em arquivos separados e começar a lidar com isso.

Talvez seja mais fácil começar do zero e usar os conceitos que você explicou nos vários capítulos.

Tentei executar o spaghetti bowl, que fez minha GPU fumegar e, infelizmente, não produziu nada muito útil.

De qualquer forma, obrigado pelo excelente material.

:-)

O material é interessante, mas o código está todo em uma enorme tigela de espaguete, o que dificulta muito a compreensão. Uma classe por arquivo teria sido mais fácil.

Seria bom ter um diagrama mostrando como todas as classes são mantidas juntas.

No momento, estou no NeuronBase, que é derivado do Object, mas usa o NeuronProof, que é derivado do NeuronBase, e também o Layer, que usa praticamente todos os tipos de classe Neuron definidos.

É necessário fazer muitas declarações para colocar tudo em arquivos separados e começar a lidar com isso.

Talvez seja mais fácil começar do zero e usar os conceitos que você explicou nos vários capítulos.

Tentei executar o spaghetti bowl, que fez minha GPU soltar fumaça e, infelizmente, não produziu nada muito útil.

De qualquer forma, obrigado pelo excelente material.

:-)

Olá,

Verifique o arquivo NN.chm. Talvez ele possa lhe ajudar.

Hi,

Sim, obrigado.

O código não está tão ruim agora e posso ver claramente como alterar a arquitetura da rede, se necessário.

Tenho tudo em arquivos de classe separados, além de uma tigela de espaguete muito menor, o que ainda é necessário porque o mt5 tem tanto a definição quanto as implementações nos mesmos arquivos.

Tentei fazer algum treinamento em GBPUSD usando o código como está, mas os resultados não parecem ser bons: o erro sobe de 50% para 70% e permanece lá, sem melhora nas épocas subsequentes.

Alguma sugestão de onde começar a fazer os ajustes?

A propósito, esta linha:

#define FileName Symb.Name()+"_"+EnumToString((ENUM_TIMEFRAMES)Period())+"_"+IntegerToString(HistoryBars,3)+StringSubstr(__FILE__,0,StringFind(__FILE__,".",0))

Precisa ser corrigida para:

#define FileName Symb.Name()+"_"+EnumToString((ENUM_TIMEFRAMES)Period())+"_"+IntegerToString(HistoryBars)+StringSubstr(__FILE__,0,StringFind(__FILE__,".",0))

No início, eu não estava entendendo o artigo, porque não estava entendendo a ideia principal.

Quando perguntei ao próprio ChatGPT sobre esse texto, ele esclareceu bastante as coisas e eu entendi a maior parte do que estava lendo:

"O algoritmo Transformer é um modelo usado para processar linguagem natural, ou seja, texto. Esse modelo divide o texto em uma sequência de palavras (ou "tokens") e, em seguida, executa uma série de operações em cada uma dessas palavras para entender melhor seu significado.

Uma das operações que o modelo executa é a autoatenção, que consiste em calcular a importância que cada palavra tem em relação às outras palavras da sequência. Para fazer isso, o modelo usa três vetores: o vetor de consulta, o vetor-chave e o vetor de valor, que são calculados para cada palavra.

Em seguida, o modelo calcula a atenção, que é a importância que cada palavra tem em relação às outras palavras da sequência. Ele usa uma função matemática chamada softmax para normalizar os coeficientes de atenção.

Por fim, o modelo combina todas as operações de autoatenção para produzir um resultado final, que é usado para prever o significado do texto.

Em resumo, o algoritmo Transformer usa operações matemáticas complexas para entender o significado do texto."

- Aplicativos de negociação gratuitos

- 8 000+ sinais para cópia

- Notícias econômicas para análise dos mercados financeiros

Você concorda com a política do site e com os termos de uso

Novo artigo Redes Neurais de Maneira Fácil (Parte 11): Uma visão sobre a GPT foi publicado:

Talvez um dos modelos mais avançados entre as redes neurais de linguagem atualmente existentes seja a GPT-3, cuja variante máxima contém 175 bilhões de parâmetros. Claro, nós não vamos criar tal monstro em nossos PCs domésticos. No entanto, nós podemos ver quais soluções arquitetônicas podem ser usadas em nosso trabalho e como nós podemos nos beneficiar delas.

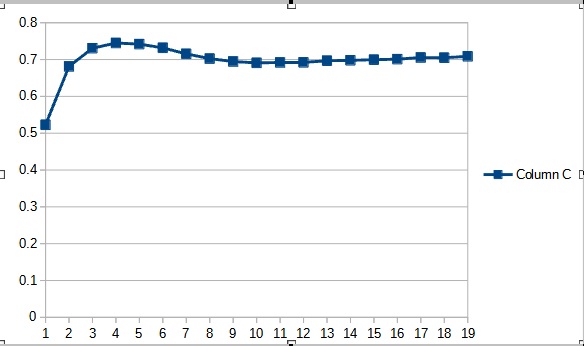

A nova classe da rede neural foi testada no mesmo conjunto de dados, que foi usado nos testes anteriores: EURUSD com o intervalo de tempo H1, os dados históricos das últimas 20 velas são alimentadas na rede neural.

Os resultados do teste confirmaram a suposição de que mais parâmetros requerem um período de treinamento mais longo. Nas primeiras épocas de treinamento, um Expert Advisor com menos parâmetros mostra resultados mais estáveis. No entanto, conforme o período de treinamento é estendido, um Expert Advisor com muitos parâmetros mostram melhores valores. Em geral, após 33 épocas o erro do Fractal_OCL_AttentionMLMH_v2 diminuiu abaixo do nível de erro do EA Fractal_OCL_AttentionMLMH, e ainda permaneceu baixo.

Autor: Dmitriy Gizlyk