Discusión sobre el artículo "Redes neuronales: así de sencillo (Parte 25): Practicando el Transfer Learning"

Hola dimitry

¡Realmente aprecio mucho esta serie de artículos! ¡Thank you for that! Pero por favor ayuda con este problema:

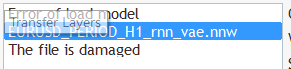

Si cargo el archivo "EURUSD_PERIOD_H1_rnn_vae.nn" como se menciona en este artículo, me sale el mensaje "Error de modelo de carga" y "El archivo está dañado":

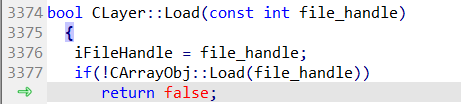

Si rastreo, encuentro el fallo de carga en esta línea en NeuroNet.mqh:

Si cargo el modelo de la parte 23, llamado "EURUSD_i_PERIOD_H1_test_rnn.nnw" parece que funciona, pero este modelo sólo tiene dos capas. Esta no es la correcta. ¿Me he perdido algo?

Si cargo el archivo "EURUSD_PERIOD_H1_rnn_vae.nn" como se menciona en este artículo, obtengo el mensaje "Error de modelo de carga" y "El archivo está dañado":

Si cargo el modelo de la parte 23, llamado "EURUSD_i_PERIOD_H1_test_rnn.nnw" parece que funciona, pero sólo tiene dos capas. Esta no es la correcta. ¿Me he perdido algo?

Hola,

Para cargar el archivo "EURUSD_PERIOD_H1_rnn_vae.nnw" necesitas recompilar NetCreator con la nueva librería NeuroNet.mqh. En el último modelo que reemplazar CBufferDouble a CBufferFloat. Y añadir algunos tipos de capa.

Puede descargar la última versión de los archivos hear.

en la última versión de NeuroNet.mqh hay una advertencia crítica en la página 2501 :

página 2501 if(inputs.AssingnArray(input Vals) || ...... )

comportamiento obsoleto, método oculto callinq se desactivará en una futura versión del compilador MQL.

en la última versión de NetCreatorPanel.mqh hay 21 advertencias críticas. A partir de la página 940

página 935 cadena temp;

página 936 ArrayFree(resultado);

página 937 switch(layr.type);

página 938 {

página 939 case defNeuronBaseOCL :

página 940 temp = StringFormat ("Dense (outputs %d, \ activation %s, \ optimisation %s)", ..... )

Warning- 'a' secuencia de escape de caracteres no reconocida

o' secuencia de caracteres no reconocida

Como resultado de todas estas advertencias, ¡el archivo "_rnn.nnw" no se cargará!

En la versión antigua (parte 24) después de chamanear con errores el mismo fichero "_rnn.nnw" se cargaba en NetCreatorPanel.mqh y era posible crear una nueva red.

Pero no fue posible probarla. ¡Hay 2 advertencias críticas en el archivo check_net!

función Train página 222 y página 307

página 219 for(int res = 0; (res <3 && sum >0); res++)

página 220 TempData. Update(res, TempData, At(res) /sum);

p 222 switch(TempData.Máximo(0,3))

Advertencia - comportamiento obsoleto, el método oculto callinq se desactivará en una futura versión del compilador MQL.

Y el registro muestra falló con el código 32767 (parámetros incorrectos)

Tengo MetaTrader build 5120.

¡¡¡Consejo!!! ¿Es posible resolver el problema con advertencias? En mi opinión, para los tontos como yo, esta es una

es la leccion clave, sin dominarla, lo unico que se puede hacer es parar.

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Usted acepta la política del sitio web y las condiciones de uso

Artículo publicado Redes neuronales: así de sencillo (Parte 25): Practicando el Transfer Learning:

En los últimos dos artículos, hemos creado una herramienta que nos permite crear y editar modelos de redes neuronales. Ahora es el momento de evaluar el uso potencial de la tecnología de Transfer Learning en ejemplos prácticos.

Podemos ver los resultados de la prueba en el siguiente gráfico. Como podemos ver, el modelo preentrenado ha comenzado con un error menor, pero pronto ambos modelos se estabilizan y además sus valores se aproximan bastante. Esto confirma la conclusión anterior: la arquitectura del codificador tiene un impacto significativo en el rendimiento de todo el modelo.

También debemos destacar la tasa de aprendizaje. Durante las pruebas, el modelo preentrenado ha necesitado 6 veces menos tiempo para pasar una época. Obviamente, aquí hemos tomado en cuenta el tiempo puro, sin considerar el coste de entrenamiento del autocodificador.

Autor: Dmitriy Gizlyk