Diskussion zum Artikel "Neuronale Netze im Handel: Maskenfreier Ansatz zur Vorhersage von Preisentwicklungen"

Hallo Dmitriy,

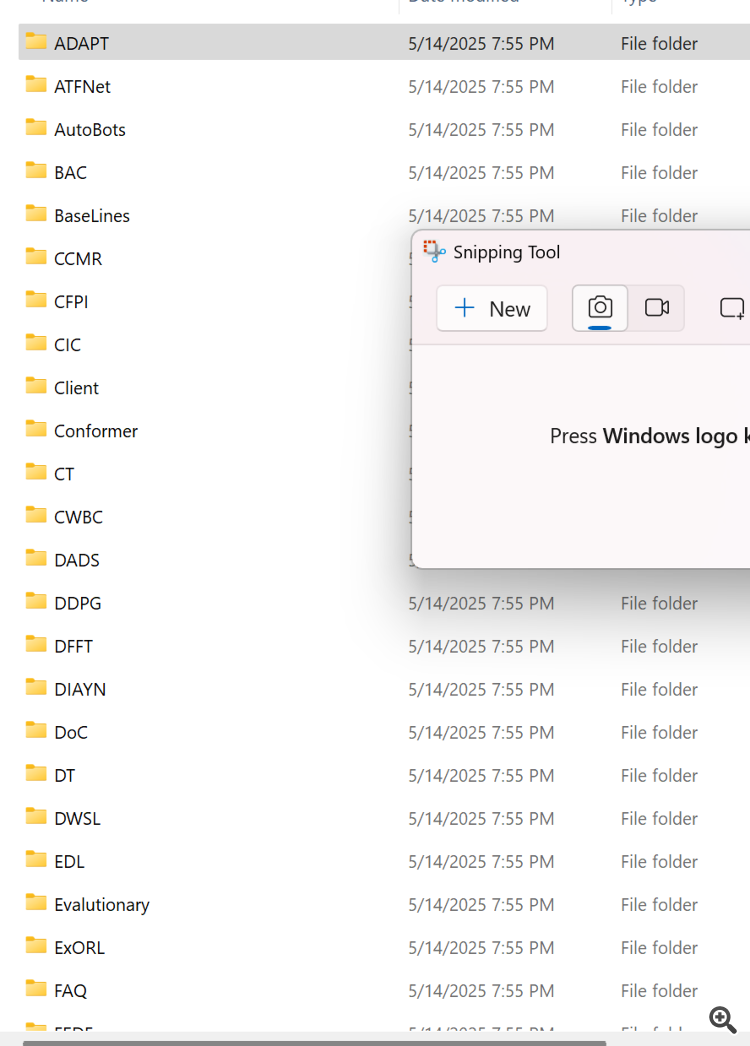

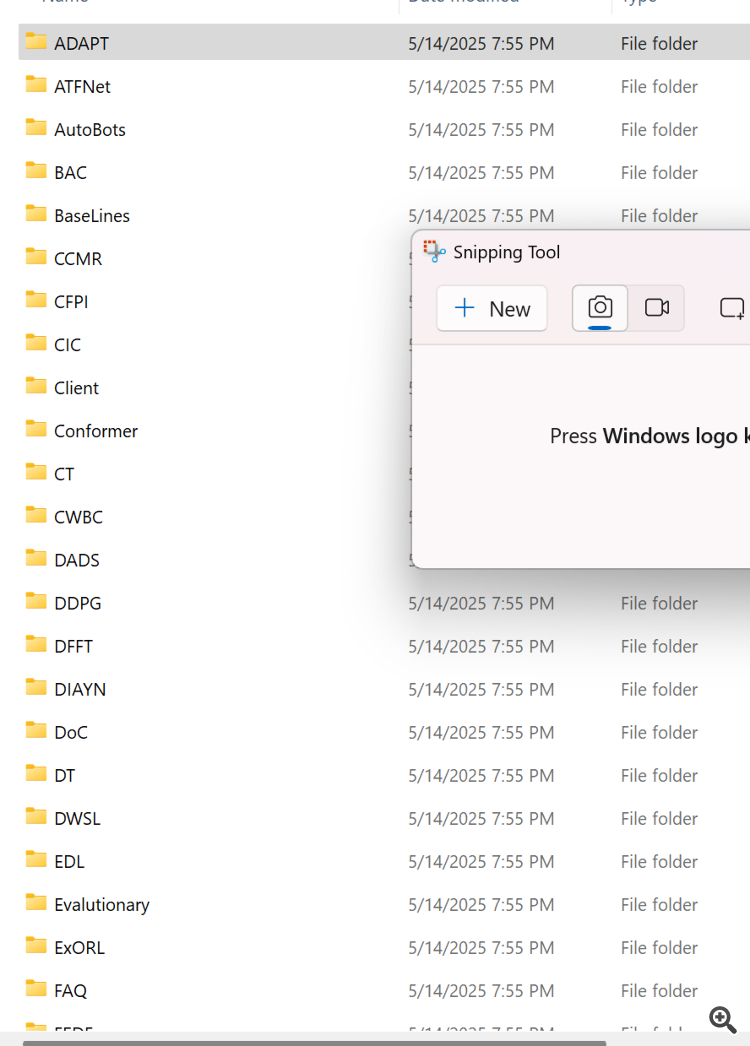

es scheint, als ob Ihre Zip-Dateien nicht korrekt erstellt wurden. Ich habe erwartet, dass der Quellcode in Ihrer Box aufgelistet ist, stattdessen ist das, was die Zip-Datei enthält. Es scheint, dass jedes aufgelistete Verzeichnis die Dateien enthält, die Sie in Ihren verschiedenen Artikeln verwendet haben. Könnten Sie eine Beschreibung der einzelnen Verzeichnisse zur Verfügung stellen oder noch besser, die Artikelnummer an jedes Verzeichnis anhängen.

Vielen Dank

CapeCoddah

Hallo Dmitrij,

es scheint, als ob Ihre Zip-Dateien nicht korrekt erstellt wurden. Ich habe erwartet, dass der Quellcode in Ihrer Box aufgelistet ist, stattdessen ist das, was die Zip-Datei enthält. Es scheint, dass jedes aufgelistete Verzeichnis die Dateien enthält, die Sie in Ihren verschiedenen Artikeln verwendet haben. Könnten Sie eine Beschreibung der einzelnen Verzeichnisse zur Verfügung stellen oder noch besser, die Artikelnummer an jedes Verzeichnis anhängen.

Vielen Dank

CapeCoddah

Hallo CapeCoddah,

Die Zip-Datei enthält Dateien aus allen Serien. Das OpenCL-Programm ist in "MQL5\Experts\NeuroNet_DNG\NeuroNet.cl" gespeichert. Die Bibliothek mit allen Klassen findet man in "MQL5\Experts\NeuroNet_DNG\NeuroNet.mqh". Und das Modell und die Experten, auf die sich dieser Artikel bezieht, befinden sich im Verzeichnis "MQL5\Experts\MAFT\".

Mit freundlichen Grüßen,

Dmitriy.

Hallo CapeCoddah,

Die Zip-Datei enthält Dateien aus allen Serien. Das OpenCL-Programm ist in "MQL5\Experts\NeuroNet_DNG\NeuroNet.cl" gespeichert. Die Bibliothek mit allen Klassen findet man in "MQL5\Experts\NeuroNet_DNG\NeuroNet.mqh". Und Modell und Experten, auf die in diesem Artikel verwiesen wird, befinden sich im Verzeichnis "MQL5\Experts\MAFT\"

Mit freundlichen Grüßen,

Dmitriy.

Hallo Dmitriy,

Danke für die prompte Antwort. Ich verstehe, was Sie sagen, aber ich glaube, Sie haben mich missverstanden. Wie verbinde ich die Namen der Unterverzeichnisse mit den entsprechenden Artikeln, entweder nach Namen oder nach Artikelnummern, nach denen ich suchen kann, um den Artikel zu finden.

Vielen Dank

CapeCoddah

Hallo Dmitriy,

Danke für die prompte Antwort. Ich verstehe, was du sagst, aber ich glaube, du hast mich falsch verstanden. Wie verbinde ich die Namen der Unterverzeichnisse mit den entsprechenden Artikeln, entweder nach Namen oder nach Artikelnummern, nach denen ich suchen kann, um den Artikel zu finden.

Vielen Dank

CapeCoddah

Nach dem Namen des Frameworks

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Neuer Artikel Neuronale Netze im Handel: Maskenfreier Ansatz zur Vorhersage von Preisentwicklungen :

Der SPFormer-Algorithmus stellt eine vollständige Ende-zu-Ende-Pipeline dar, mit der Objektabfragen direkt Instanzvorhersagen erzeugen können. Mit Hilfe von Transformer-Decodern werden durch eine feste Anzahl von Objektabfragen globale Objektinformationen aus der analysierten Punktwolke aggregiert. Darüber hinaus nutzt SPFormer Objektmasken, um die Kreuzaufmerksamkeit zu steuern, sodass die Abfragen nur auf maskierte Merkmale ausgerichtet sind. In der Anfangsphase der Ausbildung sind diese Masken jedoch von geringer Qualität. Dies beeinträchtigt die Leistung in den nachfolgenden Schichten und erhöht die Gesamtkomplexität des Trainings.

Um dieses Problem zu lösen, führen die Autoren der MAFT-Methode eine Hilfsaufgabe zur Zentrumsregression ein, um die Segmentierung der Instanzen zu steuern. Zunächst werden globale Positionen 𝒫 aus der Rohpunktwolke ausgewählt und globale Objektmerkmale ℱ über ein Backbone-Netzwerk extrahiert. Dies können Voxel oder Superpunkte sein. Zusätzlich zu den Inhaltsabfragen 𝒬0c führen die Autoren von MAFT eine feste Anzahl von Positionsabfragen 𝒬0p ein, die normalisierte Objektzentren darstellen. Während 𝒬0p zufällig initialisiert wird, ist 𝒬0c beginnt mit Nullwerten. Das Hauptziel besteht darin, dass die Positionsabfragen die entsprechenden kontextuellen Abfragen bei der Kreuzaufmerksamkeit leiten, gefolgt von einer iterativen Verfeinerung beider Abfragesätze, um Objektzentren, Klassen und Masken vorherzusagen.

Autor: Dmitriy Gizlyk