Was soll in den Eingang des neuronalen Netzes eingespeist werden? Ihre Ideen... - Seite 68

Sie verpassen Handelsmöglichkeiten:

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Registrierung

Einloggen

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Wenn Sie kein Benutzerkonto haben, registrieren Sie sich

Zum Beispiel: das Verhältnis des aktuellen Preises zu den letzten N Kerzen. Oder alle die gleiche chronologische Reihenfolge, aber mit der obligatorischen Beziehung zu den jüngsten Daten: wenn es der Preis ist - die Reflexion des Inkrements des jüngsten Preises mit dem Rest. Und dann die "toten" unrentabel Chronologie beginnt zum Leben zu erwecken.

Wie haben Sie das früher gemacht? Haben Sie absolute Kurswerte zum Üben vorgelegt? Zum Beispiel 1,14241, 1,14248.

Was Sie beschrieben haben, sind relative Preise. Sie können die Differenz (Delta) des aktuellen Preises zu anderen Bars oder Ratio, wie Sie beschrieben.

Ich habe immer auf Deltas trainiert. Das Ergebnis ist das gleiche...

Wie haben Sie das früher gemacht? Haben Sie der Studie absolute Preise vorgelegt? Zum Beispiel 1,14241, 1,14248.

Was Sie beschrieben haben, sind relative Preise. Sie können die Differenz (Delta) des aktuellen Preises zu anderen Bars oder Verhältnis, wie Sie beschrieben.

Ich habe immer auf Deltas trainiert. Das Ergebnis ist das gleiche...

Die Eingabe istnicht die Stärke des Signals

Seine Stärke wird ihm durch Gewichte gegeben. Aber die Eingangszahl selbst trägt a priori bereits(!) ein Kraftelement in sich - ihren quantitativen Faktor.Vorhin habe ich das Problem des Verständnisses von Eingabedaten angesprochen: Indem wir der Eingabe eine Zahl geben, verleihen wir der Eingabe bereits einen Kraftwert.

Das ist ein Fehler, denn das Wesen unserer NS besteht nur darin, den Kraftfaktor zu finden und ihn auf die Eingänge zu verteilen. 0,9 für den Eingang - das ist gleichbedeutend mit der Tatsache, dass das Signal extrem stark ist. Und dann gibt es berechtigte Fragen: 1) Warum ist es stark? 2) Wo ist es stark? Kaufen? Sitzen? Halten? Close Buy?

Close Sel? Der numerische Wert für die Eingabe ist also bereits fertig "nachbearbeitet" und gibt die Signalstärke vor. Aber es hindert den NS daran, mit den Daten zu arbeiten.

Dies ist das eigentliche"Rauschen", dessen Wesen "Interferenz", "Unschärfe", "Verschlechterung", "Verschlüsselung" ist. Dies ist gleichbedeutend mit einer zufälligen Initialisierung der Skalen vor der ersten Epoche des Lernens.

Nur bei den Gewichten ist es wichtig, aber bei den Eingaben ist es gewolltes Rauschen. Und dann hat der NS die Aufgabe, die Eingabedaten zu "bereinigen", anstatt sie zu lernen. Und jetzt kommen wir tatsächlich zur destruktiven Funktion von numerischen Daten:Wenn die Zahl 0,9 als Eingabe gegeben wird, was bedeutet sie dann? "Aktiv KAUFEN"?

"Aus der Sicht eines jeden Oszillators mit einem Bereich von 0 bis 1 ist es entweder strikt KAUFEN oder striktVERKAUFEN, je nach.... dem Trader!

Nur er "verleiht" den Oszillatoren magische Signale, wenn er seine Handelsstrategie aufbaut. In der Praxis bedeuten diese Zahlen absolut nichts.

Jeder Programmierer/Codierer wird die gesamte Historie durchgehen und sehen, dass diese Signale zufällig sind. Wenn die Zahl 0,9 eingegeben wird, was bedeutet sie dann?

Der NS hat die Möglichkeit, sie mit Gewichten deutlich "abzuschwächen". Was bedeutet das?

In Anbetracht der Tatsache, dass die Gewichte in allen Architekturen statisch sind, führt dies dazu, dass Zahlen, die kleiner als 0,9 sind, mit einer signifikanten Abschwächung das neuronale Netz NICHT funktionieren. Sie haben einfach keinen Einfluss auf die Gesamtleistung, da sich die Gesamtsumme im Addierer nur unwesentlich verschiebt. Stellen Sie sich vor, das NS hat ein Gewicht von 0,1 auf die eingegebene Zahl gesetzt, das ein Maximum von "1" hat, was zur Folge hat, dass, wenn die Eingabe 0,9 ist, die Zahl 0,09 wird.

Wenn die Eingabe 0,9 ist, wird die Zahl 0,09, und wenn 0,1 kommt, wird die Zahl 0,01. Buchstäblich ALLE Bereiche unter 1 werden einfach abgetötet. Und wenn die "Arbeitsfähigkeit" einer gegebenen Eingabezahl im Bereich von 0,1 bis 0,5 liegt und in diesen Bereich fällt, muss die Zahl für die Gesamtarchitektur und weitere Berechnungen in den nächsten Schichten "gestärkt"(!) werden... Das wird nicht funktionieren, die Zahl 0,9 wird einbrechen und einfach die ganze List "brechen".

Immerhin beeinflusst sie die Lösung des NS wegen ihrer konstanten quantitativen Dominanz - mehr. Auch beim XOR-Problem gibt es keine 2, es gibt keine 0,5 am Eingang. Es gibt ein 1-Tupel. Folglich ist die Eingabe nach dem Muster "ja, es gibt ein Signal" (1) und "kein Signal" (0).

Wenn wir diesen Ansatz in die Sprache von NS forex übersetzen, erhalten wir folgendes Ergebnis: Wenn die Zahl 0,9 kommt, wenden wir sie auf den ersten Eingang an, und wenn die Zahl 0,1 kommt, wenden wir sie auf den zweiten Eingang an.

Andernfalls - 0. Bitte beachten Sie: Wir erhaltendynamische Gewichte, d.h. in der Anfangsphase wird das "Rauschen" herausgefiltert.

Wenn 0,9 eine "schlechte" Zahl ist, multiplizieren wir sie, sagen wir, mit 0,0001, um sie ganz nach unten zu "sprinten", damit sie das Lernen nicht mit ihrem übermäßigen Leistungsfaktor stört. Und wenn die Zahl 0,1 ist, multiplizieren wir sie mit der maximalen Gewichtung "1,0", um den maximalen Einfluss der Zahl auf den NS festzulegen. Es gibt also etwas Vernünftiges und Mögliches in der Dynamik der Gewichte.

IMHO, imho. Es sieht nur irgendwie vernünftig aus. Als Beispiel für ein dynamisches Gewicht (Filter): 5 Eingänge, alle passieren die "Filterung", aber das ist alles - ich habe MLP nicht weiter angeschlossen, weil ich das Problem der Umschulung in der Dynamik der Gewichte nicht ganz verstanden habe.

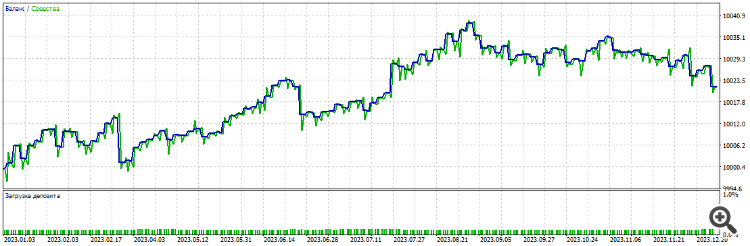

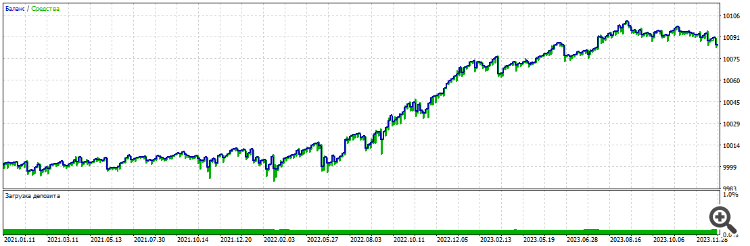

Alles mit MT5-Tools, übliche Optimierung. Filter-Optimierung 2000-2021, EURUSD, H1:

Vorwärts erstes Jahr 2021-2022

Vorwärts zweites Jahr 2022-2023

Weiterleitung drittes Jahr 2023-2024

Alle drei Jahre des Forward

UPDDer Punkt istalso, dass die Zahl am Eingang nur die Position der Indikatorlinie ist, nicht die Stärke.Es ist ein Baumuster.

Und jedem Baumuster muss ein Gewicht zugewiesen werden, so dass ihre kombinierte Zahl das gesamte (große) Arbeitsmuster organisiert .

Hatte irgendjemand Glück mit NN und DL...

---

außer Python-Charts und angepassten Tests:-) Zumindest "Expert Advisor trades on demo and plus".

---

oder man hat das Gefühl, dass dies ein Sackgassen-Zweig der Evolution ist und der ganze Output von Mashobuch und Neuronen in Werbung, Spam und "mutual_sending" besteht.

Es ist ein Sackgassen-Zweig der Evolution.

So wie der Kaffeesatz des 21. Jahrhunderts.

Was ist, wenn die "Praktikabilität" einer gegebenen Eingangszahl im Bereich von 0,1 bis 0,5 liegt und die Zahl, die in diesen Bereich fällt, für die Gesamtarchitektur und die weiteren Berechnungen in den nächsten Schichten "gestärkt"(!) werden muss? Es wird nicht funktionieren, die Zahl 0,9 wird einbrechen und das ganze Chaos einfach "kaputtmachen". Immerhin hat sie aufgrund ihrer konstanten quantitativen Dominanz einen größeren Einfluss auf die NS-Lösung.

Bei Bäumen wird es durch Splits gelöst - einfach Blätter mit Prädiktorwert < 0,1 und > 0,5 werden keine Signale erzeugen.

In NS ist dies auch möglich, wenn man nichtlineare Aktivierungsfunktionen wie Sigmoid verwendet. Aber ich habe mich schon lange nicht mehr mit NS beschäftigt, daher kann ich das nicht mit Sicherheit sagen. Aber im Prinzip arbeiten sie auch auf der Ebene von Holzmodellen, manchmal sogar besser, so dass sie das Unnötige abschneiden können. Deshalb bin ich zu den Bäumen übergegangen, weil man dort verstehen kann, warum eine solche Entscheidung getroffen wurde.