Hallo Dimitry,

ich schätze diese Artikelserie wirklich sehr! Vielen Dank dafür! Aber bitte hilf mir bei diesem Problem:

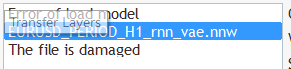

Wenn ich die Datei "EURUSD_PERIOD_H1_rnn_vae.nn" lade, wie in diesem Artikel erwähnt, erhalte ich die Meldung "Error of load model" und "The file is damaged":

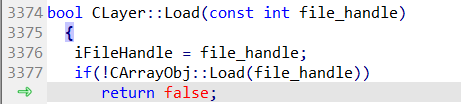

Wenn ich die Spur verfolge, finde ich den Ladefehler in dieser Zeile in NeuroNet.mqh:

Wenn ich das Modell aus Teil 23 mit dem Namen "EURUSD_i_PERIOD_H1_test_rnn.nnw" lade, scheint es zu funktionieren, aber dieses Modell hat nur zwei Schichten. Dies ist nicht das richtige Modell. Habe ich etwas übersehen?

Wenn ich die Datei "EURUSD_PERIOD_H1_rnn_vae.nn" wie in diesem Artikel erwähnt lade, erhalte ich die Meldung "Fehler beim Laden des Modells" und "Die Datei ist beschädigt":

Wenn ich das Modell aus Teil 23 mit dem Namen "EURUSD_i_PERIOD_H1_test_rnn.nnw" lade, scheint es zu funktionieren, aber es hat nur zwei Ebenen. Das ist nicht das richtige Modell. Habe ich etwas übersehen?

Hallo,

Um die Datei "EURUSD_PERIOD_H1_rnn_vae.nnw" zu laden, müssen Sie NetCreator mit der neuen NeuroNet.mqh-Bibliothek neu kompilieren. Im letzten Modell ersetzen wir CBufferDouble durch CBufferFloat. Und fügen einige Typen von Ebenen hinzu.

Sie können die neueste Version der Hördateien herunterladen.

In der neuesten Version von NeuroNet.mqh gibt es auf Seite 2501 eine kritische Warnung:

Seite 2501 if(inputs.AssingnArray(input Vals) || ...... )

veraltetes Verhalten, versteckte Methodenaufrufe werden in einer zukünftigen MQL-Compilerversion deaktiviert.

In der neuesten Version von NetCreatorPanel.mqh gibt es 21 kritische Warnungen. Beginnend auf Seite 940

Seite 935 string temp;

Seite 936 ArrayFree(result);

Seite 937 switch(layr.type);

Seite 938 {

Seite 939 case defNeuronBaseOCL :

p 940 temp = StringFormat ("Dense (Ausgaben %d, \ Aktivierung %s, \ Optimierung %s)", ..... )

Warnung - 'a' nicht erkannte Zeichen-Escape-Sequenz

'o' nicht erkannte Zeichen-Escape-Sequenz

Infolge all dieser Warnungen wird die Datei "_rnn.nnw" nicht geladen!

In der alten Version (Teil 24) wurde nach dem Schamanismus mit Fehlern die gleiche Datei "_rnn.nnw" in NetCreatorPanel.mqh geladen und es war möglich, ein neues Netzwerk zu erstellen.

Aber es war nicht möglich, es zu testen. Es gibt 2 kritische Warnungen in der check_net Datei!

Funktion Train Seite 222 und Seite 307

Seite 219 for(int res = 0; (res <3 && sum >0); res++)

Seite 220 TempData. Aktualisieren(res, TempData, At(res) /sum);

Seite 222 switch(TempData.Maximum(0,3))

Warnung - veraltetes Verhalten, versteckte Methodenaufrufe werden in einer zukünftigen MQL-Compilerversion deaktiviert sein.

Und das Protokoll zeigt fehlgeschlagen mit Code 32767 (falsche Parameter)

Ich habe MetaTrader Build 5120.

Ratschlag!!! Ist es möglich, das Problem mit Warnungen zu lösen? Meiner Meinung nach, für solche Dummies wie mich, ist dies eine

ist die wichtigste Lektion, ohne sie zu meistern, ist das einzige, was zu tun ist, zu stoppen.

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Neuer Artikel Neuronale Netze leicht gemacht (Teil 25): Praxis des Transfer-Learnings :

In den letzten beiden Artikeln haben wir ein Tool zur Erstellung und Bearbeitung von Modellen neuronaler Netze entwickelt. Nun ist es an der Zeit, die Einsatzmöglichkeiten der Technologie des Transfer-Learnings anhand praktischer Beispiele zu bewerten.

Die Testergebnisse sind in der nachstehenden Tabelle aufgeführt. Wie Sie sehen können, begann das vorab trainierte Modell mit einem kleineren Fehler. Doch schon bald holte das zweite Modell auf, und im weiteren Verlauf lagen ihre Werte recht nahe beieinander. Dies bestätigt die frühere Schlussfolgerung, dass die Encoderarchitektur einen erheblichen Einfluss auf die Leistung des gesamten Modells hat.

Achten Sie auf die Lernraten. Das vortrainierte Modell benötigte sechsmal weniger Zeit, um eine Epoche zu durchlaufen. Dies ist natürlich die reine Zeit, ohne Berücksichtigung des Autoencoder-Trainings.

Autor: Dmitriy Gizlyk