Maschinelles Lernen im Handel: Theorie, Modelle, Praxis und Algo-Trading - Seite 626

Sie verpassen Handelsmöglichkeiten:

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Registrierung

Einloggen

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Wenn Sie kein Benutzerkonto haben, registrieren Sie sich

Warum, nein, es sind zu viele Bäume... es war auch mit 10 gut (ich weiß nicht mehr, wie viele ich eingestellt habe)

500 ist eine Menge, genug für jeden Datensatz

Warum treten solche Fehler bei Bruchzahlen auf? ... seltsam, ich hatte erwartet, dass die Maschine genau lernen kann... Im Falle von Mustern (im Forex) ist ihre Form also alles andere als klar (wie das Einmaleins), und es ist gut, wenn Sie in 60 % der Fälle richtige Vorhersagen erhalten.

Die Fehler traten auf, weil der Parameter r niedrig war, was bedeutet, dass nur die Hälfte der Beispiele für das Training verwendet wurde, und diese Hälfte wurde auf der Hälfte der Bäume trainiert :) und es gibt nur wenige Beispiele

müssen Sie r~1 einstellen, um genau zu sein. Wird für die Pseudoregularisierung und für Tests an Proben außerhalb des Beutels verwendet

es ist nur so, dass dieser Mechanismus angepasst werden muss, im Falle des Waldes gibt es nur 2 Einstellungen

Sie sollten sich auch darüber im Klaren sein, dass NS (RF) keine Rechenmaschine ist, sondern eine Funktion annähert, und dass eine zu hohe Genauigkeit für viele Aufgaben eher schlecht als recht ist.

Ich befürchte, dass eine Regression/Prognose im Netz in etwa das Gleiche ergeben wird wie die Suche nach ähnlichen Standorten/Mustern in der Geschichte (was ich vor 3 Monaten getan habe):

Die Fehler traten auf, weil der r-Parameter niedrig war, was bedeutet, dass nur die Hälfte der Beispiele für das Training verwendet wurde, und diese Hälfte wurde auf der Hälfte der Bäume trainiert :) und es gibt nur wenige Beispiele

müssen Sie r~1 einstellen, um genau zu sein. Wird für die Pseudoregularisierung und für Tests an Proben außerhalb des Beutels verwendet

Man muss nur wissen, wie man diesen Mechanismus einstellt, im Falle des Waldes gibt es nur 2 Einstellungen

Wenn Sie z. B. r auf 1 setzen, wird es auf alle Stichproben trainiert.

Da der Wald ohnehin nicht alle Attribute verwendet, gibt es eine Modelländerung, mit der Sie ihn so einstellen können, dass er alle Attribute verwendet. Dies ist jedoch nicht empfehlenswert, da sich der Wald alle Optionen merken wird

und die Auswahl der Einstellungen ist oft so subjektiv, dass man experimentieren muss

wenn weniger als 1, dann wird das Modell an den verbleibenden Stichproben validiert (das Modell wird an Daten geschätzt, die nicht aus der Trainingsstichprobe stammen). classic r ist 0,67, das Modell wird an den verbleibenden 33% validiert. Dies gilt natürlich für große Stichproben, für kleine Stichproben ist es wie mit dem Einmaleins - es ist besser, 1 zu setzen.

Da der Wald ohnehin nicht alle Attribute verwendet, gibt es eine Modelländerung, mit der Sie ihn so einstellen können, dass er alle Attribute verwendet. Dies ist jedoch nicht empfehlenswert, da sich der Wald alle Optionen merken wird

und die Auswahl der Einstellungen ist oft so subjektiv, dass man experimentieren muss

Wenn er kleiner als 1 ist, wird das Modell an den verbleibenden Stichproben validiert (das Modell wird an Daten geschätzt, die nicht in die Trainingsstichprobe aufgenommen wurden). r wird klassischerweise auf 0,67 gesetzt, an den verbleibenden 33% wird das Modell validiert.

Auswahl der Merkmale

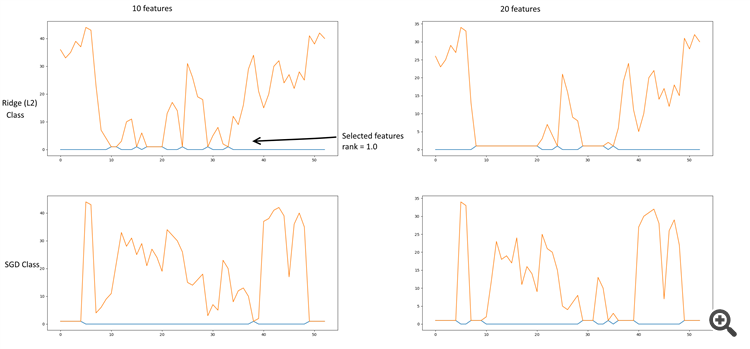

Ein bisschen Datamining. Ich habe die Merkmalsauswahl mittels Chi^2 + KBest, RFE (rekursive Merkmalseliminierung) + (SGDClassifier, RidgeClassifier), L2 (Ridge, RidgeClassifier), L1 (Lasso) durchgeführt. Die Ridge-Regularisierung führt zu vernünftigeren Ergebnissen.

Einige Diagramme:

RFE + Ridge & SGD

Ridge-Regressor (L2).

Ridge-Klassifikator (L2)

Die Datei enthält eine Tabelle mit den Parameterwerten und deren Stichproben durch die Merkmalsauswahl.

Die wichtigsten Koeffizienten sind:

- 10, 11 - Schließen, Delta (Öffnen-Schließen)

- 18-20 - Ableitung Hoch, Tief, Schluss

- 24 - Log-Derivat Schließen

- 29, 30 - Lowess

- 33 - Entmagnetisierung schließen - Lowess

- 35 - EMA 26 (13 als Option)

- 40 - Abgeleitete EMA 13

PS. Die Zeile "Ridge Classifier" in der Tabelle basiert auf einer Klasse, sie spiegelt nicht die Abhängigkeiten der Parameter von anderen Klassen wider.Verweis auf das Skript.

ein neues Netzdiagramm skizziert hat, ist dies die erste Beschreibung. Später wird es mehr geben (hoffentlich)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

ein neues Netzdiagramm skizziert hat, ist dies die erste Beschreibung. Später wird es mehr geben (hoffentlich)

https://rationatrix.blogspot.ru/2018/01/blog-post.html

Ich frage mich, warum der erste Beitrag gelöscht wurde. Er hat den Plan gebloggt. =)