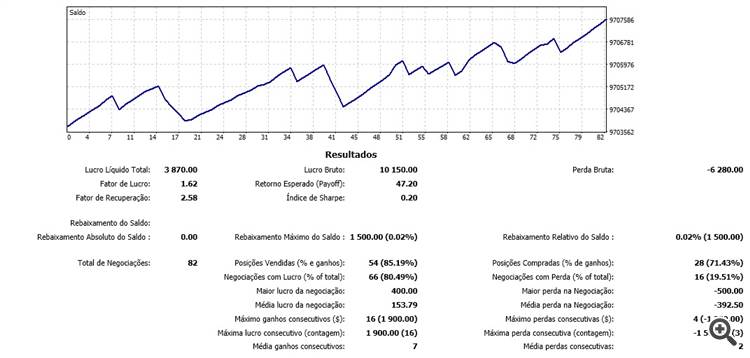

Ich danke Ihnen sehr für Ihre Artikel. Seine Algorithmen sind sehr gut, für mich sind sie die besten Algorithmen in mql5 für neuronale Netze, da sie es erlauben, das Netz in Echtzeit zu aktualisieren, während des Marktes, Zeile für Zeile. Ich teste seine Algorithmen auf dem brasilianischen Futures-Markt und die Ergebnisse sind ermutigend, die Vorhersage hat eine Effizienz von mehr als 80% in den letzten 100 Bars erreicht, was zu positiven Trades geführt hat. Ich freue mich schon auf den nächsten Artikel.

Neuer Artikel Neuronale Netze leicht gemacht (Teil 11): Ein Blick auf GPT ist veröffentlicht worden:

Autor: Dmitrij Gizlyk

Interessantes Material, aber der Code ist alles in einer riesigen Spaghetti-Schüssel, ziemlich schwer zu verstehen. Eine Klasse pro Datei wäre einfacher gewesen.

Es wäre gut, ein Diagramm zu haben, das zeigt, wie alle Klassen zusammengehalten werden.

Im Moment bin ich bei NeuronBase, die von Object abgeleitet ist, aber NeuronProof verwendet, das von NeuronBase abgeleitet ist, und auch Layer, das praktisch jeden definierten Typ von Neuron-Klasse verwendet.

Es sind viele Vorwärtsdeklarationen erforderlich, um alles in separate Dateien zu packen und in den Griff zu bekommen.

Wahrscheinlich ist es einfacher, einfach anzufangen und die Konzepte zu verwenden, die Sie in den verschiedenen Kapiteln erklärt haben.

Ich habe versucht, die Spaghetti-Schüssel laufen zu lassen, die meine GPU zum Qualmen brachte und leider nichts Nützliches produzierte.

Trotzdem vielen Dank für die tollen Materialien.

:-)

Interessantes Material, aber der Code ist alles in einem riesigen Spaghetti-Schüssel ziemlich schwer zu bekommen, um mit ihm umzugehen. Eine Klasse pro Datei wäre einfacher gewesen.

Es wäre gut, ein Diagramm zu haben, das zeigt, wie alle Klassen zusammen gehalten werden.

Im Moment bin ich bei NeuronBase, die von Object abgeleitet ist, aber NeuronProof verwendet, das von NeuronBase abgeleitet ist, und auch Layer, das praktisch jede Art von Neuron-Klasse definiert verwendet.

Es sind viele Vorwärtsdeklarationen erforderlich, um alles in separate Dateien zu packen und in den Griff zu bekommen.

Wahrscheinlich ist es einfacher, sauber anzufangen und die Konzepte zu verwenden, die Sie in den verschiedenen Kapiteln erklärt haben.

Ich habe versucht, die Spaghetti-Schüssel laufen zu lassen, die meine GPU zum Rauchen brachte und leider nichts Nützliches produzierte.

Trotzdem danke für die tollen Materialien.

:-)

Hi,

Ja, das hat es, danke.

Der Code ist jetzt nicht mehr so schlimm und ich kann deutlich sehen, wie ich die Netzarchitektur ändern kann, falls nötig.

Ich habe alles in separaten Klassendateien, plus eine viel kleinere Spaghetti-Schüssel, die immer noch notwendig ist, weil mt5 sowohl Definition als auch Implementierungen in denselben Dateien hat.

Ich habe versucht, etwas Training auf GBPUSD mit dem Code zu machen, wie es ist, aber die Ergebnisse scheinen nicht gut zu sein, der Fehler klettert von den natürlichen 50 % auf 70 % und bleibt dort mit keiner Verbesserung über nachfolgende Epochen.

Irgendwelche Vorschläge, wo ich mit dem Optimieren beginnen kann?

BTW diese Zeile:

#define FileName Symb.Name()+"_"+EnumToString((ENUM_TIMEFRAMES)Period())+"_"+IntegerToString(HistoryBars,3)+StringSubstr(__FILE__,0,StringFind(__FILE__,".",0))

Muss korrigiert werden auf:

#define FileName Symb.Name()+"_"+EnumToString((ENUM_TIMEFRAMES)Period())+"_"+IntegerToString(HistoryBars)+StringSubstr(__FILE__,0,StringFind(__FILE__,".",0))

Zuerst habe ich den Artikel nicht wirklich verstanden, weil ich die Hauptidee nicht wirklich verstanden habe.

Als ich ChatGPT selbst zu diesem Text befragte, klärte er vieles auf und ich verstand das meiste, was ich las:

"Der Transformer-Algorithmus ist ein Modell zur Verarbeitung von natürlicher Sprache, d.h. von Text. Dieses Modell zerlegt den Text in eine Folge von Wörtern (oder "Token") und führt dann eine Reihe von Operationen an jedem dieser Wörter durch, um ihre Bedeutung besser zu verstehen.

Eine der Operationen, die das Modell durchführt, ist die Selbstaufmerksamkeit, die darin besteht, die Bedeutung jedes Wortes im Verhältnis zu den anderen Wörtern in der Sequenz zu berechnen. Dazu verwendet das Modell drei Vektoren: den Abfragevektor, den Schlüsselvektor und den Wertvektor, die für jedes Wort berechnet werden.

Das Modell berechnet dann die Aufmerksamkeit, d. h. die Bedeutung, die jedes Wort im Verhältnis zu den anderen Wörtern der Sequenz hat. Es verwendet eine mathematische Funktion namens Softmax, um die Aufmerksamkeitskoeffizienten zu normalisieren.

Schließlich kombiniert das Modell alle Selbstaufmerksamkeitsoperationen, um ein Endergebnis zu erhalten, das zur Vorhersage der Bedeutung des Textes verwendet wird.

Kurz gesagt, der Transformer-Algorithmus verwendet komplexe mathematische Operationen, um die Bedeutung des Textes zu verstehen."

Hallo nochmal :) Ich habe das Problem gefunden. Auf in Include-Ordner die Opencl-Konfiguration war scheitern, weil ich mein System getestet, und GPU nicht dupport den Code nur die CPU, ein wenig ändern und arbeiten perfekt, aber slowwly :S

- Freie Handelsapplikationen

- Über 8.000 Signale zum Kopieren

- Wirtschaftsnachrichten für die Lage an den Finanzmärkte

Sie stimmen der Website-Richtlinie und den Nutzungsbedingungen zu.

Neuer Artikel Neuronale Netze leicht gemacht (Teil 11): Ein Blick auf GPT :

Eines der fortschrittlichsten Modelle unter den derzeit existierenden neuronalen Netzen für Sprachen ist vielleicht GPT-3, dessen maximale Variante 175 Milliarden Parameter enthält. Natürlich werden wir ein solches Ungetüm nicht auf unseren Heim-PCs erstellen. Wir können uns jedoch ansehen, welche architektonischen Lösungen bei unserer Arbeit verwendet werden können und wie wir von ihnen profitieren können.

Die neue Klasse des neuronalen Netzwerks wurde auf demselben Datensatz getestet, der in den vorherigen Tests verwendet wurde: EURUSD mit dem H1-Zeitrahmen, historische Daten der letzten 20 Candlesticks wurden in das neuronale Netz eingespeist.

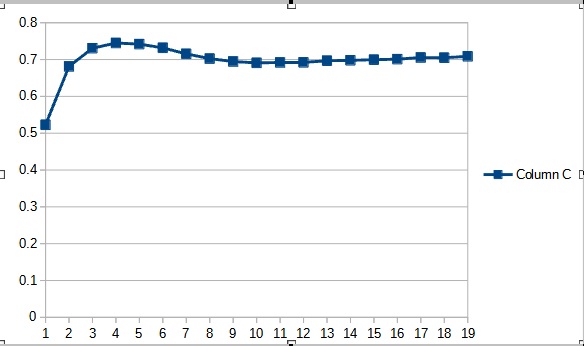

Die Testergebnisse haben die Vermutung bestätigt, dass mehr Parameter eine längere Trainingsperiode erfordern. In den ersten Trainingsepochen zeigt ein Expert Advisor mit weniger Parametern stabilere Ergebnisse. Mit zunehmender Dauer des Trainings zeigt ein Expert Advisor mit einer großen Anzahl von Parametern jedoch bessere Werte. Im Allgemeinen sank der Fehler von Fractal_OCL_AttentionMLMH_v2 nach 33 Epochen unter das Fehlerniveau des Fractal_OCL_AttentionMLMH EA und blieb weiterhin niedrig.

Autor: Dmitriy Gizlyk