Discussão do artigo "Redes neurais de maneira fácil (Parte 38): Exploração auto-supervisionada via desacordo (Self-Supervised Exploration via Disagreement)"

Olá. Já está virando um jogo de azar - tentar executar outra de suas criações. Não sou especialista em programação, mas pelo menos pude apreciar a profundidade do tópico e sua vastidão. Eu o executei no testador de estratégia com otimização de lote de 100 a 110. O indicador na bandeja é executado e nada mais acontece por 12 horas. O que estou fazendo de errado?

Vou verificar as alterações nos arquivos desta versão em comparação com as anteriores. Tenho visto o mesmo problema.

Quando tento remover o indicador do MT5 ou quando estou fazendo depuração no meta editor, o MetaTrader5 trava imediatamente.

Ele não funciona, mesmo depois de muitas horas

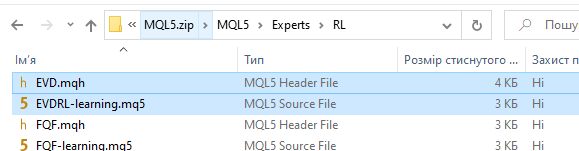

Seu link não contém o referido EA!!! Há apenas o antigo do último artigo. A princípio, pensei que você tivesse esquecido de alterar o nome ao copiar, mas, ao comparar, encontrei uma correspondência completa do código!!!! CARAUL!!!

No arquivo na parte inferior do artigo está anexado um conjunto completo de arquivos. Há Expert Advisors de artigos anteriores. Mas também há o Expert Advisor mencionado no artigo.

Desculpe, mais uma pergunta de amador. O Expert Advisor não fez uma única negociação no testador. Ele está apenas pendurado no gráfico, sem sinais de atividade. Por quê?

E mais uma coisa. Os dados do indicador são usados apenas como um filtro adicional ao fazer uma negociação?

Muito obrigado por este artigo!

Vi que você também oferece um arquivo zip com muitos experimentos de RL. Existe algum arquivo mq5 específico que eu possa compilar, executar e avaliar com mais detalhes?

Muito obrigado!

Muito obrigado por este artigo!

Vi que você também oferece um arquivo zip com muitos experimentos de RL. Existe algum arquivo mq5 específico que eu possa compilar, executar e avaliar com mais detalhes?

Muito obrigado!

Olá, sim, você pode. Em anexo, todos os arquivos dos artigos anteriores.

- Aplicativos de negociação gratuitos

- 8 000+ sinais para cópia

- Notícias econômicas para análise dos mercados financeiros

Você concorda com a política do site e com os termos de uso

Novo artigo Redes neurais de maneira fácil (Parte 38): Exploração auto-supervisionada via desacordo (Self-Supervised Exploration via Disagreement) foi publicado:

Um dos principais desafios do aprendizado por reforço é a exploração do ambiente. Anteriormente, já nos iniciamos no método de exploração baseado na curiosidade interna. E hoje proponho considerar outro algoritmo, o de exploração por desacordo.

O algoritmo de exploração baseado em discordância é um dos métodos de aprendizado por reforço que permite que um agente explore o ambiente para encontrar áreas novas e inexploradas sem depender de recompensas externas, usando um conjunto de modelos.

No artigo "Self-Supervised Exploration via Disagreement", os autores descrevem essa abordagem e propõem um método simples que envolve o treinamento de um conjunto de modelos de dinâmica progressiva e o incentivo ao agente para explorar o espaço de ação onde há o máximo de discrepância ou variação entre as previsões dos modelos do conjunto.

Assim, em vez de escolher ações que geram a maior recompensa esperada, o agente escolhe ações que maximizam a discrepância entre os modelos do conjunto. Isso permite que o agente explore regiões do espaço de estado em que os modelos do conjunto não concordam entre si e onde é provável que existam regiões novas e inexploradas do ambiente.

Nesse caso, todos os modelos do conjunto convergem para um valor médio, reduzindo, em última análise, a variação do conjunto e proporcionando ao agente previsões mais precisas sobre os estados do ambiente e as possíveis consequências das ações.

Além disso, o algoritmo de exploração via discordância permite que o agente lide com sucesso com a estocasticidade da interação com o ambiente. Os resultados experimentais obtidos pelos autores do artigo mostraram que a abordagem proposta de fato melhora a exploração em ambientes estocásticos e supera os métodos existentes de motivação intrínseca e modelagem de incerteza. Além disso, eles observaram que sua abordagem pode ser estendida ao aprendizado supervisionado, em que o valor de uma amostra é determinado com base no estado de um conjunto de modelos em vez de na etiqueta verdadeira.

Assim, o algoritmo de exploração via desacordo representa uma abordagem promissora para o problema da exploração em ambientes estocásticos. Ele permite que o agente explore o ambiente com mais eficiência e sem depender de recompensas externas, o que pode ser particularmente útil em aplicativos do mundo real em que as recompensas externas podem ser limitadas ou caras.

Autor: Dmitriy Gizlyk