Resulta curioso por qué es la orientación tendencial la que resulta. Normalmente, si la tarea es encontrar regularidades, entonces, dado el crecimiento en zigzag de casi cualquier tendencia, la red neuronal debería encontrar rentable y utilizar una estrategia contra-tendencia en paralelo, abriendo en los extremos esperados, especialmente en caso de crecimiento prolongado. La experiencia anterior (artículo 29) tiene algo parecido, donde la curva de equilibrio crece durante todo el periodo, mientras que aquí se desvanece gradualmente.

Dmitriy Gizlyk

Проведите свои эксперименты и будет интересно понаблюдать за их результатами.

Es genial que haya una oportunidad de torcer la aplicación en sus manos.

Por desgracia, no está probado. Trató de entrar en el editor, se bloquea al compilar. Parece que he copiado todos los archivos al ver todos los artículos.

Por favor, aconséjeme lo que tengo que hacer.

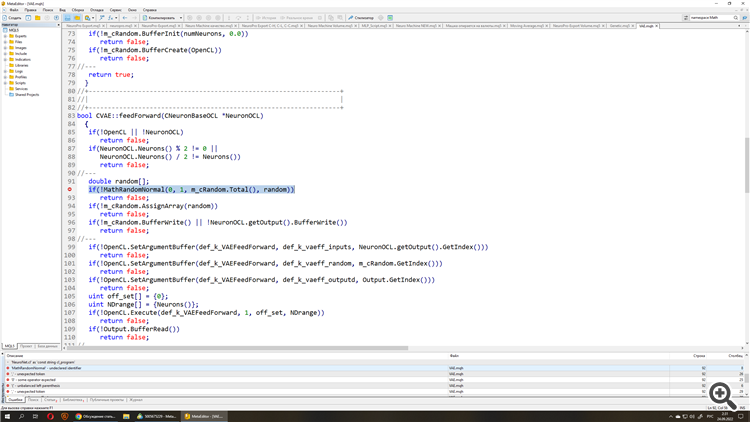

He eliminado el espacio de nombres Math y las llaves en uno de los archivos de inclusión ,

Para el entrenamiento en el artículo, utilicé un modelo similar al entrenado en el artículo actor-critic y policy gradient. Simplemente le das al Asesor Experto un modelo normal. Y lo complementa con modelos similares en arquitectura hasta llenar la población.

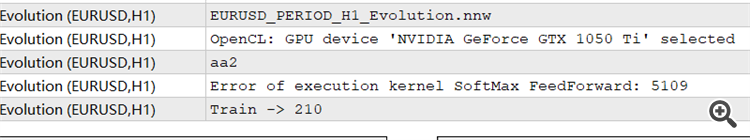

Hola, aprecio mucho su gran esfuerzo para esta serie de artículos, pero cuando trato de ejecutar la evolución EA, o Genética EA, me dio un error de 5109, que me volví a MQ5 libro guía y se encontró, este error es causado por OPENCL.

Tengo un error de 5109, que me dirigí a MQ5 libro de guía y se encontró, este error es causado por OPENCL ..., ¿me puede decir cómo ejecutar este error? Tengo un error de 5109, que me volví a MQ5 libro de guía y encontró, este error es causado por OPENCL.

¿pueden decirme como solucionar este problema? de todas formas, muchas gracias...

| ERR_OPENCL_EXECUTE | ERR_OPENCL_EXECUTE | Error de ejecución del programa OpenCL |

- Aplicaciones de trading gratuitas

- 8 000+ señales para copiar

- Noticias económicas para analizar los mercados financieros

Usted acepta la política del sitio web y las condiciones de uso

Artículo publicado Redes neuronales: así de sencillo (Parte 30): Algoritmos genéticos:

En el artículo de hoy, hablaremos de un método de aprendizaje ligeramente distinto. Podríamos decir que lo hemos tomado de la teoría de la evolución de Darwin. Probablemente resulte menos controlable que los métodos anteriormente mencionados, pero también nos permite entrenar modelos indiferenciados.

Las pruebas del proceso de optimización se han realizado manteniendo todos los parámetros usados anteriormente. Hemos tomado la muestra de entrenamiento de la historia del instrumento EURUSD, con el marco temporal H1. Para la optimización, hemos tomado la historia de los últimos 2 años. Para el asesor, hemos tomado los parámetros externos por defecto. Como modelo para la prueba, hemos tomado la arquitectura del artículo anterior con la búsqueda de la distribución de probabilidad óptima de la toma de decisiones. Este enfoque nos permitirá sustituir el modelo optimizado en el asesor experto "REINFORCE-test.mq5" utilizado anteriormente. Como podemos ver, este es el tercer enfoque en el proceso de entrenamiento del modelo de arquitectura única. Hemos entrenado previamente un modelo similar con los algoritmos Policy Gradient y Actor-Crítico. Resulta más interesante observar los resultados de la optimización.

Como recordará, no hemos utilizado los datos del último mes para optimizar el modelo. Esto nos deja pocos datos para poner a prueba el modelo optimizado. Al ejecutar el modelo optimizado en el simulador de estrategias con los datos del último mes, hemos obtenido el siguiente resultado.

Como podemos ver en el gráfico, hemos obtenido un gráfico de balance creciente, pero su rendimiento es algo inferior al obtenido entrenando un modelo similar con el método Actor-Crítico. Al mismo tiempo, también se observa una disminución del número de transacciones. De hecho, el número de transacciones se ha reducido a la mitad.

Autor: Dmitriy Gizlyk