余额线很奇怪。在这一年中,似乎只有交易是开放的,而在测试结束时,所有交易都关闭了。所有交易都在秋季出售和欧元全年。已坐收盈亏近一年)。

Нейросети — это просто (Часть 25): Практикум Transfer Learning

- www.mql5.com

В последних двух статьях мы создали инструмент, позволяющий создавать и редактировать модели нейронных сетей. И теперь пришло время оценить потенциальные возможности использования технологии Transfer Learning на практических примерах.

非常成功的文章。您能帮我创建模型吗? 神经元数量、哪一层、激活方式、输出。感谢您的帮助。

在之前的文章中,您介绍了模型创建、图层及其特征。在这种情况下该如何操作?

作者不见了。也许是论坛中的某个成员运行了这只怪兽?能否请您提供一些关于为模型创建哪些图层的信息?

超级

您有模型文件吗?压缩文件中似乎没有。

没有这些文件,EA 无法启动运行。

如下所述:

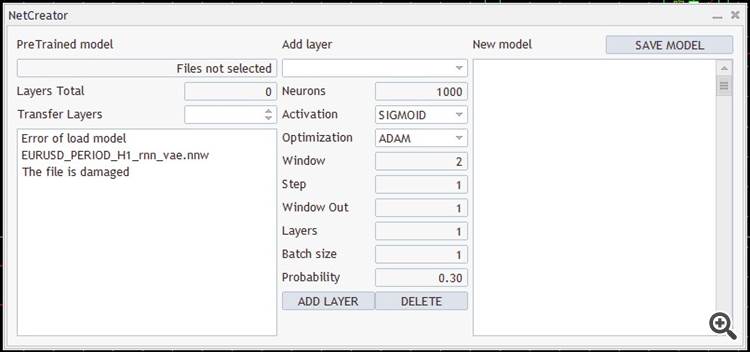

为了训练 EA,所有模型都是使用NetCreator 工具 创建的。需要补充的是,要在策略测试器中启用 EA 操作,模型文件必须位于终端公共目录 "Terminal/Common/Files "中,因为每个代理都在自己的沙盒中运行,所以它们只能通过公共终端文件夹交换数据。

Neural networks made easy (Part 25): Practicing Transfer Learning

- www.mql5.com

In the last two articles, we developed a tool for creating and editing neural network models. Now it is time to evaluate the potential use of Transfer Learning technology using practical examples.

我也想了解更多关于如何创建模型的详细信息。我真的很想用这个 EA 做实验,但这阻碍了我!

新文章 神经网络变得轻松(第三十五部分):内在好奇心模块已发布:

我们继续研究强化学习算法。 到目前为止,我们所研究的所有算法都需要创建一个奖励政策,从而令代理者能够每次从一个系统状态过渡到另一个系统状态的转换中估算其每个动作。 然而,这种方式人为因素相当大。 在实践中,动作和奖励之间存在一些时间滞后。 在本文中,我们将领略一种模型训练算法,该算法可以操控从动作到奖励的各种时间延迟

为了训练 EA,所有模型都是利用 NetCreator 工具创建的。 应该补充的是,若要在策略测试器中启用 EA 操作,模型文件必须位于终端公共目录 'Terminal\Common\Files' 之中,因为每个代理者都在自己的沙箱中运行,因此它们只能通过公共终端文件夹交换数据。

策略测试器中的训练比以前的虚拟训练方法需要花费更长的时间。 出于这个原因,我将模型训练期缩短到 10 个月。. 其余测试参数保持不变。 这次同样,我采用基于 EURUSD 的 H1 时间帧。 指标采用默认参数。

老实说,我期待的学习过程将从本金亏损开始。 但在第一次验算时,模型显示的结果接近 0。 然后它甚至在第二次验算中赚取了一些盈利。 该模型执行了 330 笔交易,超过 98% 的操作是盈利的。

作者:Dmitriy Gizlyk