Для тестирования была создана сверточная модель следующей архитектуры:

- ソース・データ・レイヤ、240エレメント(20ローソク、1ローソクの記述につき12ニューロン)。

- 収束層, ソース・データ・ウィンドウ 24 (2 ローソク), ステップ 12 (1 ローソク), 出力 6 フィルタ.

- 収束層、ソース・データ・ウィンドウ 2、ステップ 1、2 フィルタ。

- 収束レイヤ、ソース・データ・ウィンドウ3、ステップ1、2フィルタ。

- 収束層、ソースデータウィンドウ3、ステップ1、2フィルタ。

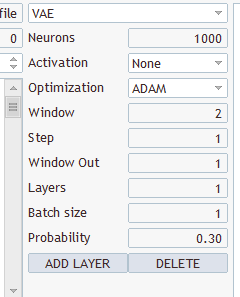

- 完全連結ニューラル層、1000要素。

- 1000要素の完全連結ニューラル層

- 3要素の完全連結層(3アクションの結果層)。

、Transfer Lerningを持っていて、コンパイルして動くのですが、どうやってこのようなモデルを作るのでしょうか?

1.TransferLearningを起動する。

2.

3.

4. Save model をクリックし、プログラムから読み込むファイル名を指定します。 モデルを保存をクリックし、プログラムから読み込むファイル名を指定します。

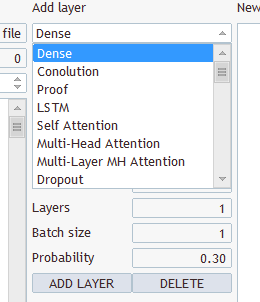

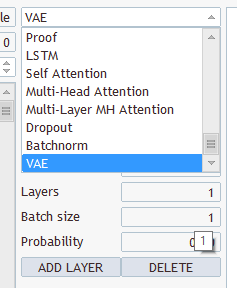

どのようなレイヤーと何を選択すればよいですか?いくつかの種類とパラメータがあります。

任意のものを選び、"EURUSD_PERIOD_H1_Q-learning.nnw "の下に保存し、Q-learning.mq5を実行すると、ログに書き込まれます。

2022.10.14 15:09:51.743 Experts Q-learning (EURUSD,H1) initialising failed with code 32767 (incorrect parameters)

そして Experts タブに:

2022.10.14 15:09:51.626 Q-learning (EURUSD,H1) OpenCL: GPU device 'NVIDIA GeForce RTX 3080' selected

2022.10.14 15:09:51.638 Q-learning (EURUSD,H1) EURUSD_PERIOD_H1_Q-learning.nnw

こんにちは、ギズリックさん。まずは、あなたの根拠のある連載に感謝したいと思います。しかし、遅ればせながら、今回の記事を理解する上で、いくつかの問題と格闘しなければなりません。以前の記事からVAE.mqhファイルとCBufferDoubleクラスを再構築できた後、この記事のサンプル・アプリケーションをコンパイルすることができました。試しに、NetCreaterを使ってネットワークを作ってみました。何度も試しましたが、あきらめました。保存したネットワークは、この記事のアプリケーションでは受け入れられませんでした。作成したネットワークをダウンロードすることはできないのでしょうか?本当にありがとうございました!

こんにちは、ギズリックさん。まずは、あなたの根拠のある連載に感謝したいと思います。しかし、遅ればせながら、今回の記事を理解する上で、いくつかの問題と格闘しなければなりません。以前の記事からVAE.mqhファイルとCBufferDoubleクラスを再構築できた後、この記事のサンプル・アプリケーションをコンパイルすることができました。試しに、NetCreaterを使ってネットワークを作ってみました。何度も試しましたが、あきらめました。保存したネットワークは、この記事のアプリケーションでは受け入れられませんでした。作成したネットワークをダウンロードすることはできないのでしょうか?本当にありがとうございました!

こんにちは!

トレーニングが保存されなかった後、トレーニングされたモデル:、

2024.06.01 01:12:26.731 Q-learning (XAUUSD_t,H1) XAUUSD_t_PERIOD_H1_Q-learning.nnw

2024.06.01 01:12:26.833 Q-learning (XAUUSD_t,H1) 反復980、損失0.75659

2024.06.01 01:12:26.833 Q-learning (XAUUSD_t,H1) ExpertRemove() 関数が呼び出されました。

テスターを実行しようとするとエラー

2024.06.01 01:16:31.860 Core 1 2024.01.01 01 00:00:00 XAUUSD_t_PERIOD_H1_Q-learning-test.nnw

2024.06.01 01:16:31.860 Core 1 OnInit がゼロ以外のコード 1 を返したため、テスターが停止しました。

2024.06.01.01 01:16:31.861 Core 1 接続切断

2024.06.01.01 01:16:31.861 Core 1 接続が切断されました。

このような現象に遭遇したことのある方、どのように問題を解決したのか、教えてください。

- 無料取引アプリ

- 8千を超えるシグナルをコピー

- 金融ニュースで金融マーケットを探索

新しい記事「ニューラルネットワークが簡単に(第27部):DQN (Deep Q-Learning)」はパブリッシュされました:

強化学習の研究を続けます。今回は、「Deep Q-Learning」という手法に触れてみましょう。この手法を用いることで、DeepMindチームはアタリ社のコンピューターゲームのプレイで人間を凌駕するモデルを作成することができました。取引上の問題を解決するための技術の可能性を評価するのに役立つと思います。

Deep Q-learningがニューラルネットワークを使ってQ関数を近似するものであることは、もうお分かりだと思います。そのような方法のメリットは何でしょうか。前回の交差エントロピーの表形式法の実装を思い出してください。表形式での実装は、可能な状態や行動の数が有限であることを前提としていることを強調しました。そこで、初期データをクラスタリングすることで、可能な状態の数を限定しました。でも、そんなにいいのでしょうか。クラスタリングは常に良い結果を生むのでしょうか。ニューラルネットワークを使用することで、可能な状態の数が制限されることはありません。これは、取引関連の問題を解決する上で、大きなメリットになると思います。

一番最初のわかりやすい方法は、前回の表をニューラルネットワークに置き換えることですが、残念ながら、そう簡単にはいきません。実際には、この方法はあまり良いものではないことが判明しました。この方法を実現するために、いくつかのヒューリスティックを追加する必要があります。

まず、エージェント訓練の目標を見てみましょう。一般的に、その目標は総報酬を最大化することです。下の図をご覧ください。エージェントは、startセルからFinishセルまで移動しなければなりません。エージェントは、Finishセルに到達したときに一度だけ報酬を受け取ることになります。それ以外の状態では、報酬はゼロです。

図には2つのパスが示されています。私たちにとって、橙色の道の方が短く、好ましいことは明らかですが、報酬の最大化という点では、両者は等価です。

作者: Dmitriy Gizlyk