Vous manquez des opportunités de trading :

- Applications de trading gratuites

- Plus de 8 000 signaux à copier

- Actualités économiques pour explorer les marchés financiers

Inscription

Se connecter

Vous acceptez la politique du site Web et les conditions d'utilisation

Si vous n'avez pas de compte, veuillez vous inscrire

(PF-1)*SdDay - limites de ce qui précède afin que ce coefficient ne capte pas l'essentiel de l'indicateur Vigoda. Plus le nombre de transactions est élevé, plus il est difficile d'atteindre une rentabilité élevée.

(PF-1) - il est utilisé pour rendre le multiplicateur de la CP négatif en cas de solde négatif. Il s'agit du premier indicateur, c'est pourquoi les suivants doivent également influencer le volume du total, et non avoir une prépondérance propre.

((PipBar+Ust)/10) - le temps n'est pas en notre faveur lorsque nous ouvrons une position, car le marché peut changer à tout moment, et l'indicateur PipBar (maintenant changé en PipMin, point/minute) montre la qualité du temps utilisé, c'est-à-dire le nombre maximum de points en un temps minimum. L'Ust est également important, plus la valeur est élevée, plus la croissance de l'équilibre est régulière. En divisant par 10, on égalise l'effet sur le solde global.

(ProcDay*10)/(MD+(SrD*4)) - Le rapport entre le taux de croissance de l'équilibre et les risques utilisés pendant celui-ci. Multiplication par 10 et 4, également pour égaliser l'impact sur le total.

Si vous utilisez la multiplication au lieu de l'addition, il est plus difficile d'équilibrer l'impact de chaque indicateur, ce qui fait parfois bondir le total inutilement. Croyez-moi, cela a déjà été testé, si un paramètre est légèrement surestimé, lorsqu'il est multiplié, il tire souvent le total vers le mauvais sommet.

Je continue à ajuster la formule et je posterai des mises à jour et des comparaisons plus tard...

(PF-1)*SdDay - ограничения сверху для того, чтоб этот коэффициент не захватил основной объем показателя Vigoda. - 1. Указывает на явное использование неверной зависимости от Профит Фактора. Чем больше сделок, тем сложнее добиться большой прибыльности. - 2. Cформулируем по-другому, тем сложнее добится случайного результата с большой прибыльностью.

(PF-1) - делается для того, чтоб при отрицательном показателе баланса, множитель PF тоже был отрицательным. - 3. Отрицательный баланс имеет минус, а профит фактор < 1 - это имеет смысл и методически оправдано. Смысл перегружать одно другим? Это идет как первый показатель, по этому следующие должны также влиять на объем общего, и не иметь какой-то свой перевес. -

((PipBar+Ust)/10) - при открытии позиции время не в нашу пользу, т.к. рынок может поменяться в любую минуту, и показатель PipBar (теперь я его переделал на PipMin, пункт/мин.) как раз и показывает качество используемого времени, т.е. максимальное кол-во пунктов за минимальное время. - 4. Обратная зависимость критерия от длины тестируемого периода проще и понятнее. Ust - устойчивость также не мало важна, чем выше показатель, тем значит плавнее рост баланса. - 5. Прибыль деленая на максимальную просадку никак не вяжется с плавностью роста баланса. Я бы так не называл это. Деление на 10 выравнивает влияние на общую сумму. - 6. Эта 10-ка результат каких-то статистических формульных вычислений или среднепотолочная эмпирика по типу "подогнать примерно"?

(ProcDay*10)/(MD+(SrD*4)) - соотношение скорости роста баланса к использованным рискам во время этого. 4. Обратная зависимость критерия от длины тестируемого периода проще и понятнее. Умножения на 10 и 4, также для выравнивания влияния на общий показатель. - 6. Эти 10-ка и 4-ка результат каких-то статистических формульных вычислений или среднепотолочная эмпирика по типу "подогнать примерно"?

Если использовать вместо сложения умножение, то сложнее отбалансировать влияние каждого показателя, от этого итог иногда неоправданно скачет.Поверьте уже все проверено, если один параметр слегка завышен, то при умножении он часто вытягивает общий итог не на ту верхушку. - 1. Указывает на явное использование неверной зависимости от Профит Фактора, Профита, Максимальной просадки, Длины тестируемого периода.

Я продолжаю корректировать формулу и позже выложу обновления и сравнения...

Laissez-moi vous le montrer avec un exemple simple, et vous vous rendrez compte que votre approche est méthodologiquement incorrecte.

Le chiffre du bilan a de la valeur pour nous car nous le comparons à notre rêve de "plus d'argent". L'équilibre et "plus d'argent" sont de même nature, et plus l'équilibre est important, plus il est proche de "plus d'argent".

L'indicateur de prélèvement maximal est précieux pour nous car nous le comparons à notre cauchemar - le "dépôt perdu". Le drawdown maximum et le "dépôt perdu" sont de même nature et plus le drawdown est faible, plus on s'éloigne du "dépôt perdu".

Le facteur de profit nous est précieux, car nous y comparons la somme de tous les profits avec la somme de toutes les pertes. Étonnamment, la somme de tous les profits et la somme de toutes les pertes sont à nouveau de même nature, et plus nous avons de profits et moins de pertes, plus l'indicateur a de la valeur pour nous.

Je pense que vous avez compris l'importance de comparer (additionner, diviser et multiplier) des indicateurs homogènes, des indicateurs de même nature. Sinon, ce sera le bazar.

Revenons maintenant à votre SrD. En utilisant son exemple, je veux vous faire remarquer que l'introduction d'un indicateur juste parce que nous savons compter le drawdown moyen sur toutes les transactions est aussi pertinente que la température moyenne du patient. Pouvez-vous expliquer ce que SrD ajoute à l'évaluation ? A mon avis - absolument rien. Tirages de 1,11, 1,11, 1,11, 1,11,... serait équivalent à un tirage de 6,6,6,6,6,6,6,6,... pour votre SrD. Je ne pense pas que vous trouverez des partisans ici qui seraient d'accord avec cette estimation. Surtout si la mort du dépôt est accompagnée d'un prélèvement de 10. Comprenez-vous la valeur d'un drawdown maximal ? Il indique à quel point votre dépôt était proche de la mort et s'il est vivant ou mort à l'arrivée. La SrD elle-même n'indique rien, car on ne la compare pas avec un indicateur de même nature, mais on la suspend simplement en l'air sans estimation, elle n'a donc aucune valeur. Si vous voulez vraiment entrer quelque chose comme ça, essayez de calculer le SrProfit et de le comparer au SrD, mais pas au MD et certainement pas au taux de croissance du solde.

Une fois que vous avez les indicateurs, il faut les multiplier. Si un indicateur est plus important pour vous qu'un autre, vous devez utiliser une fonction plus "puissante" pour lui. Par exemple, élever au carré l'indicateur le plus lourd, ou prendre le logarithme de celui qui est moins lourd, la racine carrée, etc. etc. C'est une question de goût et de préférence que d'imposer un poids à un indicateur en utilisant une fonction. Il n'y a pas de statistiques derrière une telle multiplication, c'est juste une approximation grossière qui a du sens - la proportionnalité du critère aux indicateurs qui sont importants pour vous. Mais ce que vous faites - diviser les bénéfices par les barres et ajouter le taux de croissance divisé par les différents drawdowns, essayer de normaliser à l'œil avec les 10 et les 4 - ce serait vrai s'il y avait une formule mathématique stricte derrière votre calcul. Jusqu'à présent, votre formule n'est même pas une approximation, car elle ne comporte aucun indicateur.

Vita писал(а) >>

Maintenant, revenons à ton SrD. En utilisant son exemple, je veux vous faire remarquer que l'introduction d'un indicateur juste parce que nous savons compter le drawdown moyen sur toutes les transactions est aussi pertinente que la température moyenne d'un patient. Pouvez-vous expliquer ce que SrD ajoute à l'évaluation ? A mon avis - absolument rien. Tirages de 1,11, 1,11, 1,11, 1,11,... serait équivalent à un tirage de 6,6,6,6,6,6,6,6,... pour votre SrD. Je ne pense pas que vous trouverez des partisans ici qui seraient d'accord avec cette estimation. Surtout si la mort du dépôt est accompagnée d'un prélèvement de 10. Comprenez-vous la valeur d'un drawdown maximal ? Il indique à quel point votre dépôt était proche de la mort et s'il est vivant ou mort à l'arrivée. La SrD elle-même n'indique rien, car on ne la compare pas avec un indicateur de même nature, mais on la suspend simplement en l'air sans estimation, elle n'a donc aucune valeur. Si vous voulez vraiment entrer dans quelque chose comme ça, essayez de calculer SrProfit et de le comparer avec SrD, mais pas avec MD et certainement pas avec le taux de croissance du solde.

Le MD est l'un des indicateurs les plus importants. Et notre tâche est de révéler l'honnêteté de cet indicateur. Qu'est-ce que cela signifie ? Je m'explique par un exemple : supposons que nous ayons deux passes similaires, que les deux aient le même drawdown et que tout le reste soit proche, il n'y a donc pas de différence fondamentale. En fait, dans l'un des passages, le drawdown est ajusté par rapport aux transactions dangereuses (qui n'ont pas été ouvertes et que nous ne voyons pas), tandis que dans l'autre passage, le drawdown est généralement faible et n'a atteint le même niveau que dans une seule transaction aléatoire. En conséquence, nous obtenons deux passages radicalement différents. Si nous imaginons que le drawdown de chaque trade est une hachure, SrD définit simplement la densité et le rayon de cette hachure, et il montre de manière évidente que le drawdown maximal par exemple de 15% a par coïncidence à peine tiré des statistiques 25-30% (qui n'ont pas ouvert à quelques millimètres du signal et que nous ne pouvons pas voir) ou vice versa accidentellement glissé de 5-10% (toutes les positions maximalement ouvertes).

L'IP est également l'un des indicateurs les plus importants. Et son optimisation peut être facilement réalisée en laissant de côté les affaires dangereuses au millimètre près. A mon avis, il est préférable d'ouvrir tous les marchés et d'obtenir PF 1.8. Mais il est préférable de voir toutes les transactions dangereuses et sûres et en fait (après optimisation) de réduire un peu le signal et d'obtenir PF 2-3. Dans l'optimisation la vie pour le TS doit être dure, alors qu'en fait il est possible de faciliter le travail. D'autant plus que les trades perdants ne sont plus nécessaires ici... "Dur dans l'apprentissage - facile dans la bataille" comme on dit, c'est comme ça que ça devrait être...

PipBar - J'explique l'importance avec un exemple. Là encore, les deux passes sont similaires, et le nombre de transactions est le même. Dans un seul passage, les affaires s'ouvrent en moyenne, attendent une demi-journée, puis se referment bien. Dans l'autre, ils ouvrent, en 5-10 minutes un rebond se produit et ils ferment dans le plus. Le même bénéfice est obtenu mais avec une utilisation du temps cardinalement différente. Bien que leur période d'essai soit la même (un an par exemple). PipBar montre de manière transparente la qualité du temps utilisé, c'est-à-dire que TS prend de l'argent du solde pour une période minimale avec un rendement maximal !

J'écrirai sur le reste plus tard...

MD - один из самых важных показателей. И наша задача выявить честность этого показателя. Что это значит? Объясняю на примере: предположим у нас два похожих друг на друга прохода, у обоих одинаковая просадка, и все остальное так же где-то рядом, изначально нет принципиальной разницы. На самом деле в одном из проходов просадка подогнана в притирку от опасных сделок (которые не открылись, и мы их не видим) - прошу пояснить, что такое опасная сделка, которая не открылась и котрую мы не видим, и как её на чистую воду выводит SrD? - а в другом наоборот просадка в основном маленькая, и только в одной случайной сделке она дошла до такого же уровня - уровня опасной сделки, так ведь?. В итоге мы получаем в корне разные два прохода. Если представить что просадка каждой сделки это штриховка, то SrD как раз и определяет плотность и радиус этой штриховки, и наглядно показывает что максимальная просадка к примеру 15% случайно совпала еле вытягиваясь из статистических 25-30% (которые не открылись в миллиметре от сигнала, и мы их не видим) или наоборот случайно проскользнувшая из 5-10% (максимально открытых всех позиций). - Я приводил примеры просадок 1-11-1-11-... против 6-6-6-6-... Я полагаю, что для них SrD одинаковое, но вот первый пример как раз именно тот, который дергает эти ваши опасные сделки, или не так?

PF - также один из самых важных показателей. И оптимизация его может получить запросто, также обходя опасные сделки в миллиметре. По мне так лучше открывать все сделки и получить PF 1.8. Но чтоб видеть все опасные и безопасные сделки, - у вас есть определение опасных и безопасных сделок и когда они открываются? Выше вы их связываете с просадкой. Сложно понять, что это. а уж на деле (после оптимизации), немного сузить сигнал и получить PF 2-3. В оптимизации жизнь для ТС должна быть жесткой, а на деле можно и облегчить труд. Тем более что убыточные сделки здесь уже не нужны... "Тяжело в учении - легко в бою" как говориться, вот так должно быть... - Интуитивно, я понимаю, чего вы желаете добиться. Сомневаюсь, что для оптимизации вы ставите параметр PF=1.8 и он вам делает прогон с PF=1.8, а для работы вы устанавливаете PF=2-3. Нет, конечно, оптимизационные и рабочие варианты отличаются другими параметрами. И вам кажется, что при оптимизационном режиме вы собираете "опасные и безопасные" сделки, убеждаетесь, что все тип-топ, а потом как бы выключаете "опасные" сделки и в уме держите - класс, я осведомлен об "опасных" сделках, я их контролирую, ведь, я их выключил в рабочем варианте, и если они даже возникнут, то они мне не угроза. Это иллюзия. Мне она напоминает анекдот про "Что делаю? Отгоняю крокодилов - Так их отродясь тут не было - Так это потому, что я их так хорошо отгоняю. А по-научному, любое высказывание о любом элементе пустого множества верно. Все что вы не придумаете о сделках, которых не было, которые не открылись в рабочем варианте и в любом другом, - все будет верно. Ваше "лучше открывать все сделки" показывает вам реальность при одном наборе оптимизируемых параметров. "Немного сузить сигнал" - другую реальность, в которой нет сделок из первой. Эти несуществующие сделки, которые не открылись при узком сигнале, существуют только в вашем воображении. И естественно, вы осведомлены о них, что они "существуют", что все под контролем - вы их отпугнули "сузив сигнал". Попробуйте понять, что в условиях "узкого сигнала" неоткрывшихся сделок нет, их свойств мы не знаем, но воображать о них мы можем что угодно. Интуитивно хочется приоткрыть дверь и вглянуть на эти неоткрывшиеся опасные сделки, но приоткрывая дверь - расширяя сигнал, мы меняем реальность. Я бы не тратил время на попытку взвешивания фантомов. Исходите из фактов. Для каждого прогона они свои.

PipBar - объясняю важность на примере. Опять же два похожих друг на друга прохода, да же кол-во сделок одинаково. Только в одном проходе сделки в среднем открываются, пол дня межуются, потом закрываются хорошо. В другом открываются, через 5-10минут происходит скачок, и закрываются также в плюсе. Получается одна и та же прибыль, но при кардинально разном использовании времени. Хотя период тестирования у них одинаковый (год к примеру). PipBar - прозрачно показывает качество использованного времени, т.е. ТС занимает деньги у баланса для совершения сделки на минимальный срок с максимальной отдачей! - Желание понятно, но методологический подход неверен. Расчитайте стоимость денег, которую вы одолжили у депозита на сделку(и) и сравните её с чем-то такой же природы, т.е. снова стоимостью чего вам покажется правильным. Или умножьте обратную величину стоимости на критерий - чем больше стоимость, тем хуже. Так ведь? А вы её к устойчивости прибавляете. То, что вы делаете, это попытка вымучать калибровкой коэффициентов критерий по вот такому типу: максимальная скорость/стоимость авто + количество подушек безопасности / расход топлива на 100 км + мощность /% по кредиту

Об остальном позже напишу...

La première question à laquelle nous voulons répondre lorsque nous optimisons avec un lot constant est le niveau de drawdown que nous devons attendre du TS. Supposons que le niveau de prélèvement soit de 30 % du dépôt initial. Comment mettre en œuvre ce critère dans la pratique, afin de pouvoir éliminer les variantes inutiles lors de l'optimisation ? Par exemple, comme ceci :

Après l'optimisation, nous obtenons un échantillon de variantes que nous transférons dans Excel. Triés par le critère - facteur de récupération (bénéfice/tirage maximal).

La deuxième question est de savoir quelle variante utiliser dans le cadre d'un trading réel. Supposons que la meilleure variante donne un drawdown de 10%. Nous autorisons 3 fois le drawdown, c'est-à-dire que le volume des transactions peut être multiplié par 3. Mais... D'autres paramètres de la variante choisie peuvent s'aggraver. En règle générale, cela se produit.

Ainsi, au lieu d'une variante, nous pouvons utiliser simultanément un groupe de variantes dont le volume est égal à un lot (0,01, 0,1, 1, etc.). En même temps, nous limitons le nombre de transactions ouvertes en même temps. Par exemple, nous avons configuré 20 Expert Advisors pour trader et seulement 3 positions avec un seul volume peuvent être ouvertes. Nous définissons un contrôle avant d'ouvrir une position :

Ainsi, nous redistribuons la probabilité d'obtenir un drawdown potentiel de 30% du dépôt initial par 20 Expert Advisors au lieu d'un seul.

Maintenant le problème est de choisir ces 20 Expert Advisors ? Prendre simplement les 20 meilleures options n'est pas une bonne solution. Après tout, de nombreuses variantes ont le même nombre d'offres pendant la période d'optimisation, c'est-à-dire qu'elles fonctionnent de manière synchrone. Nous trions donc par nombre de transactions et par facteur de récupération. Dans chaque groupe, nous choisissons la meilleure variante.

Pour moi, le "critère de sélection automatique des résultats de l'optimisation" est le temps, c'est-à-dire que le système doit être stable à tous les intervalles de temps.

Le marché étant dynamique, nous pouvons en conclure que les résultats de l'optimisation sont dynamiques et ne peuvent être utilisés pour une sélection automatique.

Si le système détecte une forte volatilité du marché et passe en mode intraday, que faire alors de l'auto-sélection ?

.

Supposons que l'optimisation du second semestre 2008 (01.08.2008-01.01.2009) n'ait pas de sens, l'ATS avec un MA sera rentable.

L'échantillonnage des périodes de tendance et de non-tendance est une option (je préfère l'optimisation fixe sur deux semaines).

Comment atteindre la stabilité ?

Mon critère de sélection est la stabilité. Pour essayer de changer mon approche, je fais comme ceci :

.

Un semestre, 12 optimisations indépendantes, sur M5 sont suffisantes.

En général, il ne restera pas plus de 50 variantes de paramètres, ce qui nous donnera toutefois environ 2 ou 3 paquets de paramètres "identiques".

La sélection des résultats de l'optimisation par pf ou cc est directement liée à la méthodologie d'écriture de l'algorithme ATC.

Une personne a besoin de temps pour apprendre à marcher, un boxeur a besoin de plus d'un tournoi pour se qualifier...

Il existe un article qui vous aidera à trier les données et à exécuter les variantes sélectionnées des paramètres à n'importe quel intervalle de temps.

>> Salutations à tous !

Le sujet du fil de discussion et les autres questions sur l'utilisation des résultats d'optimisation sont certainement extrêmement importants pour tout trader.

Ma question ne s'adresse pas seulement aux auteurs cités ci-dessous.....

L'analyse reçue est probablement uniquement manuelle, comme l'a dit quelqu'un ici : "le réseau neuronal le plus parfait est la tête".

Mais je pense que les résultats, tant psychologiques que factuels, en valent la peine.

Sans fausse modestie), je noterai que j'ai obtenu un certain succès en sélectionnant à la main le résultat de l'optimisation . Cependant, il n'existe aucun moyen d'automatiser ce processus. Peut-être s'agit-il simplement d'une expérience peu formalisable.

Il s'agit d'une version test pour l'instant, mais je suis déjà satisfait des résultats...

Voilà, vous avez supplié mon critère super-simple mais super-efficace ;)

Pourquoi le thème s'est tu. La question en l'air et donc raccrochée. Après avoir essayé un grand nombre d'EA rentables "muets" (à un seul passage) et les avoir perdus en démo, sinon en forwards, puis en trading réel, j'ai réalisé que tant que je n'aurai pas tranché cette question par moi-même - je n'irai pas plus loin..... il n'y a nulle part où aller :)

..............

Si je vois ce qui vaut la peine, je regroupe les ensembles - 2, une force de trois et l'optimisation finale à travers l'intervalle...... choisir le meilleur, puis démo.... Aucune garantie, aucune statistique pour le moment :)

...............................................

Ce message daté du 04.10.2008 12:05 AM Stats devrait déjà apparaître ! !!

À en juger par les messages, chacun est plus ou moins satisfait de ses critères et des résultats de la sélection du jeu de paramètres final (FSP).

.............................

Voici donc la question :

Supposons que nous avons un TS qui est optimisé sur un historique de 3 semaines, puis nous sélectionnons un TPF basé sur les résultats de l'optimisation, puis une semaine pour de vrai (ou OOS), pendant la semaine le TPF ne change pas, à la fin de la semaine nous fixons le résultat.

Nous répétons 52 cycles (semaines) avec un décalage d'une semaine en avant, c'est-à-dire 1 an.

Nous considérons qu'il y a succès si le résultat d'une semaine de trading (test) est positif ou égal à zéro.

Question : Quel est le nombre de succès obtenus en utilisant vos critères et méthodes de sélection de l'ensemble final de paramètres ?

Je pose cette question car je cherchais des méthodes pour sélectionner un TPF en fonction des résultats de l'optimisation.

Je décrirai plus tard mon expérience à ce sujet.

Salutations à tous !

Ok, bien, pendant que vous vous cachez tous, j'ai le temps de raconter mon histoire.

.............

J'ai réalisé que a) le marché est volatile, b) il est impossible de créer un conseiller expert qui réalise des bénéfices avec des paramètres constants pendant une longue période, c) ... d'autres informations importantes,

la tâche a été fixée : apprendre à sélectionner, parmi les résultats d'optimisation d'un conseiller expert, un ensemble de paramètres finaux (FPS) dont l'utilisation donne, de manière statistiquement fiable, un gain attendu positif.

Tout semble être clair, mais juste au cas où, je vais expliquer par un exemple du post précédent :

Nous répétons ainsi 52 cycles (semaines), en nous décalant d'une semaine en avant, c'est-à-dire d'un an.

Le succès est considéré comme tel si le résultat de la négociation hebdomadaire (test) est positif ou égal à zéro.

c'est-à-dire si, sur 52 semaines, les résultats de 40 semaines se sont avérés positifs et que la perte moyenne de 12 semaines infructueuses était, par exemple, de 1 126 uc,

et que la semaine moyenne rentable s'avère être égale à - 1777 c.u., alors nous considérons que le problème est parfaitement résolu.

(Nous comprenons qu'il est préférable d'avoir les résultats de l'échantillon de 520 semaines ou de 5200. Mais nous avons des raisons de croire que dans des échantillons de cette taille, les proportions de nos résultats ne changent pas).

.........

Admettez que la tâche est sérieuse. C'est mieux que de trouver le graal, car théoriquement, n'importe quel MTS peut être utilisé selon la méthodologie donnée. L'auteur du sujet écrit également à ce sujet.

La partie technique a été résolue comme suit :

- nous attachons le calcul de divers critères au conseiller expert. Les données standard du rapport MT plus, par exemple, le profit maximum, le temps nécessaire pour l'atteindre en % du temps de test, le Z-score étendu, le temps moyen d'une transaction à l'achat et à la vente, le temps passé à l'achat et à la vente en % du temps de test, etc. En bref, plus il y en a, mieux c'est. Il n'y a pas d'informations superflues. (Je veux dire des informations sur mes métiers ;-)) )

- IsBackTestingTime.mqh Copyright © 2008, Nikolay Kositsin. Il est refait dans ma version mais l'idée est similaire. Je vais reprendre l'exemple précédent : supposons qu'un conseiller expert possède deux paramètres optimisés avec dix valeurs chacun, et un autre avec trois valeurs. Après avoir défini la durée requise des périodes d'optimisation et de test ainsi que les décalages de ces périodes, pour une optimisation complète (sans GA), nous obtiendrons 31200 = 300*52 + 300*52 passes, c'est-à-dire 52 passes de 300 passes à la période d'optimisation et 300 passes à la période de test (par rapport aux passes précédentes). Article et photos de Kositsin ici

Je serai absent pendant un certain temps, puis je continuerai.....

En attendant, sortez de votre cachette, arrêtez de vous cacher..... ))

- nous écrivons tous les paramètres externes du conseiller expert et les critères dont nous avons besoin dans un fichier csv (à partir de deinit).

- Une fois l'optimisation terminée, je la charge dans Excel, et en une minute nous avons un fichier xls formaté et prêt à l'emploi avec toutes les passes.

Une question se pose : que dois-je faire de tous ces "trucs" ?

J'ai décidé d'automatiser le processus de choix des FPP selon les modèles qui ont déjà été décrits dans cette section et dans d'autres. Par exemple :

Prenons les passages d'optimisation des sous-groupes de 1-st à 300-th

1. Offres inférieures à 50 - à filtrer (il en reste 220)

2. ProfitFactor inférieur à 2 - filtrer (78 left)

3. Profit inférieur à 30% ou supérieur à 70% (nous prenons le milieu) - filtrez-le (il en reste 33)

.... Un total de 6 critères peut être traité avec des filtres définis par valeur absolue, valeur relative (%) et numéro de position. Il existe deux types de filtres : les filtres de bande (intérieur, extérieur) et les filtres de frontière (plus, moins).

7. Nous sélectionnons directement le FPN. Par exemple, ce sera l'ensemble qui a la valeur maximale du critère responsable de la rectitude de la courbe d'équilibre.

Maintenant, trouvons la passe correspondante dans le test des trois cents passes de ce groupe (comme s'il s'agissait de OoS) et fixons le bénéfice par le nombre disponible d'une passe.

Et ainsi de suite pour chaque sous-groupe.

Comme résultat, nous obtenons le rapport avec le graphique du solde et les indices des "transactions" hebdomadaires (dans ce cas). Tout semble glamour. Mais...

Résultat :

Je n'ai pu déceler aucun modèle cohérent dans les méthodes de sélection. Tout semble aller bien, mais quelque chose ne va pas. Je n'y crois pas ! !! (comme le grand disait...).

En même temps, je crois que cette approche a du potentiel et qu'elle est énorme.

Je n'ai pas traité cette question pendant longtemps, et je n'ai testé qu'une seule stratégie (j'essaie de me rappeler où et pourquoi j'ai développé ce thème....).

Questions :

1. Que pensez-vous : Peut pas tous les TS est adapté à un tel traitement ? c'est à dire plus stable dans le temps, et ce que d'introduire un critère pour cette stabilité, pour déterminer immédiatement - notre TS / pas notre TS.

2. Qu'est-ce qui est mal fait ici ? Quelqu'un peut-il voir d'autres approches ?

3. j'aimerais connaître vos résultats. La question est déjà posée dans mon (mes) premier(s) message(s) sur cette page

Proposition :

Collectivement, choisissez une stratégie prête (déjà déboguée par MTS ou par un auteur crédible, suggérez) et essayez à nouveau collectivement de résoudre le problème (ou au moins de vous en approcher).

en utilisant la description fonctionnelle que j'ai faite (mais je n'insiste pas, une autre similaire est possible - suggérez-la).

Les résultats des tests seront affichés ici ou pas, nous pouvons en décider ensemble.

Nous pouvons ouvrir un nouveau fil, comme vous le dites.

Seulement si les résultats ont été obtenus et que le sujet ne s'estompe pas et n'évolue pas.

Un ajout.

1. l'outil est assez flexible. Il permet de formaliser toute méthode de sélection des résultats d'optimisation. Imho, bien sûr.

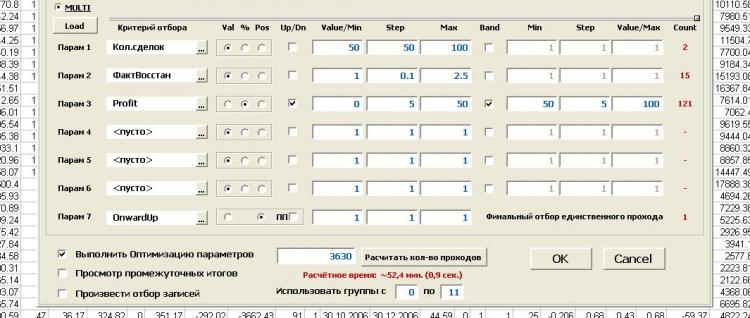

2. Je n'ai pas du tout dit qu'il existait une fonctionnalité permettant d'optimiser les méthodes de recherche de l'ensemble final de paramètres, c'est-à-dire d'optimiser les paramètres d'optimisation. Nous sélectionnons la plage et le pas pour chaque critère, ainsi que le type de bordure et le mode de fonctionnement du filtre, et nous effectuons l'optimisation. Il vaut mieux le voir une fois que...

C'est tout ce qu'il y a à faire.

PS. "Quel gâchis, quand on y pense... Il n'y a pas de quoi rire... "(c) UmaTurman