本文创建的神经网络(正向模型、逆向模型)与前一篇文章兼容吗?

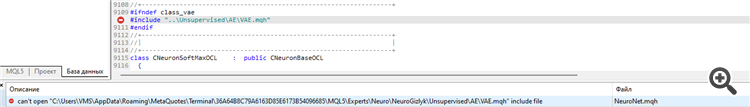

CS 0 15:22:10.739 Core 01 2023.01.01 00:00:00 EURUSD_PERIOD_H1_RRL-learning.nnw CS 0 15:22:10.739 Core 01 2023.01.01 00:00:00 OpenCL not found. Error code=5103 CS 2 15:22:10.739 Core 01 2023.01.01 00:00:00 invalid pointer access in 'NeuroNet.mqh' (2876,11) CS 2 15:22:10.739 Core 01 OnInit critical error CS 2 15:22:10.739 Core 01 tester stopped because OnInit failed CS 2 15:22:10.740 Core 01 disconnected CS 0 15:22:10.740 Core 01 connection closed

我尝试用 NetCreator 制作神经网络,但也出现了同样的错误。

是什么原因导致了这个问题?

| err_opencl_context_create | 5103 | 创建OpenCL 上下文时 出错 |

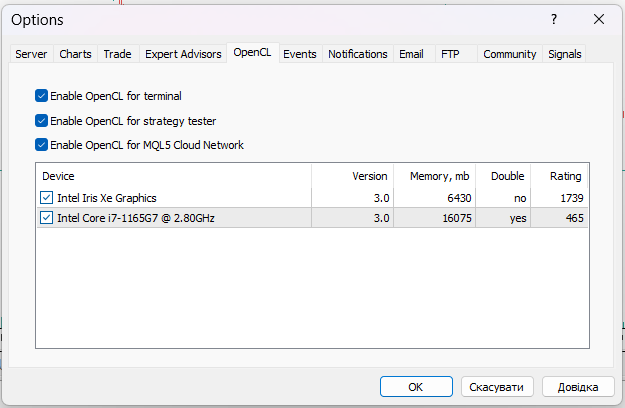

在使用此库之前,您必须在 PC 上安装 OpenCL

我使用的是 Nvidia Tesla A100 GPU,它已经启用了 OpenCL,但出现了同样的错误

新文章 神经网络变得轻松(第三十六部分):关系强化学习已发布:

在上一篇文章中讨论的强化学习模型中,我们用到了卷积网络的各种变体,这些变体能够识别原始数据中的各种对象。 卷积网络的主要优点是能够识别对象,无关它们的位置。 与此同时,当物体存在各种变形和噪声时,卷积网络并不能始终表现良好。 这些是关系模型可以解决的问题。

关系模型的主要优点是能够在对象之间构建依赖关系。 这样就可以构建源数据。 关系模型可以用示图的形式表示,其中对象和事件表示为节点,而关系代表对象和事件之间的依赖关系。

通过使用示图,我们可以直观地构建对象之间的依赖关系结构。 例如,如果我们想描述通道突破模式,我们可以绘制一个有顶部的通道形成的示图。 通道形成描述也可以表示为示图。 接下来,我们将创建两个通道突破节点(上边界和下边界)。 两个节点均拥有与前一个通道形成节点的相同链接,但它们彼此间没有相互连接。 为了避免在出现假突破时入场建仓,我们可以等待价格回滚到通道边界。 这就是另外两个节点,即回滚到通道上边界和下边界。 它们将与相应通道边界突破的节点建立连接。 但同样,它们彼此之间不会有连接。

所描述的结构适合示图,从而提供了数据和事件序列的清晰结构。 在构建关联规则时,我们研究过类似的东西。 但这与我们之前所用的卷积网络难以相关。

卷积网络用于识别数据中的对象。 我们可以训练模型来检测一些走势逆转点或小型趋势。 但在实践中,通道形成过程可以随着通道内趋势的不同强度而扩展。 然而,卷积模型也许无法很好地应对这种扭曲。 此外,卷积和完全连接的神经层都不能分离由不同序列的相同对象组成的两种不同形态。

还应该注意的是,卷积神经网络只能检测对象,但不能在它们之间建立依赖关系。 因此,我们需要寻找一些其它算法来学习这种依赖关系。 现在,我们回到关注度模型。 关注度模型可以将注意力集中在独立对象上,从常规数据数组中将它们挑捡出来。

作者:Dmitriy Gizlyk