Освойте бесплатно за 2 недели основы Python и анализа данных на курсе «Специалист по Data Science» от Яндекс Практикум: https://ya.cc/t/HG2PtD254WHFyvПереход...

해킹은 데이터를 원하는 만큼 늘리는 것입니다. 어떤 FF를 가지고 입력에 최대한 많은 데이터를 추가하여 최대화하는 것입니다. 잘 최대화되지 않으면 데이터를 더 추가하거나 더 정확한 최적화 알고리즘을 선택합니다. 즉, 모든 FF는 이런 방식으로 최대화할 수 있습니다. 이것이 TC 최적화에서 가장 일반적인 경우입니다. 이 경우 더 많은 데이터 - 더 많은 오버트레이닝. 옵션이 없습니다. 글로벌 최소-최대값은 아무 것도 알려주지 않습니다. 논리적 해결책은 위에서 설명한 것처럼 기능의 수를 최소화하면서 FF를 최대화하는 것입니다. 말하자면 최소한의 악입니다. Baes는 과학적 용어로 변형 트라이도프입니다.

그 반대의 과정은 연구인데, 초기 가정을 세우지 않고, FF를 천장에서 가져가지 않고, 데이터에서 패턴을 조사하는 것입니다.

"당신이 만들어낸 것"은 현실과는 아무런 관련이 없습니다. "연구를 바탕으로 결론을 도출했다"는 것은 현실과 관련이 있습니다.

연구를 하려면 최소한 연구의 주제와 방법을 정의한 다음 연구 도구를 선택해야 합니다. 연구 대상이 BP가 아니라 본인만 알고 있는 단체라면 연구 결과를 미리 결정할 수도 있습니다. 대학에서 이런 것을 가르치지 않는다는 것을 알고 있으므로 여기갑니다 :)

Maxim Dmitrievsky #: 해킹은 데이터를 원하는 만큼 늘리는 것입니다. 어떤 FF를 가져와서 입력에 최대한 많은 데이터를 추가하여 최대화합니다. 제대로 최대화되지 않으면 데이터를 더 추가하거나 더 정확한 최적화 알고리즘을 선택합니다. 즉, 모든 FF는 이런 방식으로 최대화할 수 있습니다. 이것이 TC 최적화에서 가장 일반적인 경우입니다. 이 경우 더 많은 데이터 - 더 많은 오버트레이닝. 옵션이 없습니다. 글로벌 최소-최대값은 아무 것도 알려주지 않습니다. 논리적 해결책은 위에서 설명한 것처럼 기능의 수를 최소화하면서 FF를 최대화하는 것입니다. 말하자면 최소한의 악입니다. Baes - 과학적 용어로 변형 트라도프.

그 반대의 과정은 연구인데, 초기 가정을 세우지 않고 FF를 천장에서 가져오는 것이 아니라 데이터에서 패턴을 조사하는 것입니다.

"당신이 만들어낸 것"은 현실과는 아무런 관련이 없습니다. "연구를 바탕으로 결론을 도출했다"는 것은 현실과 관련이 있습니다.

연구를 하려면 최소한 연구의 주제와 방법을 정의한 다음 연구 도구를 선택해야 합니다. 연구 대상이 BP가 아니라 본인만 알고 있는 단체라면 연구 결과를 미리 결정할 수도 있습니다. 대학에서 이런 것을 가르치지 않는다는 것을 알고 있으므로 여기갑니다 :)

타르 한 숟가락이 든 꿀 통, 그래서 꿀을 버릴 수 있습니다. 스털리츠가 말했듯이 기억에 남는 마지막 문구입니다.

질문에 대한 답변은 필요하지 않습니다. 답을 찾으면 어디로 가져가야 하나요? 질문에 대한 답변의 실질적인 가치는 무엇인가요?

EA의 어느 부분에 질문에 대한 답변을 삽입할 수 있나요? IO에서 질문에 대한 답변을 어디에 넣을 것인가?

필요하지도 않은 답변을 왜 백 번씩 질문하나요?

다음은 귀하의 질문에 대한 답변입니다(또는 오히려 제가 원래 질문한 내용에 대한 답변입니다):

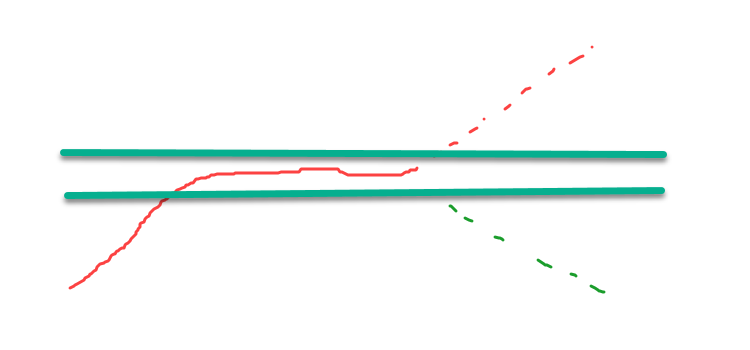

범위를 벗어난 빨간색 점선의 부호를 변경하면 원하는 간격에 남아있는 것이 최대 점수를 가지므로 최적화는 최대 값을 찾는 것으로 축소됩니다. 찾고있는 것은 가능한 최대 점수를 갖게됩니다.

이것은 사용중인 점수를 최대값이 고원에있는 점수로 변환하는 간단한 방법입니다. 그러나 이것은 올바른 방법이 아니며 올바른 방법은 처음에 찾고있는 위치에서 최대 값을 갖는 점수를 사용하는 것입니다.

이것은 신경망 훈련, 기능 최적화, 전략 최적화 등 모든 것에 해당됩니다.

따라서 "최대값을 찾을 필요 없이 안정된 고원을 찾아야 한다"는 말은 본질적으로 잘못된 것이며, 이는 추정을 잘못 사용했음을 나타냅니다.

앤드류는 NS 트레이닝과 매개변수 최적화를 혼동하고 있는 것 같습니다.

둘 다 최적화와 비슷한데, 새끼 고양이가 많은 음식을 먹었을 때 약간 당황합니다. 모든 곳에서 음식이 최적화되어있는 것 같고 무엇을 먹어야할지 명확하지 않습니다.

따라서 "최대치를 찾을 필요 없이 꾸준한 정체점을 찾아야 한다"는 말은 추정을 잘못 사용했다는 점에서 본질적으로 잘못된 것입니다.

귀하의 주장과는 달리 추정을 시연함으로써 정체기가 발견되었음을 보여주었습니다.

이를 실제로 어디에 적용할 수 있나요?

우리는 일반적으로 최적화를 기반으로 하는 과적합에 대해 논의하고 있습니다. 테스터에서는 명확합니다.

MO에서는 다른 파일에서 모델을 실행하면 과적합이 드러납니다. 모델 성능의 변화는 과적합이므로 기준이 필요하지 않습니다. 과적합으로 드러나는 패키지도 있습니다.

하늘에서 내려와서 실례지만, 극한에서 상황이 다른 지상으로 내려오세요.

귀하의 주장과는 달리 감사를 표시함으로써 정체기를 찾았습니다.

이를 실제로 어디에 적용할 수 있나요?

우리는 일반적으로 최적화를 기반으로 하는 피팅에 대해 논의하고 있습니다. 테스터에서는 모든 것이 명확합니다.

MO에서는 다른 파일에서 모델을 실행하면 과적합이 드러납니다. 모델 성능의 변화는 과적합이므로 기준이 필요하지 않습니다. 과적합을 감지하는 패키지도 있습니다.

극단에서 내려와서 상황이 다른 곳으로 내려오세요.

결국,"우리가 생각해냈다"는 문구 자체에는 일종의 사고 과정(반복)이 내포되어 있습니다.

최종 모델은 두뇌 반복인지 컴퓨터 반복인지 그리고 둘 사이에 차이가 있는지 어떻게 알 수 있을까요?

이 질문은 프라도의 글을 읽고 나서 떠올랐습니다.

해킹은 데이터를 원하는 만큼 늘리는 것입니다. 어떤 FF를 가져와서 입력에 최대한 많은 데이터를 추가하여 최대화합니다. 제대로 최대화되지 않으면 데이터를 더 추가하거나 더 정확한 최적화 알고리즘을 선택합니다. 즉, 모든 FF는 이런 방식으로 최대화할 수 있습니다. 이것이 TC 최적화에서 가장 일반적인 경우입니다. 이 경우 더 많은 데이터 - 더 많은 오버트레이닝. 옵션이 없습니다. 글로벌 최소-최대값은 아무 것도 알려주지 않습니다. 논리적 해결책은 위에서 설명한 것처럼 기능의 수를 최소화하면서 FF를 최대화하는 것입니다. 말하자면 최소한의 악입니다. Baes - 과학적 용어로 변형 트라도프.

타르 한 숟가락이 든 꿀 통, 그래서 꿀을 버릴 수 있습니다. 스털리츠가 말했듯이 기억에 남는 마지막 문구입니다.

한 숟가락의 타르가 든 꿀 한 통, 그래서 꿀은 버릴 수 있습니다. 스털리츠가 말했듯이 중요한 것은 마지막 문장이에요.

최적화 프로세스는 알려지지 않은 매개변수를 찾는 과정입니다.